programa

Los sistemas operativos (SO) tradicionales como Windows, macOS y Linux han dominado durante mucho tiempo el panorama informático. Sin embargo, imagina un escenario en el que escribes: "Organizar mi escritorio desordenado y poner un fondo de pantalla tranquilizador", y ocurre en cuestión de segundos.

Este futuro no está lejos, gracias al desarrollo de sistemas operativos de grandes modelos lingüísticos (SO LLM).

A diferencia de los SO tradicionales que se basan en comandos predefinidos e interfaces gráficas, un SO LLM se centra en un modelo de IA que interpreta y ejecuta órdenes basadas en el lenguaje natural.

Este cambio de paradigma es un avance hacia un modelo de interacción más conversacional e intuitivo, en el que el sistema operativo se convierte más en un asistente inteligente que en una herramienta que requiere una intervención manual constante. Como resultado, los ordenadores serán más accesibles a un público más amplio, independientemente de sus conocimientos técnicos.

En este artículo, aprenderás qué es LLM en qué se diferencian de los sistemas tradicionales, los hitos que han dado forma a su desarrollo y los retos y consideraciones éticas que conlleva su adopción.

Desarrollar aplicaciones de IA

¿Qué son los sistemas operativos LLM?

Un sistema operativo LLM (LLM OS) representa una evolución significativa en el funcionamiento de los ordenadores, pasando de los sistemas tradicionales, rígidamente estructurados, a entornos más fluidos e impulsados por la IA.

Básicamente, un SO LLM es un sistema operativo en el que las funcionalidades básicas -como la interacción con el usuario, la gestión de tareas y el control del sistema- están impulsadas por un LLM.

Esto significa que en lugar de interactuar con tu ordenador mediante comandos o menús predefinidos, interactúas mediante el lenguaje natural. Puedes hablar o escribir instrucciones en lenguaje cotidiano, y la LLM interpreta estas instrucciones para realizar tareas, gestionar aplicaciones e incluso automatizar flujos de trabajo complejos.

Por ejemplo, podrías decir: "Instala la última versión de Photoshop", y el LLM se encargaría de todo el proceso, incluyendo encontrar el software, descargarlo y configurarlo correctamente.

Características clave del LLM OS

Exploremos las características clave de un LLM OS con más detalle.

Interfaz de lenguaje natural

La característica más destacada de un SO LLM es su capacidad para comprender y ejecutar órdenes emitidas en lenguaje natural. Esto significa que, en lugar de tener que conocer comandos específicos o navegar por menús complejos, los usuarios pueden simplemente dar instrucciones al sistema de la misma forma que hablarían con otra persona.

Ejemplo: Si quieres enviar un correo electrónico, en lugar de abrir un cliente de correo electrónico y escribirlo todo manualmente, podrías decir simplemente: "Envía un correo electrónico a Juan diciendo que llegaré tarde a la reunión", y el sistema se encargaría del resto.

Ejecución de tareas dirigida por IA

El LLM no sólo interpreta lo que le pides que haga, sino que también decide la mejor forma de ejecutar esas tareas. Esto implica comprender el contexto, gestionar los recursos y, potencialmente, manejar múltiples aplicaciones para lograr el resultado deseado.

Ejemplo: Una petición como "Organizar todos mis archivos por proyecto y enviar los últimos borradores al equipo" podría implicar clasificar archivos, crear carpetas, seleccionar documentos relevantes y enviar correos electrónicos: todas ellas tareas gestionadas sin problemas por el SO LLM.

Adaptabilidad y flexibilidad

A diferencia de los sistemas tradicionales, que requieren una personalización manual y tienen una adaptabilidad limitada, un SO LLM puede aprender de tus interacciones y ajustar su comportamiento para adaptarse mejor a tus preferencias y flujos de trabajo. Con el tiempo, se alinea más con tus necesidades, ofreciendo sugerencias y automatizando tareas repetitivas sin instrucciones explícitas.

Ejemplo: Si trabajas frecuentemente en informes cada lunes, el SO LLM podría empezar a preparar borradores de informes para ti automáticamente, basándose en los datos y formatos que has utilizado en el pasado.

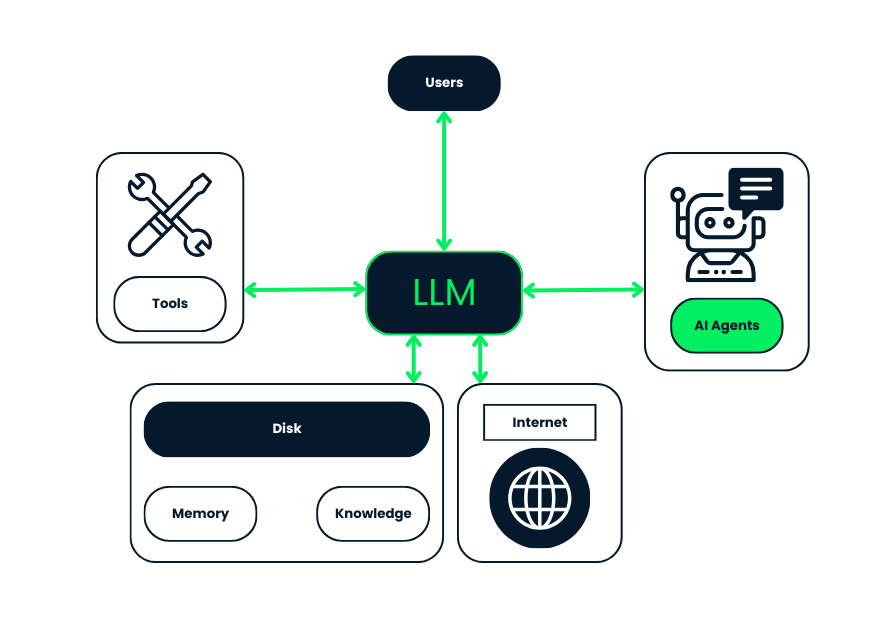

Este diagrama ilustra la arquitectura de un SO LLM, mostrando cómo interactúan los distintos componentes dentro del sistema.

- LLM: Sirve como motor central del sistema. Procesa y comprende las entradas de lenguaje natural, dando al SO la capacidad de interpretar las órdenes del usuario, gestionar tareas y comunicarse con otros componentes.

- Usuarios: Pueden interactuar con el sistema dando órdenes en lenguaje natural. La LLM interpreta estas entradas para ejecutar tareas.

- Herramientas: El SO LLM se integra con diversas herramientas y aplicaciones de software, a las que puede acceder para realizar tareas específicas. La LLM se coordina con estas herramientas para llevar a cabo las instrucciones del usuario de forma eficaz.

- Agentes de IA: Pueden realizar tareas específicas de forma autónoma. El LLM se comunica con estos agentes de IA para delegar tareas o recabar información, mejorando la funcionalidad y capacidad de respuesta general del sistema.

- Disco: Esta parte del sistema son los recursos de almacenamiento, incluyendo la memoria y las bases de conocimiento. La LLM accede a estos recursos para mantener el contexto, recuperar información y aprender de interacciones anteriores, mejorando sus respuestas a lo largo del tiempo.

- Internet: El acceso del sistema a Internet permite al LLM buscar información, realizar tareas que requieren conectividad en línea e integrar datos y recursos externos en sus operaciones.

En la siguiente sección, exploraremos en qué se diferencian los Sistemas Operativos LLM de los sistemas operativos tradicionales, profundizando en sus singulares paradigmas de interacción y capacidades de ejecución de tareas.

LLM OS vs. Sistema operativo tradicional

Los sistemas operativos LLM difieren de los tradicionales en tres áreas clave: paradigma de interacción, ejecución de tareas y adaptabilidad.

Paradigma de interacción

La diferencia más significativa entre un SO LLM y los sistemas operativos tradicionales radica en el paradigma de interacción. Los sistemas operativos tradicionales, como Windows, macOS y Linux, se basan en GUI y CLI para facilitar la interacción del usuario. Los usuarios suelen interactuar con estos sistemas haciendo clic en los iconos, navegando por los menús o introduciendo comandos específicos a través de un terminal.

Un SO LLM introduce una interfaz de lenguaje natural en el núcleo del sistema, que permite a los usuarios interactuar mediante comandos conversacionales.

Esto significa que podrías simplemente dar instrucciones al sistema utilizando un lenguaje cotidiano -como decirle "crea un nuevo documento y resume las últimas notas de la reunión"- y el SO LLM entendería y ejecutaría estas órdenes sin necesidad de abrir aplicaciones específicas o seguir una serie de pasos manuales. El sistema basado en IA interpreta la intención de las palabras del usuario y lleva a cabo las acciones adecuadas.

Ejecución de tareas

En los sistemas operativos tradicionales, la ejecución de tareas suele ser lineal y compartimentada. Los usuarios realizan tareas abriendo aplicaciones específicas diseñadas para funciones concretas (por ejemplo, utilizar un procesador de textos para escribir, un navegador para acceder a Internet). Cada tarea requiere instrucciones explícitas y navegación manual por el sistema operativo.

Los SO LLM gestionan las tareas de forma más integrada y fluida. La LLM interpreta peticiones complejas del usuario y puede ejecutar múltiples tareas relacionadas simultáneamente o en secuencia, sin necesidad de que el usuario gestione cada paso individualmente.

Por ejemplo, en lugar de abrir por separado una hoja de cálculo, un cliente de correo electrónico y una aplicación de calendario para organizar un proyecto, podrías simplemente pedir al SO LLM que "prepare el presupuesto del proyecto, programe una reunión de equipo y envíe el orden del día", y él realizaría todas estas tareas en segundo plano, coordinándose entre las distintas herramientas según fuera necesario.

Adaptabilidad

Los sistemas operativos tradicionales ofrecen opciones de personalización, pero suelen ser estáticas y requieren una introducción manual. Por ejemplo, los usuarios pueden cambiar la disposición de su escritorio, personalizar temas o instalar software específico, pero el propio SO no se adapta intrínsecamente al comportamiento del usuario a lo largo del tiempo.

En un SO LLM, la adaptabilidad es una característica esencial. El sistema aprende de cada interacción, comprendiendo gradualmente las preferencias, rutinas y patrones de flujo de trabajo del usuario. Este proceso de aprendizaje continuo permite al SO LLM ofrecer sugerencias cada vez más personalizadas y automatizar tareas repetitivas sin necesidad de órdenes explícitas del usuario.

Resumamos lo que hemos tratado en esta sección:

|

Aspecto |

Sistema operativo tradicional |

LLM OS |

|

Paradigma de interacción |

Los usuarios interactúan a través de GUIs y CLIs, utilizando iconos, menús y líneas de comando. |

Los usuarios interactúan mediante el lenguaje natural, dando órdenes a través de la conversación. |

|

Ejecución de tareas |

Las tareas se realizan linealmente y requieren instrucciones explícitas en aplicaciones específicas. |

Las tareas se gestionan conjuntamente, y el LLM maneja varias tareas relacionadas al mismo tiempo o una tras otra, sin necesidad de instrucciones detalladas. |

|

Adaptabilidad |

La personalización es posible, pero estática, por lo que requiere una introducción y configuración manual. |

El sistema aprende y se adapta con el tiempo, ofreciendo sugerencias personalizadas y automatizando tareas repetitivas basándose en el comportamiento del usuario. |

En la siguiente sección, exploraremos los hitos clave en el desarrollo de los Sistemas Operativos LLM, destacando algunos de los proyectos pioneros y sus contribuciones a este campo.

De AIOS a MemGPT: Hitos clave en el desarrollo del SO LLM

El desarrollo de los SO LLM se ha caracterizado por varios hitos clave que han hecho avanzar significativamente estos sistemas. He aquí un vistazo a algunos proyectos e innovaciones clave que han contribuido a la evolución del SO LLM.

AIOS: Pioneros en el concepto

AIOS (AI Operating System) es uno de los primeros intentos de integrar grandes modelos lingüísticos en el núcleo de un sistema operativo. Desarrollado como proyecto de investigación, AIOS se diseñó para demostrar cómo los LLM podían funcionar como el cerebro de un SO, encargándose de tareas que normalmente requieren la intervención humana o instrucciones preprogramadas.

AIOS se centra en incrustar los LLM directamente en el núcleo del SO, permitiéndoles gestionar recursos, ejecutar comandos e interactuar con las aplicaciones de forma más inteligente.

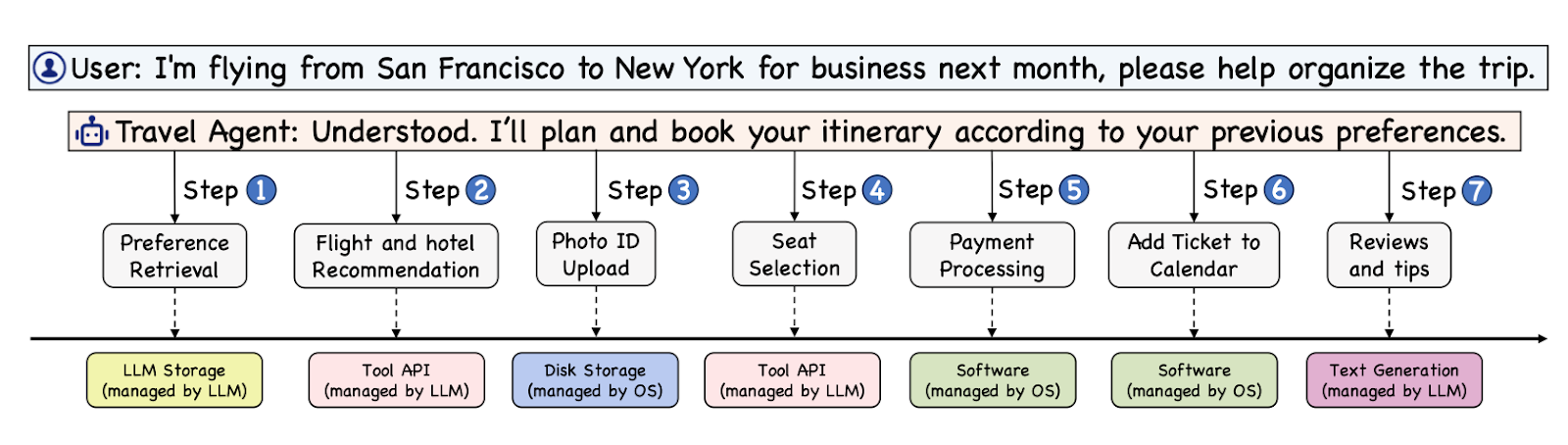

Ejemplo ilustrativo tomado del original original.

Una de las características más destacadas de AIOS es su núcleo específico LLM, que está optimizado para manejar las demandas únicas de las tareas basadas en LLM, como priorizar las peticiones de los agentes y gestionar la memoria de forma eficiente. El sistema está diseñado para hacer frente a las complejidades de ejecutar varios agentes LLM simultáneamente, garantizando un funcionamiento fluido sin los típicos cuellos de botella asociados a las tareas computacionales de alta demanda.

Puedes obtener más información aquí.

BabyAGI: El agente autónomo

BabyAGI es otro proyecto importante en el desarrollo del SO LLM, que introduce el concepto de agentes autónomos impulsados por LLMs. Este sistema amplía las capacidades de los LLM permitiéndoles realizar tareas de forma autónoma, como navegar por la web, recopilar información y ejecutar procesos de varios pasos sin la intervención continua del usuario.

Logotipo de BabyAGI.

La importancia de BabyAGI radica en su capacidad para automatizar los flujos de trabajo y los procesos de toma de decisiones. Por ejemplo, un usuario puede pedir a BabyAGI que busque las mejores opciones de viaje y reserve un vuelo, y el sistema se encargaría autónomamente de cada paso, desde la búsqueda de vuelos hasta la finalización del proceso de reserva.

Puedes obtener más información aquí.

MemGPT: Colmar la brecha entre memoria e inteligencia

MemGPT representa un avance más reciente en el desarrollo de SO LLM, centrado en la integración de la memoria a largo plazo y la mejora de las capacidades de razonamiento en los sistemas basados en LLM. Uno de los retos de los LLM tradicionales son sus limitadas ventanas de contexto, que restringen la cantidad de información que pueden procesar a la vez. MemGPT aborda este problema introduciendo una arquitectura de memoria multinivel que imita las técnicas tradicionales de gestión de memoria de los SO, como la memoria virtual.

Logotipo de MemGPT.

La arquitectura de MemGPT incluye un "contexto principal" (análogo a la RAM) y un "contexto externo" (similar al almacenamiento en disco), lo que permite al sistema gestionar conjuntos de datos más grandes y mantener el contexto en interacciones más largas. Esto es especialmente útil en aplicaciones que requieren conversaciones continuas y contextualizadas o un análisis en profundidad de los documentos.

Puedes obtener más información aquí.

En la siguiente sección, exploraremos el potencial de los Sistemas Operativos LLM, debatiendo cómo estos sistemas podrían transformar la productividad, la accesibilidad y las experiencias de los usuarios.

Retos y limitaciones de la adopción del SO LLM

Los sistemas operativos LLM aportan posibilidades apasionantes de formas más naturales y potentes de interactuar con la tecnología. Sin embargo, hay importantes retos que deben resolverse antes de que estos sistemas puedan utilizarse ampliamente. Estos retos, incluidos los técnicos éticosy prácticos influyen en la eficacia y viabilidad del SO LLM en distintos escenarios.

Fiabilidad y seguridad

Una de las mayores preocupaciones de los Sistemas Operativos LLM es garantizar que sus resultados sean fiables y seguros. Los LLM a veces pueden generar información incorrecta o engañosa que parece creíble, pero que es objetivamente errónea o no tiene sentido.

En un sistema operativo, estos errores pueden causar graves problemas, sobre todo si la LLM interpreta mal las órdenes o proporciona información incorrecta durante tareas importantes como las transacciones financieras o el procesamiento de datos médicos. Garantizar que los SO LLM puedan diferenciar sistemáticamente la información exacta de la inexacta y tomar decisiones seguras es un reto importante.

Rendimiento y eficacia

El rendimiento de los LLM es una preocupación crítica, sobre todo cuando se trata de responder en tiempo real. Estos modelos requieren una importante potencia de cálculosobre todo cuando se manejan órdenes complejas o grandes cantidades de datos.

Esta demanda puede provocar retrasos, en los que el sistema tarda más de lo esperado en responder, afectando negativamente a la experiencia del usuario. Además, el elevado consumo de energía que necesitan los LLM plantea problemas medioambientales. Garantizar que el SO LLM pueda escalar para soportar múltiples usuarios y tareas simultáneamente sin grandes caídas de rendimiento es un objetivo clave de la investigación y el desarrollo en curso.

Privacidad y seguridad

Privacidad y seguridad son cruciales en cualquier sistema operativo, y el SO LLM se enfrenta a retos específicos en estas áreas. Estos sistemas a menudo necesitan acceder a grandes cantidades de datos personales y sensibles para funcionar eficazmente.

Es esencial proteger estos datos de accesos no autorizados y evitar que el LLM filtre accidentalmente información sensible. Además, como los LLM pueden ser vulnerables a ataques en los que entradas maliciosas manipulan la salida del modelo, desarrollar defensas fuertes contra estas amenazas es muy importante.

Consideraciones éticas y jurídicas

El despliegue del SO LLM también plantea cuestiones éticas y legales cuestiones jurídicassobre todo en relación con la parcialidad y la propiedad intelectual.

Los LLM pueden propagar involuntariamente los sesgos presentes en sus datos de entrenamiento, dando lugar a resultados discriminatorios o injustos. Además, como los LLM se entrenan con vastos conjuntos de datos que pueden incluir contenidos protegidos por derechos de autor, su uso en un entorno de SO podría dar lugar a problemas legales relacionados con los derechos de propiedad intelectual. Abordar estos retos éticos y jurídicos es importante para la adopción responsable del SO LLM.

El futuro de los sistemas operativos LLM

El futuro de los SO LLM está llamado a redefinir cómo interactuamos con la tecnología. Esto es lo que podemos esperar de la evolución de estos sistemas.

Ampliación de las capacidades del LLM

A medida que los LLM sean más avanzados, es probable que se integren en los sistemas operativos de forma que puedan realizar tareas cada vez más complejas. Estos sistemas podrían gestionarlo todo, desde las interacciones básicas de los usuarios hasta operaciones más sofisticadas como la creación automatizada de contenidos, el análisis de datos e incluso la toma de decisiones estratégicas.

Esta ampliación de capacidades permitirá al SO LLM servir como potentes asistentes que no sólo ejecuten comandos, sino que también proporcionen grandes conocimientos y recomendaciones basadas en grandes conjuntos de datos.

Modelos especializados y más pequeños

Además de los avances en los SO LLM, también estamos asistiendo a una tendencia hacia el desarrollo de pequeños modelos lingüísticos (SLM). Estos modelos son más eficientes y pueden desplegarse en dispositivos periféricos con capacidad de procesamiento limitadacomo los smartphones o los dispositivos IoT.

Las SLM ofrecen la ventaja de ser más especializadas, lo que permite soluciones a medida que se adaptan mejor a tareas o industrias específicas. Esto podría conducir a un enfoque más descentralizado de la IA, en el que diferentes modelos gestionen diversos aspectos de un sistema operativo, trabajando todos juntos para proporcionar una experiencia de usuario unificada y fluida.

Impacto en la empresa y la productividad

La integración de LLM OS en entornos empresariales se espera que impulse un aumento significativo de la productividad. Estos sistemas pueden automatizar las tareas rutinarias, mejorar las operaciones y proporcionar información basada en datos en tiempo real, lo que permite a las empresas funcionar con más eficacia y tomar decisiones mejor informadas.

A medida que los LLM sigan mejorando en áreas como la comprensión del contexto y el procesamiento del lenguaje natural, es probable que su papel en la estrategia empresarial y las interacciones con los clientes sea aún más destacado, transformando los modelos empresariales y los flujos de trabajo tradicionales.

Conclusión

El desarrollo de los SO LLM representa una evolución significativa en la forma en que interactuamos con la tecnología, marcando un cambio hacia sistemas más intuitivos, eficientes y adaptativos.

Estos sistemas operativos utilizan las capacidades de los LLM para ofrecer a los usuarios una experiencia informática más natural y receptiva, transformando los flujos de trabajo personales y profesionales.

Preguntas frecuentes

¿Pueden funcionar los sistemas operativos LLM en dispositivos móviles o hardware de bajo consumo?

Sí, los sistemas operativos LLM pueden funcionar en dispositivos móviles y hardware de bajo consumo, pero existen retos. Los avances recientes han permitido desplegar LLM más pequeños en dispositivos móviles mediante aplicaciones optimizadas como MLC LLM, compatible con iOS y Android. Sin embargo, el rendimiento puede ser limitado, especialmente en dispositivos antiguos. Por ejemplo, algunos modelos pueden generar salidas a un ritmo más lento debido a la limitada potencia de procesamiento disponible en los dispositivos móviles. Se están realizando esfuerzos para optimizar estos sistemas, por ejemplo, aprovechando las unidades de procesamiento dedicadas, como las NPU de los smartphones modernos, para mejorar el rendimiento.

¿Cómo gestionan la privacidad de los datos los sistemas operativos LLM en comparación con los SO tradicionales?

El SO LLM puede implementar funciones avanzadas de privacidad, como la privacidad diferencial, en la que los datos se anonimizan antes de procesarlos. Estos sistemas también adaptan la configuración de privacidad en función del comportamiento del usuario, ofreciendo un enfoque más dinámico y proactivo para salvaguardar la información personal en comparación con los sistemas operativos tradicionales. Sin embargo, estos sistemas también se enfrentan a retos, como garantizar que la IA no exponga inadvertidamente información sensible a través de sus resultados, lo que hace que los avances continuos en la tecnología de la privacidad sean cruciales para el despliegue seguro del SO LLM.

¿Cómo gestiona un SO LLM las actualizaciones de software y la compatibilidad con las aplicaciones existentes?

Los sistemas operativos LLM gestionan las actualizaciones y la compatibilidad mediante una combinación de mecanismos de retrocompatibilidad y diseño modular. Estos sistemas se están desarrollando para integrarse perfectamente en los entornos de software existentes, al tiempo que permiten actualizaciones periódicas que mejoran sus capacidades. Las capas o módulos de compatibilidad garantizan que las aplicaciones más antiguas puedan seguir funcionando dentro de un SO LLM, incluso cuando evolucionen los componentes centrales impulsados por la IA.

¿Cómo aprovechan los sistemas operativos LLM los servicios en la nube y cuáles son sus ventajas?

Los sistemas operativos LLM pueden utilizar los servicios en la nube para mejorar sus capacidades, descargando las tareas que consumen muchos recursos, como los cálculos complejos y el procesamiento de datos a gran escala, en una infraestructura basada en la nube. Esto permite que el SO acceda a más potencia de cálculo y almacenamiento de lo que podría estar disponible localmente en el dispositivo de un usuario, lo que permite un rendimiento más fluido y el manejo de conjuntos de datos más grandes.

¿Puedes utilizar distintos tipos de LLM en sistemas operativos LLM?

Sí, puedes utilizar distintos tipos de LLM en sistemas operativos LLM, cada uno adaptado a tareas y funcionalidades específicas. Por ejemplo. La flexibilidad para integrar distintos LLM permite a los Sistemas Operativos LLM manejar una gama más amplia de tareas, desde la creación de contenidos hasta la interpretación de datos complejos, utilizando los puntos fuertes de cada tipo de modelo. Esta modularidad permite al SO ofrecer una experiencia de usuario más personalizada y eficiente.