programa

¿Te imaginas a un fontanero sin caja de herramientas? No, ¿verdad? Lo mismo ocurre con los profesionales de los datos. Sin sus herramientas de análisis de datos, los profesionales del sector no podrían analizar datos, visualizarlos, extraer valor de ellos y hacer todas esas cosas interesantes que hacen en su trabajo diario.

Tu conjunto de herramientas de ciencia de datos variará ligeramente en función de la carrera que más te interese:analista de datos, científico de datos, ingeniero de datos, etc.

En este artículo, enumeraremos algunas de las herramientas de análisis de datos imprescindibles que todo analista de datos experimentado debería tener. En esencia, un analista de datos se centra en:

- Recopilar, procesar y realizar análisis estadísticos de datos para detectar patrones importantes.

- Transformar y manipular grandes conjuntos de datos en formatos utilizables, como informes o presentaciones.

- Comunicación de información sobre datos mediante visualizaciones y técnicas narrativas.

Ahora que ya sabes qué hace un analista de datos, ¡vamos a ver cuáles son sus herramientas de trabajo!

Criterios para seleccionar una herramienta de análisis de datos

La ciencia de datos es un sector en rápida evolución. Cada día se lanzan nuevos programas y herramientas, incluidas herramientas de análisis de datos. Con un ecosistema tan dinámico, elegir las herramientas adecuadas puede resultar complicado, especialmente si eres nuevo en el campo de la ciencia de datos.

Al igual que cualquier caja de herramientas, ninguna herramienta es la mejor en términos absolutos para abordar todos los problemas a los que te enfrentarás como analista de datos. En cambio, la clave es contar con un conjunto completo y equilibrado de herramientas que te ayuden a tener éxito en cualquier situación.

Cada caso es diferente, y tú o la empresa para la que trabajas debéis tener en cuenta varios factores para encontrar la opción que mejor se adapte a tus necesidades. A continuación, encontrarás una lista de factores que debes evaluar antes de elegir tus herramientas de análisis de datos:

Identificar las necesidades empresariales

Probablemente este sea el factor más importante. Si bien es importante preguntarte qué herramientas quieres aprender y cuáles te gustan más, nunca debes olvidar preguntarte qué necesita tu empresa, o la empresa en la que te gustaría trabajar. Esto tiene sentido: si el resto del equipo utiliza Python, aprender primero R puede que no sea la decisión más inteligente.

Al mismo tiempo, siempre debes estar al tanto de las últimas tendencias y tecnologías de datos de vanguardia para poder aprenderlas y aumentar tu valor dentro del equipo.

Escalabilidad y flexibilidad

El panorama del big data ha cambiado drásticamente en los últimos años. Hoy en día, las empresas basadas en datos manejan enormes cantidades de datos en diversos formatos que a menudo se procesan casi en tiempo real.

En este contexto, la escalabilidad y la flexibilidad son fundamentales para el éxito. El panorama tecnológico de la ciencia de datos está creciendo rápidamente, con numerosas herramientas y aplicaciones diseñadas específicamente para abordar los retos que plantean el aumento del volumen, la velocidad y la variabilidad de los datos. Por lo tanto, al elegir tus herramientas, ten siempre en cuenta la flexibilidad y la escalabilidad que tú o tu equipo necesitáis.

Facilidad de uso y curva de aprendizaje

La facilidad de uso y la complejidad de las herramientas de análisis de datos varían considerablemente. Cuantas más funciones y capacidades avanzadas, más pronunciada es la curva de aprendizaje. Por el contrario, las herramientas de análisis de datos más sencillas son más adecuadas para usuarios sin conocimientos técnicos, que podrán empezar a utilizarlas rápidamente.

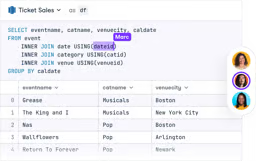

DataLab

Sáltate el proceso de instalación y experimenta con código de ciencia de datos en tu navegador con DataLab, el cuaderno de DataCamp potenciado por IA.

Las 9 mejores herramientas de análisis de datos

Teniendo en cuenta los factores anteriores, aquí tienes la lista de las 9 mejores herramientas de análisis de datos para analistas de datos.

1. Python

Python, que ocupa el primer lugar en los índices de popularidad de varios lenguajes de programación, es una herramienta imprescindible para los analistas de datos. Python es un lenguaje de programación de código abierto y extremadamente versátil con una amplia aplicabilidad en la industria de la ciencia de datos y otras disciplinas, como el desarrollo web y el desarrollo de videojuegos. Puedes leer más sobre para qué se utiliza Python en otra publicación.

Python puede realizar cualquier tarea relacionada con la ciencia de datos. Esto se debe principalmente a su rico ecosistema de bibliotecas. Con miles de potentes paquetes respaldados por su enorme comunidad de usuarios, Python puede realizar todo tipo de operaciones, desde el preprocesamiento de datos, la visualización y el análisis estadístico hasta la implementación de modelos de machine learning y aprendizaje profundo.

Debido a su sintaxis sencilla y legible, Python suele considerarse uno de los lenguajes de programación más fáciles de aprender para los principiantes.

Sin embargo, cuando se trata de procesar grandes cantidades de datos, otros lenguajes de programación y soluciones, como Julia o Spark, pueden ofrecer un mejor rendimiento y eficiencia que Python.

Si quieres ser un experto en Python, DataCamp está aquí para ayudarte. Encontrarás muchos cursos de Python para todos los niveles en nuestro catálogo de cursos. Echa un vistazo a nuestro programa de analista de datos con Python y prepárate para tu viaje de aprendizaje de Python.

2. Programación en R

Aunque no es tan popular como Python, R sigue siendo una de las mejores opciones para los analistas de datos. A menudo considerado como el principal competidor de Python, aprender uno (o ambos) de estos dos lenguajes es un paso fundamental para convertirse en analista de datos. Echa un vistazo a nuestra comparación entre Python y R para obtener más detalles.

R es un lenguaje de código abierto específico para un dominio, diseñado explícitamente para la ciencia de datos y la informática avanzada. Muy popular en el mundo financiero y académico, R es un lenguaje perfecto para la manipulación, el procesamiento y la visualización de datos, así como para el cálculo estadístico y machine learning.

R cuenta con una gran comunidad de usuarios y una amplia colección de bibliotecas especializadas para el análisis de datos y machine learning. Algunos de los más destacados pertenecen a la familia Tidyverse, una colección de paquetes de ciencia de datos. Incluye dplyr para la manipulación de datos y el potente ggplot2, la biblioteca estándar para la visualización de datos en R.

En comparación con Python, los principiantes pueden encontrar R más difícil y menos versátil. Sin embargo, si eres nuevo en la ciencia de datos o deseas añadir nuevos lenguajes a tu arsenal, aprender R es una opción perfecta. Echa un vistazo a nuestro amplio catálogo de cursos de R, incluido nuestro popular curso Introducción a R, para perfeccionar tus habilidades hoy mismo. También puedes seguir nuestro programa de analista de datos con R .

3. SQL

Gran parte de los datos del mundo se almacenan en bases de datos. SQL (Structured Query Language) es un lenguaje específico de dominio que permite a los programadores comunicarse con bases de datos, editarlas y extraer datos de ellas. Es imprescindible tener sólidos conocimientos de bases de datos y SQL si quieres convertirte en analista de datos.

Saber SQL te permitirá trabajar con diferentes bases de datos relacionales, incluidos sistemas populares como SQLite, MySQL y PostgreSQL.

Tanto si eliges Python como R para iniciar tu andadura como analista de datos, también deberías plantearte aprender SQL. Debido a su sintaxis declarativa y sencilla, SQL es muy fácil de aprender en comparación con otros lenguajes y te será de gran ayuda a lo largo del camino.

Sin embargo, aunque la sintaxis SQL parece sencilla y rudimentaria, escribir consultas SQL avanzadas puede resultar complicado, especialmente cuando se trata de bases de datos grandes y complejas.

¿Quieres iniciarte en SQL? Echa un vistazo a nuestro programa de analista de datos en SQL para convertirte en un experto en consultas.

4. Julia

A pesar de ser un lenguaje relativamente joven —se lanzó en 2011—, Julia ya ha impresionado al mundo de la computación numérica.

Julia es un nuevo y emocionante lenguaje de programación concebido desde sus fundamentos para ser el lenguaje ideal para la computación científica, machine learning y la minería de datos. Julia logra este objetivo al combinar la velocidad de C, la capacidad de programación general de Python y la destreza estadística de R.

En los últimos años, Julia ha ido ganando impulso de forma constante, y cada vez más profesionales de los datos optan por Julia en lugar de Python debido a su asombroso rendimiento. Puedes leer más sobre para qué se utiliza Julia en nuestra guía independiente.

Sin embargo, Julia aún no está tan extendida como lenguajes como Python y R. Tu comunidad es más pequeña y no cuenta con tantas bibliotecas como sus principales competidores.

DataCamp ha estado trabajando duro para actualizar su catálogo con nuevos cursos de Julia. Para empezar a familiarizarte con esta estrella emergente de la ciencia de datos, echa un vistazo a nuestro programa formativo«Fundamentos de Julia».

5. Excel

Microsoft Excel no necesita mucha presentación, porque todo el mundo lo conoce. Una herramienta clásica en el análisis de datos, muchos gurús han predicho su desaparición en las últimas décadas. Sin embargo, las predicciones no podían estar más equivocadas. A pesar de la aparición de herramientas más flexibles y potentes, Excel sigue siendo la herramienta preferida para muchas tareas diarias de análisis de datos.

Excel combina potentes funciones con una interfaz fácil de usar, lo que lo hace perfecto tanto para analistas de datos experimentados como para usuarios con menos conocimientos técnicos. También es una herramienta excelente gracias a su perfecta integración con la pila de BI de Microsoft, incluido PowerBI.

Excel está diseñado específicamente para ser accesible y fácil de usar. Sin embargo, esto tiene un precio: Excel no es tan flexible como otras herramientas como Python o R, y algunas operaciones complejas pueden no ser tan sencillas.

Sin embargo, aprender Excel es una decisión inteligente, ya que es muy probable que parte de tu trabajo como analista de datos implique manejar hojas de cálculo de Excel. Echa un vistazo a nuestro catálogo, donde encontrarás cursos sobre este tema, como Análisis de datos en Excel, Preparación de datos en Excel y Visualización de datos en Excel.

Avanza en tu carrera con Excel

Adquiere los conocimientos necesarios para sacar el máximo partido a Excel, sin necesidad de experiencia.

6. Spark

Las herramientas convencionales de análisis de datos, como Python o R, pueden resultar insuficientes cuando se trata de conjuntos de datos enormes. Se requiere un conjunto diferente de herramientas para procesar conjuntos de datos con millones de filas a alta velocidad, incorporando técnicas avanzadas para proporcionar un alto rendimiento.

Entre estas soluciones, Apache Spark es probablemente la más popular. Spark es una plataforma para la computación en clúster. Spark te permite distribuir datos y cálculos entre clústeres con múltiples nodos (piensa en cada nodo como un ordenador independiente). Dividir los datos facilita el trabajo con conjuntos de datos muy grandes, ya que cada nodo solo trabaja con una pequeña cantidad de datos.

Un aspecto clave de Spark es su integración con otras herramientas de análisis de datos, incluido Python. PySpark es el paquete de Python que hace posible la magia. Estas integraciones facilitan a los analistas de datos empezar a trabajar con Spark.

¿Quieres aprender Spark? Nuestro curso Introducción a PySpark es un excelente punto de partida.

7. Power BI

Power BI es una solución de análisis empresarial basada en la nube que te permite combinar diferentes fuentes de datos, analizarlos y presentar el análisis de datos a través de visualizaciones, informes y paneles.

Según el Cuadrante Mágico de Gartner, PowerBI de Microsoft es el líder del sector en soluciones de BI. Power BI facilita el acceso a los datos desde prácticamente cualquier dispositivo, tanto dentro como fuera de la organización.

Entre sus características esenciales, Power BI incluye:

- Conectividad directa con Excel y fácil integración con otros productos de Microsoft.

- Capacidad para comprimir datos y extraer información valiosa de grandes conjuntos de datos.

- Personalización mediante R y Python

- Uso de Power Query para importar, filtrar y traducir datos

- Una experiencia de usuario adaptable y agradable.

Sin embargo, al igual que Excel, Power BI a veces sacrifica la flexibilidad en aras de la accesibilidad. Algunas operaciones pueden ser difíciles de realizar y las funcionalidades en ciertas áreas pueden verse limitadas. Del mismo modo, a pesar de su interfaz intuitiva, PowerBI puede resultar complejo, especialmente cuando se utiliza junto con otras herramientas interrelacionadas.

Todo aspirante a analista de datos debe dominar al menos una herramienta de BI. Power BI es sin duda uno de los mejores candidatos. DataCamp cuenta con abundante material sobre esta herramienta, desde nuestro curso Introducción a Power BI hasta temas más avanzados, como nuestro curso Informes en Power BI.

Domina Power BI desde cero

8. Cuadro

Fundada en 2003 en la Universidad de Stanford, Tableau es una potente y popular herramienta de visualización de datos que te permite analizar datos de múltiples fuentes simultáneamente.

Tableau es una de las mejores herramientas de BI de su clase. Lo utilizan las principales empresas para extraer información valiosa de grandes cantidades de datos sin procesar. Gracias a su plataforma intuitiva y potente, tanto los usuarios técnicos como los no técnicos pueden crear paneles visuales y hojas de cálculo.

En muchos aspectos, Tableau ofrece las mismas capacidades que Power BI. Sin embargo, se considera una herramienta más compleja para los principiantes. Por lo tanto, si solo te interesa crear gráficos sencillos, debes elegir opciones menos complejas. Además, una desventaja importante de Tableau es que no existe una versión gratuita, por lo que tendrás que pagar una suscripción bastante costosa para poder utilizarlo.

A pesar de ello, muchas organizaciones siguen eligiendo Tableau por sus capacidades únicas y potentes. Echa un vistazo a nuestro curso Introducción a Tableau y a nuestro curso Creación de paneles en Tableau para descubrir esta maravillosa herramienta.

Domina Tableau desde cero

Acelera tu carrera con Tableau: no necesitas experiencia.

9. DataLab

El trabajo de un analista de datos no sería posible sin los IDE (entornos de desarrollo integrados). Estas herramientas de programación proporcionan interfaces potentes e intuitivas que facilitan la escritura, la depuración y la comprobación del código.

Existen muchos IDE populares, como JupyterLab o RStudio, pero no queremos perder esta oportunidad para hablaros del DataLab propio de DataCamp.

Diseñado con la democratización de los datos en mente, DataLab es una herramienta valiosa para la colaboración en equipo y el aprendizaje organizativo en diversos sectores.

Con el nuevo asistente de IA, DataLab pretende hacer que la ciencia de datos sea aún más accesible y productiva para sus usuarios. Entre las funciones principales del asistente de IA se encuentra el botón «Corregir error», que no solo corrige los errores del código, sino que también los explica, lo que permite a los usuarios aprender y evitar repetir los mismos errores.

La función «Generar código» te permite generar código basado en consultas en lenguaje natural y responder preguntas clave sobre un conjunto de datos. Además, el asistente de IA ofrece sugerencias inteligentes basadas en el código y el contexto existentes, lo que hace que la escritura de código sea más inteligente y eficiente.

Disponible tanto en los planes gratuitos como en los de pago de DataLab, el asistente de IA promete una integración más fluida en el conjunto de herramientas de los científicos de datos modernos, lo que permite a cualquiera que trabaje con datos tomar decisiones informadas. Puedes empezar a utilizar DataLab de forma gratuita.

10. Google BigQuery

Google BigQuery es un almacén de datos sin servidor y totalmente gestionado que permite realizar análisis escalables de grandes conjuntos de datos. Forma parte de Google Cloud Platform y está diseñado para realizar consultas a gran velocidad en grandes volúmenes de datos.

BigQuery resulta especialmente útil para organizaciones que analizan conjuntos de datos masivos de forma rápida y eficiente sin tener que gestionar la infraestructura subyacente.

BigQuery resulta especialmente valioso para las empresas que se dedican al análisis de datos a gran escala, en particular aquellas que ya utilizan los servicios de la nube de Google. Sin embargo, los costes pueden acumularse en función de la cantidad de datos procesados, por lo que es importante gestionar tus consultas de manera eficiente para optimizar los costes.

Añadir estas herramientas a tu caja de herramientas puede ayudarte a abordar una gama más amplia de tareas de análisis de datos, especialmente en campos especializados o cuando se trata del procesamiento de datos a gran escala.

Consulta nuestro curso Introducción a BigQuery para obtener más información sobre esta increíble herramienta.

Tendencias futuras en herramientas de análisis de datos

Todo evoluciona rápidamente en el sector de la ciencia de datos. Cualquier pequeño avance innovador puede cambiar por completo el panorama tecnológico. Las herramientas y soluciones que hoy parecen ser las más habituales pueden quedar obsoletas mañana, a medida que las tecnologías emergentes con nuevas y potentes capacidades lleguen al mercado.

Esto queda claramente ilustrado por la revolución de la IA que se ha producido tras el lanzamiento de chatGPT. Con sus impresionantes capacidades, chatGPT y muchas otras tecnologías de IA generativa impulsadas por grandes modelos lingüísticos, la IA está cambiando rápidamente la forma en que se conciben la ciencia de datos y el desarrollo de software.

Estas herramientas pronto se convertirán en una parte esencial de la caja de herramientas del analista de datos. Por lo tanto, aprenderlos es esencial. Por suerte, en DataCamp te tenemos cubierto. Estamos trabajando duro para ofrecerte los mejores cursos y materiales para navegar por la revolución de la IA, incluyendo nuestro popular curso Generative AI Concepts Coursey nuestro AI Essentials Skill Program.

Reflexiones finales

Convertirse en analista de datos es una de las mejores decisiones que puede tomar cualquier persona interesada en la ciencia de datos. Aprender a utilizar las herramientas adecuadas de análisis de datos será una parte fundamental de tu trayectoria. Solo nos queda desearte un buen viaje y esperar que nuestros cursos, tutoriales, hojas de referencia y demás materiales te sean de utilidad.

Aquí tienes una lista con nuestras recomendaciones de aprendizaje para empezar:

Analista de datos con Python

Este programa comienza con los conceptos básicos del lenguaje de programación Python para el análisis de datos. Una vez cubiertos los conceptos básicos, profundizarás en las técnicas de manipulación y visualización de datos.

También aprenderás a obtener datos de diferentes fuentes, como la web, bases de datos y archivos JSON. Por último, este programa ofrece una visión general de las técnicas de análisis exploratorio de datos y mejora las habilidades del alumno en bases de datos relacionales y conceptos SQL.

Analista de datos con R

Este programa se centra en las habilidades principales que necesitan los analistas de datos que trabajan con el lenguaje de programación R. Ofrece contenido completo que abarca los paquetes R más utilizados, como tidyverse, ggplot y dplyr.

Al igual que el programa de Python, este curso ayuda a desarrollar conocimientos intermedios sobre habilidades de análisis de datos, como la obtención, manipulación y visualización de datos.

Analista de datos con SQL

Este programa de carrera ayuda al alumno a desarrollar un conocimiento profundo de SQL Server, los conceptos de las bases de datos relacionales, su diseño y la optimización del rendimiento.

Preguntas frecuentes

¿Cómo puedo determinar el equilibrio adecuado entre aprender a utilizar varias herramientas y especializarme en una sola?

Si bien es esencial tener un amplio conocimiento de diversas herramientas, centrarse primero en dominar una o dos herramientas clave, como Python o SQL, puede proporcionar una base sólida. Una vez que domines estas herramientas, podrás ampliar gradualmente tus habilidades aprendiendo a utilizar otras herramientas adicionales que complementen tu experiencia principal. El equilibrio adecuado depende de tus objetivos profesionales y de las necesidades específicas del sector o la empresa en la que deseas trabajar.

¿Qué debes tener en cuenta a la hora de decidir entre herramientas gratuitas y de pago para el análisis de datos?

A la hora de elegir entre herramientas gratuitas y de pago, ten en cuenta las funciones específicas que necesitas, la escalabilidad de la herramienta y el tamaño de los conjuntos de datos con los que vas a trabajar. Las herramientas gratuitas como Python o R pueden ser muy potentes, especialmente con sus amplias bibliotecas. Sin embargo, las herramientas de pago como Tableau o Power BI pueden ofrecer un mejor soporte, funciones avanzadas y capacidades de integración que justifican su coste, especialmente en un entorno profesional.

¿Qué tan importante es estar al día con las últimas herramientas y tendencias de análisis de datos?

Mantenerse al día con las últimas herramientas y tendencias es fundamental en el campo de la ciencia de datos, que evoluciona rápidamente. Las nuevas herramientas suelen ofrecer un rendimiento mejorado, una mayor integración o nuevas funcionalidades que pueden mejorar significativamente tu productividad y la calidad de tus análisis. Participar regularmente en comunidades profesionales, asistir a seminarios web y realizar cursos de actualización puede ayudarte a mantener tus habilidades al día.

¿Cuáles son algunos de los retos más comunes a los que se enfrentan los analistas de datos a la hora de integrar nuevas herramientas en tu flujo de trabajo?

Entre los retos más comunes se encuentran los problemas de compatibilidad con las herramientas existentes, la pronunciada curva de aprendizaje asociada a las nuevas herramientas y la resistencia de los miembros del equipo que están acostumbrados a utilizar determinadas herramientas. Además, la transición a una nueva herramienta puede requerir mucho tiempo y esfuerzo en términos de configuración, migración de datos y ajustes de procesos.

¿Cómo puede un analista de datos comunicar eficazmente la necesidad de adoptar nuevas herramientas a su equipo o a la dirección?

Para comunicar eficazmente la necesidad de nuevas herramientas, un analista de datos debe presentar un caso claro que destaque las limitaciones de las herramientas actuales y cómo las nuevas herramientas pueden subsanar estas deficiencias. Esto puede incluir demostrar el ahorro de tiempo potencial, la mejora de la precisión, una mayor escalabilidad y los beneficios a largo plazo para la empresa. Proporcionar casos prácticos o ejemplos de otras empresas también puede reforzar tu argumento.

Soy analista de datos autónomo y colaboro con empresas y organizaciones de todo el mundo en proyectos de ciencia de datos. También soy instructor de ciencia de datos con más de 2 años de experiencia. Escribo regularmente artículos relacionados con la ciencia de datos en inglés y español, algunos de los cuales se han publicado en sitios web consolidados como DataCamp, Towards Data Science y Analytics Vidhya Como científico de datos con formación en ciencias políticas y derecho, mi objetivo es trabajar en la interacción de las políticas públicas, el derecho y la tecnología, aprovechando el poder de las ideas para promover soluciones y narrativas innovadoras que puedan ayudarnos a abordar retos urgentes, como la crisis climática. Me considero autodidacta, aprendiz constante y firme partidaria de la multidisciplinariedad. Nunca es demasiado tarde para aprender cosas nuevas.