programa

Los modelos de lenguaje pequeños (SLM) son compactos, eficientes y no necesitan servidores masivos, a diferencia de sus homólogos, los modelos de lenguaje grandes (LLM). Están diseñadas para ofrecer velocidad y rendimiento en tiempo real, y pueden ejecutarse en nuestros teléfonos inteligentes, tabletas o relojes inteligentes.

En este artículo, examinaremos los 15 mejores SLM de 2026 y exploraremos sus puntos fuertes, sus puntos débiles y lo que hace que cada modelo sea único.

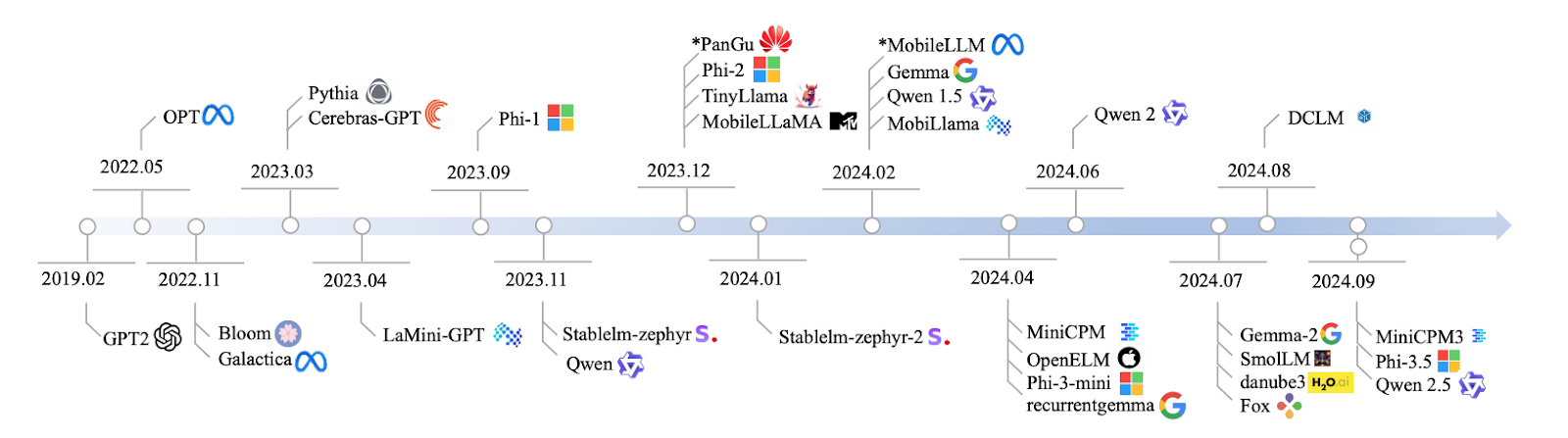

Fuente: Lu et al., 2024

Pasaré directamente a hablar de los modelos, pero si necesitas una introducción a los modelos de lenguaje pequeños, he escrito un artículo aparte aquí: Modelos lingüísticos pequeños: Guía con ejemplos.

1. Qwen2: 0,5B, 1B y 7B

Qwen2 es una familia de modelos, con tamaños que van desde los 500 millones hasta los 7000 millones de parámetros. Si estás trabajando en una aplicación que necesita un modelo superligero, la versión 0.5B es perfecta.

Sin embargo, si necesitas algo más robusto para tareas como la síntesis o la generación de texto, el modelo 7B es el que te ofrecerá un mayor rendimiento. Es escalable y se puede adaptar a tus necesidades específicas.

Es posible que los modelos Qwen2 no igualen las amplias capacidades de los enormes modelos de IA en cuanto a pensamiento complejo, pero son excelentes para muchos usos prácticos en los que la velocidad y la eficiencia son lo más importante. Son especialmente útiles para aplicaciones que requieren respuestas rápidas o recursos limitados.

- Parámetros: Versiones de 500 millones, 1000 millones y 7000 millones.

- Acceso: https://huggingface.co/Qwen

- Código abierto: Sí, con una licencia de código abierto.

2. Mistral Nemo 12B

Con 12 000 millones de parámetros, el modelo Mistral Nemo 12B es ideal para tareas complejas de PLN, como la traducción de idiomas y los sistemas de diálogo en tiempo real. Compite con modelos como Falcon 40B y Chinchilla 70B, pero puede funcionar a nivel local sin necesidad de una gran infraestructura. Es uno de esos modelos que equilibra la complejidad con la practicidad.

- Parámetros: 12 mil millones

- Access: https://huggingface.co/mistralai/Mistral-7B-Instruct-v0.2

- Código abierto: Sí, con una licencia Apache 2.0.

Desarrollar aplicaciones de IA

3. Llama 3.1 8B

Pasando a Llama 3.1 8B, este modelo tiene 8000 millones de parámetros y ofrece un equilibrio increíble entre potencia y eficiencia. Es ideal para tareas como responder preguntas y analizar opiniones.

Llama 3.1 8B ofrece un rendimiento bastante bueno si necesitas resultados rápidos sin una gran potencia de cálculo. Es perfecto para quienes desean velocidad sin sacrificar la precisión.

Para obtener experiencia práctica con este modelo, lee este tutorial sobre RAG con Llama 3.1 8B, Ollama y Langchain.

- Parámetros: 8 mil millones

- Acceso: https://ollama.com/library/llama3

- Código abierto: Sí, pero con restricciones de uso.

4. Pitia

Hablemos de la serie Pythia, un conjunto de modelos que van desde los 160 millones hasta los 2800 millones de parámetros, diseñados para tareas de razonamiento y habilidades de codificación. Si te gusta el desarrollo de software, Pythia es ideal para manejar tareas estructuradas y basadas en la lógica, en las que la precisión y la lógica son fundamentales. Es perfecto para entornos de programación en los que necesitas que el modelo piense de forma estructurada y lógica.

Ahora, en comparación con otros modelos como GPT-Neo, Pythia ofrece un mejor rendimiento en tareas como la codificación y el razonamiento, ya que está diseñado para estas aplicaciones específicas. Sin embargo, cuando lo utilizas en tareas lingüísticas más generales, las cosas pueden volverse un poco inestables: Phi 3.5 y Llama 3.1 8B pueden funcionar de manera más consistente en esas áreas más amplias. Cabe destacar que las opciones de transparencia y personalización de la formación pública de Pythia son realmente impresionantes. Puedes ajustarlo a tus necesidades específicas, lo que lo convierte en una herramienta increíblemente flexible.

- Parámetros: 160 MILLONES – 2800 MILLONES

- Acceso: https://github.com/EleutherAI/pythia

- Código abierto: Sí

5. Cerebras-GPT

Cerebras-GPT es un modelo eficiente y rápido. Con parámetros que van desde los 111 millones hasta los 2700 millones, está diseñado para entornos en los que los recursos computacionales son limitados, pero se necesita un gran rendimiento. Cerebras-GPT ofrece excelentes resultados sin consumir todos tus recursos.

Ahora bien, en comparación con modelos más grandes como GPT-3 o LLaMA 13B, es posible que Cerebras-GPT no tenga el mismo entrenamiento exhaustivo, pero sigue las leyes de escalabilidad de Chinchilla, lo que significa que es increíblemente eficiente en términos de computación. Modelos como GPT-J y GPT-NeoX pueden ser más voluminosos, pero Cerebras-GPT maximiza el rendimiento y mantiene un bajo consumo de recursos. Si necesitas escalabilidad y eficiencia, este modelo está optimizado para ofrecerte lo mejor de ambos mundos.

- Parámetros: 111 MILLONES – 2700 MILLONES

- Acceso: https://github.com/Cerebras

- Código abierto: Sí

6. Phi-3,5

Este modelo tiene 3800 millones de parámetros, pero esto es lo que lo hace único: 128K tokens de longitud de contexto. ¿Qué significa eso? Puede manejar documentos largos o tareas que impliquen conversaciones de varios turnos sin perder el contexto. Además, es multilingüe, lo que lo convierte en un fuerte competidor frente a modelos como Llama 13B y GPT-3.5, pero con unos requisitos computacionales mucho menores. Este modelo es ideal para resumir documentos, realizar tareas multilingües y aplicar razonamientos lógicos.

- Parámetros: 3800 millones

- Acceso: https://huggingface.co/microsoft/phi-2

- Código abierto: Sí, solo con fines de investigación.

7. StableLM-zephyr

StableLM-Zephyr es un pequeño modelo de lenguaje con 3000 millones de parámetros que resulta ideal cuando se busca precisión y velocidad. Este modelo proporciona una inferencia rápida y funciona increíblemente bien en entornos en los que es fundamental tomar decisiones rápidas, como los sistemas periféricos o los dispositivos con pocos recursos. Si necesitas algo preciso y rápido, StableLM-Zephyr es una excelente opción.

StableLM-Zephyr destaca en tareas que implican razonamiento e incluso interpretación de roles. Aunque es más ligero y rápido, es posible que no pueda realizar tareas más complejas, como escribir o programar, tan bien como los modelos más grandes, pero para su tamaño, tiene un rendimiento excelente. Si la velocidad y la eficiencia son tus prioridades, StableLM-Zephyr es una opción sólida.

- Parámetros: 3B

- Acceso: https://github.com/StabilityAI/stablelm

- Código abierto: Sí

8. TinyLlama

Hablemos de TinyLlama, un modelo compacto con 1100 millones de parámetros que funciona muy bien para su tamaño. Está diseñado para ser eficiente y es perfecto para dispositivos que no pueden soportar la gran carga computacional de los modelos más grandes.

Para tareas del mundo real, TinyLlama realmente funciona mejor que modelos como Pythia-1.4B, especialmente en lo que respecta al razonamiento basado en el sentido común. No tiene la potencia bruta de modelos como LLaMA 13B, pero ofrece un gran equilibrio entre rendimiento y eficiencia de recursos. Esto lo hace ideal para situaciones en las que necesitas potentes capacidades de IA sin sobrecargar el sistema, especialmente en dispositivos móviles y periféricos.

- Parámetros: 1.1B

- Acceso: https://github.com/tinyLlama

- Código abierto: Sí

9. MobileLLaMA

MobileLLaMA es una versión especializada de LLaMA diseñada para funcionar muy bien en dispositivos móviles y de baja potencia. Con 1400 millones de parámetros, está diseñado para ofrecer un equilibrio entre rendimiento y eficiencia, especialmente en dispositivos con recursos limitados.

MobileLLaMA está optimizado para aplicaciones de IA de alta velocidad y baja latencia sobre la marcha. Con versiones como MobileLLaMA-1.4B y MobileLLaMA-2.7B, supera fácilmente a modelos más pequeños como TinyLLaMA 1.1B y compite estrechamente con OpenLLaMA 3B, todo ello siendo aproximadamente un 40 % más rápido. Si necesitas IA en tiempo real directamente en tu dispositivo, MobileLLaMA es la solución perfecta. Este modelo está diseñado para llevar la IA de alto rendimiento directamente a tu móvil o sistemas periféricos sin necesidad de una infraestructura pesada.

- Parámetros: 1.4B

- Acceso: https://github.com/mobileLLaMA

- Código abierto: Sí

10. LaMini-GPT

LaMini-GPT es un modelo compacto pero potente, con entre 774 millones y 1500 millones de parámetros, que ha sido diseñado específicamente para tareas multilingües. Es especialmente eficaz en entornos con recursos limitados, lo que significa que puede manejar varios idiomas sin necesidad de una gran potencia computacional, lo que lo hace ideal para dispositivos o sistemas con recursos limitados.

Algo interesante sobre LaMini-GPT es que se desarrolló mediante la destilación de conocimientos de modelos más grandes de la familia GPT, lo que te permite funcionar muy bien en tareas de seguimiento de instrucciones. Con más de 2,58 millones de pares de instrucciones y respuestas en su conjunto de datos, está optimizado para gestionar tareas e instrucciones específicas de forma más eficiente que los modelos más grandes. Sin embargo, aunque es increíblemente eficiente y ligero, especialmente para tareas específicas, no es tan bueno para aplicaciones más amplias que requieren una comprensión contextual profunda o una generación de texto más general. Si buscas algo rápido y eficiente, especialmente en entornos multilingües, LaMini-GPT es una opción sólida.

- Parámetros: 774 MILLONES – 1500 MILLONES

- Acceso: https://github.com/LaMiniGPT

- Código abierto: Sí

11. Gemma2

Hablemos ahora de Gemma2. Este modelo tiene 2000 millones de parámetros y funciona muy bien si estás pensando en una implementación local. Es ligero y eficiente, ideal para tareas como la generación de texto o la traducción.

Cuando lo comparas con pesos pesados como OpenAI o1-preview, Gemma2 se centra en aplicaciones en tiempo real, no en razonamientos complejos. Para la computación periférica, es la alternativa perfecta a modelos como GPT-3.5 o Llama 65B, que consumen muchos recursos.

Si quieres familiarizarte con este SLM, lee este tutorial sobre cómo ajustar Gemma 2 y utilizarlo localmente.

- Parámetros: Versiones de 9 mil millones y 27 mil millones

- Acceso: https://ai.google.dev/gemma

- Código abierto: Sí, con una licencia permisiva que permite la redistribución, el ajuste y el uso comercial.

12. MiniCPM

MiniCPM es un modelo con un equilibrio sólido entre rendimiento y eficiencia de recursos, con tamaños de parámetros que oscilan entre 1000 millones y 4000 millones. Está diseñado para manejar fácilmente tareas lingüísticas generales y ofrece un rendimiento fiable en numerosas aplicaciones, lo que lo convierte en una excelente opción versátil.

MiniCPM es escalable y eficiente. A pesar de su menor tamaño, su rendimiento es similar al de modelos mucho más grandes, como Mistral-7B y LLaMA 7B. Está especialmente optimizado para el procesamiento del lenguaje tanto en inglés como en chino, lo que lo convierte en una alternativa muy eficaz y ligera para entornos en los que los recursos informáticos son limitados. Si trabajas en un entorno con recursos limitados, pero necesitas un procesamiento del lenguaje sólido, MiniCPM te ofrece una solución excelente.

- Parámetros: 1B – 4B

- Acceso: https://github.com/miniCPM

- Código abierto: Sí

13. OpenELM

OpenELM es un modelo flexible y adaptable con un rango de parámetros de entre 270 millones y 3000 millones. Está diseñado para entornos que requieren multitarea y respuestas de baja latencia. Esto es perfecto para tareas que requieren un rendimiento en tiempo real en dispositivos más pequeños.

Desarrollado por Apple, OpenELM se centra en la eficiencia energética y las aplicaciones de IA en dispositivos. Compite bien con modelos como MobiLlama y OLMo, mostrando mejoras significativas cuando se ajusta para tareas específicas. Con su amplia gama de tamaños de parámetros, OpenELM está optimizado para entornos más pequeños y con más limitaciones, a diferencia de modelos más pesados como GPT-4 o LLaMA, que necesitan más recursos para ofrecer un rendimiento comparable. Si estás buscando algo ligero pero potente, especialmente para uso móvil o periférico, OpenELM es una opción ideal.

- Parámetros: 270M – 3B

- Acceso: https://github.com/OpenELM

- Código abierto: Sí

14. DCLM

Analicemos DCLM, un modelo con mil millones de parámetros diseñado específicamente para el razonamiento basado en el sentido común. Funciona bien en tareas del mundo real en las que es fundamental comprender y hacer deducciones lógicas.

DCLM es bueno para la comprensión del lenguaje y el razonamiento, especialmente con su versión de 7000 millones de parámetros. Compite con modelos como LLaMA 2 (7B) y Mistral 7B, con un rendimiento igual de bueno en tareas como el razonamiento basado en el sentido común y la deducción lógica. Sin duda, no es tan potente como modelos más grandes como LLaMA 13B, pero DCLM está altamente optimizado para aplicaciones del mundo real que requieren eficiencia y menos recursos computacionales, por lo que cuando se dispone de entornos en los que se necesita un gran rendimiento sin una infraestructura pesada, DCLM es una excelente opción.

- Parámetros: 1B

- Acceso: https://github.com/DCLM

- Código abierto: Sí

15. Fox

Y por último, el modelo Fox, un modelo de 1600 millones de parámetros diseñado específicamente para ofrecer velocidad y eficiencia. Está optimizado para aplicaciones móviles, donde es fundamental mantener una latencia baja. Fox está diseñado para ofrecer respuestas rápidas sin consumir demasiada potencia computacional.

Fox funciona muy bien en entornos en los que se necesita velocidad. Maneja tareas de baja latencia muy rápido, lo que es ideal para dispositivos móviles o periféricos. No tiene un rendimiento tan bueno en razonamientos complejos, pero Fox es perfecto para situaciones en las que necesitas respuestas rápidas y eficientes de IA y no puedes permitirte utilizar recursos pesados. Es el modelo ideal cuando la potencia computacional es limitada, pero la velocidad es una prioridad.

- Parámetros: 1.6B

- Acceso: https://github.com/foxmodel

- Código abierto: Sí

Comparación de modelos lingüísticos pequeños

Resumamos lo que hemos visto en esta tabla:

|

Nombre del modelo |

Parámetros |

Código abierto |

Características principales |

|

Qwen2 |

0.5B, 1B, 7B |

Sí |

Escalable, adecuado para diversas tareas. |

|

Mistral Nemo 12B |

12B |

Sí |

Tareas complejas de PLN, implementación local |

|

Llama 3.1 8B |

8B |

Sí* |

Potencia y eficiencia equilibradas |

|

Pitia |

160 MILLONES - 2800 MILLONES |

Sí |

Centrado en el razonamiento y la codificación |

|

Cerebras-GPT |

111 MILLONES - 2700 MILLONES |

Sí |

Eficiente en términos computacionales, sigue las leyes de escalabilidad de Chinchilla. |

|

Phi-3,5 |

3.8B |

Sí** |

Longitud de contexto larga (128 000 tokens), multilingüe |

|

StableLM-zephyr |

3B |

Sí |

Inferencia rápida, eficiente para sistemas periféricos. |

|

TinyLlama |

1.1B |

Sí |

Eficaz para dispositivos móviles y periféricos |

|

MobileLLaMA |

1.4B |

Sí |

Optimizado para dispositivos móviles y de bajo consumo energético. |

|

LaMini-GPT |

774 MILLONES - 1500 MILLONES |

Sí |

Tareas multilingües que requieren seguir instrucciones. |

|

Gemma2 |

9B, 27B |

Sí |

Implementación local, aplicaciones en tiempo real |

|

MiniCPM |

1B - 4B |

Sí |

Rendimiento equilibrado, optimizado para inglés y chino. |

|

OpenELM |

270M - 3B |

Sí |

Multitarea, baja latencia, eficiencia energética. |

|

DCLM |

1B |

Sí |

Razonamiento basado en el sentido común, deducción lógica. |

|

Fox |

1,6 MIL MILLONES |

Sí |

Velocidad optimizada para aplicaciones móviles. |

*Con restricciones de uso.

**Solo para fines de investigación.

Conclusión

Y esto es todo por este artículo, un pequeño recorrido por el mundo de los modelos de lenguaje pequeños en 2026. Hemos visto cómo estos modelos demuestran que más pequeño no significa más débil, sino más inteligente en muchos sentidos.

Espera ver estos SLM integrados en más de tus experiencias tecnológicas diarias. Recuerda que se trata de elegir los modelos adecuados para cada trabajo y, en muchos casos, el modelo adecuado puede ser pequeño y ágil.

Para obtener más información sobre los modelos de lenguaje pequeños, recomiendo estos dos recursos:

Ana Rojo Echeburúa es especialista en IA y datos y doctora en Matemáticas Aplicadas. Le encanta convertir los datos en información práctica y tiene una amplia experiencia dirigiendo equipos técnicos. A Ana le gusta trabajar en estrecha colaboración con los clientes para resolver sus problemas empresariales y crear soluciones innovadoras de IA. Conocida por su capacidad para resolver problemas y su claridad de comunicación, es una apasionada de la IA, especialmente de la IA generativa. Ana se dedica al aprendizaje continuo y al desarrollo ético de la IA, así como a simplificar problemas complejos y explicar la tecnología de forma accesible.