Cursus

Les modèles linguistiques de petite taille (SLM) sont compacts, efficaces et ne nécessitent pas de serveurs massifs, contrairement à leurs homologues, les grands modèles linguistiques (LLM). Ils sont conçus pour offrir vitesse et performances en temps réel et peuvent fonctionner sur nos smartphones, tablettes ou montres connectées.

Dans cet article, nous examinerons les 15 meilleurs SLM de 2026 et explorerons leurs forces, leurs faiblesses et ce qui rend chaque modèle unique.

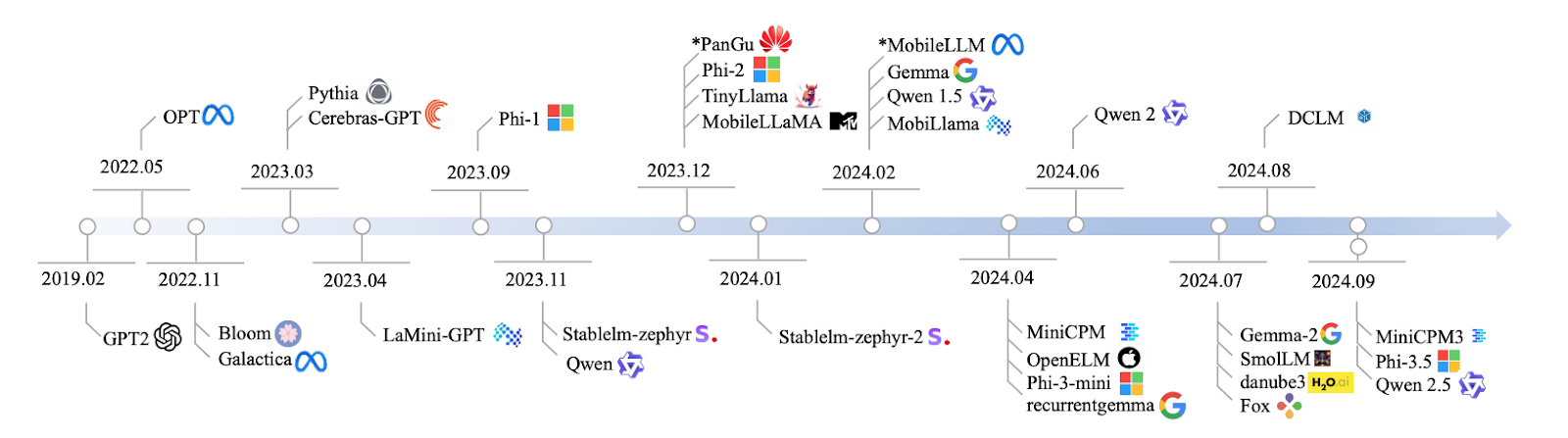

Source : Lu et al., 2024

Je vais passer directement à la discussion des modèles, mais si vous avez besoin d'une introduction aux petits modèles linguistiques, j'ai rédigé un article séparé à ce sujet ici : Modèles linguistiques de petite taille : Un guide illustré d'exemples.

1. Qwen2 : 0,5B, 1B et 7B

Qwen2 est une famille de modèles dont la taille varie de 0,5 milliard à 7 milliards de paramètres. Si vous travaillez sur une application qui nécessite un modèle extrêmement léger, la version 0.5B est idéale.

Toutefois, si vous avez besoin d'un modèle plus robuste pour des tâches telles que la synthèse ou la génération de texte, le modèle 7B est celui qui vous offrira les meilleures performances. Il est évolutif et peut être adapté à vos besoins spécifiques.

Les modèles Qwen2 ne peuvent pas rivaliser avec les capacités étendues des modèles d'IA de grande envergure en matière de réflexion complexe, mais ils sont excellents pour de nombreuses utilisations pratiques où la rapidité et l'efficacité sont primordiales. Ils sont particulièrement utiles pour les applications nécessitant des réponses rapides ou des ressources limitées.

- Paramètres : Versions 0,5 milliard, 1 milliard et 7 milliards

- Accès : https://huggingface.co/Qwen

- Open source : Oui, avec une licence open source.

2. Mistral Nemo 12B

Avec 12 milliards de paramètres, le modèle Mistral Nemo 12B est idéal pour les tâches complexes de traitement du langage naturel, telles que la traduction linguistique et les systèmes de dialogue en temps réel. Il est en concurrence avec des modèles tels que Falcon 40B et Chinchilla 70B, mais il peut néanmoins fonctionner localement sans nécessiter une infrastructure importante. C'est l'un de ces modèles qui allient complexité et fonctionnalité.

- Paramètres : douze milliards

- Accès : https://huggingface.co/mistralai/Mistral-7B-Instruct-v0.2

- Open source : Oui, avec une licence Apache 2.0.

Développer des applications d'IA

3. Llama 3.1 8B

Passons maintenant à Llama 3.1 8B. Ce modèle dispose de 8 milliards de paramètres et offre un équilibre remarquable entre puissance et efficacité. Il est particulièrement adapté à des tâches telles que la réponse à des questions et l'analyse des sentiments.

Llama 3.1 8B offre des performances satisfaisantes si vous avez besoin de résultats rapides sans nécessiter une puissance de calcul importante. Il est idéal pour ceux qui recherchent la rapidité sans compromettre la précision.

Pour acquérir une expérience pratique avec ce modèle, veuillez consulter ce tutoriel sur RAG avec Llama 3.1 8B, Ollama et Langchain.

- Paramètres : huit milliards

- Access: https://ollama.com/library/llama3

- Open source : Oui, mais avec des restrictions d'utilisation.

4. Pythie

Nous allons aborder la série Pythia, un ensemble de modèles comprenant entre 160 millions et 2,8 milliards de paramètres, conçus pour des tâches de raisonnement et de codage. Si vous êtes intéressé par le développement de logiciels, Pythia est un excellent outil pour gérer des tâches structurées et basées sur la logique, où la précision et la logique sont essentielles. Il est idéal pour les environnements de codage où il est nécessaire que le modèle réfléchisse de manière structurée et logique.

À présent, comparé à d'autres modèles tels que GPT-Neo, Pythia affiche de meilleures performances dans des tâches telles que le codage et le raisonnement, car il est conçu pour ces applications spécifiques. Cependant, lorsque vous l'utilisez dans des tâches linguistiques plus générales, les résultats peuvent être moins fiables. Phi 3.5 et Llama 3.1 8B pourraient offrir des performances plus constantes dans ces domaines plus vastes. Il convient de noter que la transparence et les options de personnalisation de la formation publique Pythia sont particulièrement remarquables. Vous pouvez l'adapter à vos besoins spécifiques, ce qui en fait un outil extrêmement flexible.

- Paramètres : 160 MILLIONS – 2,8 MILLIARDS

- Accès : https://github.com/EleutherAI/pythia

- Source ouverte : Oui

5. Cerebras-GPT

Cerebras-GPT est un modèle efficace et rapide. Avec des paramètres allant de 111 millions à 2,7 milliards, il est conçu pour les environnements où les ressources informatiques sont limitées, mais où vous avez tout de même besoin de performances élevées. Cerebras-GPT offre d'excellents résultats sans épuiser toutes vos ressources.

À présent, comparé à des modèles plus importants tels que GPT-3 ou LLaMA 13B, Cerebras-GPT n'a peut-être pas bénéficié d'un entraînement aussi approfondi, mais il suit les lois d'échelle de Chinchilla, ce qui signifie qu'il est extrêmement efficace en termes de calcul. Les modèles tels que GPT-J et GPT-NeoX peuvent être plus volumineux, mais Cerebras-GPT optimise les performances tout en conservant une faible utilisation des ressources. Si vous recherchez évolutivité et efficacité, ce modèle est optimisé pour vous offrir le meilleur des deux mondes.

- Paramètres : 111 MILLIONS – 2,7 MILLIARDS

- Accès : https://github.com/Cerebras

- Open source : Oui

6. Phi-3,5

Ce modèle comporte 3,8 milliards de paramètres, mais voici ce qui le rend unique : 128 Ko de jetons de longueur de contexte. Que signifie cela ? Il est capable de traiter des documents volumineux ou des tâches impliquant des conversations à plusieurs tours sans perdre le fil du contexte. Il est également multilingue, ce qui en fait un concurrent sérieux face à des modèles tels que Llama 13B et GPT-3.5, mais avec des exigences informatiques nettement moins élevées. Ce modèle est particulièrement adapté à la synthèse de documents, aux tâches multilingues et au raisonnement logique.

- Paramètres : 3,8 milliards

- Accès : https://huggingface.co/microsoft/phi-2

- Open source : Oui, uniquement à des fins de recherche.

7. StableLM-zephyr

StableLM-Zephyr est un modèle linguistique compact doté de 3 milliards de paramètres, particulièrement adapté lorsque précision et rapidité sont requises. Ce modèle offre une inférence rapide et fonctionne remarquablement bien dans les environnements où la prise de décision rapide est essentielle, comme les systèmes périphériques ou les appareils à faibles ressources. Si vous recherchez un outil performant et rapide, StableLM-Zephyr constitue une excellente option.

StableLM-Zephyr excelle dans les tâches qui impliquent le raisonnement et même le jeu de rôle. Bien qu'il soit plus léger et plus rapide, il peut ne pas être aussi performant que les modèles plus grands pour les tâches plus complexes telles que l'écriture ou le codage, mais compte tenu de sa taille, il offre d'excellentes performances. Si la rapidité et l'efficacité sont vos priorités, StableLM-Zephyr constitue un choix judicieux.

- Paramètres : 3B

- Accès : https://github.com/StabilityAI/stablelm

- Open source : Oui

8. TinyLlama

Veuillez considérer TinyLlama, un modèle compact doté de 1,1 milliard de paramètres qui offre des performances remarquables compte tenu de sa taille. Il est conçu pour être efficace et convient parfaitement aux appareils qui ne peuvent pas supporter la charge de calcul importante des modèles plus volumineux.

Pour les tâches du monde réel, TinyLlama obtient en réalité de meilleurs résultats que des modèles tels que Pythia-1.4B, en particulier pour le raisonnement de bon sens. Il ne dispose pas de la puissance brute de modèles tels que LLaMA 13B, mais il offre un excellent équilibre entre performances et efficacité des ressources. Cela le rend idéal pour les scénarios où vous avez besoin de capacités d'IA puissantes sans surcharger le système, en particulier sur les appareils mobiles et périphériques.

- Paramètres : 1.1B

- Access: https://github.com/tinyLlama

- Open source : Oui

9. MobileLLaMA

MobileLLaMA est une version spécialisée de LLaMA conçue pour fonctionner de manière optimale sur les appareils mobiles et à faible consommation d'énergie. Avec 1,4 milliard de paramètres, il est conçu pour vous offrir un équilibre entre performances et efficacité, en particulier sur les appareils aux ressources limitées.

MobileLLaMA est optimisé pour les applications d'IA mobiles rapides et à faible latence. Avec des versions telles que MobileLLaMA-1.4B et MobileLLaMA-2.7B, il surpasse facilement les modèles plus petits comme TinyLLaMA 1.1B et rivalise étroitement avec OpenLLaMA 3B, tout en étant environ 40 % plus rapide. Si vous avez besoin d'une intelligence artificielle en temps réel directement sur votre appareil, MobileLLaMA est la solution idéale. Ce modèle est conçu pour apporter une IA haute performance directement sur votre mobile ou vos systèmes périphériques. systèmes périphériques sans nécessiter d'infrastructure lourde.

- Paramètres : 1.4B

- Access: https://github.com/mobileLLaMA

- Open source : Oui

10. LaMini-GPT

LaMini-GPT est un modèle compact mais puissant, comprenant entre 774 millions et 1,5 milliard de paramètres, spécialement conçu pour les tâches multilingues. Il est particulièrement performant dans les environnements aux ressources limitées, ce qui signifie qu'il peut gérer plusieurs langues sans nécessiter une grande puissance de calcul, ce qui convient parfaitement aux appareils ou systèmes aux ressources limitées.

Une caractéristique intéressante de LaMini-GPT est qu'il a été développé grâce à la distillation des connaissances issues de modèles plus importants de la famille GPT, ce qui lui permet d'obtenir d'excellents résultats dans les tâches nécessitant le suivi d'instructions. Avec plus de 2,58 millions de paires instruction-réponse dans son ensemble de données, il est optimisé pour traiter des tâches et des instructions spécifiques plus efficacement que les modèles plus volumineux. Cependant, bien qu'il soit extrêmement efficace et léger, en particulier pour des tâches spécifiques, il n'est pas aussi performant pour des applications plus générales qui nécessitent une compréhension contextuelle approfondie ou une génération de texte plus générale. Si vous recherchez une solution rapide et efficace, en particulier dans des contextes multilingues, LaMini-GPT constitue un choix judicieux.

- Paramètres : 774 MILLIONS – 1,5 MILLIARD

- Access: https://github.com/LaMiniGPT

- Open source : Oui

11. Gemma2

Veuillez maintenant nous parler de Gemma2. Ce modèle dispose de 2 milliards de paramètres et fonctionne très bien si vous envisagez un déploiement local. Il est léger et efficace, ce qui le rend idéal pour des tâches telles que la génération de texte ou la traduction.

Lorsque l'on compare ce modèle à des poids lourds tels que OpenAI o1-preview, Gemma2 se concentre sur les applications en temps réel, et non sur le raisonnement complexe. Pour l'informatique de pointe, il s'agit d'une alternative idéale aux modèles tels que GPT-3.5 ou Llama 65B, qui sont très gourmands en ressources.

Si vous souhaitez vous familiariser avec ce SLM, veuillez consulter ce tutoriel sur le réglage de Gemma 2 et son utilisation en local.

- Paramètres : 9 milliards et 27 milliards de versions

- Access: https://ai.google.dev/gemma

- Open source : Oui, avec une licence permissive autorisant la redistribution, la modification et l'utilisation commerciale.

12. MiniCPM

MiniCPM est un modèle présentant un équilibre solide entre performances et efficacité des ressources, avec des tailles de paramètres allant de 1 à 4 milliards. Il est conçu pour traiter facilement les tâches linguistiques générales et offre des performances fiables dans de nombreuses applications, ce qui en fait une excellente option polyvalente.

MiniCPM est évolutif et efficace. Malgré sa taille réduite, ses performances sont comparables à celles de modèles beaucoup plus grands tels que Mistral-7B et LLaMA 7B. Il est particulièrement optimisé pour le traitement du langage en anglais et en chinois, ce qui en fait une alternative très performante et légère pour les environnements où les ressources informatiques sont limitées. Si vous travaillez dans un environnement aux ressources limitées mais que vous avez néanmoins besoin d'un traitement linguistique fiable, MiniCPM constitue une excellente solution.

- Paramètres : 1B – 4B

- Access: https://github.com/miniCPM

- Open source : Oui

13. OpenELM

OpenELM est un modèle flexible et adaptable avec une plage de paramètres allant de 270 millions à 3 milliards. Il est conçu pour les environnements qui nécessitent une capacité multitâche et des réponses à faible latence. Ceci est idéal pour les tâches qui nécessitent des performances en temps réel sur des appareils plus petits.

Développé par Apple, OpenELM met l'accent sur l'efficacité énergétique et les applications d'IA intégrées aux appareils. Il rivalise efficacement avec des modèles tels que MobiLlama et OLMo, et affiche des améliorations significatives lorsqu'il est optimisé pour des tâches spécifiques. Avec sa large gamme de tailles de paramètres, OpenELM est optimisé pour les environnements plus petits et plus contraints, contrairement aux modèles plus lourds tels que GPT-4 ou LLaMA, qui nécessitent davantage de ressources pour offrir des performances comparables. Si vous recherchez une solution légère mais performante, en particulier pour une utilisation mobile ou périphérique, OpenELM est la solution idéale.

- Paramètres : 270 MILLIONS – 3 MILLIARDS

- Accès : https://github.com/OpenELM

- Open source : Oui

14. DCLM

Analysons DCLM, un modèle doté d'un milliard de paramètres spécialement conçu pour le raisonnement fondé sur le bon sens. Il est particulièrement performant dans les tâches concrètes où la compréhension et la déduction logique sont essentielles.

DCLM est particulièrement efficace pour la compréhension du langage et le raisonnement, notamment dans sa version à 7 milliards de paramètres. Il rivalise avec des modèles tels que LLaMA 2 (7B) et Mistral 7B, affichant des performances équivalentes dans des tâches telles que le raisonnement de bon sens et la déduction logique. Il n'est certes pas aussi puissant que des modèles plus volumineux tels que LLaMA 13B, mais DCLM est hautement optimisé pour les applications concrètes qui exigent efficacité et ressources informatiques réduites. Par conséquent, lorsque vous avez besoin de performances élevées sans infrastructure lourde, DCLM constitue un excellent choix.

- Paramètres : 1B

- Accès : https://github.com/DCLM

- Open source : Oui

15. Fox

Enfin, le modèle Fox, un modèle de 1,6 milliard de paramètres, a été spécialement conçu pour offrir rapidité et efficacité. Il est optimisé pour les applications mobiles, où il est essentiel de maintenir une faible latence. Fox est conçu pour fournir des réponses rapides sans utiliser trop de puissance de calcul.

Fox est particulièrement performant dans les environnements où la rapidité est essentielle. Il traite très rapidement les tâches à faible latence, ce qui est idéal pour les appareils mobiles ou périphériques. Il n'est pas aussi performant pour les raisonnements complexes, mais Fox est idéal pour les situations où vous avez besoin de réponses rapides et efficaces de l'IA et où vous ne pouvez pas vous permettre d'utiliser des ressources importantes. C'est le modèle idéal lorsque la puissance de calcul est limitée mais que la vitesse est une priorité.

- Paramètres : 1,6 MILLIARD

- Accès : https://github.com/foxmodel

- Open source : Oui

Comparaison des modèles linguistiques de petite taille

Résumons ce que nous avons abordé dans ce tableau :

|

Nom du modèle |

Paramètres |

Open Source |

Caractéristiques principales |

|

Qwen2 |

0,5 MILLIARD, 1 MILLIARD, 7 MILLIARDS |

Oui |

Évolutif, adapté à diverses tâches |

|

Mistral Nemo 12B |

12B |

Oui |

Tâches complexes de traitement du langage naturel, déploiement local |

|

Llama 3.1 8B |

8B |

Oui |

Puissance et efficacité équilibrées |

|

Pythie |

160 MILLIONS - 2,8 MILLIARDS |

Oui |

Axé sur le raisonnement et le codage |

|

Cerebras-GPT |

111 MILLIONS - 2,7 MILLIARDS |

Oui |

Efficacité de calcul, conforme aux lois d'évolutivité de Chinchilla |

|

Phi-3,5 |

3,8 MILLIARDS |

Oui |

Longueur de contexte importante (128 000 tokens), multilingue |

|

StableLM-zephyr |

3B |

Oui |

Inférence rapide, efficace pour les systèmes périphériques |

|

TinyLlama |

1,1 MILLIARD |

Oui |

Efficace pour les appareils mobiles et périphériques |

|

MobileLLaMA |

1,4 MILLIARD |

Oui |

Optimisé pour les appareils mobiles et à faible consommation d'énergie |

|

LaMini-GPT |

774 MILLIONS - 1,5 MILLIARD |

Oui |

Tâches multilingues nécessitant le respect d'instructions |

|

Gemma2 |

9B, 27B |

Oui |

Déploiement local, applications en temps réel |

|

MiniCPM |

1B - 4B |

Oui |

Performances équilibrées, optimisées pour l'anglais et le chinois |

|

OpenELM |

270M - 3B |

Oui |

Multitâche, faible latence, économe en énergie |

|

DCLM |

1B |

Oui |

Raisonnement fondé sur le bon sens, déduction logique |

|

Fox |

1,6 MILLIARD |

Oui |

Optimisé pour la vitesse des applications mobiles |

*Avec restrictions d'utilisation

À des fins de recherche uniquement

Conclusion

Ceci conclut cet article, qui vous a proposé un bref aperçu du monde des petits modèles linguistiques en 2026. Nous avons constaté que ces modèles démontrent que plus petit ne signifie pas nécessairement moins performant, mais plutôt plus intelligent à bien des égards.

Attendez-vous à voir ces SLM intégrés dans davantage de vos expériences technologiques quotidiennes. N'oubliez pas qu'il s'agit de choisir les modèles adaptés à la tâche à accomplir et, dans de nombreux cas, le modèle approprié peut être petit et agile.

Pour en savoir plus sur les modèles linguistiques de petite taille, je recommande ces deux ressources :

Ana Rojo Echeburúa est une spécialiste de l'IA et des données, titulaire d'un doctorat en mathématiques appliquées. Elle aime transformer les données en informations exploitables et possède une grande expérience de la direction d'équipes techniques. Ana aime travailler en étroite collaboration avec ses clients pour résoudre leurs problèmes commerciaux et créer des solutions d'IA innovantes. Connue pour ses compétences en matière de résolution de problèmes et de communication claire, elle est passionnée par l'IA, en particulier l'IA générative. Ana se consacre à l'apprentissage continu et au développement éthique de l'IA, ainsi qu'à la simplification des problèmes complexes et à l'explication de la technologie de manière accessible.