Programa

Os modelos de linguagem pequenos (SLMs) são compactos, eficientes e não precisam de servidores enormes — ao contrário dos seus equivalentes, os grandes modelos de linguagem (LLMs). Elas são feitas pra serem rápidas e funcionarem em tempo real, e podem rodar nos nossos smartphones, tablets ou smartwatches.

Neste artigo, vamos dar uma olhada os 15 principais SLMs de 2026 e vamos ver seus pontos fortes, pontos fracos e o que torna cada modelo único.

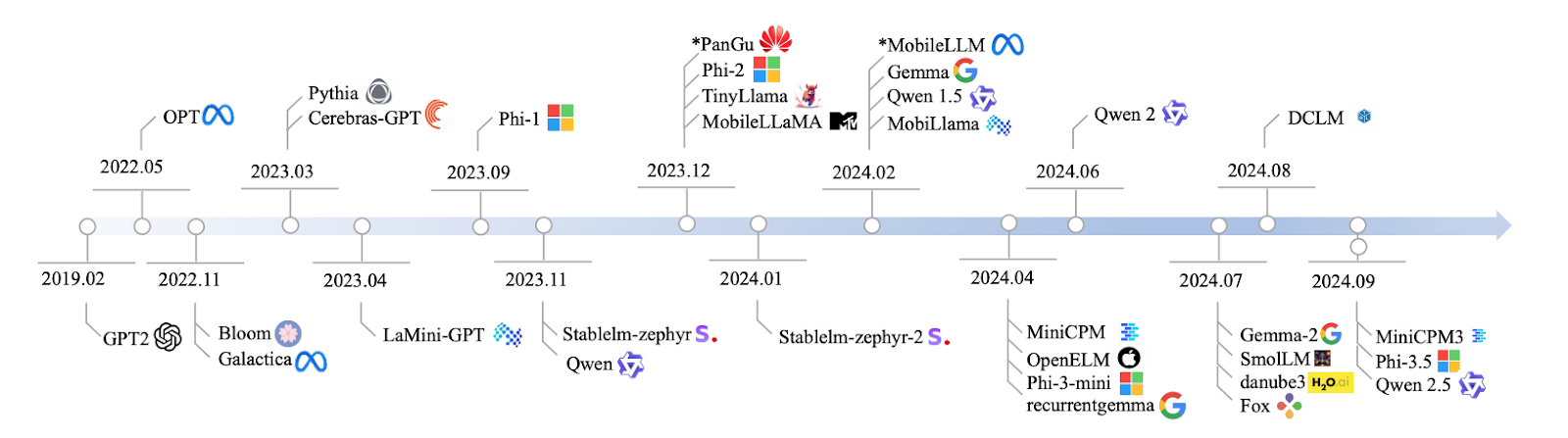

Fonte: Lu et al., 2024

Vou direto ao ponto e falar sobre os modelos, mas se você precisar de uma introdução sobre modelos de linguagem pequenos, escrevi um artigo separado aqui: Modelos de linguagem pequenos: Um guia com exemplos.

1. Qwen2: 0,5B, 1B e 7B

Qwen2 é uma família de modelos, com tamanhos que vão de 0,5 bilhão a 7 bilhões de parâmetros. Se você está trabalhando em um aplicativo que precisa de um modelo super leve, a versão 0.5B é perfeita.

Mas, se você precisar de algo mais robusto para tarefas como resumo ou geração de texto, o modelo 7B é onde você vai conseguir o melhor desempenho. É escalável e pode ser adaptado às suas necessidades específicas.

Os modelos Qwen2 podem não ter as mesmas capacidades gerais dos grandes modelos de IA em termos de raciocínio complexo, mas são ótimos para muitas aplicações práticas em que a velocidade e a eficiência são mais importantes. São especialmente úteis para aplicativos que precisam de respostas rápidas ou têm recursos limitados.

- Parâmetros: Versões de 0,5 bilhão, 1 bilhão e 7 bilhões

- Access: https://huggingface.co/Qwen

- Código aberto: Sim, com uma licença de código aberto.

2. Mistral Nemo 12B

Com 12 bilhões de parâmetros, o modelo Mistral Nemo 12B é ótimo para tarefas complexas de PLN, como tradução de idiomas e sistemas de diálogo em tempo real. Ele compete com modelos como Falcon 40B e Chinchilla 70B, mas ainda pode funcionar localmente sem precisar de uma infraestrutura enorme. É um daqueles modelos que equilibra complexidade com praticidade.

- Parâmetros: 12 bilhões

- Access: https://huggingface.co/mistralai/Mistral-7B-Instruct-v0.2

- Código aberto: Sim, com uma licença Apache 2.0.

Desenvolver aplicativos de IA

3. Llama 3.1 8B

Passando para o Llama 3.1 8B, esse modelo tem 8 bilhões de parâmetros e oferece um equilíbrio incrível entre potência e eficiência. É ótimo para tarefas como responder perguntas e fazer análise de sentimentos.

O Llama 3.1 8B oferece um desempenho razoavelmente bom se você precisa de resultados rápidos sem precisar de muita potência de computação. É ideal pra quem quer velocidade sem perder a precisão.

Para ter uma experiência prática com esse modelo, dá uma olhada nesse tutorial sobre RAG com Llama 3.1 8B, Ollama e Langchain.

- Parâmetros: 8 bilhões

- Acesso: https://ollama.com/library/llama3

- Código aberto: Sim, mas com algumas restrições de uso.

4. Pítia

Vamos falar sobre a série Pythia, um conjunto de modelos que variam de 160 milhões a 2,8 bilhões de parâmetros, projetados para tarefas de raciocínio e habilidades de codificação. Se você curte desenvolvimento de software, o Pythia é ótimo pra lidar com tarefas estruturadas e baseadas em lógica, onde precisão e lógica são fundamentais. É perfeito pra ambientes de programação onde você precisa que o modelo pense de um jeito estruturado e lógico.

Agora, comparado com outros modelos como o GPT-Neo, o Pythia tem um desempenho melhor em tarefas como codificação e raciocínio, já que foi feito para essas aplicações específicas. Mas, quando você coloca isso em tarefas de linguagem mais gerais, as coisas podem ficar meio instáveis — o Phi 3.5 e o Llama 3.1 8B podem funcionar de forma mais consistente nessas áreas mais amplas. Uma coisa a se notar é que a transparência do treinamento público da Pythia e as opções de personalização são bem impressionantes. Você pode ajustá-lo para atender às suas necessidades específicas, o que o torna uma ferramenta incrivelmente flexível.

- Parâmetros: 160 MILHÕES – 2,8 BILHÕES

- Acesso: https://github.com/EleutherAI/pythia

- Código aberto: Sim

5. Cerebras-GPT

O Cerebras-GPT é um modelo eficiente e rápido. Com parâmetros que vão de 111 milhões a 2,7 bilhões, ele foi feito pra ambientes onde os recursos computacionais são limitados, mas você ainda precisa de um ótimo desempenho. O Cerebras-GPT traz ótimos resultados sem consumir todos os seus recursos.

Agora, comparado com modelos maiores como o GPT-3 ou o LLaMA 13B, o Cerebras-GPT pode não ter o mesmo treinamento extensivo, mas segue as leis de escalabilidade do Chinchilla, o que significa que é incrivelmente eficiente em termos de computação. Modelos como GPT-J e GPT-NeoX podem ser mais volumosos, mas o Cerebras-GPT maximiza o desempenho enquanto mantém o uso de recursos baixo. Se você precisa de escalabilidade e eficiência, esse modelo é otimizado para oferecer o melhor dos dois mundos.

- Parâmetros: 111 MILHÕES – 2,7 BILHÕES

- Acesso: https://github.com/Cerebras

- Código aberto: Sim

6. Phi-3,5

Esse modelo tem 3,8 bilhões de parâmetros, mas o que o torna único é o seguinte: 128K tokens de comprimento de contexto. O que isso quer dizer? Ele consegue lidar com documentos longos ou tarefas que envolvem conversas com várias voltas sem perder o contexto. Ele também é multilíngue, o que o torna um forte concorrente de modelos como Llama 13B e GPT-3.5, mas com requisitos computacionais muito menores. Esse modelo é ótimo para resumir documentos, tarefas multilíngues e raciocínio lógico.

- Parâmetros: 3,8 bilhões

- Acesso: https://huggingface.co/microsoft/phi-2

- Código aberto: Sim, só pra fins de pesquisa.

7. StableLM-zephyr

O StableLM-Zephyr é um modelo de linguagem pequeno com 3 bilhões de parâmetros que é ótimo quando você quer precisão e velocidade. Esse modelo oferece uma inferência rápida e tem um desempenho incrível em ambientes onde é essencial tomar decisões rápidas, como sistemas de ponta ou dispositivos com poucos recursos. Se você precisa de algo preciso e rápido, o StableLM-Zephyr é uma ótima opção.

O StableLM-Zephyr é ótimo em tarefas que envolvem raciocínio e até mesmo interpretação de papéis. Embora seja mais leve e rápido, ele pode não dar conta de tarefas mais complexas, como escrever ou programar, tão bem quanto os modelos maiores, mas, pelo tamanho, ele tem um ótimo desempenho. Se velocidade e eficiência são suas prioridades, o StableLM-Zephyr é uma escolha sólida.

- Parâmetros: 3B

- Acesso: https://github.com/StabilityAI/stablelm

- Código aberto: Sim

8. TinyLlama

Vamos falar sobre o TinyLlama, um modelo compacto com 1,1 bilhão de parâmetros que tem um desempenho muito bom para o seu tamanho. Ele foi feito pra ser eficiente e é perfeito pra aparelhos que não aguentam a carga pesada de computação de modelos maiores.

Para tarefas do mundo real, o TinyLlama realmente se sai melhor do que modelos como o Pythia-1.4B, especialmente no que diz respeito ao raciocínio baseado no senso comum. Não tem a potência bruta de modelos como o LLaMA 13B, mas tem um ótimo equilíbrio entre desempenho e eficiência de recursos. Isso torna-o ideal para cenários em que você precisa de recursos avançados de IA sem sobrecarregar o sistema, especialmente em dispositivos móveis e de ponta.

- Parâmetros: 1.1B

- Acesso: https://github.com/tinyLlama

- Código aberto: Sim

9. MobileLLaMA

O MobileLLaMA é uma versão especializada do LLaMA, feita pra funcionar super bem em dispositivos móveis e de baixo consumo de energia. Com 1,4 bilhão de parâmetros, ele foi feito pra te dar um equilíbrio entre desempenho e eficiência, principalmente em aparelhos com recursos limitados.

O MobileLLaMA é otimizado para aplicações de IA rápidas e de baixa latência em movimento. Com versões como MobileLLaMA-1.4B e MobileLLaMA-2.7B, ele facilmente supera modelos menores como TinyLLaMA 1.1B e compete de perto com OpenLLaMA 3B - tudo isso sendo cerca de 40% mais rápido. Se você precisa de IA em tempo real direto no seu aparelho, o MobileLLaMA é perfeito. Esse modelo foi feito pra levar IA de alto desempenho direto pro seu celular ou sistemas de ponta sem a necessidade de uma infraestrutura pesada.

- Parâmetros: 1,4 BILHÃO

- Acesso: https://github.com/mobileLLaMA

- Código aberto: Sim

10. LaMini-GPT

O LaMini-GPT é um modelo compacto, mas poderoso, com 774 milhões a 1,5 bilhão de parâmetros, feito especialmente para tarefas multilíngues. É especialmente bom em ambientes com recursos limitados, ou seja, consegue lidar com vários idiomas sem precisar de muita potência computacional, o que é ótimo para dispositivos ou sistemas com recursos limitados.

Uma coisa interessante sobre o LaMini-GPT é que ele foi desenvolvido através da destilação de conhecimento de modelos maiores da família GPT, o que permite que ele tenha um ótimo desempenho em tarefas que envolvem seguir instruções. Com mais de 2,58 milhões de pares de instruções e respostas no seu conjunto de dados, ele é otimizado para lidar com tarefas e instruções específicas de forma mais eficiente do que modelos maiores. Mas, mesmo sendo super eficiente e leve, principalmente pra tarefas específicas, não é tão bom pra aplicações mais amplas que precisam de um entendimento contextual profundo ou geração de texto mais geral. Se você está procurando algo rápido e eficiente, principalmente em cenários multilíngues, o LaMini-GPT é uma escolha sólida.

- Parâmetros: 774 MILHÕES – 1,5 BILHÃO

- Acesso: https://github.com/LaMiniGPT

- Código aberto: Sim

11. Gemma2

Vamos falar agora sobre a Gemma2. Esse modelo tem 2 bilhões de parâmetros e funciona muito bem se você estiver pensando em uma implantação local. É leve e eficiente — ideal para coisas como geração de texto ou tradução.

Quando você compara com pesos pesados como OpenAI o1-preview, o Gemma2 foca em aplicações em tempo real, não em raciocínios complexos. Para computação de ponta, é a alternativa perfeita para modelos como GPT-3.5 ou Llama 65B, que consomem muitos recursos.

Se você quiser experimentar este SLM, leia este tutorial sobre como ajustar o Gemma 2 e usá-lo localmente.

- Parâmetros: 9 bilhões e 27 bilhões de versões

- Access: https://ai.google.dev/gemma

- Código aberto: Sim, com uma licença permissiva que permite redistribuição, ajustes e uso comercial.

12. MiniCPM

O MiniCPM é um modelo com um equilíbrio sólido entre desempenho e eficiência de recursos, com tamanhos de parâmetros que variam de 1 bilhão a 4 bilhões. Ele foi feito pra lidar com tarefas gerais de linguagem com facilidade e oferece um desempenho confiável em várias aplicações, o que o torna uma ótima opção versátil.

O MiniCPM é escalável e eficiente. Apesar de ser menor, ele funciona tão bem quanto modelos maiores, tipo o Mistral-7B e o LLaMA 7B. Ele é especialmente otimizado para processamento de linguagem em inglês e chinês, o que o torna uma alternativa leve e altamente capaz para ambientes onde os recursos computacionais são limitados. Se você está trabalhando em um ambiente com recursos limitados, mas ainda precisa de um processamento de linguagem sólido, o MiniCPM oferece uma excelente solução.

- Parâmetros: 1B – 4B

- Acesso: https://github.com/miniCPM

- Código aberto: Sim

13. OpenELM

O OpenELM é um modelo flexível e adaptável, com uma gama de parâmetros que vai de 270 milhões a 3 bilhões. Ele foi feito pra ambientes que precisam de multitarefa e respostas rápidas. Isso é perfeito pra tarefas que precisam de desempenho em tempo real em aparelhos menores.

Desenvolvido pela Apple, o OpenELM foca na eficiência energética e em aplicativos de IA no dispositivo. Ele compete bem com modelos como MobiLlama e OLMo, mostrando melhorias significativas quando ajustado para tarefas específicas. Com sua ampla gama de tamanhos de parâmetros, o OpenELM é otimizado para ambientes menores e mais restritos, ao contrário de modelos mais pesados como o GPT-4 ou o LLaMA, que precisam de mais recursos para oferecer um desempenho comparável. Se você está procurando algo leve, mas eficiente, especialmente para uso móvel ou de ponta, o OpenELM é uma ótima opção.

- Parâmetros: 270M – 3B

- Acesso: https://github.com/OpenELM

- Código aberto: Sim

14. DCLM

Vamos analisar o DCLM, um modelo com 1 bilhão de parâmetros projetado especificamente para o raciocínio baseado no senso comum. Ele tem um bom desempenho em tarefas do mundo real, onde entender e fazer deduções lógicas são essenciais.

O DCLM é ótimo pra entender idiomas e raciocinar, principalmente com a versão de 7 bilhões de parâmetros. Ele compete com modelos como LLaMA 2 (7B) e Mistral 7B, com desempenho igualmente bom em tarefas como raciocínio comum e dedução lógica. Ele definitivamente não é tão poderoso quanto modelos maiores, como o LLaMA 13B, mas o DCLM é altamente otimizado para aplicações do mundo real que exigem eficiência e menos recursos computacionais. Portanto, quando você tem ambientes que exigem um desempenho forte sem uma infraestrutura pesada, o DCLM é uma ótima escolha.

- Parâmetros: 1B

- Acesso: https://github.com/DCLM

- Código aberto: Sim

15. Raposa

E por último, o modelo Fox, um modelo com 1,6 bilhão de parâmetros projetado especificamente para velocidade e eficiência. É otimizado para aplicativos móveis, onde manter a latência baixa é super importante. O Fox foi feito pra dar respostas rápidas sem gastar muita energia de computação.

A Fox funciona super bem em ambientes onde você precisa de velocidade. Ele lida com tarefas de baixa latência muito rapidamente, o que é ótimo para dispositivos móveis ou de ponta. Ele não tem um desempenho tão bom em raciocínios complexos, mas o Fox é perfeito pra situações em que você precisa de respostas rápidas e eficientes de IA e não pode usar muitos recursos. É o modelo ideal quando o poder computacional é limitado, mas a velocidade é prioridade.

- Parâmetros: 1,6 BILHÃO

- Acesso: https://github.com/foxmodel

- Código aberto: Sim

Comparação de pequenos modelos de linguagem

Vamos resumir o que vimos nesta tabela:

|

Nome do modelo |

Parâmetros |

Código aberto |

Principais recursos |

|

Qwen2 |

0,5B, 1B, 7B |

Sim |

Escalável, ideal para várias tarefas |

|

Mistral Nemo 12B |

12B |

Sim |

Tarefas complexas de NLP, implantação local |

|

Llama 3.1 8B |

8B |

Sim* |

Potência e eficiência equilibradas |

|

Pítia |

160 MILHÕES - 2,8 BILHÕES |

Sim |

Focado em raciocínio e programação |

|

Cerebras-GPT |

111 MILHÕES - 2,7 BILHÕES |

Sim |

Eficiente em termos de computação, segue as leis de escalabilidade Chinchilla |

|

Phi-3,5 |

3,8 BILHÕES |

Sim** |

Contexto longo (128 mil tokens), multilíngue |

|

StableLM-zephyr |

3B |

Sim |

Inferência rápida, eficiente para sistemas de ponta |

|

TinyLlama |

1,1 BILHÃO |

Sim |

Ótimo para dispositivos móveis e periféricos |

|

MobileLLaMA |

1,4 BILHÃO |

Sim |

Otimizado para dispositivos móveis e de baixo consumo de energia |

|

LaMini-GPT |

774 MILHÕES - 1,5 BILHÃO |

Sim |

Tarefas multilíngues que seguem instruções |

|

Gemma2 |

9B, 27B |

Sim |

Implantação local, aplicativos em tempo real |

|

MiniCPM |

1B - 4B |

Sim |

Desempenho equilibrado, otimizado para inglês e chinês |

|

OpenELM |

270M - 3B |

Sim |

Multitarefa, baixa latência, eficiência energética |

|

DCLM |

1B |

Sim |

Raciocínio lógico, dedução lógica |

|

Raposa |

1,6 BILHÃO |

Sim |

Otimizado para aplicações móveis |

*Com restrições de uso

Só pra fins de pesquisa

Conclusão

E é isso aí pra esse artigo, um tour rapidinho pelo mundo dos pequenos modelos de linguagem em 2026. Vimos como esses modelos mostram que menor não quer dizer mais fraco — quer dizer mais inteligente em vários aspectos.

Espere ver esses SLMs cada vez mais presentes nas suas experiências tecnológicas do dia a dia. Lembre-se, o importante é escolher os modelos certos para o trabalho — e, em muitos casos, o modelo certo pode ser pequeno e ágil.

Pra saber mais sobre modelos de linguagem pequenos, recomendo esses dois recursos:

Ana Rojo Echeburúa é especialista em IA e dados, com doutorado em Matemática Aplicada. Ela adora transformar dados em insights acionáveis e tem ampla experiência na liderança de equipes técnicas. Ana gosta de trabalhar em estreita colaboração com os clientes para resolver seus problemas de negócios e criar soluções inovadoras de IA. Conhecida por suas habilidades de resolução de problemas e comunicação clara, ela é apaixonada por IA, especialmente IA generativa. Ana se dedica ao aprendizado contínuo e ao desenvolvimento ético de IA, além de simplificar problemas complexos e explicar a tecnologia de forma acessível.