Lernpfad

Kleine Sprachmodelle (SLMs) sind kompakt, effizient und brauchen keine riesigen Server – anders als ihre großen Sprachmodelle (LLMs). Sie sind auf Geschwindigkeit und Echtzeitleistung ausgelegt und laufen auf unseren Smartphones, Tablets oder Smartwatches.

In diesem Artikel schauen wir uns die 15 besten SLMs des Jahres 2026 und schauen uns ihre Stärken, Schwächen und Besonderheiten an.

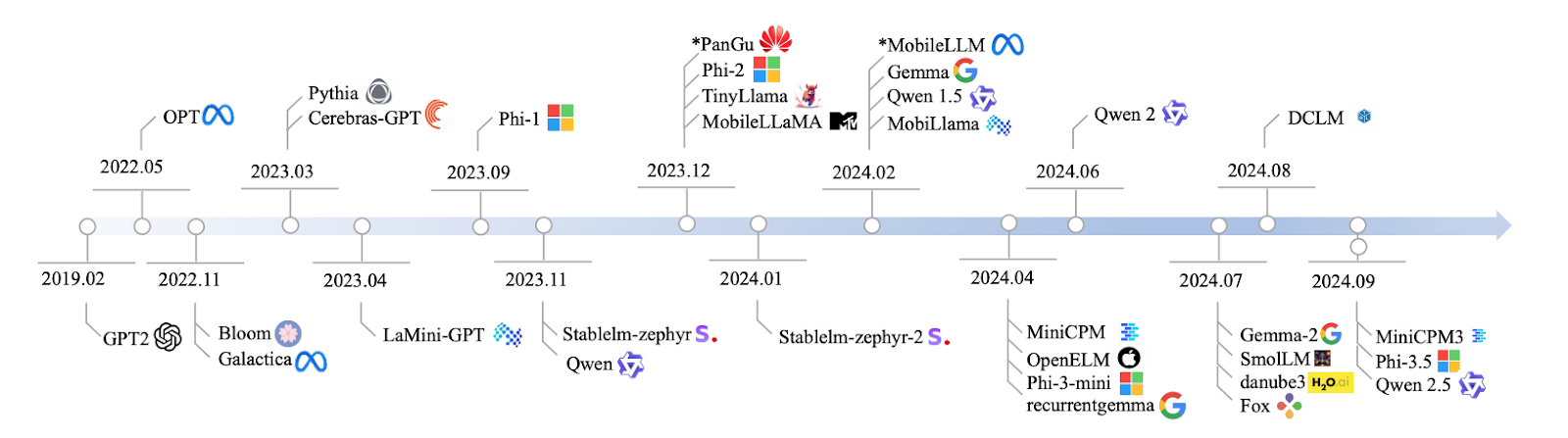

Quelle: Lu et al., 2024

Ich fange gleich mit der Besprechung der Modelle an, aber wenn du eine Einführung in kleine Sprachmodelle brauchst, habe ich hier einen separaten Artikel geschrieben: Kleine Sprachmodelle: Ein Leitfaden mit Beispielen.

1. Qwen2: 0,5B, 1B und 7B

Qwen2 ist eine Familie von Modellen mit Größen von 0,5 Milliarden bis 7 Milliarden Parametern. Wenn du an einer App arbeitest, die ein superleichtes Modell braucht, ist die 0.5B-Version genau das Richtige.

Wenn du aber was Robusteres für Aufgaben wie Zusammenfassungen oder Textgenerierung brauchst, ist das 7B-Modell das, was dir die beste Leistung bringt. Es ist flexibel und kann genau auf deine Bedürfnisse zugeschnitten werden.

Qwen2-Modelle können vielleicht nicht mit den umfassenden Fähigkeiten großer KI-Modelle beim komplexen Denken mithalten, aber sie sind super für viele praktische Anwendungen, bei denen es vor allem auf Geschwindigkeit und Effizienz ankommt. Sie sind besonders nützlich für Apps, die schnelle Reaktionen oder begrenzte Ressourcen brauchen.

- Parameter: 0,5 Milliarden, 1 Milliarde und 7 Milliarden Versionen

- Zugang: https://huggingface.co/Qwen

- Open Source: Ja, mit einer Open-Source-Lizenz

2. Mistral Nemo 12B

Mit 12 Milliarden Parametern eignet sich das Modell Mistral Nemo 12B super für komplizierte NLP-Aufgaben wie Sprachübersetzung und Echtzeit-Dialogsysteme. Es konkurriert mit Modellen wie Falcon 40B und Chinchilla 70B, kann aber trotzdem lokal ohne riesige Infrastruktur laufen. Es ist eines dieser Modelle, die Komplexität und Praktikabilität gut zusammenbringen.

- Parameter: 12 Milliarden

- Zugang: https://huggingface.co/mistralai/Mistral-7B-Instruct-v0.2

- Open Source: Ja, mit einer Apache-2.0-Lizenz.

KI-Anwendungen entwickeln

3. Llama 3.1 8B

Weiter geht's mit Llama 3.1 8B. Dieses Modell hat 8 Milliarden Parameter und schafft einen super Spagat zwischen Leistung und Effizienz. Es eignet sich super für Sachen wie das Beantworten von Fragen und die Analyse von Stimmungen.

Llama 3.1 8B ist echt gut, wenn du schnelle Ergebnisse willst, ohne dass du dafür eine riesige Rechenleistung brauchst. Es ist super für alle, die schnell sein wollen, ohne dabei an Genauigkeit einzubüßen.

Um praktische Erfahrungen mit diesem Modell zu sammeln, lies dieses Tutorial zu RAG mit Llama 3.1 8B, Ollama und Langchain.

- Parameter: acht Milliarden

- Zugang: https://ollama.com/library/llama3

- Open Source: Ja, aber mit Einschränkungen bei der Nutzung

4. Pythia

Reden wir mal über die Pythia-Serie, eine Reihe von Modellen mit 160 Millionen bis 2,8 Milliarden Parametern, die für Aufgaben im Bereich des logischen Denkens und der Codierung entwickelt wurden. Wenn du dich für Softwareentwicklung interessierst, ist Pythia super für strukturierte, logikbasierte Aufgaben, bei denen es auf Genauigkeit und Logik ankommt. Es ist super für Programmierumgebungen, wo das Modell strukturiert und logisch denken muss.

Im Vergleich zu anderen Modellen wie GPT-Neo macht Pythia bei Aufgaben wie Programmieren und Schlussfolgern einen besseren Job, weil es genau für diese Sachen entwickelt wurde. Wenn du es aber auf allgemeinere Sprachaufgaben anwendest, kann es ein bisschen wackelig werden – Phi 3.5 und Llama 3.1 8B könnten in diesen breiteren Bereichen konsistenter sein. Man sollte wissen, dass die Transparenz und die Anpassungsmöglichkeiten bei den öffentlichen Schulungen von Pythia echt beeindruckend sind. Du kannst es an deine speziellen Bedürfnisse anpassen, was es zu einem super flexiblen Tool macht.

- Parameter: 160 MIO. – 2,8 MRD.

- Access: https://github.com/EleutherAI/pythia

- Open Source: Ja

5. Cerebras-GPT

Cerebras-GPT ist ein Modell, das effizient und schnell ist. Mit Parametern von 111 Millionen bis 2,7 Milliarden ist es für Umgebungen gedacht, in denen die Rechenressourcen begrenzt sind, du aber trotzdem eine hohe Leistung brauchst. Cerebras-GPT liefert super Ergebnisse, ohne alle deine Ressourcen zu verbrauchen.

Im Vergleich zu größeren Modellen wie GPT-3 oder LLaMA 13B hat Cerebras-GPT vielleicht nicht das gleiche umfangreiche Training durchlaufen, aber es folgt den Skalierungsgesetzen von Chinchilla, was bedeutet, dass es unglaublich rechenintensiv ist. Modelle wie GPT-J und GPT-NeoX sind vielleicht sperriger, aber Cerebras-GPT holt das Maximum aus der Leistung raus und verbraucht dabei nur wenig Ressourcen. Wenn du Skalierbarkeit und Effizienz brauchst, ist dieses Modell genau das Richtige für dich, weil es beides super kombiniert.

- Parameter: 111 MIO. – 2,7 MRD.

- Access: https://github.com/Cerebras

- Open Source: Ja

6. Phi-3,5

Dieses Modell hat 3,8 Milliarden Parameter, aber hier ist, was es so besonders macht: 128K Token mit Kontextlänge. Was heißt das denn? Es kann lange Dokumente oder Aufgaben mit mehreren Gesprächsrunden abarbeiten, ohne den Zusammenhang zu verlieren. Es ist auch mehrsprachig, was es zu einem starken Konkurrenten gegenüber Modellen wie Llama 13B und GPT-3.5 macht, aber mit viel geringeren Rechenanforderungen. Dieses Modell eignet sich super für die Zusammenfassung von Dokumenten, mehrsprachige Aufgaben und logisches Denken.

- Parameter: 3,8 Milliarden

- Zugang: https://huggingface.co/microsoft/phi-2

- Open Source: Ja, aber nur für Forschungszwecke.

7. StableLM-zephyr

StableLM-Zephyr ist ein kleines Sprachmodell mit 3 Milliarden Parametern, das super ist, wenn du Genauigkeit und Geschwindigkeit willst. Dieses Modell macht schnelle Schlussfolgerungen und läuft echt gut in Umgebungen, wo schnelle Entscheidungen wichtig sind, wie zum Beispiel bei Edge-Systemen oder Geräten mit wenig Ressourcen. Wenn du was Scharfes und Schnelles brauchst, ist StableLM-Zephyr eine super Wahl.

StableLM-Zephyr ist super bei Aufgaben, die logisches Denken und sogar Rollenspiele erfordern. Es ist zwar leichter und schneller, kann aber komplexere Aufgaben wie Schreiben oder Programmieren vielleicht nicht so gut wie die größeren Modelle. Für seine Größe ist es aber echt leistungsstark. Wenn dir Geschwindigkeit und Effizienz wichtig sind, ist StableLM-Zephyr eine gute Wahl.

- Parameter: 3B

- Access: https://github.com/StabilityAI/stablelm

- Open Source: Ja

8. TinyLlama

Reden wir mal über TinyLlama, ein kompaktes Modell mit 1,1 Milliarden Parametern, das für seine Größe echt gut läuft. Es ist auf Effizienz ausgelegt und passt super zu Geräten, die die hohe Rechenlast größerer Modelle nicht schaffen.

Bei echten Aufgaben macht TinyLlama es tatsächlich besser als Modelle wie Pythia-1.4B, vor allem beim gesunden Menschenverstand. Es hat zwar nicht die rohe Kraft von Modellen wie LLaMA 13B, bietet aber eine super Balance zwischen Leistung und Ressourceneffizienz. Das macht es super für Situationen, in denen du starke KI-Fähigkeiten brauchst, ohne das System zu überlasten, vor allem auf Mobil- und Edge-Geräten.

- Parameter: 1,1 MRD.

- Access: https://github.com/tinyLlama

- Open Source: Ja

9. MobileLLaMA

MobileLLaMA ist eine spezielle Version von LLaMA, die für super Leistung auf Handys und Geräten mit geringem Stromverbrauch entwickelt wurde. Mit 1,4 Milliarden Parametern ist es so gemacht, dass du ein gutes Gleichgewicht zwischen Leistung und Effizienz bekommst, vor allem auf Geräten mit begrenzten Ressourcen.

MobileLLaMA ist für schnelle und reaktionsschnelle KI-Anwendungen unterwegs gemacht. Mit Versionen wie MobileLLaMA-1.4B und MobileLLaMA-2.7B ist es viel schneller als kleinere Modelle wie TinyLLaMA 1.1B und kann locker mit OpenLLaMA 3B mithalten – und das bei einer Geschwindigkeitssteigerung von etwa 40 %. Wenn du Echtzeit-KI direkt auf deinem Gerät brauchst, ist MobileLLaMA genau das Richtige für dich. Dieses Modell wurde entwickelt, um leistungsstarke KI direkt auf dein Handy oder deine Edge-Systeme zu bringen. Edge-Systeme zu bringen, ohne dass du eine aufwendige Infrastruktur brauchst.

- Parameter: 1,4 MRD.

- Access: https://github.com/mobileLLaMA

- Open Source: Ja

10. LaMini-GPT

LaMini-GPT ist ein kompaktes, aber leistungsstarkes Modell mit 774 Millionen bis 1,5 Milliarden Parametern, das speziell für mehrsprachige Aufgaben entwickelt wurde. Es ist besonders gut in Umgebungen mit begrenzten Ressourcen, was bedeutet, dass es mehrere Sprachen verarbeiten kann, ohne viel Rechenleistung zu brauchen, was super für Geräte oder Systeme mit begrenzten Ressourcen ist.

Das Coole an LaMini-GPT ist, dass es durch Wissensdestillation aus größeren Modellen der GPT-Familie entwickelt wurde, wodurch es bei Aufgaben, bei denen es Anweisungen befolgen muss, echt gut abschneidet. Mit über 2,58 Millionen Befehl-Antwort-Paaren in seinem Datensatz ist es so gemacht, dass es bestimmte Aufgaben und Befehle effizienter erledigen kann als größere Modelle. Obwohl es super effizient und leicht ist, vor allem für bestimmte Aufgaben, ist es nicht so toll für breitere Anwendungen, die ein tiefes Verständnis des Kontexts oder eine allgemeinere Textgenerierung brauchen. Wenn du nach einer schnellen und effizienten Lösung suchst, vor allem in mehrsprachigen Szenarien, ist LaMini-GPT eine gute Wahl.

- Parameter: 774 MILLIONEN – 1,5 MILLIARDEN

- Access: https://github.com/LaMiniGPT

- Open Source: Ja

11. Gemma2

Reden wir jetzt mal über Gemma2. Dieses Modell hat 2 Milliarden Parameter und ist super, wenn du über eine lokale Bereitstellung nachdenkst. Es ist leicht und effizient – perfekt für Sachen wie Textgenerierung oder Übersetzung.

Wenn man es mit Schwergewichten wie OpenAI o1-previewkonzentriert sich Gemma2 auf Echtzeitanwendungen und nicht auf komplexes Denken. Für Edge-Computing ist es die perfekte Alternative zu Modellen wie GPT-3.5 oder Llama 65B, die echt viele Ressourcen brauchen.

Wenn du dich mit diesem SLM vertraut machen willst, schau dir dieses Tutorial zur Feinabstimmung von Gemma 2 und die lokale Verwendung.

- Parameter: 9 Milliarden und 27 Milliarden Versionen

- Access: https://ai.google.dev/gemma

- Open Source: Ja, mit einer liberalen Lizenz, die Weiterverbreitung, Anpassung und kommerzielle Nutzung erlaubt.

12. MiniCPM

MiniCPM ist ein Modell, das Leistung und Ressourceneffizienz gut ausbalanciert, mit Parametergrößen von 1 Milliarde bis 4 Milliarden. Es ist so gemacht, dass es allgemeine Sprachaufgaben locker meistert und in vielen Anwendungen zuverlässig läuft, was es zu einer super Allround-Option macht.

MiniCPM ist flexibel und effizient. Obwohl es kleiner ist, macht es mit viel größeren Modellen wie Mistral-7B und LLaMA 7B richtig gut mit. Es ist besonders gut für die Sprachverarbeitung auf Englisch und Chinesisch gemacht, was es zu einer super leistungsfähigen, schlanken Alternative für Umgebungen macht, wo die Rechenressourcen knapp sind. Wenn du in einer Umgebung mit begrenzten Ressourcen arbeitest, aber trotzdem eine zuverlässige Sprachverarbeitung brauchst, ist MiniCPM eine super Lösung.

- Parameter: 1B – 4B

- Access: https://github.com/miniCPM

- Open Source: Ja

13. OpenELM

OpenELM ist ein flexibles und anpassungsfähiges Modell mit einem Parameterbereich von 270 Millionen bis 3 Milliarden. Es ist für Umgebungen gedacht, die Multitasking und Reaktionen mit geringer Latenz brauchen. Das ist super für Aufgaben, die Echtzeitleistung auf kleineren Geräten brauchen.

OpenELM wurde von Apple entwickelt und konzentriert sich auf Energieeffizienz und KI-Anwendungen auf dem Gerät. Es kann gut mit Modellen wie MobiLlama und OLMo mithalten und zeigt deutliche Verbesserungen, wenn es für bestimmte Aufgaben optimiert wird. Mit seiner großen Auswahl an Parametergrößen ist OpenELM perfekt für kleinere, eingeschränktere Umgebungen, im Gegensatz zu schwereren Modellen wie GPT-4 oder LLaMA, die mehr Ressourcen brauchen, um eine vergleichbare Leistung zu bringen. Wenn du nach einer leichten, aber leistungsstarken Lösung suchst, vor allem für den mobilen oder Edge-Einsatz, ist OpenELM genau das Richtige für dich.

- Parameter: 270 MILLIONEN – 3 MILLIARDEN

- Access: https://github.com/OpenELM

- Open Source: Ja

14. DCLM

Schauen wir uns mal DCLM an, ein Modell mit einer Milliarde Parametern, das extra für logisches Denken entwickelt wurde. Es macht einen guten Job bei echten Aufgaben, bei denen es darauf ankommt, Dinge zu verstehen und logische Schlussfolgerungen zu ziehen.

DCLM ist super für Sprachverständnis und logisches Denken, vor allem mit seiner Version mit 7 Milliarden Parametern. Es kann mit Modellen wie LLaMA 2 (7B) und Mistral 7B mithalten und ist bei Aufgaben wie gesundem Menschenverstand und logischer Schlussfolgerung genauso gut. Es ist definitiv nicht so leistungsstark wie größere Modelle wie LLaMA 13B, aber DCLM ist super für echte Anwendungen optimiert, die Effizienz und weniger Rechenressourcen brauchen. Wenn du also Umgebungen hast, in denen du starke Leistung ohne schwere Infrastruktur brauchst, ist DCLM eine super Wahl.

- Parameter: 1B

- Access: https://github.com/DCLM

- Open Source: Ja

15. Fuchs

Und zum Schluss noch das Fox-Modell, ein Modell mit 1,6 Milliarden Parametern, das extra auf Geschwindigkeit und Effizienz ausgelegt ist. Es ist für mobile Anwendungen optimiert, bei denen es super wichtig ist, die Latenz niedrig zu halten. Fox ist so gemacht, dass es schnell reagiert, ohne zu viel Rechenleistung zu verbrauchen.

Fox läuft echt gut in Umgebungen, wo man Geschwindigkeit braucht. Es macht Aufgaben mit geringer Latenz echt schnell, was super für Mobilgeräte oder Edge-Geräte ist. Es ist nicht so stark bei komplizierten Denkaufgaben, aber Fox ist super für Situationen, in denen du schnelle, effiziente KI-Antworten brauchst und keine großen Ressourcen verwenden kannst. Das ist das Modell, das man wählt, wenn die Rechenleistung begrenzt ist, aber Geschwindigkeit wichtig ist.

- Parameter: 1,6 MRD.

- Access: https://github.com/foxmodel

- Open Source: Ja

Vergleich kleiner Sprachmodelle

Lass uns mal zusammenfassen, was wir in dieser Tabelle besprochen haben:

|

Modellname |

Parameter |

Open Source |

Wichtigste Funktionen |

|

Qwen2 |

0,5B, 1B, 7B |

Ja |

Skalierbar, für verschiedene Aufgaben geeignet |

|

Mistral Nemo 12B |

12B |

Ja |

Komplexe NLP-Aufgaben, lokale Bereitstellung |

|

Llama 3.1 8B |

8B |

Ja* |

Ausgewogene Leistung und Effizienz |

|

Pythia |

160 MIO. – 2,8 MRD. |

Ja |

Mit Fokus auf logischem Denken und Programmieren |

|

Cerebras-GPT |

111 MIO. – 2,7 MRD. |

Ja |

Rechenintensiv, folgt den Skalierungsgesetzen von Chinchilla |

|

Phi-3,5 |

3,8 MRD. |

Ja** |

Langer Kontext (128.000 Tokens), mehrsprachig |

|

StableLM-zephyr |

3B |

Ja |

Schnelle Schlussfolgerung, super für Edge-Systeme |

|

TinyLlama |

1,1 MRD. |

Ja |

Effizient für Mobil- und Edge-Geräte |

|

MobileLLaMA |

1,4 MRD. |

Ja |

Optimiert für Handys und Geräte mit niedrigem Stromverbrauch |

|

LaMini-GPT |

774 MILLIONEN – 1,5 MILLIARDEN |

Ja |

Mehrsprachige Aufgaben, bei denen man Anweisungen befolgen muss |

|

Gemma2 |

9B, 27B |

Ja |

Lokale Bereitstellung, Echtzeit-Anwendungen |

|

MiniCPM |

1B – 4B |

Ja |

Ausgewogene Leistung, optimiert für Englisch und Chinesisch |

|

OpenELM |

270M – 3B |

Ja |

Multitasking, geringe Latenz, energieeffizient |

|

DCLM |

1B |

Ja |

Gesunder Menschenverstand, logische Schlussfolgerung |

|

Fuchs |

1,6 MRD. |

Ja |

Geschwindigkeitsoptimiert für mobile Anwendungen |

*Mit Nutzungsbeschränkungen

Nur für Forschungszwecke

Fazit

Das war's für diesen Artikel, eine kleine Tour durch die Welt der kleinen Sprachmodelle im Jahr 2026. Wir haben gesehen, wie diese Modelle zeigen, dass kleiner nicht gleich schwächer ist – sondern in vielerlei Hinsicht smarter.

Rechne damit, dass diese SLMs in immer mehr deiner täglichen Tech-Erlebnisse eingebaut werden. Denk dran, es geht um die richtigen Modelle für den Job – und oft ist das richtige Modell einfach klein und flexibel.

Um mehr über kleine Sprachmodelle zu erfahren, empfehle ich diese beiden Quellen:

Ana Rojo Echeburúa ist KI- und Datenspezialistin und hat einen Doktortitel in angewandter Mathematik. Sie liebt es, Daten in verwertbare Erkenntnisse umzuwandeln und hat umfangreiche Erfahrung in der Leitung technischer Teams. Ana arbeitet gerne eng mit ihren Kunden zusammen, um deren Geschäftsprobleme zu lösen und innovative KI-Lösungen zu entwickeln. Sie ist für ihre Problemlösungsfähigkeiten und ihre klare Kommunikation bekannt und hat eine Leidenschaft für KI, insbesondere für generative KI. Ana widmet sich dem kontinuierlichen Lernen und der ethischen KI-Entwicklung sowie der Vereinfachung komplexer Probleme und der Erklärung von Technologien auf verständliche Weise.