programa

El aprendizaje por transferencia se ha vuelto muy importante en aprendizaje automáticodonde los modelos preentrenados se adaptan a nuevas tareas relacionadas para ahorrar tiempo y recursos. Esta estrategia es muy eficaz en campos como la visión por ordenador, el procesamiento del lenguaje natural y el reconocimiento del habla, donde abundan los datos preentrenados a gran escala.

A pesar de su popularidad el ajuste finoun enfoque habitual del aprendizaje por transferencia, a menudo se encuentra con obstáculos como el sobreajuste o los desajustes entre el dominio del modelo preentrenado y los datos objetivo, un fenómeno conocido como cambio de dominio. El aprendizaje por transferencia básico puede encontrar dificultades cuando se enfrenta a tareas complejas o datos limitados, lo que conduce a una adaptación inadecuada.

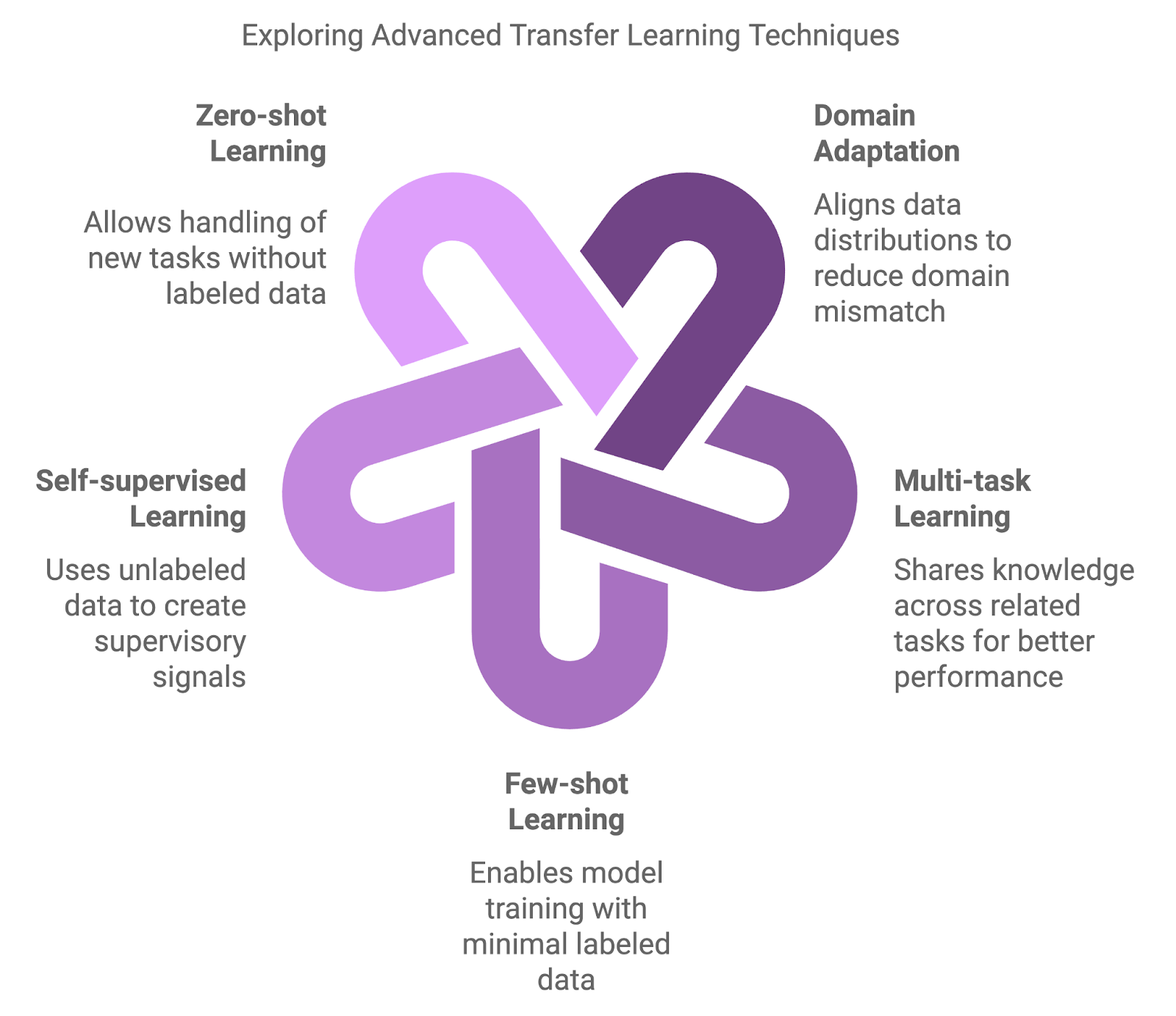

Para superar estos retos, ha surgido una nueva oleada de técnicas avanzadas de aprendizaje por transferencia, que abordan las discrepancias de dominio, la escasez de datos y la necesidad de una adaptación eficaz de los modelos. En este artículo, exploraré algunas de estas estrategiasavanzadas de aprendizaje por transferencia .

Conviértete en un Científico ML

Tipos de técnicas avanzadas de aprendizaje por transferencia

Los enfoques tradicionales, como el preentrenamiento en un gran conjunto de datos y el posterior ajuste en un conjunto de datos de una tarea específica, son fundamentales, pero a veces insuficientes. Han surgido métodos más avanzados para abordar los matices de los cambios de dominio, la escasez de datos y el aprendizaje multitarea.

Los métodos avanzados introducen capas adicionales de complejidad y flexibilidad. Estas técnicas pretenden mejorar el rendimiento del modelo en situaciones en las que los enfoques tradicionales pueden no ser adecuados.

Adaptación del dominio

Las técnicas de adaptación de dominio están diseñadas para manejar las discrepancias entre los dominios de origen (preentrenamiento) y de destino (ajuste fino). El ajuste fino tradicional a menudo produce resultados subóptimos cuando los modelos preentrenados se encuentran con datos que divergen significativamente de sus datos de entrenamiento. Las técnicas de adaptación al dominio reducen este desajuste alineando las distribuciones de datos, lo que garantiza que el modelo pueda generalizar mejor en entornos novedosos.

Aprendizaje Multitarea (MTL)

La MTL permite que un modelo aprenda simultáneamente en varias tareas relacionadas. Al compartir conocimientos entre tareas, el modelo puede utilizar los puntos en común y mejorar el rendimiento en todas las tareas. Esta estrategia es especialmente eficaz cuando las tareas son complementarias, como el aprendizaje conjunto de la clasificación de textos y el análisis de sentimientos en el procesamiento del lenguaje natural. El MTL mejora la generalización y reduce el riesgo de sobreajuste al guiar al modelo para que se centre en los patrones compartidos.

Aprendizaje con pocos disparos

Otra técnica clave es aprendizaje de pocos datosdiseñado para entrenar modelos con un mínimo de datos etiquetados. Mientras que los enfoques tradicionales requieren grandes cantidades de datos etiquetados, las técnicas de pocos datos permiten a los modelos transferir conocimientos utilizando sólo unos pocos ejemplos. Métodos como el metaaprendizaje y las redes prototípicas pueden conducir a una rápida adaptación a nuevas tareas, lo que los hace inestimables en campos como las recomendaciones personalizadas o las clasificaciones de imágenes de nicho.

Aprendizaje autosupervisado (SSL)

La SSL utiliza datos no etiquetados para entrenar modelos, lo que la consolida como una potente herramienta cuando los datos etiquetados son escasos o no están disponibles. Esta técnica construye señales de supervisión a partir de los propios datos, resolviendo tareas de pretexto como predecir las partes que faltan en una imagen o reconstruir un texto revuelto. Los modelos preentrenados mediante SSL han demostrado una gran transferibilidad a toda una serie de aplicaciones.

Aprendizaje sin disparos

El aprendizaje cero va un paso más allá al permitir que los modelos manejen tareas completamente nuevas sin ningún dato etiquetado. Esto se consigue mediante información auxiliar, como relaciones semánticas o descripciones de tareas, que permiten al modelo generalizar incluso ante categorías novedosas. Esta capacidad es muy relevante en campos dinámicos en los que surgen con frecuencia nuevas categorías, como en las aplicaciones de PNL que manejan términos recién acuñados o argot.

Diagrama generado con napkin.ai

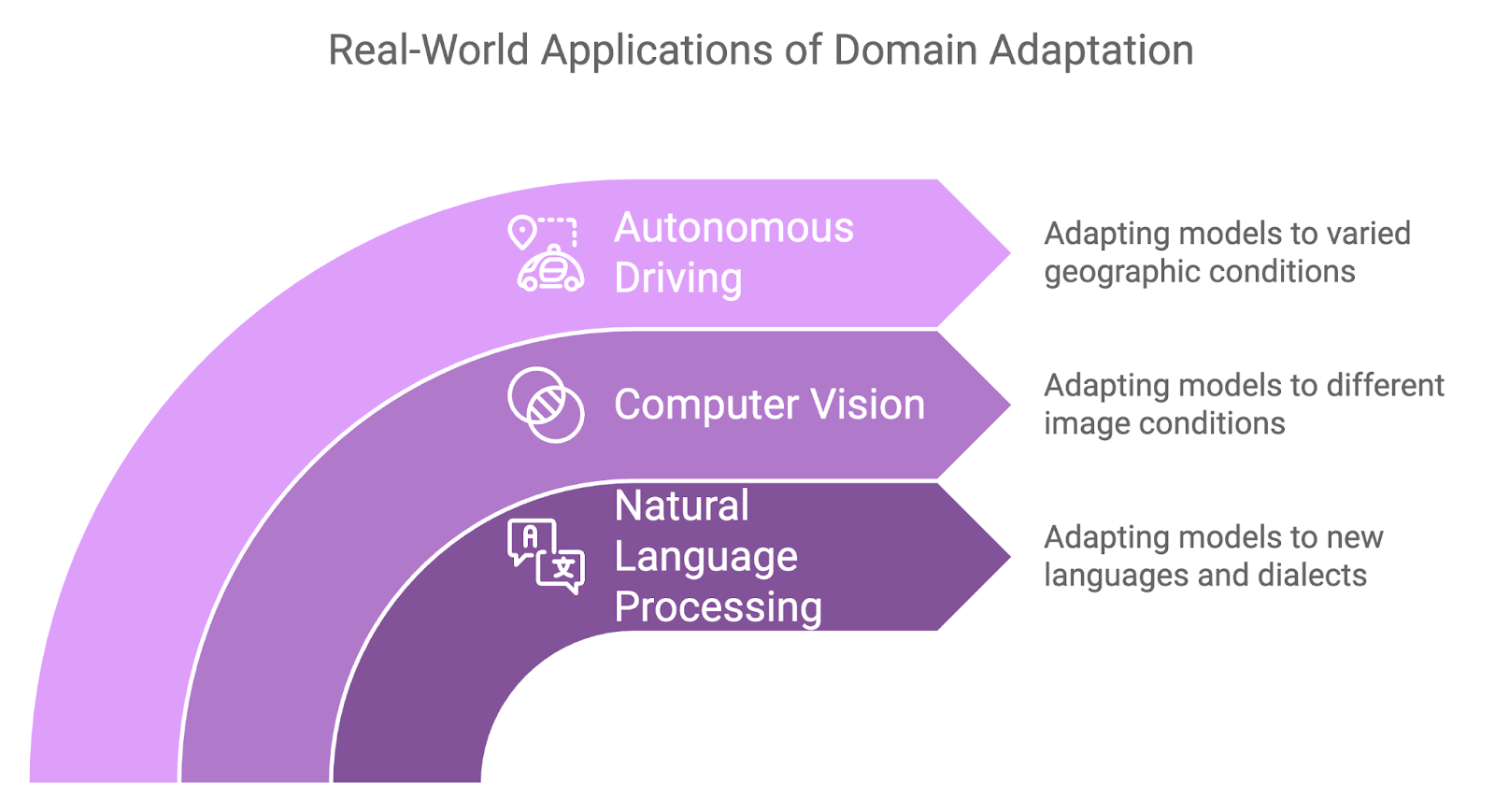

Técnicas de adaptación al dominio

Como ya se ha comentado brevemente, la adaptación de dominio es un subcampo del aprendizaje por transferencia centrado en el manejo de situaciones en las que existe una diferencia significativa, o "cambio de dominio", entre los datos utilizados para entrenar un modelo y los datos en los que se despliega el modelo.

En el aprendizaje por transferencia típico, se supone que los dominios de origen y destino comparten características similares, pero en muchos escenarios del mundo real, estos dominios difieren sustancialmente. En última instancia, esto puede degradar el rendimiento, ya que los modelos entrenados en un conjunto de datos tienen dificultades para generalizarse a nuevas condiciones.

Las técnicas de adaptación de dominio están diseñadas para salvar esta distancia, permitiendo que un modelo entrenado en un dominio funcione eficazmente en otro minimizando la discrepancia entre las distribuciones de datos de origen y de destino. Como resultado, la adaptación al dominio es aún más valiosa en situaciones en las que los datos etiquetados son abundantes en un dominio, pero escasos o no disponibles en otro.

Se han desarrollado varias técnicas para abordar el reto de la adaptación al dominio: dos de los enfoques más comunes son los métodos adversariales y el aprendizaje de características invariantes del dominio.

Adaptación del dominio adversarial

Una técnica muy utilizada para la adaptación al dominio es el aprendizaje adversarial. En este contexto, se entrena un modelo para que aprenda características útiles para la tarea de destino, asegurando al mismo tiempo que esas características no se distinguen entre los dominios de origen y de destino.

Podemos conseguirlo utilizando un discriminador, es decir, una red neuronal encargada de distinguir entre los datos del dominio de origen y los del dominio de destino. El modelo se entrena de forma adversarial para que aprenda a "engañar" al discriminador, haciendo que las representaciones de rasgos sean invariantes del dominio. Si esto te resulta familiar, es porque esta técnica se inspira en Redes Generativas Adversariales (GAN)que utilizan una configuración similar para generar datos sintéticos realistas.

Aprendizaje de rasgos independientes del dominio

Otro enfoque se centra en el aprendizaje de representaciones que no se ven afectadas por las variaciones específicas del dominio. Esto transforma los datos de entrada de ambos dominios en un espacio de características compartido en el que los dominios de origen y destino se alinean más estrechamente. Técnicas como la Máxima Discrepancia Media (MMD) y la CORAL (Correlation Alignment) ayudan a minimizar las diferencias estadísticas en este espacio, garantizando que el modelo pueda generalizarse más eficazmente cuando se aplique al dominio objetivo.

Casos prácticos

La adaptación al dominio ha demostrado su utilidad en diversas aplicaciones del mundo real en las que los cambios de dominio son inevitables:

- La adaptación al dominio se aplica con frecuencia en PNL cuando se transfieren modelos entrenados en una lengua o dialecto a otro.

- Por ejemplo, un modelo de análisis de sentimientos entrenado en inglés puede tener que adaptarse para trabajar con un dialecto regional del mismo idioma, o un modelo entrenado en texto formal puede tener que adaptarse al lenguaje informal y coloquial, por ejemplo, los datos de las redes sociales.

- En visión por ordenador, la adaptación de dominio se utiliza a menudo cuando hay diferencias en las características de la imagen entre los datos de entrenamiento y los de destino.

- Por ejemplo, un modelo entrenado con imágenes de objetos en condiciones de luz natural puede tener que adaptarse para funcionar con luz tenue o artificial.

- Los sistemas de conducción autónoma requieren un gran rendimiento independientemente de las regiones geográficas en las que se encuentren, y aquí es donde la adaptación al dominio demuestra su utilidad una vez más.

- Un modelo entrenado para reconocer señales de tráfico, peatones o vehículos en un país puede tener que adaptarse a unas condiciones de la carretera, unas pautas meteorológicas o incluso unas normas de tráfico ligeramente diferentes en otra región.

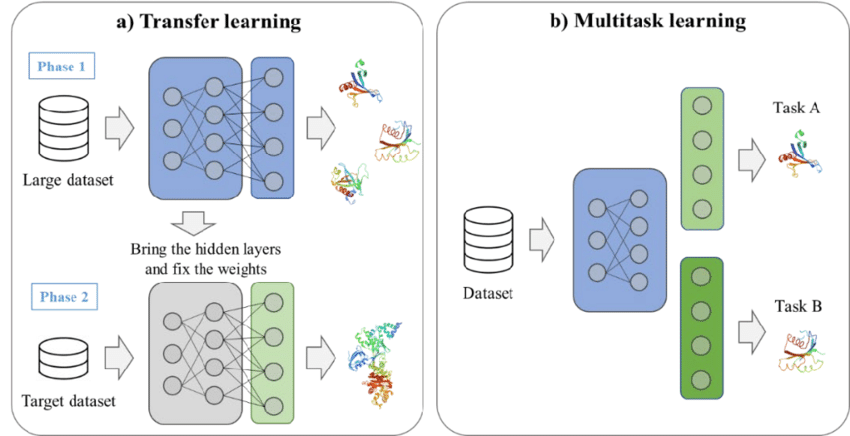

Sinergia entre el aprendizaje multitarea y el aprendizaje por transferencia

A medida que las tareas de aprendizaje automático aumentan en complejidad, la capacidad de abordar simultáneamente múltiples problemas relacionados puede mejorar significativamente el rendimiento y la eficacia de un modelo. La MTL aborda este problema entrenando a los modelos para que realicen varias tareas a la vez, en lugar de centrarse en una única tarea de forma aislada.

¿Qué es el aprendizaje multitarea?

La fuerza del MTL reside en su capacidad para capitalizar las relaciones y estructuras compartidas entre tareas, lo que permite a los modelos aprender representaciones de rasgos más ricas. Los conocimientos adquiridos en una tarea mejoran el rendimiento del modelo en otra, lo que conduce a una mayor eficacia general del aprendizaje.

En la MTL, se suelen utilizar dos estrategias principales:

- Compartición de parámetros duros: Con este enfoque, el modelo comparte la mayoría de sus parámetros entre tareas, siendo independientes sólo las capas específicas de cada tarea. Esto reduce el sobreajuste haciendo que el modelo aprenda representaciones que generalicen bien entre tareas.

- Compartición suave de parámetros: Aquí, cada tarea tiene su propio conjunto de parámetros, pero alguna forma de regularización garantiza que estos parámetros sean similares, fomentando el aprendizaje compartido sin solapamiento total de parámetros.

Un ejemplo de aprendizaje por transferencia y aprendizaje multitarea. Fuente: Kim et al., 2021

Ventajas del aprendizaje multitarea

La MTL ofrece varias ventajas que la convierten en un enfoque valioso para escenarios complejos de aprendizaje automático.

Generalización mejorada

Al aprender en múltiples tareas, el modelo se expone a una gama más amplia de datos y aprende representaciones más generales. Esto a menudo conduce a un mejor rendimiento en cada tarea, especialmente cuando esas tareas están relacionadas.

Eficacia de los datos

Con la MTL, los modelos aprovechan mejor los datos disponibles, sobre todo en situaciones en las que los datos etiquetados son escasos. Como el modelo aprende de múltiples tareas, puede utilizar la información de tareas relacionadas para mejorar el rendimiento. Este aprendizaje entre tareas acelera el proceso de aprendizaje y reduce la dependencia de grandes conjuntos de datos para cada tarea.

Modelo de eficiencia

En lugar de entrenar modelos separados para cada tarea, el MTL consolida el aprendizaje en un único modelo. Esto reduce el coste computacional y la huella de memoria, haciéndolo más eficiente para su despliegue en entornos con recursos limitados.

Aplicaciones del aprendizaje multitarea

La MTL se ha aplicado con éxito en varios ámbitos, con casos de uso notables en la PNL y la visión por ordenador.

Procesamiento del lenguaje natural

En el procesamiento del lenguaje natural, la MTL se utiliza habitualmente para entrenar modelos en múltiples tareas relacionadas. Por ejemplo, un modelo lingüístico puede entrenarse para realizar simultáneamente la traducción automática y la clasificación de textos. Al compartir las representaciones aprendidas en estas tareas, el modelo puede mejorar su comprensión de la estructura y el contexto del lenguaje, lo que beneficia a ambas tareas.

Visión por ordenador

En visión por ordenador, la MTL puede aplicarse a tareas como la detección de objetos y la segmentación de imágenes. Podemos entrenar un modelo para identificar objetos dentro de una imagen y, al mismo tiempo, aprender también a clasificar esos objetos. Este proceso de aprendizaje compartido permite al modelo reconocer tanto la ubicación como la categoría de los objetos, lo que lo hace más versátil y eficaz.

Aprendizaje de pocos disparos y autosupervisado

En escenarios en los que los datos etiquetados son escasos o no están disponibles, el aprendizaje de pocos datos y la SSL han surgido como poderosas técnicas para abordar las limitaciones de los métodos supervisados tradicionales.

Estos enfoques ofrecen formas innovadoras de adaptar modelos a nuevas tareas con un mínimo de datos etiquetados o utilizando grandes cantidades de datos sin etiquetar, lo que los convierte en herramientas esenciales en el ámbito del aprendizaje por transferencia avanzado.

Aprendizaje con pocos disparos

Como ya sabemos, el aprendizaje de pocos disparos está diseñado para permitir que los modelos se adapten rápidamente a nuevas tareas con sólo unos pocos ejemplos etiquetados.

Sin embargo, recopilar grandes conjuntos de datos es poco práctico en muchas aplicaciones, como el diagnóstico de enfermedades raras o la identificación de productos nicho. El aprendizaje de pocos datos resuelve esto transfiriendo conocimientos de tareas relacionadas y afinando los modelos para que funcionen bien con un mínimo de datos nuevos.

A continuación, analizamos dos estrategias clave en el aprendizaje de pocos disparos.

Metaaprendizaje

También conocido como "aprender a aprender", el metaaprendizaje consiste en entrenar un modelo para que se adapte rápidamente a nuevas tareas con un mínimo de datos. La idea es entrenar el modelo a través de una variedad de tareas para que pueda generalizar su aprendizaje y ajustarse rápidamente a tareas no vistas.

Los marcos de metaaprendizaje como el Metaaprendizaje Diagnóstico de Modelos (MAML) permiten que el modelo aprenda un conjunto óptimo de parámetros que pueden ajustarse a nuevas tareas con sólo unos pocos ejemplos.

Redes prototípicas

Otro enfoque habitual son las redes prototípicas, diseñadas para clasificar puntos de datos calculando distancias entre ellos en un espacio de características aprendido. En esta configuración, cada clase está representada por un prototipo (la media de los ejemplos de esa clase en el espacio de características).

A continuación, los nuevos puntos de datos se clasifican en función de su proximidad a estos prototipos. Las redes prototípicas pueden ser eficaces en el aprendizaje de pocos ejemplos, ya que sólo necesitan un número mínimo de ejemplos por clase para generar prototipos significativos para la clasificación.

Aprendizaje autosupervisado

SSL permite a los modelos extraer representaciones significativas de grandes cantidades de datos sin etiquetar mediante la generación de señales de supervisión, obviando la necesidad de etiquetas manuales. Una vez que el modelo ha aprendido de los datos no etiquetados, se puede afinar en un conjunto de datos etiquetados más pequeño, consiguiendo un gran rendimiento en las tareas posteriores.

Una de las técnicas SSL más impactantes es el aprendizaje contrastivo, que entrena modelos comparando pares positivos y negativos de puntos de datos. El objetivo es acercar los puntos de datos similares (pares positivos) en el espacio de características y alejar los disímiles (pares negativos).

En el procesamiento del lenguaje natural, un método SSL popular es el modelado del lenguaje enmascarado, utilizado en modelos como el BERT. Aquí, se enmascaran partes de la entrada y se entrena al modelo para predecir los elementos que faltan utilizando el contexto circundante. Esta estrategia de preentrenamiento ayuda al modelo a aprender representaciones robustas y de uso general que pueden ajustarse para diversas tareas de PNL.

Aplicaciones

El aprendizaje de pocos datos y el aprendizaje autosupervisado se utilizan mucho en campos en los que las limitaciones de datos son un obstáculo importante. He aquí algunas aplicaciones clave de cada uno.

Aprendizaje de pocos disparos en la detección personalizada de objetos

El aprendizaje de pocos intentos resulta valioso en la detección de objetos personalizados, donde la identificación de objetos raros o especializados puede requerir que los modelos aprendan de sólo un puñado de ejemplos etiquetados.

En entornos industriales, la detección de defectos en un proceso de fabricación puede implicar muy pocos casos del defecto. Aprovechando el aprendizaje de pocos disparos, un modelo preentrenado en tareas generales de detección de objetos puede adaptarse rápidamente para detectar estos objetos específicos con un mínimo de datos de entrenamiento adicionales.

Aprendizaje autosupervisado en LM

El aprendizaje autosupervisado ha revolucionado el procesamiento del lenguaje natural mediante modelos como GPT y BERT. Estos modelos aprenden representaciones lingüísticas de uso general que pueden ajustarse para tareas específicas con conjuntos de datos etiquetados relativamente pequeños. Por ejemplo, un modelo lingüístico preentrenado mediante SSL puede ajustarse para realizar tareas como el análisis de sentimientos, la clasificación de textos o el resumen, consiguiendo a menudo resultados de vanguardia.

Aplicación práctica de técnicas avanzadas de aprendizaje por transferencia

Las bibliotecas y marcos de aprendizaje automático pueden simplificar considerablemente la aplicación de métodos avanzados de aprendizaje por transferencia. Herramientas como PyTorch, TensorFlowy Transformadores de Caras Abrazadas proporcionan la flexibilidad necesaria y componentes preconstruidos para acelerar el proceso de desarrollo.

Marcos y herramientas

Para los profesionales que deseen aplicar técnicas avanzadas de aprendizaje por transferencia, varias bibliotecas y marcos de trabajo ofrecen un amplio apoyo:

- PyTorch: Un marco flexible y fácil de usar, ampliamente utilizado en proyectos de investigación y de aprendizaje automático práctico. El gráfico computacional dinámico de PyTorch lo hace ideal para tareas como el metaaprendizaje y el aprendizaje multitarea.

- TensorFlow: Otro popular marco de aprendizaje profundo, TensorFlow, ofrece un sólido soporte para el aprendizaje por transferencia y la adaptación al dominio a través de su API de alto nivel, Keras. El tensorflow_hub de TensorFlow también proporciona modelos preentrenados que pueden ajustarse para nuevas tareas.

- Cara Abrazada Transformers: Es una biblioteca ideal para tareas de procesamiento del lenguaje natural, ya que proporciona una variedad de modelos preentrenados, como BERT, GPT y T5, que pueden ajustarse para tareas posteriores específicas con un esfuerzo mínimo.

Retos y consideraciones

Aplicar técnicas avanzadas de aprendizaje por transferencia es un reto, y hay algunos factores críticos que debemos tener en cuenta.

Olvido catastrófico

El perfeccionamiento en tareas nuevas puede hacer que los modelos "olviden" lo que han aprendido en tareas anteriores. Técnicas como Consolidación del Peso Elástico (EWC) pueden ayudar a preservar los pesos del modelo preentrenado, lo que es crucial para el conocimiento previo.

Manejo de la complejidad computacional

Técnicas como la adaptación al dominio y el aprendizaje multitarea pueden aumentar significativamente los requisitos computacionales. Entrenar modelos de adaptación al dominio adversario o arquitecturas multitarea puede requerir más recursos debido a la complejidad adicional. Tenemos que optimizar nuestro modelo y utilizar herramientas como el entrenamiento de precisión mixta para manejar modelos grandes con eficacia.

Garantizar la imparcialidad y mitigar los prejuicios

Los modelos de aprendizaje por transferencia preentrenados en datos sesgados pueden propagar o incluso amplificar estos sesgos en nuevas tareas, lo que conduce a predicciones sesgadas. Este riesgo es crítico en ámbitos sensibles como la sanidad y las finanzas. Para garantizar la imparcialidad, deberíamos evaluar periódicamente los resultados del modelo en busca de sesgos y aplicar técnicas de mitigación, como la reponderación, la desprejuiciación adversarial o el aprendizaje de representación justa.

Ejemplos del sector

Los métodos avanzados de aprendizaje por transferencia se están aplicando en diversos sectores, aportando soluciones innovadoras a complejos retos del mundo real. A continuación se presentan algunas aplicaciones clave y ejemplos de la industria que ponen de relieve cómo estas técnicas están impulsando los avances de la IA.

OpenAI: Modelos GPT con ganancias de pocos disparos

El modelo modelo GPT-4o de OpenAIun ejemplo destacado de aprendizaje con pocos ejemplos en acción, ha demostrado la capacidad de adaptarse a nuevas tareas con sólo unos pocos ejemplos. GPT-4o, preentrenado en cantidades masivas de datos de texto, puede realizar varias tareas, como traducción, resumen y respuesta a preguntas, sin necesidad de un ajuste fino específico de la tarea.

En su lugar, los usuarios proporcionan algunos ejemplos de la tarea deseada, y el modelo generaliza a partir de ahí. Esta capacidad de aprendizaje en pocos pasos ha ampliado la gama de aplicaciones de los grandes modelos lingüísticos, desde la escritura creativa hasta los agentes conversacionales.

DeepMind: Aprendizaje multitarea en la IA sanitaria

DeepMind, líder en investigación de IA, ha utilizado el aprendizaje multitarea para desarrollar modelos sanitarios que pueden ayudar a diagnosticar múltiples afecciones a partir de imágenes médicas. Por ejemplo, su sistema de IA para detectar enfermedades oculares a partir de exploraciones de la retina es capaz de diagnosticar una serie de afecciones, como la retinopatía diabética y la degeneración macular asociada a la edad, utilizando un único modelo.

Este enfoque MTL reduce la necesidad de modelos separados para cada afección, lo que permite a los profesionales sanitarios agilizar sus procesos de diagnóstico y proporcionar una atención al paciente más rápida y precisa.

Waymo: Adaptación del dominio en la conducción autónoma

Waymo (el proyecto de coche autoconducido de Google) utiliza técnicas de adaptación de dominio para mejorar la generalización de sus modelos de vehículo autónomo en diversos entornos de conducción. La empresa entrena sus modelos en entornos simulados y luego los adapta para su despliegue en el mundo real, en diferentes ciudades y condiciones meteorológicas.

Este proceso garantiza que los coches autoconducidos puedan adaptarse a los matices de los distintos paisajes urbanos, desde las congestionadas calles de San Francisco hasta las amplias autopistas de Arizona, sin necesidad de un reentrenamiento exhaustivo para cada lugar.

Tendencias futuras en el aprendizaje avanzado por transferencia

Los investigadores están ampliando constantemente los límites, esforzándose por hacer modelos más adaptables, justos y capaces de manejar tareas complejas del mundo real, reduciendo al mismo tiempo la cantidad de datos y el tiempo de entrenamiento necesarios.

Aprendizaje continuo

El aprendizaje continuo o aprendizaje a lo largo de toda la vida se centra en el desarrollo de modelos que puedan aprender continuamente a partir de nuevos datos, al tiempo que retienen los conocimientos de las tareas aprendidas anteriormente. A diferencia del aprendizaje por transferencia tradicional, en el que los modelos son estáticos una vez ajustados, el aprendizaje continuo permite una adaptación continua a la nueva información.

Esto es vital para entornos dinámicos, como la robótica y los sistemas autónomos, en los que surgen nuevos escenarios con regularidad. En este contexto, las estrategias basadas en la memoria ayudan a equilibrar la necesidad de conservar los conocimientos pasados al tiempo que se incorporan nuevas habilidades. Los desarrollos futuros pretenden ampliar el aprendizaje continuo a dominios más complejos, garantizando que los modelos puedan actualizarse eficazmente sin comprometer el rendimiento anterior.

Equidad y mitigación de prejuicios

A medida que el aprendizaje por transferencia se hace más frecuente en sectores como la sanidad, las finanzas y la aplicación de la ley, es imposible ignorar la necesidad de abordar la imparcialidad y la parcialidad.

Los modelos preentrenados en conjuntos de datos grandes y diversos suelen llevar sesgos inherentes, que pueden dar lugar a resultados sesgados en nuevas aplicaciones. Para contrarrestarlo, los investigadores están explorando técnicas como la eliminación de sesgos adversariales, la reponderación y el aprendizaje de representación justa para detectar y mitigar estos sesgos.

Garantizar la imparcialidad seguirá siendo un punto central en la investigación del aprendizaje por transferencia, especialmente en dominios sensibles en los que las predicciones sesgadas pueden tener implicaciones en el mundo real.

Aprendizaje híbrido por transferencia

El aprendizaje de transferencia híbrido combina métodos supervisados, no supervisados y autosupervisados para aprovechar los puntos fuertes de cada uno. Los modelos suelen preentrenarse utilizando enfoques no supervisados o autosupervisados para aprender representaciones generales y luego se ajustan con datos etiquetados para tareas específicas.

Esta estrategia híbrida mejora la transferibilidad y reduce la dependencia de grandes conjuntos de datos etiquetados, lo que la hace especialmente útil en campos con pocos datos anotados, como el diagnóstico de enfermedades raras o las aplicaciones industriales especializadas.

Aprendizaje por refuerzo en el aprendizaje por transferencia

El aprendizaje por transferencia también está avanzando en aprendizaje por refuerzo (RL)donde los agentes entrenados en un entorno se adaptan para su uso en entornos relacionados. Esto reduce el tiempo y los datos necesarios para que los agentes dominen nuevas tareas, mejorando su eficacia a la hora de resolver problemas complejos de varios pasos.

Por ejemplo, un agente de RL entrenado para navegar por un tipo específico de sistema robótico puede aplicar sus conocimientos a una configuración nueva, pero similar, con un reentrenamiento mínimo, lo que aumenta significativamente la versatilidad y escalabilidad de los sistemas de RL.

Conclusión

En este artículo, exploramos técnicas avanzadas de aprendizaje por transferencia. Hemos examinado la adaptación al dominio para tratar las diferencias en la distribución de los datos, el aprendizaje multitarea para utilizar el conocimiento compartido, y el aprendizaje de pocos disparos y autosupervisado para escenarios con datos etiquetados limitados.

Estas técnicas pueden ofrecernos estrategias eficaces para afrontar los retos y mejorar el rendimiento del modelo. A medida que la IA siga avanzando, la familiaridad con estas técnicas será esencial para seguir siendo competitivos.