Programa

A aprendizagem por transferência se tornou muito importante na aprendizado de máquinaem que modelos pré-treinados são adaptados para novas tarefas relacionadas, a fim de economizar tempo e recursos. Essa estratégia é altamente eficaz em áreas como visão computacional, processamento de linguagem natural e reconhecimento de fala, em que há abundância de dados pré-treinados em grande escala.

Apesar de sua popularidade, ajuste finouma abordagem comum de aprendizagem por transferência, muitas vezes encontra obstáculos, como excesso de ajuste ou desalinhamentos entre o domínio do modelo pré-treinado e os dados de destino, um fenômeno conhecido como mudança de domínio. A aprendizagem por transferência básica pode encontrar dificuldades quando confrontada com tarefas complexas ou dados limitados, levando a uma adaptação inadequada.

Para superar esses desafios, surgiu uma nova onda de técnicas avançadas de aprendizagem por transferência, abordando as discrepâncias de domínio, a escassez de dados e a necessidade de adaptação eficiente do modelo. Neste artigo, explorarei algumas dessas estratégiasavançadas de aprendizagem por transferência.

Torne-se um cientista de ML

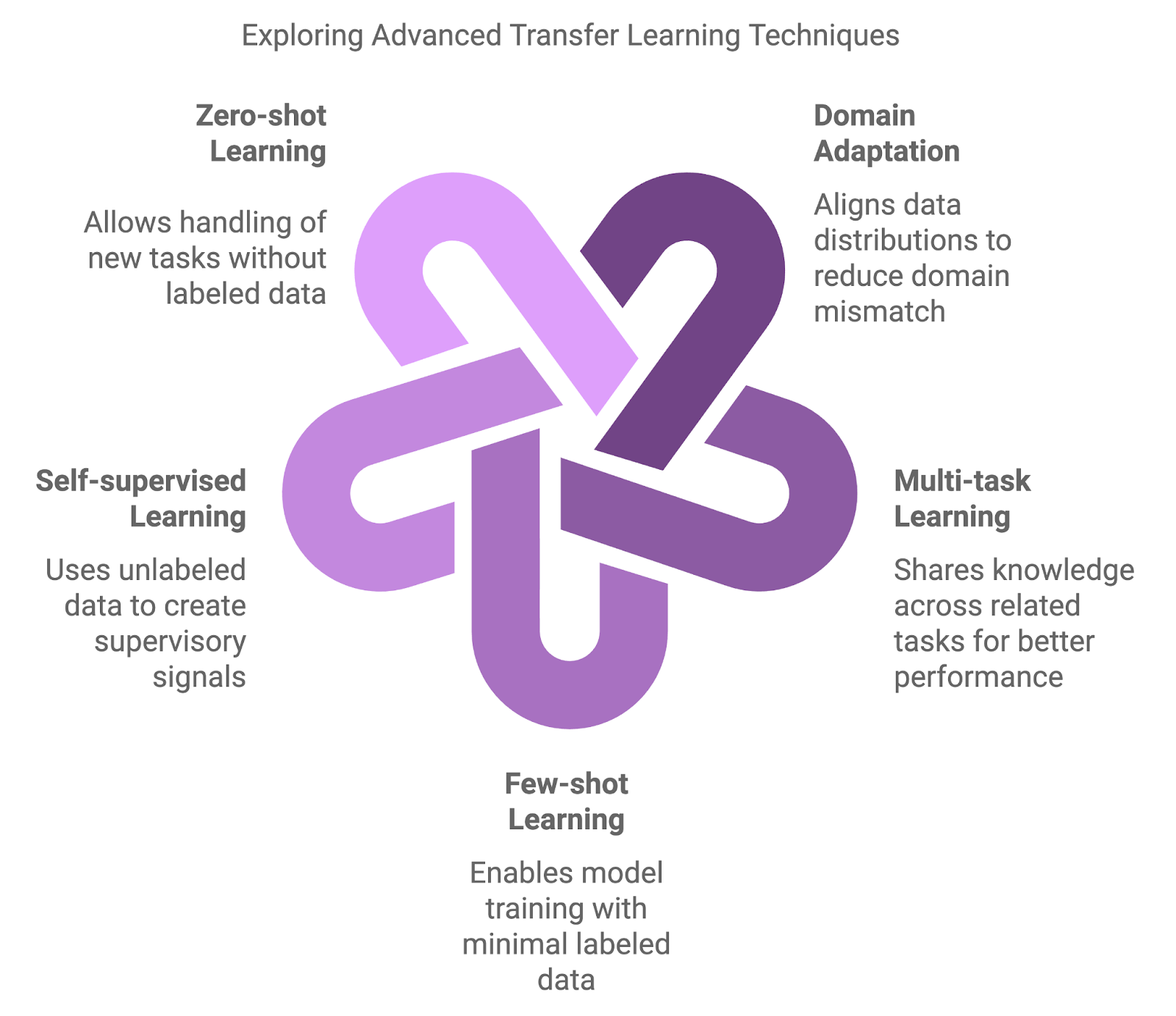

Tipos de técnicas avançadas de aprendizagem por transferência

As abordagens tradicionais, como o pré-treinamento em um grande conjunto de dados e, em seguida, o ajuste fino em um conjunto de dados específico da tarefa, são fundamentais, mas às vezes insuficientes. Surgiram métodos mais avançados para lidar com as nuances das mudanças de domínio, escassez de dados e aprendizado multitarefa.

Os métodos avançados introduzem camadas adicionais de complexidade e flexibilidade. Essas técnicas visam melhorar o desempenho do modelo em cenários em que as abordagens tradicionais podem não ser adequadas.

Adaptação do domínio

As técnicas de adaptação de domínio são projetadas para lidar com discrepâncias entre os domínios de origem (pré-treinamento) e de destino (ajuste fino). O ajuste fino tradicional geralmente produz resultados abaixo do ideal quando os modelos pré-treinados encontram dados que divergem significativamente dos dados de treinamento. As técnicas de adaptação de domínio reduzem essa incompatibilidade alinhando as distribuições de dados, garantindo que o modelo possa se generalizar melhor em novas configurações.

Aprendizagem multitarefa (MTL)

O MTL permite que um modelo aprenda simultaneamente em várias tarefas relacionadas. Ao compartilhar o conhecimento entre as tarefas, o modelo pode usar pontos em comum e melhorar o desempenho em todas as tarefas. Essa estratégia é especialmente eficaz quando as tarefas são complementares, como o aprendizado conjunto de classificação de texto e análise de sentimentos no processamento de linguagem natural. O MTL aprimora a generalização e reduz o risco de ajuste excessivo, orientando o modelo a se concentrar em padrões compartilhados.

Aprendizagem com poucos disparos

Outra técnica importante é a aprendizado de poucos disparosprojetada para treinar modelos com o mínimo de dados rotulados. Embora as abordagens tradicionais exijam grandes quantidades de dados rotulados, as técnicas de poucos disparos permitem que os modelos transfiram conhecimento usando apenas alguns exemplos. Métodos como meta-aprendizagem e redes prototípicas podem levar a uma rápida adaptação a novas tarefas, tornando-os inestimáveis em campos como recomendações personalizadas ou classificações de imagens de nicho.

Aprendizagem autossupervisionada (SSL)

O SSL usa dados não rotulados para treinar modelos, consolidando-o como uma ferramenta poderosa quando os dados rotulados são escassos ou não estão disponíveis. Essa técnica constrói sinais de supervisão a partir dos próprios dados, solucionando tarefas de pretexto, como a previsão de partes ausentes de uma imagem ou a reconstrução de texto embaralhado. Os modelos pré-treinados usando SSL demonstraram alta capacidade de transferência em uma variedade de aplicações.

Aprendizagem de tiro zero

A aprendizagem zero-shot vai um passo além, permitindo que os modelos lidem com tarefas completamente novas sem nenhum dado rotulado. Isso é obtido por meio de informações auxiliares, como relações semânticas ou descrições de tarefas, permitindo que o modelo generalize mesmo quando confrontado com novas categorias. Esse recurso é altamente relevante em campos dinâmicos em que novas categorias surgem com frequência, como em aplicativos de PNL que lidam com termos ou gírias recém-criados.

Diagrama gerado com o napkin.ai

Técnicas de adaptação de domínio

Conforme discutido brevemente anteriormente, a adaptação de domínio é um subcampo da aprendizagem por transferência que se concentra em lidar com situações em que há uma diferença significativa, ou "mudança de domínio", entre os dados usados para treinar um modelo e os dados em que o modelo é implantado.

Na aprendizagem por transferência típica, supõe-se que os domínios de origem e de destino compartilhem características semelhantes, mas em muitos cenários do mundo real, esses domínios diferem substancialmente. Em última análise, isso pode prejudicar o desempenho, pois os modelos treinados em um conjunto de dados têm dificuldade para generalizar para novas condições.

As técnicas de adaptação de domínio são projetadas para preencher essa lacuna, permitindo que um modelo treinado em um domínio tenha um desempenho eficaz em outro, minimizando a discrepância entre as distribuições de dados de origem e de destino. Como resultado, a adaptação do domínio é ainda mais valiosa em situações em que os dados rotulados são abundantes em um domínio, mas escassos ou indisponíveis em outro.

Várias técnicas foram desenvolvidas para enfrentar o desafio da adaptação de domínio - duas das abordagens mais comuns são os métodos adversários e o aprendizado de recursos invariantes de domínio.

Adaptação de domínio adversarial

Uma técnica amplamente usada para a adaptação do domínio envolve o aprendizado contraditório. Nesse contexto, um modelo é treinado para aprender recursos que são úteis para a tarefa de destino e, ao mesmo tempo, garantir que esses recursos sejam indistinguíveis entre os domínios de origem e de destino.

Podemos fazer isso usando um discriminador, ou seja, uma rede neural encarregada de distinguir entre os dados de domínio de origem e de destino. O modelo é treinado de forma contraditória para que aprenda a "enganar" o discriminador, tornando as representações de recursos independentes do domínio. Se isso soa familiar, é porque essa técnica é inspirada em Redes Adversariais Generativas (GANs)que usam uma configuração semelhante para gerar dados sintéticos realistas.

Aprendizagem de recursos invariantes de domínio

Outra abordagem se concentra em aprender representações que não são afetadas por variações específicas do domínio. Isso transforma os dados de entrada de ambos os domínios em um espaço de recursos compartilhado em que os domínios de origem e de destino se alinham mais estreitamente. Técnicas como MMD (Maximum Mean Discrepancy, discrepância média máxima) e CORAL (Correlation Alignment, alinhamento de correlação) ajudam a minimizar as diferenças estatísticas nesse espaço, garantindo que o modelo possa ser generalizado com mais eficiência quando aplicado ao domínio de destino.

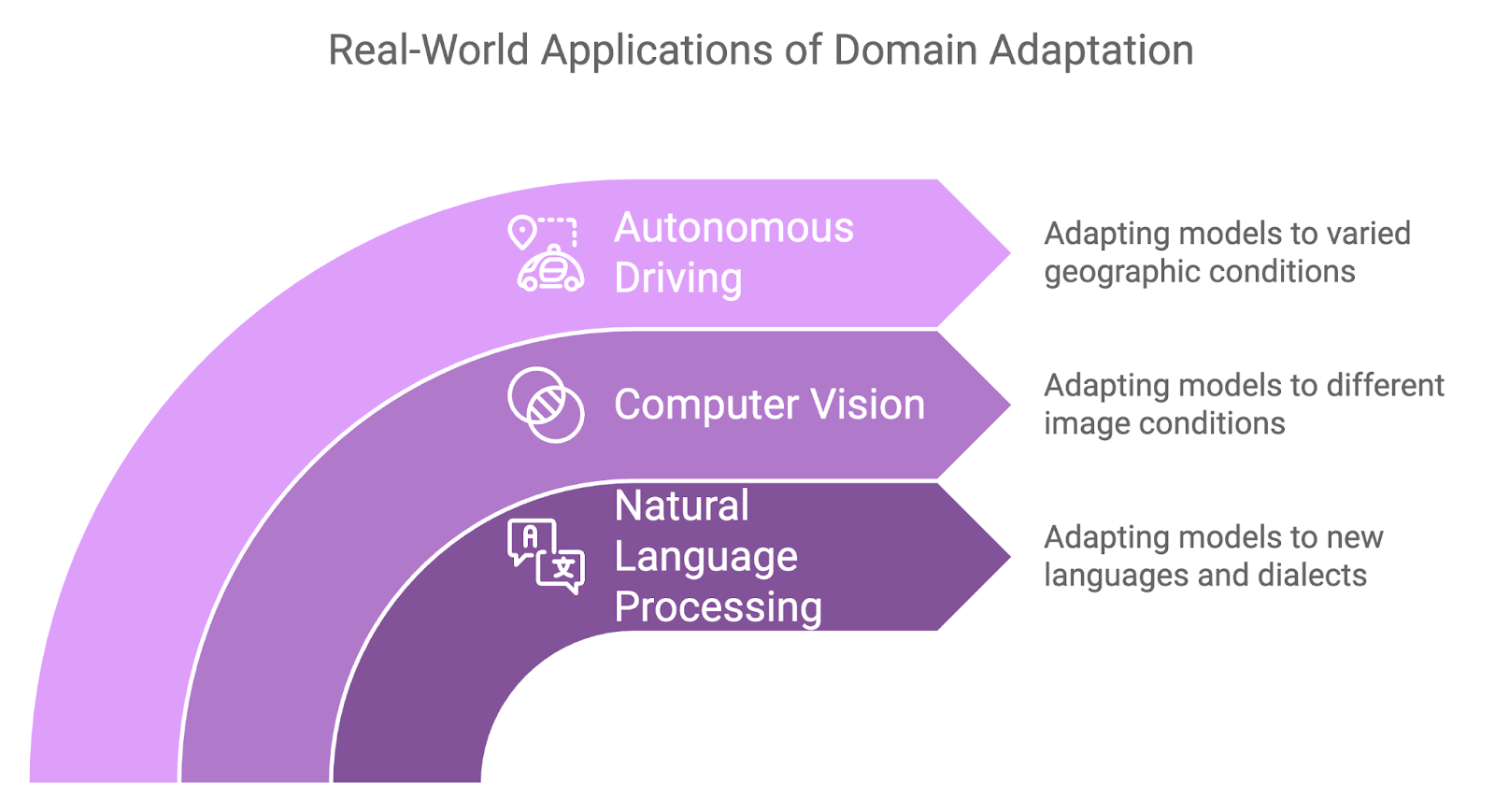

Casos de uso

A adaptação de domínio provou ser útil em uma variedade de aplicativos do mundo real em que as mudanças de domínio são inevitáveis:

- A adaptação de domínio é aplicada com frequência na PNL ao transferir modelos treinados em um idioma ou dialeto para outro.

- Por exemplo, um modelo de análise de sentimentos treinado em inglês pode precisar ser adaptado para trabalhar com um dialeto regional do mesmo idioma, ou um modelo treinado em texto formal pode precisar se adaptar a uma linguagem informal e coloquial, por exemplo, dados de mídia social.

- Na visão computacional, a adaptação de domínio é usada com frequência quando há diferenças nas características da imagem entre os dados de treinamento e os dados de destino.

- Por exemplo, um modelo treinado em imagens de objetos em condições de iluminação natural pode precisar ser adaptado para funcionar com iluminação fraca ou artificial.

- Os sistemas de direção autônoma exigem um bom desempenho, independentemente das regiões geográficas encontradas, e é nesse ponto que a adaptação do domínio se mostra útil mais uma vez.

- Um modelo treinado para reconhecer sinais de trânsito, pedestres ou veículos em um país pode precisar se adaptar a condições de estrada, padrões climáticos ou até mesmo regras de trânsito ligeiramente diferentes em outra região.

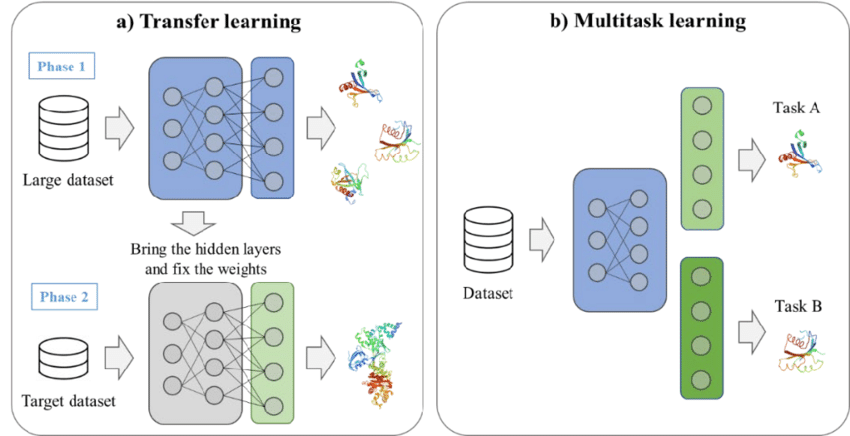

Sinergia entre aprendizagem multitarefa e aprendizagem por transferência

À medida que as tarefas de aprendizado de máquina aumentam em complexidade, a capacidade de lidar com vários problemas relacionados simultaneamente pode melhorar significativamente o desempenho e a eficiência de um modelo. O MTL aborda isso treinando modelos para executar várias tarefas ao mesmo tempo, em vez de se concentrar em uma única tarefa isoladamente.

O que é aprendizagem multitarefa?

A força da MTL está em sua capacidade de capitalizar relacionamentos e estruturas compartilhadas entre tarefas, permitindo que os modelos aprendam representações de recursos mais ricas. Os insights obtidos em uma tarefa melhoram o desempenho do modelo em outra, levando a uma maior eficiência geral de aprendizado.

Na MTL, duas estratégias principais são comumente usadas:

- Compartilhamento rígido de parâmetros: Com essa abordagem, o modelo compartilha a maioria de seus parâmetros entre as tarefas, sendo que apenas as camadas específicas da tarefa são independentes. Isso reduz o excesso de ajuste, fazendo com que o modelo aprenda representações que se generalizam bem entre as tarefas.

- Compartilhamento suave de parâmetros: Aqui, cada tarefa tem seu próprio conjunto de parâmetros, mas alguma forma de regularização garante que esses parâmetros sejam semelhantes, incentivando o aprendizado compartilhado sem sobreposição total de parâmetros.

Um exemplo de aprendizagem por transferência e aprendizagem multitarefa. Fonte: Kim et al., 2021

Benefícios do aprendizado multitarefa

O MTL oferece várias vantagens que o tornam uma abordagem valiosa para cenários complexos de aprendizado de máquina.

Generalização aprimorada

Ao aprender em várias tarefas, o modelo é exposto a uma gama mais ampla de dados e aprende representações mais gerais. Isso geralmente leva a um melhor desempenho em cada tarefa, especialmente quando essas tarefas estão relacionadas.

Eficiência de dados

Com o MTL, os modelos fazem melhor uso dos dados disponíveis, especialmente em situações em que os dados rotulados são escassos. Como o modelo aprende com várias tarefas, ele pode usar insights de tarefas relacionadas para melhorar o desempenho. Esse aprendizado entre tarefas acelera o processo de aprendizado e reduz a dependência de grandes conjuntos de dados para cada tarefa.

Eficiência do modelo

Em vez de treinar modelos separados para cada tarefa, o MTL consolida o aprendizado em um único modelo. Isso reduz o custo computacional e o espaço de memória, tornando-o mais eficiente para a implantação em ambientes com recursos limitados.

Aplicações do aprendizado multitarefa

A MTL tem sido aplicada com sucesso em vários domínios, com casos de uso notáveis em PNL e visão computacional.

Processamento de linguagem natural

No processamento de linguagem natural, o MTL é comumente usado para treinar modelos em várias tarefas relacionadas. Por exemplo, um modelo de linguagem pode ser treinado para realizar simultaneamente a tradução automática e a classificação de texto. Ao compartilhar representações aprendidas nessas tarefas, o modelo pode melhorar sua compreensão da estrutura e do contexto da linguagem, beneficiando ambas as tarefas.

Visão computacional

Na visão computacional, a MTL pode ser aplicada a tarefas como detecção de objetos e segmentação de imagens. Podemos treinar um modelo para identificar objetos em uma imagem e, ao mesmo tempo, aprender a classificar esses objetos. Esse processo de aprendizado compartilhado permite que o modelo reconheça tanto a localização quanto a categoria dos objetos, tornando-o mais versátil e eficiente.

Aprendizagem com poucos disparos e autossupervisionada

Em cenários em que os dados rotulados são escassos ou não estão disponíveis, o aprendizado de poucos disparos e a SSL surgiram como técnicas poderosas para lidar com as limitações dos métodos supervisionados tradicionais.

Essas abordagens oferecem maneiras inovadoras de adaptar modelos a novas tarefas com o mínimo de dados rotulados ou usando grandes quantidades de dados não rotulados, o que as torna ferramentas essenciais no campo da aprendizagem por transferência avançada.

Aprendizagem com poucos disparos

Como já sabemos, a aprendizagem de poucos disparos foi projetada para permitir que os modelos se adaptem rapidamente a novas tarefas com apenas alguns exemplos rotulados.

No entanto, a coleta de grandes conjuntos de dados é impraticável em muitas aplicações, como o diagnóstico de doenças raras ou a identificação de produtos de nicho. O aprendizado de poucos disparos resolve isso transferindo o conhecimento de tarefas relacionadas e ajustando os modelos para que tenham um bom desempenho com o mínimo de novos dados.

A seguir, discutiremos duas estratégias importantes no aprendizado de poucos disparos.

Meta-aprendizagem

Também conhecido como "aprender a aprender", o meta-aprendizado envolve o treinamento de um modelo para se adaptar rapidamente a novas tarefas com o mínimo de dados. A ideia é treinar o modelo em uma variedade de tarefas para que ele possa generalizar seu aprendizado e se ajustar rapidamente a tarefas inéditas.

As estruturas de meta-aprendizagem, como a MAML (Model-Agnostic Meta-Learning), permitem que o modelo aprenda um conjunto ideal de parâmetros que podem ser ajustados para novas tarefas com apenas alguns exemplos.

Redes prototípicas

Outra abordagem comum são as redes prototípicas, que são projetadas para classificar pontos de dados calculando as distâncias entre eles em um espaço de recursos aprendido. Nessa configuração, cada classe é representada por um protótipo (a média dos exemplos dessa classe no espaço de recursos).

Novos pontos de dados são então classificados com base em sua proximidade com esses protótipos. As redes prototípicas podem ser eficazes no aprendizado de poucas tentativas, pois exigem apenas um número mínimo de exemplos por classe para gerar protótipos significativos para a classificação.

Aprendizagem autossupervisionada

O SSL permite que os modelos extraiam representações significativas de grandes quantidades de dados não rotulados, gerando sinais de supervisão, ignorando a necessidade de rótulos manuais. Depois que o modelo tiver aprendido com os dados não rotulados, ele poderá ser ajustado em um conjunto de dados rotulados menor, obtendo um bom desempenho em tarefas posteriores.

Uma das técnicas de SSL mais impactantes é a aprendizagem contrastiva, que treina modelos comparando pares positivos e negativos de pontos de dados. O objetivo é aproximar os pontos de dados semelhantes (pares positivos) no espaço de recursos e afastar os pontos diferentes (pares negativos).

No processamento de linguagem natural, um método popular de SSL é a modelagem de linguagem mascarada, usada em modelos como o BERT. Aqui, partes da entrada são mascaradas, e o modelo é treinado para prever os elementos ausentes usando o contexto ao redor. Essa estratégia de pré-treinamento ajuda o modelo a aprender representações robustas e de uso geral que podem ser ajustadas para várias tarefas de PLN.

Aplicativos

O aprendizado com poucos disparos e autossupervisionado é amplamente usado em campos em que as limitações de dados são uma barreira significativa. Aqui estão algumas das principais aplicações de cada uma delas.

Aprendizado de poucos disparos na detecção de objetos personalizados

O aprendizado de poucos disparos se mostra valioso na detecção de objetos personalizados, em que a identificação de objetos raros ou especializados pode exigir que os modelos aprendam com apenas alguns exemplos rotulados.

Em ambientes industriais, a detecção de defeitos em um processo de fabricação pode envolver muito poucas instâncias do defeito. Ao aproveitar o aprendizado de poucos disparos, um modelo pré-treinado em tarefas gerais de detecção de objetos pode ser rapidamente adaptado para detectar esses objetos específicos com o mínimo de dados de treinamento adicionais.

Aprendizagem autossupervisionada em LMs

O aprendizado autossupervisionado revolucionou o processamento de linguagem natural por meio de modelos como GPT e BERT. Esses modelos aprendem representações de linguagem de uso geral que podem ser ajustadas para tarefas específicas com conjuntos de dados rotulados relativamente pequenos. Por exemplo, um modelo de linguagem pré-treinado usando SSL pode ser ajustado para executar tarefas como análise de sentimentos, classificação de texto ou sumarização, geralmente obtendo resultados de última geração.

Implementação prática de técnicas avançadas de aprendizagem por transferência

As bibliotecas e estruturas de aprendizagem automática podem simplificar significativamente a implementação de métodos avançados de aprendizagem por transferência. Ferramentas como PyTorch, TensorFlowe Transformadores Hugging Face fornecem a flexibilidade necessária e componentes pré-construídos para acelerar o processo de desenvolvimento.

Estruturas e ferramentas

Para os profissionais que desejam implementar técnicas avançadas de aprendizagem por transferência, várias bibliotecas e estruturas oferecem amplo suporte:

- PyTorch: Uma estrutura flexível e fácil de usar, amplamente utilizada em pesquisas e projetos práticos de aprendizado de máquina. O gráfico computacional dinâmico do PyTorch o torna ideal para tarefas como meta-aprendizagem e aprendizagem multitarefa.

- TensorFlow: Outra estrutura popular de aprendizagem profunda, o TensorFlow, oferece suporte robusto para aprendizagem por transferência e adaptação de domínio por meio de sua API de alto nível, o Keras. O tensorflow_hub do TensorFlow também fornece modelos pré-treinados que podem ser ajustados para novas tarefas.

- Hugging Face Transformers: Uma biblioteca ideal para tarefas de processamento de linguagem natural, ela oferece uma variedade de modelos pré-treinados, como BERT, GPT e T5, que podem ser ajustados para tarefas específicas de downstream com o mínimo de esforço.

Desafios e considerações

A implementação de técnicas avançadas de aprendizagem por transferência é um desafio, e há alguns fatores críticos que precisamos ter em mente.

Esquecimento catastrófico

O ajuste fino em novas tarefas pode fazer com que os modelos "esqueçam" o que aprenderam em tarefas anteriores. Técnicas como Consolidação de peso elástico (EWC) podem ajudar a preservar os pesos do modelo pré-treinado, o que é fundamental para o conhecimento prévio.

Lidar com a complexidade computacional

Técnicas como adaptação de domínio e aprendizado multitarefa podem aumentar significativamente os requisitos computacionais. O treinamento de modelos de adaptação de domínio adversários ou arquiteturas multitarefa pode exigir mais recursos devido à complexidade adicional. Precisamos otimizar nosso modelo e usar ferramentas como treinamento de precisão mista para lidar com modelos grandes de forma eficiente.

Garantia de justiça e mitigação de preconceitos

Os modelos de aprendizagem por transferência pré-treinados em dados tendenciosos podem propagar ou até mesmo ampliar essas tendências em novas tarefas, levando a previsões distorcidas. Esse risco é crítico em áreas sensíveis, como saúde e finanças. Para garantir a imparcialidade, devemos avaliar regularmente os resultados do modelo quanto à parcialidade e aplicar técnicas de atenuação, como reponderação, desvios adversários ou aprendizado de representação justa.

Exemplos do setor

Métodos avançados de aprendizagem por transferência estão sendo aplicados em vários setores, fornecendo soluções inovadoras para desafios complexos do mundo real. Veja abaixo alguns aplicativos importantes e exemplos do setor que destacam como essas técnicas estão impulsionando os avanços da IA.

OpenAI: Modelos de GPT usando ganhos de poucos disparos

O modelo GPT-4o da OpenAIda OpenAI, um dos principais exemplos de aprendizado de poucos disparos em ação, demonstrou a capacidade de se adaptar a novas tarefas com apenas alguns exemplos. O GPT-4o, pré-treinado em grandes quantidades de dados de texto, pode executar várias tarefas, como tradução, resumo e resposta a perguntas, sem a necessidade de ajuste fino específico da tarefa.

Em vez disso, os usuários fornecem alguns exemplos da tarefa desejada, e o modelo generaliza a partir daí. Esse recurso de aprendizado de poucos disparos ampliou a gama de aplicações para modelos de linguagem grandes, desde a escrita criativa até agentes de conversação.

DeepMind: Aprendizagem multitarefa na IA do setor de saúde

A DeepMind, líder em pesquisa de IA, utilizou o aprendizado multitarefa para desenvolver modelos de saúde que podem auxiliar no diagnóstico de várias condições a partir de imagens médicas. Por exemplo, seu sistema de IA para detectar doenças oculares a partir de exames de retina é capaz de diagnosticar uma série de condições, incluindo retinopatia diabética e degeneração macular relacionada à idade, usando um único modelo.

Essa abordagem MTL reduz a necessidade de modelos separados para cada condição, permitindo que os prestadores de serviços de saúde otimizem seus processos de diagnóstico e ofereçam um atendimento mais rápido e preciso aos pacientes.

Waymo: Adaptação de domínio na direção autônoma

O Waymo (projeto de carro autônomo do Google) usa técnicas de adaptação de domínio para melhorar a generalização de seus modelos de veículos autônomos em vários ambientes de direção. A empresa treina seus modelos em ambientes simulados e depois os adapta para implantação no mundo real em diferentes cidades e condições climáticas.

Esse processo garante que os carros autônomos possam lidar com as nuances de diferentes paisagens urbanas, desde as ruas congestionadas de São Francisco até as rodovias abertas do Arizona, sem a necessidade de um treinamento extensivo para cada local.

Tendências futuras no aprendizado avançado por transferência

Os pesquisadores estão constantemente ampliando os limites, esforçando-se para tornar os modelos mais adaptáveis, justos e capazes de lidar com tarefas complexas do mundo real e, ao mesmo tempo, reduzir a quantidade de dados e o tempo de treinamento necessários.

Aprendizado contínuo

A aprendizagem contínua ou aprendizagem ao longo da vida concentra-se no desenvolvimento de modelos que podem aprender continuamente com novos dados e, ao mesmo tempo, reter o conhecimento de tarefas aprendidas anteriormente. Em contraste com a aprendizagem por transferência tradicional, em que os modelos são estáticos após o ajuste fino, a aprendizagem contínua permite a adaptação contínua a novas informações.

Isso é vital para ambientes dinâmicos, como robótica e sistemas autônomos, em que novos cenários surgem regularmente. Nesse contexto, as estratégias baseadas na memória ajudam a equilibrar a necessidade de preservar o conhecimento anterior e, ao mesmo tempo, incorporar novas habilidades. Os desenvolvimentos futuros visam estender a aprendizagem contínua a domínios mais complexos, garantindo que os modelos possam ser atualizados com eficiência sem comprometer o desempenho anterior.

Equidade e mitigação de preconceitos

À medida que a aprendizagem por transferência se torna mais predominante em setores como saúde, finanças e aplicação da lei, é impossível ignorar a necessidade de abordar a justiça e o preconceito.

Os modelos pré-treinados em conjuntos de dados grandes e diversificados geralmente apresentam vieses inerentes, o que pode levar a resultados distorcidos em novos aplicativos. Para neutralizar isso, os pesquisadores estão explorando técnicas como a eliminação de vieses adversários, a reponderação e o aprendizado de representação justa para detectar e atenuar esses vieses.

Garantir a imparcialidade continuará sendo o foco central da pesquisa sobre aprendizagem por transferência, especialmente em domínios sensíveis em que as previsões tendenciosas podem ter implicações no mundo real.

Aprendizagem por transferência híbrida

A aprendizagem por transferência híbrida combina métodos supervisionados, não supervisionados e autossupervisionados para aproveitar os pontos fortes de cada um. Em geral, os modelos são pré-treinados usando abordagens não supervisionadas ou autossupervisionadas para aprender representações gerais e, em seguida, são ajustados com dados rotulados para tarefas específicas.

Essa estratégia híbrida aumenta a capacidade de transferência e reduz a dependência de grandes conjuntos de dados rotulados, o que a torna particularmente útil em campos com dados anotados limitados, como o diagnóstico de doenças raras ou aplicativos industriais especializados.

Aprendizagem por reforço na aprendizagem por transferência

A aprendizagem por transferência também está avançando na aprendizagem por reforço (RL)em que os agentes treinados em um ambiente são adaptados para uso em ambientes relacionados. Isso reduz o tempo e os dados necessários para que os agentes dominem novas tarefas, melhorando sua eficiência na solução de problemas complexos e de várias etapas.

Por exemplo, um agente de RL treinado para navegar em um tipo específico de sistema robótico pode aplicar seu conhecimento a uma configuração nova, mas semelhante, com o mínimo de retreinamento, aumentando significativamente a versatilidade e o dimensionamento dos sistemas de RL.

Conclusão

Neste artigo, exploramos técnicas avançadas de aprendizagem por transferência. Examinamos a adaptação do domínio para lidar com as diferenças de distribuição de dados, a aprendizagem multitarefa para usar o conhecimento compartilhado e a aprendizagem autossupervisionada e de poucos disparos para cenários com dados rotulados limitados.

Essas técnicas podem nos oferecer estratégias eficazes para enfrentar os desafios e melhorar o desempenho do modelo. Como a IA continua avançando, a familiaridade com essas técnicas será essencial para você se manter competitivo.