Cursus

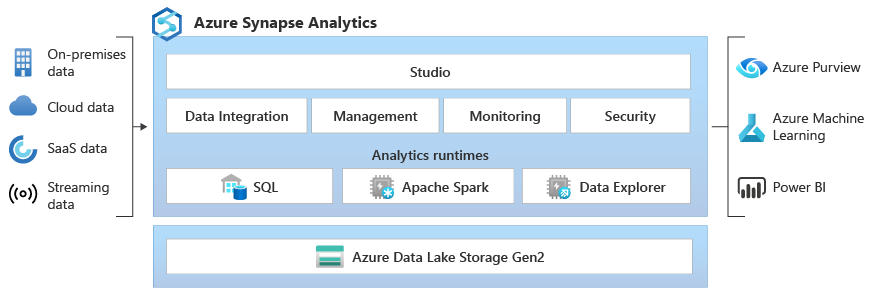

Microsoft Synapse Analytics, anciennement connu sous le nom d'Azure SQL Data Warehouse, est un service d'analyse intégré offrant une plateforme unifiée pour le big data et le stockage de données.

En combinant de manière transparente le stockage des données d'entreprise et l'analyse des mégadonnées, Synapse permet aux utilisateurs d'ingérer, de préparer, de gérer et de fournir des données pour répondre aux besoins immédiats en matière de veille économique et d'apprentissage automatique. Ce service performant prend en charge plusieurs langages tels que SQL, Python et Spark, offrant ainsi un large éventail de capacités de traitement et de transformation des données. De plus, son architecture sans serveur garantit une évolutivité permettant de traiter n'importe quel volume de données, ce qui en fait un outil indispensable pour les professionnels des données modernes.

Ce guide présente les thèmes et questions essentiels pour vous aider à préparer votre entretien Synapse. Ces questions reflètent ma propre expérience en matière d'entretiens et de collaboration avec des professionnels des données utilisant Synapse, et fournissent des informations précieuses sur ce que recherchent les responsables du recrutement.

En plus de suivre ce guide d'entretien, je vous recommande de consulter la documentation Microsoft Azure Synapse Analytics pour toute question spécifique que vous pourriez vous poser au cours du processus.

Questions d'entretien de base sur Synapse

Au niveau élémentaire, les questions porteront sur vos connaissances fondamentales de Synapse, notamment sur des tâches telles que la navigation dans Synapse Studio, la compréhension de ses composants principaux et la réalisation d'explorations de données simples. Attendez-vous à ces questions si vous avez une expérience limitée de Synapse ou si le recruteur évalue vos connaissances fondamentales.

Quels sont les principaux sujets que vous devriez connaître ?

Si l'on vous demande de présenter Synapse de manière générale, vous devriez être en mesure de décrire Synapse Analytics et son rôle dans un environnement de données moderne.

- Fonctionnalités principales et interface utilisateur: Comprenez le Synapse Studio, ses différents hubs (Données, Développement, Intégration, Surveillance, Gestion) et leurs fonctionnalités.

- Exemples d'utilisation simples: Veuillez fournir des exemples illustrant la manière dont les organisations utilisent Synapse, y compris des informations sur l'architecture de base.

Qu'est-ce que Microsoft Synapse Analytics et quelles sont ses principales fonctionnalités ?

Synapse Analytics est un service d'analyse illimité qui combine le stockage des données d'entreprise et l'analyse des mégadonnées. Les principales caractéristiques sont les suivantes :

- s sur le pool SQL (entrepôt de données): Moteur de requêtes distribué pour l'analyse haute performance de données structurées.

- s sur Spark Pool: Intégration avec Apache Spark pour le traitement des mégadonnées et l'apprentissage automatique.

- Assistance pour les lacs de données: Intégration native avec Azure Data Lake Storage Gen2 pour l'analyse des données sur place.

- Synapse Studio: Un espace de travail unifié pour la préparation des données, le stockage des données, l'analyse des mégadonnées et les tâches d'intelligence artificielle.

- s relatives à l'intégration des données: Fonctionnalités intégrées d'intégration des données avec Azure Data Factory.

Veuillez expliquer l'architecture principale de Synapse Analytics.

L'architecture principale comprend :

- Synapse Studio: Interface utilisateur centrale pour toutes les activités Synapse.

- s sur les pools SQL: Fournir des capacités de requête basées sur T-SQL pour les données structurées. Les pools SQL dédiés fournissent des ressources garanties, tandis que les pools SQL sans serveur permettent d'interroger les données du lac de données à la demande.

- Spark Pools: Fournir Apache Spark en tant que service pour le traitement des mégadonnées, l'ingénierie des données et les tâches d'apprentissage automatique.

- s sur le stockage de lacs de données: Azure Data Lake Storage Gen2 constitue la base pour le stockage de grands volumes de données structurées, semi-structurées et non structurées.

- s sur les pipelines: Pipelines d'intégration de données optimisés par Azure Data Factory pour les processus ETL/ELT.

Comment effectuer une requête de données dans Synapse Analytics ?

Vous pouvez interroger les données dans Synapse en utilisant :

- T-SQL: Utilisation du pool SQL pour les données structurées.

- s sur Spark SQL: Utilisation de Spark Pools pour les données dans le lac de données.

- s sur le pool SQL sans serveur: Interrogez directement les données dans le lac de données à l'aide de T-SQL sans provisionner de ressources.

Questions d'entretien intermédiaire chez Synapse

Ces questions évaluent votre compréhension approfondie de Synapse et de sa configuration. Vous devrez démontrer votre capacité à gérer les ressources, à mettre en œuvre des flux de travail pour le traitement des données et à optimiser les performances.

Ceci s'appuie sur vos connaissances de base et nécessite la compréhension des éléments suivants :

- s de gestion des ressources: Comment provisionner et gérer les pools SQL et les pools Spark.

- Intégration des données: Création et gestion de pipelines de données à l'aide de Synapse Pipelines (Azure Data Factory).

- Optimisation des performances: Comprendre les techniques d'optimisation des requêtes et les stratégies de partitionnement des données.

Comment créer et gérer des pools SQL dans Synapse Analytics ?

Pour créer un pool SQL, veuillez vous rendre dans Synapse Studio, sélectionner le hub « Manage » (Gérer), puis « SQL pools » (Pools SQL). Vous pouvez ensuite configurer le niveau de performance du pool (unités de stockage de données - DWU) en fonction de vos besoins en matière de charge de travail.

La gestion implique de surveiller les performances, d'ajuster les ressources et de suspendre/reprendre le pool selon les besoins.

Veuillez expliquer comment Spark est utilisé dans Synapse Analytics.

Synapse utilise Spark Pools pour fournir Apache Spark en tant que service. Cela vous permet de :

- Traitez de grands ensembles de données à l'aide de Spark DataFrames.

- Effectuer des tâches d'ingénierie des données à l'aide de langages tels que Python, Scala et Java.

- Construisez et formez des modèles d'apprentissage automatique à l'aide de Spark MLlib.

Que sont les pipelines de données et comment les créer dans Synapse ?

Les pipelines de données sont des flux de travail automatisés pour l'ingestion, la transformation et le chargement des données. Dans Synapse, vous les créez à l'aide du hub « Intégrer », qui fournit une interface visuelle (Azure Data Factory) pour concevoir et gérer les pipelines.

Ces pipelines peuvent se connecter à diverses sources de données, effectuer des transformations à l'aide d'activités telles que le flux de données ou l'exécution de procédures stockées, et charger les données dans les systèmes cibles.

Comment surveillez-vous et gérez-vous les ressources dans Synapse Analytics ?

Vous pouvez surveiller les ressources via le hub « Monitor » dans Synapse Studio. Ce hub fournit des informations sur les performances de SQL Pool et Spark Pool, les exécutions de pipelines et l'état général du système. Vous pouvez également utiliser Azure Monitor pour bénéficier de fonctionnalités de surveillance et d'alerte plus détaillées.

Veuillez décrire les options de stockage de données disponibles dans Synapse Analytics.

Synapse Analytics propose diverses options de stockage de données adaptées à différents besoins et scénarios, garantissant flexibilité et efficacité dans le traitement de divers ensembles de données. Ces options comprennent :

- s sur le stockage Azure Data Lake Gen2: Stockage principal pour le lac de données, optimisé pour l'analyse à grande échelle.

- s sur le stockage SQL pool: Stocke les données structurées dans l'entrepôt de données.

- s sur le stockage Blob Azure: Peut être utilisé pour le stockage de données, bien que Data Lake Storage Gen2 soit généralement préféré pour les charges de travail analytiques.

Questions d'entretien avancées sur Synapse

Les utilisateurs avancés sont censés gérer l'optimisation des performances, créer des flux de travail complexes et mettre en œuvre des modèles sophistiqués d'analyse et d'apprentissage automatique. Ces questions sont typiques des postes de haut niveau dans le domaine des données ou des rôles comportant une composante DevOps.

Ceci s'appuie sur des connaissances de base et intermédiaires, et nécessite une expérience pratique dans les domaines suivants :

- s d'optimisation des performances: Optimisation des configurations SQL Pool et Spark Pool, optimisation des requêtes et gestion du partitionnement des données.

- s sur l'apprentissage automatique: Intégration de Synapse à Azure Machine Learning, déploiement de modèles et gestion du cycle de vie des modèles.

- Pipelines CI/CD: Mise en œuvre de l'intégration continue et du déploiement continu pour les solutions Synapse.

Quelles stratégies utilisez-vous pour optimiser les performances dans Synapse ?

Indexation appropriée : Optimisez les performances du pool SQL en utilisant des index clusterisés de type columnstore et des index non clusterisés appropriés.

- s relatives au partitionnement des données: Veuillez partitionner les données dans les pools SQL et le stockage Data Lake en fonction des modèles de requête afin d'améliorer les performances.

- s sur l'optimisation des requêtes: Utilisez des conseils de requête, réécrivez les requêtes complexes et analysez les plans d'exécution des requêtes afin d'identifier les goulots d'étranglement.

- Allocation des ressources: Dimensionnez correctement les pools SQL et Spark en fonction des exigences de la charge de travail.

Comment mettre en œuvre des pipelines CI/CD pour Synapse Analytics ?

Veuillez utiliser Azure DevOps ou GitHub Actions pour automatiser la création, le test et le déploiement des solutions Synapse. Cela comprend :

- Contrôle des sources: Veuillez stocker les artefacts Synapse (scripts SQL, notebooks Spark, pipelines) dans un système de contrôle de version.

- s de test automatisé: Mettre en œuvre des tests unitaires et des tests d'intégration pour les scripts SQL et les pipelines de données.

- s de déploiement automatisé: Veuillez utiliser les modèles Azure Resource Manager (ARM) ou les API Synapse pour déployer les modifications dans différents environnements (développement, test, production).

Veuillez expliquer comment gérer des analyses complexes dans Synapse Analytics.

La gestion d'analyses complexes et la garantie d'opérations de données fluides au sein de Synapse Analytics nécessitent une approche multiforme. Cela implique des tests automatisés, des stratégies de déploiement et des techniques analytiques avancées.

Vous trouverez ci-dessous les méthodes essentielles pour atteindre efficacement ces objectifs :

- Requêtes SQL avancées: Utilisez les fonctions de fenêtre, les expressions de table commune (CTE) et d'autres fonctionnalités T-SQL avancées pour l'analyse de données complexes dans les pools SQL.

- Spark pour le traitement des mégadonnées: Utilisez Spark Pools pour traiter de grands ensembles de données, effectuer des transformations complexes et créer des modèles d'apprentissage automatique.

- Intégration avec Azure Machine Learning: Tirez parti d'Azure Machine Learning pour des scénarios d'analyse avancés, tels que la modélisation prédictive et la détection d'anomalies.

Comment déployez-vous les modèles d'apprentissage automatique dans Synapse Analytics ?

Le déploiement de modèles d'apprentissage automatique dans Synapse Analytics implique plusieurs étapes clés, depuis la formation et l'enregistrement des modèles jusqu'à leur déploiement pour une utilisation pratique. Voici une approche structurée pour déployer avec succès des modèles d'apprentissage automatique :

- Modèles de trains: Entraînez des modèles d'apprentissage automatique à l'aide de Spark MLlib dans Synapse ou Azure Machine Learning.

- Modèles enregistrés: Enregistrez les modèles formés dans le registre de modèles Azure Machine Learning.

- Déployer les modèles: Déployez des modèles en tant que points de terminaison REST à l'aide d'Azure Machine Learning ou intégrez-les dans des pipelines Synapse pour le scoring par lots.

Questions d'entretien Synapse pour les postes d'ingénieur de données

Les ingénieurs de données sont chargés de concevoir, de créer et de maintenir des pipelines de données, de garantir la qualité des données et d'optimiser les performances. Pour les postes d'ingénieur de données axés sur Synapse, il est important de comprendre :

- Architecture du pipeline de données: Concevez des pipelines de données évolutifs et fiables pour les processus ETL/ELT.

- s de traitement en temps réel: Mettez en œuvre l'ingestion et le traitement des données en temps réel à l'aide d'Azure Event Hubs, d'Azure Stream Analytics et de Synapse.

- s relatives à la sécurité des données: Mettre en œuvre des mesures de sécurité pour protéger les données au repos et en transit.

Comment concevez-vous des pipelines de données dans Synapse Analytics ?

Lors de la conception de pipelines de données dans Synapse Analytics, plusieurs éléments clés doivent être pris en compte afin de garantir un traitement efficace et fiable des données :

- Veuillez identifier les sources des données: Déterminez les sources de données (par exemple, bases de données, API, fichiers) et leurs méthodes d'ingestion.

- Concevoir des processus ETL/ELT: Veuillez créer des pipelines de données à l'aide de Synapse Pipelines (Azure Data Factory) pour extraire, transformer et charger les données.

- Veuillez mettre en œuvre des contrôles de qualité des données.: Veuillez ajouter des étapes de validation des données et de gestion des erreurs afin de garantir la qualité des données.

- Automatiser l'exécution des pipelines: Planifiez l'exécution automatique des pipelines à l'aide de déclencheurs et d'une exécution basée sur un calendrier.

Quelles sont les meilleures pratiques pour les processus ETL dans Synapse Analytics ?

Dans le contexte de Synapse Analytics, la mise en œuvre de processus ETL (Extract, Transform, Load) efficaces est essentielle pour garantir une gestion et une analyse efficaces des données. Les meilleures pratiques suivantes sont recommandées pour optimiser les processus ETL dans Synapse Analytics :

- Veuillez utiliser Delta Lake: Veuillez utiliser Delta Lake pour stocker les données dans le lac de données afin de permettre les transactions ACID et le versionnage des données.

- modulaires de code: Écrivez du code modulaire et réutilisable dans les notebooks Synapse et les scripts SQL.

- Paramétrage de l': Paramétrer les pipelines et les scripts SQL afin de les rendre plus flexibles et réutilisables.

- de surveillance: Surveillez les exécutions et les performances des pipelines à l'aide de Synapse Studio et Azure Monitor.

Comment gérez-vous le traitement des données en temps réel dans Synapse ?

En tant qu'ingénieur de données, on est confronté à de nombreux défis qui nécessitent des solutions innovantes et des méthodologies robustes. Travailler avec des données en temps réel et les gérer en fait partie. Voici quelques expériences et techniques couramment utilisées :

- Intégrer l'des données en temps réel: Veuillez utiliser Azure Event Hubs ou Azure IoT Hub pour ingérer des flux de données en temps réel.

- Traiter les données à l'aide de l'analyse de flux: Veuillez utiliser Azure Stream Analytics pour effectuer des transformations et des agrégations en temps réel.

- Veuillez charger les données dans Synapse: Veuillez charger les données traitées dans des pools SQL ou dans le stockage Data Lake pour une analyse en temps réel.

Comment garantissez-vous la sécurité des données dans Synapse Analytics ?

Il est essentiel de garantir la sécurité des données dans Synapse Analytics afin de protéger les informations sensibles et de maintenir la conformité aux normes réglementaires. Plusieurs stratégies clés peuvent être mises en œuvre pour protéger les données dans l'environnement Synapse :

- s relatives au contrôle d'accès: Mettre en œuvre le contrôle d'accès basé sur les rôles (RBAC) pour gérer l'accès aux ressources Synapse.

- Chiffrementdes données : Activez le chiffrement au repos et en transit à l'aide d'Azure Key Vault.

- Sécuritédes réseaux : Utilisez l'intégration du réseau virtuel (VNet) et les points de terminaison privés pour sécuriser l'accès au réseau.

- Audit de l': Activez l'audit pour suivre l'activité des utilisateurs et l'accès aux données.

- s sur le masquage des données: Mettez en place un masquage des données afin de protéger les informations sensibles.

Conclusions finales

Ce guide vous a fourni des informations clés pour aborder en toute confiance votre entretien chez Microsoft Synapse Analytics, que vous soyez ingénieur de données ou ingénieur logiciel.

N'oubliez pas de mettre en avant non seulement vos connaissances théoriques, mais également votre expérience pratique dans la conception de pipelines de données, l'optimisation des performances et la garantie d'une sécurité des données robuste.

Au-delà des aspects techniques, veuillez mettre en avant vos compétences en matière de résolution de problèmes et votre capacité à apprendre en permanence, car Synapse Analytics est une plateforme en constante évolution. Restez curieux, continuez à explorer les ressources Microsoft et démontrez votre passion pour l'exploitation des données afin d'obtenir des résultats commerciaux significatifs. Je vous souhaite bonne chance.

Obtenez la certification Azure AZ-900

Lead BI Consultant - Power BI Certified | Azure Certified | ex-Microsoft | ex-Tableau | ex-Salesforce - Auteur

Questions fréquentes concernant les entretiens Azure Synapse

Quelle est la meilleure façon de se préparer à un entretien pour un poste chez Microsoft Synapse Analytics ?

La manière la plus efficace de se préparer est d'acquérir une expérience pratique. Collaborez avec Synapse Studio, créez des pools SQL et Spark, construisez des pipelines de données et explorez l'intégration avec Azure Data Lake Storage. Microsoft Learn propose d'excellents parcours d'apprentissage et tutoriels. De plus, il est important de comprendre les concepts courants liés au stockage des données et au big data.

Dans quelle mesure est-il important de maîtriser à la fois SQL et Spark pour un poste chez Synapse Analytics ?

L'importance dépend du rôle spécifique. Les ingénieurs de données doivent souvent posséder de solides compétences en SQL et Spark pour le traitement et la transformation des données. Les scientifiques des données pourraient se concentrer davantage sur Spark pour les tâches d'apprentissage automatique. Cependant, une compréhension générale des deux est utile, car Synapse intègre les deux moteurs de manière transparente.

Quelles sont les principales différences entre les pools SQL dédiés et les pools SQL sans serveur dans Synapse Analytics, et dans quels cas est-il préférable d'utiliser l'un ou l'autre ?

Les pools SQL dédiés fournissent des ressources provisionnées pour des performances constantes et conviennent aux charges de travail dont les modèles d'utilisation sont prévisibles.

Les pools SQL sans serveur permettent d'interroger à la demande les données du lac de données sans provisionner de ressources, ce qui les rend idéaux pour l'analyse et l'exploration ad hoc.

Veuillez utiliser les pools SQL dédiés pour le stockage des données de production et les pools SQL sans serveur pour la recherche et l'analyse rapides des données.

J'ai de l'expérience avec Azure Data Factory. Quelle partie de ces connaissances peut être transférée à Synapse Pipelines ?

Une grande partie de vos connaissances est transférable. Les pipelines Synapse sont construits sur la même base qu'Azure Data Factory, partageant la même interface visuelle et la même bibliothèque d'activités. La compréhension des concepts d'intégration de données, de conception de pipelines et de configuration d'activités accélérera considérablement votre apprentissage de Synapse Pipelines.

Quelles questions puis-je m'attendre à recevoir concernant la sécurité et la gouvernance des données dans Synapse Analytics ?

Préparez-vous à répondre à des questions sur la mise en œuvre du contrôle d'accès basé sur les rôles (RBAC), le chiffrement des données au repos et en transit, l'utilisation d'Azure Key Vault pour la gestion des secrets, la configuration de la sécurité réseau avec des réseaux virtuels et des points de terminaison privés, ainsi que la mise en œuvre du masquage des données pour protéger les informations sensibles. Il sera essentiel de démontrer votre compréhension de ces mesures de sécurité.