Programa

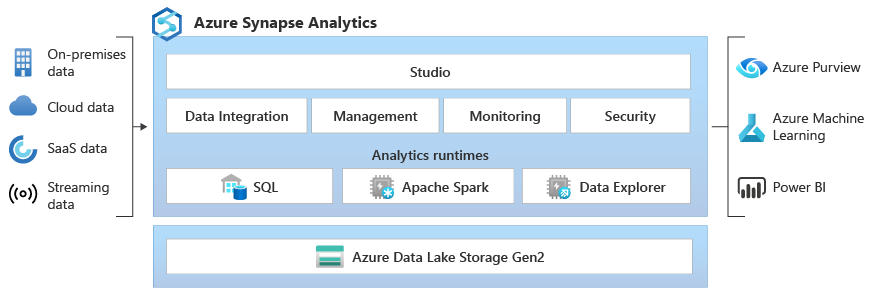

O Microsoft Synapse Analytics, que antes era chamado de Azure SQL Data Warehouse, é um serviço de análise integrado que oferece uma plataforma unificada para big data e warehouse.

Ao combinar perfeitamente o warehouse de dados empresariais e a análise de big data, o Synapse permite que os usuários coletem, preparem, gerenciem e forneçam dados para necessidades imediatas de inteligência de negócios e machine learning. Esse serviço incrível dá suporte a várias linguagens, como SQL, Python e Spark, permitindo um monte de recursos de processamento e transformação de dados. Além disso, sua arquitetura sem servidor garante escalabilidade para lidar com qualquer volume de dados, tornando-a uma ferramenta indispensável para os profissionais de dados modernos.

Este guia traz tópicos e perguntas essenciais para te ajudar a se preparar para a entrevista da Synapse. Essas perguntas refletem minha própria experiência entrevistando e trabalhando com profissionais de dados que usam o Synapse, oferecendo uma visão valiosa sobre o que os gerentes de contratação procuram.

Além de ler este guia de entrevista, sugiro que você dê uma olhada na documentação do Microsoft Azure Synapse Analytics para esclarecer dúvidas específicas que possam surgir ao longo do caminho.

Perguntas básicas para entrevistas na Synapse

No nível básico, as perguntas vão cobrir o seu conhecimento básico do Synapse, incluindo tarefas como navegar no Synapse Studio, entender seus componentes principais e fazer uma exploração simples de dados. Espere essas perguntas se você tiver pouca experiência com o Synapse ou se o entrevistador estiver avaliando seus conhecimentos básicos.

Quais são os principais assuntos que você precisa conhecer?

Se te pedirem pra dar uma visão geral do Synapse, você deve saber descrever o Synapse Analytics e o papel dele no cenário moderno de dados.

- Principais recursos e interface do usuário: Entenda o Synapse Studio, seus diferentes hubs (Dados, Desenvolvimento, Integração, Monitoramento, Gerenciamento) e suas funcionalidades.

- Casos de uso simples: Mostre exemplos de como as organizações usam o Synapse, incluindo informações básicas sobre a arquitetura.

O que é o Microsoft Synapse Analytics e quais são suas principais funcionalidades?

O Synapse Analytics é um serviço de análise sem limites que junta warehouse de dados empresariais e análise de big data. As principais características incluem:

- Pool SQL (Data Warehouse): Um mecanismo de consulta distribuído para análises de alto desempenho em dados estruturados.

- Spark Pool: Integração com o Apache Spark para processamento de big data e machine learning.

- Suporte para Data Lake: Integração nativa com o Azure Data Lake Storage Gen2 para analisar dados no local.

- Synapse Studio: Um espaço de trabalho unificado para preparação de dados, warehouse, análise de big data e tarefas de IA.

- Integração de dados: Recursos integrados de integração de dados com o Azure Data Factory.

Explique a arquitetura central do Synapse Analytics.

A arquitetura principal inclui:

- Synapse Studio: A interface central para todas as atividades do Synapse.

- Pools SQL: Oferece recursos de consulta baseados em T-SQL para dados estruturados. Os pools SQL dedicados oferecem recursos garantidos, enquanto os pools SQL sem servidor permitem consultar dados no data lake quando você precisar.

- Spark Pools: Ofereça o Apache Spark como um serviço para processamento de big data, engenharia de dados e tarefas de machine learning.

- Armazenamento em Data Lake: O Azure Data Lake Storage Gen2 é a base para guardar grandes quantidades de dados estruturados, semiestruturados e não estruturados.

- Pipelines: Pipelines de integração de dados com o Azure Data Factory para processos ETL/ELT.

Como você consulta dados no Synapse Analytics?

Você pode consultar dados no Synapse usando:

- T-SQL: Usando o SQL Pool para dados estruturados.

- Spark SQL: Usando Spark Pools para dados no data lake.

- Pool SQL sem servidor: Consulte dados diretamente no data lake usando T-SQL sem precisar provisionar recursos.

Perguntas da entrevista intermediária da Synapse

Essas perguntas avaliam o seu entendimento mais profundo do Synapse e sua configuração. Você vai precisar mostrar que sabe lidar com recursos, implementar fluxos de trabalho de processamento de dados e otimizar o desempenho.

Isso se baseia no seu conhecimento básico e precisa que você entenda:

- Gestão de recursos: Como provisionar e gerenciar pools SQL e pools Spark.

- Integração de dados: Criando e gerenciando pipelines de dados usando o Synapse Pipelines (Azure Data Factory).

- Ajuste de desempenho: Entendendo as técnicas de otimização de consultas e as estratégias de particionamento de dados.

Como criar e gerenciar pools SQL no Synapse Analytics?

Para criar um pool SQL, vá até o Synapse Studio, selecione o hub “Gerenciar” e, em seguida, “Pools SQL”. Você pode então configurar o nível de desempenho do pool (Unidades de Data Warehouse - DWUs) com base nos requisitos da sua carga de trabalho.

Gerenciar envolve monitorar o desempenho, dimensionar recursos e pausar/retomar o pool conforme necessário.

Explique como o Spark é usado no Synapse Analytics.

A Synapse usa o Spark Pools para oferecer o Apache Spark como um serviço. Isso permite que você:

- Processe grandes conjuntos de dados usando Spark DataFrame.

- Fazer tarefas de engenharia de dados usando linguagens como Python, Scala e Java.

- Crie e treine modelos de machine learning usando o Spark MLlib.

O que são pipelines de dados e como você os cria no Synapse?

Os pipelines de dados são fluxos de trabalho automatizados para ingestão, transformação e carregamento de dados. No Synapse, você cria usando o hub “Integrar”, que oferece uma interface visual (Azure Data Factory) para projetar e gerenciar pipelines.

Esses pipelines podem se conectar a várias fontes de dados, fazer transformações usando atividades como fluxo de dados ou execução de procedimentos armazenados e carregar dados nos sistemas de destino.

Como você monitora e gerencia recursos no Synapse Analytics?

Você pode monitorar os recursos pelo hub “Monitor” no Synapse Studio. Esse hub dá uma visão geral do desempenho do SQL Pool e do Spark Pool, das execuções do pipeline e da saúde geral do sistema. Você também pode usar o Azure Monitor para obter recursos mais detalhados de monitoramento e alerta.

Descreva as opções de armazenamento de dados disponíveis no Synapse Analytics.

A Synapse Analytics oferece várias opções de armazenamento de dados para atender a diferentes necessidades e cenários, garantindo flexibilidade e eficiência no manuseio de diversos conjuntos de dados. Essas opções incluem:

- Armazenamento em data lake do Azure Gen2: Armazenamento primário para o data lake, otimizado para análises em grande escala.

- e de armazenamento em pool SQL: Armazena dados estruturados no data warehouse.

- Armazenamento de blobs do Azure: Pode ser usado para armazenar dados, embora o Data Lake Storage Gen2 seja geralmente preferido para cargas de trabalho de análise.

Perguntas avançadas para entrevistas sobre sinapses

Espera-se que usuários avançados cuidem da otimização do desempenho, criem fluxos de trabalho complexos e implementem análises sofisticadas e modelos de machine learning. Essas questões são típicas para cargos ou funções sênior na área de dados com um componente DevOps.

Isso se baseia em conhecimentos básicos e intermediários, exigindo experiência prática em:

- Otimização de desempenho: Ajustando as configurações do SQL Pool e do Spark Pool, otimizando consultas e gerenciando o particionamento de dados.

- machine learning: Integrando o Synapse com o Azure Machine Learning, colocando modelos em prática e cuidando do ciclo de vida deles.

- Pipelines de CI/CD: Implementando integração contínua e implantação contínua para as soluções Synapse.

Que estratégias você usa para otimizar o desempenho no Synapse?

Indexação correta: Otimize o desempenho do SQL Pool usando índices de armazenamento em coluna agrupados e índices não agrupados apropriados.

- Particionamento de dados: Divida os dados em SQL Pools e Data Lake Storage com base nos padrões de consulta para melhorar o desempenho.

- Otimização de consultas: Use dicas de consulta, reescreva consultas complexas e analise planos de execução de consultas para identificar gargalos.

- Alocação de recursos: Dimensionar corretamente os pools SQL e Spark com base nos requisitos de carga de trabalho.

Como você pode implementar pipelines de CI/CD para o Synapse Analytics?

Use o Azure DevOps ou o GitHub Actions para automatizar a compilação, o teste e a implantação de soluções Synapse. Isso inclui:

- Controle de código-fonte: Guarde os artefatos do Synapse (scripts SQL, notebooks Spark, pipelines) num sistema de controle de versão.

- Teste automatizado: Implementar testes unitários e testes de integração para scripts SQL e pipelines de dados.

- Implantação automatizada: Use modelos do Azure Resource Manager (ARM) ou APIs do Synapse para implementar alterações em diferentes ambientes (desenvolvimento, teste, produção).

Explique como lidar com análises complexas no Synapse Analytics?

Lidar com análises complexas e garantir operações de dados sem problemas no Synapse Analytics exige uma abordagem multifacetada. Isso envolve testes automatizados, estratégias de implantação e técnicas analíticas avançadas.

Abaixo, você vai encontrar métodos essenciais para atingir esses objetivos de forma eficaz:

- Consultas SQL avançadas: Use funções de janela, expressões de tabela comuns (CTEs) e outros recursos avançados do T-SQL para fazer análises complexas de dados em SQL Pools.

- Spark para o processamento de Big Data: Use o Spark Pools pra processar grandes conjuntos de dados, fazer transformações complexas e criar modelos de machine learning.

- Integração com o Azure Machine Learning: Use o Azure Machine Learning para cenários de análise avançada, como modelagem preditiva e detecção de anomalias.

Como você implementa modelos de machine learning no Synapse Analytics?

Implantar modelos de machine learning no Synapse Analytics envolve várias etapas importantes, desde treinar e registrar os modelos até colocá-los em prática. Aqui está uma abordagem estruturada para implementar com sucesso modelos de machine learning:

- Modelos de trens: Treine modelos de machine learning usando o Spark MLlib no Synapse ou no Azure Machine Learning.

- Registre os modelos: Registre modelos treinados no Registro de Modelos do Azure Machine Learning.

- Implemente modelos: Implemente modelos como pontos finais REST usando o Azure Machine Learning ou integre-os aos pipelines do Synapse para pontuação em lote.

Perguntas da entrevista da Synapse para cargos de engenheiro de dados

Os engenheiros de dados são responsáveis por projetar, construir e manter pipelines de dados, garantir a qualidade dos dados e otimizar o desempenho. Para cargos de engenheiro de dados com foco em Synapse, você deve entender:

- Arquitetura do pipeline de dados: Crie pipelines de dados escaláveis e confiáveis para processos ETL/ELT.

- Processamento em tempo real: Faça a ingestão e o processamento de dados em tempo real usando o Azure Event Hubs, o Azure Stream Analytics e o Synapse.

- Segurança de dados: Implemente medidas de segurança para proteger os dados em repouso e em trânsito.

Como você cria pipelines de dados no Synapse Analytics?

Ao projetar pipelines de dados no Synapse Analytics, é preciso pensar em vários componentes importantes para garantir um processamento de dados eficiente e confiável:

- Identifique as fontes de dados: Decida quais fontes de dados (por exemplo, bancos de dados, APIs, arquivos) e como você vai pegar esses dados.

- Processo de ETL/ELT de design: Crie pipelines de dados usando o Synapse Pipelines (Azure Data Factory) para extrair, transformar e carregar dados.

- Implementar verificações de qualidade dos dados: Adicione etapas de validação de dados e tratamento de erros para garantir a qualidade dos dados.

- Automatizar a execução do pipeline: Programe pipelines para rodarem automaticamente usando gatilhos e execução baseada em programação.

Quais são as melhores práticas para processos ETL no Synapse Analytics?

No contexto da Synapse Analytics, implementar processos ETL (Extract, Transform, Load) eficazes é essencial para garantir uma gestão e análise de dados eficientes. As seguintes práticas recomendadas são sugeridas para otimizar os processos ETL no Synapse Analytics:

- Use o delta lake: Use o Delta Lake para guardar dados no data lake e poder fazer transações ACID e controlar as versões dos dados.

- Código modular: Escreva código modular e reutilizável em cadernos Synapse e scripts SQL.

- Parametrização: Parametrizar pipelines e scripts SQL para torná-los mais flexíveis e reutilizáveis.

- Monitoramento: Monitore as execuções e o desempenho do pipeline usando o Synapse Studio e o Azure Monitor.

Como você lida com o processamento de dados em tempo real no Synapse?

Como engenheiro de dados, a gente enfrenta vários desafios que pedem soluções inovadoras e metodologias robustas. Trabalhar e lidar com dados em tempo real é uma delas. Aqui estão algumas experiências e técnicas que a galera costuma usar:

- Ingestão de dados em tempo real: Use o Azure Event Hubs ou o Azure IoT Hub para pegar fluxos de dados em tempo real.

- Processe dados com análise de fluxo: Use o Azure Stream Analytics para fazer transformações e agregações em tempo real.

- Carregue os dados no Synapse: Carregue os dados processados em SQL Pools ou Data Lake Storage para análises em tempo real.

Como você garante a segurança dos dados no Synapse Analytics?

Garantir a segurança dos dados no Synapse Analytics é super importante pra proteger informações confidenciais e manter a conformidade com as normas regulatórias. Várias estratégias importantes podem ser implementadas para proteger os dados no ambiente Synapse:

- : Use o controle de acesso baseado em função (RBAC) para gerenciar o acesso aos recursos do Synapse.

- Criptografiade dados : Habilite a criptografia em repouso e em trânsito usando o Azure Key Vault.

- Segurançade rede : Use a integração da rede virtual (VNet) e pontos de extremidade privados para proteger o acesso à rede.

- Auditoria: Ative a auditoria para acompanhar a atividade do usuário e o acesso aos dados.

- Mascaramento de dados: Use o mascaramento de dados para proteger os dados confidenciais.

Considerações finais

Este guia te deu as dicas essenciais para encarar com confiança sua entrevista para a Microsoft Synapse Analytics, seja você engenheiro de dados ou engenheiro de software.

Lembre-se de mostrar não só o seu conhecimento teórico, mas também a sua experiência prática em projetar pipelines de dados, otimizar o desempenho e garantir uma segurança de dados robusta.

Além dos aspectos técnicos, destaque suas habilidades de resolução de problemas e capacidade de aprender continuamente, já que o Synapse Analytics é uma plataforma que está sempre mudando. Mantenha a curiosidade, continue explorando os recursos da Microsoft e mostre sua paixão por usar dados para gerar resultados comerciais impactantes. Boa sorte!

Obter a certificação Azure AZ-900

Consultor líder de BI - Certificado em Power BI | Certificado em Azure | ex-Microsoft | ex-Tableau | ex-Salesforce - Autor

Perguntas frequentes sobre entrevistas do Azure Synapse

Qual é a melhor maneira de se preparar para uma entrevista sobre o Microsoft Synapse Analytics?

A melhor maneira de se preparar é através da experiência prática. Trabalhe com o Synapse Studio, crie SQL e Spark Pools, construa pipelines de dados e explore a integração com o Azure Data Lake Storage. O Microsoft Learn oferece excelentes trilhas de aprendizagem e tutoriais. Além disso, entenda os conceitos comuns de warehouse de dados e big data.

É importante saber tanto SQL quanto Spark pra trabalhar com o Synapse Analytics?

A importância depende da função específica. Os engenheiros de dados geralmente precisam de habilidades sólidas em SQL e Spark para processamento e transformação de dados. Os cientistas de dados podem se concentrar mais no Spark para tarefas de machine learning. Mas, é legal entender os dois, porque o Synapse junta os dois motores de forma bem integrada.

Quais são as principais diferenças entre pools SQL dedicados e pools SQL sem servidor no Synapse Analytics, e quando eu usaria cada um deles?

Os pools SQL dedicados oferecem recursos provisionados para um desempenho consistente e são ideais para cargas de trabalho com padrões de uso previsíveis.

Os pools SQL sem servidor oferecem consultas sob demanda de dados no data lake sem precisar provisionar recursos, o que os torna perfeitos para análises e explorações ad hoc.

Use pools SQL dedicados para warehouse de dados de produção e pools SQL sem servidor para descoberta e análise rápida de dados.

Tenho experiência com o Azure Data Factory. Quanto desse conhecimento pode ser transferido para o Synapse Pipelines?

Uma boa parte do que você sabe pode ser passada para os outros. Os Synapse Pipelines são construídos com a mesma base do Azure Data Factory, compartilhando a mesma interface visual e biblioteca de atividades. Entender os conceitos de integração de dados, design de pipeline e configuração de atividades vai acelerar bastante sua curva de aprendizado com o Synapse Pipelines.

Que tipo de perguntas posso esperar sobre segurança e governança de dados no Synapse Analytics?

Espere perguntas sobre como implementar o controle de acesso baseado em função (RBAC), criptografar dados em repouso e em trânsito, usar o Azure Key Vault para gerenciar segredos, configurar a segurança de rede com redes virtuais e pontos de extremidade privados e implementar o mascaramento de dados para proteger informações confidenciais. Mostrar que você entende essas medidas de segurança vai ser super importante.