Lernpfad

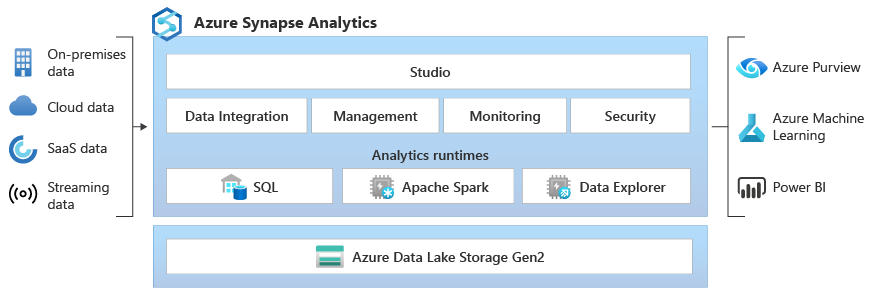

Microsoft Synapse Analytics, früher bekannt als Azure SQL Data Warehouse, ist ein integrierter Analysedienst, der eine einheitliche Plattform für Big Data und Data Warehousing bietet.

Durch die nahtlose Verbindung von Unternehmensdatenbanken und Big-Data-Analysen können Nutzer mit Synapse Daten sammeln, aufbereiten, verwalten und bereitstellen, um sofortige Business-Intelligence- und Machine-Learning-Anforderungen zu erfüllen. Dieser leistungsstarke Dienst unterstützt mehrere Sprachen wie SQL, Python und Spark und bietet so eine breite Palette an Datenverarbeitungs- und -transformationsfunktionen. Außerdem sorgt die serverlose Architektur dafür, dass es mit jedem Datenvolumen klarkommt, was es zu einem unverzichtbaren Tool für moderne Datenexperten macht.

Dieser Leitfaden enthält wichtige Themen und Fragen, die dir bei der Vorbereitung auf dein Synapse-Vorstellungsgespräch helfen sollen. Diese Fragen zeigen meine eigenen Erfahrungen aus Interviews und der Zusammenarbeit mit Datenprofis, die Synapse nutzen, und geben einen guten Einblick in das, worauf Personalverantwortliche achten.

Ich schlage vor, dass du neben der Arbeit mit diesem Interviewleitfaden auch mal in der Microsoft Azure Synapse Analytics-Dokumentation stöberst, falls du unterwegs Fragen hast.

Grundlegende Fragen für Vorstellungsgespräche bei Synapse

Auf der Grundstufe geht's um dein Basiswissen über Synapse, zum Beispiel wie man sich im Synapse Studio zurechtfindet, was die wichtigsten Teile sind und wie man einfache Datenauswertungen macht. Rechne mit diesen Fragen, wenn du nur wenig Erfahrung mit Synapse hast oder wenn der Interviewer dein grundlegendes Verständnis checken will.

Was sind die wichtigsten Themen, mit denen du dich auskennen solltest?

Wenn du gebeten wirst, einen Überblick über Synapse zu geben, solltest du Synapse Analytics und seine Rolle in einer modernen Datenlandschaft beschreiben können.

- Hauptfunktionen und Benutzeroberfläche: Mach dich mit Synapse Studio, seinen verschiedenen Hubs (Daten, Entwicklung, Integration, Überwachung, Verwaltung) und deren Funktionen vertraut.

- Einfache Anwendungsfälle: Zeig uns Beispiele, wie Unternehmen Synapse nutzen, und gib uns einen Einblick in die grundlegende Architektur.

Was ist Microsoft Synapse Analytics und was sind seine wichtigsten Funktionen?

Synapse Analytics ist ein super vielseitiger Analysedienst, der Unternehmensdatenlagerung und Big-Data-Analysen zusammenbringt. Die wichtigsten Funktionen sind:

- SQL-Pool (Data Warehouse): Eine verteilte Abfrage-Engine für schnelle Analysen von strukturierten Daten.

- Spark Pool-: Integration mit Apache Spark für die Verarbeitung von Big Data und maschinelles Lernen.

- Support für Data Lake: Native Integration mit Azure Data Lake Storage Gen2, um Daten direkt vor Ort zu analysieren.

- Synapse Studio: Ein einheitlicher Arbeitsbereich für Datenaufbereitung, Data Warehousing, Big-Data-Analysen und KI-Aufgaben.

- Datenintegration: Integrierte Datenintegrationsfunktionen mit Azure Data Factory.

Erkläre die Kernarchitektur von Synapse Analytics.

Die Kernarchitektur umfasst:

- Synapse Studio: Die zentrale Benutzeroberfläche für alle Synapse-Aktivitäten.

- SQL-Pools: Biete T-SQL-basierte Abfragefunktionen für strukturierte Daten an. Dedizierte SQL-Pools bieten garantierte Ressourcen, während serverlose SQL-Pools die Abfrage von Daten im Data Lake nach Bedarf ermöglichen.

- Spark Pools: Biete Apache Spark als Service für die Verarbeitung von Big Data, Data Engineering und Machine-Learning-Aufgaben an.

- en zu Data Lake Storage: Azure Data Lake Storage Gen2 ist die Basis für die Speicherung von großen Mengen strukturierter, halbstrukturierter und unstrukturierter Daten.

- Pipelines: Datenintegrations-Pipelines mit Azure Data Factory für ETL-/ELT-Prozesse.

Wie fragt man Daten in Synapse Analytics ab?

Du kannst Daten in Synapse mit folgendem Befehl abfragen:

- T-SQL: Den SQL-Pool für strukturierte Daten nutzen.

- Spark SQL: Spark Pools für Daten im Data Lake nutzen.

- Serverloser SQL-Pool-: Frag Daten direkt im Data Lake mit T-SQL ab, ohne Ressourcen bereitstellen zu müssen.

Fragen für Vorstellungsgespräche für Fortgeschrittene bei Synapse

Diese Fragen zeigen, wie gut du Synapse und seine Konfiguration verstehst. Du musst zeigen, dass du Ressourcen verwalten, Datenverarbeitungsabläufe umsetzen und die Leistung optimieren kannst.

Das baut auf deinen Grundkenntnissen auf und du solltest Folgendes verstehen:

- Ressourcenmanagement-: Wie man SQL-Pools und Spark-Pools bereitstellt und verwaltet.

- Datenintegrations: Erstellen und Verwalten von Datenpipelines mit Synapse Pipelines (Azure Data Factory).

- Leistungsoptimierung: Verstehe, wie man Abfragen optimiert und Daten aufteilt.

Wie erstellt und verwaltet man SQL-Pools in Synapse Analytics?

Um einen SQL-Pool zu erstellen, gehst du zu Synapse Studio, wählst den Hub „Verwalten” und dann „SQL-Pools”. Du kannst dann die Leistungsstufe des Pools (Data Warehouse Units – DWUs) nach deinen Anforderungen an die Arbeitslast einstellen.

Verwalten heißt, die Leistung im Auge zu behalten, Ressourcen anzupassen und den Pool bei Bedarf anzuhalten oder wieder zu starten.

Erklär mal, wie Spark in Synapse Analytics genutzt wird.

Synapse nutzt Spark Pools, um Apache Spark als Dienst anzubieten. Damit kannst du:

- Verarbeite große Datensätze mit Spark DataFrames.

- Mach Data-Engineering-Aufgaben mit Sprachen wie Python, Scala und Java.

- Mach dir mit Spark MLlib die Erstellung und das Training von Machine-Learning-Modellen klar.

Was sind Datenpipelines und wie macht man sie in Synapse?

Datenpipelines sind automatisierte Abläufe für die Erfassung, Umwandlung und das Laden von Daten. In Synapse machst du das über den Hub „Integrate“, der eine visuelle Oberfläche (Azure Data Factory) zum Entwerfen und Verwalten von Pipelines bietet.

Diese Pipelines können mit verschiedenen Datenquellen verbunden werden, Transformationen mithilfe von Aktivitäten wie Datenfluss oder der Ausführung gespeicherter Prozeduren durchführen und Daten in Zielsysteme laden.

Wie checkst und verwaltest du Ressourcen in Synapse Analytics?

Du kannst Ressourcen über den Hub „Monitor“ in Synapse Studio überwachen. Dieser Hub gibt dir einen Einblick in die Leistung von SQL Pool und Spark Pool, die Ausführung von Pipelines und den allgemeinen Systemzustand. Du kannst auch Azure Monitor für detailliertere Überwachungs- und Warnfunktionen nutzen.

Beschreib mal die Datenspeicheroptionen, die es in Synapse Analytics gibt.

Synapse Analytics hat verschiedene Optionen für die Datenspeicherung, die zu unterschiedlichen Bedürfnissen und Situationen passen. So ist alles flexibel und effizient, wenn es um verschiedene Datensätze geht. Zu diesen Optionen gehören:

- Azure Data Lake Storage Gen2-: Primärspeicher für den Data Lake, der für große Analysen optimiert ist.

- SQL-Pool-Speicher: Speichert strukturierte Daten im Data Warehouse.

- Azure Blob Storage-: Kann zum Speichern von Daten genutzt werden, obwohl Data Lake Storage Gen2 für Analyse-Workloads meistens besser ist.

Fragen für Vorstellungsgespräche bei Advanced Synapse

Von fortgeschrittenen Benutzern wird erwartet, dass sie die Leistungsoptimierung übernehmen, komplexe Arbeitsabläufe erstellen und anspruchsvolle Analyse- und Machine-Learning-Modelle umsetzen. Diese Fragen sind typisch für leitende Positionen im Datenbereich oder Jobs mit DevOps-Aufgaben.

Das baut auf Grund- und Mittelstufenkennis auf und braucht praktische Erfahrung in:

- Leistungsoptimierung: Anpassen der SQL-Pool- und Spark-Pool-Einstellungen, Optimieren von Abfragen und Verwalten der Datenpartitionierung.

- Machine-Learning-: Synapse mit Azure Machine Learning verbinden, Modelle einrichten und den Modelllebenszyklus verwalten.

- CI/CD-Pipelines: Einfach mal Continuous Integration und Continuous Deployment für Synapse-Lösungen einrichten.

Welche Strategien nutzt du, um die Leistung in Synapse zu verbessern?

Richtige Indizierung: Mach die SQL-Pool-Leistung besser, indem du Clustered-Columnstore-Indizes und passende Non-Clustered-Indizes benutzt.

- Datenpartitionierungs: Teile Daten in SQL-Pools und Data Lake Storage nach Abfragemustern auf, um die Leistung zu verbessern.

- Abfrageoptimierungs: Nutze Abfragehinweise, schreib komplexe Abfragen um und schau dir die Ausführungspläne von Abfragen an, um Engpässe zu finden.

- Ressourcenverteilungs: SQL-Pools und Spark-Pools entsprechend den Anforderungen der Arbeitslast richtig dimensionieren.

Wie kannst du CI/CD-Pipelines für Synapse Analytics einrichten?

Nutze Azure DevOps oder GitHub Actions, um das Erstellen, Testen und Bereitstellen von Synapse-Lösungen zu automatisieren. Das umfasst:

- Quellcodeverwaltung: Speichere Synapse-Artefakte (SQL-Skripte, Spark-Notebooks, Pipelines) in einem Versionskontrollsystem.

- Automatisierte Test: Mach Unit-Tests und Integrationstests für SQL-Skripte und Datenpipelines.

- Automatisierte Bereitstellungs: Benutze Azure Resource Manager (ARM)-Vorlagen oder Synapse-APIs, um Änderungen in verschiedenen Umgebungen (Entwicklung, Test, Produktion) zu machen.

Erklär mal, wie man komplexe Analysen in Synapse Analytics macht.

Um komplexe Analysen zu machen und einen reibungslosen Datenbetrieb in Synapse Analytics zu haben, braucht man einen vielseitigen Ansatz. Dazu gehören automatisierte Tests, Bereitstellungsstrategien und fortgeschrittene Analysetechniken.

Hier findest du wichtige Methoden, um diese Ziele effektiv zu erreichen:

- Erweiterte SQL-Abfragen: Nutze Fensterfunktionen, Common Table Expressions (CTEs) und andere fortgeschrittene T-SQL-Features für komplexe Datenanalysen in SQL Pools.

- Spark für die Verarbeitung von Big Data: Nutze Spark Pools, um große Datensätze zu verarbeiten, komplizierte Transformationen durchzuführen und Machine-Learning-Modelle zu erstellen.

- Integration mit Azure Machine Learning: Nutze Azure Machine Learning für anspruchsvolle Analyseszenarien wie Vorhersagemodelle und Anomalieerkennung.

Wie setzt man Machine-Learning-Modelle in Synapse Analytics ein?

Das Einrichten von Machine-Learning-Modellen in Synapse Analytics hat ein paar wichtige Schritte, vom Trainieren und Registrieren der Modelle bis hin zu ihrer Einrichtung für den praktischen Einsatz. Hier ist ein strukturierter Ansatz für die erfolgreiche Implementierung von Machine-Learning-Modellen:

- Modelleisenbahnen: Mach dir Machine-Learning-Modelle mit Spark MLlib in Synapse oder Azure Machine Learning.

- Registriere Modelle: Registriere trainierte Modelle in der Azure Machine Learning-Modellregistrierung.

- Modelle bereitstellen: Modelle als REST-Endpunkte mit Azure Machine Learning bereitstellen oder für die Batch-Bewertung in Synapse-Pipelines einbauen.

Synapse-Interviewfragen für Stellen als Dateningenieur

Dateningenieure kümmern sich darum, Datenpipelines zu entwerfen, aufzubauen und zu pflegen, die Datenqualität sicherzustellen und die Leistung zu optimieren. Für Stellen als Dateningenieur mit Schwerpunkt auf Synapse solltest du Folgendes verstehen:

- Datenpipeline-Architektur: Entwickle skalierbare und zuverlässige Datenpipelines für ETL-/ELT-Prozesse.

- Echtzeit-Verarbeitungs: Mach Echtzeit-Datenerfassung und -verarbeitung mit Azure Event Hubs, Azure Stream Analytics und Synapse.

- Datenschutz: Mach Sicherheitsmaßnahmen, um Daten zu schützen, egal ob sie gespeichert sind oder übertragen werden.

Wie machst du Datenpipelines in Synapse Analytics?

Beim Entwerfen von Datenpipelines in Synapse Analytics musst du ein paar wichtige Sachen beachten, damit die Daten effizient und zuverlässig verarbeitet werden:

- Identifiziere die Datenquellen: Entscheide, woher die Daten kommen sollen (z. B. Datenbanken, APIs, Dateien) und wie sie reingeholt werden.

- Entwerfen von ETL-/ELT-Prozessen: Mach Datenpipelines mit Synapse Pipelines (Azure Data Factory), um Daten zu extrahieren, zu transformieren und zu laden.

- Mach Datenqualitätsprüfungen: Füge Schritte zur Datenüberprüfung und Fehlerbehandlung hinzu, um die Datenqualität sicherzustellen.

- Pipeline-Ausführung automatisieren: Pipelines automatisch mit Triggern und zeitgesteuerter Ausführung laufen lassen.

Was sind die besten Vorgehensweisen für ETL-Prozesse in Synapse Analytics?

Bei Synapse Analytics ist es echt wichtig, gute ETL-Prozesse (Extrahieren, Transformieren, Laden) einzurichten, um Datenmanagement und -analyse effizient zu machen. Die folgenden bewährten Methoden sind empfehlenswert, um ETL-Prozesse in Synapse Analytics zu optimieren:

- Delta Lake verwenden: Benutz Delta Lake, um Daten im Data Lake zu speichern, damit ACID-Transaktionen und Datenversionierung möglich sind.

- Modulares Code-: Schreib modularen und wiederverwendbaren Code in Synapse-Notebooks und SQL-Skripten.

- Parameterisierung: Parametrisier Pipelines und SQL-Skripte, damit sie flexibler und wiederverwendbar sind.

- Überwachungs: Überwache die Ausführung und Leistung von Pipelines mit Synapse Studio und Azure Monitor.

Wie geht man bei Synapse mit der Echtzeit-Datenverarbeitung um?

Als Dateningenieur hat man mit vielen Herausforderungen zu tun, die coole Lösungen und starke Methoden brauchen. Eins davon ist die Arbeit mit und der Umgang mit Echtzeitdaten. Hier sind ein paar Erfahrungen und Techniken, die oft benutzt werden:

- Echtzeit-Daten: Nutze Azure Event Hubs oder Azure IoT Hub, um Echtzeit-Datenströme zu erfassen.

- Verarbeitest Daten mit Stream-Analytics-: Nutze Azure Stream Analytics, um Echtzeit-Transformationen und -Aggregationen durchzuführen.

- Lade die Daten in Synapse: Lade die verarbeiteten Daten in SQL-Pools oder Data Lake Storage, um sie in Echtzeit zu analysieren.

Wie stellst du die Datensicherheit in Synapse Analytics sicher?

Die Datensicherheit in Synapse Analytics ist super wichtig, um sensible Infos zu schützen und die gesetzlichen Standards einzuhalten. Es gibt ein paar wichtige Strategien, die man anwenden kann, um Daten in der Synapse-Umgebung zu schützen:

- Zugangskontroll: Setze rollenbasierte Zugriffskontrolle (RBAC) ein, um den Zugriff auf Synapse-Ressourcen zu verwalten.

- Daten verschlüsselung: Aktiviere die Verschlüsselung im Ruhezustand und während der Übertragung mit Azure Key Vault.

- Netzwerk- -Sicherheit: Nutze die Integration von virtuellen Netzwerken (VNet) und private Endpunkte, um den Netzwerkzugang sicher zu machen.

- Prüfung von: Aktiviere die Überwachung, um die Aktivitäten der Benutzer und den Datenzugriff zu verfolgen.

- Datenmaskierungs: Mach Datenmaskierung, um sensible Daten zu schützen.

Abschließende Gedanken

Dieser Leitfaden hat dir wichtige Infos gegeben, damit du dein Vorstellungsgespräch bei Microsoft Synapse Analytics locker meistern kannst, egal ob du Dateningenieur oder Softwareentwickler bist.

Denk dran, nicht nur dein theoretisches Wissen zu zeigen, sondern auch deine praktische Erfahrung beim Entwerfen von Datenpipelines, beim Optimieren der Leistung und beim Sicherstellen einer robusten Datensicherheit.

Zeig nicht nur deine technischen Fähigkeiten, sondern auch, dass du Probleme lösen kannst und immer dazulernst, weil Synapse Analytics eine Plattform ist, die sich schnell weiterentwickelt. Bleib neugierig, schau dir weiter die Ressourcen von Microsoft an und zeig, wie sehr du dich dafür begeisterst, Daten zu nutzen, um beeindruckende Geschäftsergebnisse zu erzielen. Viel Glück!

Werde Azure AZ-900 zertifiziert

Lead BI Consultant - Power BI Certified | Azure Certified | ex-Microsoft | ex-Tableau | ex-Salesforce - Autor

Häufig gestellte Fragen zu Azure Synapse-Interviews

Wie kann man sich am besten auf ein Vorstellungsgespräch bei Microsoft Synapse Analytics vorbereiten?

Der beste Weg, sich vorzubereiten, ist einfach praktische Erfahrung. Arbeite mit Synapse Studio, erstelle SQL- und Spark-Pools, baue Datenpipelines auf und schau dir die Integration mit Azure Data Lake Storage an. Microsoft Learn hat echt coole Lernpfade und Tutorials. Außerdem solltest du die gängigen Konzepte von Data Warehousing und Big Data verstehen.

Wie wichtig ist es, für einen Job bei Synapse Analytics sowohl SQL als auch Spark zu beherrschen?

Die Wichtigkeit hängt von der jeweiligen Aufgabe ab. Dateningenieure brauchen oft gute Kenntnisse in SQL und Spark, um Daten zu verarbeiten und umzuwandeln. Datenwissenschaftler könnten sich bei Machine-Learning-Aufgaben mehr auf Spark konzentrieren. Ein allgemeines Verständnis von beiden ist aber hilfreich, weil Synapse beide Engines nahtlos zusammenbringt.

Was sind die wichtigsten Unterschiede zwischen dedizierten SQL-Pools und serverlosen SQL-Pools in Synapse Analytics und wann sollte ich welche nutzen?

Dedizierte SQL-Pools bieten bereitgestellte Ressourcen für eine gleichbleibende Leistung und eignen sich für Workloads mit vorhersehbaren Nutzungsmustern.

Serverlose SQL-Pools machen es möglich, Daten im Data Lake nach Bedarf abzufragen, ohne dass man dafür Ressourcen bereitstellen muss. Das macht sie super für Ad-hoc-Analysen und Erkundungen.

Nutze dedizierte SQL-Pools für die Datenlagerung in der Produktion und serverlose SQL-Pools für die schnelle Datenermittlung und -analyse.

Ich habe Erfahrung mit Azure Data Factory. Wie viel von diesem Wissen kann man auf Synapse Pipelines übertragen?

Ein großer Teil deines Wissens ist übertragbar. Synapse Pipelines basieren auf derselben Grundlage wie Azure Data Factory und haben die gleiche visuelle Oberfläche und Aktivitätsbibliothek. Wenn du die Konzepte der Datenintegration, des Pipeline-Designs und der Aktivitätskonfiguration verstehst, wirst du Synapse Pipelines viel schneller lernen.

Welche Fragen kann ich zu Datensicherheit und Governance in Synapse Analytics erwarten?

Rechne mit Fragen zur Implementierung der rollenbasierten Zugriffskontrolle (RBAC), zur Verschlüsselung von gespeicherten und übertragenen Daten, zur Verwendung von Azure Key Vault für die Verwaltung von Geheimnissen, zur Konfiguration der Netzwerksicherheit mit virtuellen Netzwerken und privaten Endpunkten sowie zur Implementierung von Datenmaskierung zum Schutz sensibler Informationen. Es ist echt wichtig, dass du zeigst, dass du diese Sicherheitsmaßnahmen verstehst.