Les futures mises à jour pourraient inclure des temps de réponse plus rapides, la navigation sur le web et le traitement des fichiers.

Alors que nous attendions tous le GPT-5OpenAI a surpris tout le monde l'été dernier avec la sortie du modèle o1-preview. Aujourd'hui, ils viennent d'annoncer que l 'o1 est entièrement disponible et n'est plus en mode preview.

Par rapport à la version préliminaire, o1 peut prendre en charge des entrées multimodales, comprend les images et est beaucoup plus rapide pour les requêtes simples. Auparavant, il fallait plus de dix secondes pour répondre à l'invite "Bonjour".

OpenAI a également introduit le mode o1 pro, qui est légèrement plus puissant et plus fiable que o1. Bien que nous ayons brièvement abordé le mode o1 pro dans cet article, nous l'explorons plus en détail dans cet autre article : Qu'est-ce que le mode O1 Pro d'OpenAI ? Caractéristiques, ChatGPT Pro & Plus.

OpenAI a remis le compteur à 1 et l'a baptisé OpenAI o1, soulignant ainsi l'accent mis sur le raisonnement par rapport à la lignée traditionnelle du GPT traditionnelle. Ceci marque le début d'une nouvelle série OpenAI o, similaire à la série GPT que nous connaissons tous.

Les modèles O1 ne sont pas conçus pour remplacer le GPT-4o dans tous les cas. Pour les applications nécessitant des temps de réponse rapides ou constants, les modèles GPT-4o et GPT-4o mini restent le choix optimal.

Lisez la suite pour en savoir plus sur les nouveaux modèles O1 !

Développer des applications d'IA

Apprenez à créer des applications d'IA à l'aide de l'API OpenAI.

Comment fonctionne OpenAI o1

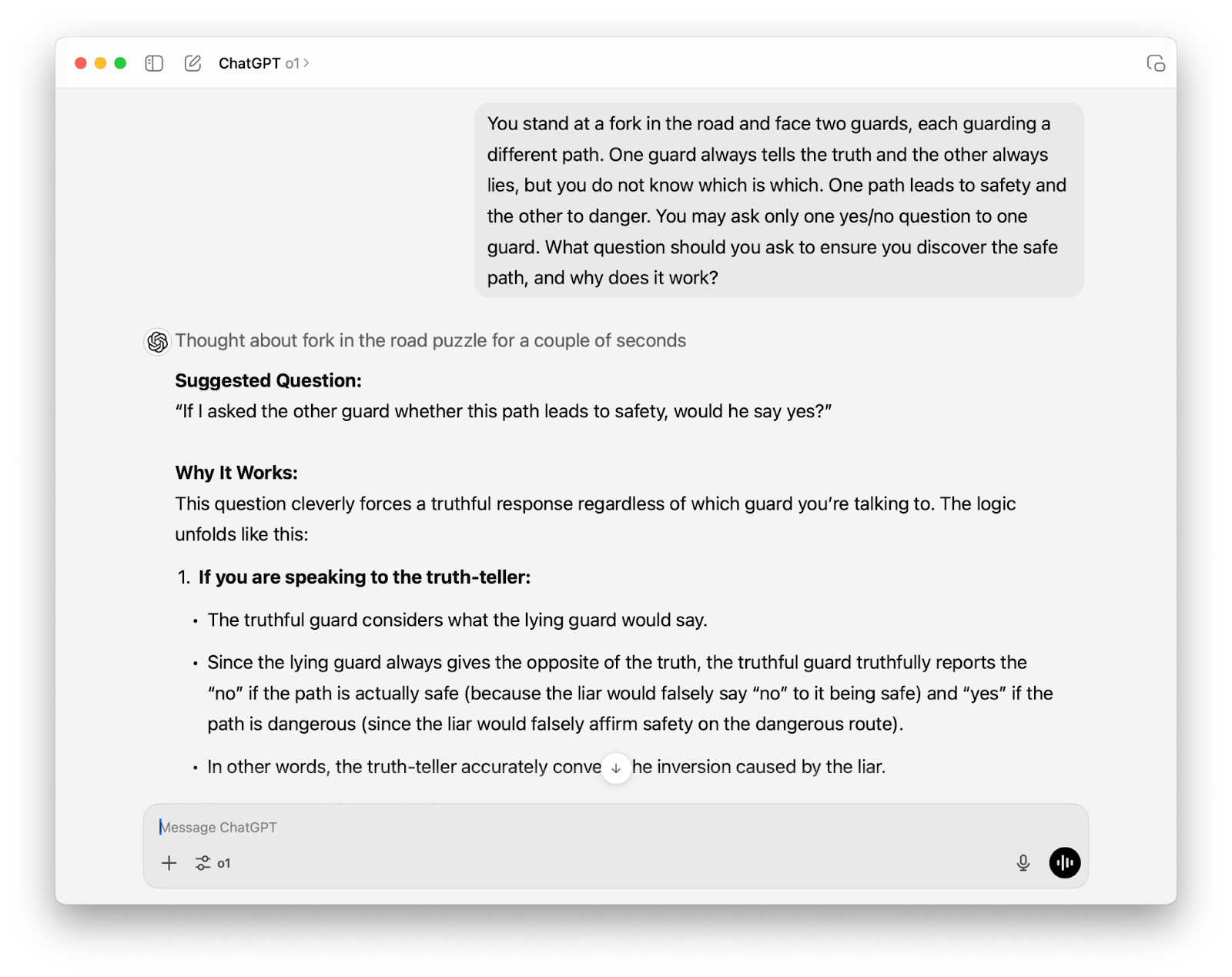

La première chose que vous remarquerez lorsque vous interagirez avec o1 est qu'il prend sensiblement plus de temps à générer des réponses que GPT-4o. Cette pause délibérée reflète l'accent mis par le modèle sur le raisonnement. O1 passe plus de temps à "réfléchir" avant de répondre, ce qui lui permet de s'attaquer à des tâches complexes et de résoudre des problèmes plus difficiles en logique, en mathématiques, en codage et en sciences.

OpenAI o1-preview s'attaque à un problème de logique

Apprentissage par renforcement et chaîne de pensée

La supériorité du raisonnement de O1 est due à une combinaison d'apprentissage par renforcement et de raisonnement par chaîne de pensée.

Grâce à apprentissage par renforcementle modèle apprend à affiner son processus de réflexion, en explorant différentes stratégies, en reconnaissant ses erreurs et en adaptant son approche pour parvenir à la solution la plus précise et la plus logique.

De l'autre côté, le raisonnement en chaîne est une technique qui permet de décomposer des problèmes complexes en éléments plus petits et plus faciles à gérer. Cette approche permet à o1 de "réfléchir avant de répondre", un peu comme si l'on planifiait méticuleusement les étapes d'une recette complexe avant de commencer à cuisiner.

En exposant explicitement son processus de raisonnement, o1 peut identifier rapidement les erreurs potentielles et augmenter la probabilité d'arriver à la bonne solution, tout comme nous, les humains, sommes moins susceptibles de faire des erreurs lorsque nous exposons soigneusement notre processus de pensée.

Le fait que l'OpenAI o1 utilise le raisonnement en chaîne le rend particulièrement efficace dans des domaines tels que les mathématiques, les sciences et le codage, où l'obtention d'une réponse correcte nécessite souvent plusieurs étapes.

Un nouveau paradigme dans l'allocation des ressources informatiques

L'un des principaux facteurs de différenciation de l'OpenAI o1 réside dans la réaffectation stratégique des ressources informatiques. Alors que les LLM traditionnels se sont principalement concentrés sur des ensembles massifs de données de préformation, o1 met l'accent sur les phases de formation et d'inférence.

Cette évolution montre que l'augmentation de la capacité de calcul à ces stades peut entraîner des gains significatifs en termes de capacités de raisonnement complexe.

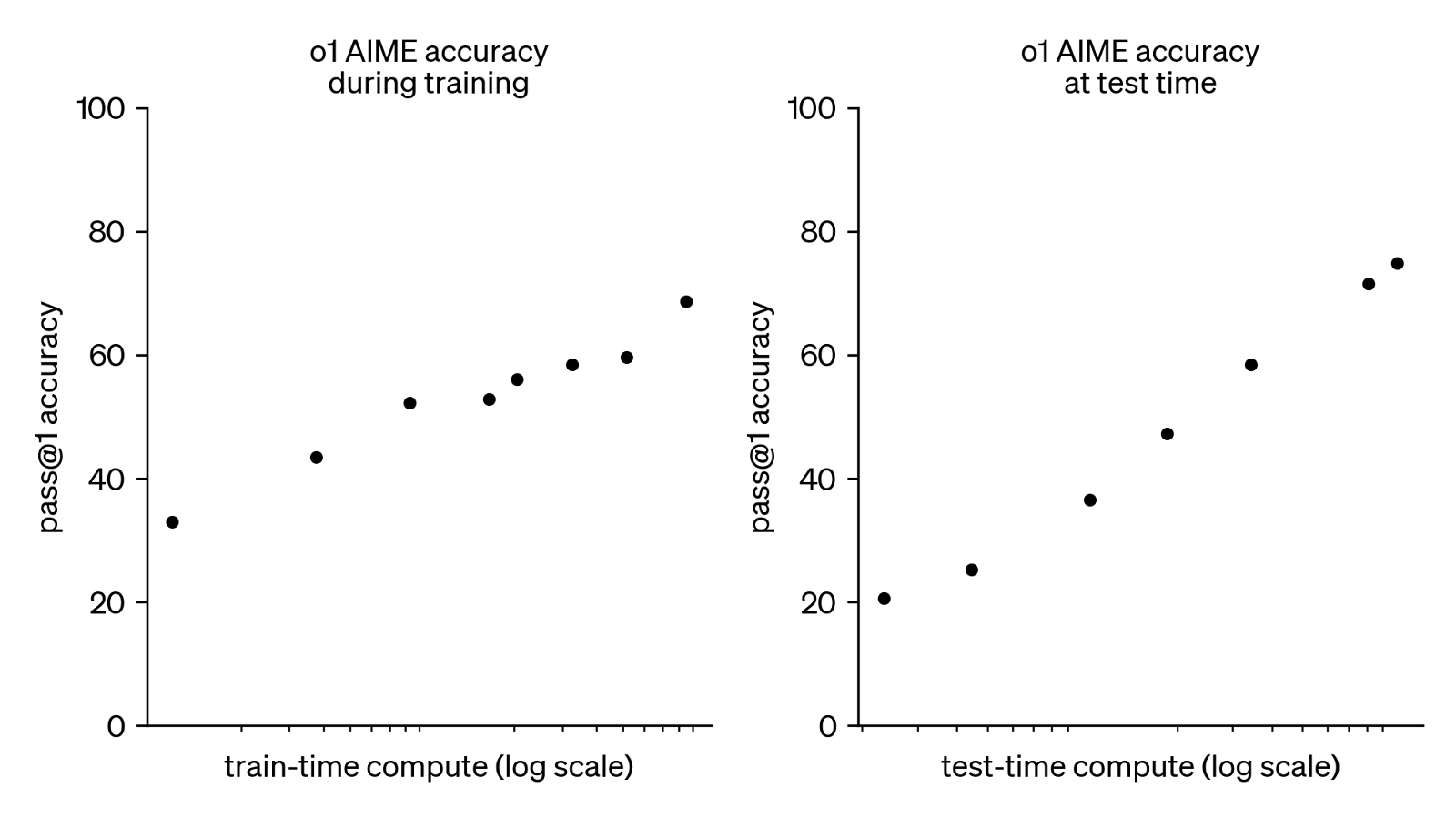

Source : OpenAI

Le graphique ci-dessus montre l'impact de l'augmentation des ressources informatiques sur les performances du modèle o1 d'OpenAI lors de l'examen AIME (American Invitational Mathematics Examination). Il comporte deux graphiques, chacun représentant la précision du modèle par rapport à la puissance de calcul consacrée à l'entraînement ou au test (inférence).

Une corrélation positive est évidente dans les deux graphiques : plus les ressources informatiques augmentent, plus la précision du modèle à résoudre les problèmes AIME du premier coup augmente. Notamment, la relation est plus prononcée dans le graphique du temps de test, ce qui suggère que le fait de donner au modèle plus de temps pour "réfléchir" pendant la résolution du problème permet d'améliorer les performances de manière significative.

Cette observation souligne la nature intensive en calcul de o1, mettant en évidence sa dépendance à l'égard de ressources informatiques substantielles. Cependant, les tendances à la hausse dans les deux graphiques impliquent également que des gains de précision supplémentaires sont possibles avec encore plus de calcul, ce qui offre des pistes prometteuses pour le développement futur des capacités de raisonnement de l'IA.

Benchmarks OpenAI O1 : Meilleur dans les tâches de raisonnement lourd

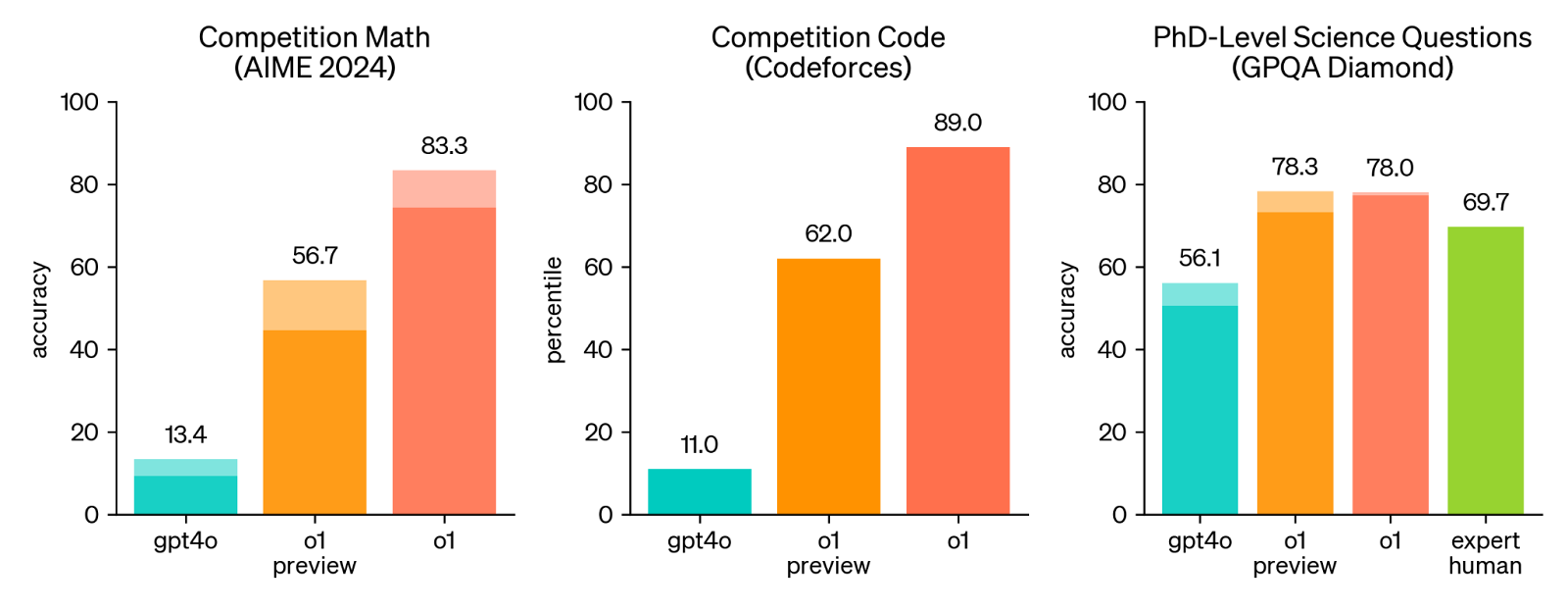

Pour démontrer les capacités de raisonnement améliorées d'o1 par rapport à GPT-4o, OpenAI a évalué le modèle sur une série de critères mathématiques, scientifiques et de codage difficiles.

Examens humains

L'examen humain montre que o1 est toujours plus performant que GPT-4o et o1-preview.

Les barres pleines indiquent la précision "pass@1" et la région ombrée montre la performance du vote majoritaire (consensus) avec 64 échantillons. Source : OpenAI

L'observation la plus frappante est sans doute le bond en avant des performances entre GPT-4o et o1 (et même o-1 preview) sur les benchmarks mathématiques et de codage.

Bien que l'amélioration dans le domaine scientifique soit moins prononcée, il convient de noter que le modèle o1-preview et le modèle o1 entièrement optimisé sont plus performants que les experts humains pour les questions scientifiques de niveau doctoral. Cela montre le potentiel de l'o1 à s'attaquer à des problèmes complexes du monde réel et même à surpasser les performances humaines dans certains domaines.

L'OpenAI o1 a des applications potentielles en génétique.

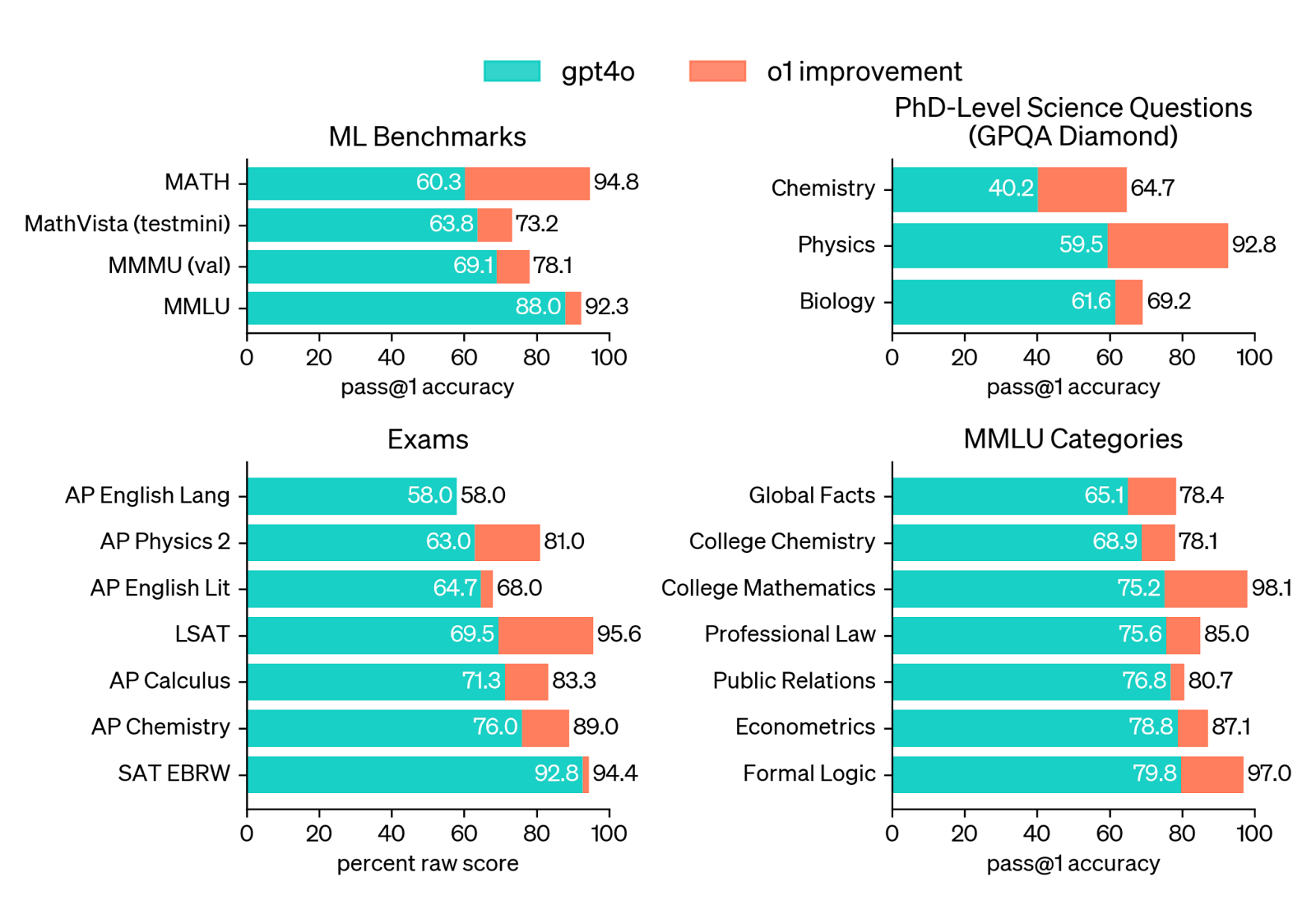

Points de repère ML

Si l'on examine les résultats des benchmarks ML, les progrès d'o1 en matière de raisonnement sont assez évidents. Sur MathVista (un benchmark mathématique) et MMLU, o1 affiche des gains substantiels en termes de précision par rapport à GPT-4o.

Source : OpenAI

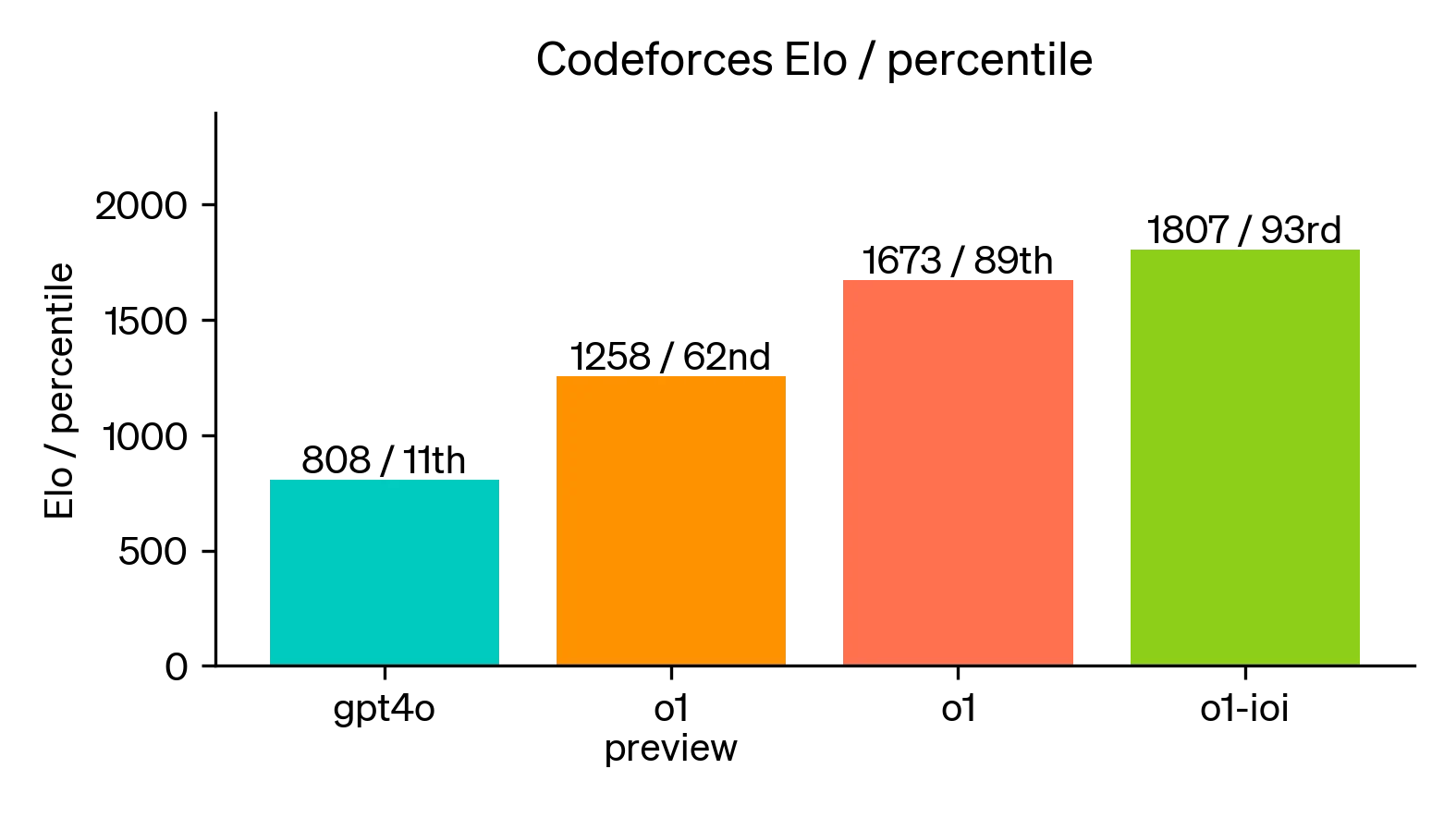

Une version spécialisée d'o1, connue sous le nom d'o1-ioi, a démontré des capacités de codage supérieures en obtenant un classement de 49e centile aux Olympiades internationales d'informatique de 2024, même dans des conditions de compétition très strictes.

Lors de concours simulés (voir le graphique ci-dessous), les performances d'o1-ioi ont été encore plus élevées, dépassant 93 % des concurrents.

Source : OpenAI

Cas d'utilisation de l'OpenAI o1

Les capacités de raisonnement de l'OpenAI o1 la rendent particulièrement apte à résoudre des problèmes complexes dans les domaines de la science, du codage et des mathématiques.

Recherche scientifique

Les chercheurs en santé, par exemple, pourraient utiliser o1 pour annoter des données complexes de séquençage cellulaire, tandis que les physiciens pourraient l'utiliser pour générer les formules mathématiques sophistiquées nécessaires à la recherche sur l'optique quantique.

Physique quantique et OpenAI o1

Codage

En suggérant des optimisations de code et en générant des cas de test, en automatisant les révisions de code et en facilitant le partage des connaissances, o1 a le potentiel d'améliorer de manière significative la productivité des développeurs et de simplifier les flux de travail.

En outre, la capacité d'o1 à comprendre et à générer du code étend son utilité au-delà du simple codage. Il peut contribuer à la planification du projet, à l'analyse des besoins et à la conception de l'architecture logicielle, en aidant les développeurs à élaborer des solutions plus efficaces.

Bien que toutes les capacités d'o1 soient encore en cours de développement, ses caractéristiques actuelles sont déjà prometteuses. Alors que l'OpenAI continue d'affiner le modèle, o1 est susceptible de devenir un outil précieux pour les développeurs, favorisant l'innovation et influençant l'avenir du développement de logiciels.

Comme nous l'avons décrit dans la section sur les critères de référence, le modèle o1 présente un grand potentiel dans le domaine du codage.

HTML Snake avec OpenAI o1

Mathématiques

Le domaine des mathématiques pourrait également bénéficier des capacités de raisonnement avancées d'o1. Ses excellentes performances sur des benchmarks comme AIME suggèrent des applications potentielles dans la résolution d'équations complexes, la démonstration de théorèmes et l'exploration de nouveaux concepts mathématiques, ce qui profitera tant aux étudiants qu'aux chercheurs.

Les mathématiques avec OpenAI o1

Cas d'utilisation à forte intensité de raisonnement

Au-delà des domaines spécifiques, l'accent mis par o1 sur le raisonnement pourrait en faire un atout précieux pour toute tâche nécessitant une réflexion critique et une déduction logique. Qu'il s'agisse de résoudre des énigmes, d'analyser des arguments complexes ou de faciliter la prise de décision en connaissance de cause, o1 pourrait ouvrir de nouvelles voies en matière de résolution de problèmes.

Écrire des puzzles avec OpenAI o1

Comment accéder à l'OpenAI o1

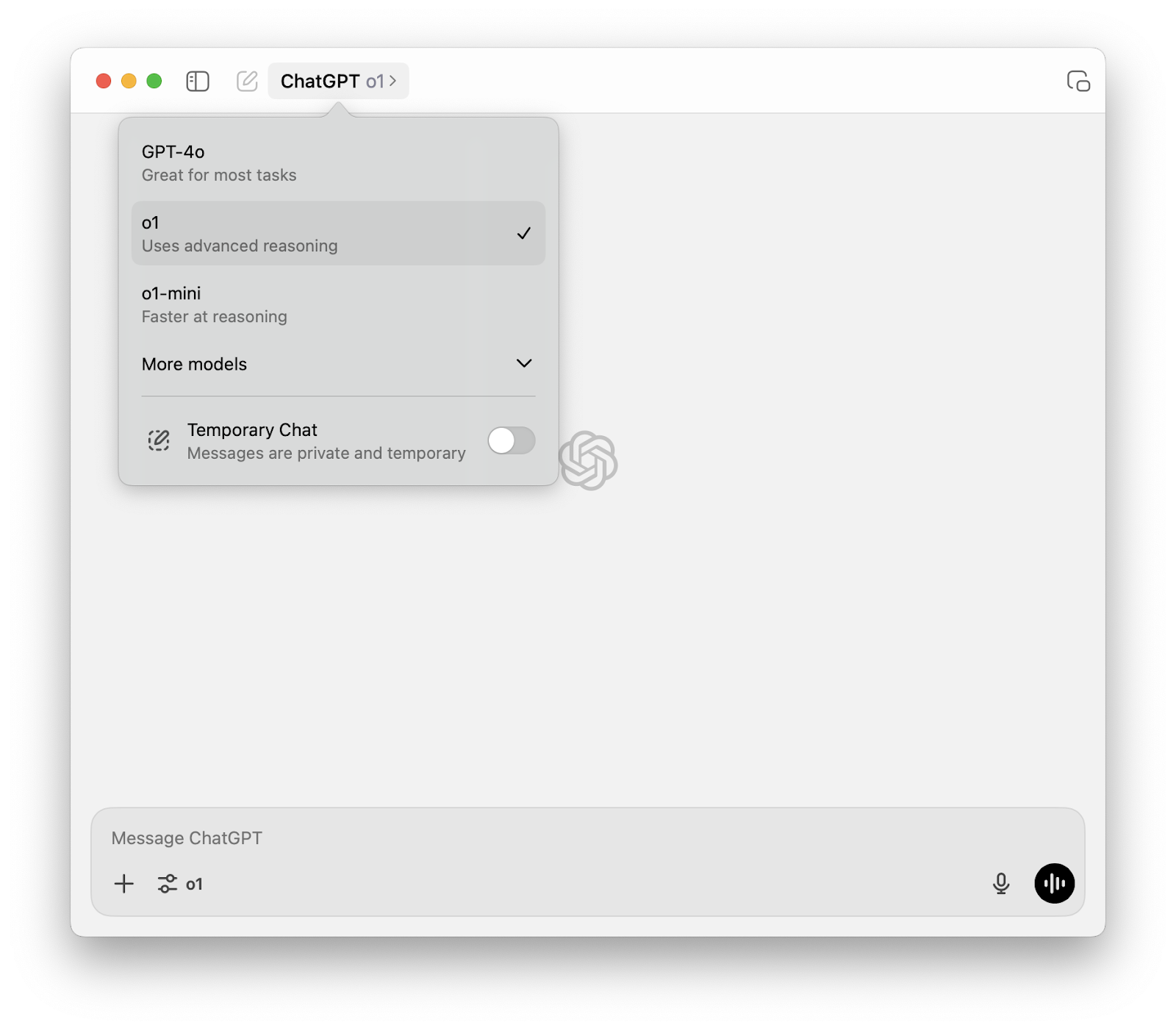

Si vous disposez d'un abonnement ChatGPT Plus ou ChatGPT Team, vous pouvez accéder au modèle o1 directement dans l'interface ChatGPT. Sélectionnez o1 dans le menu déroulant du sélecteur de modèle en haut de la page .

Gardez à l'esprit qu'avec un compte ChatGPT Plus ou Team, vous recevez 50 messages par semaine avec OpenAI o1 et 50 messages par jour avec OpenAI o1-mini pour commencer.

OpenAI o1 API

Bien que o1 soit accessible au sein de ChatGPT pour les abonnés Plus et Team, les développeurs et les chercheurs ayant besoin d'une plus grande flexibilité et d'options d'intégration trouveront l'API o1 d'OpenAI plus adaptée à leurs besoins.

Limites de la version bêta

Même si le modèle o1 n'est pas prévisible dans l'interface de discussion, au moment de la rédaction de cet article (6 décembre 2024), l'API ne donne accès qu'à deux variantes du modèle o1 :

- o1-preview : Il s'agit d'un avant-goût du modèle o1 complet, conçu pour résoudre des problèmes complexes nécessitant de vastes connaissances générales.

- o1-mini : Une version plus rapide et plus rentable de o1, bien adaptée aux tâches de codage, de mathématiques et de sciences pour lesquelles une connaissance générale approfondie n'est pas nécessaire.

o1-preview et o1-mini sont tous deux accessibles via le point de terminaison point de terminaison des conversationsce qui facilite leur intégration dans des projets existants. Le processus consiste à sélectionner le modèle souhaité (par exemple, model="o1-preview") lors des appels à l'API. Pour apprendre étape par étape comment utiliser o1 via l'API, lisez ce tutoriel : Tutoriel de l'API O1 de l'OpenAI : Comment se connecter à l'API d'OpenAI.

o1 étant actuellement en version bêta, certains paramètres et fonctionnalités de l'API ne sont pas encore pris en charge. Il s'agit notamment de

- Modalités: Actuellement, seules les entrées et sorties de texte sont prises en charge ; le traitement des images n'est pas encore disponible.

- Types de messages : Les messages du système ne sont pas pris en charge ; seuls les messages de l'utilisateur et de l'assistant sont autorisés.

- Streaming : La fonction de streaming n'est pas encore disponible pour les modèles o1.

- Outils et appels de fonctions: Ces fonctionnalités avancées ne sont pas prises en charge actuellement.

- Logprobs : Les probabilités logarithmiques ne sont pas encore disponibles.

- Autres paramètres : Les paramètres tels que

temperature,top_p, etnsont fixés à 1, tandis quepresence_penaltyetfrequency_penaltysont fixés à 0. - Assistants et Batch APILes modèles o1 ne sont pas encore intégrés à l'API Assistants ou à l'API Batch.

OpenAI prévoit d'ajouter progressivement la prise en charge de certains de ces paramètres et fonctionnalités au fur et à mesure que o1 sort de la phase bêta. Des fonctionnalités plus avancées, telles que la multimodalité et l'utilisation d'outils, devraient être incluses dans les prochaines versions de la série o1.

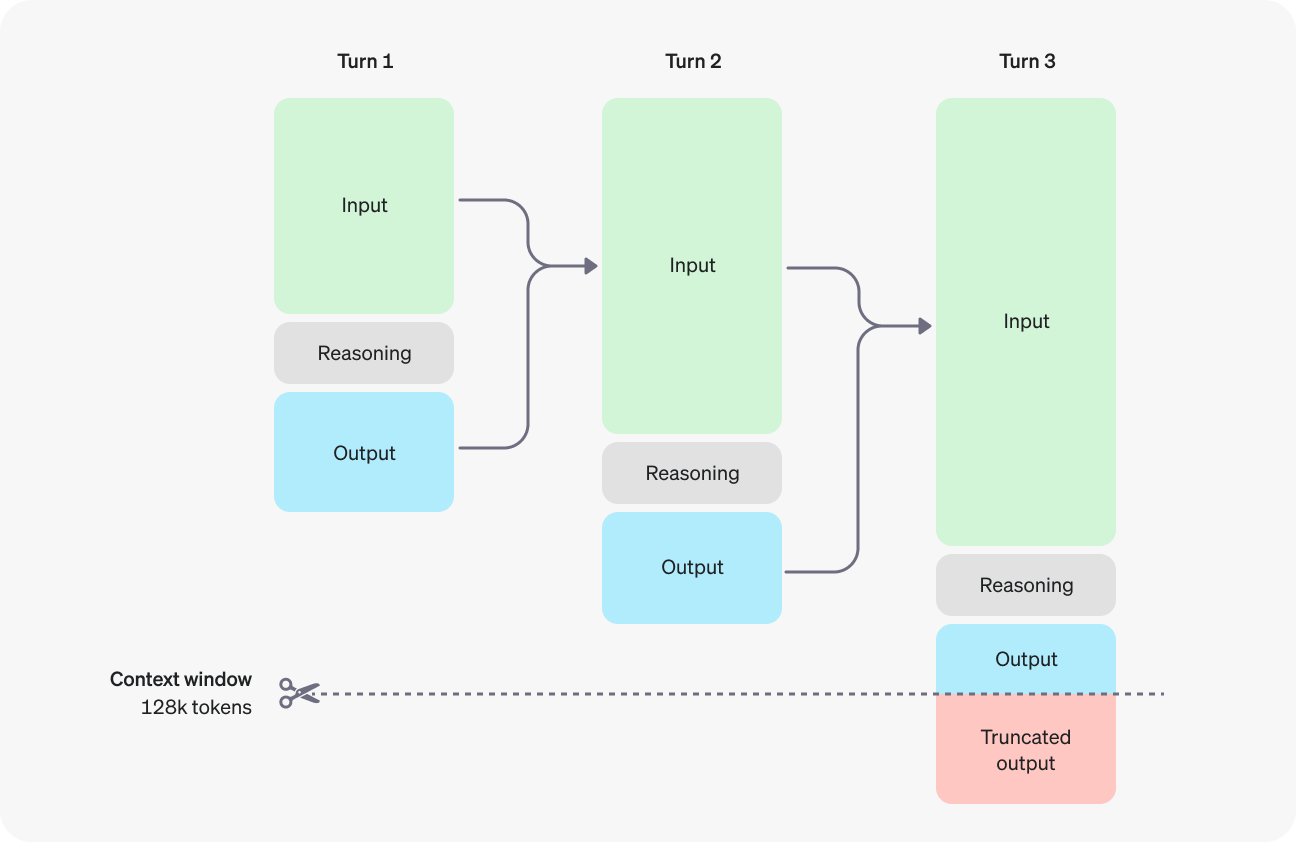

Comprendre les jetons de raisonnement

Un aspect essentiel des modèles o1 est l'introduction de "jetons de raisonnement". Ces jetons représentent le processus de réflexion interne du modèle lorsqu'il décompose l'invite, envisage différentes approches et formule une réponse. Bien que ces jetons de raisonnement ne soient pas visibles via l'API, ils occupent de l'espace dans la fenêtre contextuelle du modèle et contribuent au nombre total de jetons, ce qui a un impact sur la facturation.

Source : OpenAI

Fenêtre contextuelle et coûts

o1-preview et o1-mini offrent tous deux une fenêtre contextuelle de 128 000 jetons. Cependant, chaque achèvement a une limite maximale sur le nombre total de jetons de sortie générés, y compris les jetons de raisonnement invisibles et les jetons d'achèvement visibles. Pour éviter les coûts inattendus et s'assurer que le modèle a suffisamment de place pour "penser", il est essentiel de gérer efficacement la fenêtre contextuelle et de fixer des limites appropriées à l'aide du paramètre max_completion_tokens.

Meilleures pratiques en matière d'incitation

Pour obtenir des résultats optimaux avec les modèles o1, veillez à ce que vos messages soient simples et directs. Évitez les techniques telles que les messages-guides à quelques reprises ou l'instruction explicite au modèle de "penser étape par étape", car elles risquent d'entraver la performance plutôt que de l'améliorer. Utilisez des délimiteurs pour structurer clairement vos données et, dans les scénarios de génération par extraction, ne fournissez que le contexte le plus pertinent afin d'éviter que le modèle ne complique trop sa réponse.

Qu'est-ce que l'OpenAI o1-mini ?

Outre le modèle complet o1-preview, OpenAI a également lancé o1-mini, une variante plus petite et plus rapide conçue pour offrir un point d'entrée plus accessible aux développeurs et aux chercheurs qui explorent les capacités de la série o1.

Si o1-mini ne possède pas les mêmes connaissances générales que son homologue plus grand, il excelle dans les tâches qui exigent des capacités de raisonnement ciblées, en particulier dans les domaines du codage, des mathématiques et des sciences.

Sa taille réduite se traduit par des temps de réponse plus rapides et des besoins de calcul moindres, ce qui en fait un choix pratique pour les applications où la vitesse et l'efficacité sont importantes.

Bien que o1-mini soit actuellement en version bêta et présente certaines limites, il donne un aperçu du potentiel de la série o1 et de l'accent mis sur l'amélioration des capacités de raisonnement de l'IA. Comme OpenAI continue d'affiner et de développer les modèles o1, nous pouvons nous attendre à ce que o1-mini évolue en même temps que son grand frère, fournissant un outil de plus en plus puissant et polyvalent pour une large gamme d'applications.

Qu'est-ce que le mode O1 Pro ?

En plus du modèle standard o1, OpenAI a également introduit le mode o1 pro. Ce modèle est conçu pour les utilisateurs qui ont besoin de capacités de raisonnement encore plus avancées et qui sont prêts à sacrifier un peu de vitesse pour une plus grande précision et la capacité de traiter des tâches très complexes.

Le mode o1 pro tire parti d'une puissance de calcul nettement supérieure à celle du modèle o1 standard. Cela lui permet de "réfléchir plus longtemps" et de "réfléchir plus fort" pour générer des réponses plus fiables, en particulier pour les problèmes difficiles dans des domaines tels que la science des données, la programmation et l'analyse de la jurisprudence.

Pour accéder au mode o1 pro, vous avez besoin d'un abonnement au ChatGPT Pro. Cet abonnement vous permet d'utiliser de manière illimitée o1 et o1 pro mode, ainsi que d'autres modèles et fonctionnalités avancés.

Nous avons abordé le mode o1 pro en profondeur dans un autre article : Qu'est-ce que le mode O1 Pro d'OpenAI ? Caractéristiques, ChatGPT Pro & Plus.

Limites de l'OpenAI o1

Bien qu'OpenAI o1-preview offre des capacités impressionnantes, il y a quelques limitations dont il faut être conscient. Ces contraintes peuvent affecter son utilité dans certains contextes, il est donc utile d'être conscient des éléments suivants.

Chaîne de pensée cachée

Afin de garantir la possibilité d'améliorations futures en matière de surveillance et de sécurité, le processus de raisonnement brut de la chaîne de pensée utilisé par o1 n'est pas directement visible pour les utilisateurs. Bien que cette décision vise à permettre une surveillance plus efficace des modèles, elle limite la transparence et pourrait avoir une incidence sur la compréhension par les utilisateurs du processus de prise de décision du modèle.

Ne navigue pas encore sur le web

OpenAI o1-preview ne peut pas naviguer sur le web, ce qui signifie que les informations qu'il fournit peuvent ne pas être toujours à jour. Si vous recherchez des données en temps réel ou sur des événements actuels, le modèle ne sera pas en mesure de les récupérer directement.

Des temps de réponse plus longs

L'une des limites les plus évidentes est que le modèle prend un temps relativement long pour traiter des requêtes complexes. Si ce délai supplémentaire lui permet de produire des réponses plus réfléchies, il peut entraîner des retards pour les utilisateurs qui attendent des réponses plus rapides.

Ne convient pas aux applications à faible latence

En raison de ses temps de réponse plus lents, OpenAI o1 n'est pas idéale pour les applications qui nécessitent des interactions rapides. pour les applications qui nécessitent des interactions rapides, comme les chatbots en temps réel ou les services de traduction.comme les chatbots en temps réel ou les services de traduction. Dans ces cas d'utilisation, le délai peut entraîner une mauvaise expérience pour l'utilisateur, car attendre plusieurs secondes pour une réponse peut être frustrant.

Si le modèle est appliqué dans des situations où ses points forts ne sont pas alignés sur la tâche, il peut en résulter une expérience négative pour l'utilisateur. Cela est particulièrement vrai pour les scénarios nécessitant des réponses rapides, à la volée, où le temps de traitement plus lent du modèle peut devenir un obstacle plutôt qu'un avantage.

OpenAI o1 Sécurité

Les nouveaux modèles o1 sont dotés d'une approche de formation à la sécurité qui utilise leurs capacités de raisonnement pour une meilleure sécurité en contexte.

L'une des principales mesures de sécurité consiste à tester la résistance du modèle aux tentatives de "tentatives de "jailbreakingoù les utilisateurs tentent de contourner les règles de sécurité. Lors d'un test de jailbreak difficile, GPT-4o a obtenu un score de 22 sur 100, tandis que le modèle plus récent o1-preview a obtenu un score de 84, ce qui indique une amélioration substantielle.

Les efforts en matière de sécurité ont été renforcés par des tests rigoureux, une interneet la collaboration avec le gouvernement fédéral. Il s'agit notamment d'utiliser le cadre de préparationl'équipe rouge et des examens au niveau du conseil d'administration par leur comité de sûreté et de sécurité.

En outre, des partenariats avec les États-Unis et le Royaume-Uni ont été mis en place. Les instituts de sécurité de l'IA ont été officialisés, ce qui leur donne un accès anticipé aux versions de recherche des modèles.

Toutefois, il est essentiel d'aborder ces premiers résultats avec un optimisme prudent.

L'avenir : Série O de l'OpenAI

L'introduction de l'OpenAI o1 marque non seulement un nouveau modèle, mais aussi le début d'une nouvelle série : la série O de l'OpenAI. Cela marque un changement délibéré dans l'orientation stratégique de l'OpenAI, qui met l'accent sur les capacités de raisonnement complexe en tant qu'élément central du développement futur de l'IA.

Les premiers résultats impressionnants obtenus avec o1 et o1 pro mode, en particulier les excellentes performances sur les benchmarks nécessitant la résolution de problèmes complexes, suggèrent que cette nouvelle série est très prometteuse.

Alors que l'OpenAI continue d'affiner et d'étendre les capacités des modèles de la série o, nous pouvons anticiper un avenir où l'IA jouera un rôle encore plus actif dans la découverte scientifique, le développement de logiciels et d'autres domaines nécessitant des compétences cognitives avancées.

Cependant, le chemin qui mène à la pleine réalisation du potentiel de la série O n'est pas sans défis. La nature intensive de ces modèles et les contraintes uniques de mise à l'échelle qu'ils présentent nécessitent une recherche et un développement continus.

Conclusion

Alors que nous attendions avec impatience l'arrivée de GPT-5 cette année, OpenAI nous a surpris avec l'introduction de o1, un modèle qui donne la priorité aux capacités de raisonnement complexes.

Les premiers succès de l'application o1 sur une variété de critères de référence démontrent son potentiel à résoudre des problèmes difficiles dans des domaines tels que les mathématiques, le codage et la recherche scientifique.

Malgré ses capacités prometteuses, o1 en est encore à ses débuts et doit relever des défis, notamment sa forte intensité de calcul et la nécessité de poursuivre les recherches sur la sécurité et le déploiement éthique.

FAQ

Qu'est-ce que l'OpenAI o1 et en quoi est-elle différente des autres modèles ?

OpenAI o1 est un nouveau modèle d'IA axé sur des tâches de raisonnement complexes telles que les mathématiques, le codage et les puzzles. Il utilise le raisonnement par chaîne de pensée pour décomposer les problèmes, ce qui améliore la précision par rapport aux anciens modèles tels que le GPT-4.

Quelles sont les tâches pour lesquelles les modèles OpenAI o1 sont particulièrement performants ?

OpenAI o1 excelle dans les problèmes mathématiques, les défis de codage, l'analyse de données et les tâches scientifiques qui nécessitent un raisonnement en plusieurs étapes.

Comment puis-je accéder à l'OpenAI o1 ?

Vous pouvez accéder à OpenAI o1 via le ChatGPT, et les développeurs peuvent y accéder via l'API d'OpenAI.

Quelle est la différence entre OpenAI o1 et o1-mini ?

o1-mini est une version plus petite de o1, mieux adaptée aux tâches légères mais moins puissante pour les raisonnements complexes.

Quelles sont les fonctionnalités attendues dans les futures mises à jour des modèles OpenAI o1 ?

Quels sont les tarifs pour l'utilisation des modèles OpenAI o1 ?

La tarification des modèles o1 est basée sur l'utilisation et dépend du modèle spécifique et du nombre de jetons traités.

- Pour o1-preview, le coût est de 15 $ pour 1 million de jetons d'entrée et de 60 $ pour 1 million de jetons de sortie.

- Pour o1-mini, le coût est de 3,00 $ pour 1 million de jetons d'entrée et de 12,00 $ pour 1 million de jetons de sortie.

- Il est important de se rappeler que le nombre total de jetons comprend à la fois les jetons d'achèvement visibles et les jetons de raisonnement invisibles, qui contribuent au coût global.

Author

Richie aide les individus et les organisations à mieux utiliser les données et l'IA. Il est data scientist depuis bien avant que l'on parle de data science, et a écrit deux livres et créé de nombreux cours DataCamp sur le sujet. Il est l'hôte du podcast DataFramed et dirige le programme de webinaires de DataCamp.

Author

Josef Waples

Je suis rédacteur et éditeur dans le domaine de la science des données. Je suis particulièrement intéressé par l'algèbre linéaire, les statistiques, R, etc. Je joue également beaucoup aux échecs !