Künftige Updates könnten schnellere Reaktionszeiten, Webbrowsing und Dateiverarbeitung beinhalten.

Während wir alle darauf gewartet hatten GPT-5warteten, überraschte OpenAI im letzten Sommer alle mit der Veröffentlichung des o1-Preview-Modells. Jetzt haben sie gerade bekannt gegeben, dass o1 vollständig verfügbar ist und sich nicht mehr im Preview-Modus befindet.

Im Vergleich zur Vorabversion kann o1 multimodale Eingaben verarbeiten, verfügt über ein Bildverständnis und ist bei einfachen Abfragen viel schneller. Früher hat es mehr als zehn Sekunden gedauert, nur um auf die Aufforderung "Hallo" zu antworten.

OpenAI hat auch den o1 pro-Modus eingeführt, der etwas leistungsfähiger und zuverlässiger ist als o1. Während wir in diesem Artikel kurz auf den o1 pro-Modus eingehen, werden wir ihn in diesem separaten Artikel ausführlicher behandeln: Was ist der O1 Pro-Modus von OpenAI? Funktionen, ChatGPT Pro & Mehr.

OpenAI hat den Zähler wieder auf 1 zurückgesetzt und ihr den Namen OpenAI o1 gegeben, um zu betonen, dass sie sich im Vergleich zur traditionellen GPT-Linie. Dies ist der Startschuss für eine neue OpenAI o-Serie, ähnlich der GPT-Serie, die wir alle kennen.

Die O1-Modelle sind nicht dazu gedacht, den GPT-4o in allen Fällen zu ersetzen. Für Anwendungen, die schnelle Reaktionszeiten erfordern, sind die Modelle GPT-4o und GPT-4o mini die optimale Wahl.

Lies weiter, um mehr über die neuen O1-Modelle zu erfahren!

KI-Anwendungen entwickeln

Lerne, wie man KI-Anwendungen mit der OpenAI API erstellt.

Wie OpenAI o1 funktioniert

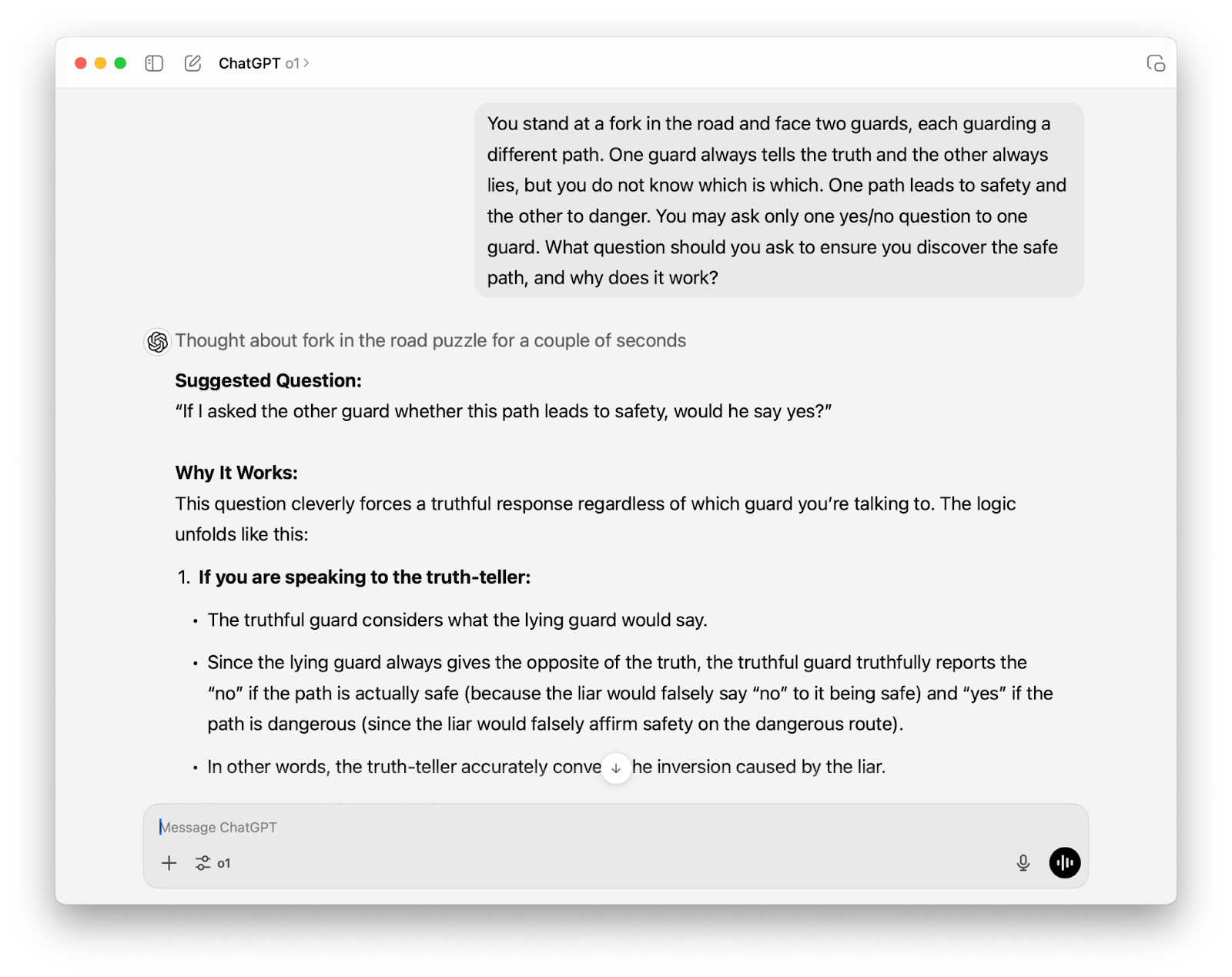

Das erste, was dir auffallen wird, wenn du mit o1 interagierst, ist, dass es im Vergleich zu GPT-4o deutlich länger dauert, bis du Antworten bekommst. Diese bewusste Pause spiegelt den Schwerpunkt des Modells auf das Denken wider. O1 verbringt mehr Zeit mit "Nachdenken", bevor es antwortet. Dadurch kann es komplexe Aufgaben angehen und schwierigere Probleme in den Bereichen Logik, Mathematik, Codierung und Wissenschaft lösen.

OpenAI o1-preview geht ein logisches Problem an

Verstärkungslernen und Gedankenkette

Das überlegene Denkvermögen von O1 wird durch eine Kombination aus Verstärkungslernen und Gedankenkettendenken erreicht.

Durch Verstärkungslernenlernt das Modell, seinen Denkprozess zu verfeinern, indem es verschiedene Strategien ausprobiert, Fehler erkennt und seinen Ansatz anpasst, um die genaueste und logischste Lösung zu finden.

Auf der anderen Seite, chain-of-thought reasoning ist eine Technik, mit der komplexe Probleme in kleinere, leichter zu handhabende Teile zerlegt werden können. Dieser Ansatz ermöglicht es o1, "zu denken, bevor es antwortet", ähnlich wie bei der akribischen Planung der Schritte eines komplexen Rezepts, bevor man mit dem Kochen beginnt.

Indem o1 seinen Denkprozess explizit darlegt, kann es potenzielle Fehler frühzeitig erkennen und die Wahrscheinlichkeit erhöhen, die richtige Lösung zu finden, so wie wir Menschen weniger Fehler machen, wenn wir unseren Denkprozess sorgfältig beschreiben.

Die Tatsache, dass OpenAI o1 die Gedankenkette nutzt, macht es besonders effektiv in Bereichen wie Mathematik, Wissenschaft und Programmierung, in denen eine richtige Antwort oft mehrere Schritte erfordert.

Ein neues Paradigma bei der Zuteilung von Rechenleistung

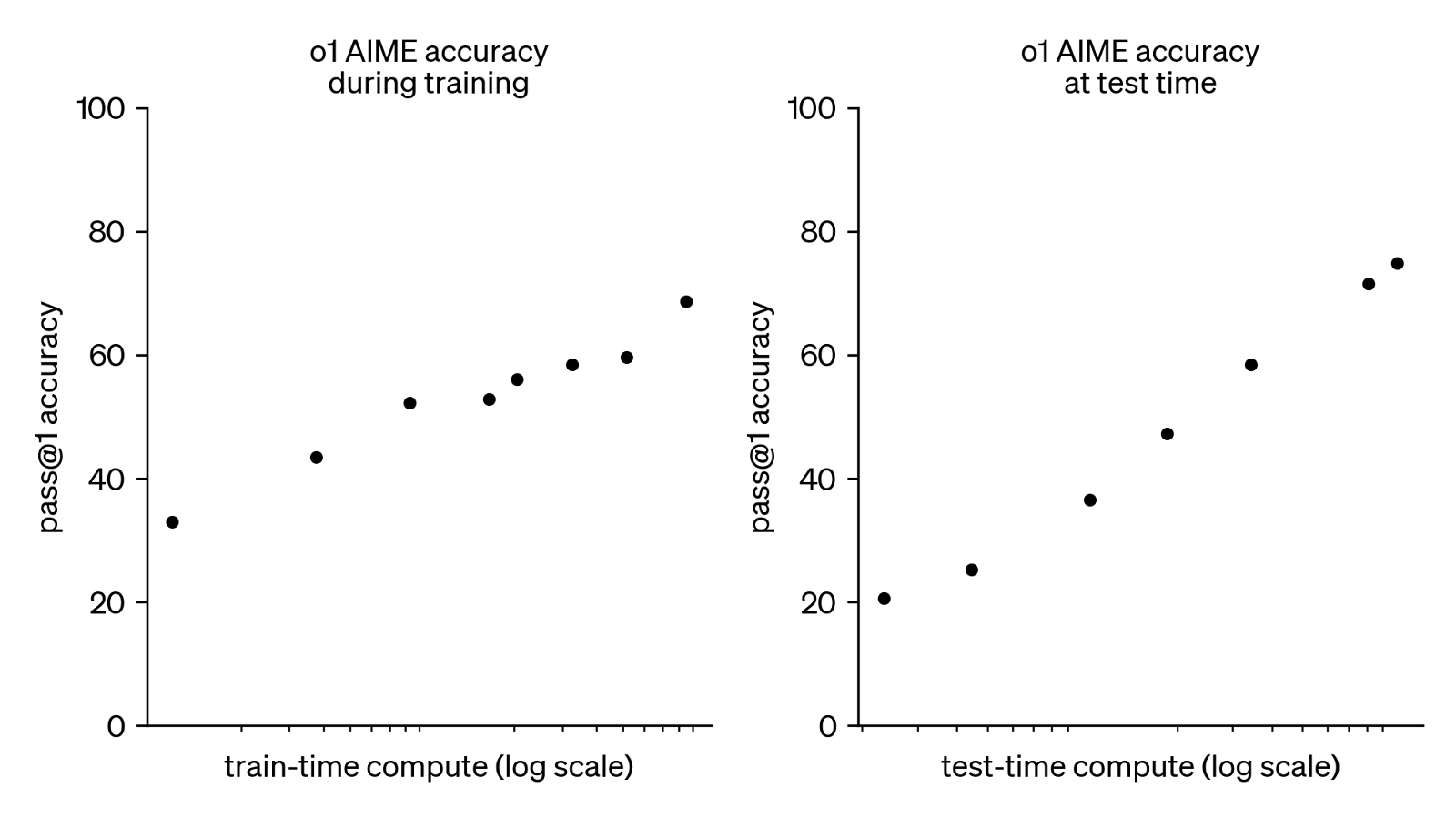

Ein wesentliches Unterscheidungsmerkmal von OpenAI o1 liegt in der strategischen Neuzuweisung von Rechenressourcen. Während sich traditionelle LLMs vor allem auf massive Pretraining-Datensätze konzentriert haben, verlagert o1 den Schwerpunkt auf die Trainings- und Inferenzphasen.

Diese Verschiebung zeigt, dass die Zuweisung von mehr Rechenleistung für diese Stufen zu einem erheblichen Gewinn an komplexen Denkfähigkeiten führen kann.

Quelle: OpenAI

Das obige Diagramm zeigt die Auswirkung erhöhter Rechenressourcen auf die Leistung des o1-Modells von OpenAI bei der anspruchsvollen AIME-Prüfung (American Invitational Mathematics Examination). Es gibt zwei Diagramme, in denen die Genauigkeit des Modells gegen die Rechenleistung aufgetragen wird, die entweder für das Training oder das Testen (Inferenz) verwendet wird.

In beiden Diagrammen ist ein klarer positiver Zusammenhang zu erkennen: Mit zunehmenden Rechenressourcen steigt auch die Genauigkeit des Modells bei der Lösung von AIME-Problemen im ersten Anlauf. Das deutet darauf hin, dass das Modell während der Problemlösung mehr Zeit zum "Denken" hat, was zu einer deutlich besseren Leistung führt.

Diese Beobachtung unterstreicht den rechenintensiven Charakter von o1 und macht deutlich, dass er auf umfangreiche Rechenressourcen angewiesen ist. Der Aufwärtstrend in beiden Diagrammen deutet jedoch auch darauf hin, dass mit noch mehr Rechenleistung weitere Genauigkeitssteigerungen möglich sind, was vielversprechende Wege für die künftige Entwicklung von KI-Schlussfolgerungen aufzeigt.

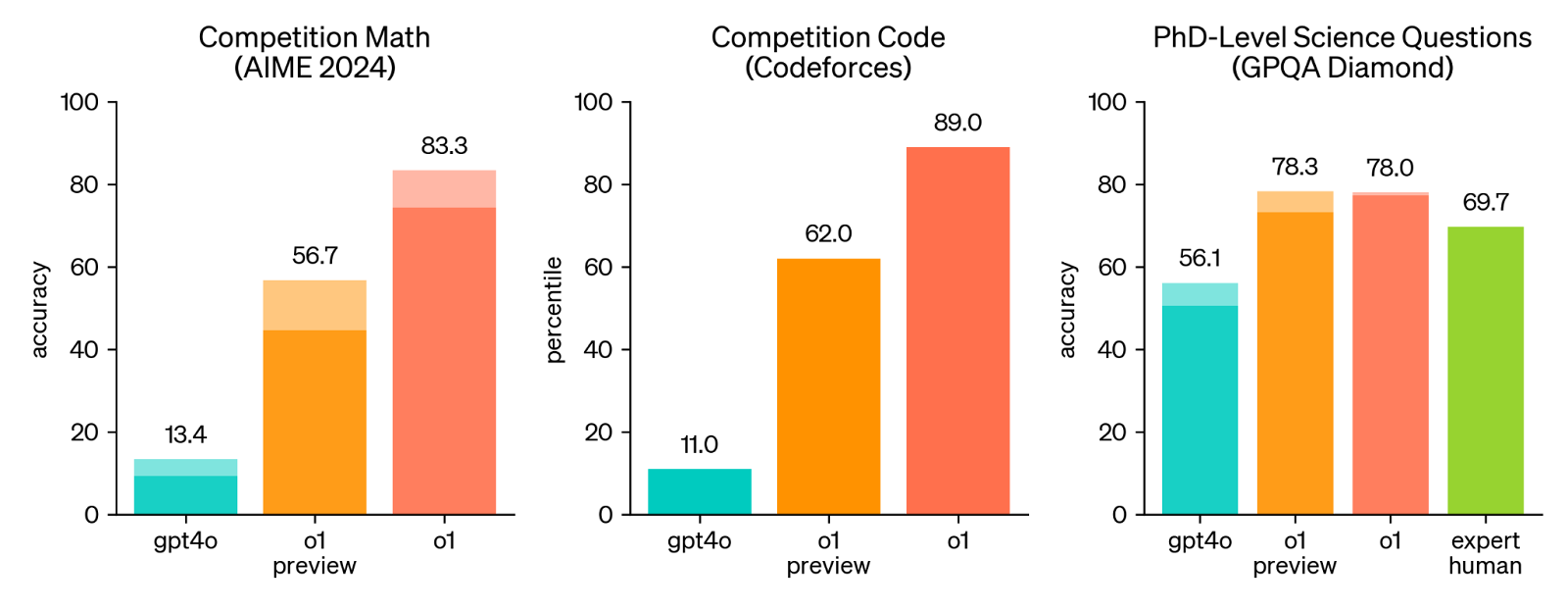

OpenAI O1 Benchmarks: Besseres logisches Denken bei schweren Aufgaben

Um die verbesserten Denkfähigkeiten von o1 im Vergleich zu GPT-4o zu demonstrieren, hat OpenAI das Modell in einer Reihe von anspruchsvollen mathematischen, programmiertechnischen und naturwissenschaftlichen Benchmarks getestet.

Menschliche Prüfungen

Die menschliche Untersuchung zeigt, dass o1 durchweg besser abschneidet als GPT-4o und o1-preview.

Die durchgezogenen Balken zeigen die Pass@1-Genauigkeit und der schattierte Bereich zeigt die Leistung der Mehrheitsabstimmung (Konsens) mit 64 Stichproben. Quelle: OpenAI

Die vielleicht auffälligste Beobachtung ist der riesige Leistungssprung zwischen GPT-4o und o1 (und sogar o-1 preview) bei den Mathe- und Code-Benchmarks.

Und obwohl die Verbesserung im wissenschaftlichen Bereich weniger ausgeprägt ist, ist es bemerkenswert, dass sowohl o1-preview als auch das vollständig optimierte o1-Modell menschliche Experten bei wissenschaftlichen Fragen auf PhD-Niveau übertrifft. Das zeigt, dass o1 das Potenzial hat, komplizierte Probleme in der realen Welt zu lösen und in bestimmten Bereichen sogar die Leistung von Menschen zu übertreffen.

OpenAI o1 hat potenzielle Anwendungsfälle in der Genetik.

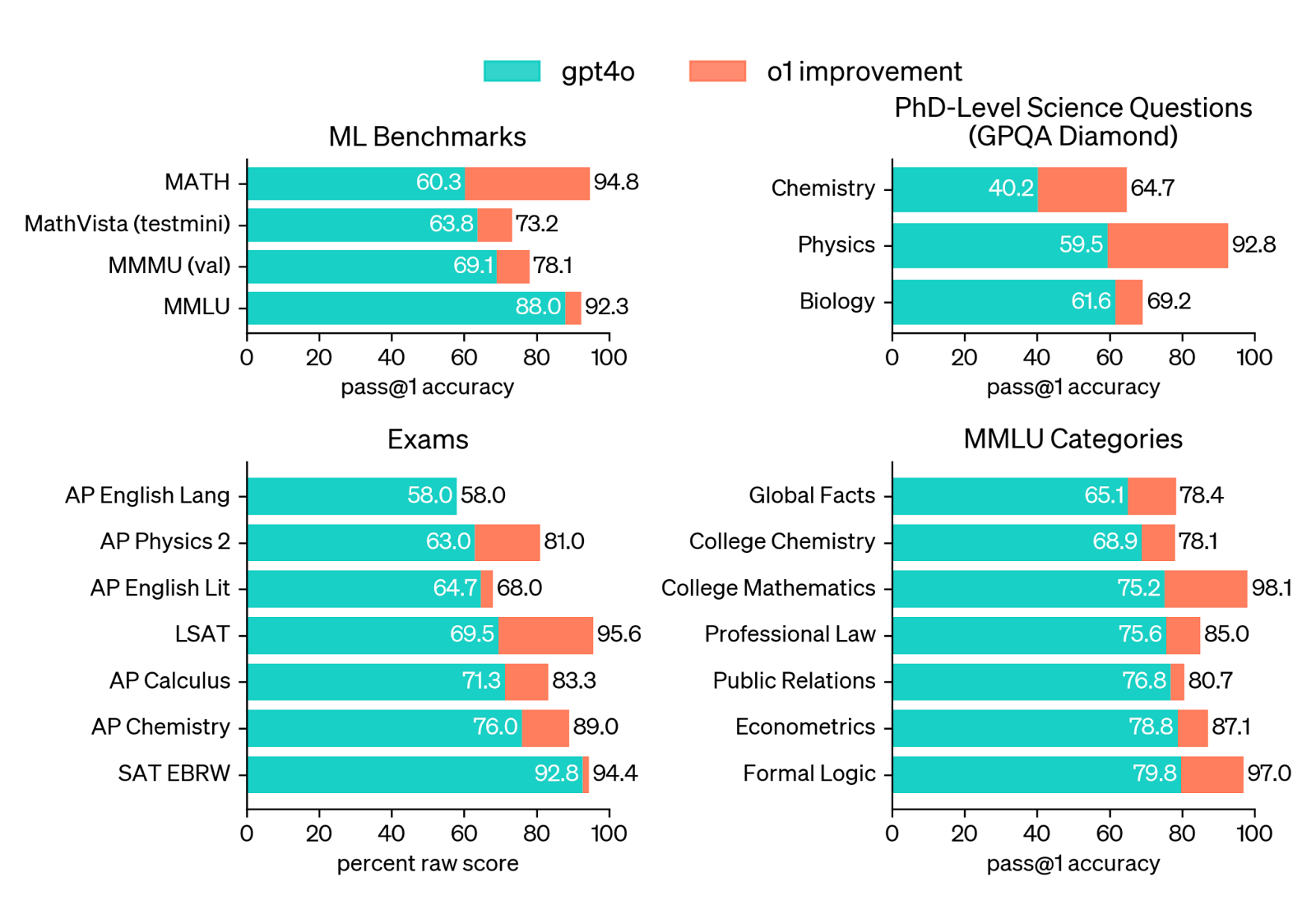

ML-Benchmarks

Wenn du dir die Ergebnisse der ML-Benchmarks ansiehst, sind die Fortschritte von o1 beim logischen Denken ziemlich offensichtlich. Sowohl bei MathVista (einem Mathematik-Benchmark) als auch bei MMLU zeigt o1 im Vergleich zu GPT-4o eine deutlich höhere Genauigkeit.

Quelle: OpenAI

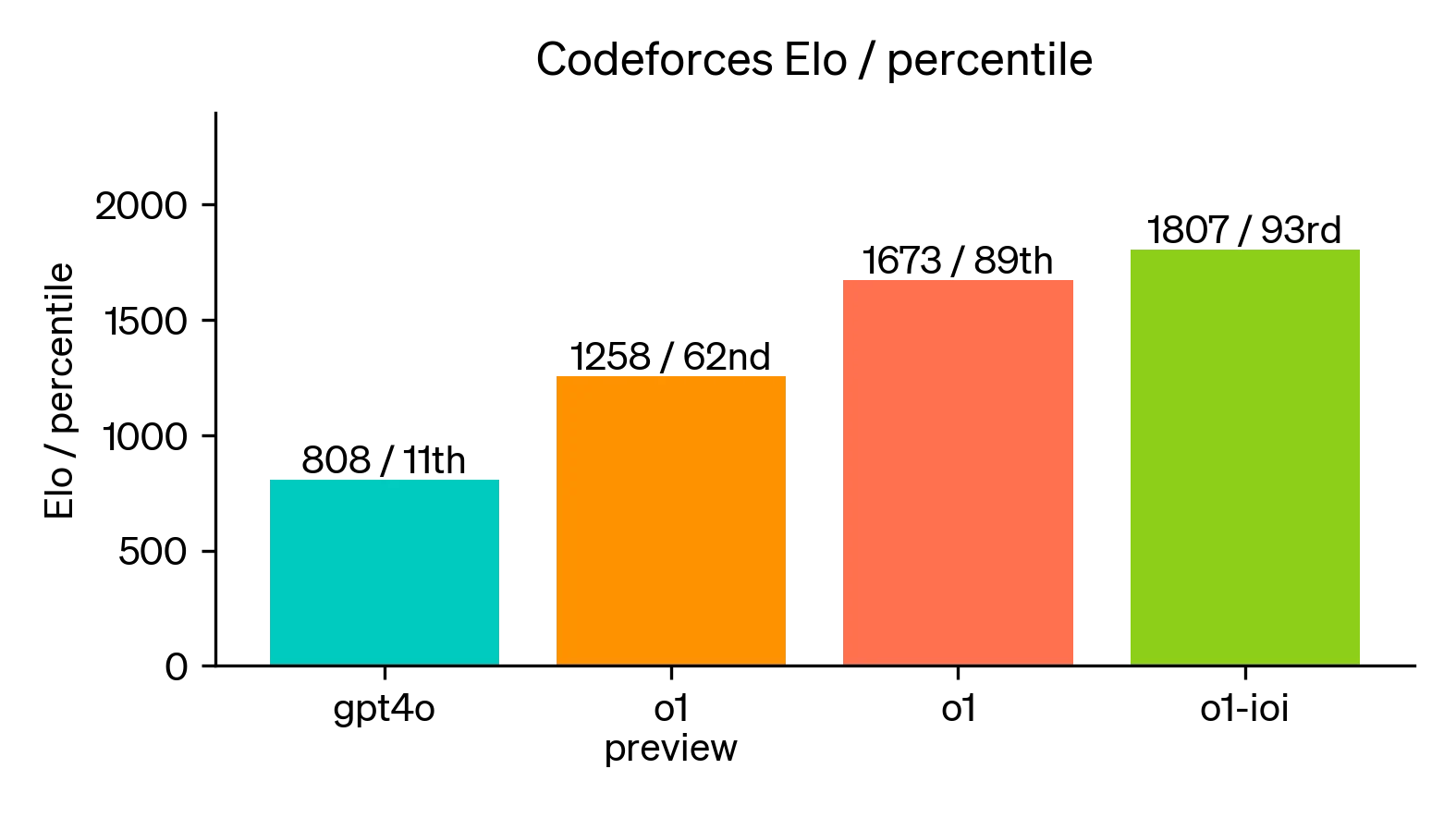

Eine spezialisierte Version von o1, bekannt als o1-ioi, bewies überlegene Programmierfähigkeiten, indem sie bei der Internationalen Informatik-Olympiade 2024 selbst unter strengen Wettbewerbsbedingungen einen Platz im 49.

In simulierten Wettbewerben (siehe Grafik unten) stieg die Leistung von o1-ioi sogar noch weiter an und übertraf 93 % der Konkurrenten.

Quelle: OpenAI

OpenAI o1 Anwendungsfälle

Die Denkfähigkeiten von OpenAI o1 eignen sich besonders gut, um komplexe Probleme in den Bereichen Wissenschaft, Programmierung und Mathematik zu lösen.

Wissenschaftliche Forschung

Forscherinnen und Forscher im Gesundheitswesen könnten o1 zum Beispiel nutzen, um komplizierte Zellsequenzierungsdaten zu annotieren, während Physikerinnen und Physiker es einsetzen könnten, um die anspruchsvollen mathematischen Formeln zu erstellen, die für die Forschung in der Quantenoptik erforderlich sind.

Quantenphysik und OpenAI o1

Codierung

Vom Vorschlagen von Code-Optimierungen und der Erstellung von Testfällen bis hin zur Automatisierung von Code-Reviews und der Erleichterung des Wissensaustauschs hat o1 das Potenzial, die Produktivität von Entwicklern erheblich zu steigern und Arbeitsabläufe zu vereinfachen.

Die Fähigkeit von o1, Code zu verstehen und zu erzeugen, erweitert seinen Nutzen über das reine Codieren hinaus. Sie kann bei der Projektplanung, der Anforderungsanalyse und dem Entwurf der Softwarearchitektur helfen und die Entwickler bei der Entwicklung effektiverer Lösungen unterstützen.

Obwohl der volle Funktionsumfang von o1 noch in der Entwicklung ist, sind die aktuellen Funktionen schon vielversprechend. Wenn OpenAI das Modell weiter verfeinert, wird o1 wahrscheinlich zu einem wertvollen Werkzeug für Entwickler werden, das Innovationen fördert und die Zukunft der Softwareentwicklung beeinflusst.

Wie im Abschnitt "Benchmarks" beschrieben, zeigt das o1-Modell großes Potenzial im Bereich der Codierung.

HTML Schlange mit OpenAI o1

Mathematik

Auch die Mathematik könnte von den fortschrittlichen Denkfähigkeiten von o1 erheblich profitieren. Seine starke Leistung bei Benchmarks wie AIME deutet auf mögliche Anwendungen beim Lösen komplexer Gleichungen, beim Beweisen von Theoremen und beim Erforschen neuer mathematischer Konzepte hin, wovon sowohl Studierende als auch Forscher profitieren.

Mathematik mit OpenAI o1

Anwendungsfälle mit hohem Begründungsaufwand

Der Fokus von o1 auf das logische Denken macht es zu einem wertvollen Werkzeug für alle Aufgaben, die kritisches Denken und logische Schlussfolgerungen erfordern. Vom Lösen von Puzzles und Rätseln bis hin zur Analyse komplexer Argumente und der Erleichterung fundierter Entscheidungen könnte o1 neue Wege zur Problemlösung eröffnen.

Rätsel schreiben mit OpenAI o1

Wie man auf OpenAI o1 zugreift

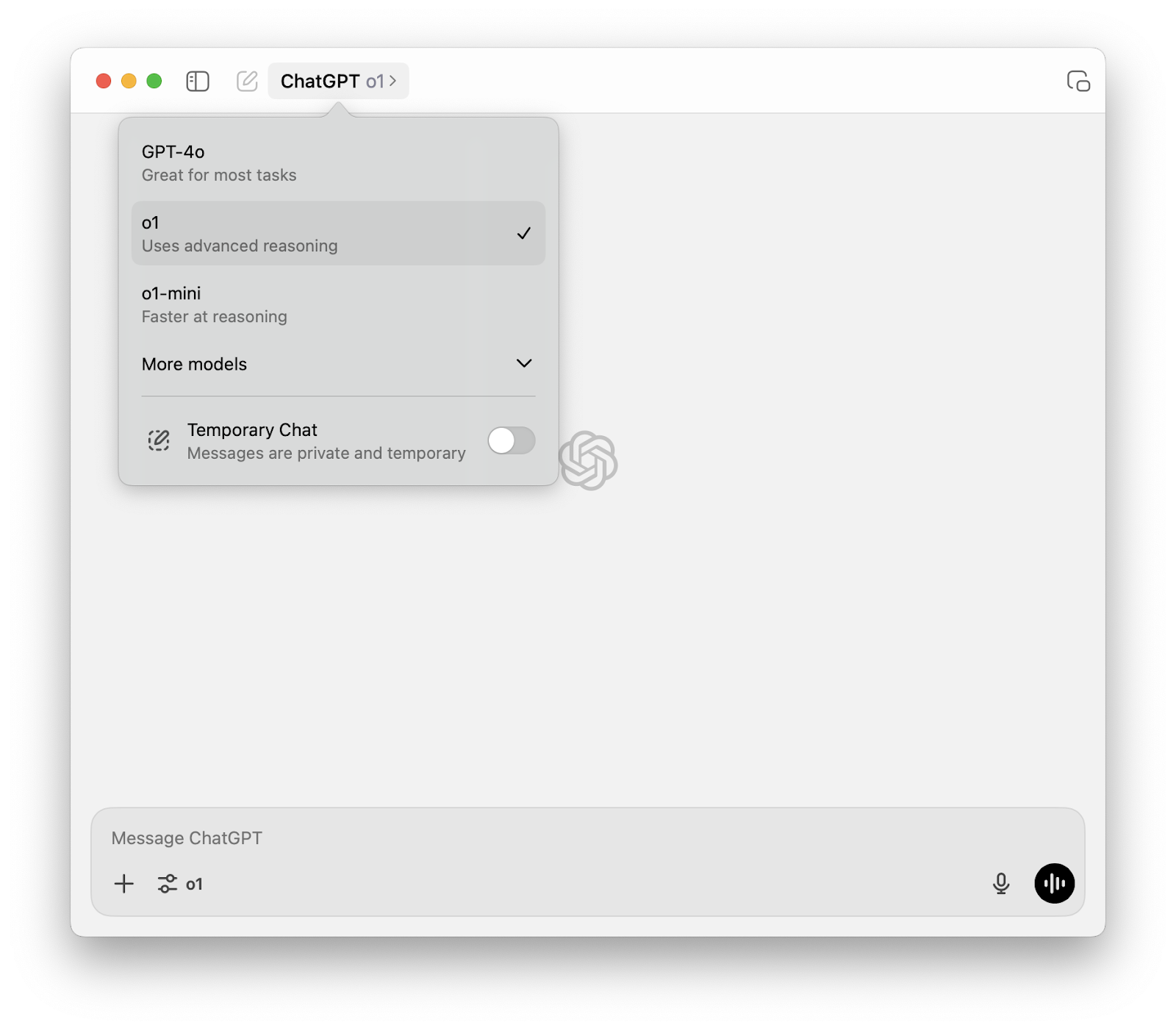

Wenn du ein ChatGPT Plus- oder ChatGPT Team-Abonnement hast, kannst du das o1-Modell direkt über die ChatGPT-Oberfläche aufrufen. Wähle o1 aus dem Dropdown-Menü der Modellauswahl oben auf der Seite .

Bedenke, dassdu mit einem ChatGPT Plus- oder Team-Konto zunächst 50 Nachrichten pro Woche mit OpenAI o1 und 50 Nachrichten pro Tag mit OpenAI o1-mini erhältst.

OpenAI o1 API

Während o1 innerhalb von ChatGPT für Plus- und Team-Abonnenten zugänglich ist, werden Entwickler und Forscher, die mehr Flexibilität und Integrationsmöglichkeiten benötigen, die OpenAI o1 API für ihre Bedürfnisse besser geeignet finden.

Beta Einschränkungen

Auch wenn das o1-Modell in der Chat-Oberfläche nicht mehr in der Vorschau zu sehen ist, bietet die API zum Zeitpunkt des Schreibens dieses Artikels (6. Dezember 2024) nur zwei Varianten des o1-Modells an:

- o1-preview: Dies ist die erste Vorschau auf das vollständige o1-Modell, das komplexe Probleme lösen soll, die ein breites Allgemeinwissen erfordern.

- o1-mini: Eine schnellere und kostengünstigere Version von o1, die sich gut für Aufgaben in den Bereichen Programmieren, Mathematik und Wissenschaft eignet, für die kein umfangreiches Allgemeinwissen erforderlich ist.

Sowohl o1-preview als auch o1-mini sind über den Endpunkt für Chatverläufezugänglich, sodass sie leicht in bestehende Projekte integriert werden können. Dabei wird das gewünschte Modell (z. B. model="o1-preview") bei API-Aufrufen ausgewählt. Wenn du Schritt für Schritt lernen willst, wie du o1 über die API verwendest, lies dieses Tutorial: OpenAI O1 API Tutorial: So verbindest du dich mit der OpenAI API.

Da sich o1 derzeit in der Beta-Phase befindet, werden bestimmte API-Parameter und Funktionen noch nicht unterstützt. Dazu gehören:

- Modalitäten: Derzeit werden nur Texteingabe und -ausgabe unterstützt; die Verarbeitung von Bildern ist noch nicht möglich.

- Nachrichtentypen: Systemmeldungen werden nicht unterstützt; nur Benutzer- und Assistentenmeldungen sind erlaubt.

- Streaming: Die Streaming-Funktion ist für die o1-Modelle noch nicht verfügbar.

- Werkzeuge und Funktionsaufrufe: Diese erweiterten Funktionen werden derzeit nicht unterstützt.

- Logprobs: Log-Wahrscheinlichkeiten sind noch nicht verfügbar.

- Andere Parameter: Parameter wie

temperature,top_pundnsind auf 1 festgelegt, währendpresence_penaltyundfrequency_penaltyauf 0 festgelegt sind. - Assistenten und Batch API: o1-Modelle sind noch nicht in die Assistenten-API oder die Batch-API integriert.

OpenAI plant, die Unterstützung für einige dieser Parameter und Funktionen schrittweise hinzuzufügen, wenn o1 die Beta-Phase verlässt. Weitere fortschrittliche Funktionen wie Multimodalität und Werkzeugnutzung sind für zukünftige Versionen der o1-Serie geplant.

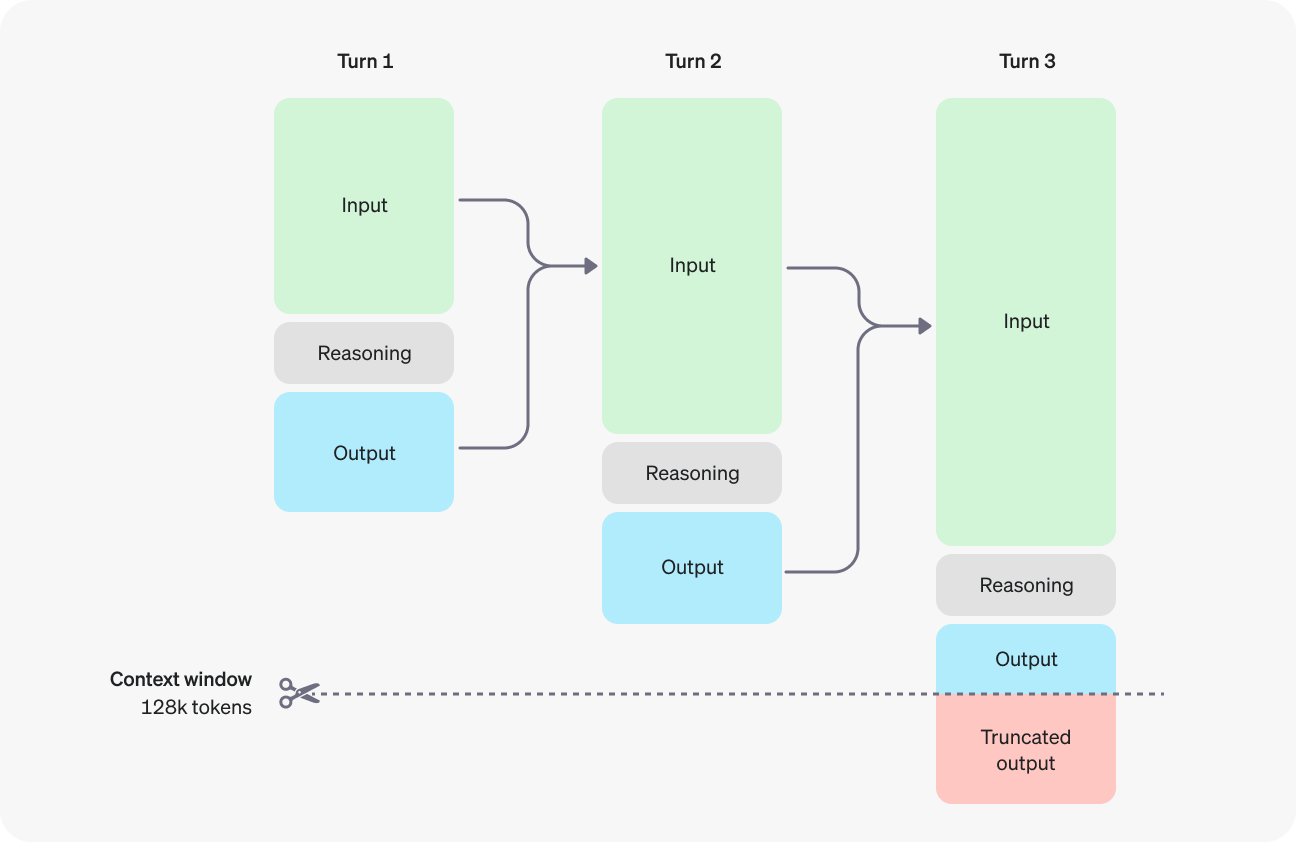

Verstehen von Argumentationsmerkmalen

Ein wichtiger Aspekt der o1-Modelle ist die Einführung von "Argumentations-Token". Diese Token stellen den internen Denkprozess des Modells dar, während es die Aufforderung zerlegt, verschiedene Ansätze in Betracht zieht und eine Antwort formuliert. Obwohl diese Argumentations-Token über die API nicht sichtbar sind, verbrauchen sie Platz im Kontextfenster des Modells und tragen zur Gesamtzahl der Token bei, was sich auf die Abrechnung auswirkt.

Quelle: OpenAI

Kontextfenster und Kosten

Sowohl o1-preview als auch o1-mini bieten ein Kontextfenster von 128.000 Token. Für jede Vervollständigung gibt es jedoch eine Höchstgrenze für die Gesamtzahl der erzeugten Output-Token, die sowohl die unsichtbaren Argumentations-Token als auch die sichtbaren Vervollständigungs-Token umfasst. Um unerwartete Kosten zu vermeiden und sicherzustellen, dass das Modell genügend Spielraum zum "Denken" hat, ist es wichtig, das Kontextfenster effektiv zu verwalten und mit dem Parameter max_completion_tokens entsprechende Grenzen zu setzen.

Bewährte Praktiken auffordern

Um optimale Ergebnisse mit o1-Modellen zu erzielen, solltest du deine Aufforderungen einfach und direkt halten. Vermeide Techniken wie die Aufforderung zu wenigen Schritten oder die explizite Anweisung an das Modell, "Schritt für Schritt zu denken", da dies die Leistung eher behindert als verbessert. Verwende Begrenzungszeichen, um deine Eingaben klar zu strukturieren, und gib in Szenarien mit abrufgestützter Generierung nur den relevantesten Kontext an, um zu verhindern, dass das Modell seine Antwort zu kompliziert gestaltet.

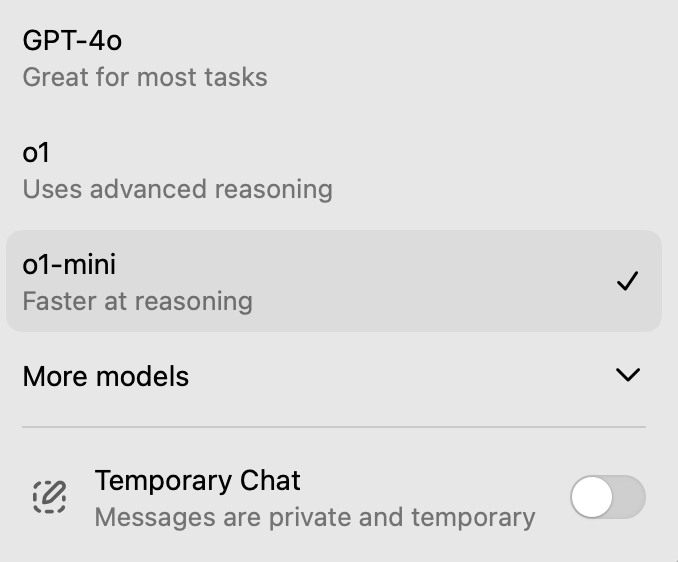

Was ist OpenAI o1-mini?

Neben dem vollwertigen Modell o1-preview hat OpenAI auch o1-mini veröffentlicht, eine kleinere und schnellere Variante, die Entwicklern und Forschern einen leichteren Einstieg in die o1-Serie ermöglicht.

Der o1-mini verfügt zwar nicht über das gleiche Allgemeinwissen wie sein größeres Gegenstück, aber er zeichnet sich bei Aufgaben aus, die ein zielgerichtetes Denken erfordern, insbesondere in den Bereichen Programmierung, Mathematik und Naturwissenschaften.

Seine geringere Größe führt zu schnelleren Reaktionszeiten und geringeren Rechenanforderungen, was ihn zu einer praktischen Wahl für Anwendungen macht, bei denen Geschwindigkeit und Effizienz wichtig sind.

Obwohl sich o1-mini derzeit in der Beta-Phase befindet und gewisse Einschränkungen hat, bietet es einen Einblick in das Potenzial der o1-Serie und ihren Fokus auf die Verbesserung der KI-Schlüsselfertigkeit. Da OpenAI die o1-Modelle weiter verfeinert und entwickelt, können wir davon ausgehen, dass sich o1-mini zusammen mit seinem größeren Bruder weiterentwickelt und ein immer leistungsfähigeres und vielseitigeres Werkzeug für eine breite Palette von Anwendungen darstellt.

Was ist der O1 Pro-Modus?

Neben dem Standardmodell o1 hat OpenAI auch den o1 pro-Modus eingeführt. Dieses Modell ist für Benutzer gedacht, die noch fortschrittlichere Argumentationsfähigkeiten benötigen und bereit sind, etwas Geschwindigkeit für eine höhere Genauigkeit und die Fähigkeit, hochkomplexe Aufgaben zu bewältigen, zu opfern.

Der o1 pro-Modus nutzt deutlich mehr Rechenleistung als das Standardmodell des o1. Dadurch kann sie "länger" und "härter" denken, um zuverlässigere Antworten zu geben, vor allem bei anspruchsvollen Problemen in Bereichen wie Datenwissenschaft, Programmierung und Rechtsprechungsanalyse.

Um den o1 Pro-Modus nutzen zu können, brauchst du ein Abonnement für ChatGPT Pro. Dieses Abonnement ermöglicht dir die unbegrenzte Nutzung des o1 und des o1 pro-Modus sowie anderer fortschrittlicher Modelle und Funktionen.

Wir haben den o1 pro-Modus in einem separaten Artikel ausführlich behandelt: Was ist der O1 Pro-Modus von OpenAI? Funktionen, ChatGPT Pro & Mehr.

Beschränkungen von OpenAI o1

OpenAI o1-preview bietet zwar beeindruckende Möglichkeiten, aber es gibt auch ein paar Einschränkungen, die du beachten solltest. Diese Einschränkungen können seine Nützlichkeit in bestimmten Kontexten beeinträchtigen, weshalb es sich lohnt, die folgenden Dinge zu beachten.

Verborgene Gedankenkette

Um das Potenzial für künftige Überwachungs- und Sicherheitsverbesserungen zu gewährleisten, ist der rohe Denkkettenprozess, den o1 verwendet, für die Nutzer/innen nicht direkt sichtbar. Diese Entscheidung zielt zwar darauf ab, eine effektivere Überwachung des Modells zu ermöglichen, aber sie schränkt die Transparenz ein und könnte das Verständnis der Nutzer für den Entscheidungsprozess des Modells beeinträchtigen.

Er surft noch nicht im Internet

OpenAI o1-preview kann das Internet nicht durchsuchen, was bedeutet, dass die Informationen, die es liefert, nicht immer aktuell sind. Wenn du nach Echtzeit- oder aktuellen Ereignisdaten suchst, kann das Modell diese nicht direkt abrufen.

Längere Reaktionszeiten

Eine der auffälligsten Einschränkungen ist, dass das Modell relativ lange braucht, um komplexe Abfragen zu verarbeiten. Diese zusätzliche Zeit erlaubt es zwar, durchdachtere Antworten zu geben, aber es kann zu Verzögerungen bei den Nutzern führen, die schnellere Antworten erwarten.

Ungeeignet für Anwendungen mit niedriger Latenzzeit

Aufgrund der langsameren Reaktionszeiten ist OpenAI o1 nicht ideal für Anwendungen, die schnelle Interaktionen erfordernwie z. B. Echtzeit-Chatbots oder Übersetzungsdienste. In diesen Anwendungsfällen kann die Verzögerung zu einem schlechten Nutzererlebnis führen, da das Warten auf eine Antwort mehrere Sekunden lang frustrierend sein kann.

Wenn das Modell in Situationen angewendet wird, in denen seine Stärken nicht mit der Aufgabe übereinstimmen, kann es zu einem negativen Nutzererlebnis führen. Das gilt vor allem für Szenarien, die eine schnelle Reaktion erfordern, bei denen die langsamere Verarbeitungszeit des Modells eher ein Hindernis als ein Vorteil ist.

OpenAI o1 Sicherheit

Die neuen o1-Modelle verfügen über einen Sicherheitstrainingsansatz, der ihre Denkfähigkeiten für mehr Sicherheit im Kontext nutzt.

Eine wichtige Sicherheitsmaßnahme ist die Prüfung der Widerstandsfähigkeit des Modells gegen "Jailbreaking"-Versuchebei dem die Benutzer versuchen, die Sicherheitsregeln zu umgehen. In einem anspruchsvollen Jailbreaking-Test erzielte GPT-4o 22 von 100 Punkten, während das neuere o1-Preview-Modell 84 Punkte erreichte, was eine deutliche Verbesserung darstellt.

Die Sicherheitsbemühungen wurden durch rigorose Tests, interne Steuerungund die Zusammenarbeit mit der Bundesregierung. Dazu gehört die Verwendung des Preparedness FrameworkRed Teaming und Überprüfungen auf Vorstandsebene durch den Ausschuss für Sicherheit und Gefahrenabwehr.

Außerdem gibt es Partnerschaften mit den USA und dem Vereinigten Königreich. Es wurden KI-Sicherheitsinstitute gegründet, die einen frühen Zugang zu den Forschungsversionen der Modelle erhalten.

Dennoch ist es wichtig, diese ersten Ergebnisse mit vorsichtigem Optimismus zu betrachten.

Die Zukunft: OpenAI O-series

Die Einführung des OpenAI o1 markiert nicht nur ein neues Modell, sondern den Beginn einer neuen Serie: der OpenAI O-Serie. Dies signalisiert einen bewussten Wechsel in der strategischen Ausrichtung von OpenAI, der komplexe Denkfähigkeiten als Kernpunkt für die zukünftige KI-Entwicklung hervorhebt.

Die beeindruckenden ersten Ergebnisse von o1 und o1 pro mode, insbesondere die starke Leistung bei Benchmarks, die komplizierte Problemlösungen erfordern, deuten darauf hin, dass diese neue Serie sehr vielversprechend ist.

Da OpenAI die Fähigkeiten der Modelle der o-Serie weiter verfeinert und ausbaut, können wir uns auf eine Zukunft einstellen, in der KI eine noch aktivere Rolle in der wissenschaftlichen Forschung, der Softwareentwicklung und anderen Bereichen spielt, die fortgeschrittene kognitive Fähigkeiten erfordern.

Der Weg zur vollen Entfaltung des Potenzials der O-Serie ist jedoch nicht ohne Herausforderungen. Die rechenintensive Natur dieser Modelle und die einzigartigen Skalierungsbeschränkungen, die sie mit sich bringen, machen weitere Forschung und Entwicklung notwendig.

Fazit

Während wir die Ankunft von GPT-5 in diesem Jahr sehnsüchtig erwartet haben, überraschte uns OpenAI mit der Einführung von o1, einem Modell, das komplexe Schlussfolgerungen in den Vordergrund stellt.

Die ersten Erfolge von o1 bei einer Reihe von Benchmarks zeigen, dass es das Potenzial hat, anspruchsvolle Probleme in Bereichen wie Mathematik, Programmierung und wissenschaftlicher Forschung zu lösen.

Trotz seiner vielversprechenden Fähigkeiten befindet sich o1 noch in der Anfangsphase und steht vor Herausforderungen, wie z.B. der hohen Rechenintensität und der Notwendigkeit, die Sicherheit und den ethischen Einsatz zu erforschen.

FAQs

Was ist OpenAI o1, und wie unterscheidet es sich von anderen Modellen?

OpenAI o1 ist ein neues KI-Modell, das sich auf komplexe Denkaufgaben wie Mathematik, Codierung und Puzzles konzentriert. Es nutzt das Prinzip der Gedankenkette, um Probleme aufzuschlüsseln, was die Genauigkeit im Vergleich zu älteren Modellen wie GPT-4 verbessert.

Welche Aufgaben können die OpenAI o1 Modelle besonders gut erledigen?

OpenAI o1 eignet sich hervorragend für mathematische Probleme, Programmieraufgaben, Datenanalysen und wissenschaftliche Aufgaben, die mehrstufiges Denken erfordern.

Wie kann ich auf OpenAI o1 zugreifen?

Du kannst über ChatGPT auf OpenAI o1 zugreifen, und Entwickler können über die API von OpenAI darauf zugreifen.

Was ist der Unterschied zwischen OpenAI o1 und o1-mini?

o1-mini ist eine kleinere Version von o1, die besser für leichtere Aufgaben geeignet ist, aber weniger Leistung für komplexe Schlussfolgerungen hat.

Welche Funktionen werden in zukünftigen Updates für die OpenAI o1 Modelle erwartet?

Wie hoch sind die Preise für die Nutzung der OpenAI o1-Modelle?

Die Preise für die o1-Modelle sind nutzungsabhängig und hängen von dem jeweiligen Modell und der Anzahl der verarbeiteten Token ab.

- Für o1-preview betragen die Kosten 15,00 $ pro 1 Million Input-Token und 60,00 $ pro 1 Million Output-Token.

- Für o1-mini betragen die Kosten 3,00 $ pro 1 Million Input-Token und 12,00 $ pro 1 Million Output-Token.

- Es ist wichtig, daran zu denken, dass die Gesamtzahl der Token sowohl sichtbare Fertigstellungs-Token als auch unsichtbare Argumentations-Token enthält, die zu den Gesamtkosten beitragen.

Author

Richie hilft Einzelpersonen und Organisationen dabei, Daten und KI besser zu nutzen. Er war schon Datenwissenschaftler, bevor es Data Science hieß, und hat zwei Bücher geschrieben und viele DataCamp-Kurse zu diesem Thema veranstaltet. Er ist Gastgeber des DataFramed-Podcasts und leitet das DataCamp-Webinarprogramm.

Author

Josef Waples