Curso

Modelos de linguagem grandes (LLMs) continuam crescendo em complexidade e tamanho, e sua implementação apresenta desafios significativos.

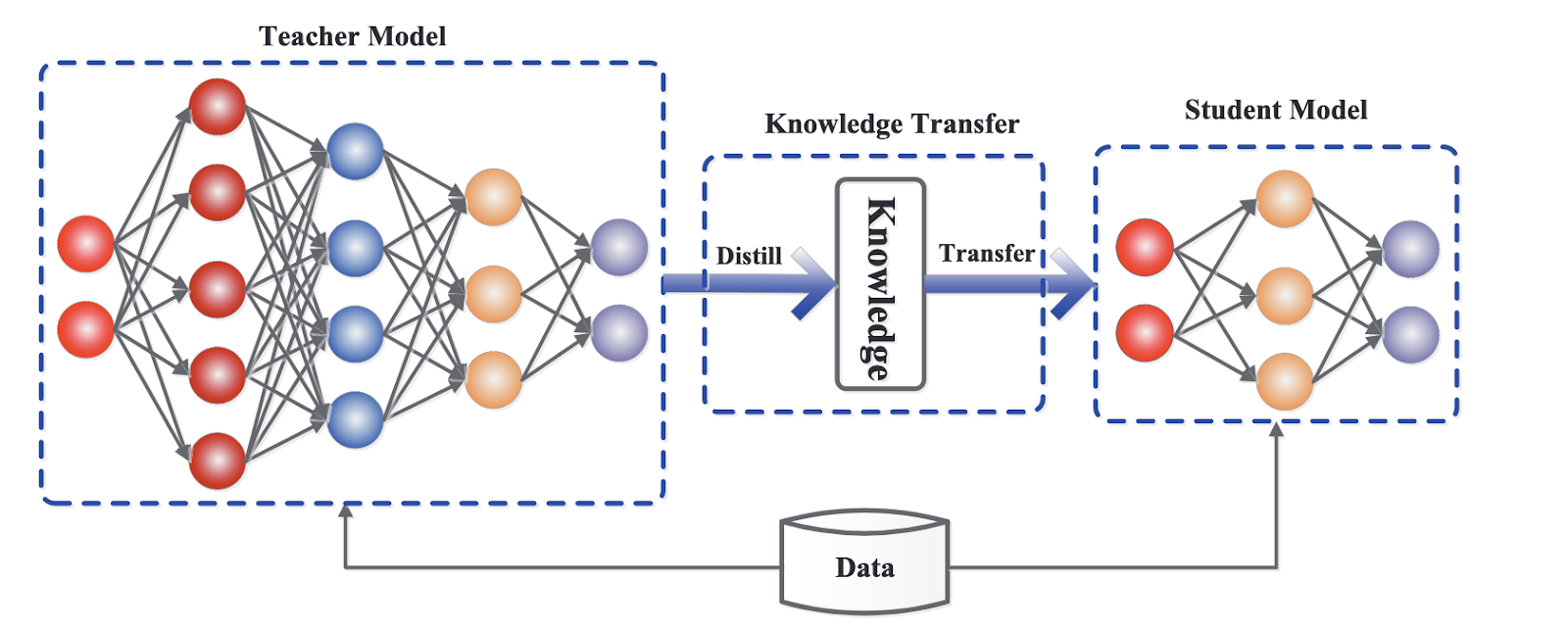

Destilação de LLM surge como uma solução poderosa para esse problema, permitindo a transferência de conhecimento de um modelo de linguagem maior e mais complexo (o "professor") para uma versão menor e mais eficiente (o "aluno").

Um exemplo recente no mundo da IA é a destilação de GPT-4o mini (estudante) do GPT-4o (professor).

Esse processo pode ser comparado a um professor que transmite sabedoria a um aluno, onde o objetivo é destilar o conhecimento essencial sem a bagagem pesada da complexidade do modelo maior. Vamos descobrir mais!

O que é a destilação do LLM?

A destilação de LLM é uma técnica que busca replicar o desempenho de um modelo de linguagem grande e, ao mesmo tempo, reduzir seu tamanho e as demandas computacionais.

Imagine um professor experiente compartilhando seus conhecimentos com um novo aluno. O professor, representando o modelo do professor, transmite conceitos e percepções complexas, enquanto o modelo do aluno aprende a imitar esses ensinamentos de maneira mais simplificada e eficiente.

Esse processo não apenas retém as competências essenciais do professor, mas também otimiza o aluno para aplicações mais rápidas e versáteis.

Por que a destilação do LLM é importante?

O tamanho crescente e os requisitos computacionais dos grandes modelos de linguagem impedem sua ampla adoção e implementação. O hardware de alto desempenho e o aumento do consumo de energia geralmente limitam a acessibilidade desses modelos, principalmente em ambientes com recursos limitados, como dispositivos móveis ou plataformas de computação de ponta.

A destilação do LLM aborda esses desafios produzindo modelos menores e mais rápidos, o que os torna ideais para a integração em uma gama mais ampla de dispositivos e plataformas.

Essa inovação não apenas democratiza o acesso à IA avançada, mas também oferece suporte a aplicativos em tempo real em que a velocidade e a eficiência são altamente valorizadas. Ao possibilitar soluções de IA mais acessíveis e dimensionáveis, a destilação do LLM ajuda a promover a implementação prática das tecnologias de IA.

Como funciona a destilação do LLM: O processo de transferência de conhecimento

O processo de destilação do LLM envolve várias técnicas que garantem que o modelo do aluno retenha informações importantes e opere com mais eficiência. Aqui, exploramos os principais mecanismos que tornam essa transferência de conhecimento eficaz.

Paradigma professor-aluno

O paradigma professor-aluno está no centro da destilação do LLM, um conceito fundamental que impulsiona o processo de transferência de conhecimento. Nessa configuração, um modelo maior e mais avançado transmite seu conhecimento a um modelo menor e mais leve.

O modelo do professor, geralmente um modelo de linguagem de última geração com treinamento extensivo e recursos computacionais, serve como uma fonte rica de informações. Por outro lado, o aluno é projetado para aprender com o professor, imitando seu comportamento e internalizando seu conhecimento.

A principal tarefa do modelo do aluno é replicar os resultados do professor, mantendo um tamanho muito menor e requisitos computacionais reduzidos. Esse processo envolve a observação e o aprendizado do aluno com as previsões, os ajustes e as respostas do professor a várias informações.

Dessa forma, o aluno pode atingir um nível comparável de desempenho e compreensão, o que o torna adequado para implantação em ambientes com recursos limitados.

Técnicas de destilação

Várias técnicas de destilação são empregadas para transferir conhecimento do professor para o aluno. Esses métodos garantem que o modelo do aluno não apenas aprenda com eficiência, mas também retenha o conhecimento e os recursos essenciais do modelo do professor. Aqui estão algumas das técnicas mais importantes usadas na destilação de LLM.

Destilação de conhecimento (KD)

Uma das técnicas mais importantes na destilação de LLM é a destilação de conhecimento (KD). No KD, o modelo do aluno é treinado usando as probabilidades de saída do modelo do professor, conhecidas como soft targets, juntamente com os rótulos da verdade terrestre, chamados de hard targets.

As metas flexíveis fornecem uma visão diferenciada das previsões do professor, oferecendo uma distribuição de probabilidade sobre possíveis resultados em vez de uma única resposta correta. Essas informações adicionais ajudam o modelo do aluno a captar os padrões sutis e o conhecimento complexo codificado nas respostas do professor.

Ao usar metas flexíveis, o modelo do aluno pode entender melhor o processo de tomada de decisão do professor, o que leva a um desempenho mais preciso e confiável. Essa abordagem não apenas preserva o conhecimento crítico do professor, mas também permite um processo de treinamento mais suave e eficaz para o aluno.

Estrutura genérica para destilação de conhecimento. Fonte

Outras técnicas de destilação

Além do KD, várias outras técnicas podem melhorar o processo de destilação do LLM:

- Aumento de dados: Isso envolve a geração de dados de treinamento adicionais usando o modelo do professor. Ao criar um conjunto de dados maior e mais abrangente, o aluno pode ser exposto a uma gama mais ampla de cenários e exemplos, melhorando seu desempenho de generalização.

- Destilação em camada intermediária: Em vez de se concentrar apenas nos resultados finais, esse método transfere o conhecimento das camadas intermediárias do modelo do professor para o aluno. Ao aprender com essas representações intermediárias, o aluno pode captar informações mais detalhadas e estruturadas, o que leva a um melhor desempenho geral.

- Destilação para vários professores: Um modelo de aluno pode se beneficiar do aprendizado com vários modelos de professores. Ao agregar o conhecimento de vários professores, o aluno pode obter uma compreensão mais abrangente e maior robustez, pois integra diferentes perspectivas e percepções.

Benefícios da destilação do LLM

A destilação de LLM oferece uma série de benefícios consideráveis que desenvolvem a usabilidade e a eficiência dos modelos de linguagem, tornando-os mais práticos para diversas aplicações.

Aqui, exploramos algumas das principais vantagens.

Tamanho reduzido do modelo

Um dos principais benefícios da destilação do LLM é a criação de modelos visivelmente menores. Ao transferir o conhecimento de um modelo de professor grande para um modelo de aluno menor, o aluno resultante retém grande parte dos recursos do professor, embora tenha uma fração do seu tamanho.

Essa redução no tamanho do modelo leva a:

- Inferência mais rápida: Modelos menores processam dados mais rapidamente, o que resulta em tempos de resposta mais rápidos.

- Redução dos requisitos de armazenamento: Os modelos menores ocupam menos espaço, o que facilita o armazenamento e o gerenciamento, especialmente em ambientes com capacidade de armazenamento limitada.

Velocidade de inferência aprimorada

O tamanho menor dos modelos destilados se traduz diretamente em maior velocidade de inferência. Isso é particularmente importante para aplicativos que exigem processamento em tempo real e respostas rápidas.

Veja como esse benefício se manifesta:

- Aplicativos em tempo real: Velocidades de inferência mais rápidas tornam viável a implantação de modelos destilados em aplicativos em tempo real, como chatbots, assistentes virtuais e sistemas interativos em que a latência é um fator vital.

- Dispositivos com recursos limitados: Os modelos destilados podem ser implantados em dispositivos com recursos computacionais limitados, como smartphones, tablets e dispositivos de bordasem comprometer o desempenho.

Custos computacionais mais baixos

Outra vantagem notável da destilação LLM é a redução dos custos computacionais. Modelos menores exigem menos poder computacional para serem executados, o que resulta em economia de custos em várias áreas:

- Ambientes de nuvem: Executar modelos menores em ambientes de nuvem reduz a necessidade de hardware caro e de alto desempenho e diminui o consumo de energia.

- Implantações no local: Modelos menores significam menores custos de infraestrutura e despesas de manutenção para organizações que preferem implementações no local.

Acessibilidade e implementação mais amplas

Os LLMs destilados são mais versáteis e acessíveis, permitindo a implementação em várias plataformas. Esse alcance ampliado tem várias implicações:

- Dispositivos móveis: Os modelos destilados podem ser implantados em dispositivos móveis, permitindo recursos avançados de IA em formatos portáteis e fáceis de usar.

- Dispositivos de borda: A capacidade de execução em dispositivos de borda aproxima os recursos de IA do local onde os dados são gerados, reduzindo a necessidade de conectividade constante e aumentando a privacidade dos dados.

- Aplicações mais amplas: Do setor de saúde ao financeiro e à educação, os modelos destilados podem ser integrados a uma infinidade de aplicativos, tornando a IA avançada acessível a mais setores e usuários.

Aplicações de LLMs destilados

Os benefícios da destilação LLM vão muito além da eficiência do modelo e da economia de custos. Os modelos de linguagem destilados podem ser aplicados em uma ampla gama de processamento de linguagem natural (NLP) e casos de uso específicos do setor, tornando as soluções de IA acessíveis em vários campos.

Tarefas eficientes de PNL

Os LLMs destilados são excelentes em muitas tarefas de processamento de linguagem natural. Seu tamanho reduzido e desempenho aprimorado os tornam ideais para tarefas que exigem processamento em tempo real e menor potência computacional.

Chatbots

Os LLMs destilados permitem o desenvolvimento de chatbots menores e mais rápidos chatbots menores e mais rápidos que podem lidar facilmente com tarefas de atendimento e suporte ao cliente. Esses chatbots podem entender e responder às consultas dos usuários em tempo real, proporcionando uma experiência perfeita ao cliente sem a necessidade de computação extensiva.

Resumo de texto

As ferramentas de resumo alimentadas por LLMs destilados podem condensar artigos de notícias, documentos ou feeds de mídia social em resumos concisos. Isso ajuda os usuários a entender rapidamente os pontos principais sem precisar ler textos longos.

Tradução automática

Os modelos destilados tornam os serviços de tradução mais rápidos e mais acessíveis em todos os dispositivos. Eles podem ser implantados em telefones celulares, tablets e até mesmo em aplicativos off-line, fornecendo tradução em tempo real com latência e sobrecarga computacional reduzidas.

Outras tarefas

Os LLMs destilados não são apenas valiosos para tarefas comuns de PNL, mas também se destacam em áreas especializadas que exigem processamento rápido e resultados precisos.

- Análise de sentimento: Analisar o sentimento dos textoscomo avaliações ou publicações em mídias sociais, torna-se mais fácil e rápida com modelos destilados, permitindo que as empresas avaliem rapidamente a opinião pública e o feedback dos clientes.

- Resposta à pergunta: Os modelos destilados podem alimentar sistemas que respondem às perguntas dos usuários com precisão e rapidez, ampliando a experiência do usuário em aplicativos como assistentes virtuais e ferramentas educacionais.

- Geração de texto: A criação de textos coerentes e contextualmente relevantes, seja para criação de conteúdo, narração de histórias ou geração automatizada de relatórios, é simplificada com LLMs destilados.

Casos de uso do setor

Os LLMs destilados não se limitam apenas a tarefas gerais de PNL. Eles também podem afetar muitos setores, melhorando os processos e as experiências dos usuários e impulsionando a inovação.

Cuidados com a saúde

No setor setor de saúdeos LLMs destilados podem processar registros de pacientes e dados de diagnóstico com mais eficiência, permitindo diagnósticos mais rápidos e precisos. Esses modelos podem ser implantados em dispositivos médicos, dando suporte a médicos e profissionais de saúde com análise de dados em tempo real e tomada de decisões.

Finanças

O setor setor financeiro se beneficia de modelos destilados por meio de sistemas de detecção de fraudes e modelos de interação com o cliente. Ao decifrar rapidamente os padrões de transações e as consultas dos clientes, os LLMs destilados ajudam a evitar atividades fraudulentas e fornecem consultoria e suporte financeiro personalizados.

Educação

Em educaçãoNa educação, os LLMs destilados facilitam a criação de sistemas de aprendizagem adaptáveis e plataformas de tutoria personalizadas. Esses sistemas podem analisar o desempenho dos alunos e oferecer conteúdo educacional personalizado, melhorando os resultados do aprendizado e tornando a educação mais acessível e impactante.

Implementação da destilação LLM

A implementação da destilação do LLM envolve uma série de etapas e o uso de estruturas e bibliotecas especializadas projetadas para facilitar o processo. Aqui, exploramos as ferramentas e as etapas necessárias para destilar um grande modelo de linguagem.

Estruturas e bibliotecas

Para simplificar o processo de destilação, estão disponíveis algumas estruturas e bibliotecas, cada uma oferecendo recursos exclusivos para dar suporte à destilação do LLM.

Transformadores Hugging Face

A biblioteca de transformadores Biblioteca de transformadores Hugging Face é uma ferramenta popular para implementar a destilação LLM. Ele inclui uma classe Distiller que simplifica o processo de transferência de conhecimento de um modelo de professor para um modelo de aluno .

Usando a classe Distiller, os profissionais podem aproveitar modelos pré-treinados, ajustá-los em conjuntos de dados específicos e empregar técnicas de destilação para obter resultados ideais.

Outras bibliotecas

Além dos Hugging Face Transformers, muitas outras bibliotecas oferecem suporte à destilação LLM:

- Otimização do modelo TensorFlow: Essa biblioteca oferece ferramentas de poda, quantização e destilação de modelos, o que a torna uma opção versátil para a criação de modelos.

- PyTorch destilador: O PyTorch

Distillerfoi projetado para compactar modelos de aprendizagem profunda, incluindo suporte para técnicas de destilação. Ele oferece uma variedade de utilitários para gerenciar o processo de destilação e melhorar a eficiência do modelo. - DeepSpeed: Desenvolvido pela Microsoft, o DeepSpeed é uma biblioteca de otimização de aprendizagem profunda que inclui recursos para destilação de modelos, permitindo o treinamento e a implantação de modelos grandes.

Etapas envolvidas

A implementação da destilação do LLM requer planejamento e execução cuidadosos. Aqui estão as principais etapas envolvidas no processo.

Preparação de dados

A primeira etapa do processo de destilação é preparar um conjunto de dados adequado para treinar o modelo do aluno. O conjunto de dados deve ser representativo das tarefas que o modelo executará, garantindo que o modelo do aluno aprenda a generalizar bem.

As técnicas de aumento de dados também podem aprimorar o conjunto de dados, fornecendo ao modelo do aluno uma gama mais ampla de exemplos para aprender.

Seleção do modelo do professor

Para que a destilação seja bem-sucedida, é necessário selecionar um modelo de professor adequado. O modelo do professor deve ser um modelo pré-treinado de bom desempenho, com um alto nível de precisão nas tarefas de destino. A qualidade e os atributos do modelo do professor influenciam diretamente o desempenho do modelo do aluno.

Processo de destilação

O processo de destilação envolve as seguintes etapas:

- Configuração do treinamento: Inicialize o modelo do aluno e configure o ambiente de treinamento, incluindo hiperparâmetros, como taxa de aprendizado e tamanho do lote.

- Transferência de conhecimento: Use o modelo do professor para gerar metas flexíveis (distribuições de probabilidade) para os dados de treinamento. Esses alvos flexíveis, juntamente com os alvos rígidos (rótulos de verdade terrestre), são usados para treinar o modelo do aluno.

- Circuito de treinamento: Treine o modelo do aluno usando uma combinação de alvos suaves e alvos difíceis. O objetivo é minimizar a função de perda, que mede a diferença entre as previsões do modelo do aluno e as metas flexíveis fornecidas pelo modelo do professor.

Métricas de avaliação

A avaliação do desempenho do modelo destilado é essencial para garantir que ele atenda aos critérios desejados. As métricas de avaliação comuns incluem:

- Precisão: Uma medida da porcentagem de previsões corretas feitas pelo modelo do aluno em comparação com a verdade básica.

- Velocidade de inferência: Avalia o tempo que o modelo do aluno leva para processar entradas e gerar saídas.

- Tamanho do modelo: Avalie a redução no tamanho do modelo e os benefícios associados em termos de armazenamento e eficiência computacional.

- Utilização de recursos: Monitora os recursos computacionais exigidos pelo modelo do aluno durante a inferência, confirmando se ele atende às restrições do ambiente de implantação.

Falo mais detalhadamente sobre a avaliação do LLM neste artigo em Avaliação do LLM: Métricas, metodologias, práticas recomendadas.

Destilação do LLM: Desafios e práticas recomendadas

Embora a destilação do LLM ofereça inúmeros benefícios, ela também apresenta vários desafios que devem ser abordados para garantir uma implementação bem-sucedida.

Perda de conhecimento

Um dos principais obstáculos na destilação do LLM é a possibilidade de perda de conhecimento. Durante o processo de destilação, algumas das informações e recursos diferenciados do modelo do professor podem precisar ser totalmente capturados pelo modelo do aluno, o que leva a uma redução no desempenho. Esse problema pode ser particularmente acentuado em tarefas que exigem compreensão profunda ou conhecimento especializado.

Aqui estão algumas estratégias que podemos implementar para mitigar a perda de conhecimento:

- Destilação em camada intermediária: A transferência de conhecimento de camadas intermediárias do modelo do professor pode ajudar o modelo do aluno a capturar informações mais detalhadas e estruturadas.

- Aumento de dados: O uso de dados aumentados gerados pelo modelo do professor pode fornecer ao modelo do aluno uma gama mais ampla de exemplos de treinamento, ajudando seu processo de aprendizado.

- Destilação iterativa: O refinamento do modelo do aluno por meio de várias rodadas de destilação pode fazer com que ele capture progressivamente mais conhecimento do professor.

Ajuste de hiperparâmetros

O ajuste cuidadoso dos hiperparâmetros é essencial para o sucesso do processo de destilação. Os principais hiperparâmetros, como a temperatura e a taxa de aprendizado, influenciam significativamente a capacidade do modelo do aluno de aprender com o professor:

- Temperatura: Esse parâmetro controla a suavidade da distribuição de probabilidade gerada pelo modelo do professor. Temperaturas mais altas produzem distribuições de probabilidade mais suaves, o que pode ajudar o modelo do aluno a aprender mais detalhadamente com as previsões do professor.

- Taxa de aprendizado: O ajuste da taxa de aprendizado é essencial para equilibrar a velocidade e a estabilidade do processo de treinamento. Uma taxa de aprendizado adequada garante que o modelo do aluno converge para uma solução ideal sem se ajustar demais ou de menos.

Avaliação da eficácia

A avaliação da eficácia do modelo destilado é uma etapa indispensável para garantir que ele atenda aos critérios de desempenho desejados, especialmente em relação a seus predecessores e alternativas. Isso envolve a comparação do desempenho do aluno com o do professor e outras linhas de base para entender até que ponto o processo de destilação preservou ou avançou a funcionalidade do modelo.

Para avaliar a eficácia do modelo destilado, é importante que você se concentre nas seguintes métricas:

- Precisão: Meça como a precisão do modelo do aluno se compara ao modelo do professor e a outras linhas de base, fornecendo informações sobre qualquer perda ou retenção de precisão.

- Velocidade de inferência: Compare a velocidade de inferência do modelo do aluno com o modelo do professor, destacando as melhorias no tempo de processamento.

- Tamanho do modelo: Avalie as diferenças no tamanho do modelo entre os modelos do aluno e do professor, bem como outras linhas de base, para avaliar os ganhos de eficiência da destilação.

- Utilização de recursos: Analise como o uso de recursos do modelo do aluno se compara ao do modelo do professor, garantindo que o modelo do aluno ofereça uma alternativa mais econômica sem comprometer o desempenho.

Práticas recomendadas

A adesão às práticas recomendadas pode aumentar a eficácia da destilação do LLM. Essas diretrizes enfatizam a experimentação, a avaliação contínua e a implementação estratégica.

- Experimentação: Experimente regularmente diferentes técnicas de destilação e configurações de hiperparâmetros para identificar as melhores configurações para seu caso de uso específico.

- Avaliação contínua: Avalie continuamente o desempenho do modelo do aluno usando benchmarks e conjuntos de dados relevantes. Testes e refinamentos iterativos são fundamentais para que você obtenha os melhores resultados.

- Treinamento equilibrado: Verifique se um processo de treinamento equilibrado está sendo implementado, combinando metas flexíveis do modelo do professor com metas rígidas. Essa abordagem ajuda o modelo do aluno a captar conhecimentos diferenciados e, ao mesmo tempo, manter a precisão.

- Atualizações regulares: Mantenha-se informado sobre os últimos avanços na pesquisa de destilação de LLM e incorpore novas técnicas e descobertas em seu processo de destilação.

Pesquisa e direções futuras

O campo da destilação de LLM está evoluindo rapidamente. Esta seção explora as últimas tendências, os desafios atuais de pesquisa e as técnicas emergentes na destilação de LLM.

Pesquisas e avanços mais recentes

Pesquisas recentes em destilação LLM se concentraram no desenvolvimento de novas técnicas e arquiteturas para aumentar a eficiência e a eficácia do processo de destilação. Alguns avanços notáveis incluem:

- Destilação progressiva: Isso envolve a destilação do conhecimento em etapas, em que os modelos intermediários dos alunos são progressivamente destilados a partir do modelo do professor. Essa técnica tem se mostrado promissora para melhorar o desempenho e a estabilidade do modelo final do aluno.

- Destilação com diagnóstico de tarefas: Os pesquisadores estão explorando métodos para destilar o conhecimento de uma maneira independente da tarefa, permitindo que o modelo do aluno se generalize em diferentes tarefas sem exigir um ajuste fino específico da tarefa. ajuste fino. Essa abordagem pode reduzir bastante o tempo de treinamento e os recursos computacionais necessários para novos aplicativos.

- Destilação intermodal: Outra área emergente é a destilação do conhecimento em diferentes modalidades, como texto, imagens e áudio. A destilação multimodal tem como objetivo criar modelos versáteis de alunos que possam lidar com vários tipos de dados de entrada, expandindo a aplicabilidade dos modelos destilados.

Problemas em aberto e direções futuras

Apesar do progresso significativo, vários desafios e questões de pesquisa em aberto permanecem no campo da destilação LLM:

- Aprimorando a generalização: Um dos principais desafios é melhorar a capacidade de generalização dos modelos destilados. Garantir que os modelos dos alunos tenham um bom desempenho em uma variedade de tarefas e conjuntos de dados continua sendo uma área de pesquisa em andamento.

- Transferência de conhecimento entre domínios: A transferência eficaz de conhecimento entre diferentes domínios é outra área crítica. O desenvolvimento de métodos para destilar o conhecimento que pode ser aplicado a domínios novos e distintos sem perda significativa de desempenho é um objetivo importante.

- Escalabilidade: O dimensionamento das técnicas de destilação para lidar com modelos e conjuntos de dados cada vez maiores de forma eficiente é um desafio persistente. A pesquisa está concentrada na otimização do processo de destilação para torná-lo mais escalável.

Técnicas emergentes

Técnicas e inovações emergentes estão sendo desenvolvidas continuamente para enfrentar esses desafios e impulsionar o campo. Algumas abordagens promissoras são:

- Adaptações de aprendizado com zero e poucos disparos: A integração de recursos de aprendizado de zero e poucos disparos em modelos destilados é uma área de pesquisa em expansão. Essas técnicas permitem que os modelos executem tarefas com poucos ou nenhum dado de treinamento específico para a tarefa, aumentando sua versatilidade e praticidade.

- Autodestilação: Na autodestilação, o modelo do aluno é treinado usando suas previsões como metas flexíveis. Essa abordagem pode melhorar o desempenho e a robustez do modelo usando o conhecimento adquirido de forma iterativa.

- Destilação adversária: A combinação de treinamento contraditório com técnicas de destilação é outra abordagem inovadora. A destilação adversarial envolve o treinamento do modelo do aluno não apenas para imitar o professor, mas também para ser robusto contra ataques adversáriosmelhorando sua segurança e confiabilidade.

Conclusão

A destilação de LLM é uma técnica essencial para tornar modelos de linguagem grandes mais práticos e eficientes. Ao transferir o conhecimento essencial de um modelo de professor complexo para um modelo de aluno menor, a destilação preserva o desempenho e reduz o tamanho e as demandas computacionais.

Esse processo permite aplicativos de IA mais rápidos e acessíveis em vários setores, desde tarefas de PNL em tempo real até casos de uso especializado em saúde e finanças. A implementação da destilação do LLM envolve um planejamento cuidadoso e as ferramentas certas, mas os benefícios - como custos mais baixos e implantação mais ampla - são substanciais.

À medida que a pesquisa continua avançando, a destilação do LLM desempenhará um papel cada vez mais importante na democratização da IA, tornando os modelos avançados mais acessíveis e utilizáveis em diversos contextos.