Curso

PySpark é a API Python para o Apache Spark, projetada para processamento de dados paralelos e distribuídos em clusters. A escolha da operação de união correta para suas necessidades afeta a velocidade do trabalho, o consumo de recursos e o sucesso geral.

Trabalhar com conjuntos de dados extensos geralmente significa integrar dados de várias fontes. A combinação eficaz dessas informações é essencial para uma análise precisa e insights significativos. As uniões do PySpark oferecem maneiras eficientes de combinar conjuntos de dados separados com base em chaves compartilhadas.

No entanto, uniões ineficientes podem afetar gravemente a velocidade e a confiabilidade do processamento de dados ao lidar com grandes conjuntos de dados contendo milhões ou até bilhões de registros em clusters distribuídos.

Você já experimentou uniões que falham com análises lentas ou mesmo com dados em grande escala? Se for o caso, este guia é para você. Ele ajudará cientistas de dados, desenvolvedores e engenheiros intermediários a adquirir domínio e confiança ao realizar junções com o PySpark.

Se você está procurando alguns exercícios práticos para se familiarizar com o PySpark, confira nossa Programa de habilidades em Big Data com PySpark.

O que são junções do PySpark?

Como você descobrirá em nosso artigo Aprenda PySpark do zero um dos principais recursos do PySpark é a capacidade de mesclar grandes conjuntos de dados. As operações de junção do PySpark são essenciais para combinar grandes conjuntos de dados com base em colunas compartilhadas, permitindo integração, comparação e análise de dados eficientes em escala.

Eles desempenham um papel fundamental no manuseio de big data, ajudando a descobrir relacionamentos e a extrair insights significativos em fontes de dados distribuídas.

O PySpark oferece vários tipos de junções, como junções internas, junções externas, junções à esquerda e à direita, semijunções, e antijunçõescada uma servindo a diferentes propósitos analíticos.

No entanto, trabalhar com uniões em grandes conjuntos de dados pode apresentar desafios como dados distorcidos, sobrecarga de embaralhamento e restrições de memória, o que torna crucial a seleção da estratégia de união correta para desempenho e precisão.

Fundamentos do PySpark Joins

Entender as operações internas do PySpark é vital para unir grandes conjuntos de dados com eficiência, como mostramos em nosso Curso de introdução ao PySpark. Esta seção descreve a estrutura conceitual por trás da execução de junção do PySpark e a função do seu otimizador.

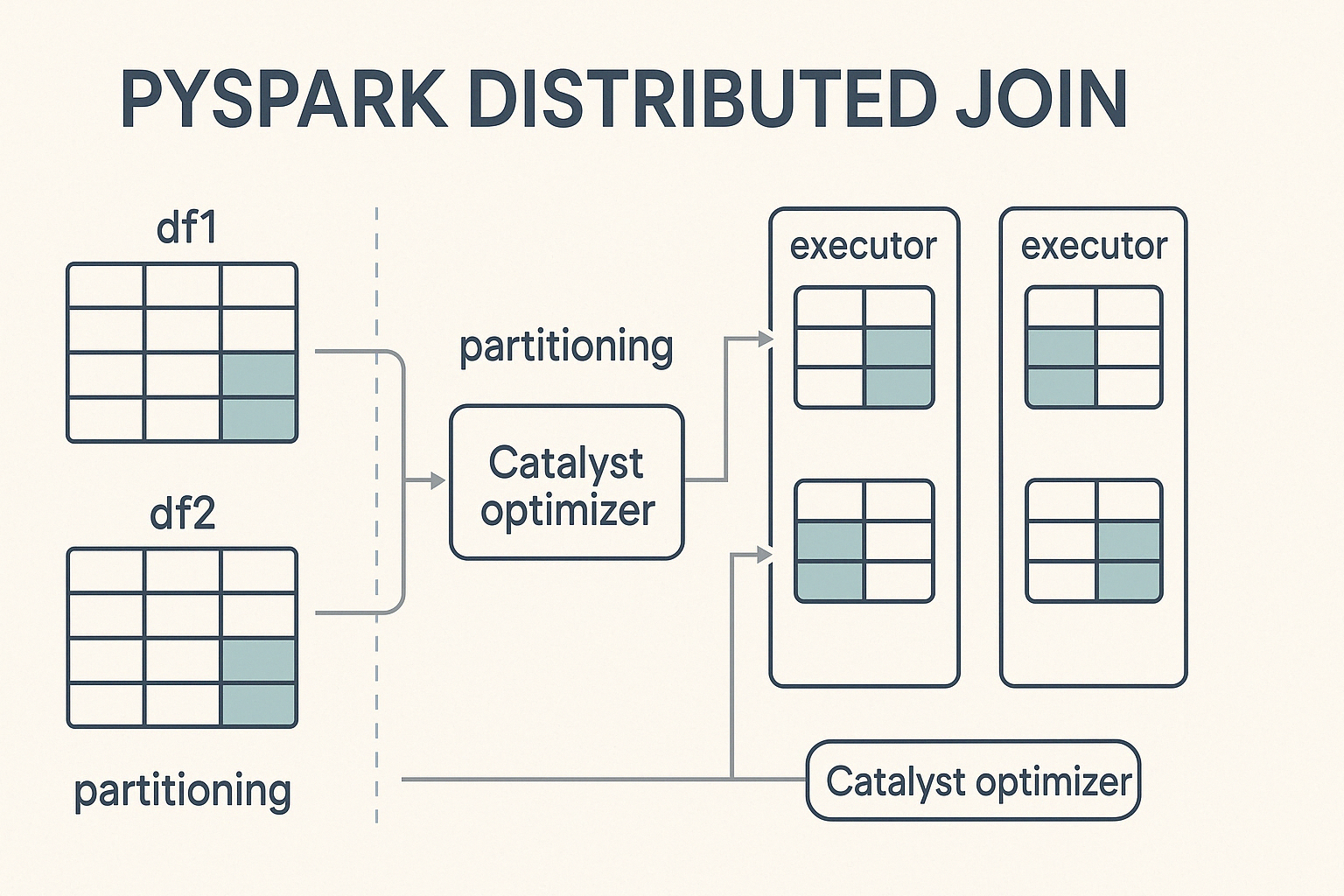

Estrutura conceitual

O PySpark realiza junções em um ambiente de computação distribuída, o que significa que ele divide grandes conjuntos de dados em partições menores e os processa em paralelo em um cluster de máquinas. Quando umaunião é acionada, o PySpark distribui o trabalho entre esses nós, visando a uma computação equilibrada para acelerar a execução e evitar gargalos.

No centro desse processo está o Catalyst, o poderoso mecanismo de otimização de consultas do Spark. O Catalyst determina como as operações de união são executadas. Ele decide estratégias de particionamento, detecta quando o embaralhamento de dados é necessário e aplica otimizações de desempenho, como pushdown de predicado e junções de broadcast. Essa otimização automatizada garante uma execução eficiente sem a necessidade de ajuste manual por parte do desenvolvedor.

Sintaxe de união principal

Para realizar uniões no PySpark, você segue uma sintaxe simples que envolve a especificação do parâmetro DataFrames, a condição de uniãoe o tipo de junção a ser executado.

from pyspark.sql import SparkSession

# Initialize Spark session

spark = SparkSession.builder.appName("PySpark Joins Example").getOrCreate()

# Perform a join

joined_df = df1.join(df2, on="key", how="inner")Neste exemplo:

df1edf2são os DataFrames a serem unidos.df1.key==df2.keyé a condição de união, determinando como as linhas de cada DataFrame devem ser combinadas.inner' specifies the join type, which could also beleft,right,,outer,semi, oranti` dependendo do resultado desejado.

Siga nosso tutorial Getting Started with PySpark para obter instruções sobre como instalar o PySpark e executar as junções acima sem erros.

Tipos e aplicativos de junção do PySpark

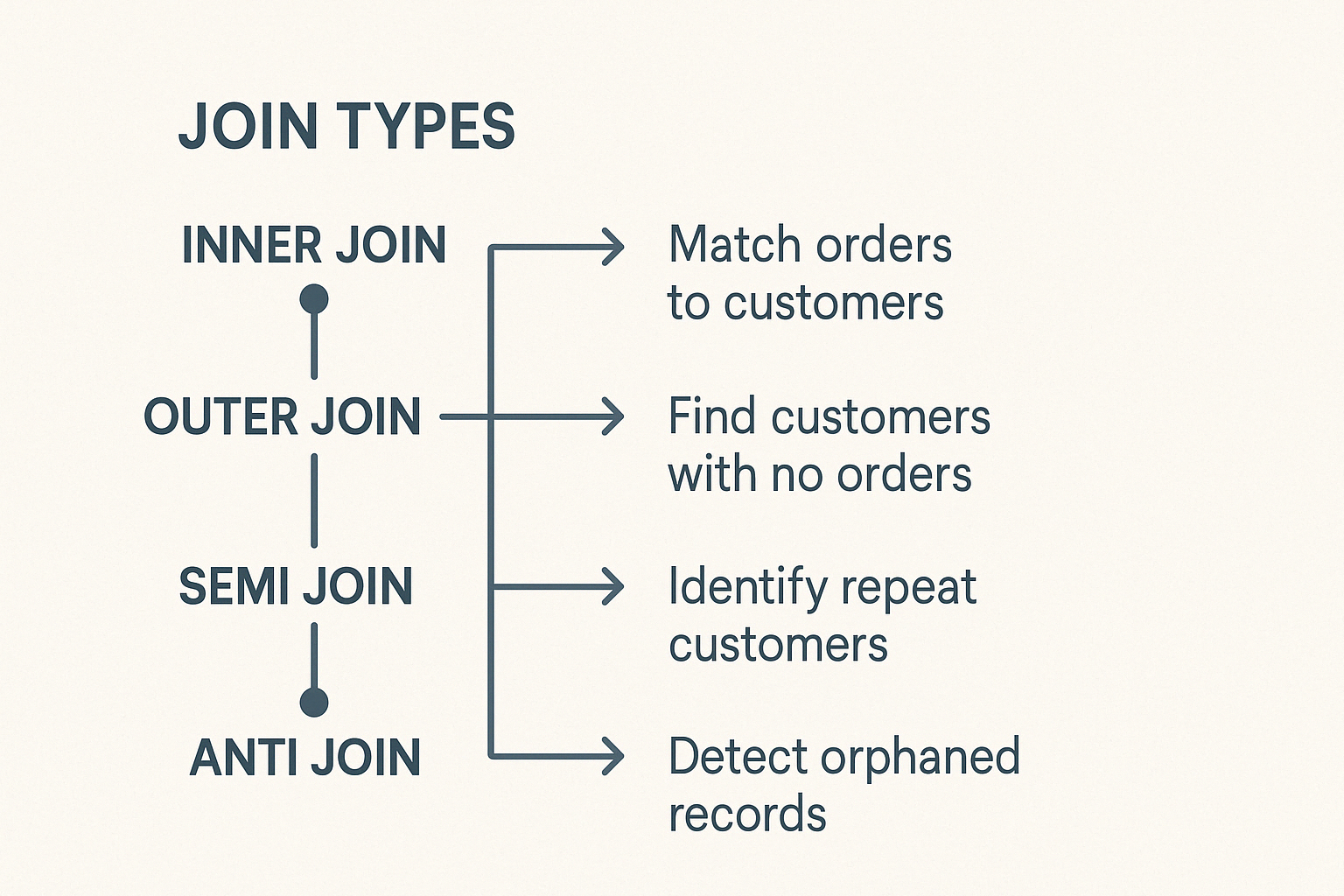

O PySpark inclui diferentes tipos de junções, cada uma adequada para tarefas de dados distintas. Entender isso ajuda você a escolher com sabedoria.

Uniões internas

A união interna combina linhas de dois DataFrames quando existem chaves correspondentes em ambos. As linhas sem chaves correspondentes serão excluídas. É o tipo de junção mais comum e padrão no PySpark.

Os cenários de uso típicos incluem:

- Corresponder pedidos de clientes a perfis de clientes para gerar relatórios analíticos precisos.

- Comparar com precisão conjuntos de dados de fontes diferentes.

Junções externas

O PySpark suporta junções externas à esquerda, à direita e completas.

A união externa esquerda retorna todas as linhas do DataFrame esquerdo e as linhas correspondentes do DataFrame direito. Quando nenhuma chave correspondente aparece no DataFrame direito, os valores nulos preenchem as colunas da direita.

Casos de uso:

- Encontrar clientes que não fizeram compras.

- Identificação de informações ausentes nos registros.

A união externa direita espelha a lógica da união esquerda. Ele retorna todas as linhas do DataFrame direito e as linhas correspondentes do DataFrame esquerdo, preenchendo as correspondências ausentes das colunas esquerdas com nulos.

Exemplo de cenário:

- Verificação de atribuições de categorias de produtos ou erros de rotulagem.

O Full Outer Join retorna todas as linhas disponíveis de ambos os DataFrames, preenchendo as entradas não correspondentes com nulos. Ele ajuda a identificar discrepâncias ou lacunas de dados entre dois conjuntos de dados.

Juntas especializadas: Semi e antijuntas

As semi e antijunções têm funções especializadas:

Uma semiconjunção retorna linhas do DataFrame esquerdo em que existem chaves correspondentes no DataFrame direito. Ele não adiciona colunas do DataFrame correto e evita duplicatas, o que o torna ideal para verificações de existência.

Exemplo de caso de uso:

- Verificar rapidamente os históricos de login dos usuários sem detalhes adicionais.

Um anti Join retorna linhas de um DataFrame que não têm chave correspondente no segundo DataFrame.

Exemplo de caso de uso:

- Encontrar registros órfãos ou validar a integridade dos dados.

As junções cruzadas criam dados ao emparelhar cada linha de um DataFrame com cada linha de outro. A menos que seja especificamente desejado, evite junções cruzadas, pois elas expandem drasticamente os conjuntos de dados.

Use-os com cautela em cenários específicos, como:

- Teste de combinações de parâmetros.

- Analisando todos os pares possíveis em configurações experimentais.

Técnicas de otimização para junções eficientes do PySpark

As uniões em grande escala exigem uma otimização cuidadosa. Considere as seguintes técnicas:

Estratégia de união de transmissão

As uniões por difusão melhoram o desempenho ao replicar DataFrames menores em todos os nós, eliminando embaralhamentos dispendiosos.

Exemplo de sintaxe:

from pyspark.sql.functions import broadcast

joined_df = large_df.join(broadcast(small_df), "id", "inner")Esteja ciente dos limites de memória do seu sistema; a transmissão de DataFrames excessivamente grandes não funcionará de forma eficaz.

Técnicas de atenuação de distorção

A distorção de dados significa que os dados não são distribuídos uniformemente entre as partições, o que cria gargalos. As técnicas para reduzir a distorção incluem:

- Salga de chaves: anexar prefixos aleatórios a chaves de junção altamente distorcidas para distribuição uniforme.

- Particionamento com reconhecimento de inclinação: O Spark equilibra automaticamente os dados entre as partições, gerenciando proativamente a distorção desde o início.

Estratégias de particionamento

O desempenho eficiente de junção no PySpark depende muito da minimização da sobrecarga de embaralhamento, que ocorre quando os dados precisam ser movidos entre os nós para satisfazer as condições de junção. Uma das maneiras mais eficazes de reduzir essa sobrecarga é alinhar as partições dos DataFrames que estão sendo unidos.

Práticas recomendadas para particionamento

Tenha em mente estas práticas recomendadas:

- Para minimizar a movimentação desnecessária de dados, particione os dois DataFrames usando a(s) mesma(s) coluna(s) usada(s) na condição de união.

- Evite colunas distorcidas: Não faça partições em colunas com poucos valores dominantes, pois isso leva a uma distribuição desequilibrada da carga de trabalho entre os nós.

- Use

repartition()oubroadcast()com sabedoria: Userepartition()para conjuntos de dados grandes em que a distribuição uniforme é possível, ebroadcast()para tabelas significativamente menores para evitar totalmente o embaralhamento. - Monitore o tamanho e a distribuição dos dados: Compreender as características subjacentes dos seus dados (por exemplo, cardinalidade e distribuição de frequência das chaves de junção) ajuda você a escolher a estratégia de particionamento mais equilibrada.

Estratégias avançadas de união com o PySpark e casos de uso

O PySpark inclui mecanismos especializados para casos mais exigentes, permitindo uma eficiência ainda maior:

Uniões de alcance

As uniões de intervalo são usadas para fazer a correspondência de linhas com base em condições numéricas ou baseadas em tempo, em vez de igualdade exata. Essas uniões são comuns em cenários que envolvem dados de séries temporais, como análise de registros, rastreamento de eventos ou fluxos de sensores de IoT.

As práticas recomendadas para uniões eficientes de faixas incluem:

- Minimizar a sobrecarga de embaralhamento: O particionamento adequado é essencial para evitar a movimentação dispendiosa de dados. Ao trabalhar com uniões de intervalos, considere a possibilidade de particionar os dados com base em janelas de tempo ou intervalos de valores relevantes para o seu caso de uso.

- Classifique os dados dentro das partições: A classificação dos dados pela chave de intervalo (por exemplo, carimbo de data/hora) antes de realizar a união pode melhorar o desempenho, especialmente ao usar operações como

rangeBetweenoubetween. - Evite varreduras de grande alcance: Mantenha os intervalos de junção tão estreitos quanto possível para reduzir o número de comparações e melhorar o tempo de execução.

- Utilize as funções de janela ou de agrupamento: Isso pode ajudar a reduzir as operações de embaralhamento e garantir um melhor alinhamento ao lidar com grandes conjuntos de dados e intervalos sobrepostos.

Exemplos de casos de uso incluem:

- Alinhamento dos dados da campanha de marketing com as interações do cliente em janelas de tempo.

- Fusão de dados de IoT ou de sensores capturados em intervalos sequenciais para detecção de anomalias ou análise de tendências.

Junções de streaming

A junção de dados de streaming apresenta desafios exclusivos devido à sua natureza contínua e, muitas vezes, imprevisível. Os principais problemas incluem eventos de chegada tardia, dados fora de ordem e a necessidade de gerenciar o estado com eficiência ao longo do tempo.

O PySpark aborda esses desafios usando marcas d'água, que definem um limite de quanto tempo o sistema deve esperar por dados atrasados antes de descartá-los. Ao definir uma marca d'água nas colunas de tempo de evento, o PySpark pode gerenciar com eficiência os dados atrasados e otimizar o uso de recursos.

As marcas d'água são especialmente úteis ao unir duas fontes de streaming ou um streaming com um conjunto de dados estático, ajudando a manter o desempenho e a consistência em pipelines de dados em tempo real.

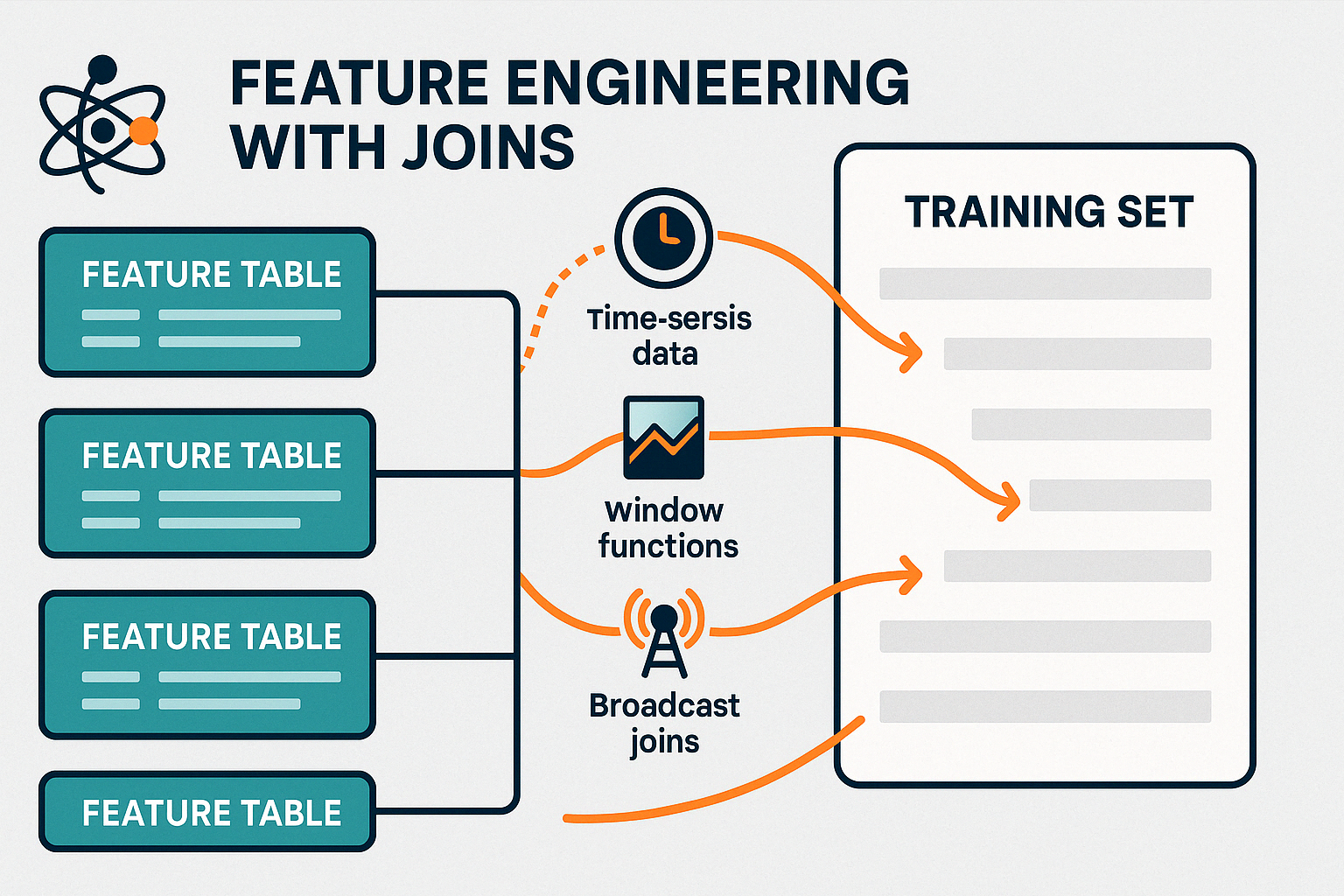

Junções de recursos de machine learning (ML)

As uniões desempenham um papel crucial na preparação de dados para modelos de machine learning, por exemplo, quando você cria modelos com o Spark MLlib. você criar modelos com o Spark MLlib. A consolidação desses recursos em um conjunto de dados único e unificado é essencial para o treinamento e a avaliação precisos do modelo.

As estratégias para a união eficiente de recursos em sistemas em tempo real incluem:

- Usando junções de transmissão para tabelas de recursos pequenos e estáticos, você pode minimizar o embaralhamento e acelerar o enriquecimento de dados em tempo real. para minimizar o embaralhamento e acelerar o enriquecimento de dados em tempo real.

- Pré-agregação de recursos usando funções de janela ou operações de grupo antes de se unir para reduzir o volume de dados em movimento.

- Aproveitamento de marcas d'água e o alinhamento de tempo de evento ao unir fluxos em tempo real para garantir atualizações de recursos relevantes e oportunas.

- Junções intermediárias persistentes para recursos reutilizados com frequência para evitar cálculos redundantes em tarefas posteriores.

Ao gerenciar com eficiência essas uniões, o PySpark permite a engenharia de recursos em tempo real, oferecendo suporte a sistemas de aprendizagem on-line e pipelines de treinamento em lote atualizados.

Você pode aprender a fazer previsões a partir de dados com o Apache Spark, usando árvores de decisão, regressão logística, regressão linear, conjuntos e pipelines com nosso Curso de machine learning com PySpark.

Práticas recomendadas e desafios comuns

A união de operações em computação distribuída requer atenção regular para evitar possíveis problemas.

Operações de junção eficientes podem melhorar drasticamente a velocidade geral do pipeline e o uso de recursos. Aqui estão as principais práticas que você deve seguir:

- Filtragem pré-união: Remova as linhas irrelevantes e elimine as colunas não utilizadas antes de realizar as uniões. Isso reduz a quantidade de dados embaralhados no cluster.

- Pedido de junção inteligente: Sempre junte tabelas menores ou transmissíveis primeiro para minimizar o tamanho dos dados intermediários e evitar cálculos desnecessários.

- Gerenciamento de memória e recursos: Monitore a execução de tarefas por meio da interface do usuário ou dos registros do Spark para detectar distorções ou gargalos. Certifique-se de que as estratégias de particionamento estejam alinhadas com os recursos do cluster para evitar a sobrecarga de nós individuais.

- Repartir com sabedoria: Use

repartition()oucoalesce()para ajustar os tamanhos das partições para um processamento paralelo mais equilibrado.

Antipadrões a serem evitados

Mesmo pequenos erros na lógica de união podem levar a grandes problemas de desempenho ou precisão dos dados. Aqui estão as armadilhas comuns às quais você deve estar atento:

- Condições de união incorretas ou ambíguas: Condições de união mal definidas podem levar a correspondências incorretas ou linhas duplicadas. Sempre verifique se as chaves de união são precisas, exclusivas, quando necessário, e se correspondem adequadamente ao tipo de dados.

- Uniões cruzadas não intencionais: As junções cruzadas multiplicam cada linha de um DataFrame com cada linha de outro, o que geralmente resulta em grandes explosões de dados. Use-os somente quando for explicitamente necessário e com uma compreensão clara do tamanho da saída.

- Forçando junções de difusão em DataFrames grandes: Ao transmitir tabelas grandes, você pode sobrecarregar a memória e reduzir o desempenho. Deixe que o PySpark decida, ou transmita manualmente apenas quando o DataFrame for pequeno e couber confortavelmente na memória.

- Ignorando a inclinação dos dados: Se uma ou mais chaves de junção estiverem muito distorcidas, você poderá sobrecarregar algumas partições. Detecte a distorção antecipadamente e considere técnicas de salga ou estratégias alternativas.

Mesmo as uniões bem estruturadas podem apresentar problemas de desempenho ou execução.

Aqui estão os problemas comuns e como você pode resolvê-los:

- Tempos de execução lentos: Geralmente causado por distorção de dados ou ipartições desequilibradas. Verifique se há valores-chave de união altamente repetitivos e considere reparticionar ou aplicar técnicas de salga para distribuir os dados de forma mais uniforme.

- Falhas de união ou erros inesperados: Normalmente, devido a incompatibilidades de tipos de dados ou valores nulos em chaves de junção. Certifique-se de que os dois lados da união usem os mesmos tipos de dados e aplique o tratamento adequado de nulos.

- Erros de falta de memória: Pode ocorrer quando grandes conjuntos de dados são unidos sem filtragem ou quando as uniões de difusão são forçadas em tabelas grandes. Filtrar antecipadamente e transmitir apenas DataFrames pequenos e estáticos.

Conclusão

As uniões do PySpark são a base do processamento de dados em grande escala, permitindo uma análise avançada e eficiente de conjuntos de dados enormes. Quando usados corretamente, eles revelam relacionamentos significativos que geram insights mais profundos e decisões mais inteligentes.

Embora o ajuste de desempenho possa apresentar desafios, como lidar com a distorção de dados ou otimizar o particionamento, dominar esses aspectos é fundamental para criar pipelines de dados robustos.

Se você estiver unindo fluxos em tempo real ou consolidando recursos para machine learning, o refinamento de suas estratégias de união pode melhorar significativamente a velocidade de execução, a eficiência dos recursos e a precisão analítica.

Para se aprofundar, explore o processamento de Big Data com o PySpark e trabalhe para se tornar um especialista em engenharia de dados com nosso curso Fundamentos de Big Data com PySpark programa de habilidades.

PySpark junta-se às perguntas frequentes

Qual é o tipo de junção mais eficiente a ser usado no PySpark?

O tipo de união mais eficiente depende de seus dados e objetivos. As uniões internas são rápidas quando existem dados correspondentes em ambos os lados. Para que você possa lidar com tabelas de referência pequenas, as uniões de difusão geralmente são as de melhor desempenho.

Quando devo usar junções de transmissão no PySpark?

Use junções de difusão quando você estiver juntando um DataFrame grande com um muito menor (geralmente menos de 10 MB a 100 MB, dependendo do seu cluster). Ao transmitir a tabela menor, você evita embaralhamentos dispendiosos.

O que causa a distorção de dados em uniões e como posso corrigi-la?

A distorção de dados ocorre quando determinadas chaves de junção têm registros desproporcionalmente grandes, fazendo com que algumas partições fiquem sobrecarregadas. O salting, que adiciona valores aleatórios para distribuir os dados de forma mais uniforme, é uma técnica eficaz para atenuar esse problema.

O reparticionamento é sempre necessário antes de uma união?

Nem sempre, mas o reparticionamento pela chave de junção pode reduzir drasticamente o embaralhamento e melhorar o desempenho quando os dois DataFrames se originam de fontes diferentes ou são particionados de forma diferente.

O PySpark pode lidar com junções de dados de streaming em tempo real?

Sim. A API Structured Streaming do PySpark oferece suporte a uniões em tempo real usando marcas d'água para lidar com dados de chegada tardia e gerenciar o estado com eficiência.