Curso

A gente calcula que tem mais ou menos 328,77 milhões de terabytes de dados são criados diariamente. Cada clique e compra gera dados que podem ser transformados em insights e previsões significativas com as ferramentas certas.

Mas a gente precisa de uma biblioteca que seja boa pra nos ajudar a processar essa quantidade de dados. É aí que entra em cenao PySpark .

Neste guia, vamos ver como aprender PySpark do zero. Vou te ajudar a criar um plano de aprendizado, compartilhar minhas melhores dicas para aprender de forma eficaz e fornecer recursos úteis para te ajudar a encontrar funções que exigem PySpark.

Aprenda PySpark do zero

O que é PySpark?

PySpark é a combinação de duas tecnologias poderosas: Python e Apache Spark.

Python é uma das linguagens de programação mais usadas no desenvolvimento de software, principalmente para ciência de dados e machine learning, porque é fácil de usar e tem uma sintaxe simples.

Por outro lado, o Apache Spark é uma estrutura que consegue lidar com grandes quantidades de dados não estruturados. O Spark foi criado usando Scala, uma linguagem que nos dá mais controle sobre ele. Mas, Scala não é uma linguagem de programação muito popular entre quem trabalha com dados. Então, o PySpark foi criado pra resolver essa questão.

O PySpark oferece uma API e uma interface fácil de usar para interagir com o Spark. Ele usa a simplicidade e flexibilidade do Python para tornar o processamento de big data acessível a um público mais amplo.

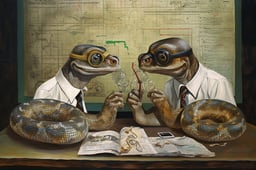

O que faz o PySpark ser tão popular?

Nos últimos anos, o PySpark virou uma ferramenta importante para quem trabalha com dados e precisa lidar com um monte de informação. A gente pode explicar a popularidade dele por vários fatores importantes:

- Fácil de usar: O PySpark usa a sintaxe familiar do Python, o que o torna mais acessível para profissionais de dados como nós.

- Rapidez e eficiência: Ao distribuir cálculos por grupos de máquinas, o PySpark lida com conjuntos de dados enormes em alta velocidade.

- Escalabilidade: O PySpark se adapta ao aumento do volume de dados, permitindo que a gente amplie nossas aplicações adicionando mais recursos de computação.

- Versatilidade: Ele oferece um amplo ecossistema de bibliotecas para diferentes tarefas, desde manipulação de dados até machine learning.

- Comunidade forte: Podemos contar com uma comunidade grande e ativa para nos dar apoio e recursos quando enfrentamos problemas e desafios.

O PySpark também nos permite aproveitar os conhecimentos e bibliotecas Python já existentes. Podemos integrá-lo facilmente com ferramentas populares como Pandas e Scikit-learn, e isso nos permite usar várias fontes de dados.

Principais recursos do PySpark

O PySpark foi feito especialmente para big data e machine learning developments. Mas quais são as funcionalidades que fazem dele uma ferramenta poderosa para lidar com grandes quantidades de dados? Vamos dar uma olhada neles:

- Conjuntos de dados distribuídos resilientes (RDDs): Essas são as estruturas de dados fundamentais por trás do PySpark. Graças a eles, a transformação, filtragem e agregação de dados podem ser feitas em paralelo.

- DataFrame e SQL: No PySpark, os DataFrame são uma abstração de nível mais alto, construída sobre os RDDs. Podemos usá-los com o Spark SQL e consultas para fazer manipulação e análise de dados.

- Bibliotecas de machine learning: Usando o biblioteca MLlib do PySpark , podemos criar e usar modelos de machine learning escaláveis para tarefas como classificação e regressão.

- Suporte a diferentes formatos de dados: O PySpark oferece bibliotecas e APIs pra ler, escrever e processar dados em vários formatos, como CSV, JSON, Parquet e Avro, entre outros.

- Tolerância a falhas: O PySpark fica de olho em cada RDD. Se um nó falhar durante a execução, o PySpark reconstrói a partição RDD perdida usando essas informações de rastreamento. Então, o risco de perder dados é bem pequeno.

- Processamento na memória: O PySpark guarda os dados intermediários na memória, o que reduz a necessidade de operações no disco e, por sua vez, melhora o desempenho do processamento de dados.

- Streaming e processamento em tempo real: A gente pode usar o componente Spark Streaming pra processar fluxos de dados em tempo real e fazer análises quase em tempo real.

Por que aprender PySpark é tão útil?

O volume de dados só está aumentando. Hoje em dia, as tarefas de manipulação de dados, análise de dados e machine learning envolvem trabalhar com grandes quantidades de dados. Precisamos usar ferramentas poderosas que processem esses dados de forma eficiente e rápida. O PySpark é uma dessas ferramentas.

O PySpark tem várias aplicações

Já falamos sobre os pontos fortes do PySpark, mas vamos ver alguns exemplos específicos de onde você pode usá-los:

- Data ETL. A capacidade do PySpark para limpeza e transformação eficiente de dados é usada para processar dados de sensores e registros de produção em manufatura e logística.

- Machine learning. A biblioteca MLlib é usada para desenvolver e implementar modelos para recomendações personalizadas, segmentação de clientes e previsão de vendas no comércio eletrônico.

- Processamento de gráficos. Os GraphFrames do PySpark são usados para analisar redes sociais e entender as relações entre os usuários.

- Processamento de fluxo. A API Structured Streaming do PySpark permite o processamento em tempo real de transações financeiras para detectar fraudes.

- Processamento de dados SQL. A interface SQL do PySpark facilita para pesquisadores e analistas da área da saúde consultar e analisar grandes conjuntos de dados genômicos.

Tem muita procura por habilidades em PySpark.

Com o surgimento da ciência de dados e do machine learning e o aumento dos dados disponíveis, tem uma demanda alta por profissionais que sabem mexer com dados. De acordo com o Relatório sobre o estado da alfabetização em dados e IA 2024, 80% dos líderes valorizam as habilidades de análise e manipulação de dados.

Aprender PySpark pode abrir um monte de oportunidades de carreira. Mais de 800 anúncios de emprego no Indeed, de engenheiros de dados a cientistas de dados, mostram a procura por pessoas que sabem usar o PySpark em anúncios de emprego relacionados a dados.

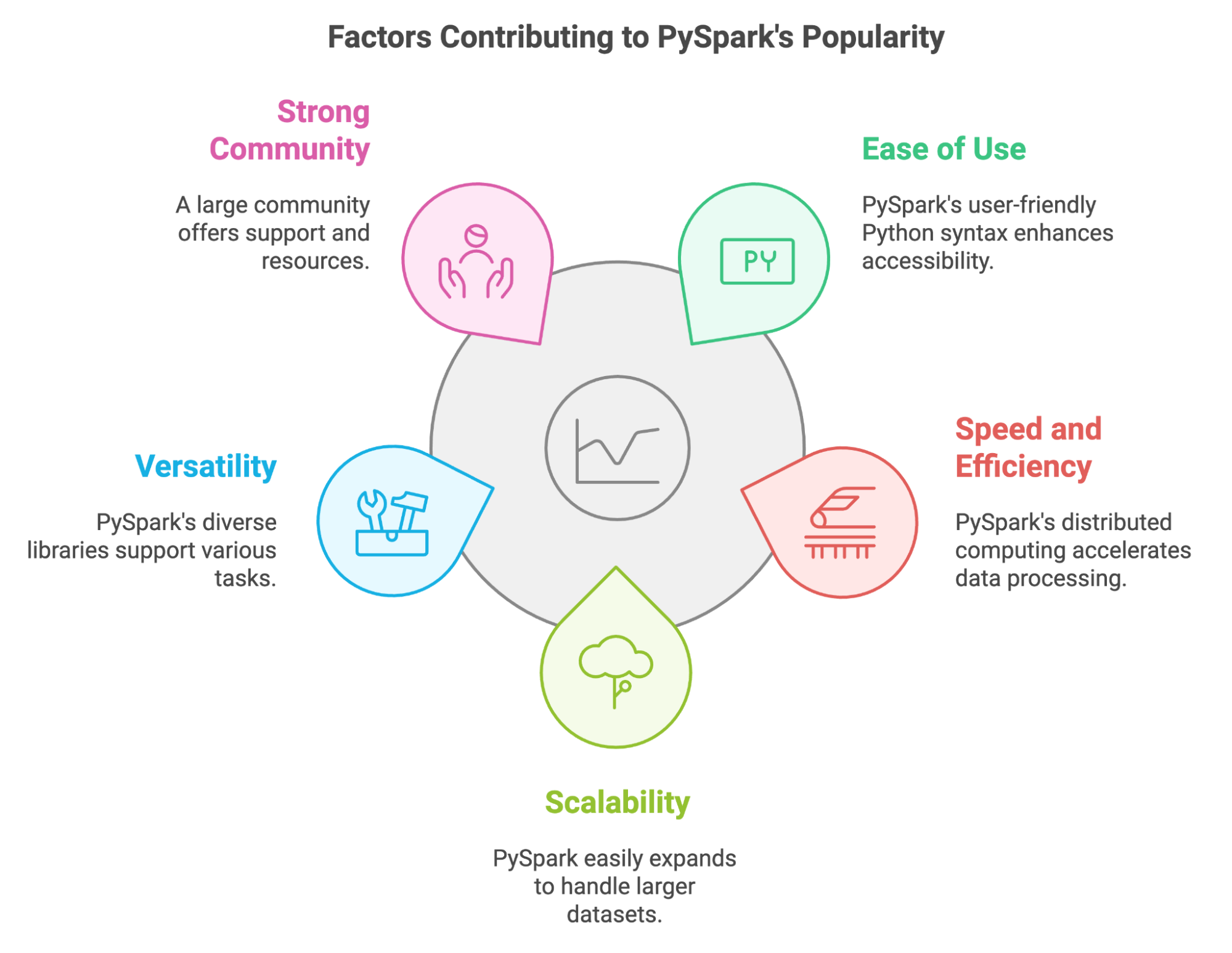

Como aprender PySpark do zero em 2026

Se você aprender PySpark de forma organizada, vai ter mais chances de sucesso. Vamos focar em alguns princípios que você pode usar na sua jornada de aprendizado.

1. Entenda por que você está aprendendo PySpark

Antes de aprender os detalhes técnicos, pense por que você quer aprender PySpark. Pergunte a si mesmo:

- Quais são meus objetivos profissionais?

- O PySpark é uma habilidade que você precisa para avançar na sua função atual ou conseguir o emprego dos seus sonhos?

- Que oportunidades você espera ter se dominar o PySpark?

- Que problemas estou tentando resolver?

- Você tem dificuldade em processar grandes conjuntos de dados que as ferramentas atuais que você conhece não conseguem lidar?

- Precisa fazer transformações complexas de dados ou criar modelos avançados de machine learning?

- O que me interessa?

- A ideia de criar pipelines de dados escaláveis te anima?

- Você está interessado em big data e seu potencial para revelar insights?

- Tenho algum projeto específico em mente que precise das funcionalidades do PySpark?

- Você está trabalhando em um projeto pessoal que envolve processamento ou análise de dados em grande escala?

- A sua empresa precisa de experiência em PySpark para um projeto que está por vir?

2. Comece com o básico do PySpark

Depois de definir seus objetivos, aprenda o básico do PySpark e entenda como ele funciona.

Fundamentos do Python

Como o PySpark é baseado no Python, você precisa se familiarizar com o Python antes de usar o PySpark. Você deve se sentir à vontade para trabalhar com variáveis e funções. Além disso, pode ser uma boa ideia se familiarizar com bibliotecas de manipulação de dados, como o Pandas. Curso de introdução ao Python da DataCamp Introdução ao Python e Manipulação de dados com Pandas podem te ajudar a se atualizar.

Instalando o PySpark e aprendendo o básico

Você precisa instalar o PySpark para começar a usá-lo. Você pode baixar o PySpark usando o pip ou o Conda, baixá-lo manualmente do site oficial ou começar com o DataLab para começar a usar o PySpark no seu navegador.

Se você quiser uma explicação completa sobre como configurar o PySpark, confira este guia sobre como instalar o PySpark no Windows, Mac e Linux.

PySpark DataFrames

O primeiro conceito que você deve aprender é como funcionam os DataFrame do PySpark. Eles são uma das principais razões pelas quais o PySpark funciona tão rápido e eficiente. Entenda como criar, transformar (mapear e filtrar) e mexer neles. O tutorial sobre como começar a trabalhar com o PySpark vai te ajudar com esses conceitos.

3. Domine as habilidades intermediárias do PySpark

Quando você já estiver de boa com o básico, é hora de explorar as habilidades intermediárias do PySpark.

Spark SQL

Uma das maiores vantagens do PySpark é a capacidade de fazer consultas tipo SQL para ler e mexer em DataFrame, fazer agregações e usar funções de janela. Nos bastidores, o PySpark usa o Spark SQL. Essa introdução ao Spark SQL em Python pode te ajudar com essa habilidade.

Organização e transformação de dados

Trabalhar com dados significa aprender a limpar, transformar e preparar os dados para análise. Isso inclui lidar com valores ausentes, gerenciar diferentes tipos de dados e fazer agregações usando o PySpark. Faça o DataCamp: Limpeza de Dados com PySpark para ganhar experiência prática e dominar essas habilidades.

Machine learning com MLlib

O PySpark também pode ser usado para desenvolver e implantar modelos de machine learning, graças à sua biblioteca MLlib. Você deve aprender a fazer engenharia de recursos, avaliação de modelos e ajuste de hiperparâmetros usando essa biblioteca. DataCamp's Machine learning com PySpark oferece uma introdução bem completa.

4. Aprenda PySpark na prática

Fazer cursos e praticar exercícios usando o PySpark é uma ótima maneira de se familiarizar com a tecnologia. Mas, pra ficar craque no PySpark, você precisa resolver problemas desafiadores e que desenvolvam suas habilidades, tipo aqueles que você vai encontrar em projetos reais. Você pode começar com tarefas simples de análise de dados e, aos poucos, passar para desafios mais complexos.

Aqui estão algumas maneiras de praticar suas habilidades:

- Participe de webinars e sessões de programação em grupo. Confira os os próximos webinars do DataCamp e eventos online, onde você pode acompanhar tutoriais e exemplos de código do PySpark. Isso vai te ajudar a entender melhor os conceitos e se familiarizar com os padrões de codificação.

- Desenvolva projetos independentes. Identifique conjuntos de dados que lhe interessam e aplique suas habilidades em PySpark para analisá-los. Isso pode envolver desde analisar tendências nas redes sociais até explorar dados do mercado financeiro.

- Contribua com projetos de código aberto. Contribua com projetos PySpark em plataformas como o GitHub para ganhar experiência colaborando com outras pessoas e trabalhando em projetos reais.

- Crie um blog pessoal. Escreva sobre seus projetos PySpark, compartilhe suas ideias e contribua com a comunidade PySpark criando um blog pessoal.

5. Crie um portfólio de projetos

À medida que você avança na sua jornada de aprendizado do PySpark, você vai concluir diferentes projetos. Para mostrar suas habilidades e experiência em PySpark para possíveis empregadores, você deve juntar tudo em um portfólio. Esse portfólio deve mostrar suas habilidades e interesses e ser feito sob medida para a carreira ou setor que você curte.

Tente fazer projetos originais e mostrar suas habilidades pra resolver problemas. Inclua projetos que mostrem sua habilidade em vários aspectos do PySpark, como manipulação de dados, machine learning e visualização de dados. Documente seus projetos, mostrando o contexto, a metodologia, o código e os resultados. Você pode usar o DataLab, que é um IDE online que permite escrever código, analisar dados de forma colaborativa e compartilhar suas ideias.

Aqui estão dois projetos PySpark nos quais você pode trabalhar:

6. Continue se desafiando

Aprender PySpark é uma jornada contínua. A tecnologia está sempre mudando, e novos recursos e aplicativos são criados o tempo todo. O PySpark não é exceção a isso.

Depois de dominar o básico, você pode procurar tarefas e projetos mais desafiadores, como otimização de desempenho ou GraphX. Concentre-se em seus objetivos e especialize-se em áreas que sejam relevantes para suas metas profissionais e interesses.

Fique por dentro das novidades e aprenda como aplicá-las nos seus projetos atuais. Continue praticando, procure novos desafios e oportunidades e aceite a ideia de cometer erros como uma forma de aprender.

Vamos recapitular os passos que podemos seguir para um plano de aprendizagem bem-sucedido do PySpark:

Um exemplo de plano de aprendizagem do PySpark

Mesmo que cada pessoa tenha sua maneira de aprender, é sempre uma boa ideia ter um plano ou guia para seguir ao aprender uma nova ferramenta. Criamos um plano de aprendizado potencial que mostra onde você deve focar seu tempo e esforços se estiver começando com o PySpark.

Mês 1: Fundamentos do PySpark

- Conceitos fundamentais. Instale o PySpark e veja como funciona a sintaxe dele. Entenda os conceitos básicos do Apache Spark, sua arquitetura e como ele permite o processamento distribuído de dados.

- Noções básicas do PySpark. Aprenda a configurar seu ambiente PySpark, criar SparkContexts e SparkSessions e explorar estruturas de dados básicas, como RDDs e DataFrame.

- Manipulação de dados. Domine as operações essenciais do PySpark para manipulação de dados, incluindo filtragem, classificação, agrupamento, agregação e junção de conjuntos de dados. Você pode fazer as projeto Cleaning Orders with PySpark.

Mês 2: PySpark para análise de dados e SQL

- Trabalhando com diferentes formatos de dados: Aprenda a ler e escrever dados em vários formatos, incluindo CSV, JSON, Parquet e Avro, usando o PySpark.

- Spark SQL. Aprenda a usar o Spark SQL para consultar e analisar dados com a sintaxe SQL que você já conhece. Explore conceitos como DataFrame, conjuntos de dados e funções SQL.

- Visualização de dados e engenharia de recursos: Explore técnicas de visualização de dados no PySpark usando bibliotecas como Matplotlib e Seaborn para obter insights a partir dos seus dados. Aprenda a lidar com dados e fazer engenharia de recursos com o curso curso Engenharia de recursos com PySpark.

Mês 3-4: PySpark para machine learning e tópicos avançados

- Introdução ao MLlib: Comece a usar a biblioteca MLlib do PySpark para machine learning. Explore algoritmos básicos para classificação, regressão e agrupamento. Você pode usar o curso machine learning com PySpark.

- Criando pipelines de ML. Aprenda a criar e implementar pipelines de machine learning no PySpark para um treinamento e avaliação eficientes de modelos.

- Desenvolva um projeto. Trabalhar no desenvolvimento de um Modelo de Previsão de Demanda.

- Conceitos avançados. Explore técnicas para otimizar aplicativos PySpark, incluindo particionamento de dados, armazenamento em cache e ajuste de desempenho.

Cinco dicas para aprender PySpark

Imagino que, a essa altura, você já esteja pronto para começar a aprender PySpark e colocar as mãos em um grande conjunto de dados para praticar sua nova habilidade. Mas antes disso, deixa eu te dar umas dicas que vão te ajudar a chegar lá e dominar o PySpark.

1. Limite o seu escopo

PySpark é uma ferramenta que pode ter várias aplicações diferentes. Para manter o foco e alcançar seu objetivo, você deve identificar sua área de interesse. Quer focar em análise de dados, engenharia de dados ou machine learning? Adotar uma abordagem focada pode te ajudar a obter os aspectos e conhecimentos mais relevantes do PySpark para o caminho que você escolheu.

2. Pratique com frequência e constantemente.

A consistência é fundamental para dominar qualquer nova habilidade. Você deve reservar um tempo dedicado para praticar o PySpark. Basta dedicar um tempinho todos os dias. Você não precisa lidar com conceitos complexos todos os dias. Você pode revisar o que aprendeu ou revisitar um exercício simples para refatorá-lo. A prática regular vai ajudar você a entender melhor os conceitos e a ficar mais confiante na hora de aplicá-los.

3. Trabalhe em projetos reais

Essa é uma das dicas mais importantes, e você vai ver isso várias vezes neste guia. Fazer exercícios é ótimo pra ganhar confiança. Mas, usar suas habilidades em PySpark em projetos reais é o que vai fazer você se destacar nisso. Procure conjuntos de dados que te interessem e use o PySpark para analisá-los, extrair insights e resolver problemas.

Comece com projetos e questões simples e, aos poucos, vá encarando os mais complexos. Isso pode ser tão simples quanto ler e limpar um conjunto de dados reais e escrever uma consulta complexa para fazer agregações e prever o preço de uma casa.

4. Participe de uma comunidade

Aprender costuma ser mais eficaz quando feito em grupo. Compartilhar suas experiências e aprender com os outros pode acelerar seu progresso e trazer insights valiosos.

Pra trocar conhecimento, ideias e perguntas, você pode entrar em alguns grupos relacionados ao PySpark e participar de encontros e conferências. A Comunidade Databricks, a empresa criada pelos caras que inventaram o Spark, tem um fórum bem ativo onde você pode participar de discussões e tirar dúvidas sobre o PySpark. Além disso, o Spark Summit, organizado pela Databricks, é a maior conferência sobre Spark.

5. Cometer erros

Como com qualquer outra tecnologia, aprender PySpark é um processo que vai acontecendo aos poucos. E aprender com os seus erros é uma parte essencial do processo de aprendizagem. Não tenha medo de experimentar, tente diferentes abordagens e aprenda com seus erros. Experimente diferentes funções e alternativas para juntar os dados, faça subconsultas ou consultas aninhadas e veja como o PySpark responde rapidinho.

As melhores maneiras de aprender PySpark

Vamos ver alguns métodos eficientes para aprender PySpark.

Faça cursos online

Os cursos online são uma ótima maneira de aprender PySpark no seu próprio ritmo. DataCamp oferece cursos de PySpark para todos os níveis, que juntos formam o Big Data com PySpark programa. Os cursos abordam conceitos introdutórios sobre temas relacionados ao machine learning e são elaborados com exercícios práticos.

Aqui estão alguns dos cursos relacionados ao PySpark no DataCamp:

- Engenharia de recursos com PySpark

- Machine learning com PySpark

- Criando mecanismos de recomendação com PySpark

- Fundamentos de Big Data com PySpark

Siga os tutoriais online

Os tutoriais são outra ótima maneira de aprender PySpark, principalmente se você é novo nessa tecnologia. Eles têm instruções passo a passo sobre como fazer tarefas específicas ou entender certos conceitos. Pra começar, dá uma olhada nesses tutoriais:

Dá uma olhada nas folhas de referência do PySpark

As folhas de referência são úteis quando você precisa de um guia rápido sobre os tópicos do PySpark. Aqui estão duas folhas de dicas úteis:

Projetos completos do PySpark

Aprender PySpark precisa de prática. Enfrentar desafios enquanto conclui projetos que permitirão que você aplique todas as habilidades que aprendeu. À medida que você começa a assumir tarefas mais complexas, vai precisar encontrar soluções e pesquisar novas alternativas para obter os resultados desejados, aumentando sua experiência com o PySpark.

Dá uma olhada nos projetos PySpark para trabalhar no DataCamp. Isso permite que você use suas habilidades de manipulação de dados e construção de modelos de machine learning usando o PySpark:

Descubra o PySpark através de livros

Os livros são um excelente recurso para aprender PySpark. Eles oferecem conhecimento aprofundado e insights de especialistas, além de trechos de código e explicações. Aqui estão alguns dos livros mais populares sobre PySpark:

- Aprendendo PySpark 2ª Edição, Jules S. Damji

- PySpark Cookbook, Denny Lee

- A inspiração para desenvolvedores Python

Carreiras no PySpark

A procura por habilidades em PySpark aumentou em várias funções relacionadas a dados, desde analistas de dados até engenheiros de big data. Se você está se preparando para uma entrevista, considere estas perguntas sobre PySpark para

Engenheiro de big data

Como engenheiro de big data, você é o arquiteto das soluções de big data, responsável por projetar, construir e manter a infraestrutura que lida com grandes conjuntos de dados. Você vai usar o PySpark pra criar pipelines de dados escaláveis, garantindo uma ingestão, processamento e armazenamento eficientes dos dados.

Você vai precisar de um bom conhecimento sobre computação distribuída e plataformas em nuvem, além de experiência em warehouse e processos ETL.

- Competências essenciais:

- Proficiência em Python e PySpark, Java e Scala

- Entendendo estruturas de dados e algoritmos

- Proficiência em SQL e nosql

- Experiência em processos ETL e construção de pipelines de dados

- Entendendo sistemas distribuídos

- Principais ferramentas utilizadas:

- Apache Spark, Hadoop Ecosystem

- Ferramentas de warehouse de dados (por exemplo, Snowflake, Redshift ou BigQuery)

- Plataformas em nuvem (por exemplo, AWS, GCP, Databricks)

- Ferramentas de orquestração de fluxo de trabalho (por exemplo, Apache Airflow, Apache Kafka)

Obtenha a certificação para a função de engenheiro de dados dos seus sonhos

Nossos programas de certificação ajudam você a se destacar e a provar que suas habilidades estão prontas para o trabalho para possíveis empregadores.

Cientista de dados

Como cientista de dados, você vai usar os recursos do PySpark para fazer o tratamento e a manipulação de dados, além de desenvolver e implementar modelos de machine learning. Seus conhecimentos estatísticos e habilidades de programação vão te ajudar a desenvolver modelos que contribuam para o processo de tomada de decisões.

- Competências essenciais:

- Conhecimento sólido de Python, PySpark e SQL

- Entendendo conceitos de machine learning e IA

- Proficiência em análise estatística, análise quantitativa e modelagem preditiva

- Técnicas de visualização de dados e relatórios

- Habilidades eficazes de comunicação e apresentação

- Principais ferramentas utilizadas:

- Ferramentas de análise de dados (por exemplo, pandas, NumPy)

- Bibliotecas de machine learning (por exemplo, Scikit-learn)

- Ferramentas de visualização de dados (por exemplo, Matplotlib, Tableau)

- Estruturas de big data (por exemplo, Airflow, Spark)

- Ferramentas de linha de comando (por exemplo, Git, Bash)

Engenheiro de machine learning

Como engenheiro de machine learning, você vai usar o PySpark para preparar dados, criar modelos de machine learning, treiná-los e implementá-los.

- Competências essenciais:

- Proficiência em Python, PySpark e SQL

- Conhecimento profundo de algoritmos de machine learning

- Conhecimento de estruturas de aprendizado profundo

- Entendimento de estruturas de dados, modelagem de dados e arquitetura de software

- Principais ferramentas utilizadas:

- Bibliotecas e algoritmos de machine learning (por exemplo, Scikit-learn, TensorFlow)

- Bibliotecas de ciência de dados (por exemplo, Pandas, NumPy)

- Nuvem platforms (por exemplo, AWS, Google Cloud Platform)

- Sistemas de controle de versão (por exemplo, Git)

- Estruturas de aprendizado profundo (por exemplo, TensorFlow, Keras, PyTorch)

Analista de dados

Como analista de dados, você vai usar o PySpark para explorar e analisar grandes conjuntos de dados, identificar tendências e comunicar suas descobertas por meio de relatórios e visualizações.

- Competências essenciais:

- Proficiência em Python, PySpark e SQL

- Conhecimento sólido de análise estatística

- Experiência com ferramentas de inteligência empresarial (por exemplo, Tableau, Power BI)

- Entendendo as técnicas de coleta e limpeza de dados

- Principais ferramentas utilizadas:

- Ferramentas de análise de dados (por exemplo, pandas, NumPy)

- Ferramentas de dados de inteligência empresarial (por exemplo, Tableau, Power BI)

- Bancos de dados SQL (por exemplo, MySQL, PostgreSQL)

|

Função |

O que você faz |

Suas principais habilidades |

Ferramentas que você usa |

|

Engenheiro de Big Data |

Projeta, constrói e mantém a infraestrutura para lidar com grandes conjuntos de dados. |

Python, PySpark, Java e Scala, estruturas de dados, SQL e nosql, ETL, sistemas distribuídos |

Apache Spark, Hadoop, Ferramentas de armazenamento de dados, Plataformas em nuvem, Ferramentas de orquestração de fluxo de trabalho |

|

Cientista de dados |

Descobre padrões escondidos e tira insights valiosos dos dados. Usa conhecimentos estatísticos e habilidades de programação para criar modelos que ajudam na tomada de decisões. |

Python, PySpark, SQL, machine learning, conceitos de IA, análise estatística, modelagem preditiva, visualização de dados, comunicação eficaz |

Pandas, NumPy, Scikit-learn, Keras, Matplotlib, plotly, Airflow, Spark, Git |

|

Engenheiro de machine learning |

Cria, desenvolve e implementa sistemas de machine learning para fazer previsões usando os dados da empresa. |

Python, PySpark e SQL, machine learning algoritmos, aprendizado profundo, estruturas de dados, modelagem de dados e arquitetura de software |

Scikit-learn, TensorFlow, Keras, PyTorch, Pandas, NumPy, AWS, Google Cloud Platform, Git |

|

Analista de Dados |

Preenche a lacuna entre dados brutos e insights comerciais acionáveis. Comunique as conclusões por meio de relatórios e visualizações. |

Python, PySpark e SQL, análise estatística, visualização de dados, técnicas de coleta e limpeza de dados |

Pandas, NumPy, Tableau, PowerBI, MySQL, PostgreSQL. |

Como encontrar um emprego que use PySpark ou em PySpark

Um diploma pode ser um grande trunfo ao iniciar uma carreira que usa PySpark, mas não é o único caminho. Hoje em dia, cada vez mais profissionais estão começando a trabalhar com dados por caminhos alternativos, incluindo a transição de outras áreas. Com dedicação, aprendizado constante e uma abordagem proativa, você pode conseguir o emprego dos seus sonhos usando o PySpark.

Continue aprendendo sobre a área

Fique por dentro das últimas novidades do PySpark. Siga profissionais influentes que estão envolvidos com o PySpark nas redes sociais, leia blogs relacionados ao PySpark e ouça podcasts relacionados ao PySpark.

O PySpark foi criado por Matei Zaharia, que também é diretor de tecnologia da Databricks, uma plataforma criada com base no Apache Spark. Você vai ficar por dentro dos assuntos do momento, das tecnologias que estão surgindo e do que vem por aí no PySpark.

Você também deve conferir os eventos do setor, sejam eles webinars no DataCamp, conferências sobre ciência de dados e IAou eventos de networking.

Crie um portfólio

Você precisa se destacar dos outros candidatos. Uma boa maneira de fazer isso é montar um portfólio legal. portfólio que mostre suas habilidades e projetos concluídos. Você pode causar uma boa impressão nos gerentes de contratação ao abordar desafios do mundo real.

Seu portfólio deve ter projetos variados que mostrem sua experiência com o PySpark e suas várias aplicações. Dá uma olhada nesse guia sobre como criar um portfólio de ciência de dados impressionante.

Crie um currículo que chame a atenção

Nos últimos anos, tem havido um aumento no número de pessoas que estão mudando para a ciência de dados e funções relacionadas a dados. Os gerentes de contratação precisam analisar centenas de currículos e escolher os melhores candidatos. Além disso, muitas vezes, seu currículo passa por Sistemas de Rastreamento de Candidatos (ATS), que são softwares automáticos que várias empresas usam pra analisar currículos e descartar aqueles que não atendem a critérios específicos. Então, você deve criar um ótimo currículo para impressionar tanto o ATS quanto os recrutadores.

Prepare-se para a entrevista

Se você chamar a atenção do gerente de contratação ou se o seu currículo for aprovado no processo de seleção, você deve se preparar para uma entrevista técnica. Para se preparar, dá uma olhada nesse artigo sobre principais perguntas feitas em entrevistas sobre PySpark.

Conclusão

Aprender PySpark pode abrir portas para melhores oportunidades e resultados na carreira. Aprender PySpark é gratificante, mas precisa de dedicação e prática. Experimentar e resolver desafios usando essa ferramenta pode acelerar seu processo de aprendizagem e te dar exemplos reais para mostrar quando você estiver procurando emprego.

Perguntas frequentes

Quais são as principais características do PySpark?

O PySpark oferece uma API Python fácil de usar para aproveitar o Spark, garantindo velocidade, escalabilidade e suporte para SQL, machine learning e processamento de fluxo para grandes conjuntos de dados.

Por que a procura por habilidades em PySpark está aumentando?

A facilidade de uso, escalabilidade e versatilidade do PySpark para processamento de big data e machine learning estão aumentando a procura por essas habilidades.

Quais são os pontos principais a considerar para aprender PySpark?

Foca nos fundamentos do Python, nos conceitos básicos do Spark e nas técnicas de manipulação de dados, e dá uma olhada em tópicos avançados como Spark SQL e MLlib.

Quais são algumas maneiras de aprender PySpark?

Faça cursos online e siga tutoriais, trabalhe com conjuntos de dados reais, use folhas de referência e descubra o PySpark através de livros.

Quais são algumas das funções que usam o PySpark?

Algumas das funções que usam o PySpark são: engenheiro de big data, engenheiro de machine learning, cientista de dados e analista de dados.