Kurs

Als ich das erste Mal mit der Datenmodellierung in Berührung kam, erschien sie mir wie ein weiterer technischer Schritt bei der Arbeit mit Datenbanken. Aber je mehr ich mich damit beschäftigte, desto mehr wurde mir klar, wie wichtig es ist, dass die Daten gut strukturiert, leicht zugänglich und für die Analyse bereit sind. Ohne ein solides Datenmodell können selbst die leistungsstärksten Datenbanken schwer zu verwalten sein, was zu Ineffizienzen und Inkonsistenzen führt.

Egal, ob du eine Datenbank von Grund auf neu entwirfst oder ein bestehendes System verfeinerst, das Verständnis der Datenmodellierung ist der Schlüssel dazu, dass Daten für dich arbeiten.

In diesem Beitrag werden wir uns mit grundlegenden Datenmodellierungstechniken, Best Practices und Beispielen aus der Praxis beschäftigen, die dir helfen, effektive Modelle zu erstellen!

Was ist Datenmodellierung?

Die Datenmodellierung ist ein detaillierter Prozess, bei dem eine visuelle Darstellung der Daten und ihrer Beziehungen erstellt wird. Sie dient als Blaupause dafür, wie Daten strukturiert, gespeichert und abgerufen werden, um Konsistenz und Klarheit im Datenmanagement zu gewährleisten.

Die Definition von Datenelementen und ihren Beziehungen hilft Teams, Informationen zu organisieren, um sie effizient zu speichern, abzurufen und zu analysieren - und damit sowohl die Leistung als auch die Entscheidungsfindung zu verbessern.

Arten von Datenmodellen

Es gibt drei Haupttypen von Datenmodellen. In diesem Abschnitt wollen wir sie erkunden.

Konzeptuelles Datenmodell

Ein konzeptionelles Modell bietet eine Übersicht über die Daten. Dieses Modell definiert die wichtigsten Geschäftseinheiten (z. B. Kunden, Produkte und Aufträge) und ihre Beziehungen, ohne auf technische Details einzugehen.

Logisches Datenmodell

Das logische Modell legt fest, wie die Daten strukturiert werden sollen. Dieses Modell konzentriert sich auf die Datenorganisation, ohne an eine bestimmte Datenbank oder Technologie gebunden zu sein. Sie enthält detaillierte Informationen über die Datenattribute, -beziehungen und -beschränkungen und bildet damit eine Brücke zwischen den Geschäftsanforderungen und der physischen Implementierung der Daten.

Physikalisches Datenmodell

Ein physisches Datenmodell stellt dar, wie die Daten tatsächlich in einer Datenbank gespeichert werden. Dieses Modell definiert die spezifischen Tabellenstrukturen, Indizes und Speichermechanismen, die zur Optimierung der Leistung und zur Gewährleistung der Datenintegrität erforderlich sind. Sie übersetzt den logischen Entwurf in ein für Datenbanksysteme geeignetes Format.

Datenmodellierungstechniken

Die Datenmodellierung ist kein Einheitsverfahren. Je nach Komplexität der Daten und den Zielen werden unterschiedliche Techniken eingesetzt. In diesem Abschnitt werden wir einige der beliebtesten Datenmodellierungsansätze kennenlernen.

Entity-Relationship (ER)-Modellierung

Die ER-Modellierung ist eine der am häufigsten verwendeten Techniken zur Darstellung von Daten. Es geht darum, drei Schlüsselelemente zu definieren:

- Entitäten (Objekte oder Dinge innerhalb des Systems).

- Beziehungen (wie diese Einheiten miteinander interagieren).

- Attribute (Eigenschaften der Entitäten).

Das ER-Modell bietet eine klare, visuelle Darstellung der Datenstruktur, um die Verbindungen zwischen verschiedenen Datenpunkten zu verdeutlichen.

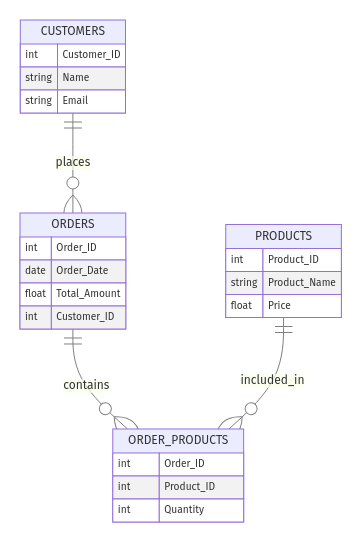

Beispiel: E-Commerce-Laden

Ziehe einen Online-Shop in Betracht. Du könntest die folgenden Einheiten haben:

- Kunden (mit Attributen wie

Customer_ID,Name, undEmail) - Bestellungen (mit

Order_ID,Order_Date,Total_Amount) - Produkte (mit

Product_ID,Product_Name,Price)

Die Beziehungen könnten sein:

- "Kunden geben Bestellungen auf" (One-to-Many)

- "Bestellungen enthalten Produkte" (Many-to-Many)

So sieht die ERD aus:

Beispiel für ein ER-Modell für einen E-Commerce-Shop. Bild vom Autor

Dimensionale Modellierung

Die dimensionale Modellierung wird häufig im Data Warehousing und in der Analytik eingesetzt, wo Daten oft in Form von Fakten und Dimensionendargestellt werden . Mit dieser Technik werden komplexe Daten vereinfacht, indem sie in einem Stern- oder Snowflake-Schema organisiert werden, das effiziente Abfragen und Berichte ermöglicht.

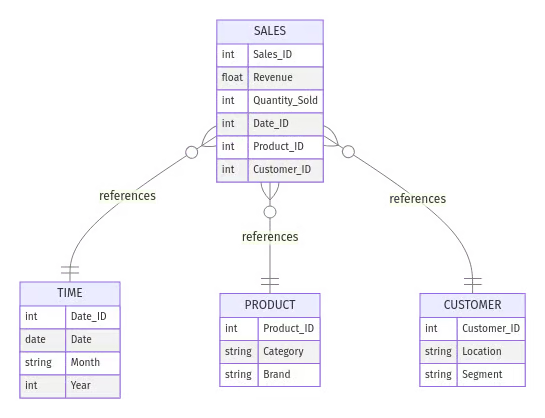

Beispiel: Verkaufsberichte

Stell dir vor, du musst deine Verkaufsdaten analysieren. Du würdest es wie folgt strukturieren:

- Tabelle der Fakten:

Sales(speichert Transaktionsdaten, z.B.Sales_ID,Revenue,Quantity_Sold)- Tabellen mit Abmessungen:

Time(z.B.Date,Month,Year)Product(z. B. Produkt_ID, Kategorie, Marke)Customer(z.B.Customer_ID,Location,Segment)

In einem Sternschema ist die Faktentabelle Sales direkt mit den Dimensionstabellen verknüpft, so dass Analysten effizient Berichte erstellen können, z. B. über den Gesamtumsatz pro Monat oder die meistverkauften Produkte nach Kategorie. So sieht das Schema aus:

Beispiel für ein Sternschema für Umsatzberichte. Bild vom Autor

💡 Möchtest du tiefer in die dimensionale Datenmodellierung eintauchen? Schau dir unsere Star Schema vs. Star Schema an. Snowflake Schema Leitfaden, um zu verstehen, wann du welches Schema für eine optimale Leistung verwenden solltest.

Objektorientierte Modellierung

Die objektorientierte Modellierung wird verwendet, um komplexe Systeme darzustellen, bei denen Daten und die Funktionen, die auf ihnen arbeiten, als Objekte gekapselt sind. Diese Technik ist nützlich für die Modellierung von Anwendungen mit komplexen, miteinander verknüpften Daten und Verhaltensweisen - insbesondere in der Softwareentwicklung und Programmierung.

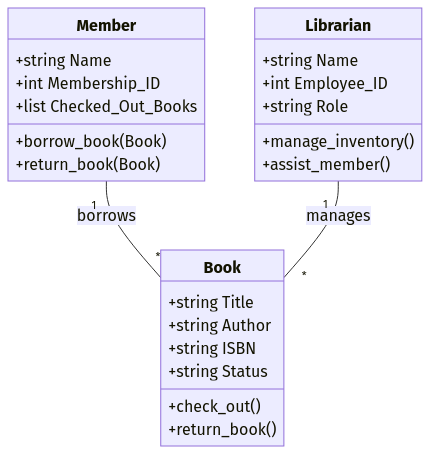

Beispiel: Bibliotheksverwaltungssystem

Angenommen, du entwirfst ein Bibliotheksverwaltungssystem. Du könntest Objekte definieren wie:

- Buch (

Title,Author,ISBN,Status) - Mitglied (

Name,Membership_ID,Checked_Out_Books) - Bibliothekar/in (

Name,Employee_ID,Role)

Jedes Objekt enthält sowohl Attribute (Datenfelder) als auch Methoden (Funktionen). Ein Book Objekt könnte zum Beispiel eine Methode .check_out() haben, die den Status des Buches aktualisiert, wenn es ausgeliehen wurde.

Besonders vorteilhaft ist dieser Ansatz in objektorientierten Programmiersprachen (OOP) wie Java und Python, wo Datenmodelle direkt auf Klassen und Objekte abgebildet werden können.

Beispiel für das objektorientierte Datenmodell. Bild vom Autor

💡 Willst du lernen, wie man objektorientierte Programmierung in Python umsetzt? Im DataCamp-Kurs "Objektorientierte Programmierung in Python " lernst du, OOP-Konzepte zu beherrschen und in realen Projekten anzuwenden.

NoSQL und dokumentenbasierte Modellierung

NoSQL und dokumentenbasierte Modellierungstechniken sind für flexible, schemafreie Datenbanken konzipiert.

Diese Technik wird oft verwendet, wenn die Datenstrukturen weniger starr sind oder sich im Laufe der Zeit verändern. Diese Modelle ermöglichen die Speicherung und Verwaltung unstrukturierter oder halbstrukturierter Daten, wie z. B. JSON-Dokumente, ohne vordefinierte Schemata.

In NoSQL-Datenbanken wie MongoDB werden die Daten in einem dokumentenbasierten Modell in Sammlungen von Dokumenten organisiert, wobei jedes Dokument eine einzigartige Struktur haben kann. Diese Flexibilität ermöglicht eine schnellere Iteration und Skalierung, insbesondere in Big-Data-Umgebungen oder Anwendungen, die einen schnellen Datenzugriff erfordern.

Beispiel: Speichern von Benutzerprofilen in MongoDB

In einer relationalen Datenbank können Benutzerprofile in mehreren Tabellen gespeichert sein. In einem dokumentenbasierten NoSQL-Modell wie MongoDB können die Daten eines Benutzers jedoch in einem einzigen JSON-ähnlichen Dokument gespeichert werden:

{

"user_id": 123,

"name": "Alice Smith",

"email": "alice@example.com",

"address": {

"street": "123 Main St",

"city": "New York",

"zip": "10001"

},

"purchases": [

{ "product_id": 101, "price": 19.99 },

{ "product_id": 202, "price": 49.99 }

]

}Datenmodelle mit Datenmodellierungstechniken abgleichen

Jede Datenmodellierungstechnik passt zu verschiedenen Phasen des Datenbankdesigns, von der High-Level-Planung bis zur physischen Implementierung. Hier siehst du, wie sie mit den Typen zusammenhängen, die wir weiter oben im Artikel gesehen haben:

- Konzeptuelles Datenmodell → Entity-Relationship (ER)-Modellierung

- Definiert Geschäftseinheiten und Beziehungen auf hoher Ebene ohne technische Details.

- Beispiel: Ein ER-Diagramm, das zeigt, wie Kunden, Bestellungen und Produkte zusammenhängen.

- Logisches Datenmodell → ER, dimensionales und objektorientiertes Modellieren

- Gibt die Datenstruktur, Attribute und Einschränkungen an, ohne sich auf die Speicherung zu konzentrieren.

- Beispiel: Ein Sternschema, das eine Faktentabelle für den Vertrieb mit Dimensionstabellen wie Zeit, Produkt und Kunde darstellt.

- Physisches Datenmodell → Dimensionale, objektorientierte und NoSQL-Modellierung

- Stellt dar, wie die Daten in einer Datenbank physisch gespeichert und optimiert werden.

- Beispiel: Ein MongoDB-Dokument, das Benutzerprofile als flexible JSON-Objekte speichert oder ein optimiertes relationales Schema in PostgreSQL.

Best Practices für die Datenmodellierung

Beim Aufbau eines effektiven Datenmodells geht es nicht nur darum, den richtigen Ansatz zu wählen, sondern auch darum, Best Practices zu befolgen, die dafür sorgen, dass dein Modell skalierbar, effizient und auf die Geschäftsanforderungen abgestimmt ist. Ein gut durchdachtes Modell hilft, häufige Probleme wie Redundanz, Leistungsengpässe und Schwierigkeiten bei der Anpassung an zukünftige Veränderungen zu vermeiden.

Im Folgenden gehen wir auf die wichtigsten Best Practices ein, die dir helfen, Datenmodelle zu erstellen, die langfristig nutzbar und leistungsfähig sind.

Frühzeitig normalisieren, bei Bedarf denormalisieren

Die Normalisierung ist ein grundlegendes Konzept bei der Datenmodellierung. Es organisiert die Daten so, dass Redundanzen minimiert werden und die Konsistenz gewährleistet ist, indem die Daten in kleinere, logisch zusammenhängende Tabellen strukturiert werden. Dieses Verfahren verringert die Wahrscheinlichkeit von Anomalien und Unstimmigkeiten und macht es einfacher, die Daten zu verwalten und zu aktualisieren.

Beispiel: Normalisierung einer Kundendatenbank

Anstatt Kunden- und Bestelldaten in einer großen Tabelle zu speichern:

|

Order_ID |

Customer_Name |

Kunde_Email |

Produkt |

Preis |

|

101 |

Alice Smith |

alice@email.com |

Laptop |

1200 |

|

102 |

Alice Smith |

alice@email.com |

Maus |

25 |

Du normalisierst, indem du Kunden und Bestellungen in zwei zusammengehörige Tabellen trennst:

- Kunden(

Customer_ID,Name,Email) - Bestellungen(

Order_ID,Customer_ID,Product,Price)

Dadurch werden redundante Kundendaten vermieden, was Aktualisierungen erleichtert.

Für Berichte und Analysen kann eine Denormalisierung jedoch notwendig sein, um die Abfrageleistung zu optimieren. Anstatt mehrere Tabellen zu verknüpfen, kann eine voraggregierte, denormalisierte Tabelle die Abfragen beschleunigen.

Es ist wichtig zu wissen, wann man welche Technik anwendet!

Schau dir unser ausführliches Tutorialüber Normalisierung in SQL an, um zu verstehen, wie Normalisierung die Datenintegrität verbessert und die Leistung optimiert.

Dein Datenmodell zukunftssicher machen

So wie sich die Unternehmen weiterentwickeln, so entwickeln sich auch ihre Datenanforderungen. Ein zukunftssicheres Datenmodell zu entwerfen bedeutet, ein flexibles und skalierbares Modell zu schaffen, das auf neue Datenquellen und veränderte Anforderungen vorbereitet ist.

Wenn du potenzielles Wachstum und zukünftige technologische Fortschritte berücksichtigst, kannst du kostspielige Nachbesserungen einkalkulieren und sie vermeiden. Wenn du von Anfang an auf Skalierbarkeit, Modularität und Wartungsfreundlichkeit achtest, kannst du sicher sein, dass sich das Modell an sich verändernde Landschaften anpassen lässt und auch im Laufe der Zeit einen Mehrwert liefert.

Beispiel: Planung der Skalierbarkeit in einer E-Commerce-Datenbank

Stell dir vor, du entwirfst eine Datenbank für einen Online-Store. Anfangs verfolgst du nur inländische Bestellungen, aber später expandierst du weltweit. Du wirst später größere Änderungen vornehmen müssen, wenn dein Schema nur eine einzige Währung unterstützt.

- Anstelle einer einfachen

PriceSpalte kannst du die FelderCurrency_CodeundExchange_Rateeinfügen. - Verwende ein flexibles Schema, das neue Attribute zulässt, ohne die Datenbank umzustrukturieren.

Andere Möglichkeiten, dein Modell zukunftssicher zu machen:

- Verwende UUIDs anstelle von automatisch inkrementierten IDs, um die Skalierbarkeit über verteilte Systeme hinweg zu gewährleisten.

- Betrachte die Schemaentwicklung in NoSQL-Datenbanken, wo Dokumente optionale Felder haben können, die sich im Laufe der Zeit ändern.

Sicherstellung von Datenqualität und -konsistenz

Ein Datenmodell ist nur so gut wie die Daten, die es enthält. Um die Datenqualität und -konsistenz im gesamten Modell aufrechtzuerhalten, ist die Einführung strenger Datenmanagement- und -validierungstechniken entscheidend.

Die Datenvalidierung stellt sicher, dass die richtige Art von Daten eingegeben wird und bestimmte Regeln befolgt werden, um Fehler zu reduzieren und die Zuverlässigkeit der Geschäftseinblicke zu erhöhen. So bleibt die Integrität des Datenmodells erhalten und es wird sichergestellt, dass sich die Entscheidungsträger auf die Informationen verlassen können, die es für genaue Erkenntnisse liefert.

Beispiel: Datenvalidierung für Produktauflistungen verwenden

Unstimmige Produktbeschreibungen in einem Online-Shop können zu Berichtsfehlern führen. Um dies zu verhindern:

- Verwende

CHECK, um zulässige Werte zu erzwingen (z. B.Stock_Quantity >= 0). - Implementiere Fremdschlüssel, um die referenzielle Integrität zu gewährleisten.

- Automatisiere die Datenvalidierung mit Tools, um Unstimmigkeiten zu erkennen, bevor sie sich auf die Berichterstattung auswirken.

Inmeinem Tutorial zu Great Expectationserfährst du, wie du die Datenvalidierung mit Python automatisieren und die Konsistenz in deinen Datenpipelines sicherstellen kannst.

Fokus auf geschäftliche Anforderungen

Ein gut durchdachtes Datenmodell sollte die Geschäftsziele direkt unterstützen. Arbeite vor der Erstellung des Schemas eng mit den Interessengruppen zusammen, um es zu definieren:

- Welche Erkenntnisse brauchen sie?

- Wie werden die Daten abgerufen und aktualisiert?

- Welche Kompromisse bei der Leistung sind akzeptabel?

Beispiel: Optimierung eines Dashboards für den Einzelhandel für schnellere Einblicke

Ein Einzelhandelsunternehmen möchte Verkaufstrends in Echtzeit verfolgen. Anstatt ein vollständig normalisiertes Schema mit mehreren Joins zu verwenden, könntest du eine denormalisierte Berichtstabelle entwerfen, die die täglichen Umsätze voraggregiert, wodurch Dashboard-Abfragen deutlich schneller werden.

Geschäftsorientiertes Datenmodell:

- Echtzeitdaten werden in einem OLTP-System (Online Transaction Processing) für schnelle Transaktionen gespeichert.

- Aggregierte Umsatzberichte werden zur Analyse in einer OLAP-Datenbank (Online Analytical Processing) gespeichert.

💡Erforscheunsere OLTP vs. OLAP-Leitfaden um zu verstehen, wann man für Transaktionen und wann für das Berichtswesen optimieren sollte.

Indem du das Datenmodell an den Geschäftsanforderungen ausrichtest, vermeidest du unnötige Komplexität und stellst sicher, dass die Beteiligten die benötigten Erkenntnisse ohne Leistungsprobleme erhalten.

Fazit

Das Verständnis und die Implementierung der richtigen Datenmodellierungstechniken sind unerlässlich, wenn du Daten effektiv strukturieren, verwalten und optimieren willst. Wie wir bereits herausgefunden haben, hängt die Wahl des Modellierungsansatzes von den Geschäftszielen, der Datenkomplexität und den Systemanforderungen ab.

Um dein Verständnis von Datenmodellierung, Data Warehousing und Datenbankdesign zu vertiefen, empfehle ich dir, diese Ressourcen zu nutzen:

- The Data Warehouse Toolkit - Ein grundlegender Leitfaden zur Dimensionsmodellierung von Ralph Kimball, der die besten Methoden für die Entwicklung von Data Warehouses beschreibt.

- Einführung in die Datenmodellierung in Snowflake - Lerne, wie du skalierbare Datenmodelle in Snowflake entwickelst.

- Data Warehousing-Konzepte - Verstehe die Grundprinzipien des Data Warehousing, einschließlich Dimensionsmodellierung und ETL-Prozesse.

- Datenbankdesign - Beherrsche Techniken zur Strukturierung von Datenbanken, um Effizienz, Konsistenz und Skalierbarkeit zu gewährleisten.

Werde Dateningenieur