Kurs

Dieser Artikel ist ein geschätzter Beitrag unserer Gemeinschaft und wurde von DataCamp auf Klarheit und Genauigkeit hin bearbeitet.

Willst du dein eigenes Fachwissen weitergeben? Wir würden uns freuen, von dir zu hören! Du kannst deine Artikel oder Ideen gerne über unser Community-Beitragsformular einreichen.

Was ist Datenintegration?

Daten sind heutzutage die Grundlage für jede Entscheidung, die wir treffen, und es ist wichtig, Daten aus verschiedenen Quellen zu verstehen und zu nutzen. Datenintegration ist der Prozess, bei dem Daten aus verschiedenen Quellen kombiniert und auf eine einheitliche und zusammenhängende Weise verfügbar gemacht werden. Sein Hauptziel ist es, eine ganzheitliche Sichtweise zu bieten, die es Unternehmen ermöglicht, wertvolle Erkenntnisse zu gewinnen, Abläufe zu rationalisieren und Entscheidungen auf der Grundlage von Daten statt auf der Basis von Theorie zu treffen.

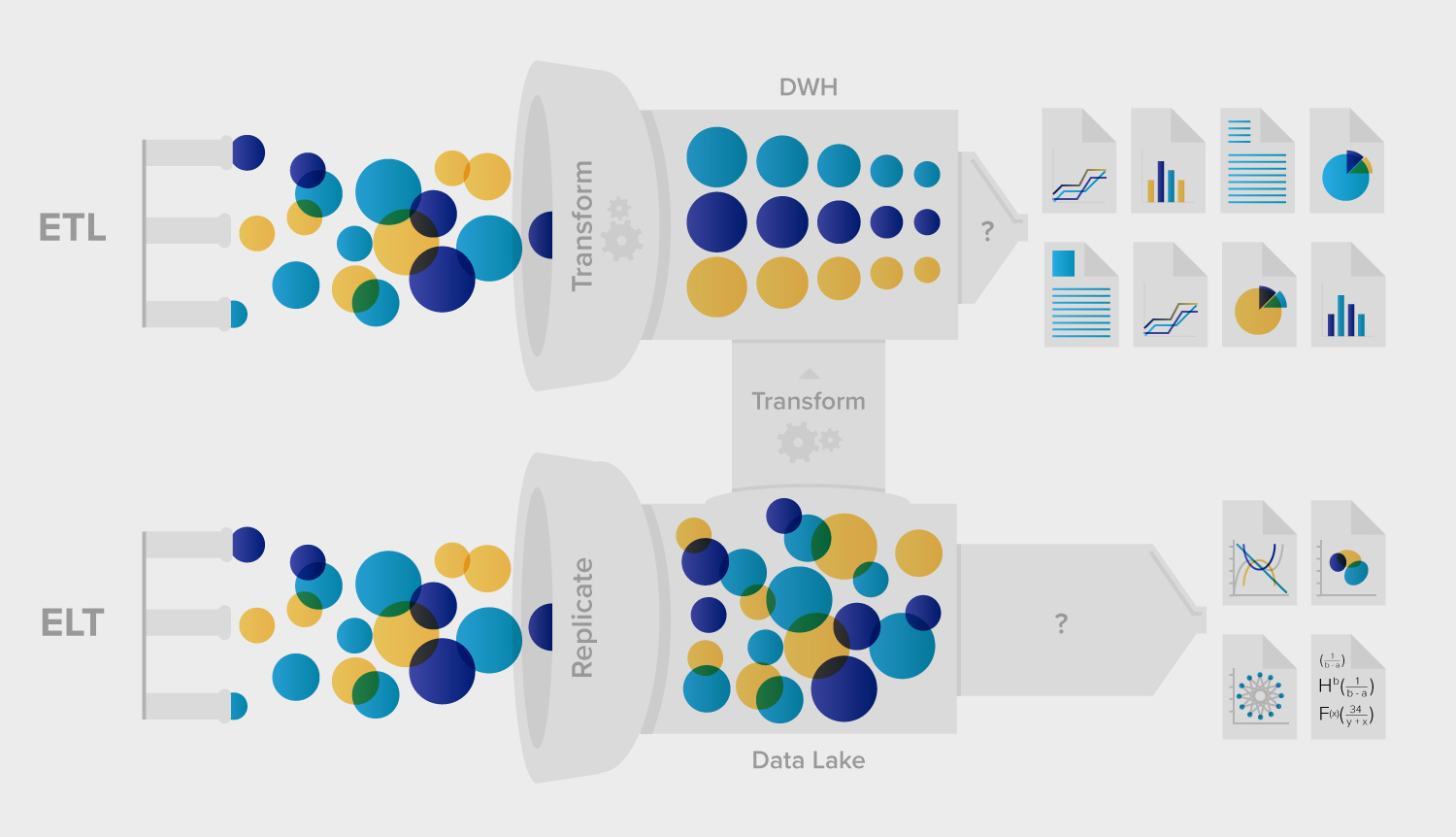

ETL und ELT: Zwei unterschiedliche Prozesse der Datenintegration

Unter der Vielzahl der verfügbaren Datenintegrationsstrategien und -tools sind ETL (Extract, Transform, Load) und ELT (Extract, Load, Transform) die beiden vorherrschenden Methoden. Diese Methoden stellen unterschiedliche Ansätze zur Datenintegration dar, die jeweils ihre Vorteile und Anwendungen haben.

Was ist ETL (Extract, Transform, Load)?

ETL besteht, wie das Akronym schon sagt, aus drei Hauptschritten:

- Auszug: Die Daten werden aus verschiedenen Quellsystemen gesammelt.

- Verwandeln: Die Daten werden dann in ein standardisiertes Format umgewandelt. Die Transformation kann Bereinigung, Aggregation, Anreicherung und andere Prozesse umfassen, um die Daten für ihren Zweck fit zu machen.

- Last: Die transformierten Daten werden in ein Ziel-Data-Warehouse oder ein anderes Repository geladen.

Anwendungsfälle und Stärken von ETL

ETL eignet sich besonders gut für Szenarien, in denen:

- Die Datenquellen sind kleiner und die Umwandlungen sind komplex.

- Es ist notwendig, die Verarbeitung der Transformation vom Zielsystem zu entlasten.

- Datensicherheit ist eine Priorität und erfordert Umwandlungen, um sensible Daten zu maskieren oder zu verschlüsseln, bevor sie in einem Lagerhaus landen.

ETL ist eine ausgezeichnete Wahl, wenn du Datenkonsistenz, -qualität und -sicherheit gewährleisten musst. Es verarbeitet die Daten, bevor sie das Warehouse erreichen, reduziert das Risiko der Offenlegung sensibler Daten und stellt sicher, dass die Daten den Geschäftsregeln und Standards entsprechen.

ETL-Datenintegration mit Python

Python, eine vielseitige und weit verbreitete Programmiersprache, hat sich zu einem beliebten Werkzeug für die ETL-Datenintegration entwickelt. Sein reichhaltiges Ökosystem an Bibliotheken und Frameworks erleichtert jeden Schritt des ETL-Prozesses und macht es zur ersten Wahl für Dateningenieure.

Wichtige Python-Bibliotheken für ETL

- Pandas: Pandas ist eine leistungsstarke Bibliothek für die Datenmanipulation und -analyse, die mit ihrer DataFrame-Struktur die Extraktion und Transformation von Daten vereinfacht.

- SQLAlchemy: Diese Bibliothek bietet eine einheitliche Methode, um mit Datenbanken zu interagieren, und hilft sowohl bei der Extraktions- als auch bei der Ladephase. Weitere Informationen findest du im SQLAlchemy-Tutorial von DataCamp.

- PySpark: Für die Big-Data-Verarbeitung bietet PySpark verteilte Datenverarbeitungsfunktionen und eignet sich damit für umfangreiche ETL-Aufgaben.

- Luigi und Apache Airflow: Dies sind Workflow-Management-Tools, die bei der Orchestrierung und Planung von ETL-Pipelines helfen.

Vorteile der Verwendung von Python für ETL

- Flexibilität: Die umfangreichen Bibliotheken von Python ermöglichen individuelle ETL-Prozesse, die auf die jeweiligen Bedürfnisse zugeschnitten sind.

- Skalierbarkeit: Mit Tools wie PySpark kann Python sowohl kleine als auch große Datensätze effizient verarbeiten.

- Unterstützung der Gemeinschaft: Eine große Gemeinschaft von Datenexperten bietet eine Fülle von Ressourcen, Tutorials und Lösungen für gängige ETL-Herausforderungen.

Die Einbindung von Python in ETL-Prozesse kann die Datenintegration rationalisieren und eine Mischung aus Effizienz, Flexibilität und Leistung bieten. Ob traditionelle Datenbanken oder Big-Data-Plattformen, die Möglichkeiten von Python im Bereich ETL sind grenzenlos.

Was ist ELT (Extract, Load, Transform)?

ELT verfolgt einen etwas anderen Ansatz:

- Auszug: Genau wie bei ETL werden die Daten aus verschiedenen Quellen gesammelt.

- Last: Anstatt sie sofort umzuwandeln, werden die Rohdaten direkt in das Zielsystem geladen.

- Transform: Transformationen finden innerhalb des Data Warehouses statt.

Der Aufschwung von ELT mit Cloud Computing

Die zunehmende Beliebtheit von ELT ist eng mit dem Aufkommen von Cloud-basierten Data Warehouses wie Snowflake, BigQuery und Redshift verbunden. Diese Plattformen verfügen über eine enorme Rechenleistung, die es ihnen ermöglicht, groß angelegte Transformationen im Lager effizient durchzuführen.

Vorteile von ELT

- Flexibilität: Da die Rohdaten zuerst geladen werden, können die Unternehmen später über die Transformationslogik entscheiden und so die Möglichkeit haben, sich an veränderte Anforderungen anzupassen.

- Effizienz: Durch die Nutzung der robusten Leistung moderner Cloud-Warehouses sind Transformationen schneller und skalierbarer.

- Eignung für große Datensätze: ELT ist in der Regel effizienter für große Datenmengen, da es die Leistung der massiven parallelen Verarbeitungsmöglichkeiten von Cloud Data Warehouses nutzt .

ETL vs. ELT: Eine vergleichende Analyse

Wichtige Gemeinsamkeiten und Unterschiede

Sowohl bei ETL als auch bei ELT geht es darum, Daten zu extrahieren und in ein Warehouse zu laden, aber der Hauptunterschied liegt darin, wo und wann der Transformationsprozess stattfindet. ETL wandelt die Daten um, bevor sie das Warehouse erreichen, während ELT dies erst danach tut.

Geschwindigkeit und Effizienz

Im Allgemeinen übertrifft die Geschwindigkeit der ELT-Datenaufnahme die der ETL, da weniger Daten bewegt werden. Die Gesamtgeschwindigkeit kann jedoch von Faktoren wie der Komplexität der Transformationen und den Fähigkeiten des Data Warehouses beeinflusst werden.

Datenumwandlung und Compliance

Bei ETL finden die Transformationen in einem Zwischensystem statt, das eine detailliertere Kontrolle über den Prozess bieten kann. Das ist wichtig für Unternehmen mit strengen Anforderungen an die Einhaltung von Vorschriften und die Datenverarbeitung. Im Gegensatz dazu verlässt sich ELT auf die Fähigkeiten des Zielsystems, das möglicherweise unbearbeitete, unmaskierte Daten preisgibt, bis die Umwandlungen abgeschlossen sind.

Die richtige Wahl treffen: ELT vs. ETL

Zu berücksichtigende Faktoren

Wenn du dich zwischen ETL und ELT entscheidest, bedenke:

- Geschäftstyp: Bei einem Startup könnte Flexibilität (ELT) im Vordergrund stehen, während bei einem Gesundheitsdienstleister die Datensicherheit (ETL) im Vordergrund steht.

- Datenbedarf: Sind Einblicke in Echtzeit wichtig oder reicht die tägliche Stapelverarbeitung aus?

- Infrastruktur: Die Wahl des Data Warehouse, die vorhandenen Tools und die IT-Fähigkeiten können die Entscheidung beeinflussen.

Die Rolle von Datenintegrationsplattformen

Moderne Datenintegrationsplattformen können die Grenzen zwischen ETL und ELT verwischen und bieten Tools, die die Stärken beider Ansätze kombinieren. Diese Plattformen können Unternehmen bei der Auswahl und Umsetzung der richtigen Strategie auf der Grundlage ihrer individuellen Anforderungen unterstützen.

Fazit

Die Entscheidung zwischen ETL und ELT ist nicht schwarz-weiß. Beide Methoden haben ihre Vorzüge, und die optimale Wahl hängt oft von den spezifischen Bedürfnissen und Umständen eines Unternehmens ab. Wenn du die Feinheiten jedes Ansatzes verstehst und moderne Datenintegrationsplattformen nutzt, können Datenverantwortliche fundierte Entscheidungen treffen und ihr Unternehmen in eine informierte Zukunft führen.

Für den Einstieg in ETL ist der DataCamp-Kurs "ETL mit Python " die ideale Ressource, denn er behandelt verschiedene Tools und die Erstellung effizienter Pipelines. Wenn du eine Karriere im Bereich Data Engineering anstrebst, solltest du dir unsere Data Engineer Zertifizierung ansehen, um deine Qualifikationen bei Arbeitgebern nachzuweisen.

Strategische, ergebnisorientierte Marketing-Führungskraft mit mehr als 15 Jahren Erfahrung in der Umsetzung von Wachstumsinitiativen in verschiedenen Branchen und Industrien.