Cours

Cet article est une contribution précieuse de notre communauté et a été édité par DataCamp dans un souci de clarté et d'exactitude.

Vous souhaitez partager votre expertise ? N'hésitez pas à nous contacter ! N'hésitez pas à soumettre vos articles ou vos idées via notre formulaire de contribution communautaire.

Qu'est-ce que l'intégration des données ?

De nos jours, les données sont à la base de toutes les décisions que nous prenons, et il est essentiel de comprendre et d'utiliser des données provenant de diverses sources. L'intégration des données est le processus par lequel des données provenant de sources multiples sont combinées et mises à disposition de manière unifiée et cohérente. Son objectif premier est d'offrir une vision globale, permettant aux entreprises de tirer des enseignements précieux, de rationaliser les opérations et de prendre des décisions fondées sur des données plutôt que sur la théorie.

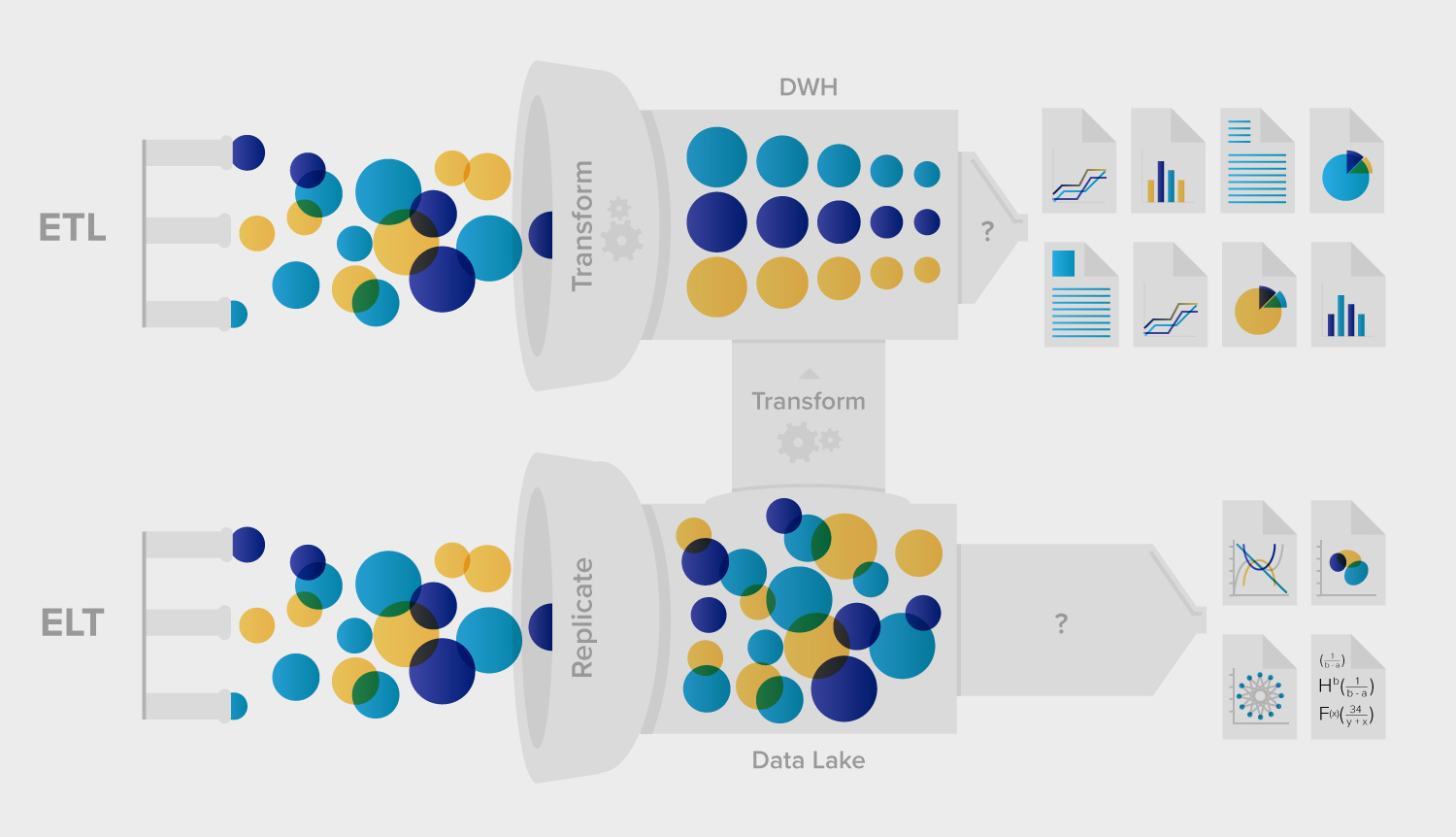

ETL et ELT : Deux processus d'intégration de données différents

Parmi la pléthore de stratégies et d' outils d' intégration de données disponibles, l'ETL (Extract, Transform, Load) et l'ELT (Extract, Load, Transform) sont les deux méthodologies prédominantes. Ces méthodes représentent des approches distinctes de l'intégration des données, chacune ayant ses avantages et ses applications.

Qu'est-ce que l'ETL (Extract, Transform, Load) ?

L'ETL, comme l'acronyme l'indique, consiste en trois étapes principales :

- Extrait : Les données sont collectées à partir de différents systèmes sources.

- Transformer : Les données sont ensuite transformées dans un format standardisé. La transformation peut inclure le nettoyage, l'agrégation, l'enrichissement et d'autres processus pour adapter les données à leur objectif.

- Chargement : Les données transformées sont chargées dans un entrepôt de données cible ou dans un autre référentiel.

Cas d'utilisation et atouts de l'ETL

L'ETL est particulièrement bien adapté aux scénarios dans lesquels :

- Les sources de données sont plus petites et les transformations sont complexes.

- Il est nécessaire de décharger le système cible du traitement de la transformation.

- La sécurité des données est une priorité qui nécessite des transformations pour masquer ou crypter les données sensibles avant qu'elles ne soient stockées dans un entrepôt.

L'ETL est un excellent choix lorsque vous devez garantir la cohérence, la qualité et la sécurité des données. Il traite les données avant qu'elles n'atteignent l'entrepôt, réduisant ainsi le risque d'exposition des données sensibles et garantissant que les données sont conformes aux règles et aux normes de l'entreprise.

ETL Intégration de données avec Python

Python, un langage de programmation polyvalent et largement utilisé, est devenu un outil de choix pour l'intégration de données ETL. Son riche écosystème de bibliothèques et de frameworks facilite chaque étape du processus ETL, ce qui en fait un choix incontournable pour les ingénieurs de données.

Principales bibliothèques Python pour l'ETL

- pandas : Puissante bibliothèque de manipulation et d'analyse de données, pandas simplifie l'extraction et la transformation des données grâce à sa structure DataFrame.

- SQLAlchemy : Cette bibliothèque fournit un moyen cohérent d'interagir avec les bases de données, en facilitant les phases d'extraction et de chargement. Pour plus d'informations, consultez le tutoriel SQLAlchemy de DataCamp.

- PySpark : Pour le traitement des big data, PySpark offre des capacités de traitement des données distribuées, ce qui le rend adapté aux tâches ETL à grande échelle.

- Luigi et Apache Airflow : Il s'agit d'outils de gestion des flux de travail qui permettent d'orchestrer et de planifier les pipelines ETL.

Avantages de l'utilisation de Python pour l'ETL

- Flexibilité : Les vastes bibliothèques de Python permettent de mettre en place des processus ETL personnalisés, adaptés à des besoins spécifiques.

- Évolutivité : Grâce à des outils tels que PySpark, Python peut traiter efficacement des ensembles de données de petite et de grande taille.

- Soutien communautaire : Une vaste communauté de professionnels des données signifie qu'une abondance de ressources, de tutoriels et de solutions est disponible pour les défis ETL les plus courants.

L'intégration de Python dans les processus ETL peut rationaliser l'intégration des données et produire un mélange d'efficacité, de flexibilité et de puissance. Qu'il s'agisse de bases de données traditionnelles ou de plateformes de big data, les capacités de Python en matière d'ETL sont illimitées.

Qu'est-ce que l'ELT (Extract, Load, Transform) ?

Les CLNA adoptent une approche légèrement différente :

- Extrait : Comme pour l'ETL, les données sont collectées à partir de différentes sources.

- Chargement : Au lieu de les transformer immédiatement, les données brutes sont directement chargées dans le système cible.

- Transformer : Les transformations ont lieu dans l'entrepôt de données.

L'essor des FLE grâce au cloud computing

La popularité croissante de l'ELT est étroitement liée à l'avènement des entrepôts de données basés sur le cloud, comme Snowflake, BigQuery et Redshift. Ces plateformes possèdent une immense puissance de traitement, ce qui leur permet de gérer efficacement les transformations à grande échelle au sein de l'entrepôt.

Avantages de l'ELT

- Flexibilité : Les données brutes étant chargées en premier, les entreprises peuvent décider de la logique de transformation ultérieurement, ce qui leur permet de s'adapter à l'évolution des besoins.

- Efficacité : En capitalisant sur la puissance robuste des entrepôts cloud modernes, les transformations sont plus rapides et plus évolutives.

- Adaptation aux grands ensembles de données : ELT est généralement plus efficace pour les grands ensembles de données, car il exploite la puissance des capacités de traitement parallèle massif des entrepôts de données en nuage.

ETL vs ELT : Une analyse comparative

Principales similitudes et différences

Si l'ETL et l'ELT impliquent tous deux l'extraction de données et leur chargement dans un entrepôt, leur principale distinction réside dans le lieu et le moment du processus de transformation. L'ETL transforme les données avant qu'elles n'atteignent l'entrepôt, tandis que l'ELT le fait après.

Rapidité et efficacité

En général, la vitesse d'ingestion des données de l'ELT dépasse celle de l'ETL en raison de la réduction des mouvements de données. Toutefois, la vitesse globale peut être influencée par des facteurs tels que la complexité des transformations et les capacités de l'entrepôt de données.

Transformation des données et conformité

Dans l'ETL, les transformations ont lieu dans un système intermédiaire, qui peut offrir un contrôle plus granulaire sur le processus. Ceci est vital pour les entreprises qui ont des exigences strictes en matière de conformité et de traitement des données. En revanche, l'ELT s'appuie sur les capacités du système cible, qui peut exposer des données brutes, non masquées, jusqu'à ce que les transformations soient terminées.

Faire le bon choix : ELT vs ETL

Facteurs à prendre en compte

Lorsque vous décidez de choisir entre ETL et ELT, tenez compte des éléments suivants :

- Type d'entreprise : Une startup peut privilégier la flexibilité (ELT), tandis qu'un prestataire de soins de santé peut privilégier la sécurité des données (ETL).

- Besoins en données : Les informations en temps réel sont-elles essentielles ou le traitement quotidien par lots est-il suffisant ?

- L'infrastructure : Le choix de l'entrepôt de données, les outils existants et les capacités informatiques peuvent influencer la décision.

Le rôle des plateformes d'intégration de données

Les plateformes d'intégration de données modernes peuvent brouiller les frontières entre l'ETL et l'ELT, en offrant des outils qui combinent les points forts des deux approches. Ces plateformes peuvent aider les entreprises à choisir et à mettre en œuvre la bonne stratégie en fonction de leurs besoins spécifiques.

Conclusion

Le choix entre l'ETL et l'ELT n'est pas tout blanc ou tout noir. Les deux méthodes ont leurs mérites et le choix optimal dépend souvent des besoins et des circonstances spécifiques de l'entreprise. En comprenant les subtilités de chaque approche et en exploitant les plateformes modernes d'intégration des données, les responsables des données peuvent prendre des décisions éclairées, conduisant leurs entreprises vers un avenir plus informé.

Pour débuter avec l'ETL, le cours ETL with Python de DataCamp est la ressource idéale, couvrant divers outils et la façon de créer des pipelines efficaces. Si vous souhaitez entamer une carrière dans le domaine de l'ingénierie des données, consultez notre certification d'ingénieur en données pour prouver vos compétences aux employeurs.

Leader en marketing stratégique, orienté vers les résultats, avec plus de 15 ans d'expérience dans la mise en œuvre d'initiatives de croissance dans divers secteurs verticaux et industriels.