Lernpfad

Kleine Sprachmodelle (SLMs) lösen das Problem, KI für Menschen mit begrenzten Ressourcen zugänglicher und effizienter zu machen, da sie kleiner, schneller und einfacher anzupassen sind als große Sprachmodelle (LLMs).

SLMs haben weniger Parameter (in der Regel unter 10 Milliarden), was die Rechenkosten und den Energieverbrauch drastisch reduziert. Sie konzentrieren sich auf bestimmte Aufgaben und werden auf kleineren Datensätzen trainiert. So wird ein Gleichgewicht zwischen Leistung und Ressourceneffizienz aufrechterhalten.

OpenAI Grundlagen

Benutze die OpenAI API und mehr!

Was sind kleine Sprachmodelle?

Kleine Sprachmodelle sind die kompakten, hocheffizienten Versionen der großen Sprachmodelle, von denen wir schon so viel gehört haben. LLMs wie GPT-4o haben Hunderte von Milliarden von Parametern, aber SMLs verwenden viel weniger - in der Regel Millionen bis ein paar Milliarden.

Die wichtigsten Merkmale von SLMs sind:

- Effizienz: SLMs brauchen nicht die enorme Rechenleistung, die LLMs erfordern. Dadurch eignen sie sich hervorragend für Geräte mit begrenzten Ressourcen, wie Smartphones, Tablets oder IoT-Geräte - mehr darüber erfährst du in diesem Blog über Edge-KI.

- Zugänglichkeit: Menschen mit begrenztem Budget können SLMs implementieren, ohne eine High-End-Infrastruktur zu benötigen. Sie eignen sich auch gut für den Einsatz vor Ort, wo Datenschutz und Datensicherheit sehr wichtig sind, da sie nicht immer auf eine cloudbasierte Infrastruktur angewiesen sind.

- Personalisierung: SLMs lassen sich leicht feinjustieren. Dank ihrer geringen Größe können sie sich schnell an Nischenaufgaben und spezialisierte Bereiche anpassen. Dadurch eignen sie sich gut für bestimmte Anwendungen wie den Kundendienst, das Gesundheitswesen oder das Bildungswesen (darauf gehen wir später noch genauer ein!).

- Schnellere Schlussfolgerungen: SLMs haben schnellere Reaktionszeiten, weil sie weniger Parameter verarbeiten müssen. Das macht sie perfekt für Echtzeitanwendungen wie Chatbots, virtuelle Assistenten oder jedes System, bei dem schnelle Entscheidungen wichtig sind. Du musst nicht auf Antworten warten, was für Umgebungen, in denen niedrige Latenzzeiten ein Muss sind, ideal ist.

Beispiele für kleine Sprachmodelle

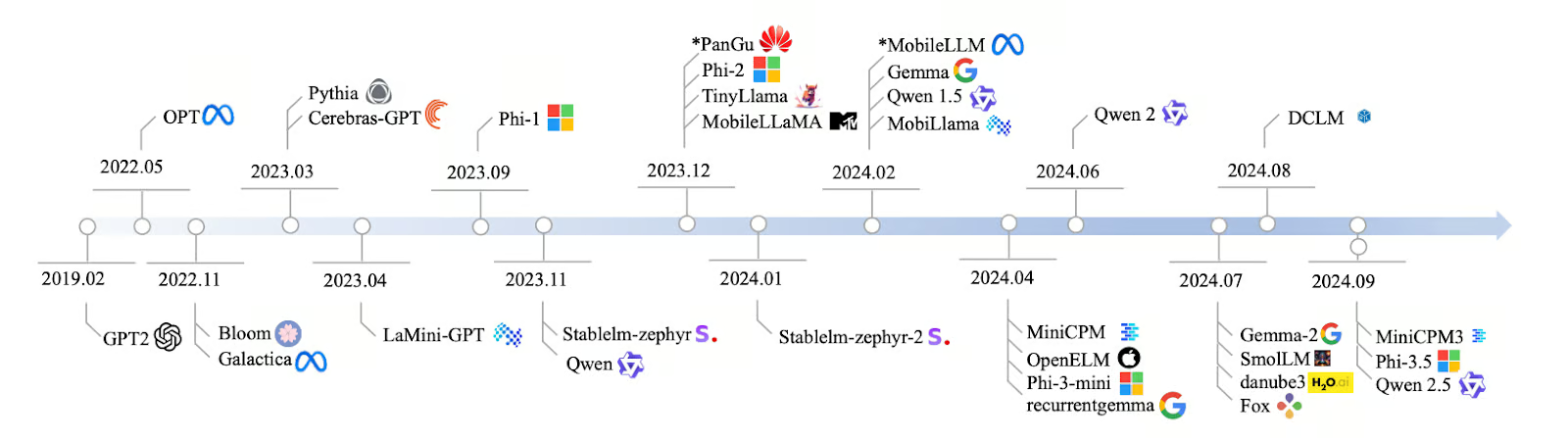

Die Entwicklung der SLMs von 2019 bis 2024 ist rasant, und es werden viele neue Modelle entwickelt, um den Bedarf an effizienterer KI zu decken. Es begann mit der GPT-2 im Jahr 2019, und im Laufe der Jahre wurden die Modelle immer zielgerichteter und schneller. Bis 2022 konnten Modelle wie Bloom und Galactica mehrere Sprachen und wissenschaftliche Daten verarbeiten, und 2023 wurden Modelle wie Pythia und Cerebras-GPT für Aufgaben wie Codieren und logisches Denken entwickelt.

Im Jahr 2024 wurden noch mehr SLMs veröffentlicht, wie LaMini-GPT, MobileLLaMA und TinyLlama, die für den Einsatz auf mobilen Geräten und anderen Systemen mit geringem Stromverbrauch konzipiert sind. Unternehmen wie Meta, Google und Microsoft sind führend in der Entwicklung dieser Modelle, von denen einige öffentlich zugänglich sind und andere privat bleiben.

Quelle: Lu et al., 2024

Praktiker/innen setzen SLMs in vielen Branchen ein, weil sie leicht und schnell sind und nicht viele Ressourcen benötigen, um zu funktionieren. Hier sind einige dieser Modelle mit ihren Parametern und wichtigsten Merkmalen:

|

Modellname |

Parameter |

Open Source |

Hauptmerkmale |

|

Qwen2 |

0.5B, 1B, 7B |

Ja |

Skalierbar, geeignet für verschiedene Aufgaben |

|

Mistral Nemo 12B |

12B |

Ja |

Komplexe NLP-Aufgaben, lokaler Einsatz |

|

Llama 3.1 8B |

8B |

Ja* |

Ausgewogene Leistung und Effizienz |

|

Pythia |

160M - 2,8B |

Ja |

Konzentriert auf Argumentation und Codierung |

|

Cerebras-GPT |

111M - 2,7B |

Ja |

Rechnereffizient, folgt den Chinchilla-Skalierungsgesetzen |

|

Phi-3.5 |

3.8B |

Ja** |

Lange Kontextlänge (128K Token), mehrsprachig |

|

StableLM-zephyr |

3B |

Ja |

Schnelle Inferenz, effizient für Edge-Systeme |

|

TinyLlama |

1.1B |

Ja |

Effizient für mobile und Edge-Geräte |

|

MobileLLaMA |

1.4B |

Ja |

Optimiert für mobile und stromsparende Geräte |

|

LaMini-GPT |

774M - 1,5B |

Ja |

Mehrsprachige, anweisungsgebundene Aufgaben |

|

Gemma2 |

9B, 27B |

Ja |

Lokaler Einsatz, Echtzeitanwendungen |

|

MiniCPM |

1B - 4B |

Ja |

Ausgewogene Leistung, Englisch und Chinesisch optimiert |

|

OpenELM |

270M - 3B |

Ja |

Multitasking, niedrige Latenz, energieeffizient |

|

DCLM |

1B |

Ja |

Gesunder Menschenverstand, logische Schlussfolgerung |

|

Fox |

1.6B |

Ja |

Geschwindigkeitsoptimiert für mobile Anwendungen |

*Mit Nutzungseinschränkungen

**Nur für Forschungszwecke

Mehr über diese Modelle erfährst du in diesem separaten Artikel, den ich über die besten kleinen Sprachmodelle.

Wie SLMs funktionieren

Wir wollen uns ansehen, wie kleine Sprachmodelle funktionieren.

Nächste Wortvorhersage

Genau wie LLMs funktionieren SLMs, indem sie das nächste Wort in einer Textsequenzvorhersagen. SLMs verwenden Muster aus dem Text, auf den sie trainiert wurden, um zu erraten, was als nächstes kommt. Es ist ein einfaches, aber wirkungsvolles Konzept, das allen Sprachmodellen zugrunde liegt.

Zum Beispiel, wenn die Eingabe: "In der Harry Potter-Reihe heißt der beste Freund der Hauptfigur Ron..." Ein SLM würde diesen Kontext analysieren und das wahrscheinlichste nächste Wort vorhersagen - in diesem Fall "Weasley".

Transformator-Architektur

Die Transformer-Architektur ist der Schlüssel dazu, wie LLMs und SLMs Sprache verstehen und erzeugen. Transformatoren können als das Gehirn hinter den Sprachmodellen verstanden werden. Sie nutzen Selbstaufmerksamkeit um herauszufinden, welche Wörter in einem Satz am besten zueinander passen. Das hilft dem Modell, den Kontext zu verstehen - zum Beispiel zu erkennen, dass "Paris" sich auf die Stadt oder die Person bezieht, die du von der Arbeit kennst.

Gleichgewicht zwischen Größe und Leistung

Die Stärke der SLMs liegt in ihrer Fähigkeit, Größe und Leistung in Einklang zu bringen. Sie verwenden deutlich weniger Parameter als LLMs, in der Regel zwischen Millionen und einigen Milliarden, im Vergleich zu Hunderten von Milliarden bei LLMs.

Mit weniger Parametern benötigen SLMs weniger Rechenleistung und Daten zum Trainieren, was sie zugänglicher macht, wenn du nur begrenzte Ressourcen hast. Durch ihre kompakte Größe können SLMs Eingaben schneller verarbeiten und Ausgaben erzeugen, was für Echtzeitanwendungen wie mobile Tastaturen oder Sprachassistenten sehr wichtig ist.

SLMs sind vielleicht nicht so vielseitig und verständnisvoll wie große Modelle, aber sie erledigen bestimmte Aufgaben gut. Ein SLM, der für die Analyse von Rechtstexten ausgebildet ist, könnte zum Beispiel bessere Arbeit leisten als ein allgemeiner LLM in diesem Bereich.

Wie SLMs erstellt werden: Techniken und Herangehensweisen

SLMs verwenden Techniken wie Destillation, Pruning und Quantisierung um kleiner, schneller und effizienter zu werden.

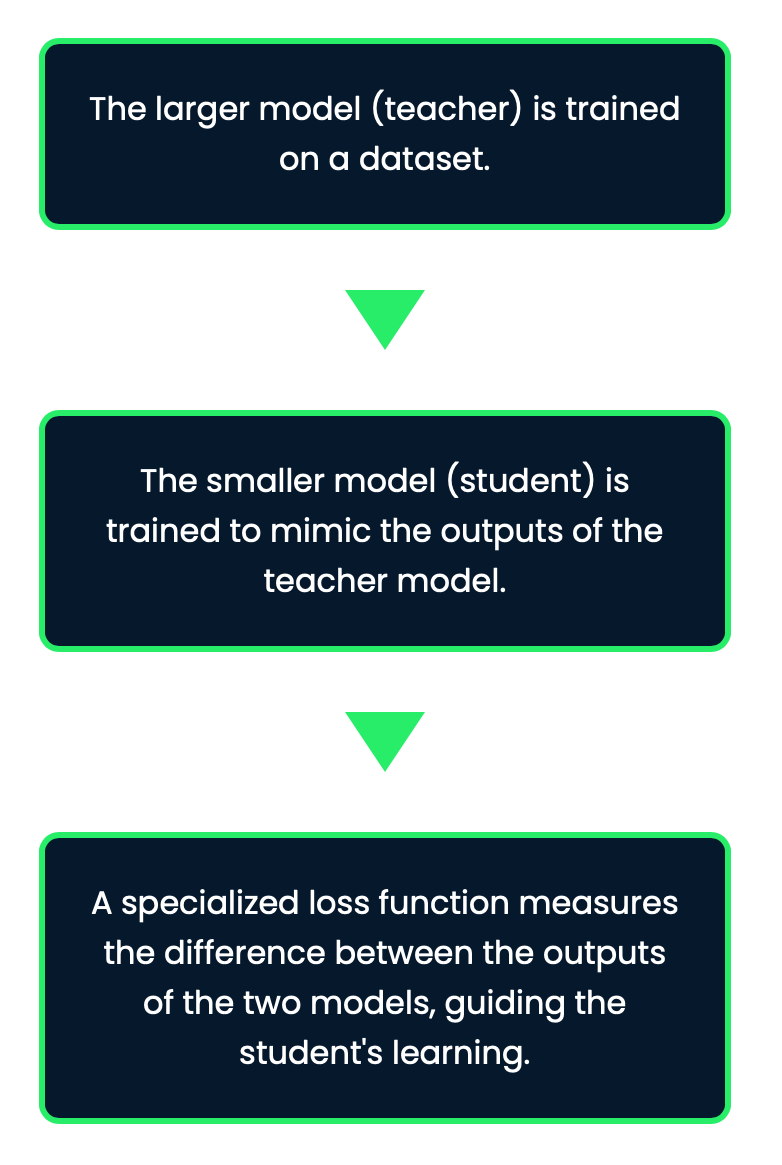

Destillation

Dies ist eine Technik zur Erstellung von SLMs, indem Wissen von einem größeren "Lehrer"-Modell auf ein kleineres "Schüler"-Modell übertragen wird. Das Ziel ist es, das, was das Lehrermodell gelernt hat, auf das Schülermodell zu übertragen, ohne zu viel von seiner Leistung zu verlieren.

Durch dieses Verfahren behalten SLMs einen Großteil der Genauigkeit größerer Modelle bei, sind aber in Bezug auf Größe und Rechenaufwand viel handlicher. Mit dieser Technik lernt das kleinere Modell nicht nur die endgültigen Vorhersagen der Lehrkraft, sondern auch die zugrunde liegenden Muster und Nuancen.

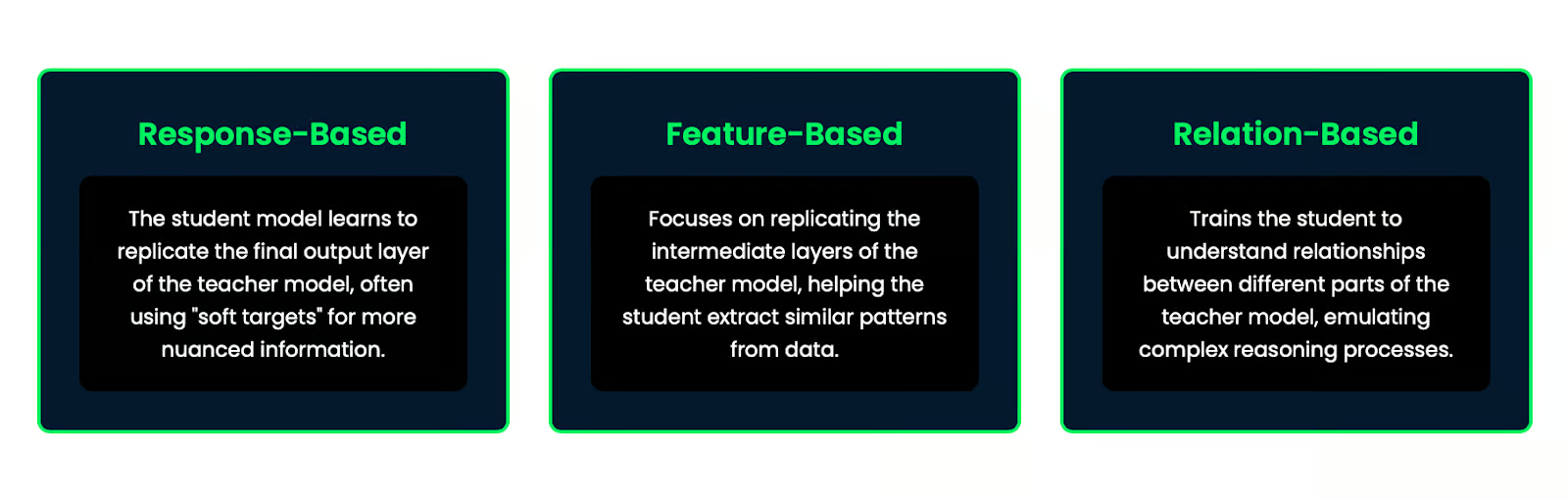

Es gibt verschiedene Methoden der Wissensdestillation:

- Reaktionsbasiert: Das Schülermodell lernt, die letzte Ausgabeschicht des Lehrermodells zu replizieren, wobei es oft "weiche Ziele" für differenziertere Informationen verwendet.

- Merkmalbasiert: Konzentriert sich darauf, die Zwischenschichten des Lehrermodells zu replizieren, um den Schüler/innen zu helfen, ähnliche Muster aus den Daten zu extrahieren.

- Beziehungsorientiert: Der Schüler/die Schülerin lernt, die Beziehungen zwischen den verschiedenen Teilen des Lehrermodells zu verstehen und komplexe Denkprozesse nachzuahmen.

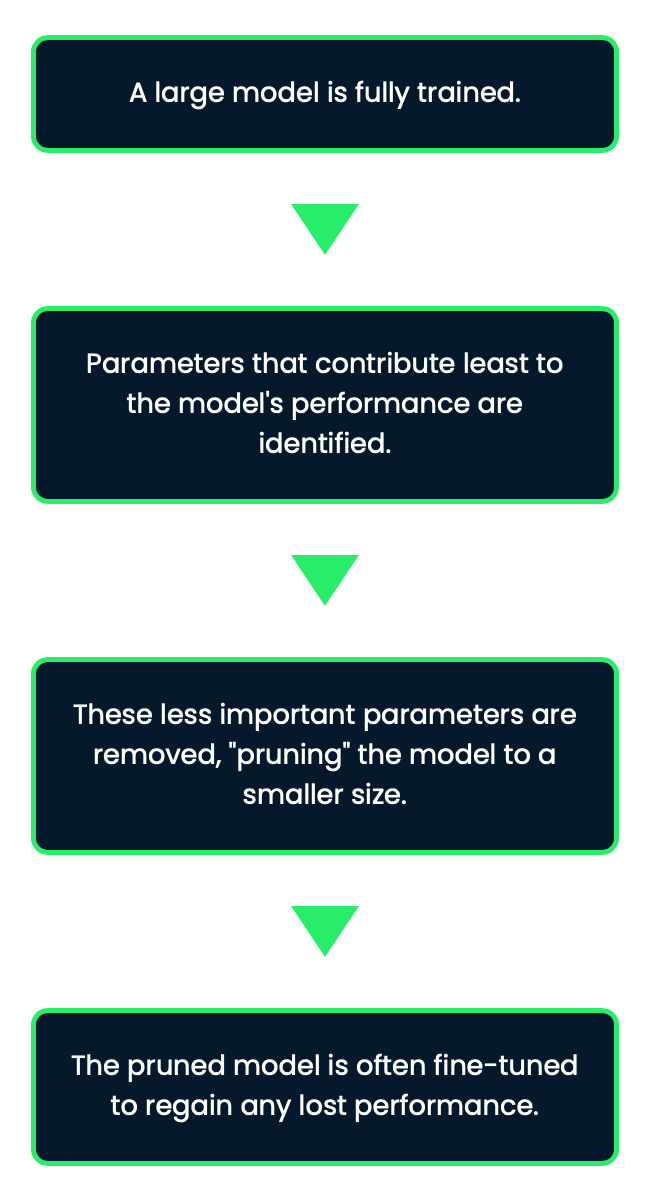

Beschneiden

Beschneiden ist so etwas wie das Beschneiden dessen, was nicht gebraucht wird. Beim Pruning werden Teile des Modells, die nicht so wichtig sind, wie Neuronen oder Parameter, die nicht viel zur Gesamtleistung beitragen, entfernt. Diese Technik hilft dabei, das Modell zu verkleinern, ohne seine Genauigkeit wesentlich zu beeinträchtigen. Das Beschneiden kann jedoch etwas knifflig sein, denn wenn du zu aggressiv vorgehst, läufst du Gefahr, zu viel herauszuschneiden und die Leistung des Modells zu beeinträchtigen.

Durch Pruning kann die Modellgröße erheblich reduziert werden, während ein Großteil der ursprünglichen Leistung erhalten bleibt, was es zu einer effektiven Technik für die Erstellung von SLMs macht.

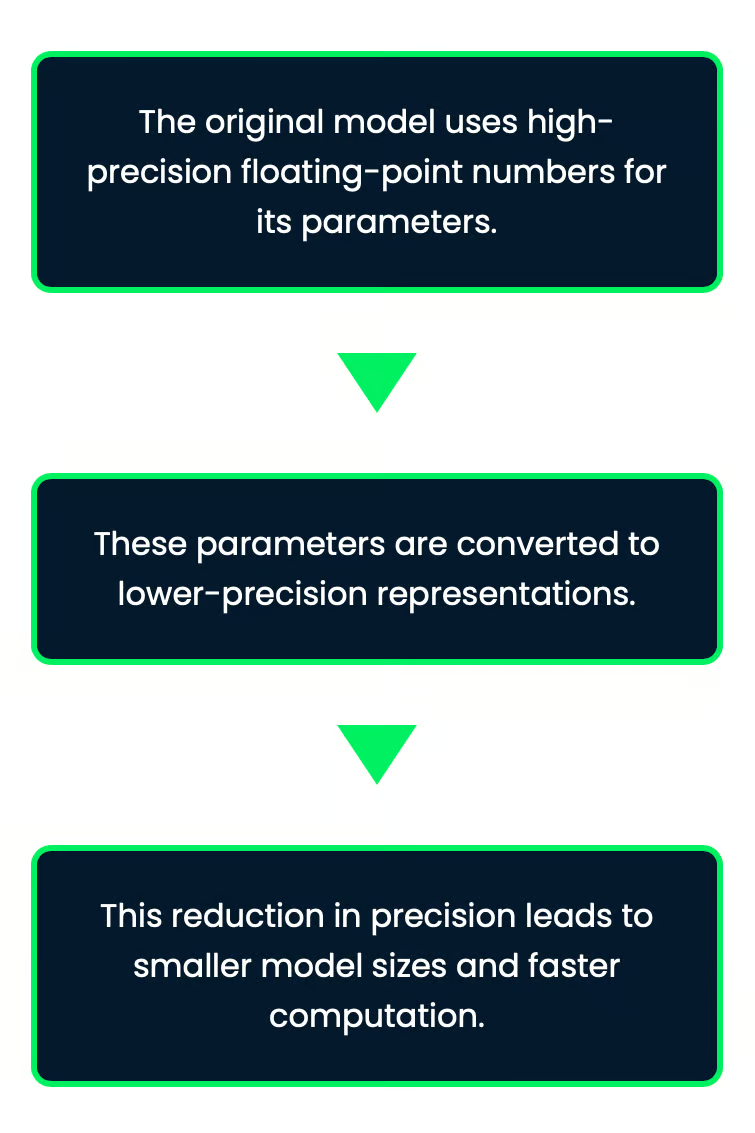

Quantisierung

Bei der Quantisierung werden weniger Bits verwendet, um die Zahlen des Modells zu speichern. Normalerweise verwendet ein Modell 32-Bit-Zahlen, aber mit dieser Methode werden diese Zahlen auf 8-Bit-Werte reduziert, die viel kleiner sind. Dadurch nimmt das Modell weniger Platz ein und kann schneller laufen. Das Beste daran ist, dass das Modell trotz der weniger präzisen Zahlen immer noch gut funktioniert und seine Genauigkeit nur geringfügig beeinträchtigt.

Stell dir vor, du speicherst die Temperaturwerte in einer Wetter-App. Du würdest sie mit hoher Genauigkeit (wie 32-Bit-Zahlen) speichern, was mehr ist, als du brauchst. Wenn du die Genauigkeit auf 8-Bit reduzierst, verlierst du zwar Details, aber die App ist immer noch nützlich, läuft schneller und verbraucht weniger Speicher.

Dies ist besonders nützlich für den Einsatz von KI auf Geräten mit begrenztem Speicher und begrenzter Rechenleistung, wie Smartphones oder Edge-Geräten.

Die Quantisierung ist besonders effektiv für den Einsatz von Modellen auf Geräten mit begrenzten Ressourcen, da sie den Speicherbedarf reduziert und die Inferenzgeschwindigkeit erhöht.

Anwendungen von Small Language Models

Das Schöne an SLMs ist, dass sie leistungsstarke KI liefern können, ohne dass eine große Infrastruktur oder eine ständige Internetverbindung erforderlich ist, was viele Anwendungsmöglichkeiten eröffnet.

On-Device-KI

Denken wir an die mobilen Assistenten - die Sprachassistenten auf deinem Telefon, die dir helfen, deinen Tag zu meistern. SLMs machen dies möglich. Sie ermöglichen Textvorhersagen in Echtzeit, Sprachbefehle und sogar Übersetzungen, ohne dass Daten in die Cloud gesendet werden müssen. Alles wird lokal erledigt, was schnellere Antworten und mehr Schutz der Privatsphäre bedeutet.

SwiftKey und Gboard zum Beispiel nutzen SLMs, um kontextgenaue Textvorschläge zu liefern, was die Tippgeschwindigkeit und -genauigkeit verbessert.

Das gilt auch für Offline-Anwendungen, bei denen die KI auch ohne Internetverbindung funktioniert, was sie in Gebieten mit eingeschränkter Konnektivität nützlich macht.

Google Translate zum Beispiel bietet Offline-Übersetzungsfunktionen, die von SLMs unterstützt werden und die Kommunikation in Gebieten mit begrenztem Internetzugang erleichtern.

Personalisierte KI

Einer der großen Vorteile von SLMs ist, dass sie für bestimmte Aufgaben oder Benutzerpräferenzen angepasst werden können. Stell dir vor, du hättest einen Chatbot, der speziell auf den Kundenservice in deinem Unternehmen abgestimmt ist, oder eine KI, die aufgrund deiner bisherigen Interaktionen genau weiß, wie sie dir helfen kann. Weil diese Modelle kleiner sind, lassen sie sich viel leichter anpassen und in verschiedenen Branchen einsetzen.

Schauen wir uns einige Beispiele an:

- Gesundheitswesen: SLMs können für die medizinische Textanalyse angepasst werden, um Echtzeit-Gesundheitsüberwachung und -beratung auf Smart Wearables zu ermöglichen. Sie funktionieren unabhängig von einer kontinuierlichen Cloud-Konnektivität.

- Smart Home Geräte: SLMs, die in Smart-Home-Systeme eingebettet sind, können individuelle Vorlieben für Temperatur und Beleuchtung lernen und die Einstellungen automatisch für verschiedene Tageszeiten oder bestimmte Anlässe anpassen.

- Bildung: Bildungsapps, die SLMs verwenden, können sich an individuelle Lernstile und -tempi anpassen, was den Schüler/innen eine persönliche Anleitung und Unterstützung bietet.

Internet der Dinge

SLMs laufen unauffällig im Hintergrund auf alltäglichen Geräten wie deinem Smart Home System oder anderen Gadgets. Sie helfen diesen Geräten, dich zu verstehen und direkt auf dich zu reagieren, ohne dass sie mit dem Internet verbunden sein müssen, was sie schneller und intelligenter macht.

Andere Anwendungen

SLMs finden auch in zahlreichen anderen Bereichen Anwendung:

- Sprachübersetzung in Echtzeit: SLMs ermöglichen eine sofortige Übersetzung, was für die globale Kommunikation wichtig ist. Einige Reise-Apps nutzen jetzt SLMs, um Schilder, Menüs oder gesprochene Wegbeschreibungen in Echtzeit zu übersetzen. Das hilft den Nutzern bei der Navigation in fremden Sprachen.

- Fahrzeugsysteme: In Autos sorgen SLMs für eine intelligente Navigation, indem sie Verkehrsmeldungen in Echtzeit liefern und die besten Routen vorschlagen. Sie verbessern auch die Sprachsteuerung, so dass der Fahrer Musik steuern, telefonieren oder Nachrichten verschicken kann, ohne die Hände zu benutzen.

- Unterhaltungssysteme: Smart TVs und Spielkonsolen nutzen SLMs zur Sprachsteuerung und um Sendungen oder Spiele vorzuschlagen, die auf dem basieren, was du zuvor gesehen oder gespielt hast.

- Kundenbetreuung: SLMs helfen Unternehmen, Kundenfragen effizienter zu bearbeiten. Einzelhandelsgeschäfte nutzen SLM, um Fragen zu Produkten, zum Bestellstatus oder zu Rückgabebedingungen zu beantworten. Dadurch verringert sich der Bedarf an menschlichem Kundensupport.

LLMs vs. SLMs

Jetzt lass uns darüber reden, wann ein LLM die bessere Wahl ist und wann ein SLM die bessere Wahl ist.

Komplexität der Aufgabe

Für hochkomplexe Aufgaben wie Deep Understanding, die Erstellung langer Inhalte oder das Lösen kniffliger Probleme sind große Modelle wie GPT-4o in der Regel besser ab als SLMs. Sie können diese Aufgaben bewältigen, weil sie aus einer riesigen Menge von Daten schöpfen, um detailliertere Antworten zu geben. Der Nachteil ist jedoch, dass dieses Maß an Raffinesse viel Rechenleistung und Zeit erfordert.

|

LLMs |

SLMs |

|

Du kannst gut mit komplexen, anspruchsvollen und allgemeinen Aufgaben umgehen |

Am besten geeignet für angemessenere, einfachere Aufgaben |

|

Bessere Genauigkeit und Leistung bei verschiedenen Aufgaben |

Großartig bei spezialisierten Anwendungen und domänenspezifischen Aufgaben |

|

In der Lage sein, den Kontext über lange Passagen aufrechtzuerhalten und eine kohärente Antwort zu geben |

Kann Schwierigkeiten mit komplexen Sprachaufgaben und weitreichendem Kontextverständnis haben |

Wenn du zum Beispiel einen Allzweck-Chatbot entwickelst, der verschiedene Themen und komplexe Anfragen bearbeiten muss, wäre ein LLM besser geeignet. Für einen spezialisierten Kundenbetreuer, der sich auf eine bestimmte Produktlinie konzentriert, könnte ein SLM jedoch mehr als ausreichend sein und aufgrund seiner gezielten Ausbildung sogar einen LLM übertreffen.

Ressourcenbeschränkungen

Wenn die Ressourcen begrenzt sind, sind die SLMs die Gewinner. Sie benötigen viel weniger Rechenleistung für die Ausbildung und den Einsatz. Sie sind eine gute Option, wenn du in einer ressourcenbeschränkten Umgebung arbeitest.

|

LLMs |

SLMs |

|

Benötigen viel Rechenleistung und Speicherplatz |

Sparsamer in Bezug auf den Ressourcenverbrauch |

|

Benötigen oft spezielle Hardware wie GPUs für Inferenzen |

Kann auf Standard-Hardware und sogar auf Geräten wie dem Raspberry Pi oder Smartphone laufen |

|

Höhere Betriebskosten aufgrund des Ressourcenbedarfs |

Kürzere Ausbildungszeiten, wodurch sie für schnelle Einsätze besser zugänglich sind |

In Situationen, in denen die Rechenleistung begrenzt ist, wie bei mobilen Geräten oder Edge Computing, sind SLMs oft die bessere Option, da sie eine gute Mischung aus Leistung und Effizienz bieten.

Einsatzumgebung

Wenn du KI auf einem Cloud-Server einsetzt, bei dem die Ressourcen keine Rolle spielen, könnte ein LLM die richtige Wahl sein, vor allem, wenn du eine hohe Genauigkeit und flüssige Antworten brauchst. Aber wenn du an Geräten mit begrenzter CPU- oder GPU-Leistung arbeitest, wie IoT-Geräte oder mobile Anwendungen, sind SLMs die perfekte Lösung.

|

LLMs |

SLMs |

|

Am besten geeignet für Cloud-Umgebungen, in denen viel Rechenleistung verfügbar ist |

Sie können in der Cloud verwendet werden, aber ihre geringere Größe macht sie besser für Orte mit begrenzten Ressourcen. Sie sind effizienter bei der Bewältigung kleinerer Aufgaben |

|

Nicht ideal für On-Device-KI, da sie viel Rechenleistung benötigt und auf eine Internetverbindung angewiesen ist |

Perfekt für On-Device-KI, die Offline-Nutzung und schnellere Reaktionszeiten ermöglicht. Sie können mobile Assistenten, Spracherkennung und andere Echtzeit-Apps ausführen, ohne dass sie eine Internetverbindung benötigen |

|

Nicht gut geeignet für Edge Computing, da sie viel Rechenleistung benötigen und langsam reagieren können |

Ideal für Edge Computing, wo schnelle Reaktionen und eine effiziente Nutzung von Ressourcen wichtig sind. Sie ermöglichen KI in IoT-Geräten, Smart Homes und anderen Edge-Anwendungen |

Bei der Auswahl der Einsatzumgebung ist es wichtig, Faktoren wie Internetverbindungen, Latenzzeiten und Datenschutz zu berücksichtigen. Für Anwendungen, die offline oder mit minimaler Latenz funktionieren müssen, sind SLMs, die auf dem Gerät oder am Rand eingesetzt werden, oft die bessere Wahl.

Die Entscheidung zwischen LLMs und SLMs hängt von der Komplexität der Aufgabe, den vorhandenen Ressourcen und dem Ort ab, an dem du sie einsetzen willst. LLMs eignen sich hervorragend für komplexe Aufgaben, die eine hohe Genauigkeit erfordern, während SLMs effizient sind und an mehr Stellen arbeiten können.

Fazit

SLMs machen KI viel leichter zugänglich. Im Gegensatz zu großen Sprachmodellen, die viel Rechenleistung benötigen, kommen SLMs mit weniger Ressourcen aus. Das bedeutet, dass kleinere Unternehmen, einzelne Entwickler und sogar Startups sie nutzen können, ohne riesige Server oder große Budgets zu benötigen.

Um mehr über kleine Sprachmodelle zu erfahren, empfehle ich diese beiden Ressourcen:

FAQs

Was sind die spezifischen Unterschiede im Energieverbrauch zwischen einem SLM und einem LLM für eine typische Unternehmensanwendung?

Der Unterschied im Energieverbrauch zwischen SLMs und LLMs kann erheblich sein. Für eine typische Unternehmensanwendung verbraucht ein SLM vielleicht nur 10-20% der Energie, die ein LLM benötigt. Der Betrieb eines SLM für einen Kundenservice-Chatbot könnte beispielsweise 50-100 kWh pro Monat verbrauchen, während ein LLM für dieselbe Aufgabe 500-1000 kWh verbrauchen könnte. Die genauen Zahlen variieren jedoch je nach Modellgröße, Nutzungsmuster und Hardware-Effizienz. Unternehmen wie Google und OpenAI haben berichtet, dass der Betrieb ihrer größten Modelle die Energie von mehreren hundert Haushalten verbrauchen kann, während SLMs oft auf Standardservern oder sogar Edge-Geräten mit deutlich geringerem Energiebedarf laufen können.

Wie sehen die Entwicklungszeiten bei der Erstellung von benutzerdefinierten SLMs im Vergleich zur Feinabstimmung bestehender LLMs für spezielle Aufgaben aus?

Die Entwicklungszeiten für benutzerdefinierte SLMs und LLMs zur Feinabstimmung können sich erheblich unterscheiden. Die Erstellung eines benutzerdefinierten SLM von Grund auf dauert in der Regel länger, oft 3-6 Monate für ein Team erfahrener Datenwissenschaftler, da es die Sammlung von Daten, den Entwurf der Modellarchitektur, Schulungen und umfangreiche Tests umfasst. Die Feinabstimmung eines bestehenden LLM für eine spezielle Aufgabe kann viel schneller gehen und möglicherweise nur ein paar Wochen dauern. Der Nachteil ist jedoch, dass fein abgestimmte LLMs möglicherweise nicht dasselbe Maß an Effizienz oder Spezialisierung erreichen wie ein speziell angefertigtes SLM. Die Wahl hängt oft vom konkreten Anwendungsfall, den verfügbaren Ressourcen und den gewünschten Leistungsmerkmalen ab.

Welche rechtlichen und ethischen Überlegungen gibt es beim Einsatz von SLMs im Vergleich zu LLMs, insbesondere in Bezug auf Datenschutz und geistiges Eigentum?

Der Datenschutz ist ein wichtiges Anliegen, da die LLMs oft viele Ausbildungsdaten haben, was das Risiko der Preisgabe persönlicher Daten erhöht. SLMs sind fokussierter und können kleinere, kontrolliertere Datensätze verwenden, was die Risiken für die Privatsphäre verringern könnte. Fragen des geistigen Eigentums sind ebenfalls kritisch, da LLMs, die auf diversen Internetdaten ausgebildet werden, urheberrechtlich geschützte Inhalte wiedergeben könnten. SLMs, die auf spezifischere Daten trainiert wurden, sind zwar weniger mit solchen Risiken konfrontiert, können aber je nach Trainingsdaten immer noch auf Probleme stoßen. Außerdem sind die Interpretierbarkeit und Erklärbarkeit von Modellentscheidungen mit SLMs oft einfacher, was für Anwendungen in regulierten Branchen sehr wichtig sein kann.

Wie schneiden SLMs und LLMs in Bezug auf ihre Mehrsprachigkeit ab, insbesondere bei weniger verbreiteten Sprachen?

SLMs und LLMs gehen unterschiedlich mit mehreren Sprachen um, vor allem bei weniger verbreiteten Sprachen. LLMs mit ihren riesigen Trainingsdaten funktionieren in der Regel gut in vielen Sprachen, auch in seltenen, aber das hat den Nachteil, dass sie groß und komplex sind. SLMs sind zwar kleiner, können aber für bestimmte Sprachen oder Sprachgruppen maßgeschneidert werden und schlagen manchmal sogar LLMs in diesen Bereichen. Für weniger verbreitete Sprachen können speziell geschulte SLMs genauere und kultursensiblere Übersetzungen oder Texte liefern, da sie sich auf hochwertige, sprachspezifische Daten konzentrieren, im Gegensatz zu den breiteren, aber möglicherweise weniger präzisen Daten, die in LLMs verwendet werden.

Was sind die besten Praktiken für die Versionskontrolle und Modellverwaltung bei der Arbeit mit SLMs und LLMs in einer Produktionsumgebung?

Best Practices für die Verwaltung von Versionen und die Überwachung von SLMs und LLMs in Produktionsumgebungen haben Ähnlichkeiten, aber auch wichtige Unterschiede. Für beides ist es wichtig, ein gutes Versionierungssystem für Modelle, Trainingsdaten und Einstellungen zu haben. Allerdings benötigen LLMs aufgrund ihrer Größe und ihrer Empfindlichkeit gegenüber Feinabstimmungen eine komplexere Infrastruktur für die Versionskontrolle. Da SLMs kleiner sind, ist es einfacher, verschiedene Versionen zu verwalten und einzusetzen. Wenn es um die Verwaltung geht, brauchen LLMs in der Regel eine strengere Aufsicht, da sie eine große Bandbreite an Fähigkeiten haben und zu unerwartetem Verhalten neigen. SLMs mit ihren spezifischeren Verwendungszwecken benötigen möglicherweise weniger Aufsicht, aber eine gezieltere Steuerung. In beiden Fällen sind regelmäßige Überprüfungen, die Verfolgung der Leistung und eine klare Dokumentation der Einschränkungen und des Verwendungszwecks sehr wichtig für einen verantwortungsvollen KI-Einsatz.