Cursus

Les petits modèles linguistiques (SLM) résolvent le problème de l'accessibilité et de l'efficacité de l'IA pour les personnes disposant de ressources limitées, car ils sont plus petits, plus rapides et plus facilement personnalisables que les grands modèles de langage (LLM).

Les SLM ont moins de paramètres (généralement moins de 10 milliards), ce qui réduit considérablement les coûts de calcul et la consommation d'énergie. Ils se concentrent sur des tâches spécifiques et sont formés sur des ensembles de données plus restreints. Cela permet de maintenir un équilibre entre les performances et l'efficacité des ressources.

Principes fondamentaux de l'OpenAI

Commencez à utiliser l'API OpenAI et plus encore !

Que sont les petits modèles linguistiques ?

Les petits modèles linguistiques sont les versions compactes et très efficaces des grands modèles linguistiques massifs dont nous avons tant entendu parler. Les LLM comme le GPT-4o ont des centaines de milliards de paramètres, mais les SML en utilisent beaucoup moins, généralement de l'ordre de quelques millions à quelques milliards.

Les principales caractéristiques des SLM sont les suivantes

- Efficacité: Les SLM n'ont pas besoin de la puissance de calcul massive qu'exigent les LLM. Ils sont donc parfaits pour une utilisation sur des appareils aux ressources limitées, comme les smartphones, les tablettes ou les appareils IoT - pour en savoir plus, consultez ce blog sur la edge AI.

- Accessibilité: Les personnes disposant d'un budget limité peuvent mettre en œuvre des SLM sans avoir besoin d'une infrastructure haut de gamme. Ils sont également bien adaptés aux déploiements sur site où la confidentialité et la sécurité des données sont très importantes, car ils ne s'appuient pas toujours sur une infrastructure basée sur le cloud.

- Personnalisation: Les SLM sont faciles à régler. Leur taille réduite leur permet de s'adapter rapidement à des tâches de niche et à des domaines spécialisés. Ils sont donc bien adaptés à des applications spécifiques telles que l'assistance à la clientèle, les soins de santé ou l'éducation (nous y reviendrons plus en détail par la suite !).

- Inférence plus rapide: Les SLM ont des temps de réponse plus rapides car ils ont moins de paramètres à traiter. Ils sont donc parfaits pour les applications en temps réel telles que les chatbots, les assistants virtuels ou tout autre système dans lequel des décisions rapides sont essentielles. Vous n'avez pas besoin d'attendre les réponses, ce qui est idéal pour les environnements où une faible latence est indispensable.

Exemples de petits modèles linguistiques

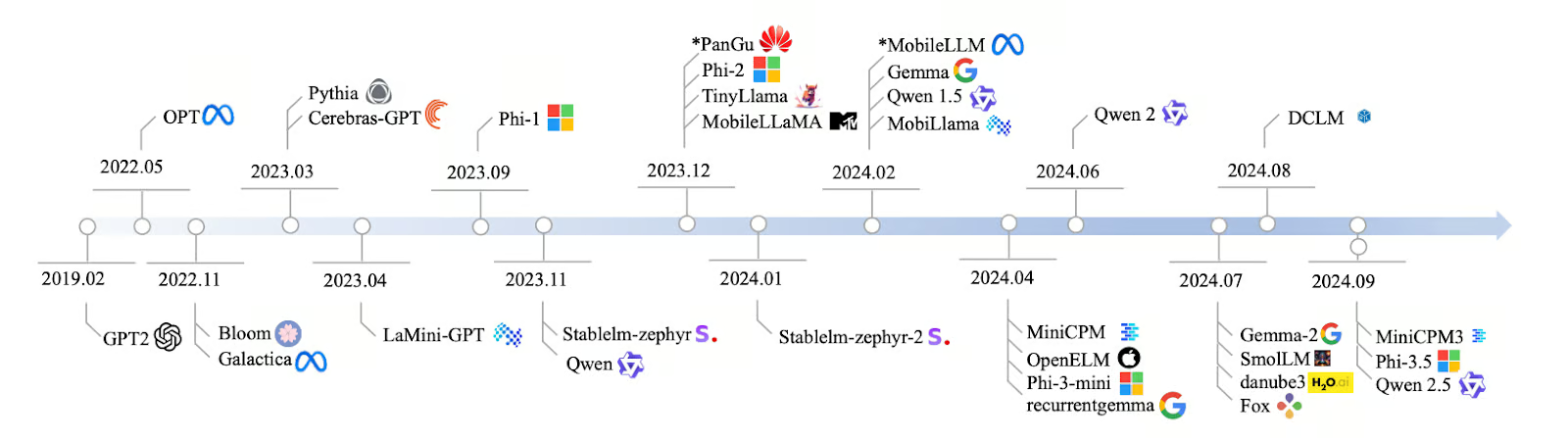

Le développement des SLM entre 2019 et 2024 a été rapide, de nombreux nouveaux modèles ayant été créés pour répondre au besoin d'une IA plus efficace. Cela a commencé avec le GPT-2 en 2019 et, au fil des ans, les modèles sont devenus plus ciblés et plus rapides. En 2022, des modèles comme Bloom et Galactica pouvaient traiter plusieurs langues et des données scientifiques, et en 2023, des modèles comme Pythia et Cerebras-GPT étaient conçus pour des tâches telles que le codage et la pensée logique.

En 2024, d'autres SLM ont été lancés, tels que LaMini-GPT, MobileLLaMA et TinyLlama, qui sont conçus pour fonctionner correctement sur des appareils mobiles et d'autres systèmes à faible consommation d'énergie. Des entreprises comme Meta, Google et Microsoft sont à la tête du développement de ces modèles, certains étant ouverts au public et d'autres restant privés.

Source : Lu et al, 2024

Les praticiens utilisent les SLM dans de nombreuses industries parce qu'ils sont légers, rapides et ne nécessitent pas beaucoup de ressources pour fonctionner. Voici quelques-uns de ces modèles, avec leurs paramètres et leurs principales caractéristiques :

|

Nom du modèle |

Paramètres |

Source ouverte |

Caractéristiques principales |

|

Qwen2 |

0,5B, 1B, 7B |

Oui |

Évolutif, adapté à diverses tâches |

|

Mistral Nemo 12B |

12B |

Oui |

Tâches NLP complexes, déploiement local |

|

Llama 3.1 8B |

8B |

Oui* |

Puissance et efficacité équilibrées |

|

Pythie |

160M - 2.8B |

Oui |

Axé sur le raisonnement et le codage |

|

Cerebras-GPT |

111M - 2.7B |

Oui |

Efficacité informatique, respect des lois d'échelle de Chinchilla |

|

Phi-3.5 |

3.8B |

Oui** |

Contexte long (128K tokens), multilingue |

|

StableLM-zephyr |

3B |

Oui |

Inférence rapide, efficace pour les systèmes périphériques |

|

TinyLlama |

1.1B |

Oui |

Efficace pour les appareils mobiles et périphériques |

|

MobileLLaMA |

1.4B |

Oui |

Optimisé pour les appareils mobiles et à faible consommation d'énergie |

|

LaMini-GPT |

774 MILLIONS - 1,5 MILLIARD |

Oui |

Tâches multilingues et respectueuses des instructions |

|

Gemma2 |

9B, 27B |

Oui |

Déploiement local, applications en temps réel |

|

MiniCPM |

1B - 4B |

Oui |

Performances équilibrées, optimisation de l'anglais et du chinois |

|

OpenELM |

270M - 3B |

Oui |

Multitâche, faible latence, efficacité énergétique |

|

DCLM |

1B |

Oui |

Raisonnement de bon sens, déduction logique |

|

Fox |

1.6B |

Oui |

Vitesse optimisée pour les applications mobiles |

*Avec des restrictions d'utilisation

**À des fins de recherche uniquement

Pour en savoir plus sur ces modèles, consultez l'article que j'ai rédigé sur les les meilleurs petits modèles linguistiques.

Fonctionnement des SLM

Voyons comment fonctionnent les petits modèles linguistiques.

Mot suivant : prédiction

Tout comme les LLM, les SLM fonctionnent en prédisant le mot suivant dans une séquence de texte. Les SLM utilisent les modèles du texte sur lequel ils ont été formés pour deviner ce qui va suivre. Il s'agit d'un concept simple mais puissant qui se trouve au cœur de tous les modèles linguistiques.

Par exemple, compte tenu de l'entrée : "Dans la série Harry Potter, le meilleur ami du personnage principal s'appelle Ron...". Un SLM analyserait ce contexte et prédirait le mot suivant le plus probable - dans ce cas, "Weasley".

Architecture du transformateur

L'architecture architecture du transformateur est un élément clé de la façon dont les LLM et les SLM comprennent et génèrent le langage. Les transformateurs peuvent être considérés comme le cerveau des modèles linguistiques. Ils utilisent l'auto-attention pour déterminer quels mots d'une phrase sont les plus pertinents les uns par rapport aux autres. Cela aide le modèle à comprendre le contexte, par exemple en reconnaissant que "Paris" fait référence à la ville ou à la personne que vous connaissez au travail.

Équilibre entre la taille et les performances

La force des SLM réside dans leur capacité à équilibrer taille et performance. Ils utilisent beaucoup moins de paramètres que les LLM, allant généralement de quelques millions à quelques milliards, contre des centaines de milliards pour les LLM.

Avec moins de paramètres, les SLM nécessitent moins de puissance de calcul et de données pour s'entraîner, ce qui les rend plus accessibles si vous disposez de ressources limitées. La taille compacte des SLM leur permet de traiter les données et de produire des résultats plus rapidement, ce qui est très important pour les applications en temps réel telles que les claviers mobiles ou les assistants vocaux.

Les SLM ne sont peut-être pas aussi polyvalents ni aussi compréhensifs que les grands modèles, mais ils s'acquittent bien de tâches spécifiques. Par exemple, un orthophoniste formé à l'analyse de textes juridiques pourrait faire un meilleur travail qu'un orthophoniste généraliste dans ce domaine.

Comment sont créés les SLM : Techniques et approches

Les SLM utilisent des techniques telles que distillationl'élagage et la quantification pour devenir plus petits, plus rapides et plus efficaces.

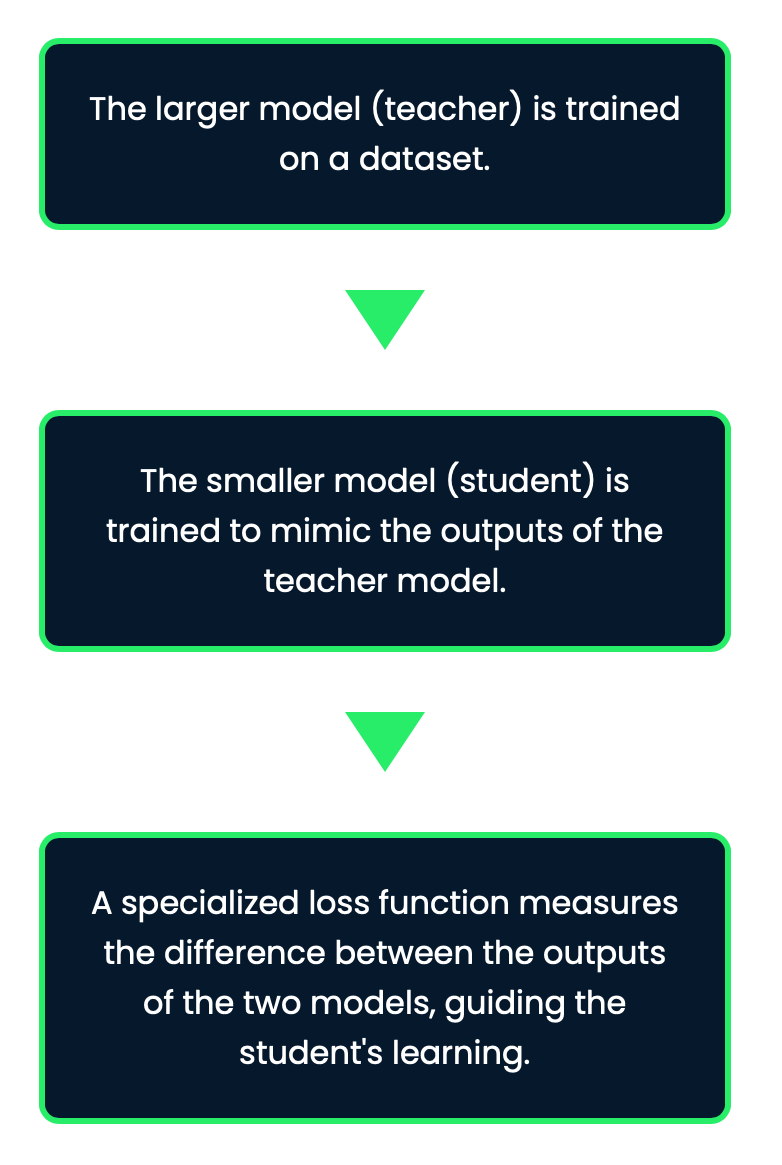

Distillation

Il s'agit d'une technique permettant de créer des SLM en transférant les connaissances d'un modèle "enseignant" plus grand à un modèle "étudiant" plus petit. L'objectif est ici de prendre ce que le modèle de l'enseignant a appris et de le comprimer dans le modèle de l'élève sans perdre trop de ses performances.

Ce processus permet aux SLM de conserver une grande partie de la précision des grands modèles tout en étant beaucoup plus faciles à gérer en termes de taille et de besoins de calcul. Grâce à cette technique, le petit modèle apprend non seulement les prédictions finales de l'enseignant, mais aussi les schémas et les nuances sous-jacents.

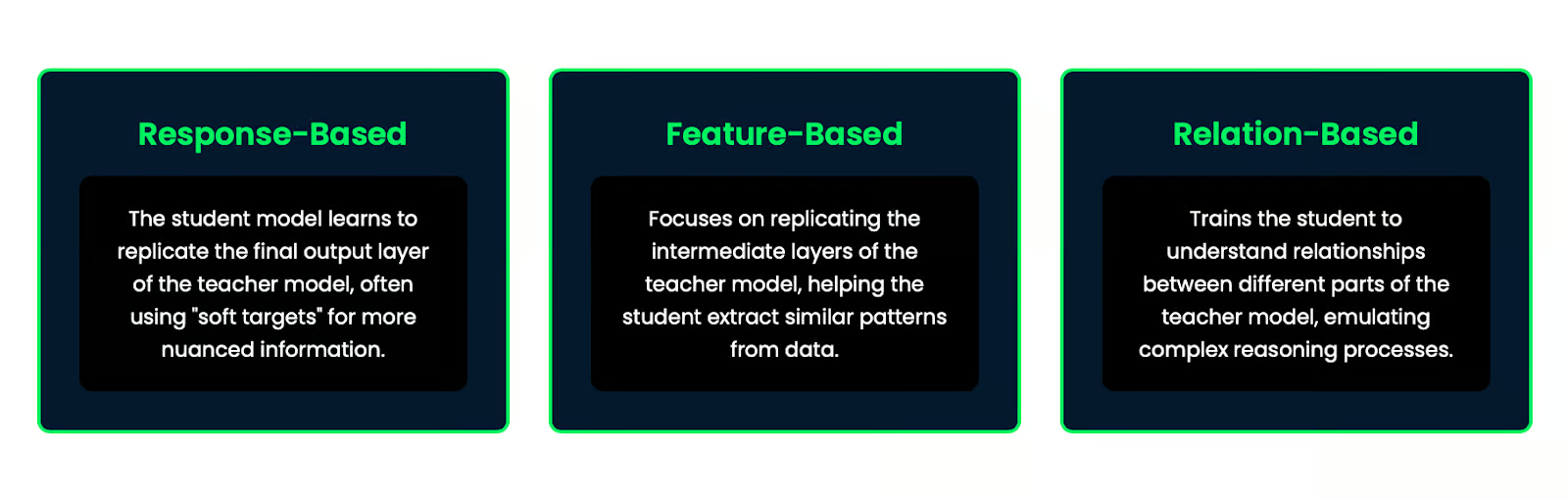

Il existe plusieurs méthodes de distillation des connaissances :

- Basé sur la réponse : Le modèle de l'élève apprend à reproduire la couche de sortie finale du modèle de l'enseignant, en utilisant souvent des "cibles douces" pour des informations plus nuancées.

- Basé sur les caractéristiques : Se concentre sur la reproduction des couches intermédiaires du modèle de l'enseignant, en aidant l'élève à extraire des modèles similaires à partir des données.

- Basé sur les relations : Entraîne l'élève à comprendre les relations entre les différentes parties du modèle de l'enseignant, en imitant des processus de raisonnement complexes.

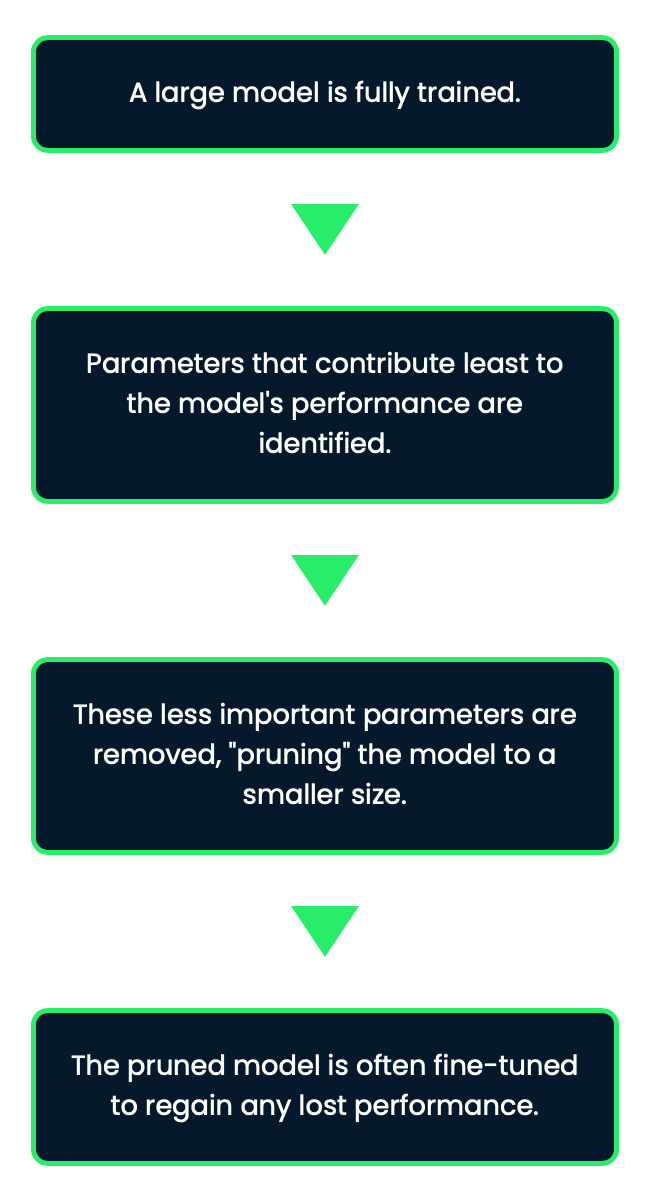

Élagage

L'élagage consiste en quelque sorte à tailler ce qui n'est pas nécessaire. Lors de l'élagage, les parties du modèle qui ne sont pas aussi importantes, comme les neurones ou les paramètres qui ne contribuent pas beaucoup à la performance globale, sont supprimées. Cette technique permet de réduire la taille du modèle sans affecter de manière significative sa précision. Cependant, l'élagage peut s'avérer délicat, car si vous êtes trop agressif, vous risquez de couper trop de choses et de nuire aux performances du modèle.

L'élagage permet de réduire considérablement la taille du modèle tout en conservant une grande partie des performances initiales, ce qui en fait une technique efficace pour créer des SLM.

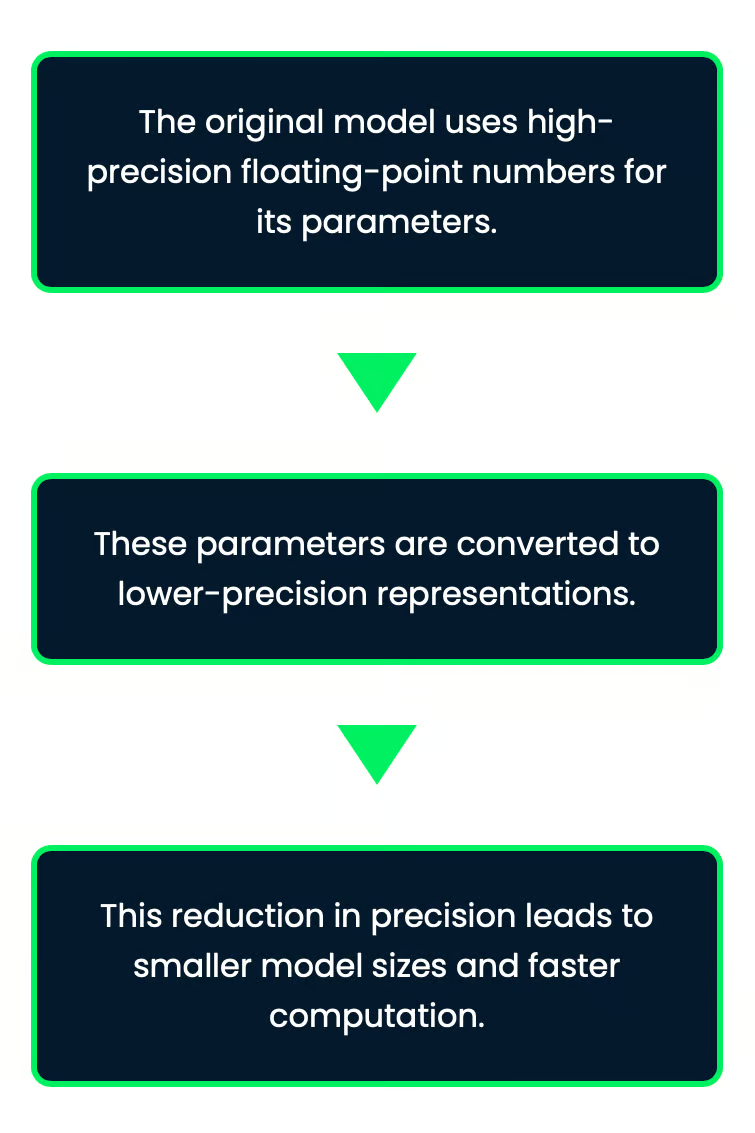

Quantification

La quantification consiste à utiliser moins de bits pour stocker les nombres du modèle. Normalement, un modèle peut utiliser des nombres de 32 bits, mais avec cette méthode, ces nombres sont réduits à des valeurs de 8 bits, qui sont beaucoup plus petites. Cela permet au modèle de prendre moins de place et de fonctionner plus rapidement. Le plus intéressant est que, même si les chiffres sont moins précis, le modèle fonctionne toujours bien et n'a qu'un faible impact sur sa précision.

Imaginez que vous stockez des valeurs de température dans une application météo. Vous les stockeriez avec une grande précision (comme des nombres de 32 bits), ce qui est plus que ce dont vous avez besoin. En réduisant la précision à 8 bits, vous risquez de perdre des détails, mais l'application restera utile tout en fonctionnant plus rapidement et en utilisant moins de mémoire.

Cela est particulièrement utile pour déployer l'IA sur des appareils dont la mémoire et la puissance de calcul sont limitées, comme les smartphones ou les appareils périphériques.

La quantification est particulièrement efficace pour déployer des modèles sur des appareils aux ressources limitées, car elle réduit les besoins en mémoire et améliore la vitesse d'inférence.

Applications des petits modèles linguistiques

La beauté des SLM réside dans leur capacité à fournir une IA puissante sans avoir besoin d'une infrastructure massive ou d'une connectivité internet permanente, ce qui ouvre la voie à de nombreuses applications.

IA sur l'appareil

Pensons aux assistants mobiles, ces assistants vocaux sur votre téléphone qui vous aident à gérer votre journée. Les SLM permettent d'atteindre cet objectif. Ils permettent la prédiction de texte en temps réel, les commandes vocales et même la traduction sans qu'il soit nécessaire d'envoyer des données dans le cloud. Tout se fait localement, ce qui signifie des réponses plus rapides et des interactions plus respectueuses de la vie privée.

Par exemple, SwiftKey et Gboard utilisent les SLM pour fournir des suggestions de texte contextuelles précises, ce qui améliore la vitesse et la précision de la frappe.

Cela s'étend également aux applications hors ligne, où l'IA peut fonctionner sans connexion internet, ce qui la rend utile dans les zones où la connectivité est limitée.

Google Translate, par exemple, offre des capacités de traduction hors ligne alimentées par des SLM, ce qui facilite la communication dans les zones où l'accès à l'internet est limité.

L'IA personnalisée

L'un des grands avantages des SLM est qu'ils peuvent être personnalisés en fonction de tâches spécifiques ou des préférences de l'utilisateur. Imaginez que votre entreprise dispose d'un chatbot spécialement conçu pour le service client ou d'une IA qui sait exactement comment vous aider en fonction de vos précédentes interactions. Ces modèles étant plus petits, il est beaucoup plus facile de les ajuster et de les déployer dans différents secteurs.

Prenons quelques exemples :

- Soins de santé : Les SLM peuvent être personnalisés pour l'analyse de textes médicaux afin de fournir une surveillance de la santé en temps réel et des conseils sur des appareils portables intelligents. Ils fonctionnent indépendamment d'une connectivité continue au cloud.

- Appareils domestiques intelligents : Les SLM intégrés dans les systèmes domestiques intelligents peuvent apprendre les préférences individuelles en matière de température et d'éclairage, et ajuster automatiquement les réglages en fonction des différents moments de la journée ou d'occasions spécifiques.

- Éducation : Les applications éducatives qui utilisent les SLM peuvent s'adapter aux styles et aux rythmes d'apprentissage individuels, ce qui permet d'offrir aux élèves des conseils et un soutien personnalisés.

Internet des objets

Les SLM fonctionnent discrètement en arrière-plan sur des appareils courants tels que votre système domestique intelligent ou d'autres gadgets. Ils permettent à ces appareils de vous comprendre et de vous répondre directement sans avoir besoin de se connecter à l'internet, ce qui les rend plus rapides et plus intelligents.

Autres applications

Les SLM trouvent des applications dans de nombreux autres domaines :

- Traduction linguistique en temps réel : Les SLM permettent une traduction instantanée, ce qui est important pour la communication mondiale. Certaines applications de voyage utilisent désormais des SLM pour traduire en temps réel des panneaux, des menus ou des indications vocales. Cela aide les utilisateurs à naviguer dans les langues étrangères.

- Systèmes automobiles : Dans les voitures, les SLM permettent une navigation intelligente, en fournissant des informations sur le trafic en temps réel et en suggérant les meilleurs itinéraires. Ils améliorent également les commandes vocales, permettant aux conducteurs de contrôler la musique, de passer des appels ou d'envoyer des messages sans utiliser leurs mains.

- Systèmes de divertissement : Les téléviseurs intelligents et les consoles de jeu utilisent les SLM pour la commande vocale et pour suggérer des émissions ou des jeux en fonction de ce que vous avez déjà regardé ou joué.

- Service à la clientèle : Les SLM aident les entreprises à gérer plus efficacement les questions des clients. Les magasins de détail utilisent la GDT pour répondre aux questions sur les produits, l'état des commandes ou les politiques de retour. Cela permet de réduire la nécessité d'une assistance humaine à la clientèle.

LLMs vs. SLMs

Voyons à présent quand il convient d'opter pour un LLM et quand les SLM constituent un meilleur choix.

Complexité des tâches

Pour les tâches très complexes telles que la compréhension en profondeur, la création de contenus de longue durée ou la résolution de problèmes délicats, les grands modèles tels que le GPT-4o sont généralement plus performants que les SLM. Ils peuvent s'acquitter de ces tâches parce qu'ils puisent dans une grande quantité de données pour fournir des réponses plus détaillées. Cependant, l'inconvénient est que ce niveau de sophistication nécessite beaucoup de puissance de calcul et de temps.

|

LLMs |

SLMs |

|

Excellente capacité à gérer des tâches complexes, sophistiquées et générales |

Mieux adapté aux tâches plus adéquates et plus simples |

|

Précision et performance accrues dans les différentes tâches |

Excellente maîtrise des applications spécialisées et des tâches spécifiques à un domaine |

|

Capable de maintenir le contexte sur de longs passages et de fournir une réponse cohérente |

Peut éprouver des difficultés à effectuer des tâches linguistiques complexes et à comprendre le contexte à long terme. |

Par exemple, si vous développez un chatbot polyvalent qui doit traiter différents sujets et répondre à des requêtes complexes, un LLM serait plus approprié. Toutefois, pour un bot de service à la clientèle spécialisé dans une ligne de produits spécifique, une SLM peut être plus que suffisante et même plus performante qu'une LLM en raison de sa formation ciblée.

Contraintes de ressources

Lorsque vous avez des contraintes de ressources, c'est là que les SLM gagnent. Leur formation et leur déploiement nécessitent beaucoup moins de puissance de calcul. Ils constituent une excellente option si vous travaillez dans un environnement où les ressources sont limitées.

|

LLMs |

SLMs |

|

Nécessite une puissance de calcul et une mémoire importantes |

Plus économique en termes de consommation de ressources |

|

L'inférence nécessite souvent du matériel spécialisé, comme les GPU. |

Peut fonctionner sur du matériel standard et même sur des appareils tels que Raspberry Pi ou smartphone |

|

Des coûts opérationnels plus élevés en raison de la demande de ressources |

Des temps de formation plus courts, ce qui les rend plus accessibles pour des déploiements rapides |

Dans les situations où la puissance de calcul est limitée, comme dans le cas des appareils mobiles ou de l'informatique en périphérie, les SLM sont souvent la meilleure option car ils offrent un bon mélange de performances et d'efficacité.

Environnement de déploiement

Si vous déployez l'IA sur un serveur cloud où les ressources ne sont pas un problème, un LLM pourrait être la solution, surtout si vous avez besoin d'une grande précision et d'une grande fluidité dans les réponses. Mais si vous travaillez sur des appareils dont la puissance du CPU ou du GPU est limitée, comme les appareils IoT ou les applications mobiles, les SLM sont parfaitement adaptés.

|

LLMs |

SLMs |

|

Idéal pour les environnements cloud où la puissance de calcul disponible est importante. |

Ils peuvent être utilisés dans le cloud, mais leur taille réduite les rend plus adaptés aux lieux disposant de ressources limitées. Ils sont plus efficaces pour les petites tâches |

|

Elle n'est pas idéale pour l'IA sur appareil car elle nécessite une grande puissance de calcul et dépend d'une connexion internet. |

Parfait pour l'IA sur appareil, permettant une utilisation hors ligne et des temps de réponse plus rapides. Ils peuvent utiliser des assistants mobiles, la reconnaissance vocale et d'autres applications en temps réel sans avoir besoin d'une connexion internet. |

|

Ils ne sont pas adaptés à l'informatique de pointe car ils nécessitent une grande puissance de calcul et peuvent être lents à réagir. |

Idéal pour l'informatique en périphérie, où les réponses rapides et l'utilisation efficace des ressources sont importantes. Ils permettent l'IA dans les appareils IoT, les maisons intelligentes et d'autres applications de périphérie |

Lors de l'examen de l'environnement de déploiement, il est essentiel d'évaluer des facteurs tels que la connectivité internet, les exigences en matière de latence et les préoccupations relatives à la protection de la vie privée. Pour les applications qui doivent fonctionner hors ligne ou avec une latence minimale, les SLM déployés sur l'appareil ou à la périphérie sont souvent le meilleur choix.

Le choix entre les LLM et les SLM dépend de la complexité de la tâche, des ressources dont vous disposez et de l'endroit où vous souhaitez les déployer. Les LLM sont parfaits pour les tâches complexes nécessitant une grande précision, tandis que les SLM sont efficaces et peuvent travailler dans plus d'endroits.

Conclusion

Les SLM rendent l'IA beaucoup plus accessible. Contrairement aux grands modèles linguistiques qui nécessitent des tonnes de puissance de calcul, les SLM fonctionnent avec moins de ressources. Cela signifie que les petites entreprises, les développeurs individuels et même les startups peuvent les utiliser sans avoir besoin de serveurs massifs ou de budgets importants.

Pour en savoir plus sur les petits modèles linguistiques, je vous recommande ces deux ressources :

FAQ

Quelles sont les différences spécifiques de consommation d'énergie entre l'utilisation d'un SLM et d'un LLM pour une application d'entreprise typique ?

La différence de consommation d'énergie entre les SLM et les LLM peut être substantielle. Pour une application d'entreprise typique, un SLM pourrait ne consommer que 10 à 20 % de l'énergie requise par un LLM. Par exemple, l'exécution d'un SLM pour un chatbot de service à la clientèle pourrait consommer environ 50-100 kWh par mois, tandis qu'un LLM pour la même tâche pourrait consommer 500-1000 kWh. Toutefois, les chiffres exacts varient en fonction de la taille du modèle, des habitudes d'utilisation et de l'efficacité du matériel. Des entreprises comme Google et OpenAI ont indiqué que l'exécution de leurs plus grands modèles peut consommer une énergie équivalente à celle de plusieurs centaines de foyers, alors que les SLM peuvent souvent être exécutés sur des serveurs standard ou même sur des dispositifs de périphérie avec des besoins en énergie nettement inférieurs.

Comment les délais de développement se comparent-ils lorsqu'il s'agit de créer des SLM personnalisés ou d'adapter des LLM existants à des tâches spécialisées ?

Les délais de développement des SLM personnalisés par rapport aux LLM de réglage fin peuvent être très différents. La création d'un SLM personnalisé à partir de zéro prend généralement plus de temps, souvent de 3 à 6 mois pour une équipe de data scientists expérimentés, car elle implique la collecte de données, la conception de l'architecture du modèle, la formation et des tests approfondis. L'adaptation d'un LLM existant à une tâche spécialisée peut être beaucoup plus rapide et ne prendre que quelques semaines. Toutefois, en contrepartie, les LLM finement réglés peuvent ne pas atteindre le même niveau d'efficacité ou de spécialisation qu'un SLM sur mesure. Le choix dépend souvent du cas d'utilisation spécifique, des ressources disponibles et des caractéristiques de performance souhaitées.

Quelles sont les considérations juridiques et éthiques à prendre en compte lors du déploiement des SLM par rapport aux LLM, en particulier en ce qui concerne la confidentialité des données et la propriété intellectuelle ?

La confidentialité des données est une préoccupation majeure, les LLM disposant souvent d'un grand nombre de données de formation, ce qui augmente potentiellement le risque d'exposition des informations personnelles. Les SLM, plus ciblés, pourraient utiliser des ensembles de données plus petits et mieux contrôlés, ce qui pourrait réduire les risques en matière de protection de la vie privée. Les questions de propriété intellectuelle sont également cruciales, car les stagiaires formés à l'utilisation de diverses données Internet peuvent reproduire des contenus protégés par le droit d'auteur. Les SLM, formés sur des données plus spécifiques, pourraient être moins exposés à ce type de risques, mais pourraient néanmoins rencontrer des problèmes en fonction de leurs données de formation. En outre, les SLM facilitent souvent l'interprétation et l'explication des décisions du modèle, ce qui peut s'avérer très important pour les applications dans les industries réglementées.

Comment les SLM et les LLM se comparent-ils en termes de capacités multilingues, en particulier pour les langues les moins courantes ?

Les SLM et les LLM traitent différemment les langues multiples, en particulier les moins courantes. Les LLM, avec leurs énormes données d'apprentissage, ont tendance à bien fonctionner dans de nombreuses langues, y compris les langues rares, mais cela présente l'inconvénient d'être volumineux et complexe. Les SLM, bien que plus petits, peuvent être personnalisés pour des langues ou des groupes linguistiques spécifiques, parfois même en battant les LLM dans ces domaines. Pour les langues moins courantes, les SLM spécialement formés peuvent fournir des traductions ou des textes plus précis et plus respectueux de la culture, car ils se concentrent sur des données de haute qualité et spécifiques à la langue, contrairement aux données plus larges, mais peut-être moins précises, utilisées par les LLM.

Quelles sont les meilleures pratiques en matière de contrôle des versions et de gouvernance des modèles lorsque l'on travaille avec des SLM ou des LLM dans un environnement de production ?

Les meilleures pratiques de gestion des versions et de supervision des SLM et LLM dans les environnements de production présentent des similitudes mais aussi des différences essentielles. Dans les deux cas, il est important de conserver un bon système de gestion des versions pour les modèles, les données de formation et les paramètres. Cependant, les LLM, en raison de leur taille et de leur sensibilité au réglage fin, nécessitent une infrastructure plus complexe pour le contrôle des versions. Les SLM étant plus petits, il est plus facile de gérer et de déployer différentes versions. En matière de gouvernance, les LLM ont généralement besoin d'une surveillance plus stricte en raison de leur large éventail de compétences et de leur potentiel de comportement inattendu. Les GDT, avec leurs utilisations plus spécifiques, peuvent nécessiter moins de surveillance mais une gouvernance plus ciblée. Dans les deux cas, des contrôles réguliers, un cursus des performances et une documentation claire sur les limitations et les utilisations prévues sont très importants pour une utilisation responsable de l'IA.