Lernpfad

Data Engineering ist mittlerweile eine der wichtigsten Aufgaben in der Tech-Branche und bildet das Rückgrat der Dateninfrastruktur für Unternehmen auf der ganzen Welt. Da Firmen immer mehr auf datengestützte Entscheidungen setzen, wird der Bedarf an guten Dateningenieuren immer größer.

Wenn du dich auf ein Vorstellungsgespräch im Bereich Data Engineering vorbereitest, solltest du dich gut mit allgemeinen und technischen Fragen auskennen, die deine Erfahrung, deine Fähigkeiten zur Problemlösung und deine technischen Kenntnisse bewerten.

In diesem Blogbeitrag geben wir dir einen umfassenden Leitfaden, der dir hilft, dich auf die verschiedenen Phasen eines Vorstellungsgesprächs im Bereich Data Engineering vorzubereiten, von der ersten Personalauswahl bis hin zu ausführlichen technischen Bewertungen.

Werde Dateningenieur

Erste Fragen für das Vorstellungsgespräch als HR-Dateningenieur

In der ersten Runde des Vorstellungsgesprächs wird dich der Personalchef zu deiner Berufserfahrung und deinem Mehrwert für das Unternehmen befragen. In dieser Phase checken wir deinen Hintergrund, deine sozialen Kompetenzen und ob du insgesamt zur Unternehmenskultur passt.

1. Was macht dich zum besten Kandidaten für diese Stelle?

Wenn der Personalchef dich für ein Telefoninterview auswählt, hat ihm wohl was in deinem Profil gefallen. Geh diese Frage selbstbewusst an und erzähl von deinen Erfahrungen und deiner beruflichen Entwicklung.

Es ist wichtig, sich vor dem Vorstellungsgespräch das Unternehmensprofil und die Stellenbeschreibung anzuschauen. So kannst du besser verstehen, was der Personalverantwortliche sucht, und deine Antwort entsprechend anpassen.

Konzentrier dich auf bestimmte Fähigkeiten und Erfahrungen, die zu den Jobanforderungen passen, wie zum Beispiel das Entwerfen und Verwalten von Datenpipelines, Modellierung und ETL-Prozesse. Zeig, wie deine einzigartige Mischung aus Fähigkeiten, Erfahrung und Wissen dich von anderen abhebt.

2. Was macht ein Dateningenieur so im Alltag?

Es gibt zwar keine allgemeingültige Antwort, aber wenn du von deinen Erfahrungen aus früheren Jobs erzählst und auf die Stellenbeschreibung eingehst, kannst du eine umfassende Antwort geben. Im Allgemeinen gehören zu den täglichen Aufgaben von Dateningenieuren:

- Entwickeln, Testen und Pflegen von Datenbanken.

- Entwickle Datenlösungen, die auf den Bedürfnissen des Unternehmens basieren.

- Datenerfassung und -integration.

- Entwickeln, Testen und Pflegen von Datenpipelines für ETL-Prozesse, Modellierung, Transformation und Bereitstellung.

- In manchen Fällen Machine-Learning- Modelle einsetzen und verwalten.

- Die Datenqualität durch Bereinigung, Validierung und Überwachung der Datenströme aufrechterhalten.

- Die Zuverlässigkeit, Leistung und Qualität des Systems verbessern.

- Die Datenverwaltungs- und Sicherheitsrichtlinien befolgen, um die Einhaltung der Vorschriften und die Datenintegrität sicherzustellen.

3. Was findest du am schwierigsten daran, Dateningenieur zu sein?

Diese Frage hängt von den persönlichen Erfahrungen ab, aber typische Herausforderungen sind:

- Mit dem schnellen Tempo der technologischen Fortschritte mithalten und neue Tools einbauen, um die Leistung, Sicherheit, Zuverlässigkeit und Rentabilität von Datensystemen zu verbessern.

- Komplexe Datenverwaltungs- und Sicherheitsprotokolle verstehen und umsetzen.

- Verwalten von Notfallwiederherstellungsplänen und Sicherstellen, dass Daten auch bei unerwarteten Ereignissen verfügbar und intakt bleiben.

- Die Balance zwischen geschäftlichen Anforderungen und technischen Einschränkungen finden und den zukünftigen Datenbedarf einschätzen.

- Effiziente Verarbeitung großer Datenmengen und Sicherstellung der Datenqualität und -konsistenz.

4. Mit welchen Datentools oder Frameworks hast du schon gearbeitet? Gibt's welche, die du lieber magst als andere?

Deine Antwort hängt von deinen Erfahrungen ab. Wenn du dich mit modernen Tools und Integrationen von Drittanbietern auskennst, kannst du diese Frage locker beantworten. Sag mal, welche Tools gibt's denn dazu?

- Datenbankverwaltung (z. B. MySQL, PostgreSQL, MongoDB)

- Datenlagerung (z. B. Amazon Redshift, Google BigQuery, Snowflake)

- Datenorchestrierung (z. B. Apache Airflow, Prefect)

- Datenpipelines (z. B. Apache Kafka, Apache NiFi)

- Cloud-Management (z. B. AWS, Google Cloud Platform, Microsoft Azure)

- Datenbereinigung, Modellierung und Transformation (z. B. Pandas, DBT, Spark)

- Batch- und Echtzeitverarbeitung (z. B. Apache Spark, Apache Flink)

Denk dran, es gibt keine falsche Antwort auf diese Frage. Der Interviewer checkt deine Fähigkeiten und Erfahrungen.

5. Wie bleibst du über die neuesten Trends und Entwicklungen im Bereich Data Engineering auf dem Laufenden?

Diese Frage zeigt, wie sehr du dich für kontinuierliches Lernen und das Auf-dem-Laufenden-Bleiben in deinem Bereich engagierst.

Du kannst erwähnen, dass du Newsletter aus der Branche abonnierst, einflussreiche Blogs verfolgst, an Online-Foren und Communities teilnimmst, Webinare und Konferenzen besuchst und Online-Kurse belegst. Sag mal, welche Quellen oder Plattformen du nutzt, um auf dem Laufenden zu bleiben.

6. Kannst du mal erzählen, wann du mit einem Team aus verschiedenen Abteilungen zusammenarbeiten musstest, um ein Projekt fertig zu machen?

Beim Data Engineering arbeitet man oft mit verschiedenen Teams zusammen, darunter Datenwissenschaftler, Analysten und IT-Mitarbeiter.

Erzähl mal ein konkretes Beispiel, wo du super mit anderen zusammengearbeitet hast, und zeig dabei deine Kommunikationsfähigkeiten, deine Fähigkeit, verschiedene Perspektiven zu verstehen, und wie du zum Erfolg des Projekts beigetragen hast. Erzähl mal, mit welchen Herausforderungen du konfrontiert warst und wie du sie gemeistert hast, um das gewünschte Ergebnis zu erzielen.

Werde Dateningenieur

Fragen für Vorstellungsgespräche mit technischen Dateningenieuren

Datenverarbeitung ist echt technisch, also ist es klar, dass die meisten Fragen und Aufgaben in deinem Vorstellungsgespräch technisch sein werden. In diesem Abschnitt schauen wir uns verschiedene technische Fragen und Antworten an, vor allem für Anfänger, Python, SQL, projektbezogene und Management-Fragen.

Fragen für das Vorstellungsgespräch für Junior-Dateningenieure

Die Vorstellungsgespräche für Nachwuchsingenieure drehen sich um Tools, Python und SQL-Abfragen. Es kann auch um Fragen zur Datenbankverwaltung und zu ETL-Prozessen gehen, einschließlich Programmieraufgaben und Tests, die man zu Hause machen kann.

Wenn Firmen Absolventen einstellen, wollen sie sicher sein, dass du mit ihren Daten und Systemen gut umgehen kannst.

7. Kannst du die für die Datenmodellierung relevanten Entwurfsschemata erklären?

Es gibt drei Hauptschemata für die Datenmodellierung: Stern, Snowflake und Galaxie.

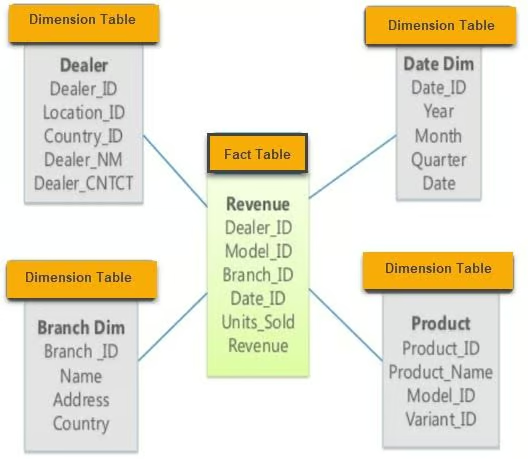

- Sternschema: Dieses Schema hat verschiedene Dimensionstabellen, die mit einer zentralen Faktentabelle verbunden sind. Es ist einfach und leicht zu verstehen, sodass es sich gut für einfache Abfragen eignet.

Beispiel für ein Sternschema. Bild von guru99

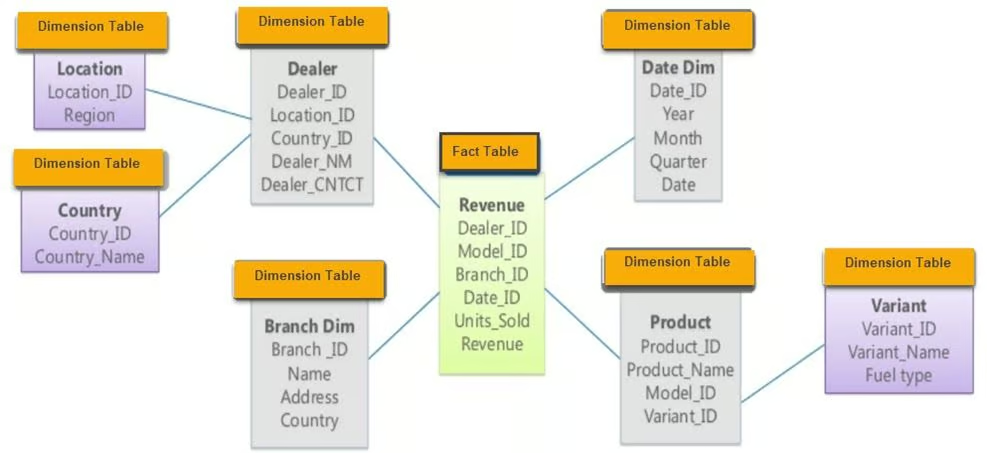

- Snowflake-Schema: Das Snowflake-Schema ist eine Erweiterung des Sternschemas und besteht aus einer Faktentabelle und mehreren Dimensionstabellen mit zusätzlichen Normalisierungsschichten, die zusammen eine schneeflockenähnliche Struktur bilden. Es reduziert Redundanzen und verbessert die Datenintegrität.

Beispiel für ein Snowflake-Schema. Bild von guru99

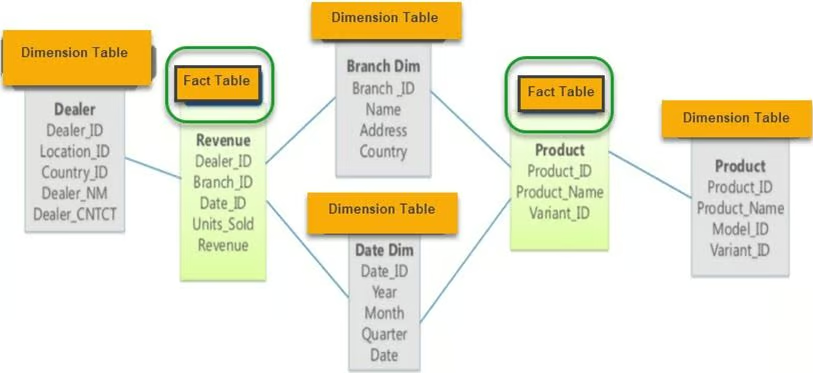

- Galaxie-Schema: Auch als Faktenkonstellationsschema bekannt, hat es zwei oder mehr Faktentabellen, die sich Dimensionstabellen teilen. Dieses Schema passt gut für komplizierte Datenbanksysteme, die mehrere Faktentabellen brauchen.

Beispiel für ein Galaxy-Schema. Bild von guru99

8. Mit welchen ETL-Tools hast du schon gearbeitet? Was magst du am liebsten und warum?

Erwähne bei der Beantwortung dieser Frage die ETL-Tools, die du beherrschst, und erkläre, warum du bestimmte Tools für bestimmte Projekte ausgewählt hast. Sag mal, was die einzelnen Tools für Vor- und Nachteile haben und wie sie in deinen Arbeitsablauf passen. Beliebte Open-Source-Tools sind zum Beispiel:

- dbt (Datenerstellungstool): Super, um Daten in deinem Warehouse mit SQL umzuwandeln.

- Apache Spark: Super für die Verarbeitung von großen Datenmengen und die Stapelverarbeitung.

- Apache Kafka: Wird für Echtzeit-Datenpipelines und Streaming genutzt.

- Airbyte: Ein Open-Source-Tool zur Datenintegration, das beim Extrahieren und Laden von Daten hilft.

Wenn du deine ETL-Kenntnisse auffrischen willst, solltest du den Kurs „Einführung in das Data Engineering“ machen.

9. Was ist Datenorchestrierung und welche Tools kann man dafür nutzen?

Datenorchestrierung ist ein automatisierter Prozess, bei dem man auf Rohdaten aus verschiedenen Quellen zugreift, sie bereinigt, umwandelt und modelliert und dann für Analysen bereitstellt. Es sorgt dafür, dass die Daten zwischen verschiedenen Systemen und Verarbeitungsschritten reibungslos fließen.

Beliebte Tools für die Datenorchestrierung sind:

- Apache Airflow: Wird oft für die Planung und Überwachung von Arbeitsabläufen genutzt.

- Präfekt: Ein modernes Orchestrierungstool, das sich auf den Datenfluss konzentriert.

- Dagster: Ein Orchestrierungstool für datenintensive Aufgaben.

- AWS Glue: Ein verwalteter ETL-Dienst, der die Datenvorbereitung für Analysen einfacher macht.

10. Welche Tools benutzt du für Analytics Engineering?

Analytics Engineering bedeutet, verarbeitete Daten umzuwandeln, statistische Modelle anzuwenden und sie durch Berichte und Dashboards zu visualisieren.

Beliebte Tools für Analytics Engineering sind:

- dbt (Datenerstellungstool): Damit kannst du Daten in deinem Warehouse mit SQL umwandeln.

- BigQuery: Ein komplett verwaltetes, serverloses Data Warehouse für große Datenanalysen.

- Postgres: Ein leistungsstarkes Open-Source-Relationales-Datenbanksystem.

- Metabase: Ein Open-Source-Tool, mit dem du Fragen zu deinen Daten stellen und die Antworten in verständlichen Formaten anzeigen kannst.

- Google Data Studio: Damit kannst du Dashboards und visuelle Berichte erstellen.

- Tableau: Eine führende Plattform für Datenvisualisierung.

Diese Tools helfen dabei, auf Daten zuzugreifen, sie umzuwandeln und zu visualisieren, um wichtige Erkenntnisse zu gewinnen und Entscheidungsprozesse zu unterstützen.

11. Was ist der Unterschied zwischen OLAP- und OLTP-Systemen?

OLAP (Online Analytical Processing) checkt alte Daten und hilft bei komplizierten Abfragen. Es ist für leseintensive Aufgaben optimiert und wird oft in Data Warehouses für Business-Intelligence-Aufgaben genutzt. OLTP ( Online Transaction Processing) ist für die Verwaltung von Echtzeit-Transaktionsdaten gedacht. Es ist für schreibintensive Aufgaben optimiert und wird in operativen Datenbanken für den täglichen Geschäftsbetrieb genutzt.

Der Hauptunterschied liegt in ihrem Zweck: OLAP hilft bei der Entscheidungsfindung, während OLTP den täglichen Betrieb unterstützt.

Wenn du immer noch Zweifel hast, schau dir mal den Blogbeitrag „OLTP vs. OLAP” an.

Fragen für Vorstellungsgespräche für Python-Dateningenieure

Python ist die beliebteste Sprache im Bereich Data Engineering, weil sie so vielseitig ist und es so viele Bibliotheken für Datenverarbeitung, Analyse und Automatisierung gibt. Hier sind ein paar Fragen zu Python, die dir in einem Vorstellungsgespräch im Bereich Data Engineering gestellt werden könnten.

12. Welche Python-Bibliotheken sind am besten für die Datenverarbeitung geeignet?

Zu den beliebtesten Bibliotheken für die Datenverarbeitung in Python gehören:

- pandas: Perfekt für die Datenbearbeitung und -analyse, mit Datenstrukturen wie DataFrames.

- NumPy: Unverzichtbar für numerische Berechnungen, unterstützt große mehrdimensionale Arrays und Matrizen.

- Dask: Macht Parallel Computing einfacher und kann Berechnungen, die den Speicher übersteigen, mit einer vertrauten pandas-ähnlichen Syntax hinkriegen.

- PySpark: Eine Python-API für Apache Spark, die bei der Verarbeitung großer Datenmengen und Echtzeitanalysen echt nützlich ist.

Jede dieser Bibliotheken hat ihre Vor- und Nachteile, und die Wahl hängt von den spezifischen Datenanforderungen und dem Umfang der Datenverarbeitungsaufgaben ab.

13. Wie macht man Web Scraping in Python?

Web Scraping in Python läuft meistens so ab:

1. Ruf die Webseite mit der Bibliothek „ requests “ auf:

import requests

from bs4 import BeautifulSoup

url = 'http://example.com'

response = requests.get(url)

soup = BeautifulSoup(response.text, 'html.parser')2. Extrahier Tabellen und Infos mit BeautifulSoup:

tables = soup.find_all('table')3. Mach daraus mit pandas ein strukturiertes Format:

import pandas as pd

data = []

for table in tables:

rows = table.find_all('tr')

for row in rows:

cols = row.find_all('td')

cols = [ele.text.strip() for ele in cols]

data.append(cols)

df = pd.DataFrame(data)4. Reinige die Daten mit pandas und NumPy:

df.dropna(inplace=True) # Drop missing values5. Speichere die Daten als CSV-Datei:

df.to_csv('scraped_data.csv', index=False)Manchmal kann „ pandas.read_html “ den Prozess vereinfachen:

df_list = pd.read_html('http://example.com')

df = df_list[0] # Assuming the table of interest is the first one14. Wie gehst du in Python mit großen Datensätzen um, die nicht in den Arbeitsspeicher passen?

Um mit großen Datensätzen umzugehen, die nicht in den Arbeitsspeicher passen, braucht man Tools und Techniken, die für die Out-of-Core-Berechnung entwickelt wurden:

- Dask: Ermöglicht paralleles Rechnen und funktioniert mit Datensätzen, die größer als der Arbeitsspeicher sind, mit einer pandas-ähnlichen Syntax.

import dask.dataframe as dd

df = dd.read_csv('large_dataset.csv')- PySpark: Ermöglicht die verteilte Datenverarbeitung, was bei der Bearbeitung großer Datenmengen nützlich ist.

from pyspark.sql import SparkSession

spark = SparkSession.builder.appName('data_processing').getOrCreate()

df = spark.read.csv('large_dataset.csv', header=True, inferSchema=True)- Chunking mit Pandas: Lies große Datensätze in Blöcken.

import pandas as pd

chunk_size = 10000

for chunk in pd.read_csv('large_dataset.csv', chunksize=chunk_size):

process(chunk) # Replace with your processing function15. Wie stellst du sicher, dass dein Python-Code effizient und auf Leistung optimiert ist?

Um sicherzustellen, dass Python-Code effizient und leistungsoptimiert ist, solltest du die folgenden Vorgehensweisen beachten:

- Profiling: Nutze Profiling-Tools wie

cProfile,line_profilerodermemory_profiler, um Engpässe in deinem Code zu finden.

import cProfile

cProfile.run('your_function()')- Vektorisierung: Benutz „

numpy“ oder „pandas“ für vektorisierte Operationen anstelle von Schleifen.

import numpy as np

data = np.array([1, 2, 3, 4, 5])

result = data * 2 # Vectorized operation- Effiziente Datenstrukturen: Such dir die passenden Datenstrukturen (z. B. Listen, Mengen, Wörterbücher) für deinen Anwendungsfall aus.

data_dict = {'key1': 'value1', 'key2': 'value2'} # Faster lookups compared to lists- Parallelverarbeitung: Nutze Multithreading oder Multiprocessing für Aufgaben, die parallelisiert werden können.

from multiprocessing import Pool

def process_data(data_chunk):

# Your processing logic here

return processed_chunk

with Pool(processes=4) as pool:

results = pool.map(process_data, data_chunks)- Vermeidung redundanter Berechnungen: Speichere die Ergebnisse von aufwendigen Vorgängen im Cache, wenn sie wiederverwendet werden müssen.

from functools import lru_cache

@lru_cache(maxsize=None)

def expensive_computation(x):

# Perform expensive computation

return result16. Wie stellst du die Datenintegrität und -qualität in deinen Datenpipelines sicher?

Datenintegrität und -qualität sind wichtig für zuverlässiges Data Engineering. Zu den bewährten Methoden gehören:

- Datenvalidierung: Mach in verschiedenen Phasen der Datenpipeline Checks, um Datenformate, Bereiche und Konsistenz zu überprüfen.

def validate_data(df):

assert df['age'].min() >= 0, "Age cannot be negative"

assert df['salary'].dtype == 'float64', "Salary should be a float"

# Additional checks...- Datenbereinigung: Nutze Bibliotheken wie

pandas, um Daten zu bereinigen und vorzubereiten, indem du fehlende Werte bearbeitest, Duplikate entfernst und Fehler korrigierst.

df.dropna(inplace=True) # Drop missing values

df.drop_duplicates(inplace=True) # Remove duplicates- Automatisierte Tests: Entwickle Unit-Tests für Datenverarbeitungsfunktionen mit Frameworks wie

pytest.

import pytest

def test_clean_data():

raw_data = pd.DataFrame({'age': [25, -3], 'salary': ['50k', '60k']})

clean_data = clean_data_function(raw_data)

assert clean_data['age'].min() >= 0

assert clean_data['salary'].dtype == 'float64'- Überwachung und Warnmeldungen: Richte eine Überwachung für deine Datenpipelines ein, um Anomalien zu erkennen und Warnmeldungen zu senden, wenn Probleme mit der Datenqualität auftreten.

from airflow import DAG

from airflow.operators.dummy_operator import DummyOperator

from airflow.operators.email_operator import EmailOperator

# Define your DAG and tasks...17. Wie gehst du mit fehlenden Daten in deinen Datensätzen um?

Der Umgang mit fehlenden Daten ist eine häufige Aufgabe im Bereich Data Engineering. Zu den Ansätzen gehören:

- Entfernung: Entferne einfach Zeilen oder Spalten mit fehlenden Daten, wenn sie nicht wichtig sind.

df.dropna(inplace=True)- Imputation: Ergänze fehlende Werte mit statistischen Maßen (Mittelwert, Median) oder probier mal komplexere Methoden wie die KNN-Imputation aus.

df['column'].fillna(df['column'].mean(), inplace=True)- Indikatorvariable: Füge eine Indikatorvariable hinzu, um anzugeben, welche Werte fehlen.

df['column_missing'] = df['column'].isnull().astype(int)- Modellbasierte Imputation: Nutze Vorhersagemodelle, um fehlende Werte zu schätzen.

from sklearn.impute import KNNImputer

imputer = KNNImputer(n_neighbors=5)

df = pd.DataFrame(imputer.fit_transform(df), columns=df.columns)18. Wie gehst du mit API-Ratenbeschränkungen um, wenn du Daten in Python abrufst?

Um API-Ratenbeschränkungen zu umgehen, gibt's Strategien wie:

- Zurückziehen und nochmal versuchen: Exponentielles Backoff machen, wenn die Ratenbegrenzungen erreicht sind.

- Seitenumbruch: Daten in kleineren Blöcken abrufen, indem du die Paginierungsoptionen der API nutzt.

- Caching: Antworten speichern, um unnötige API-Aufrufe zu vermeiden.

Beispiel mit der Python-Bibliothek „ time ” und dem Modul „ requests ”:

import time

import requests

def fetch_data_with_rate_limit(url):

for attempt in range(5): # Retry up to 5 times

response = requests.get(url)

if response.status_code == 429: # Too many requests

time.sleep(2 ** attempt) # Exponential backoff

else:

return response.json()

raise Exception("Rate limit exceeded")Python ist echt eine der wichtigsten Sprachen im Bereich Data Engineering. Du kannst deine Fähigkeiten verbessern, indem du unseren Lernpfad „Data Engineer in Python“ machst. Der Lernpfad deckt ein umfassendes Lehrprogramm ab, das dir moderne Datenverarbeitungskonzepte, Programmiersprachen, Tools und Frameworks beibringt.

Fragen für das Vorstellungsgespräch als SQL-Dateningenieur

Die SQL-Codierungsphase ist ein wichtiger Teil des Einstellungsprozesses für Dateningenieure. Das Üben von verschiedenen einfachen und komplizierten Skripten kann dir bei der Vorbereitung helfen. Die Interviewer könnten dich bitten, Abfragen für Datenanalysen, gemeinsame Ausdrücke in Tabellen, Ranglisten, Zwischensummen und temporäre Funktionen zu schreiben.

19. Was sind Common Table Expressions (CTEs) in SQL?

CTEs werden benutzt, um komplizierte Verknüpfungen zu vereinfachen und Unterabfragen auszuführen. Sie machen SQL-Abfragen übersichtlicher und einfacher zu pflegen. Hier ist ein Beispiel für eine CTE, die alle Studenten mit dem Hauptfach Naturwissenschaften und der Note A anzeigt:

SELECT *

FROM class

WHERE id IN (

SELECT DISTINCT id

FROM students

WHERE grade = "A"

AND major = "Science"

);Mit CTE sieht die Abfrage so aus:

WITH temp AS (

SELECT id

FROM students

WHERE grade = "A"

AND major = "Science"

)

SELECT *

FROM class

WHERE id IN (SELECT id FROM temp);CTEs kann man für kompliziertere Probleme nutzen und mehrere CTEs kann man miteinander verbinden.

20. Wie sortierst du die Daten in SQL?

Dateningenieure ordnen Werte oft nach Parametern wie Umsatz und Gewinn. Die Funktion „ RANK() “ sortiert Daten nach einer bestimmten Spalte:

SELECT

id,

sales,

RANK() OVER (ORDER BY sales DESC) AS rank

FROM bill;Du kannst auch „ DENSE_RANK() “ verwenden, das nachfolgende Ränge nicht überspringt, wenn die Werte gleich sind.

21. Kannst du eine einfache temporäre Funktion erstellen und sie in einer SQL-Abfrage verwenden?

Genau wie in Python kannst du in SQL Funktionen erstellen, um deine Abfragen eleganter zu gestalten und wiederholte case-Anweisungen zu vermeiden. Hier ist ein Beispiel für eine temporäre Funktion „ get_gender “:

CREATE TEMPORARY FUNCTION get_gender(type VARCHAR) RETURNS VARCHAR AS (

CASE

WHEN type = "M" THEN "male"

WHEN type = "F" THEN "female"

ELSE "n/a"

END

);

SELECT

name,

get_gender(type) AS gender

FROM class;Dieser Ansatz macht deinen SQL-Code übersichtlicher und einfacher zu pflegen.

22. Wie fügt man Zwischensummen in SQL hinzu?

Zwischensummen kannst du mit den Funktionen „ GROUP BY “ und „ ROLLUP() “ hinzufügen. Hier ein Beispiel:

SELECT

department,

product,

SUM(sales) AS total_sales

FROM sales_data

GROUP BY ROLLUP(department, product);Diese Abfrage gibt dir eine Zwischensumme für jede Abteilung und am Ende eine Gesamtsumme.

23. Wie gehst du mit fehlenden Daten in SQL um?

Der Umgang mit fehlenden Daten ist super wichtig, um die Datenintegrität zu sichern. Zu den gängigen Ansätzen gehören:

COALESCE(): Diese Funktion gibt den ersten Wert in der Liste zurück, der nicht null ist.

SELECT id, COALESCE(salary, 0) AS salary FROM employees;CASE-Anweisungen verwenden: Um fehlende Werte bedingt zu behandeln.

SELECT id,

CASE

WHEN salary IS NULL THEN 0

ELSE salary

END AS salary

FROM employees;24. Wie machst du Datenaggregation in SQL?

Bei der Datenaggregation werden Aggregatfunktionen wie „ SUM() “, „ AVG() “, „ COUNT() “, „ MIN() “ und „ MAX() “ benutzt. Hier ein Beispiel:

SELECT department,

SUM(salary) AS total_salary,

AVG(salary) AS average_salary,

COUNT(*) AS employee_count

FROM employees

GROUP BY department;25. Wie optimiert man SQL-Abfragen für eine bessere Leistung?

Um SQL-Abfragen zu optimieren, kannst du Folgendes tun:

- Benutze Indizes für oft abgefragte Spalten, um Suchvorgänge schneller zu machen.

- Vermeide „

SELECT *“, indem du nur die benötigten Spalten angibst. - Verwendet Joins mit Bedacht und vermeidet unnötige.

- Optimiere die Verwendung von Unterabfragen, indem du sie bei Bedarf durch CTEs ersetzt.

- Analysiere die Ausführungspläne von Abfragen, um Engpässe zu finden. Beispiel:

EXPLAIN ANALYZE

SELECT customer_id, COUNT(order_id)

FROM orders

GROUP BY customer_id;SQL-Codierungsübungen zu lösen ist der beste Weg, um zu üben und vergessene Konzepte wieder aufzufrischen. Du kannst deine SQL-Kenntnisse mit dem Test „Datenanalyse in SQL“ von DataCamp checken (du brauchst ein Konto, um auf diesen Test zugreifen zu können).

Fragen für Vorstellungsgespräche mit Dateningenieuren im Projektbereich

Nach den allgemeinen Vorstellungsgesprächen geht's normalerweise weiter zur technischen Phase, wo du dich mit Programmieraufgaben, Problemlösungen, dem Entwurf von Datenbanksystemen auf einem Whiteboard, einer Hausarbeit und analytischen Fragen beschäftigen musst.

Diese Phase kann ziemlich intensiv sein, daher kann es dir helfen, einige der üblichen Fragen und Antworten aus Vorstellungsgesprächen im Bereich Data Engineering zu kennen, um das Vorstellungsgespräch mit Bravour zu meistern.

26. Erzähl mir mal von einem Projekt, an dem du von Anfang bis Ende gearbeitet hast.

Diese Antwort sollte dir leicht fallen, wenn du schon mal als Student oder Profi an einem Datenengineering-Projekt gearbeitet hast. Trotzdem ist es immer gut, sich im Voraus vorzubereiten. So kannst du deine Antwort aufbauen:

- Einführung und geschäftliches Problem:

- Fang damit an, den Hintergrund des Projekts zu erklären. Erzähl mal, welches geschäftliche Problem du gelöst hast und was die Ziele des Projekts waren.

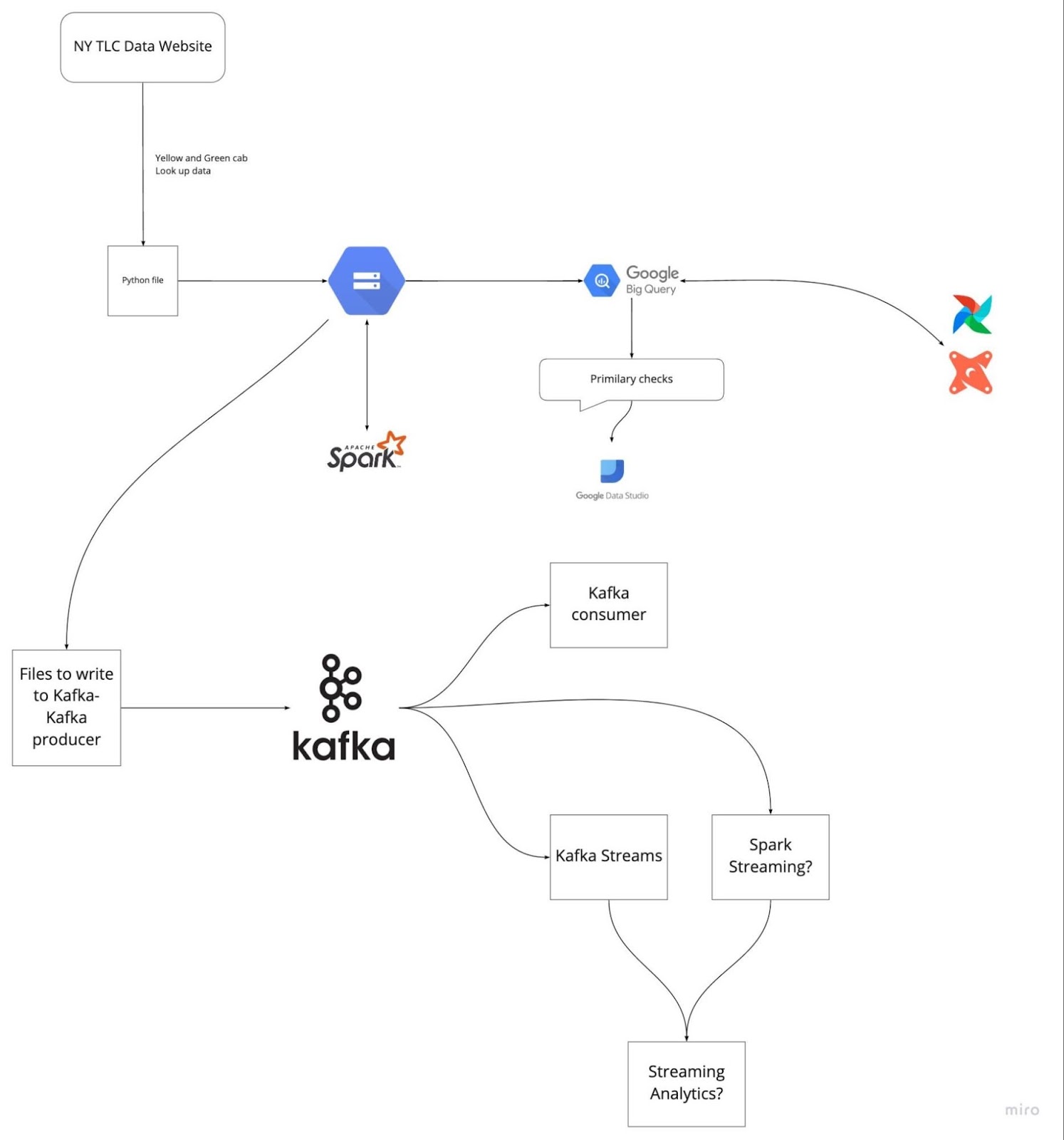

- Beispiel: Bei diesem Projekt wollten wir die Datenpipeline für die Verarbeitung von TLC-Reiseaufzeichnungsdaten optimieren, um die Abfrageleistung und Datengenauigkeit für das Analyseteam zu verbessern.

- Datenaufnahme:

- Erzähl mal, wie du an die Rohdaten gekommen bist und sie verarbeitet hast.

- Beispiel: Wir haben die rohen TLC-Reiseaufzeichnungsdaten mit GCP, Airflow und PostgreSQL verarbeitet, um sicherzustellen, dass die Daten aus verschiedenen Quellen zuverlässig erfasst werden.

- Datenverarbeitung und -umwandlung:

- Erzähl mal, welche Schritte du gemacht hast, um die Daten zu bereinigen, umzuwandeln und zu strukturieren.

- Beispiel: Wir haben Apache Spark für die Stapelverarbeitung und Apache Kafka für das Echtzeit-Streaming genutzt, um die Datenumwandlung zu machen. Die Daten wurden bereinigt, überprüft und in ein strukturiertes Format gebracht, das man gut analysieren kann.

- Datenspeicherung und -lagerung:

- Sag mal, welche Datenspeicherlösungen ihr benutzt und warum ihr euch dafür entschieden habt.

- Beispiel: Die Daten wurden in Google BigQuery gespeichert, das eine skalierbare und effiziente Lösung für die Datenspeicherung bot. Airflow wurde benutzt, um die Daten-Workflows zu verwalten.

- Analytische Technik:

- Zeig mal die Tools und Methoden, die du für die Analyse benutzt.

- Beispiel: Für die Analyse haben wir dbt (Data Build Tool), BigQuery, PostgreSQL, Google Data Studio und Metabase benutzt. Diese Tools haben dabei geholfen, solide Datenmodelle zu erstellen und aussagekräftige Berichte und Dashboards zu generieren.

- Bereitstellung und Cloud-Umgebung:

- Sag mal, welche Strategien und welche Cloud-Infrastruktur ihr benutzt.

- Beispiel: Das ganze Projekt wurde mit GCP, Terraform und Docker gemacht, um eine skalierbare und zuverlässige Cloud-Umgebung zu haben.

- Herausforderungen und Lösungen:

- Erzähl mal, welche Herausforderungen du hattest und wie du sie gemeistert hast.

- Beispiel: Eine der größten Herausforderungen war, die vielen Daten in Echtzeit zu verarbeiten. Wir haben das Problem gelöst, indem wir unsere Kafka-Streaming-Jobs optimiert und effiziente Spark-Transformationen gemacht haben.

- Ergebnisse und Auswirkungen:

- Schließ mit einer Beschreibung der Ergebnisse und Auswirkungen des Projekts ab.

- Beispiel: Das Projekt hat die Abfrageleistung und Datengenauigkeit für das Analyseteam echt verbessert, was zu schnelleren Entscheidungen und besseren Erkenntnissen geführt hat.

Bild von DataTalksClub/data-engineering-zoomcamp

Wenn du dich im Voraus auf die letzten fünf Projekte vorbereitest, an denen du gearbeitet hast, kannst du vermeiden, dass du während des Vorstellungsgesprächs nervös wirst. Verstehe die Problemstellung und die Lösungen, die du umgesetzt hast. Übe, jeden Schritt klar und knapp zu erklären.

Fragen für das Vorstellungsgespräch zum Data Engineer Manager

Bei Stellen als Engineering Manager drehen sich die Fragen normalerweise um Themen wie Entscheidungsfindung, Geschäftsverständnis, Kuratieren und Pflegen von Datensätzen, Compliance und Sicherheitsrichtlinien.

27. Was ist der Unterschied zwischen einem Data Warehouse und einer operativen Datenbank?

Ein Data Warehouse liefert alte Daten für Datenanalysen und Entscheidungen. Es unterstützt die Verarbeitung großer Datenmengen, wie zum Beispiel Online Analytical Processing (OLAP). Datenlager sind so gemacht, dass sie komplizierte Abfragen mit vielen Zeilen hinkriegen und sind für leseintensive Vorgänge optimiert. Sie unterstützen mehrere Benutzer gleichzeitig und sind so gemacht, dass sie schnell und effizient große Datenmengen abrufen können.

Operative Datenbankmanagementsysteme (OLTP) verwalten dynamische Datensätze in Echtzeit. Sie können viele Transaktionen für viele Kunden gleichzeitig abwickeln und sind deshalb super für den täglichen Betrieb. Die Daten sind meistens aktuelle Infos über Geschäftstransaktionen und -abläufe. OLTP-Systeme sind für schreibintensive Vorgänge und schnelle Abfrageverarbeitung optimiert.

28. Was glaubst du, warum braucht jedes Unternehmen, das Datensysteme nutzt, einen Notfallplan?

Katastrophenmanagement ist die Aufgabe eines Daten-Engineering-Managers. Ein Notfallwiederherstellungsplan sorgt dafür, dass Datensysteme wiederhergestellt werden können und weiterlaufen, wenn es zu einem Cyberangriff, einem Hardwareausfall, einer Naturkatastrophe oder anderen katastrophalen Ereignissen kommt. Wichtige Punkte sind:

- Echtzeit-Backup: Regelmäßige Sicherung von Dateien und Datenbanken an sicheren, externen Speicherorten.

- Datenredundanz: Datenreplikation über verschiedene geografische Standorte hinweg, um die Verfügbarkeit sicherzustellen.

- Sicherheitsprotokolle: Protokolle einrichten, um den ein- und ausgehenden Datenverkehr zu überwachen, zu verfolgen und zu beschränken, um Datenverstöße zu verhindern.

- Wiederherstellungsvorgänge: Detaillierte Verfahren zur schnellen und effizienten Wiederherstellung von Daten und Systemen, um Ausfallzeiten zu minimieren.

- Tests und Übungen: Regelmäßiges Testen des Notfallplans durch Simulationen und Übungen, um sicherzustellen, dass er funktioniert, und um bei Bedarf Anpassungen vorzunehmen.

29. Wie gehst du bei der Entscheidungsfindung vor, wenn du ein Data-Engineering-Team leitest?

Als Daten-Engineering-Manager muss man bei Entscheidungen technische Aspekte und Geschäftsziele gegeneinander abwägen. Einige Ansätze sind:

- Entscheidungen, die auf Daten basieren: Entscheidungen mit Hilfe von Datenanalysen treffen, damit sie auf objektiven Erkenntnissen und nicht auf Intuition basieren.

- Zusammenarbeit mit den Beteiligten: Enge Zusammenarbeit mit allen Beteiligten, um die geschäftlichen Anforderungen zu verstehen und die Datenverarbeitung auf die Unternehmensziele abzustimmen.

- Risikobewertung: Potenzielle Risiken und ihre Auswirkungen auf Projekte einschätzen und Strategien entwickeln, um diese Risiken zu verringern.

- Agile Methoden: Agile Methoden anwenden, um sich an veränderte Anforderungen anzupassen und schrittweise Mehrwert zu schaffen.

- Mentoring und Entwicklung: Wir helfen den Teammitgliedern, sich weiterzuentwickeln, indem wir ihnen Mentoring und Schulungen anbieten und ein Umfeld schaffen, in dem Zusammenarbeit großgeschrieben wird.

30. Wie gehst du bei deinen Datenprojekten mit dem Datenschutz um?

Um die Datenschutzregeln einzuhalten, muss man ein paar Sachen beachten, zum Beispiel:

- Regeln verstehen: Auf dem Laufenden bleiben über Datenschutzbestimmungen wie DSGVO, CCPA und HIPAA.

- Rahmenwerk für die Datenverwaltung: Ein robustes Rahmenwerk für die Datenverwaltung einführen, das Richtlinien für Datenschutz, Sicherheit und Zugriffskontrolle enthält.

- Datenverschlüsselung: Verschlüsseln von sensiblen Daten, egal ob sie gespeichert sind oder übertragen werden, um zu verhindern, dass jemand ohne Erlaubnis drauf zugreifen kann.

- Zugangskontrollen: Durch strenge Zugriffskontrollen wird sichergestellt, dass nur Leute, die dazu berechtigt sind, auf sensible Daten zugreifen können.

- Prüfungen und Überwachung: Regelmäßige Audits und Überwachung des Datenzugriffs und der Datennutzung, um Compliance-Probleme schnell zu erkennen und zu lösen.

31. Kannst du mal ein anspruchsvolles Datenengineering-Projekt beschreiben, das du geleitet hast?

Wenn du über ein anspruchsvolles Projekt redest, kannst du dich auf die folgenden Punkte konzentrieren:

- Projektumfang und Ziele: Mach dir klar, was die Ziele des Projekts sind und welches geschäftliche Problem es lösen soll.

- Herausforderungen: Sag uns, welche Probleme es gibt, wie zum Beispiel technische Einschränkungen, knappe Ressourcen oder Schwierigkeiten bei der Abstimmung zwischen den Beteiligten.

- Strategien und Lösungen: Erzähl uns, wie du diese Herausforderungen meisterst, zum Beispiel mit technischen Lösungen, Teammanagement und der Einbindung von Stakeholdern.

- Ergebnisse und Auswirkungen: Zeig die guten Ergebnisse und die Auswirkungen auf das Geschäft, wie zum Beispiel bessere Datenqualität, verbesserte Systemleistung oder höhere Betriebseffizienz.

32. Wie bewertest du neue Datentechnologien und setzt sie um?

Neue Datentechnologien zu checken und einzusetzen bedeutet:

- Marktforschung: Immer auf dem Laufenden über die neuesten Entwicklungen und Trends in der Datenverarbeitungstechnologie.

- Proof of Concept (PoC): Durchführung von PoC-Projekten, um die Machbarkeit und die Vorteile neuer Technologien in deinem spezifischen Kontext zu testen.

- Kosten-Nutzen-Analyse: Die Kosten, Vorteile und den möglichen ROI der Einführung neuer Technologien checken.

- Einbindung der Interessengruppen: Den Leuten die Ergebnisse und Empfehlungen zeigen, um ihre Zustimmung und Unterstützung zu kriegen.

- Umsetzungsplan: Einen detaillierten Plan für die Umsetzung machen, der Zeitpläne, die Verteilung der Ressourcen und Strategien für das Risikomanagement enthält.

- Schulung und Support: Wir bieten dem Team Schulungen und Unterstützung, damit der Umstieg auf neue Technologien reibungslos klappt.

33. Wie legst du Prioritäten für Aufgaben und Projekte in einem schnelllebigen Umfeld fest?

Eine gute Methode, um Aufgaben zu priorisieren, ist, sie nach ihrer Bedeutung für die Geschäftsziele und ihrer Dringlichkeit zu sortieren. Du kannst Frameworks wie die Eisenhower-Matrix nutzen, um Aufgaben in vier Quadranten einzuteilen: dringend und wichtig, wichtig, aber nicht dringend, dringend, aber nicht wichtig und weder noch. Außerdem solltest du mit den Beteiligten reden, um Prioritäten abzustimmen und sicherzustellen, dass sich das Team auf wichtige Sachen konzentriert.

Interviewfragen für Dateningenieure bei FAANG

In diesem Abschnitt schauen wir uns die häufigsten Fragen an, die Manager von Facebook, Amazon und Google bei Vorstellungsgesprächen für Stellen im Bereich Data Engineering stellen.

Fragen für Vorstellungsgespräche für Dateningenieure bei Facebook

34. Warum nutzen wir Cluster in Kafka und was sind die Vorteile?

Ein Kafka-Cluster besteht aus mehreren Brokern, die Daten auf mehrere Instanzen verteilen. Diese Architektur bietet Skalierbarkeit und Ausfallsicherheit ohne Ausfallzeiten. Wenn der primäre Cluster ausfällt, können andere Kafka-Cluster die gleichen Dienste übernehmen und so für hohe Verfügbarkeit sorgen.

Die Kafka-Clusterarchitektur besteht aus Themen, Brokern, ZooKeeper, Produzenten und Konsumenten. Es macht einen super Job beim Umgang mit Datenströmen für Big-Data-Anwendungen und hilft dabei, starke datengesteuerte Anwendungen zu entwickeln.

35. Welche Probleme löst Apache Airflow?

Mit Apache Airflow kannst du Pipelines für Analyse-Workflows, Data-Warehouse-Management sowie Datentransformation und -modellierung verwalten und planen. Es bietet:

- Pipeline-Management: Eine Plattform zum Definieren, Planen und Überwachen von Arbeitsabläufen.

- Zentrale Protokollierung: Überwache die Ausführungsprotokolle an einem Ort.

- Fehlerbehandlung: Callbacks zum Senden von Fehlermeldungen an Kommunikationsplattformen wie Slack und Discord.

- Benutzeroberfläche: Eine einfache Benutzeroberfläche zum Verwalten und Anzeigen von Arbeitsabläufen.

- Integration: Funktioniert super mit vielen Tools und Systemen.

- Open Source: Die Nutzung ist kostenlos und wird von der Community super unterstützt.

Fragen für Vorstellungsgespräche für Dateningenieure bei Amazon

36. Du bekommst eine IP-Adresse als Eingabe in Form einer Zeichenfolge. Wie würdest du herausfinden, ob es sich um eine gültige IP-Adresse handelt oder nicht?

Um zu checken, ob eine IP-Adresse echt ist, kannst du die Zeichenfolge an den Punkten „.“ trennen und mehrere Prüfungen machen, um jedes Segment zu checken. Hier ist eine Python-Funktion, um das zu machen:

def is_valid(ip):

ip = ip.split(".")

for i in ip:

if len(i) > 3 or int(i) < 0 or int(i) > 255:

return False

if len(i) > 1 and int(i) == 0:

return False

if len(i) > 1 and int(i) != 0 and i[0] == '0':

return False

return True

A = "255.255.11.135"

B = "255.050.11.5345"

print(is_valid(A)) # True

print(is_valid(B)) # False37. Was sind die verschiedenen Modi in Hadoop?

Hadoop läuft hauptsächlich in drei Modi:

- Standalone-Modus: Dieser Modus ist für Debugging-Zwecke gedacht. Es nutzt kein HDFS und macht sich beim Ein- und Auslesen das lokale Dateisystem zunutze.

- Pseudoverteilter Modus: Das ist ein Cluster mit nur einem Knoten, wo der NameNode und der DataNode auf demselben Rechner laufen. Es wird hauptsächlich zum Testen und Entwickeln benutzt.

- Vollständig verteilter Modus: Das ist ein produktionsbereiter Modus, bei dem die Daten auf mehrere Knoten verteilt werden, mit separaten Knoten für die Master- (NameNode) und Slave- (DataNode) Daemons.

Fragen für Vorstellungsgespräche für Dateningenieure bei Google

38. Wie würdest du mit doppelten Datenpunkten in einer SQL-Abfrage umgehen?

Um Duplikate in SQL zu bearbeiten, kannst du das Schlüsselwort „ DISTINCT “ verwenden oder doppelte Zeilen mit „ ROWID “ und den Funktionen „ MAX “ oder „ MIN “ löschen. Hier sind ein paar Beispiele:

DISTINCT:

SELECT DISTINCT Name, ADDRESS

FROM CUSTOMERS

ORDER BY Name;Duplikate löschen mit „ ROWID “:

DELETE FROM Employee

WHERE ROWID NOT IN (

SELECT MAX(ROWID)

FROM Employee

GROUP BY Name, ADDRESS

);39. Angenommen, du hast eine Liste mit n-1 ganzen Zahlen, die zwischen 1 und n liegen. In der Liste gibt's keine doppelten Einträge. Eine der ganzen Zahlen fehlt in der Liste. Kannst du einen effizienten Code schreiben, um die fehlende ganze Zahl zu finden?

Dieses häufige Problem beim Codieren kann mit einem mathematischen Ansatz gelöst werden:

def search_missing_number(list_num):

n = len(list_num)

# Check if the first or last number is missing

if list_num[0] != 1:

return 1

if list_num[-1] != n + 1:

return n + 1

# Calculate the sum of the first n+1 natural numbers

total = (n + 1) * (n + 2) // 2

# Calculate the sum of all elements in the list

sum_of_L = sum(list_num)

# Return the difference, which is the missing number

return total - sum_of_L

# Validation

num_list = [1, 2, 3, 4, 5, 6, 7, 8, 9, 10, 11, 13]

print("The missing number is", search_missing_number(num_list)) # The missing number is 12Wie man sich auf das Vorstellungsgespräch als Dateningenieur vorbereitet

Bevor du zum Vorstellungsgespräch gehst, solltest du dir alle Begriffe und Standardausdrücke im Bereich Data Engineering nochmal anschauen. Hier sind ein paar der wichtigsten Bereiche, auf die du dich konzentrieren solltest:

- SQL meistern: Du solltest das Erstellen, Ändern und Verwalten von Datenbanken üben. Außerdem solltest du Datenanalyse, Modellierung und Transformation beherrschen.

- Löse Programmieraufgaben: Löse Programmieraufgaben in Python, Scala oder C++. Die meisten Firmen checken die Programmierkenntnisse durch Tests, die man zu Hause machen kann, und Live-Coding-Herausforderungen.

- Entwirf eine ETL-Pipeline: Übe das Erstellen von Daten-, ETL- oder Bereitstellungspipelines. Du musst wissen, wie man Datenpipelines testet, validiert, skaliert und wartet.

- Analytics Engineering: Lade, transformiere und analysiere Daten. Lerne, wie du ein Dashboard für Datenqualität und Systemleistung erstellst.

- Schau dir mögliche Fragen an: Bereite dich auf das Vorstellungsgespräch vor, indem du dir Beispielfragen anschaust. Eine einfache Google-Suche bringt dir hunderte von Fragen.

- Lerne moderne Datenverarbeitungstools kennen: Auch wenn du noch keine Erfahrung mit modernen Datenverarbeitungstools hast, solltest du wissen, wie sie funktionieren und wie sie mit anderen Tools zusammenarbeiten. Firmen suchen immer nach besseren Tools, um die Leistung zu verbessern und dabei Kosten zu sparen.

- Lerne Batch-Verarbeitung und Streaming: Apache Spark wird für die Stapelverarbeitung genutzt, und Apache Kafka ist für das Daten-Streaming da. Diese Tools sind echt gefragt und helfen dir dabei, einen Job bei den Top-Unternehmen zu kriegen.

- Umwelt: Manchmal fragt der Interviewer nach Cloud Computing (GCP, AWS, Azure), Docker, Skripting, Terraform und Kubernetes. Mit diesen Tools kannst du Cloud- oder lokale Computer- und Speicherressourcen einrichten. Es ist echt sinnvoll, diese Technologien zu verstehen und in Portfolio-Projekte einzubauen.

Die Vorbereitung auf ein Vorstellungsgespräch im Bereich Data Engineering kann echt schwierig sein, aber mit den richtigen Ressourcen und etwas Übung kannst du dich von der Masse abheben und deinen Traumjob ergattern. Um deine Fähigkeiten und dein Wissen noch weiter zu verbessern, schau dir diese coolen Ressourcen an:

- Datenverarbeitung verstehen: Hol dir ein umfassendes Verständnis der Konzepte und Prinzipien des Data Engineering.

- Dateningenieur in Python: Lerne mit diesem Karrierepfad Master Data Engineering mit Python und lerne dabei wichtige Tools und Frameworks kennen.

- Datenbankdesign: Lerne die Grundlagen des Datenbankdesigns, um effiziente und skalierbare Datenbanken zu erstellen.

Nutze diese Kurse, um deine Grundlagen zu festigen und in deiner Karriere im Bereich Data Engineering immer einen Schritt voraus zu sein. Viel Glück bei deinen Vorstellungsgesprächen!

Werde Dateningenieur

FAQs

Was kann ich von einem Vorstellungsgespräch als Dateningenieur erwarten?

Du kannst mit einem Telefoninterview mit der Personalabteilung, einem technischen Telefoninterview, einer Hausarbeit, einer Programmieraufgabe, einem Vorstellungsgespräch vor Ort, Datenbank- und Systemdesigns am Whiteboard, einem SQL-Interview und schließlich dem „Executive”-Interview rechnen, bei dem die kulturelle Eignung geprüft wird.

Manche Firmen haben drei Bewerbungsrunden, andere sogar bis zu neun. Firmen haben oft hohe Einstiegshürden, um Leute auf jeder Ebene zu testen.

Sind Dateningenieure gefragt?

Ja, jedes Unternehmen, das Daten erzeugt, braucht Dateningenieure, um Pipelines zu erstellen, Daten zu verwalten und an verschiedene Abteilungen zu liefern. Bis 2025 werden wir täglich 463 Exabyte an Daten produzieren und brauchen immer mehr Ingenieure, die die Datenpipelines und -systeme extrahieren, umwandeln und verwalten – weforum.org.

Schreiben Dateningenieure Code?

Ja, jeder, der mit IT zu tun hat, sollte lernen, wie man programmiert, auch wenn man in der Führungsetage ist. Für Dateningenieure sind Python, SQL, Docker, Yaml und Bash wichtige Programmiersprachen. Sie werden in den Bereichen Infrastructure as Code, Pipelines, Datenbankverwaltung, Streaming, Web Scraping, Datenverarbeitung, Modellierung und Analytik eingesetzt.

Was ist der Unterschied zwischen einem Datenanalysten und einem Dateningenieur?

Der Dateningenieur sammelt, verarbeitet und bereitet Daten vor, damit Datenanalysten wertvolle geschäftliche Erkenntnisse gewinnen können. Dateningenieure kümmern sich um die ganzen Datenbanksysteme und sorgen dafür, dass sie hochwertige Daten für Aufgaben wie Analyseberichte, Dashboards, Kundenforschung und Prognosen liefern.

Was macht ein Dateningenieur eigentlich?

Sammle Daten aus verschiedenen Quellen, erstelle, überprüfe und pflege Datenpipelines, verarbeite Daten mit Algorithmen, mach analytisches Engineering, sorge dafür, dass Daten-Governance und -Sicherheit eingehalten werden, und kümmere dich um ganze Datenbanksysteme. Sie sind dafür zuständig, verschiedene Abteilungen in einem Unternehmen mit hochwertigen Datenströmen zu versorgen. Mehr über Data Engineering erfährst du hier Was ist Data Engineering? Blog.

Welche Fähigkeiten braucht man, um Dateningenieur zu werden?

Du solltest dich mit Programmierung, Data Warehousing, ETL (Extract Transform Load), SQL-Abfragen, Datenanalyse und -modellierung, kritischen Dingen und Kommunikationsfähigkeiten auskennen. Datenverarbeitung lernt man durch Erfahrung und indem man schwierige Herausforderungen in der Praxis meistert. Unsere Data Engineering-Zertifizierung ist genau das Richtige, um deine Fähigkeiten auszubauen und einen Job als Data Engineer zu ergattern.

Als zertifizierter Data Scientist ist es meine Leidenschaft, modernste Technologien zu nutzen, um innovative Machine Learning-Anwendungen zu entwickeln. Mit meinem fundierten Hintergrund in den Bereichen Spracherkennung, Datenanalyse und Reporting, MLOps, KI und NLP habe ich meine Fähigkeiten bei der Entwicklung intelligenter Systeme verfeinert, die wirklich etwas bewirken können. Neben meinem technischen Fachwissen bin ich auch ein geschickter Kommunikator mit dem Talent, komplexe Konzepte in eine klare und prägnante Sprache zu fassen. Das hat dazu geführt, dass ich ein gefragter Blogger zum Thema Datenwissenschaft geworden bin und meine Erkenntnisse und Erfahrungen mit einer wachsenden Gemeinschaft von Datenexperten teile. Zurzeit konzentriere ich mich auf die Erstellung und Bearbeitung von Inhalten und arbeite mit großen Sprachmodellen, um aussagekräftige und ansprechende Inhalte zu entwickeln, die sowohl Unternehmen als auch Privatpersonen helfen, das Beste aus ihren Daten zu machen.