programa

Cada vez que hacemos clic, publicamos o transmitimos algo, creamos datos que pueden procesarse para obtener información y predicciones significativas con las herramientas adecuadas. Para 2028, se estima que generaremos alrededor de 394 zettabytes de datos al año (fuente: Statista).

La capacidad de procesar esos datos en tiempo real nos permite tomar medidas inmediatas, como detectar fraudes o hacer recomendaciones personalizadas. Ahí es donde entra en juego Apache Kafka. Permite a las empresas actualizar sus estrategias de datos con una arquitectura de transmisión de eventos.

Esta guía explorará cómo aprender Apache Kafka desde cero. Te ayudaré a elaborar un plan de aprendizaje, compartiré mis mejores consejos para aprender de forma eficaz y te proporcionaré recursos útiles para ayudarte a encontrar puestos que requieran Apache Kafka.

¿Qué es Apache Kafka?

El procesamiento de datos en tiempo real nos brinda grandes oportunidades. Si un banco detecta una compra extraña con nuestra tarjeta de crédito, puede detener la transaccióninmediatamente . O, si estamos buscando un producto, pueden aparecer sugerencias de productos mientras navegamos por el sitio web. Esta rapidez se traduce en mejores decisiones, clientes más satisfechos y un negocio más eficiente.

Apache Kafka es un almacén de datos distribuido de alto rendimiento optimizado para recopilar, procesar, almacenar y analizar datos en tiempo real. Permite que diferentes aplicaciones publiquen y se suscriban a flujos de datos, lo que les permite comunicarse y reaccionar ante los eventos a medida que se producen.

Gracias a su eficiente gestión de los flujos de datos, Kafka se ha vuelto muy popular. Se utiliza en diferentes sistemas, desde las compras en línea y las redes sociales hasta la banca y la asistencia sanitaria.

¿Qué hace que Apache Kafka sea tan popular?

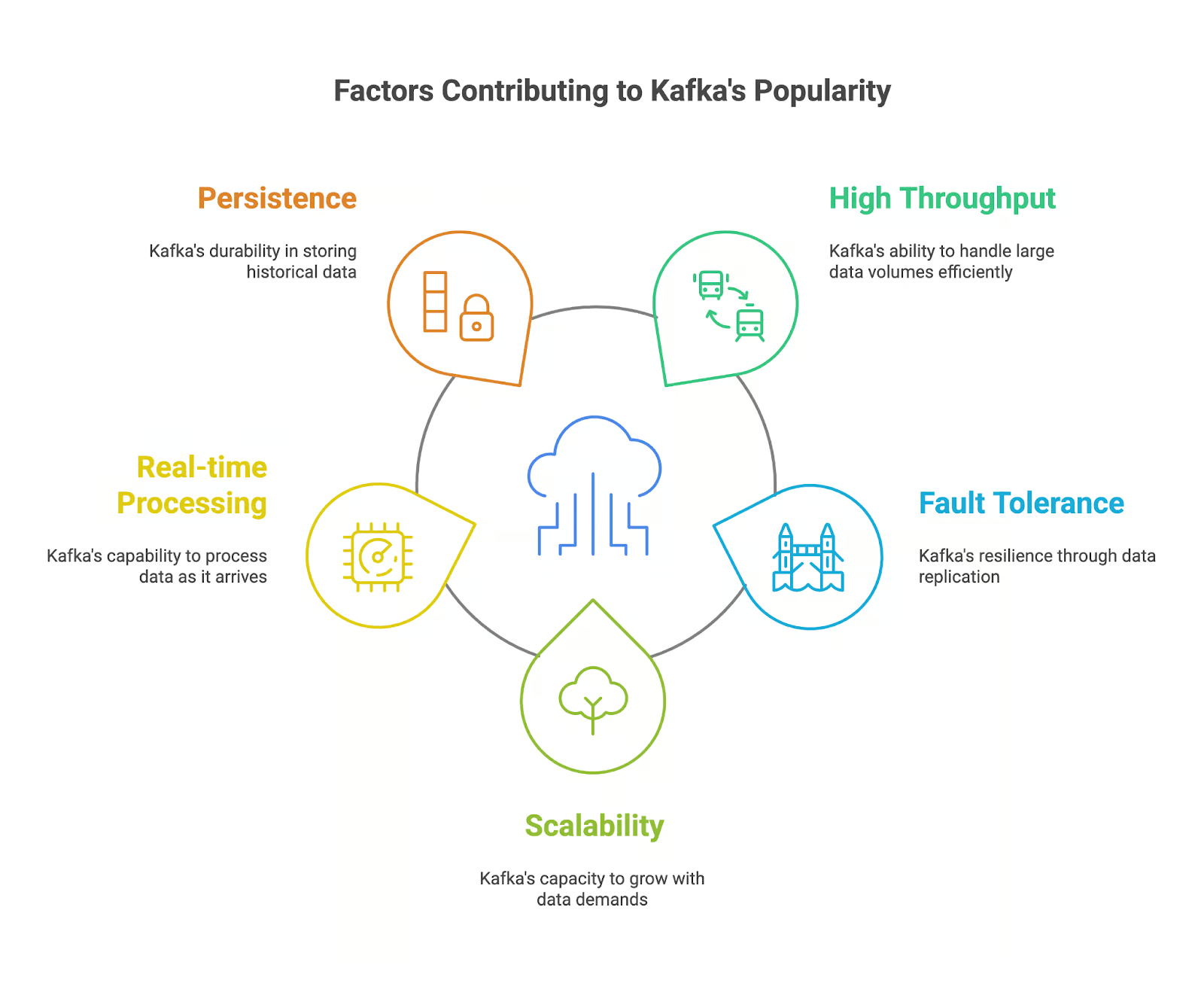

Apache Kafka se ha vuelto popular entre los profesionales de datos que se enfrentan al reto de gestionar flujos de datos en tiempo real. Podemos explicar tu popularidad por varios factores clave:

- Alto rendimiento: Kafka puede manejar grandes cantidades de datos con gran velocidad y eficiencia, lo que lo hace ideal para procesar flujos de datos en tiempo real.

- Tolerancia a fallos: La arquitectura distribuida de Kafka garantiza que nuestros datos se repliquen en múltiples brokers, lo que confiere a nuestra aplicación resistencia frente a fallos y garantiza la durabilidad de los datos.

- Escalabilidad: Kafka puede escalarse fácilmente para gestionar volúmenes de datos y demandas de usuarios cada vez mayores añadiendo más brokers al clúster.

- Procesamiento en tiempo real: La capacidad de Kafka para gestionar flujos de datos en tiempo real permite a nuestras aplicaciones responder a los eventos a medida que se producen, lo que nos brinda oportunidades para tomar decisiones en tiempo real.

- Persistencia: Kafka almacena los datos de forma duradera, lo que permite a nuestras aplicaciones acceder a datos históricos con fines de análisis y auditoría.

Características principales de Apache Kafka

Apache Kafka se utiliza actualmente en aplicaciones que requieren el procesamiento y análisis de datos en tiempo real. Pero, ¿qué características lo convierten en una herramienta potente para gestionar datos en streaming? Echemos un vistazo a ellos:

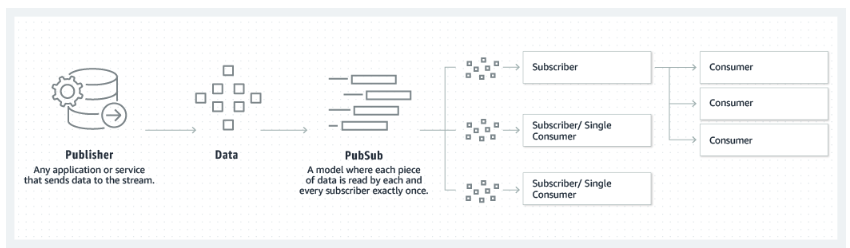

- Modelo editor-suscriptor: Kafka sigue un modelo editor-suscriptor, en el que los productores publican datos sobre temas y los consumidores se suscriben a estos temas para recibir datos.

- Temas y particiones: Los datos en Kafka se organizan en temas, que a su vez se dividen en particiones para facilitar la escalabilidad y el paralelismo.

- Corredores y clústeres: Los brokers Kafka son responsables de almacenar y servir datos. Un clúster Kafka está formado por varios brokers que trabajan juntos para proporcionar tolerancia a fallos y alta disponibilidad.

- Productores y consumidores: Los productores publican datos en los temas de Kafka, mientras que los consumidores se suscriben a los temas y procesan los datos.

- Integración con ZooKeeper: Kafka depende de ZooKeeper para gestionar los metadatos del clúster y garantizar la coordinación entre los brokers.

El modelo editor-suscriptor en el que se basa Kafka. Fuente: Amazon

¿Por qué es tan útil aprender Apache Kafka?

Aprender Apache Kafka te convierte en un candidato valioso para los empleadores y las empresas que generan y procesan datos a gran velocidad. Apache Kafka, con sus potentes funciones y su uso generalizado, se ha convertido en una herramienta clave para crear las arquitecturas de datos modernas y aplicaciones.

Existe demanda de habilidades en Apache Kafka.

He mencionado que Kafka se ha vuelto muy popular en los últimos años. Se estima que Apache Kafka es utilizado actualmente por más del el 80 % de las empresas de la lista Fortune 100.

El uso cada vez mayor de Kafka en diversos sectores, junto con su papel en la habilitación de soluciones de datos en tiempo real, hace que los conocimientos sobre Kafka sean muy valiosos en el mercado laboral. Según PayScale y ZipRecruiter, en noviembre de 2024, el salario medio de un ingeniero con conocimientos de Kafka en Estados Unidos era de 100 000 dólares al año.

Apache Kafka tiene una gran variedad de aplicaciones.

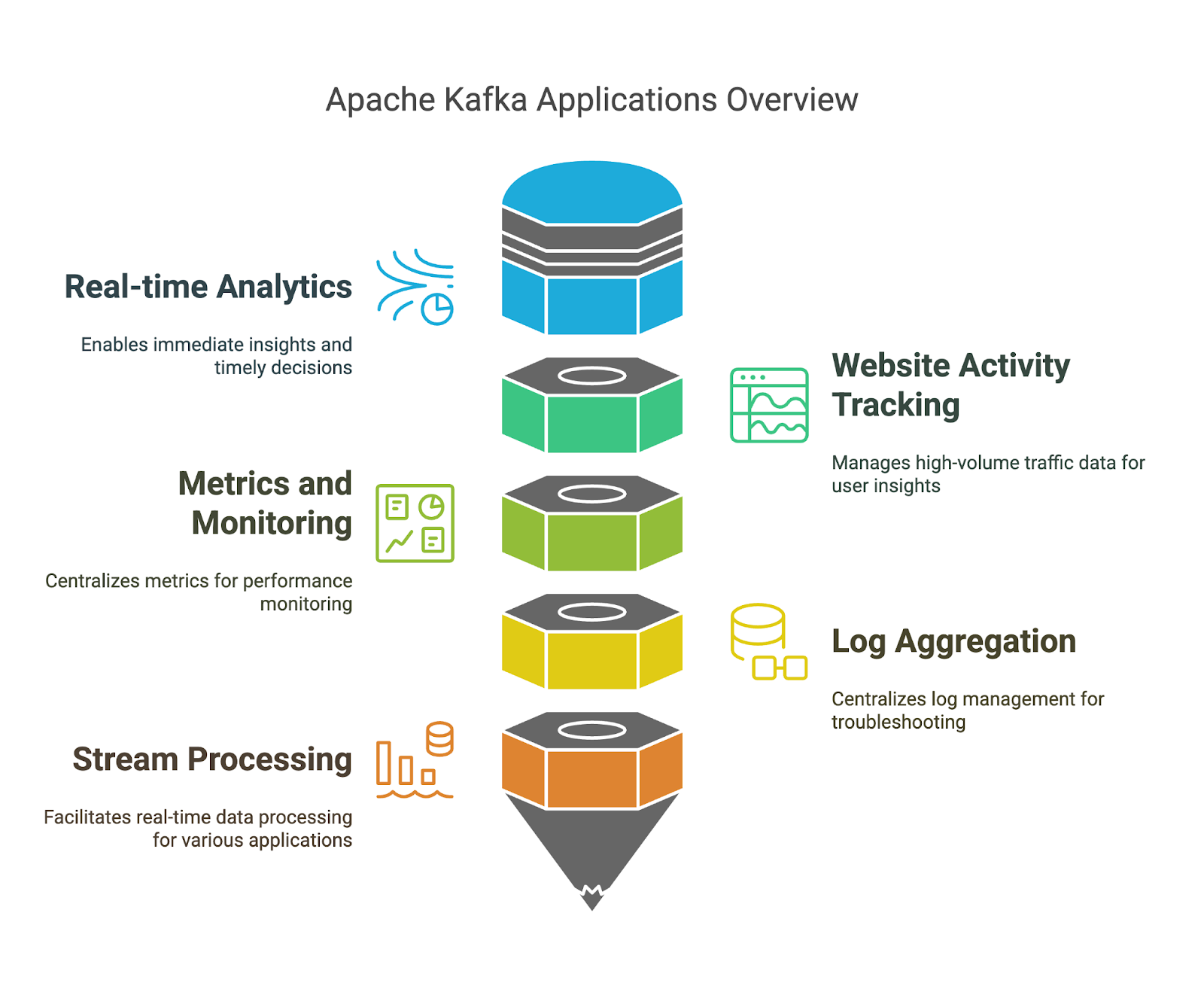

Ya hemos mencionado las ventajas de Apache Kafka, pero veamos algunos ejemplos concretos en los que puedes utilizarlas:

- Análisis en tiempo real: Con Kafka, podemos realizar la ingesta y el procesamiento de datos en tiempo real, lo que nos ayuda a obtener información inmediata a partir de los datos en streaming y a tomar decisiones oportunas.

- Seguimiento de la actividad del sitio web: Dado que Kafka puede gestionar grandes volúmenes de datos de tráfico web, podemos comprender el comportamiento de los usuarios, el rendimiento del sitio web y los contenidos más populares.

- Métricas y supervisión: Kafka puede recopilar y procesar métricas de diversos sistemas y aplicaciones. Podemos aprovechar tu plataforma centralizada para supervisar el rendimiento e identificar posibles problemas.

- Agregación de registros: Kafka puede agregar registros de múltiples fuentes. Podemos aprovechar su gestión y análisis centralizados de registros para la resolución de problemas y la supervisión de la seguridad.

- Procesamiento de flujos: Kafka Streams nos permite crear aplicaciones que procesan datos en tiempo real. Esto nos permite desarrollar modelos eficientes para la detección de fraudes, la detección de anomalías y las recomendaciones en tiempo real.

Cómo aprender Apache Kafka desde cero en 2026

Si aprendes Apache Kafka de forma metódica, tendrás más posibilidades de éxito. Centrémonos en algunos principios que puedes utilizar en tu proceso de aprendizaje.

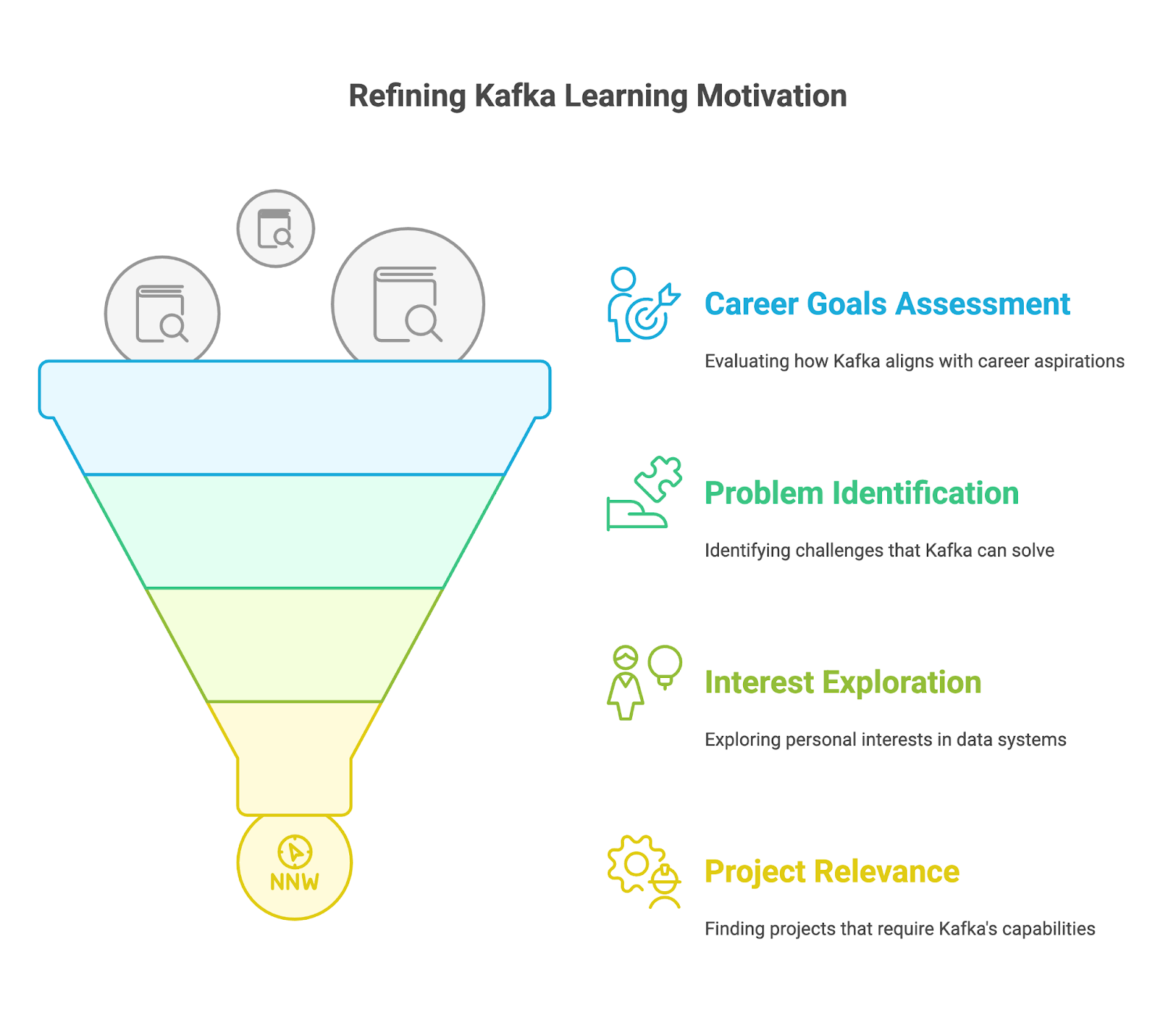

1. Comprende por qué estás aprendiendo Apache Kafka.

Antes de aprender los detalles técnicos, define tu motivación para aprender Apache Kafka. Pregúntate a ti mismo:

- ¿Cuáles son tus objetivos profesionales?

- ¿Es Kafka una habilidad que necesitas para avanzar en tu puesto actual o conseguir el trabajo de tus sueños?

- ¿Tu objetivo es dar un giro a tu carrera profesional y dedicarte a la ingeniería de big data, el desarrollo de aplicaciones en tiempo real o la transmisión de datos?

- ¿Qué oportunidades crees que se te abrirán al dominar Kafka? Piensa en puestos específicos como ingeniero de Kafka, arquitecto de datos o ingeniero de software especializado en sistemas en tiempo real.

- ¿Qué problemas estoy tratando de resolver?

- ¿Te enfrentas a retos con los sistemas de mensajería existentes que Kafka podría resolver?

- ¿Necesitas crear aplicaciones que puedan gestionar la complejidad de los flujos de datos en tiempo real?

- ¿Procesas grandes volúmenes de eventos procedentes de dispositivos IoT, redes sociales o transacciones financieras?

- ¿Tienes dificultades para integrar datos de diferentes fuentes y sistemas de forma fiable y eficiente?

- ¿Qué me interesa?

- ¿Te entusiasma la idea de crear sistemas distribuidos altamente escalables y tolerantes a fallos?

- ¿Te interesa el procesamiento de datos en tiempo real y el potencial que ofrece para las empresas y las aplicaciones?

- ¿Te interesa explorar el amplio ecosistema de las tecnologías de big data y cómo encaja Kafka en él?

- ¿Tienes en mente algún proyecto específico que requiera las capacidades de Kafka?

- ¿Estás trabajando en un proyecto personal que implica la transmisión de datos en tiempo real, como la creación de una aplicación de chat?

- ¿Tu empresa tiene algún proyecto próximo que requiera conocimientos especializados sobre Kafka, como la migración a un nuevo sistema de mensajería, la implementación de análisis en tiempo real o la creación de una arquitectura de microservicios?

2. Empieza con los conceptos básicos de Apache Kafka.

Una vez que hayas identificado tus objetivos, domina los conceptos básicos de Kafka y comprende cómo funcionan.

Instalación de Apache Kafka

Para aprender Apache Kafka, primero necesitamos instalarlo en tu máquina local. Dado que Kafka se desarrolla utilizando Java, debemos asegurarnos de tener Java instalado. A continuación, hay que descargar los binarios de Kafka desde la sitio web oficial y extraerlos.

Ahora iniciamos ZooKeeper, seguido del servidor Kafka, utilizando los scripts proporcionados. Por último, podemos utilizar las herramientas de línea de comandos para crear temas e intentar producir y consumir algunos mensajes para comprender los conceptos básicos. DataCamp's Apache Kafka para principiantes puede ayudarte a ponerte al día.

Comprender el modelo editor-suscriptor

El primer concepto que debemos aprender es el modelo editor-suscriptor en Kafka. Esta es una de las razones principales por las que Apache Kafka puede gestionar datos en streaming de forma eficiente. Comprender cómo los productores publican mensajes y los consumidores se suscriben a estos temas, recibiendo solo mensajes relevantes para sus intereses.

Introducción a Apache Kafka de DataCamp Introducción a Apache Kafka ofrece una introducción, con ejercicios interactivos y ejemplos prácticos.

Exploración de los componentes de Kafka

Al describir el modelo editor-suscriptor, hemos mencionado algunos componentes clave de Kafka: Productor y consumidor. Sin embargo, debemos explorar todos los componentes básicos. Debemos aprender cómo Kafka organiza los datos en temas y particiones, y comprender cómo las particiones contribuyen a la escalabilidad y la tolerancia a fallos.

También debemos comprender cómo los brokers forman un clúster para proporcionar alta disponibilidad y tolerancia a fallos.

Consulta la introducción a Apache Kafka de DataCamp. Introducción a Apache Kafka , así como el artículo Apache Kafka para principiantes para tener una idea clara de estos temas.

3. Domina las habilidades intermedias de Apache Kafka

Una vez que te sientas cómodo con los conceptos básicos, es hora de explorar las habilidades intermedias de Apache Kafka.

Kafka Connect para la integración de datos

Una de las características clave de Apache Kafka es su capacidad para gestionar grandes volúmenes de datos en streaming. Kafka Connect es un componente gratuito y de código abierto de Apache Kafka que simplifica la integración de datos entre sistemas de archivos, bases de datos, índices de búsqueda y almacenes de claves-valores.

Aprender a utilizar Connect puede ayudarnos a desbloquear un flujo de datos eficiente para el análisis, la integración de aplicaciones y la creación de una arquitectura de datos robusta y escalable. Consulta nuestro artículo Apache Kafka para principiantes para obtener más detalles.

Kafka Streams para el procesamiento de flujos

Otra característica avanzada de Kafka es Streams. Debemos aprender a crear aplicaciones de procesamiento de flujos directamente en Kafka con la ayuda de Streams. Ofrece API y un lenguaje específico de dominio de alto nivel para gestionar, convertir y evaluar flujos continuos de datos. Más información en Artículo Apache Kafka para principiantes.

Supervisión y gestión de Kafka

Al igual que con cualquier otra tecnología, siempre es bueno realizar un seguimiento de su rendimiento. Para ello, debemos aprender a supervisar el estado y el rendimiento de vuestro clúster Kafka. Podemos explorar herramientas y técnicas para supervisar métricas clave, gestionar temas y particiones, y garantizar un rendimiento óptimo.

4. Aprende Apache Kafka con la práctica

Realizar cursos sobre Apache Kafka es una forma excelente de familiarizarse con esta tecnología. Sin embargo, para dominar Kafka, es necesario resolver problemas desafiantes y que permitan desarrollar habilidades, como los que se te presentarán en proyectos del mundo real.

Puedes empezar experimentando con tareas sencillas de transmisión de datos, como producir y consumir mensajes, y luego aumentar gradualmente la complejidad explorando temas como la partición, la tolerancia a fallos y la integración con sistemas externos utilizando Kafka Connect.

Aquí tienes algunas formas de practicar tus habilidades:

- Configura un clúster Kafka local: Instala Kafka en tu máquina local y experimenta con la producción y el consumo de mensajes. Utiliza un proveedor de nube como Confluent Cloud, AWS MSK o Azure HDInsight Kafka para disfrutar de un entorno Kafka gestionado. Esto es ideal para aprender sobre escalabilidad y aspectos operativos.

- Participa en seminarios web y sesiones de programación conjunta. Consulta los los próximos seminarios web de DataCamp o los seminarios web de Confluent, donde podrás seguir tutoriales sobre Apache Kafka y ejemplos de código. Esto te ayudará a reforzar tu comprensión de los conceptos y a familiarizarte con los patrones de codificación.

- Contribuye a proyectos de código abierto. Contribuye a proyectos de Apache Kafka en plataformas como GitHub para adquirir experiencia colaborando con otras personas y trabajando en proyectos reales. El propio Apache Kafka ofrece estas oportunidades.

5. Crea un portafolio de proyectos.

Completarás diferentes proyectos a medida que avances en tu proceso de aprendizaje de Apache Kafka. Para mostrar tus habilidades y experiencia en Apache Kafka a posibles empleadores, debes recopilarlas en un portafolio. Este portafolio debe reflejar tus habilidades e intereses y estar adaptado a la carrera o industria que te interesa.

Intenta que tus proyectos sean originales y demuestren tu capacidad para resolver problemas. Incluye proyectos que demuestren tu dominio de diferentes aspectos de Kafka, como la creación de canalizaciones de datos con Kafka Connect, el desarrollo de aplicaciones de streaming con Kafka Streams o el trabajo con clústeres de Kafka. Documenta tus proyectos de forma exhaustiva, proporcionando contexto, metodología, código y resultados. Puedes utilizar plataformas como GitHub para alojar tu código y Confluent Cloud para un entorno Kafka gestionado.

6. Sigue desafiándote a ti mismo.

Aprender Kafka es un viaje continuo. La tecnología evoluciona constantemente y se desarrollan nuevas funciones y aplicaciones con regularidad. Kafka no es una excepción.

Una vez que domines los fundamentos, podrás buscar tareas y proyectos más desafiantes, como el ajuste del rendimiento de sistemas de alto rendimiento y la implementación de procesamiento avanzado de flujos con Kafka Streams. Céntrate en tus objetivos y especialízate en áreas que sean relevantes para tus metas profesionales y tus intereses.

Mantente al día de las últimas novedades, como nuevas funciones o propuestas de KIP, y aprende a aplicarlas a tus proyectos. Sigue practicando, busca nuevos retos y oportunidades, y acepta la idea de cometer errores como una forma de aprender.

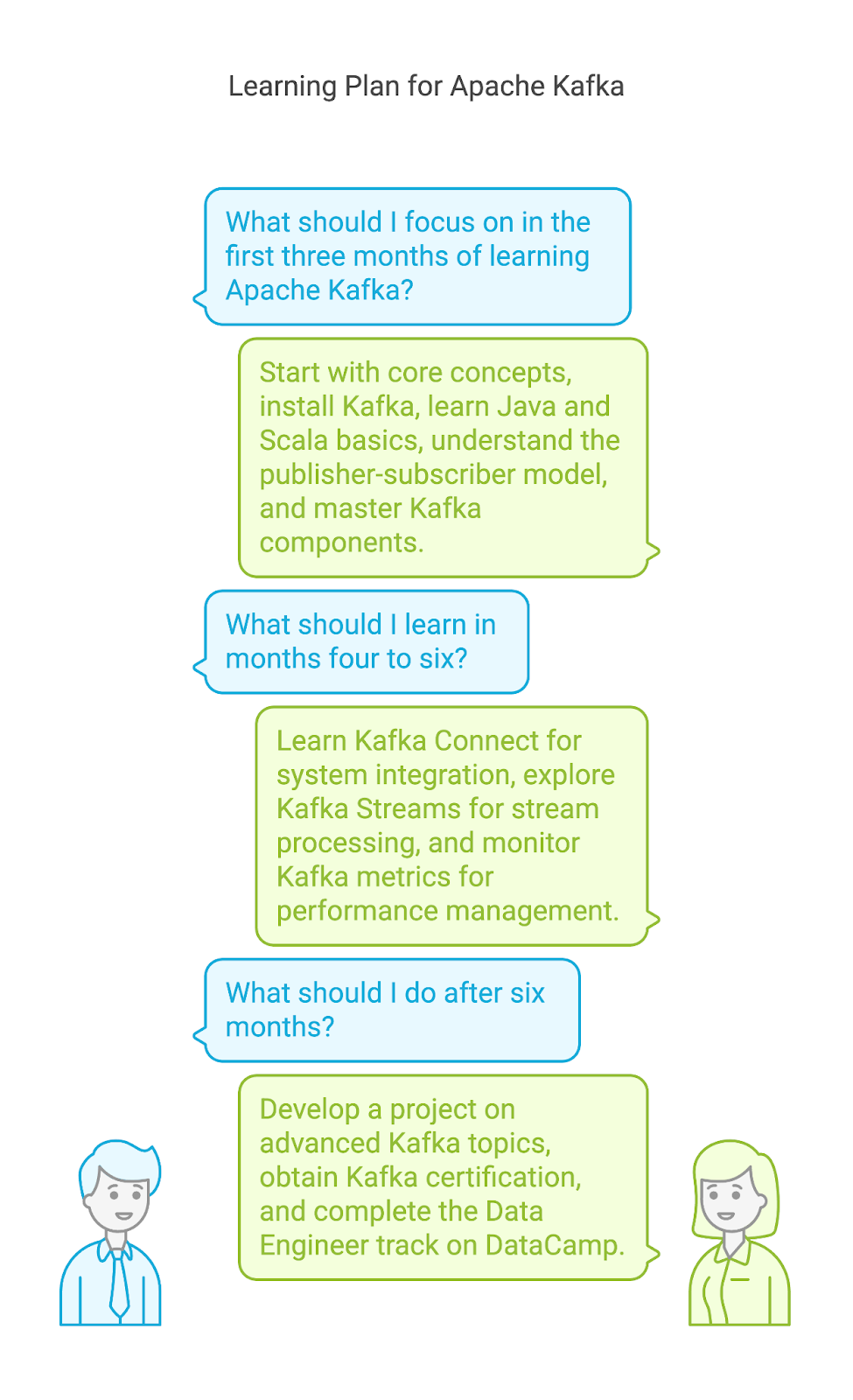

Un ejemplo de plan de aprendizaje de Apache Kafka

Aunque cada persona tiene su propia forma de aprender, siempre es buena idea contar con un plan o una guía que seguir para aprender a utilizar una nueva herramienta. He creado un posible plan de aprendizaje en el que se describe dónde centrar tu tiempo y tus esfuerzos si acabas de empezar con Apache Kafka.

Plan de aprendizaje para los meses 1-3

- Conceptos básicos. Instala Apache Kafka e inicia ZooKeeper y el servidor Kafka. Comprender cómo utilizar las herramientas de línea de comandos para crear temas.

- Java y Scala. Dado que Kafka está desarrollado en estos lenguajes de programación, también puedes aprender los conceptos básicos de Java y Scala.

- Modelo editor-suscriptor. Comprende el sistema central que hay detrás de Kafka, el modelo editor-suscriptor. Explora cómo se producen y consumen los mensajes de forma asíncrona. Completa el curso Introducción a Apache Kafka.

- Componentes de Kafka: Domina los conceptos y elementos clave de Kafka, incluidos los temas y particiones, los brokers y clústeres, los productores y los consumidores. Comprender sus funciones y cómo interactúan para garantizar la tolerancia a fallos y la escalabilidad. Explora herramientas como Kafka Manager para visualizar y supervisar tu clúster de Kafka.

Plan de aprendizaje para los meses 4-6

- Kafka Connect. Aprende a conectar Kafka con diversos sistemas, como bases de datos (MySQL, PostgreSQL), servicios en la nube (AWS S3, Azure Blob Storage) y otros sistemas de mensajería (JMS, RabbitMQ) utilizando Kafka Connect. Explora los diferentes tipos de conectores (fuente y sumidero) y las opciones de configuración.

- Kafka Streams. Explora conceptos como operaciones con estado, ventanas y dualidad de tablas de flujo. Aprende a escribir, probar e implementar aplicaciones de procesamiento de flujos dentro de tu infraestructura Kafka.

- Supervisión y gestión de Kafka. Aprende a supervisar métricas clave de Kafka, como el rendimiento, la latencia y el retraso de los consumidores, utilizando herramientas como Burrow y Kafka Manager. Comprende cómo identificar y solucionar los cuellos de botella que afectan al rendimiento y garantiza el buen funcionamiento de tu clúster de Kafka.

A partir del séptimo mes

- Desarrolla un proyecto. Sumérgete en temas avanzados de Kafka, como seguridad, ajuste del rendimiento y técnicas avanzadas de procesamiento de flujos. Contribuye a la comunidad Kafka y crea proyectos del mundo real.

- Obtén la certificación Kafka. Prepárate y obtén una certificación de Kafka, como la de programador certificado por Confluent para Apache Kafka. Consulta esta guía de certificación de Kafka.

- Ingeniero de datos con programa Python Track. Completa la programa de ingeniero de datos en DataCamp, que abarca habilidades esenciales de ingeniería de datos como la manipulación de datos, SQL, nube y canalizaciones de datos.

Seis consejos para aprender Apache Kafka

Imagino que a estas alturas ya estás listo para lanzarte a aprender Kafka y hacerte con un gran conjunto de datos para practicar tus nuevas habilidades. Pero antes de hacerlo, permíteme destacar estos consejos que te ayudarán a recorrer el camino hacia el dominio de Apache Kafka.

1. Reduce tu ámbito de búsqueda

Kafka es una herramienta versátil que se puede utilizar de muchas maneras. Debes identificar tus objetivos e intereses específicos dentro del ecosistema Kafka. ¿Qué aspecto de Kafka te atrae más? ¿Te interesa la ingeniería de datos, el procesamiento de flujos o la administración de Kafka? Un enfoque específico puede ayudarte a adquirir los aspectos y conocimientos más relevantes de Apache Kafka para satisfacer tus intereses.

2. Practica con frecuencia y constancia.

La constancia es clave para dominar cualquier habilidad nueva. Debes reservar tiempo específico para practicar Kafka. Solo necesitas dedicarle un poco de tiempo cada día. No es necesario que abordes conceptos complejos todos los días. Puedes realizar ejercicios prácticos, seguir tutoriales y experimentar con diferentes funciones de Kafka. Cuanto más practiques, más cómodo te sentirás con la plataforma.

3. Trabaja en proyectos reales

Este es uno de los consejos clave, y lo leerás varias veces en esta guía. Practicar ejercicios es ideal para ganar confianza. Sin embargo, aplicar tus conocimientos de Kafka a proyectos del mundo real es lo que te hará destacar en este campo.

Empieza con proyectos y preguntas sencillos y ve pasando gradualmente a otros más complejos. Esto podría implicar la creación de una sencilla aplicación de productor-consumidor, para luego pasar a construir un canal de datos en tiempo real con Kafka Connect, o incluso diseñar una aplicación de streaming tolerante a fallos con Kafka Streams. La clave está en desafiarte continuamente a ti mismo y ampliar tus habilidades prácticas con Kafka.

4. Participa en una comunidad

El aprendizaje suele ser más eficaz cuando se realiza de forma colaborativa. Compartir tus experiencias y aprender de los demás puede acelerar tu progreso y proporcionarte información valiosa.

Para intercambiar conocimientos, ideas y preguntas, puedes unirte a algunos grupos relacionados con Apache Kafka y asistir a reuniones y conferencias. Puedes unirte a comunidades en línea como el canal Slack de Confluent o Foro Confluent, donde podrás interactuar con otros entusiastas de Kafka. También puedes unirte a encuentros, con charlas de expertos en Kafka, o conferencias, como ApacheCon.

5. Cometer errores

Al igual que con cualquier otra tecnología, aprender Apache Kafka es un proceso iterativo. Aprender de tus errores es una parte esencial de este proceso. No tengas miedo de experimentar, prueba diferentes enfoques y aprende de tus errores.

Prueba diferentes configuraciones para tus productores y consumidores de Kafka, explora varios métodos de serialización de datos (JSON, Avro, Protobuf) y experimenta con diferentes estrategias de partición. Lleva tu clúster Kafka al límite con grandes volúmenes de mensajes y observa cómo gestiona la carga. Analiza el retraso de los consumidores, ajusta las configuraciones y comprende cómo tus optimizaciones afectan al rendimiento.

6. No te apresures.

Tómate tu tiempo para comprender realmente conceptos básicos como temas, particiones, grupos de consumidores y la función de ZooKeeper. Si construyes ahora una base sólida, te resultará más fácil comprender temas más avanzados y resolver problemas de forma eficaz. Divide el proceso de aprendizaje en pasos más pequeños y date tiempo para comprender la información. Un enfoque lento y constante suele conducir a una comprensión y un dominio más profundos.

Las mejores formas de aprender Apache Kafka

Veamos algunos métodos eficaces para aprender Apache Kafka.

Realizar cursos en línea

Los cursos en línea ofrecen una excelente manera de aprender Apache Kafka a tu propio ritmo. DataCamp ofrece un curso intermedio de Kafka. Este curso abarca los conceptos básicos de Kafka, incluyendo el modelo editor-suscriptor, temas y particiones, corredores y clústeres, productores y consumidores.

Sigue los tutoriales en línea.

Los tutoriales son otra forma estupenda de aprender Apache Kafka, especialmente si eres nuevo en esta tecnología. Contienen instrucciones paso a paso sobre cómo realizar tareas específicas o comprender determinados conceptos. Para empezar, ten en cuenta estos tutoriales:

Leer blogs

Para conocer más a fondo las ventajas de Apache Kafka, también debes comprender cuáles son las principales similitudes y diferencias con otras tecnologías. Puedes leer artículos sobre cómo se compara Kafka con otras herramientas, como los siguientes:

Descubre Apache Kafka a través de libros

Los libros son un recurso excelente para aprender Apache Kafka. Ofrecen conocimientos profundos y opiniones de expertos, junto con fragmentos de código y explicaciones. Estos son algunos de los libros más populares sobre Kafka:

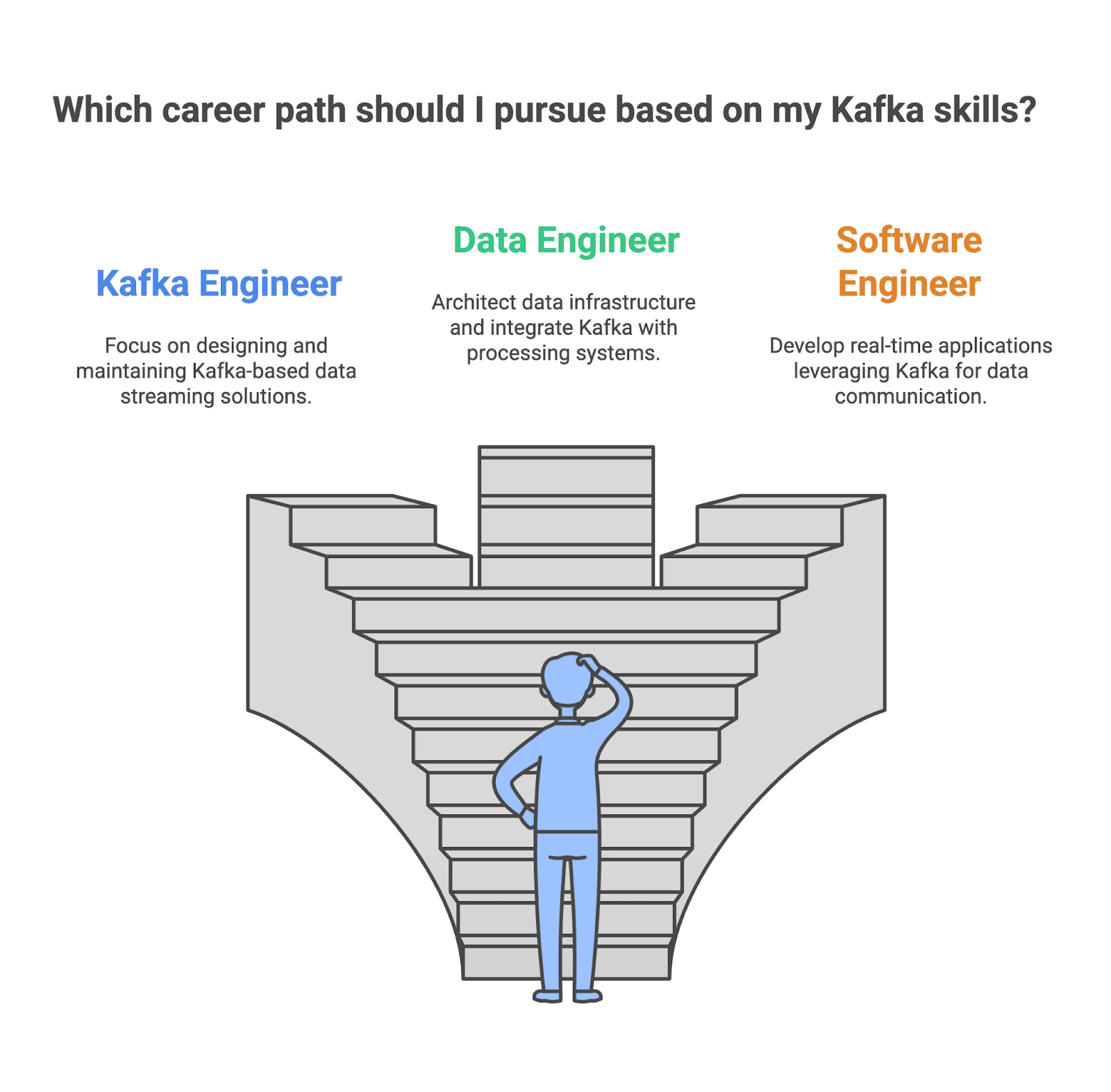

Las diferentes carreras profesionales en Apache Kafka hoy en día

Debido a que la adopción de Apache Kafka sigue creciendo, también lo hacen las oportunidades profesionales para los profesionales con conocimientos de Kafka, desde ingenieros especializados en Kafka hasta ingenieros de software. Si estás evaluando si tus habilidades en Kafka son adecuadas, ten en cuenta estas funciones:

Ingeniero de Kafka

Como ingeniero de Kafka, serás responsable de diseñar, crear y mantener soluciones de transmisión de datos basadas en Kafka con alta disponibilidad y escalabilidad. Deberás garantizar un flujo de datos fiable y eficiente dentro de la empresa, así como supervisar y optimizar el rendimiento de Kafka para garantizar un rendimiento y una latencia óptimos.

- Habilidades clave:

- Sólidos conocimientos sobre la arquitectura y los componentes de Kafka.

- Competencia en la administración y configuración de Kafka.

- Experiencia con canalizaciones de datos y procesos ETL.

- Conocimiento de los conceptos de procesamiento de flujos y Kafka Streams.

- Herramientas clave utilizadas:

- Apache Kafka

- Kafka Connect

- Kafka Streams

- ZooKeeper

- Herramientas de supervisión

Ingeniero de datos

Como ingeniero de datos, eres el arquitecto de la infraestructura de datos, responsable de diseñar y construir los sistemas que gestionan los datos de una empresa. Kafka suele desempeñar un papel importante en estas canalizaciones de datos, ya que permite una transmisión de datos en tiempo real eficiente y escalable entre diferentes sistemas. Deberás asegurarte de que Kafka se integre perfectamente con otros componentes.

- Habilidades clave:

- Sólidos conocimientos sobre conceptos de almacenamiento y modelado de datos.

- Dominio de herramientas de procesamiento de datos como Spark y Hadoop.

- Experiencia con nubes como AWS, Azure o GCP.

- Conocimientos sobre Kafka para la transmisión de datos en tiempo real.

- Herramientas clave utilizadas:

- Apache Kafka

- Apache Spark

- Hadoop

- Colmena

- Nube (AWS, Azure, GCP)

Ingeniero de software

Como ingeniero de software, utilizarás Kafka para crear aplicaciones en tiempo real, como plataformas de chat y juegos en línea. Tendrás que integrarlo en el código de la aplicación para garantizar un flujo de datos fluido mediante la conexión con diversos sistemas de mensajería y API. También optimizarás estas aplicaciones para mejorar su escalabilidad y rendimiento, lo que les permitirá gestionar grandes cantidades de datos en tiempo real.

- Habilidades clave:

- Sólidos conocimientos de programación en lenguajes como Java, Python o Scala.

- Comprensión del modelo editor-suscriptor y la API de Kafka.

- Experiencia en la creación de sistemas y aplicaciones distribuidos.

- Conocimiento de las mejores prácticas de ingeniería de software.

- Herramientas clave utilizadas:

- Apache Kafka

- Lenguajes de programación (Java, Python, Scala)

- Sistemas de mensajería (por ejemplo, RabbitMQ, ActiveMQ)

- Herramientas y marcos de desarrollo

|

Función |

Lo que haces |

Tus habilidades clave |

Herramientas que utilizas |

|

Kafka Engineer |

Diseñar e implementar clústeres Kafka para garantizar una alta disponibilidad y escalabilidad. |

Arquitectura Kafka, componentes, Administración y configuración, conceptos de procesamiento de flujos. |

Apache Kafka, Kafka Connect, Kafka Streams, ZooKeeper |

|

Ingeniero de datos |

Diseñar e implementar almacenes de datos y lagos de datos, integrar Kafka con otros sistemas de procesamiento y almacenamiento de datos. |

Dominio de herramientas de procesamiento de datos, experiencia con plataformas de nube y conocimientos de Kafka. |

Apache Kafka, Apache Spark, Hadoop, Colmena, Nubes |

|

Ingeniero de software |

Diseña y desarrolla aplicaciones que aprovechen Kafka para la comunicación de datos en tiempo real. |

Conocimientos de programación, sistemas y aplicaciones distribuidos, y el modelo editor-suscriptor de Kafka. |

Apache Kafka, Java, Python, Scala, RabbitMQ, ActiveMQ, Herramientas y marcos de desarrollo. |

Cómo encontrar un trabajo que utilice Apache Kafka

Aunque tener un título universitario puede ser muy valioso a la hora de desarrollar una carrera profesional en un puesto relacionado con los datos que utilice Apache Kafka, no es la única vía para alcanzar el éxito. Cada vez más personas de diversos orígenes y con diferentes experiencias están empezando a trabajar en puestos relacionados con los datos. Con dedicación, aprendizaje constante y un enfoque proactivo, puedes conseguir el trabajo de tus sueños utilizando Apache Kafka.

Sigue aprendiendo sobre Kakfa

Mantente al día de las últimas novedades sobre Kafka. Sigue en las redes sociales a profesionales influyentes relacionados con Apache Kafka, lee blogs sobre Apache Kafka y escucha podcasts relacionados con Kafka.

Interactúa con figuras influyentes, como Neha Narkhede, cofundadora de Kafka y directora de tecnología de Confluent. Obtendrás información sobre temas de actualidad, tecnologías emergentes y la dirección futura de Apache Kafka. Tú también también leer el blog de Confluent, que ofrece artículos y tutoriales detallados sobre una amplia gama de temas relacionados con Kafka, desde la arquitectura y la administración hasta casos de uso y mejores prácticas.

También deberías echar un vistazo a los eventos del sector, como los seminarios web de Confluent o la cumbre anual Cumbre Kafka.

Desarrollar una cartera

Tienes que destacar entre los demás candidatos. Una buena forma de hacerlo es crear un buen portafolio que muestre tus habilidades y los proyectos que has completado.

Tu portafolio debe contener proyectos que demuestren tu competencia en la creación de canalizaciones de datos, la implementación de aplicaciones de procesamiento de flujos y la integración de Kafka con otros sistemas.

Elaborar un currículum eficaz

Los responsables de contratación tienen que revisar cientos de currículos y distinguir a los mejores candidatos. Además, en muchas ocasiones, tu currículum pasa por los sistemas de seguimiento de candidatos (ATS), unos programas informáticos automatizados que utilizan muchas empresas para revisar los currículums y descartar aquellos que no cumplen unos criterios específicos. Por lo tanto, debes crear un buen currículum y redactar una impresionante carta de presentación para impresionar tanto al ATS como a tus reclutadores.

Llama la atención de un responsable de contratación

Si llamas la atención del responsable de contratación o tu currículum eficaz supera el proceso de selección, lo siguiente que debes hacer es prepararte para una entrevista técnica. Para estar preparado, puedes consultar este artículo sobre 20 preguntas de entrevista sobre Kafka para ingenieros de datos.

Conclusión

Aprender Apache Kafka puede abrirte las puertas a mejores oportunidades y resultados profesionales. El camino para aprender Kafka es gratificante, pero requiere constancia y práctica. Experimentar y resolver retos con esta herramienta puede acelerar tu proceso de aprendizaje y proporcionarte ejemplos reales para demostrar tus habilidades prácticas cuando busques trabajo.

Preguntas frecuentes

¿Por qué está creciendo la demanda de habilidades relacionadas con Apache Kafka?

Las empresas necesitan gestionar flujos de datos en tiempo real, crear aplicaciones escalables e integrar diversos sistemas, tareas en las que Kafka destaca.

¿Cuáles son las principales características de Apache Kafka?

LasLas principales características de Pache Kafka son su alto rendimiento, tolerancia a fallos, escalabilidad y capacidades de transmisión de datos en tiempo real, lo que lo hace ideal para crear sólidas canalizaciones de datos y aplicaciones distribuidas.

¿Cuáles son algunas de las funciones que utilizan Apache Kafka?

Ingeniero de datos, ingeniero de Kafka e ingeniero de software.