Programa

Toda vez que a gente clica, posta ou transmite algo, a gente cria dados que podem ser transformados em insights e previsões significativas com as ferramentas certas. Até 2028, a gente acha que vai gerar cerca de 394 zettabytes de dados por ano (fonte: Statista).

Processar esses dados em tempo real nos permite agir na hora, tipo detectar fraudes ou fazer recomendações personalizadas. É aí que entra em cenao Apache Kafka . Isso permite que as empresas atualizem suas estratégias de dados com uma arquitetura de streaming de eventos.

Este guia vai mostrar como aprender Apache Kafka do zero. Vou te ajudar a criar um plano de aprendizado, compartilhar minhas melhores dicas para aprender de forma eficaz e fornecer recursos úteis para te ajudar a encontrar funções que exigem Apache Kafka.

O que é o Apache Kafka?

Processar dados em tempo real nos dá ótimas oportunidades. Se um banco perceber uma compra estranha com o nosso cartão de crédito, eles podem parar a transação na hora. Ou, se estivermos procurando um produto, sugestões de produtos podem aparecer enquanto navegamos pelo site. Essa rapidez significa melhores decisões, clientes mais satisfeitos e um negócio mais eficiente.

O Apache Kafka é um armazenamento de dados distribuído de alto rendimento, feito pra coletar, processar, guardar e analisar dados em tempo real. Permite que diferentes aplicativos publiquem e assinem fluxos de dados, possibilitando que eles se comuniquem e reajam a eventos à medida que eles acontecem.

Por gerenciar fluxos de dados de forma eficiente, o Kafka ficou super popular. É usado em vários sistemas, desde compras online e redes sociais até bancos e saúde.

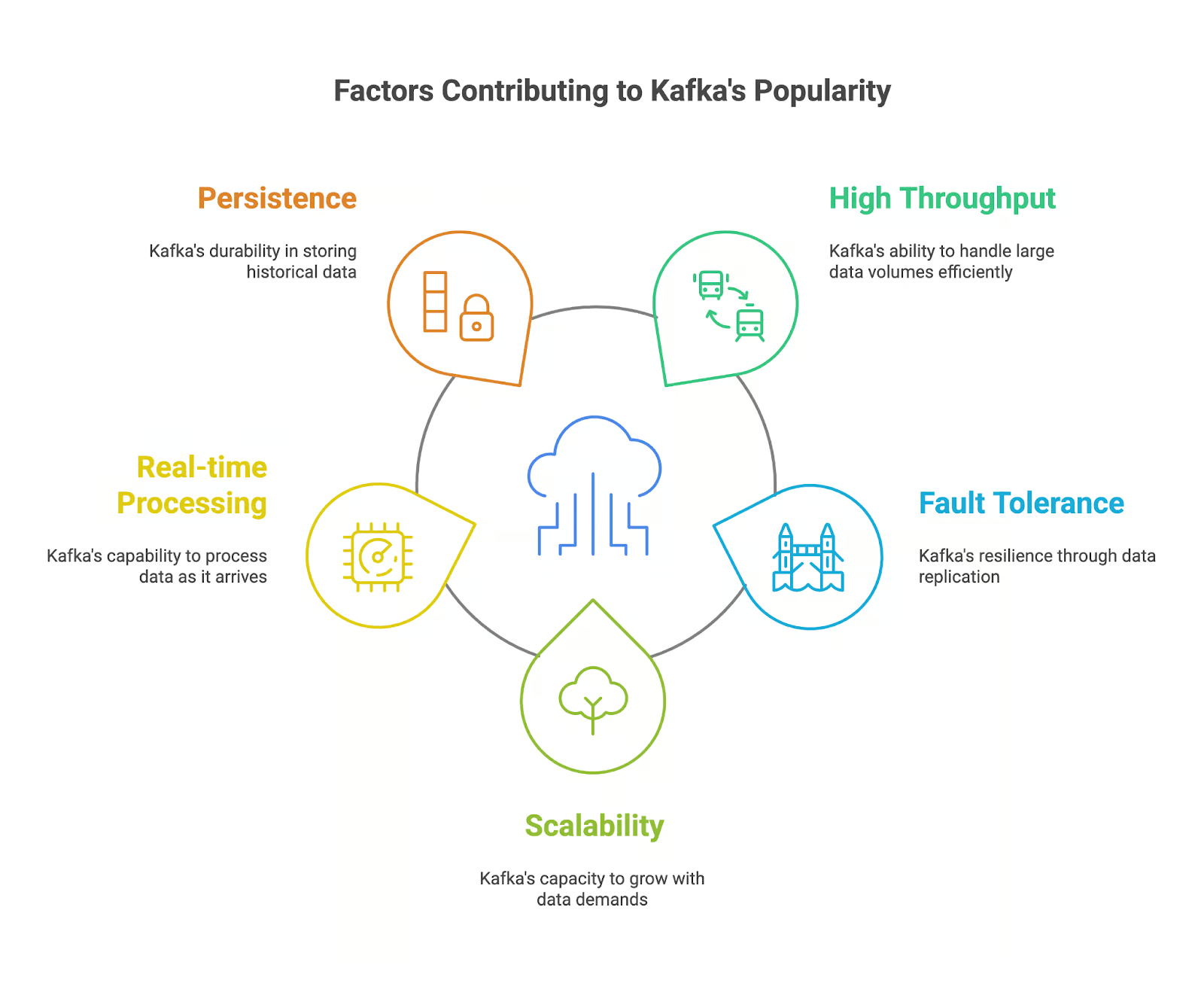

O que faz o Apache Kafka ser tão popular?

O Apache Kafka ficou bem popular entre os profissionais de dados que precisam lidar com fluxos de dados em tempo real. A gente pode explicar a popularidade dele por vários fatores importantes:

- Alto rendimento: O Kafka consegue lidar com um monte de dados com muita rapidez e eficiência, o que o torna perfeito para processar fluxos de dados em tempo real.

- Tolerância a falhas: A arquitetura distribuída do Kafka garante que nossos dados sejam replicados em vários brokers, conferindo resiliência à nossa aplicação contra falhas e garantindo a durabilidade dos dados.

- Escalabilidade: O Kafka pode facilmente se adaptar para lidar com volumes crescentes de dados e demandas dos usuários, adicionando mais brokers ao cluster.

- Processamento em tempo real: A capacidade do Kafka de lidar com fluxos de dados em tempo real permite que nossos aplicativos respondam aos eventos assim que eles acontecem, dando a gente oportunidades de tomar decisões na hora.

- Persistência: O Kafka guarda os dados de forma duradoura, permitindo que nossos aplicativos acessem dados históricos para análise e auditoria.

Principais recursos do Apache Kafka

O Apache Kafka é usado atualmente em aplicativos que precisam processar e analisar dados em tempo real. Mas quais recursos fazem dele uma ferramenta poderosa para lidar com dados de streaming? Vamos dar uma olhada neles:

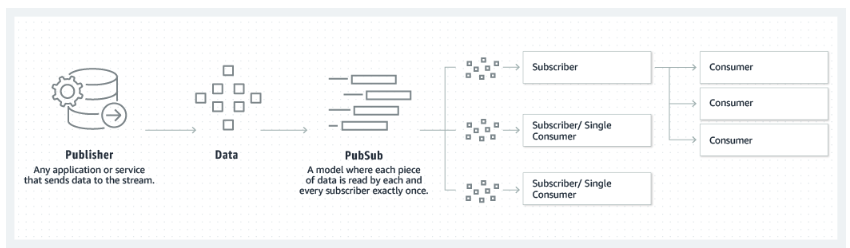

- Modelo editor-assinante: O Kafka segue um modelo editor-assinante, onde os produtores publicam dados sobre tópicos e os consumidores assinam esses tópicos para receber os dados.

- Tópicos e divisões: Os dados no Kafka são organizados em tópicos, que são divididos em partições para garantir escalabilidade e paralelismo.

- Corretores e clusters: Os corretores Kafka são os responsáveis por guardar e servir os dados. Um cluster Kafka é formado por vários brokers que trabalham juntos para oferecer tolerância a falhas e alta disponibilidade.

- Produtores e consumidores: Os produtores publicam dados nos tópicos do Kafka, enquanto os consumidores assinam os tópicos e processam os dados.

- Integração com o ZooKeeper: O Kafka usa o ZooKeeper pra cuidar dos metadados do cluster e garantir que os brokers funcionem juntos.

O modelo editor-assinante em que o Kafka se baseia. Fonte: Amazon

Por que aprender Apache Kafka é tão útil?

Aprender Apache Kafka faz de você um candidato valioso para empregadores e empresas que geram e processam dados em altas taxas. O Apache Kafka, com seus recursos poderosos e uso generalizado, virou uma ferramenta essencial pra construir arquiteturas de dados modernas e aplicativos.

Tem muita procura por gente que sabe usar o Apache Kafka.

Já falei que Kafka ficou super popular nos últimos anos. A gente acha que o Apache Kafka tá sendo usado por mais de 80% das empresas da Fortune 100.

O uso cada vez maior do Kafka em vários setores, junto com o papel dele em possibilitar soluções de dados em tempo real, faz com que as habilidades em Kafka sejam super valiosas no mercado de trabalho. De acordo com o PayScale e ZipRecruiter, em novembro de 2024, o salário médio de um engenheiro com habilidades em Kafka nos Estados Unidos era de US$ 100.000 por ano.

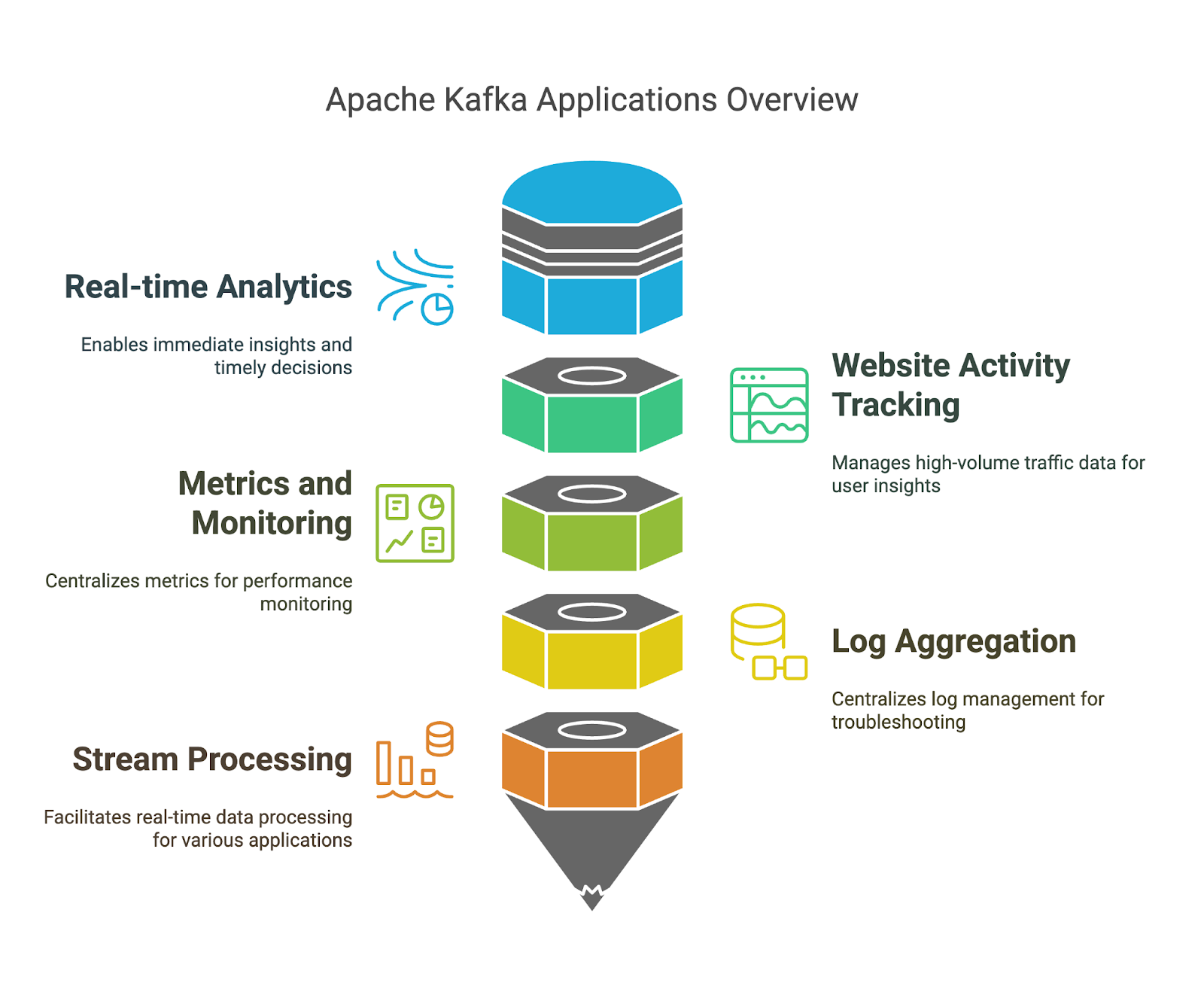

O Apache Kafka tem várias aplicações

Já falamos sobre os pontos fortes do Apache Kafka, mas vamos ver alguns exemplos específicos de onde você pode usá-los:

- Análise em tempo real: Usando o Kafka, a gente consegue fazer a ingestão e o processamento de dados em tempo real, o que ajuda a ter insights imediatos a partir dos dados transmitidos e tomar decisões na hora certa.

- Rastreamento de atividade no site: Como o Kafka consegue lidar com um monte de dados de tráfego de sites, dá pra entender o comportamento dos usuários, o desempenho do site e o conteúdo que tá bombando.

- Métricas e monitoramento: O Kafka pode coletar e processar métricas de vários sistemas e aplicativos. A gente pode aproveitar a plataforma centralizada pra monitorar o desempenho e identificar possíveis problemas.

- Agregação de registros: O Kafka pode juntar logs de várias fontes. Podemos usar o gerenciamento e a análise centralizados de registros para resolver problemas e monitorar a segurança.

- Processamento de fluxo: O Kafka Streams permite a gente criar aplicativos que processam dados em tempo real. Isso nos permite desenvolver modelos eficientes para detecção de fraudes, detecção de anomalias e recomendações em tempo real.

Como aprender Apache Kafka do zero em 2026

Se você aprender o Apache Kafka de forma organizada, vai ter mais chances de sucesso. Vamos focar em alguns princípios que você pode usar na sua jornada de aprendizado.

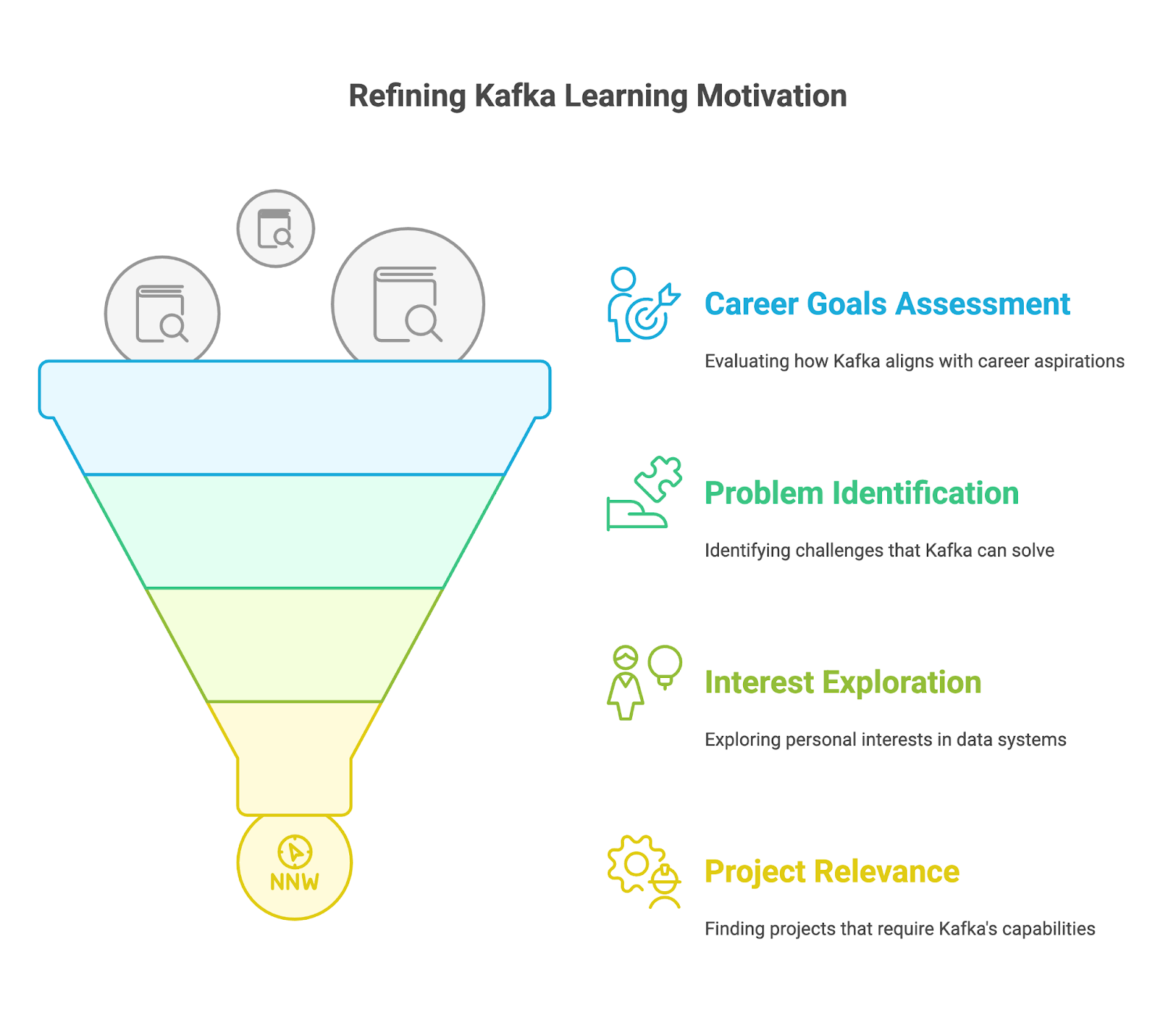

1. Entenda por que você está aprendendo Apache Kafka

Antes de aprender os detalhes técnicos, pense por que você quer aprender o Apache Kafka. Pergunte a si mesmo:

- Quais são meus objetivos profissionais?

- O Kafka é uma habilidade que você precisa para avançar no seu cargo atual ou conseguir o emprego dos seus sonhos?

- Você está pensando em mudar de carreira para engenharia de big data, desenvolvimento de aplicativos em tempo real ou streaming de dados?

- Que oportunidades você vê surgindo ao dominar o Kafka? Pense em funções específicas como Engenheiro Kafka, Arquiteto de Dados ou Engenheiro de Software com foco em sistemas em tempo real.

- Que problemas estou tentando resolver?

- Você está enfrentando desafios com os sistemas de mensagens existentes que o Kafka poderia resolver?

- Precisa criar aplicativos que possam lidar com as complexidades dos fluxos de dados em tempo real?

- Você está lidando com um monte de eventos de dispositivos IoT, feeds de redes sociais ou transações financeiras?

- Você está tendo dificuldades para integrar dados de diferentes fontes e sistemas de forma confiável e eficiente?

- O que me interessa?

- A ideia de criar sistemas distribuídos altamente escaláveis e tolerantes a falhas te anima?

- Você está interessado em processar dados em tempo real e no potencial que isso abre para empresas e aplicações?

- Tá a fim de conhecer melhor o mundo das tecnologias de big data e como o Kafka se encaixa nisso?

- Tenho algum projeto específico em mente que precise das funcionalidades do Kafka?

- Você está trabalhando em um projeto pessoal que envolve streaming de dados em tempo real, como a criação de um aplicativo de bate-papo?

- A sua empresa tem algum projeto que precisa de experiência com Kafka, tipo migrar para um novo sistema de mensagens, implementar análises em tempo real ou criar uma arquitetura de microsserviços?

2. Comece com o básico do Apache Kafka

Depois de definir seus objetivos, aprenda o básico do Kafka e entenda como ele funciona.

Instalando o Apache Kafka

Pra aprender Apache Kafka, primeiro a gente precisa instalar ele na nossa máquina local. Como o Kafka é desenvolvido usando Java, você pode usar o JDK 7 ou mais recente. Java, devemos garantir que o Java esteja instalado. Depois, a gente precisa baixar os binários do Kafka do site oficial e extraí-los.

Agora vamos iniciar o ZooKeeper, seguido pelo servidor Kafka, usando os scripts fornecidos. Por fim, podemos usar as ferramentas de linha de comando para criar tópicos e tentar produzir e consumir algumas mensagens para entender o básico. DataCamp's Apache Kafka para iniciantes pode te ajudar a se atualizar.

Entendendo o modelo editor-assinante

O primeiro conceito que devemos aprender é o modelo editor-assinante no Kafka. Essa é uma das principais razões pelas quais o Apache Kafka consegue lidar com dados de streaming de forma eficiente. Entenda como os produtores publicam mensagens e os consumidores se inscrevem nesses tópicos, recebendo só as mensagens que são relevantes para os seus interesses.

Introdução ao DataCamp Introdução ao Apache Kafka oferece uma introdução, com exercícios interativos e exemplos práticos.

Explorando os componentes do Kafka

Ao falar sobre o modelo editor-assinante, mencionamos alguns componentes importantes do Kafka: Produtor e Consumidor. Mas, a gente deveria dar uma olhada em todos os componentes principais. A gente precisa aprender como o Kafka organiza os dados em tópicos e partições, e entender como as partições ajudam na escalabilidade e na tolerância a falhas.

Também devemos entender como os brokers formam um cluster para oferecer alta disponibilidade e tolerância a falhas.

Dá uma olhada no DataCamp's Introdução ao Apache Kafka e o artigo artigo Apache Kafka para iniciantes para entender melhor esses assuntos.

3. Domine as habilidades intermediárias do Apache Kafka

Quando você estiver confortável com o básico, é hora de explorar as habilidades intermediárias do Apache Kafka.

Kafka Connect para integração de dados

Uma das principais características do Apache Kafka é a capacidade de lidar com grandes volumes de dados em streaming. O Kafka Connect é um componente gratuito e de código aberto do Apache Kafka que simplifica a integração de dados entre sistemas de arquivos, bancos de dados, índices de pesquisa e armazenamentos de chave-valor.

Aprender a usar o Connect pode nos ajudar a desbloquear um fluxo de dados eficiente para análises, integração de aplicativos e construção de uma arquitetura de dados robusta e escalável. Dá uma olhada no nosso artigo Apache Kafka para iniciantes para mais detalhes.

Kafka Streams para processamento de fluxos

Outro recurso avançado do Kafka é o Streams. A gente precisa aprender a criar aplicativos de processamento de fluxo direto no Kafka com a ajuda do Streams. Ele oferece APIs e uma linguagem específica de domínio de alto nível para lidar, converter e avaliar fluxos contínuos de dados. Saiba mais sobre Artigo Apache Kafka para iniciantes.

Monitorando e gerenciando o Kafka

Como com qualquer outra tecnologia, é sempre bom programar o desempenho dela. Pra isso, a gente precisa aprender a monitorar a saúde e o desempenho do nosso cluster Kafka. Podemos explorar ferramentas e técnicas para monitorar métricas importantes, gerenciar tópicos e partições e garantir um desempenho ideal.

4. Aprenda Apache Kafka na prática

Fazer cursos sobre o Apache Kafka é uma ótima maneira de se familiarizar com a tecnologia. Mas, pra ficar craque no Kafka, você precisa resolver problemas desafiadores e que desenvolvam suas habilidades, tipo aqueles que você vai encontrar em projetos reais.

Você pode começar experimentando tarefas simples de streaming de dados, como produzir e consumir mensagens, e depois aumentar gradualmente a complexidade explorando tópicos como particionamento, tolerância a falhas e integração com sistemas externos usando o Kafka Connect.

Aqui estão algumas maneiras de praticar suas habilidades:

- Configure um cluster Kafka local: Instale o Kafka na sua máquina local e experimente produzir e consumir mensagens. Use um provedor de nuvem como Confluent Cloud, AWS MSK ou Azure HDInsight Kafka para experimentar um ambiente Kafka gerenciado. Isso é ótimo pra aprender sobre escalabilidade e aspectos operacionais.

- Participe de webinars e sessões de programação em grupo. Confira os os próximos webinars do DataCamp ou webinars da Confluent onde você pode acompanhar os tutoriais do Apache Kafka e exemplos de código. Isso vai te ajudar a entender melhor os conceitos e se familiarizar com os padrões de codificação.

- Contribua com projetos de código aberto. Contribua com projetos do Apache Kafka em plataformas como o GitHub pra ganhar experiência colaborando com outras pessoas e trabalhando em projetos reais. O Apache Kafka oferece essas oportunidades.

5. Crie um portfólio de projetos

Você vai fazer vários projetos diferentes enquanto avança na sua jornada de aprendizado do Apache Kafka. Para mostrar suas habilidades e experiência com o Apache Kafka para possíveis empregadores, você deve juntar tudo em um portfólio. Esse portfólio deve mostrar suas habilidades e interesses e ser feito sob medida para a carreira ou setor que você curte.

Tente fazer projetos originais e mostrar suas habilidades pra resolver problemas. Inclua projetos que mostrem sua habilidade em diferentes partes do Kafka, tipo criar pipelines de dados com o Kafka Connect, desenvolver aplicativos de streaming com o Kafka Streams ou trabalhar com clusters do Kafka. Documente seus projetos com cuidado, colocando o contexto, a metodologia, o código e os resultados. Você pode usar plataformas como o GitHub para hospedar seu código e o Confluent Cloud para um ambiente Kafka gerenciado.

6. Continue se desafiando

Aprender Kafka é uma jornada contínua. A tecnologia está sempre mudando, e novos recursos e aplicativos são criados o tempo todo. Kafka não é exceção a isso.

Depois de dominar os fundamentos, você pode procurar tarefas e projetos mais desafiadores, como ajuste de desempenho para sistemas de alto rendimento e implementação de processamento avançado de fluxo com Kafka Streams. Concentre-se em seus objetivos e especialize-se em áreas que sejam relevantes para suas metas profissionais e interesses.

Fique por dentro das novidades, tipo novos recursos ou propostas do KIP, e aprenda como usar isso nos seus projetos. Continue praticando, procure novos desafios e oportunidades e aceite a ideia de cometer erros como uma forma de aprender.

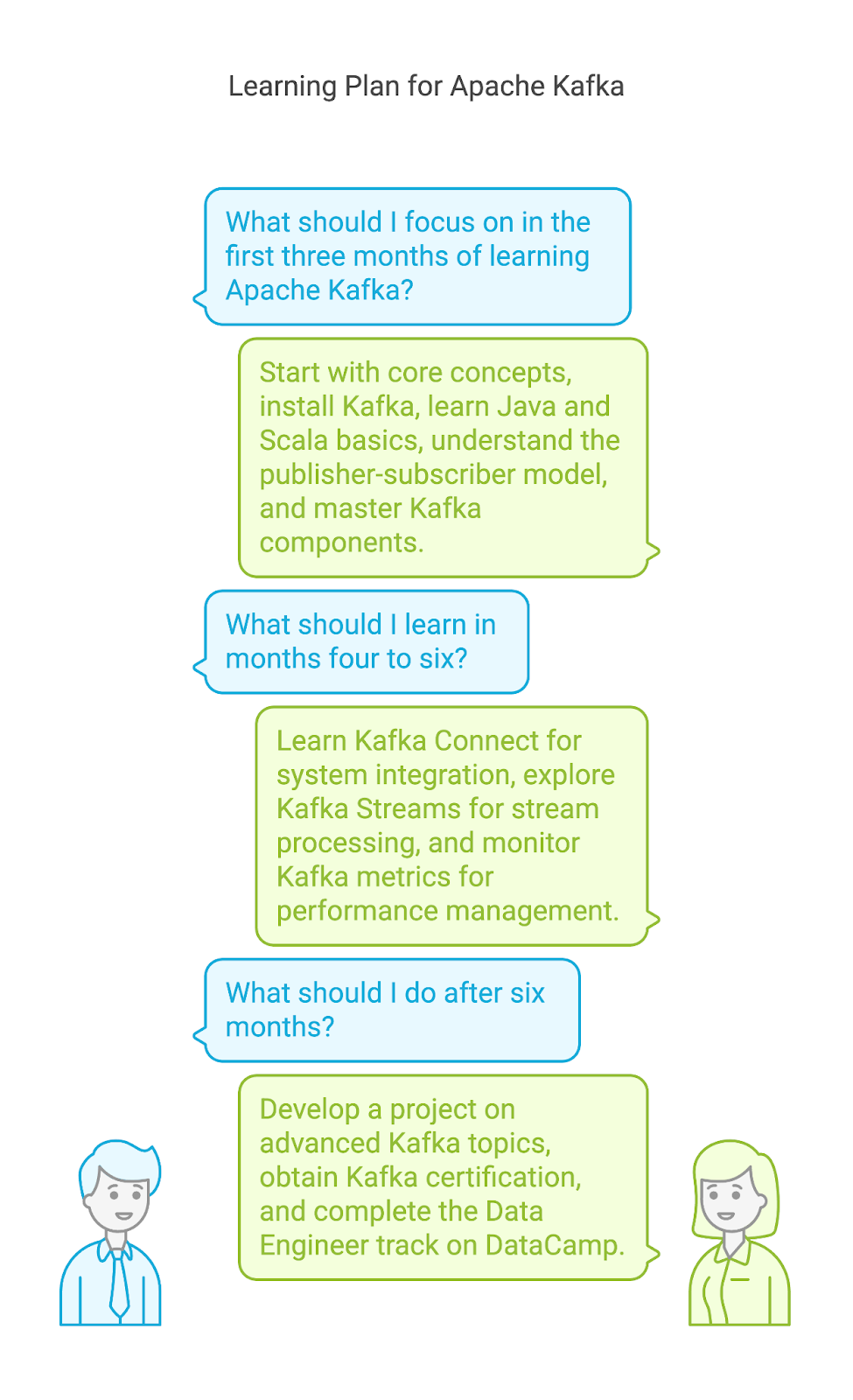

Um exemplo de plano de aprendizagem do Apache Kafka

Mesmo que cada pessoa tenha sua maneira de aprender, é sempre uma boa ideia ter um plano ou guia para seguir ao aprender uma nova ferramenta. Criei um plano de aprendizagem potencial que mostra onde você deve focar seu tempo e esforços se estiver começando com o Apache Kafka.

Plano de aprendizagem para os meses 1 a 3

- Conceitos fundamentais. Instale o Apache Kafka e inicie o ZooKeeper e o servidor Kafka. Entenda como usar as ferramentas de linha de comando para criar tópicos.

- Java e Scala. Como o Kafka é desenvolvido nessas linguagens de programação, você também pode aprender o básico de Java e Scala.

- Modelo editor-assinante. Entenda o sistema central por trás do Kafka, o modelo editor-assinante. Descubra como as mensagens são produzidas e consumidas de forma assíncrona. Conclua o curso curso Introdução ao Apache Kafka.

- Componentes Kafka: Domine os conceitos e elementos principais do Kafka, incluindo os tópicos e partições, brokers e clusters, produtores e consumidores. Entenda suas funções e como elas interagem para garantir tolerância a falhas e escalabilidade. Dá uma olhada em ferramentas como o Kafka Manager pra visualizar e monitorar seu cluster Kafka.

Plano de aprendizagem para os meses 4 a 6

- Kafka Connect. Aprenda a conectar o Kafka com vários sistemas, como bancos de dados (MySQL, PostgreSQL), serviços em nuvem (AWS S3, Azure Blob Storage) e outros sistemas de mensagens (JMS, RabbitMQ) usando o Kafka Connect. Dá uma olhada nos diferentes tipos de conectores (fonte e coletor) e opções de configuração.

- Kafka Streams. Explore conceitos como operações com estado, janelas e dualidade entre fluxo e tabela. Aprenda a escrever, testar e implantar aplicativos de processamento de fluxo dentro da sua infraestrutura Kafka.

- Monitorando e gerenciando o Kafka. Aprenda a monitorar métricas importantes do Kafka, como throughput, latência e atraso do consumidor, usando ferramentas como Burrow e Kafka Manager. Entenda como identificar e resolver problemas de desempenho e garantir a integridade do seu cluster Kafka.

A partir do sétimo mês

- Desenvolva um projeto. Mergulhe em tópicos avançados do Kafka, como segurança, ajuste de desempenho e técnicas avançadas de processamento de fluxo. Contribua com a comunidade Kafka e crie projetos reais.

- Obtenha a certificação Kafka. Prepare-se e obtenha uma certificação Kafka, como a Confluent Certified Developer for Apache Kafka. Dá uma olhada nisso guia de certificação Kafka.

- Engenheiro de Dados com programa Python Track. Conclua a curso de Engenharia de Dados no DataCamp, que abrange habilidades essenciais de engenharia de dados, como manipulação de dados, SQL, computação em nuvem e pipelines de dados.

Seis dicas para aprender Apache Kafka

Imagino que, a essa altura, você já esteja pronto para começar a aprender Kafka e colocar as mãos em um grande conjunto de dados para praticar sua nova habilidade. Mas antes disso, deixa eu te dar umas dicas que vão te ajudar a chegar lá e dominar o Apache Kafka.

1. Limite o seu escopo

O Kafka é uma ferramenta versátil que pode ser usada de várias maneiras. Você deve identificar seus objetivos e interesses específicos dentro do ecossistema Kafka. Qual aspecto de Kafka mais te atrai? Você curte engenharia de dados, processamento de fluxo ou administração do Kafka? Uma abordagem focada pode te ajudar a aprender os aspectos e conhecimentos mais relevantes do Apache Kafka para atender aos seus interesses.

2. Pratique com frequência e constantemente.

A consistência é fundamental para dominar qualquer nova habilidade. Você deve reservar um tempo só para praticar Kafka. Basta dedicar um tempinho todos os dias. Você não precisa lidar com conceitos complexos todos os dias. Você pode fazer exercícios práticos, seguir tutoriais e experimentar diferentes recursos do Kafka. Quanto mais você praticar, mais à vontade ficará com a plataforma.

3. Trabalhe em projetos reais

Essa é uma das dicas mais importantes, e você vai ver isso várias vezes neste guia. Fazer exercícios é ótimo pra ganhar confiança. Mas, usar suas habilidades em Kafka em projetos reais é o que vai fazer você se destacar nisso.

Comece com projetos e questões simples e, aos poucos, vá encarando os mais complexos. Isso pode envolver a criação de um aplicativo simples de produtor-consumidor, depois avançar para a construção de um pipeline de dados em tempo real com o Kafka Connect, ou até mesmo projetar um aplicativo de streaming tolerante a falhas com o Kafka Streams. O segredo é continuar se desafiando e expandindo suas habilidades práticas com o Kafka.

4. Participe de uma comunidade

Aprender costuma ser mais eficaz quando feito em grupo. Compartilhar suas experiências e aprender com os outros pode acelerar seu progresso e trazer insights valiosos.

Pra trocar conhecimento, ideias e perguntas, você pode entrar em alguns grupos relacionados ao Apache Kafka e participar de encontros e conferências. Você pode entrar em comunidades online como o canal Confluent Slack ou Fórum Confluent, onde você pode interagir com outros entusiastas do Kafka. Você também pode participar de encontros virtuais ou presenciais encontros, com palestras de especialistas em Kafka, ou conferências, como a ApacheCon.

5. Cometer erros

Como com qualquer outra tecnologia, aprender Apache Kafka é um processo que vai rolando. Aprender com seus erros é uma parte essencial desse processo. Não tenha medo de experimentar, tente diferentes abordagens e aprenda com seus erros.

Experimente diferentes configurações para seus produtores e consumidores Kafka, explore vários métodos de serialização de dados (JSON, Avro, Protobuf) e teste diferentes estratégias de particionamento. Leve seu cluster Kafka ao limite com grandes volumes de mensagens e veja como ele lida com a carga. Analise o atraso do consumidor, ajuste as configurações e entenda como suas otimizações afetam o desempenho.

6. Não se apresse

Dá uma olhada com calma pra entender de verdade conceitos importantes como tópicos, partições, grupos de consumidores e o papel do ZooKeeper. Se você construir agora uma base sólida, vai ser mais fácil entender assuntos mais avançados e resolver problemas de forma eficaz. Divida o processo de aprendizagem em etapas menores e dê a si mesmo tempo para entender as informações. Uma abordagem lenta e constante geralmente leva a uma compreensão mais profunda e ao domínio.

As melhores maneiras de aprender Apache Kafka

Vamos ver alguns métodos eficientes para aprender Apache Kafka.

Faça cursos online

Os cursos online são uma ótima maneira de aprender Apache Kafka no seu ritmo. DataCamp oferece um curso intermediário sobre Kafka. Este curso aborda os conceitos básicos do Kafka, incluindo o modelo editor-assinante, tópicos e partições, corretores e clusters, produtores e consumidores.

Siga os tutoriais online

Os tutoriais são outra ótima maneira de aprender Apache Kafka, principalmente se você é novo nessa tecnologia. Eles têm instruções passo a passo sobre como fazer tarefas específicas ou entender certos conceitos. Pra começar, dá uma olhada nesses tutoriais:

Ler blogs

Para entender melhor as vantagens do Apache Kafka, você também precisa saber quais são as principais semelhanças e diferenças com outras tecnologias. Você pode ler artigos sobre como o Kafka se compara a outras ferramentas, como os seguintes:

Descubra o Apache Kafka através de livros

Os livros são um ótimo jeito de aprender sobre o Apache Kafka. Eles oferecem conhecimento aprofundado e insights de especialistas, além de trechos de código e explicações. Aqui estão alguns dos livros mais populares sobre Kafka:

As diferentes carreiras no Apache Kafka hoje

Como o Apache Kafka tá cada vez mais popular, as oportunidades de carreira pra quem sabe usar o Kafka também aumentam, desde engenheiros especializados em Kafka até engenheiros de software. Se você está avaliando suas habilidades em Kafka, considere estas funções:

Engenheiro Kafka

Como engenheiro Kafka, você é responsável por projetar, construir e manter soluções de streaming de dados baseadas em Kafka com alta disponibilidade e escalabilidade. Você vai precisar garantir um fluxo de dados confiável e eficiente dentro da empresa, além de monitorar e otimizar o desempenho do Kafka para garantir um rendimento e uma latência ideais.

- Competências essenciais:

- Conhecimento sólido da arquitetura e dos componentes do Kafka.

- Proficiência em administração e configuração do Kafka.

- Experiência com pipelines de dados e processos ETL.

- Conhecimento dos conceitos de processamento de fluxos e Kafka Streams.

- Principais ferramentas utilizadas:

- Apache Kafka

- Kafka Connect

- Kafka Streams

- ZooKeeper

- Ferramentas de monitoramento

Engenheiro de dados

Como engenheiro de dados, você é o arquiteto da infraestrutura de dados, responsável por projetar e construir os sistemas que lidam com os dados de uma empresa. O Kafka costuma ter um papel importante nesses pipelines de dados, permitindo um fluxo de dados em tempo real eficiente e escalável entre diferentes sistemas. Você vai precisar garantir que o Kafka se integre perfeitamente com outros componentes.

- Competências essenciais:

- Boa compreensão dos conceitos de warehouse e modelagem de dados.

- Proficiência em ferramentas de processamento de dados como Spark e Hadoop.

- Experiência com nuvem como AWS, Azure ou GCP.

- Conhecimento do Kafka para streaming de dados em tempo real.

- Principais ferramentas utilizadas:

- Apache Kafka

- Apache Spark

- Hadoop

- Colmeia

- Nuvem (AWS, Azure, GCP)

Engenheiro de software

Como engenheiro de software, você vai usar o Kafka para criar aplicativos em tempo real, como plataformas de bate-papo e jogos online. Você vai precisar integrá-lo ao código do aplicativo para garantir um fluxo de dados tranquilo, conectando-se a vários sistemas de mensagens e APIs. Você também vai otimizar esses aplicativos para escalabilidade e desempenho, permitindo que eles lidem com grandes quantidades de dados em tempo real.

- Competências essenciais:

- Ótimas habilidades de programação em linguagens como Java, Python ou Scala.

- Entendendo o modelo editor-assinante e a API do Kafka.

- Experiência com a construção de sistemas e aplicativos distribuídos.

- Conhecimento das melhores práticas de engenharia de software.

- Principais ferramentas utilizadas:

- Apache Kafka

- Linguagens de programação (Java, Python, Scala)

- Sistemas de mensagens (por exemplo, RabbitMQ, ActiveMQ)

- Ferramentas e estruturas de desenvolvimento

|

Função |

O que você faz |

Suas principais habilidades |

Ferramentas que você usa |

|

Engenheiro Kafka |

Projete e implemente clusters Kafka para alta disponibilidade e escalabilidade. |

Arquitetura Kafka, componentes, administração e configuração, conceitos de processamento de fluxo. |

Apache Kafka, Kafka Connect, Kafka Streams, ZooKeeper |

|

Engenheiro de Dados |

Projetar e implementar warehouses e lagos de dados, integrar o Kafka com outros sistemas de processamento e armazenamento de dados |

Proficiência em ferramentas de processamento de dados, experiência com plataformas em nuvem e conhecimento de Kafka. |

Apache Kafka, Apache Spark, Hadoop, Colmeia, Plataformas em nuvem |

|

Engenheiro de Software |

Crie e desenvolva aplicativos que usam o Kafka para comunicação de dados em tempo real. |

Conhecimentos de programação, sistemas e aplicações distribuídos, conhecimento sobre o editor-assinante Kafka. |

Apache Kafka, Java, Python, Scala, RabbitMQ, ActiveMQ, Ferramentas e estruturas de desenvolvimento. |

Como encontrar um emprego que use o Apache Kafka

Embora ter um diploma possa ser muito valioso quando se busca uma carreira em uma função relacionada a dados que usa o Apache Kafka, esse não é o único caminho para o sucesso. Cada vez mais pessoas de diferentes origens e experiências estão começando a trabalhar em funções relacionadas a dados. Com dedicação, aprendizado constante e uma abordagem proativa, você pode conseguir o emprego dos seus sonhos usando o Apache Kafka.

Continue aprendendo sobre Kafka

Fique por dentro das últimas novidades sobre o Kafka. Siga profissionais influentes que estão envolvidos com o Apache Kafka nas redes sociais, leia blogs relacionados ao Apache Kafka e ouça podcasts relacionados ao Kafka.

Interaja com pessoas influentes, como Neha Narkhede, que ajudou a criar o Kafka e também é CTO da Confluent. Você vai ficar por dentro dos assuntos do momento, tecnologias novas e o que vem por aí no Apache Kafka. Você também também ler o blog da Confluent, que oferece artigos detalhados e tutoriais sobre uma ampla variedade de tópicos do Kafka, desde arquitetura e administração até casos de uso e melhores práticas.

Você também deve conferir eventos do setor, como webinars em Confluent ou o Kafka Summit.

Crie um portfólio

Você precisa se destacar dos outros candidatos. Uma boa maneira de fazer isso é montar um portfólio bacana que mostre suas habilidades e os projetos que você já fez.

Seu portfólio deve ter projetos que mostrem como você é bom em criar pipelines de dados, implementar aplicativos de processamento de fluxo e integrar o Kafka com outros sistemas.

Crie um currículo que chame a atenção

Os gerentes de contratação precisam analisar centenas de currículos e escolher os melhores candidatos. Além disso, muitas vezes, seu currículo passa por Sistemas de Rastreamento de Candidatos (ATS), que são softwares automáticos que várias empresas usam pra analisar currículos e descartar aqueles que não atendem a critérios específicos. Então, você deve fazer um currículo incrível e escrever uma carta de apresentação impressionante pra impressionar tanto o ATS quanto os recrutadores.

Chame a atenção de um gerente de contratação

Se você chamar a atenção do gerente de contratação ou se o seu currículo for aprovado no processo de seleção, você deve se preparar para uma entrevista técnica. Para se preparar, dá uma olhada nesse artigo sobre 20 perguntas de entrevista sobre Kafka para engenheiros de dados.

Conclusão

Aprender Apache Kafka pode abrir portas para melhores oportunidades e resultados profissionais. O caminho para aprender Kafka é gratificante, mas precisa de consistência e prática. Experimentar e resolver desafios usando essa ferramenta pode acelerar seu processo de aprendizagem e te dar exemplos reais para mostrar suas habilidades práticas quando estiver procurando emprego.

Perguntas frequentes

Por que a procura por habilidades em Apache Kafka está aumentando?

As empresas precisam lidar com fluxos de dados em tempo real, criar aplicativos escaláveis e integrar diversos sistemas, e o Kafka é ótimo nisso tudo.

Quais são as principais características do Apache Kafka?

As principais características do Apache Kafka são alto rendimento, tolerância a falhas, escalabilidade e recprincipais recursos do Apache Kafka são alto rendimento, tolerância a falhas, escalabilidade e recursos de streaming de dados em tempo real, tornando-o ideal para a construção de pipelines de dados robustos e aplicativos distribuídos.

Quais são algumas das funções que usam o Apache Kafka?

Engenheiro de dados, engenheiro Kafka e engenheiro de software.