Lernpfad

Jedes Mal, wenn wir klicken, etwas posten oder streamen, machen wir Daten, die mit den richtigen Tools zu nützlichen Erkenntnissen und Vorhersagen verarbeitet werden können. Bis 2028 werden wir voraussichtlich etwa 394 Zettabyte an Daten pro Jahr erzeugen (Quelle: Statista).

Die Möglichkeit, diese Daten in Echtzeit zu verarbeiten, lässt uns sofort handeln, zum Beispiel Betrug erkennen oder personalisierte Empfehlungen aussprechen. Hier kommt„ “ Apache Kafka ins Spiel. Es hilft Unternehmen dabei, ihre Datenstrategien mit einer Event-Streaming-Architektur auf den neuesten Stand zu bringen.

In diesem Leitfaden geht's darum, wie du Apache Kafka von Grund auf lernen kannst. Ich helfe dir dabei, einen Lernplan zu erstellen, gebe dir meine besten Tipps für effektives Lernen und stelle dir nützliche Ressourcen zur Verfügung, mit denen du Stellen finden kannst, für die Apache Kafka erforderlich ist.

Was ist Apache Kafka?

Daten in Echtzeit zu verarbeiten, gibt uns echt tolle Möglichkeiten. Wenn eine Bank einen komischen Kauf mit unserer Kreditkarte merkt, kann sie die Transaktionsofort stoppen . Oder wenn wir nach einem Produkt suchen, können beim Surfen auf der Website Produktvorschläge eingeblendet werden. Diese Geschwindigkeit sorgt für bessere Entscheidungen, zufriedenere Kunden und ein effizienteres Geschäft.

Apache Kafka ist ein verteilter Datenspeicher mit hohem Durchsatz, der für das Sammeln, Verarbeiten, Speichern und Analysieren von Streaming-Daten in Echtzeit optimiert ist. Es lässt verschiedene Anwendungen Datenströme veröffentlichen und abonnieren, sodass sie miteinander reden und auf Ereignisse reagieren können, sobald sie passieren.

Weil Kafka Datenströme so gut im Griff hat, ist es echt beliebt geworden. Es wird in verschiedenen Systemen genutzt, vom Online-Shopping und sozialen Medien bis hin zum Bankwesen und Gesundheitswesen.

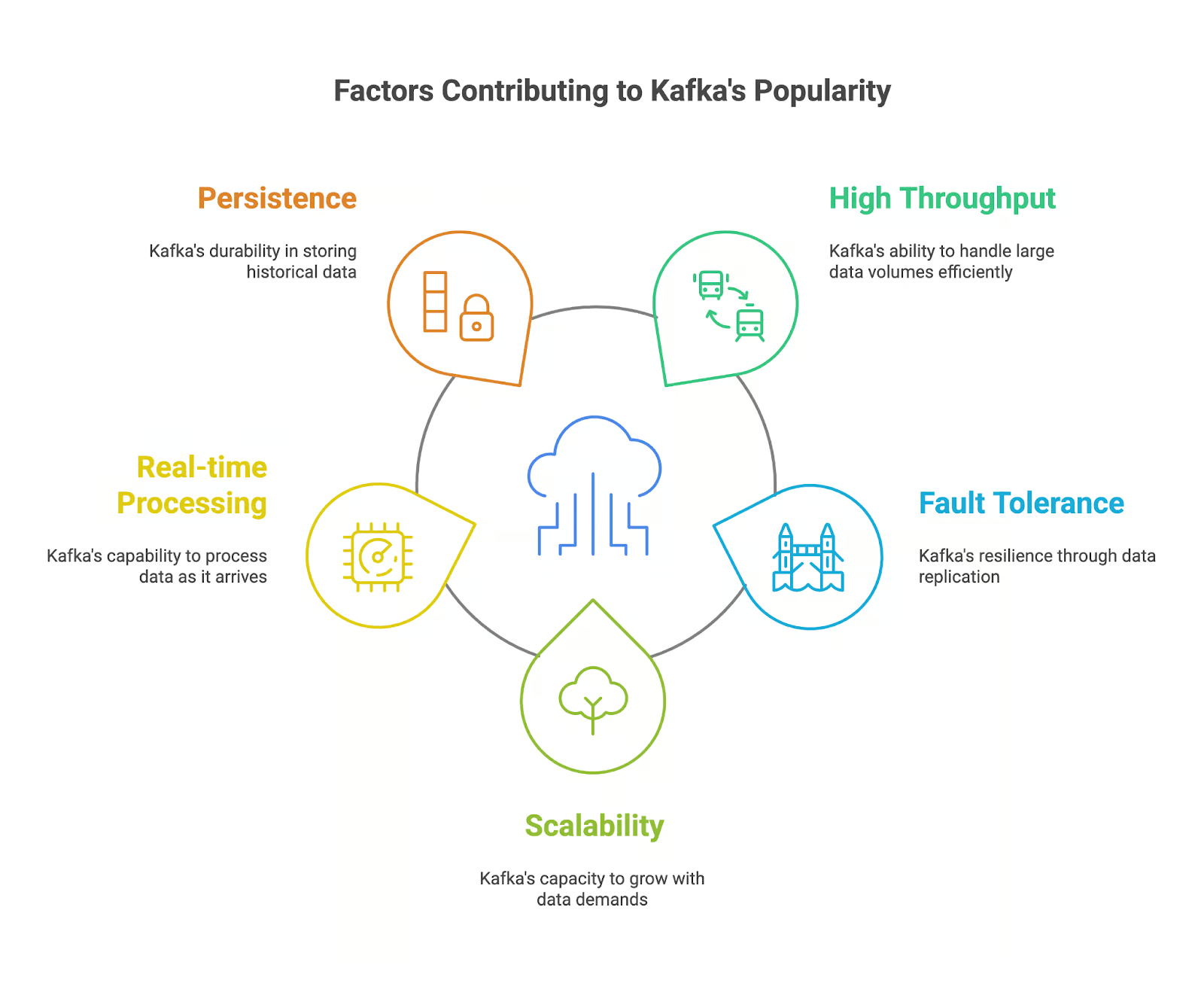

Was macht Apache Kafka so beliebt?

Apache Kafka ist bei Leuten, die mit Daten arbeiten und mit Echtzeit-Datenströmen zu kämpfen haben, echt beliebt geworden. Wir können seine Beliebtheit mit ein paar wichtigen Sachen erklären:

- Hoher Durchsatz: Kafka kann riesige Datenmengen super schnell und effizient verarbeiten und ist damit perfekt für die Echtzeitverarbeitung von Datenströmen.

- Fehlertoleranz: Die verteilte Architektur von Kafka sorgt dafür, dass unsere Daten auf mehrere Broker verteilt werden, was unsere Anwendung widerstandsfähig gegen Ausfälle macht und die Datenbeständigkeit sicherstellt.

- Skalierbarkeit: Kafka kann ganz einfach skaliert werden, um mit wachsenden Datenmengen und Nutzeranforderungen klarzukommen, indem man dem Cluster einfach mehr Broker hinzufügt.

- Echtzeitverarbeitung: Kafkas Fähigkeit, Echtzeit-Datenströme zu verarbeiten, lässt unsere Anwendungen sofort auf Ereignisse reagieren, sodass wir Entscheidungen in Echtzeit treffen können.

- Beharrlichkeit: Kafka speichert Daten dauerhaft, sodass unsere Apps auf alte Daten zugreifen können, um sie zu analysieren und zu prüfen.

Die wichtigsten Features von Apache Kafka

Apache Kafka wird gerade in Anwendungen genutzt, die Daten in Echtzeit verarbeiten und analysieren müssen. Aber welche Funktionen machen es zu einem starken Tool für den Umgang mit Streaming-Daten? Schauen wir sie uns mal an:

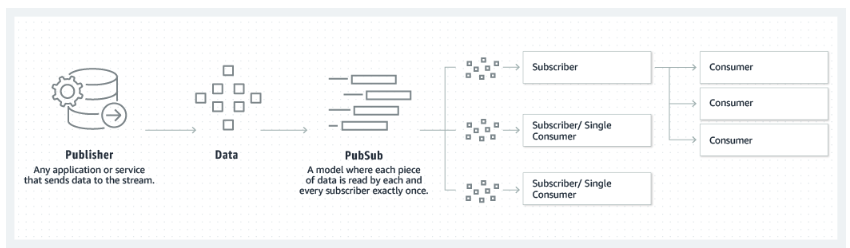

- Publisher-Subscriber-Modell: Kafka nutzt ein Publisher-Subscriber-Modell, bei dem Produzenten Daten zu Themen veröffentlichen und Konsumenten diese Themen abonnieren, um die Daten zu bekommen.

- Themen und Unterteilungen: Die Daten in Kafka sind in Themen organisiert, die für Skalierbarkeit und Parallelität in Partitionen unterteilt sind.

- Makler und Cluster: Kafka-Broker kümmern sich um das Speichern und Bereitstellen von Daten. Ein Kafka-Cluster besteht aus mehreren Brokern, die zusammenarbeiten, um Fehlertoleranz und hohe Verfügbarkeit zu gewährleisten.

- Produzenten und Verbraucher: Produzenten veröffentlichen Daten in Kafka-Themen, während Konsumenten Themen abonnieren und die Daten verarbeiten.

- ZooKeeper-Integration: Kafka nutzt ZooKeeper, um Cluster-Metadaten zu verwalten und die Koordination der Broker sicherzustellen.

Das Publisher-Subscriber-Modell, auf das Kafka setzt. Quelle: Amazon

Warum ist es so nützlich, Apache Kafka zu lernen?

Wenn du Apache Kafka lernst, wirst du zu einem super Kandidaten für Arbeitgeber und Firmen, die viele Daten erzeugen und verarbeiten. Apache Kafka ist mit seinen coolen Funktionen und seiner weit verbreiteten Nutzung zu einem wichtigen Tool für den Aufbau moderne Datenarchitekturen und Anwendungen.

Es gibt eine Nachfrage nach Fähigkeiten in Apache Kafka.

Ich hab schon mal gesagt, dass Kafka in den letzten Jahren echt beliebt geworden ist. Es wird geschätzt, dass Apache Kafka derzeit von über 80 % der Fortune-100-Unternehmen Unternehmen

Kafka wird in vielen Branchen immer beliebter und ist super wichtig für Echtzeit-Datenlösungen. Deshalb sind Leute, die sich mit Kafka auskennen, auf dem Arbeitsmarkt echt gefragt. Laut PayScale und ZipRecruiterbeträgt das durchschnittliche Jahresgehalt eines Ingenieurs mit Kafka-Kenntnissen in den USA im November 2024 100.000 US-Dollar.

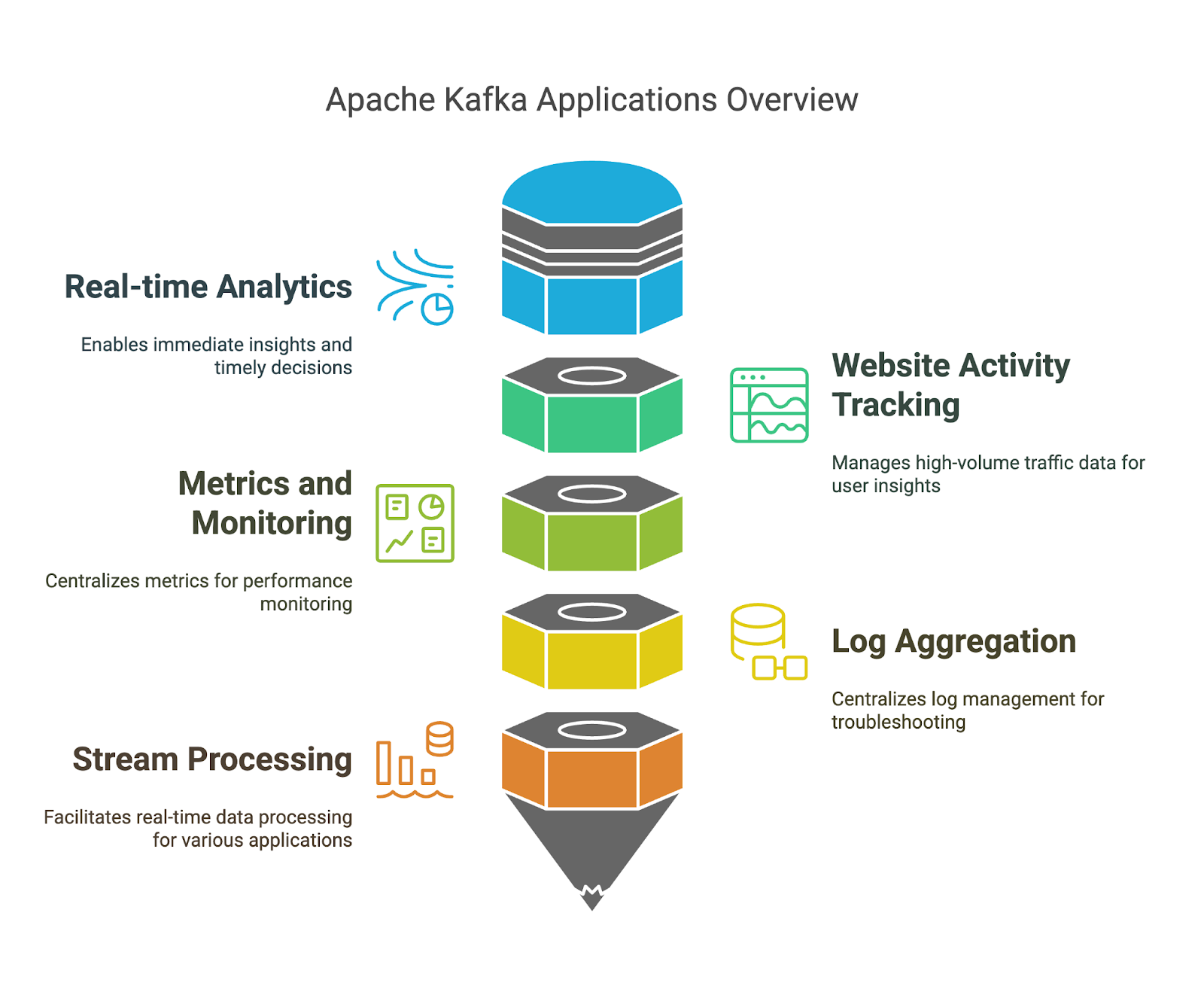

Apache Kafka hat viele verschiedene Anwendungsmöglichkeiten.

Wir haben schon die Vorteile von Apache Kafka angesprochen, aber schauen wir uns mal ein paar konkrete Beispiele an, wo du sie nutzen kannst:

- Echtzeit-Analysen: Mit Kafka können wir Daten in Echtzeit erfassen und verarbeiten, was uns hilft, sofortige Erkenntnisse aus Streaming-Daten zu gewinnen und zeitnahe Entscheidungen zu treffen.

- Verfolgung der Website-Aktivitäten: Da Kafka große Mengen an Website-Traffic-Daten verarbeiten kann, können wir das Nutzerverhalten, die Website-Performance und beliebte Inhalte besser verstehen.

- Metriken und Überwachung: Kafka kann Metriken aus verschiedenen Systemen und Anwendungen sammeln und verarbeiten. Wir können die Vorteile der zentralen Plattform nutzen, um die Leistung zu überwachen und mögliche Probleme zu erkennen.

- Protokollaggregation: Kafka kann Protokolle aus verschiedenen Quellen zusammenfassen. Wir können die zentralisierte Protokollverwaltung und -analyse für die Fehlerbehebung und Sicherheitsüberwachung nutzen.

- Stream-Verarbeitung: Mit Kafka Streams können wir Apps entwickeln, die Daten in Echtzeit verarbeiten. So können wir coole Modelle für Betrugserkennung, Anomalieerkennung und Echtzeitempfehlungen entwickeln.

Wie man Apache Kafka von Grund auf neu lernt im Jahr 2026

Wenn du Apache Kafka systematisch lernst, hast du bessere Chancen auf Erfolg. Schauen wir uns ein paar Prinzipien an, die du auf deinem Lernweg nutzen kannst.

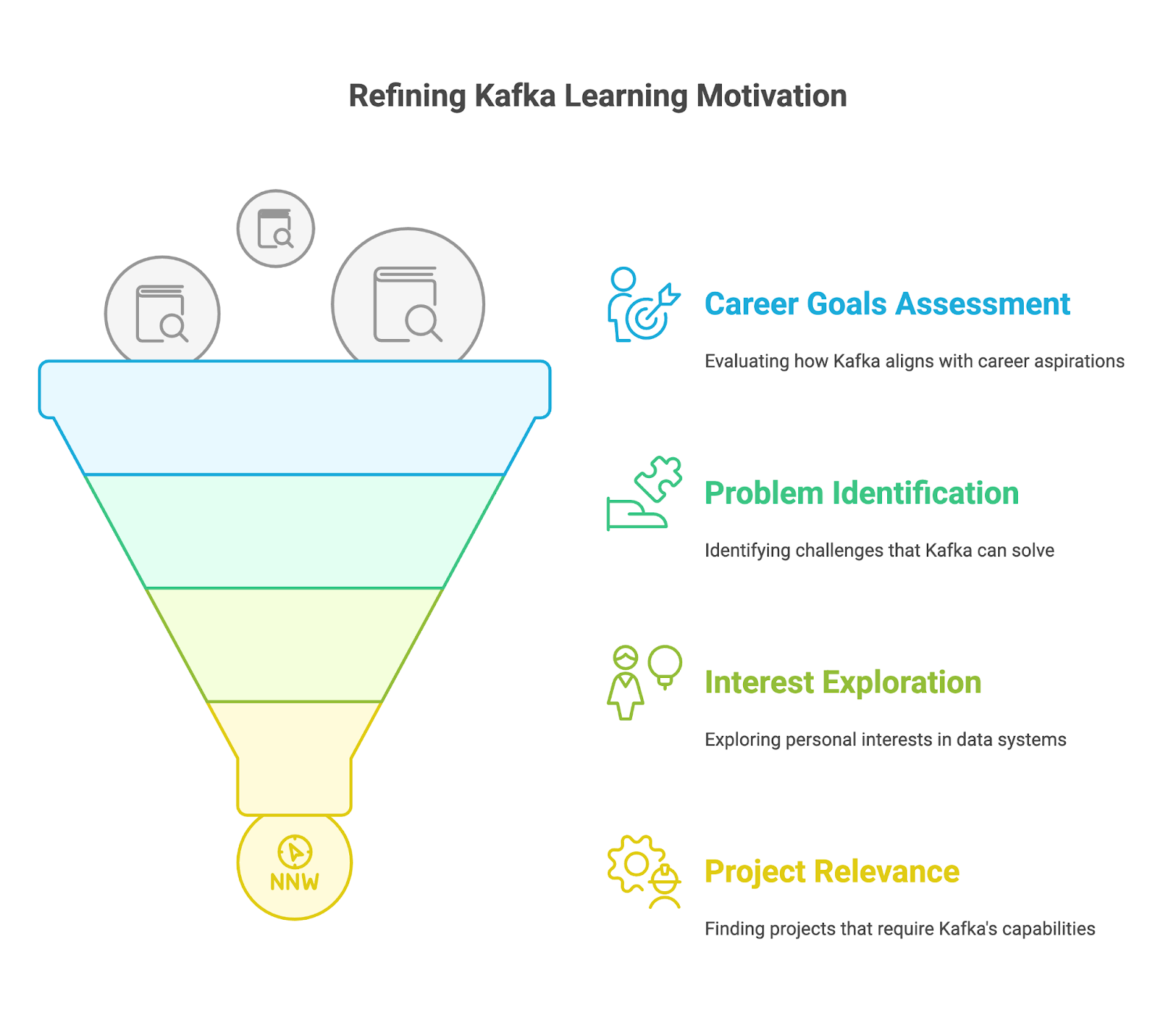

1. Versteh, warum du Apache Kafka lernst

Bevor du dich mit den technischen Details beschäftigst, überleg dir, warum du Apache Kafka lernen willst. Frag dich mal:

- Was sind meine Karriereziele?

- Brauchst du Kafka, um in deinem jetzigen Job weiterzukommen oder deinen Traumjob zu kriegen?

- Willst du in die Bereiche Big-Data-Engineering, Echtzeit-Anwendungsentwicklung oder Daten-Streaming wechseln?

- Welche Chancen siehst du, wenn du Kafka richtig beherrschst? Denk mal an bestimmte Jobs wie Kafka-Ingenieur, Datenarchitekt oder Softwareentwickler, die sich auf Echtzeitsysteme konzentrieren.

- Welche Probleme versuche ich zu lösen?

- Hast du Probleme mit deinen aktuellen Messaging-Systemen, die Kafka vielleicht lösen könnte?

- Möchtest du Anwendungen entwickeln, die mit der Komplexität von Echtzeit-Datenströmen klarkommen?

- Bearbeitest du viele Ereignisse von IoT-Geräten, Social-Media-Feeds oder Finanztransaktionen?

- Hast du Probleme damit, Daten aus verschiedenen Quellen und Systemen zuverlässig und effizient zusammenzuführen?

- Was interessiert mich?

- Findest du die Idee, hoch skalierbare und fehlertolerante verteilte Systeme zu entwickeln, spannend?

- Interessierst du dich für die Echtzeitverarbeitung von Daten und die Möglichkeiten, die sich daraus für Unternehmen und Anwendungen ergeben?

- Willst du mehr über das breitere Ökosystem der Big-Data-Technologien erfahren und wissen, wie Kafka da reinpasst?

- Habe ich ein bestimmtes Projekt im Kopf, für das ich Kafkas Funktionen brauche?

- Arbeitest du gerade an einem persönlichen Projekt, das Echtzeit-Daten-Streaming beinhaltet, wie zum Beispiel die Entwicklung einer Chat-Anwendung?

- Hat dein Unternehmen ein Projekt, für das man Kafka-Kenntnisse braucht, wie zum Beispiel die Umstellung auf ein neues Messaging-System, die Implementierung von Echtzeitanalysen oder den Aufbau einer Microservices-Architektur?

2. Fang mit den Grundlagen von Apache Kafka an

Nachdem du deine Ziele festgelegt hast, lerne die Grundlagen von Kafka und wie sie funktionieren.

Apache Kafka installieren

Um Apache Kafka zu lernen, müssen wir es erst mal auf unseren Rechner laden. Weil Kafka mit Javaentwickelt wurde, sollten wir sicherstellen, dass Java installiert ist. Dann müssen wir die Kafka-Binärdateien von der offiziellen Website herunterladen und entpacken.

Jetzt starten wir ZooKeeper und dann den Kafka-Server mit den bereitgestellten Skripten. Zum Schluss können wir die Befehlszeilentools nutzen, um Themen zu erstellen und versuchen, ein paar Nachrichten zu produzieren und zu konsumieren, um die Grundlagen zu verstehen. DataCamp's Artikel „Apache Kafka für Anfänger” kann dir helfen, dich schnell zurechtzufinden.

Das Publisher-Subscriber-Modell verstehen

Das erste Konzept, das wir uns merken sollten, ist das Publisher-Subscriber-Modell in Kafka. Das ist einer der Hauptgründe, warum Apache Kafka Streaming-Daten so gut verarbeiten kann. Verstehe, wie Produzenten Nachrichten veröffentlichen und Konsumenten diese Themen abonnieren, sodass sie nur Nachrichten bekommen, die für ihre Interessen relevant sind.

DataCamps Einführung in Apache Kafka bietet eine Einführung mit interaktiven Übungen und praktischen Beispielen.

Kafka-Komponenten erkunden

Bei der Beschreibung des Publisher-Subscriber-Modells haben wir ein paar wichtige Kafka-Komponenten erwähnt: Produzent und Verbraucher. Wir sollten aber alle Kernkomponenten anschauen. Wir sollten uns damit beschäftigen, wie Kafka Daten in Themen und Partitionen organisiert, und verstehen, wie Partitionen zur Skalierbarkeit und Fehlertoleranz beitragen.

Wir sollten auch wissen, wie Broker einen Cluster bilden, um hohe Verfügbarkeit und Fehlertoleranz zu bieten.

Schau dir die Einführung in Apache Kafka von DataCamp an Einführung in Apache Kafka sowie den Artikel Artikel „Apache Kafka für Anfänger” an, um dir ein klares Bild von diesen Themen zu machen.

3. Lerne Apache Kafka auf fortgeschrittenem Niveau

Sobald du dich mit den Grundlagen vertraut gemacht hast, kannst du dich mit den fortgeschrittenen Apache Kafka-Fähigkeiten beschäftigen.

Kafka Connect für die Datenintegration

Eines der wichtigsten Features von Apache Kafka ist, dass es riesige Mengen an Streaming-Daten verarbeiten kann. Kafka Connect ist eine kostenlose Open-Source-Komponente von Apache Kafka, die die Datenintegration zwischen Dateisystemen, Datenbanken, Suchindizes und Schlüsselwertspeichern einfacher macht.

Wenn wir Connect richtig nutzen, können wir einen effizienten Datenfluss für Analysen, die Integration von Anwendungen und den Aufbau einer robusten, skalierbaren Datenarchitektur schaffen. Schau dir unseren Artikel „Apache Kafka für Anfänger” für mehr Infos.

Kafka Streams für die Stream-Verarbeitung

Eine weitere coole Funktion von Kafka sind Streams. Wir sollten lernen, wie man mit Streams direkt in Kafka Stream-Verarbeitungsanwendungen erstellt. Es bietet APIs und eine hochentwickelte domänenspezifische Sprache zum Verarbeiten, Konvertieren und Auswerten von kontinuierlichen Datenströmen. Mehr Infos findest du unter Artikel „Apache Kafka für Anfänger“.

Überwachung und Verwaltung von Kafka

Wie bei jeder anderen Technologie ist es immer gut, ihre Leistung im Auge zu behalten. Dafür sollten wir lernen, wie wir den Zustand und die Leistung unseres Kafka-Clusters im Auge behalten können. Wir können Tools und Techniken anschauen, um wichtige Kennzahlen zu überwachen, Themen und Partitionen zu verwalten und eine optimale Leistung sicherzustellen.

4. Lerne Apache Kafka durch praktische Übungen

Kurse über Apache Kafka sind super, um sich mit der Technologie vertraut zu machen. Um Kafka richtig gut zu beherrschen, musst du aber knifflige Probleme lösen, die deine Fähigkeiten verbessern, so wie du sie auch in echten Projekten findest.

Du kannst mit einfachen Daten-Streaming-Aufgaben anfangen, wie zum Beispiel dem Erstellen und Verwenden von Nachrichten, und dann nach und nach die Komplexität erhöhen, indem du Themen wie Partitionierung, Fehlertoleranz und die Integration mit externen Systemen mithilfe von Kafka Connect erkundest.

Hier sind ein paar Möglichkeiten, deine Fähigkeiten zu trainieren:

- Richte einen lokalen Kafka-Cluster ein: Installier Kafka auf deinem Rechner und probier mal aus, wie man Nachrichten erstellt und nutzt. Probier mal einen Cloud-Anbieter wie Confluent Cloud, AWS MSK oder Azure HDInsight Kafka aus, um eine verwaltete Kafka-Umgebung zu erleben. Das ist super, um mehr über Skalierung und operative Aspekte zu lernen.

- Mach bei Webinaren und Code-Alongs mit. Schau mal nach den kommende DataCamp-Webinare oder Confluent-Webinare, bei denen du Apache Kafka-Tutorials und Code-Beispiele mitverfolgen kannst. Das hilft dir, dein Verständnis der Konzepte zu vertiefen und dich mit Codierungsmustern vertraut zu machen.

- Mach bei Open-Source-Projekten mit. Mach bei Apache Kafka-Projekten auf Plattformen wie GitHub mit, um Erfahrungen in der Zusammenarbeit mit anderen und in der Arbeit an echten Projekten zu sammeln. Apache Kafka selbst bietet solche Möglichkeiten.

5. Ein Projektportfolio aufbauen

Während du dich weiter mit Apache Kafka beschäftigst, wirst du verschiedene Projekte machen. Um potenziellen Arbeitgebern deine Apache Kafka-Kenntnisse und -Erfahrungen zu zeigen, solltest du sie in einem Portfolio zusammenfassen. Dieses Portfolio sollte deine Fähigkeiten und Interessen zeigen und auf den Job oder die Branche zugeschnitten sein, die dich interessieren.

Mach deine Projekte originell und zeig, wie gut du Probleme lösen kannst. Zeig Projekte, die zeigen, wie gut du dich mit verschiedenen Aspekten von Kafka auskennst, wie zum Beispiel beim Aufbau von Datenpipelines mit Kafka Connect, bei der Entwicklung von Streaming-Anwendungen mit Kafka Streams oder bei der Arbeit mit Kafka-Clustern. Dokumentiere deine Projekte gründlich und gib dabei den Kontext, die Methodik, den Code und die Ergebnisse an. Du kannst Plattformen wie GitHub nutzen, um deinen Code zu hosten, und Confluent Cloud für eine verwaltete Kafka-Umgebung.

6. Fordere dich selbst immer wieder heraus

Kafka zu lernen ist ein ständiger Prozess. Die Technik entwickelt sich ständig weiter, und es kommen immer wieder neue Funktionen und Anwendungen dazu. Kafka ist da keine Ausnahme.

Sobald du die Grundlagen drauf hast, kannst du dich an anspruchsvollere Aufgaben und Projekte wagen, wie zum Beispiel die Leistungsoptimierung für Systeme mit hohem Durchsatz und die Implementierung von fortgeschrittener Stream-Verarbeitung mit Kafka Streams. Konzentrier dich auf deine Ziele und spezialisier dich auf Bereiche, die für deine Karrierepläne und Interessen wichtig sind.

Bleib auf dem Laufenden über die neuesten Entwicklungen, wie neue Funktionen oder KIP-Vorschläge, und lerne, wie du sie in deinen Projekten anwenden kannst. Mach weiter so, such dir neue Herausforderungen und Chancen und sieh Fehler als Chance, um was Neues zu lernen.

Ein Beispiel für einen Apache Kafka-Lernplan

Auch wenn jeder Mensch seine eigene Art zu lernen hat, ist es immer gut, einen Plan oder Leitfaden zu haben, an dem man sich beim Erlernen eines neuen Tools orientieren kann. Ich hab einen möglichen Lernplan zusammengestellt, der zeigt, wo du deine Zeit und Mühe reinlegen solltest, wenn du gerade erst mit Apache Kafka anfängst.

Lernplan für die Monate 1 bis 3

- Kernkonzepte. Installier Apache Kafka und starte ZooKeeper und den Kafka-Server. Lerne, wie du die Befehlszeilentools zum Erstellen von Themen benutzt.

- Java und Scala. Da Kafka in diesen Programmiersprachen entwickelt wurde, kannst du auch die Grundlagen von Java und Scala.

- Publisher-Subscriber-Modell. Verstehe das Kernsystem hinter Kafka, das Publisher-Subscriber-Modell. Schau dir an, wie Nachrichten asynchron erstellt und genutzt werden. Mach den Kurs „Einführung in Apache Kafka“.

- Kafka-Komponenten: Lerne die wichtigsten Konzepte und Elemente von Kafka kennen, wie Themen und Partitionen, Broker und Cluster, Produzenten und Konsumenten. Verstehe ihre Rollen und wie sie zusammenarbeiten, um Fehlertoleranz und Skalierbarkeit zu gewährleisten. Probier Tools wie Kafka Manager aus, um deinen Kafka-Cluster zu visualisieren und zu überwachen.

Lernplan für die Monate 4 bis 6

- Kafka Connect. Lerne, wie du Kafka mit verschiedenen Systemen wie Datenbanken (MySQL, PostgreSQL), Cloud-Diensten (AWS S3, Azure Blob Storage) und anderen Messaging-Systemen (JMS, RabbitMQ) über Kafka Connect verbinden kannst. Schau dir verschiedene Verbindungstypen (Quelle und Senke) und Konfigurationsoptionen an.

- Kafka Streams. Schau dir Konzepte wie zustandsbehaftete Operationen, Windowing und Stream-Tabellen-Dualität an. Lerne, wie du Stream-Processing-Anwendungen in deiner Kafka-Infrastruktur schreibst, testest und einsetzt.

- Überwachung und Verwaltung von Kafka. Lerne, wichtige Kafka-Metriken wie Durchsatz, Latenz und Verbraucherverzögerung mit Tools wie Burrow und Kafka Manager zu überwachen. Lerne, wie du Leistungsengpässe erkennst und behebst und den ordnungsgemäßen Zustand deines Kafka-Clusters sicherstellst.

Ab dem 7. Monat

- Mach ein Projekt. Tauch ein in fortgeschrittene Kafka-Themen wie Sicherheit, Leistungsoptimierung und fortgeschrittene Stream-Verarbeitungstechniken. Mach bei der Kafka-Community mit und entwickle Projekte für die Praxis.

- Hol dir die Kafka-Zertifizierung. Mach dich bereit für eine Kafka-Zertifizierung, wie zum Beispiel die Confluent Certified Developer for Apache Kafka, und hol sie dir. Schau dir das an Kafka-Zertifizierungsleitfadenan.

- Dateningenieur mit Python-Lernpfad. Mach den Data Engineer-Lernpfad auf DataCamp durch, der wichtige Datenverarbeitungsfähigkeiten wie Datenbearbeitung, SQL, Cloud Computing und Datenpipelines abdeckt.

Sechs Tipps zum Lernen von Apache Kafka

Ich denke, du bist jetzt bereit, dich mit Kafka zu beschäftigen und einen großen Datensatz zu nehmen, um deine neuen Fähigkeiten auszuprobieren. Bevor du das machst, will ich dir aber noch ein paar Tipps geben, die dir helfen werden, Apache Kafka richtig gut zu verstehen.

1. Schränk deinen Fokus ein

Kafka ist ein echt vielseitiges Tool, das man auf viele Arten nutzen kann. Du solltest deine spezifischen Ziele und Interessen innerhalb des Kafka-Ökosystems identifizieren. Welcher Aspekt von Kafka reizt dich am meisten? Interessierst du dich für Data Engineering, Stream Processing oder Kafka-Administration? Ein fokussierter Ansatz kann dir helfen, die wichtigsten Aspekte und Kenntnisse von Apache Kafka zu erlernen, um deine Interessen zu verwirklichen.

2. Übe oft und regelmäßig

Um eine neue Fähigkeit richtig zu lernen, ist es wichtig, dranzubleiben. Du solltest dir Zeit nehmen, um Kafka zu üben. Ein bisschen Zeit jeden Tag reicht schon. Du musst dich nicht jeden Tag mit komplizierten Sachen rumschlagen. Du kannst praktische Übungen machen, Tutorials durcharbeiten und mit verschiedenen Kafka-Funktionen experimentieren. Je mehr du übst, desto besser wirst du mit der Plattform klarkommen.

3. Arbeite an echten Projekten

Das ist einer der wichtigsten Tipps, und du wirst ihn in diesem Leitfaden mehrmals lesen. Übungen zu machen ist super, um Selbstvertrauen zu gewinnen. Aber erst wenn du deine Kafka-Kenntnisse in echten Projekten anwendest, wirst du richtig gut darin.

Fang mit einfachen Projekten und Fragen an und mach dich dann nach und nach an komplexere Sachen ran. Dazu könnte man eine einfache Produzent-Konsument-App aufsetzen, dann eine Echtzeit-Datenpipeline mit Kafka Connect bauen oder sogar eine fehlertolerante Streaming-App mit Kafka Streams entwickeln. Der Schlüssel ist, sich ständig selbst herauszufordern und seine praktischen Kafka-Kenntnisse zu erweitern.

4. Mach mit in einer Community

Gemeinsam lernt man oft besser. Wenn du deine Erfahrungen teilst und von anderen lernst, kannst du schneller vorankommen und wertvolle Einblicke gewinnen.

Um Wissen, Ideen und Fragen auszutauschen, kannst du Gruppen beitreten, die sich mit Apache Kafka beschäftigen, und an Treffen und Konferenzen teilnehmen. Du kannst Online-Communities wie dem Confluent Slack-Kanal oder dem Confluent Forum treten, wo du dich mit anderen Kafka-Fans austauschen kannst. Du kannst auch an virtuellen oder persönlichen Treffenteilnehmen, bei denen Kafka-Experten Vorträge halten, oder Konferenzen wie die ApacheCon.

5. Mach Fehler

Wie bei jeder anderen Technologie ist auch das Lernen von Apache Kafka ein schrittweiser Prozess. Aus Fehlern zu lernen ist ein wichtiger Teil dieses Prozesses. Hab keine Angst davor, zu experimentieren, verschiedene Ansätze auszuprobieren und aus deinen Fehlern zu lernen.

Probier verschiedene Konfigurationen für deine Kafka-Produzenten und -Konsumenten aus, schau dir verschiedene Daten-Serialisierungsmethoden an (JSON, Avro, Protobuf) und probier verschiedene Partitionierungsstrategien aus. Bring deinen Kafka-Cluster mit vielen Nachrichten an seine Grenzen und schau dir an, wie er mit der Last klarkommt. Analysiere Verzögerungen bei den Verbrauchern, passe die Konfigurationen an und finde raus, wie sich deine Optimierungen auf die Leistung auswirken.

6. Mach's ruhig

Nimm dir Zeit, um wichtige Sachen wie Themen, Partitionen, Verbrauchergruppen und die Rolle von ZooKeeper richtig zu verstehen. Wenn du jetzt eine solide Grundlage schaffst, wird es dir leichter fallen, fortgeschrittenere Themen zu verstehen und Probleme effektiv zu lösen. Teile den Lernprozess in kleinere Schritte auf und nimm dir Zeit, um die Infos zu verstehen. Ein langsamer und stetiger Ansatz führt oft zu einem tieferen Verständnis und einer besseren Beherrschung der Materie.

Die besten Methoden, um Apache Kafka zu lernen

Schauen wir uns mal ein paar coole Methoden an, um Apache Kafka zu lernen.

Mach Online-Kurse

Online-Kurse sind super, um Apache Kafka in deinem eigenen Tempo zu lernen. DataCamp bietet einen Kafka-Kurs für Fortgeschrittenean. Dieser Kurs behandelt die wichtigsten Konzepte von Kafka, darunter das Publisher-Subscriber-Modell, Themen und Partitionen, Broker und Cluster, Produzenten und Konsumenten.

Mach die Online-Tutorials

Tutorials sind auch super, um Apache Kafka zu lernen, vor allem wenn du noch keine Erfahrung mit der Technologie hast. Sie haben Schritt-für-Schritt-Anleitungen, wie man bestimmte Aufgaben macht oder bestimmte Konzepte versteht. Schau dir mal diese Tutorials an:

Blogs lesen

Um die Vorteile von Apache Kafka besser zu verstehen, solltest du auch wissen, was die wichtigsten Gemeinsamkeiten und Unterschiede zu anderen Technologien sind. Du kannst Artikel darüber lesen, wie Kafka im Vergleich zu anderen Tools abschneidet, zum Beispiel die folgenden:

Lerne Apache Kafka mit Büchern kennen

Bücher sind echt super, um Apache Kafka zu lernen. Sie bieten fundiertes Wissen und Einblicke von Experten sowie Code-Schnipsel und Erklärungen. Hier sind ein paar der beliebtesten Bücher über Kafka:

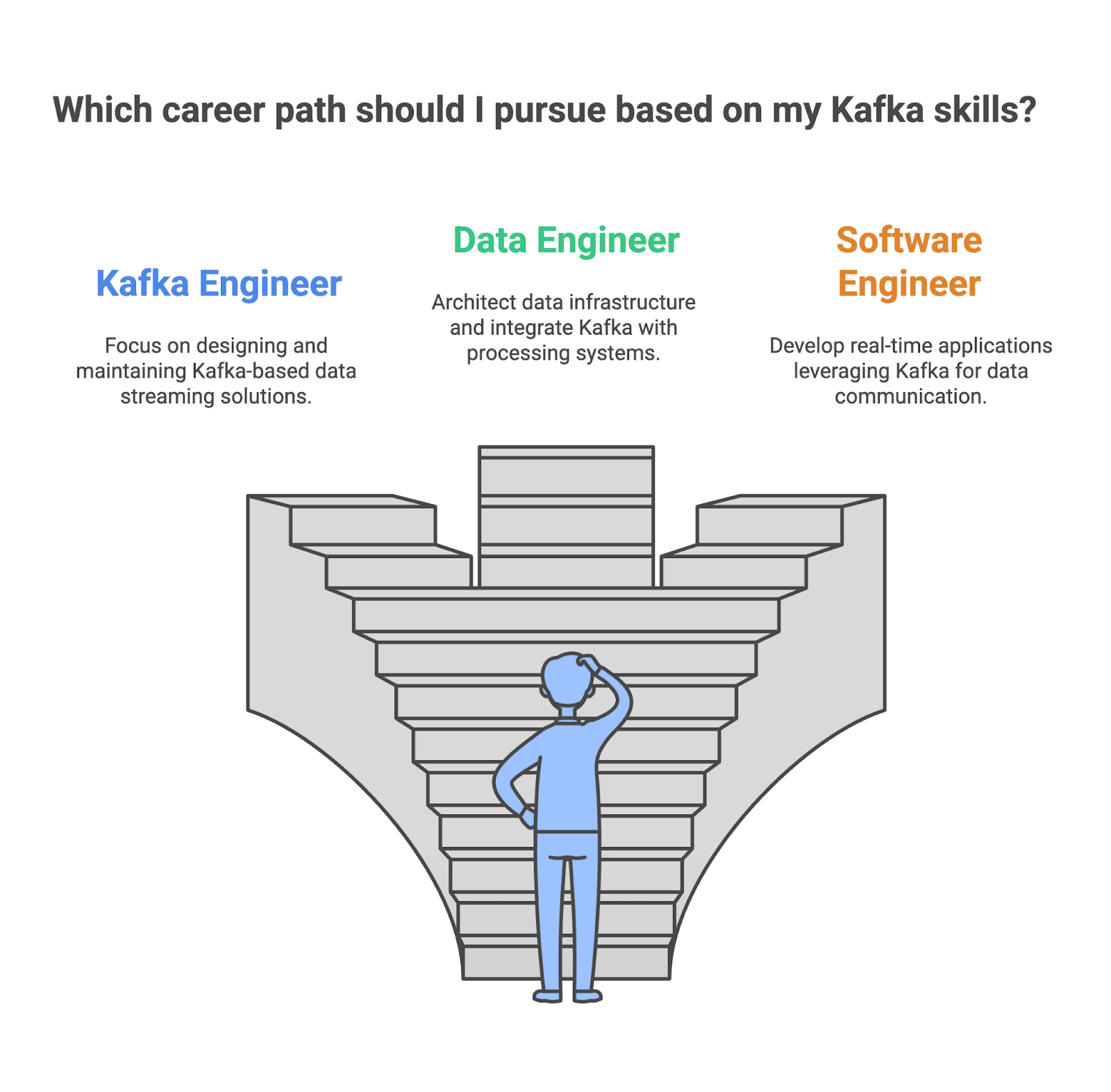

Die verschiedenen Karrieren bei Apache Kafka heute

Da Apache Kafka immer beliebter wird, gibt's auch immer mehr Jobchancen für Leute mit Kafka-Kenntnissen, von speziellen Kafka-Ingenieuren bis hin zu Softwareentwicklern. Wenn du deine Kafka-Kenntnisse checken willst, schau dir mal diese Rollen an:

Kafka engineer

Als Kafka-Ingenieur bist du dafür zuständig, Kafka-basierte Daten-Streaming-Lösungen mit hoher Verfügbarkeit und Skalierbarkeit zu entwerfen, zu entwickeln und zu warten. Du musst dafür sorgen, dass die Daten innerhalb des Unternehmens zuverlässig und effizient fließen, und außerdem die Kafka-Leistung im Auge behalten und optimieren, um einen optimalen Durchsatz und eine optimale Latenz zu erreichen.

- Wichtige Fähigkeiten:

- Gutes Verständnis der Kafka-Architektur und -Komponenten.

- Du kannst Kafka super verwalten und einrichten.

- Erfahrung mit Datenpipelines und ETL-Prozessen.

- Du solltest mit Stream-Processing-Konzepte und Kafka Streams vertraut sein.

- Wichtige Tools, die benutzt werden:

- Apache Kafka

- Kafka Connect

- Kafka Streams

- ZooKeeper

- Überwachungsinstrumente

Dateningenieur

Als Dateningenieur bist du der Architekt der Dateninfrastruktur und dafür zuständig, die Systeme zu entwerfen und aufzubauen, die die Daten eines Unternehmens verarbeiten. Kafka ist oft ein wichtiger Teil dieser Datenpipelines und sorgt für effizientes und skalierbares Echtzeit-Daten-Streaming zwischen verschiedenen Systemen. Du musst dafür sorgen, dass Kafka nahtlos mit anderen Komponenten zusammenarbeitet.

- Wichtige Fähigkeiten:

- Gutes Verständnis von Data Warehousing und Datenmodellierung.

- Du kannst super mit Datenverarbeitungs-Tools wie Spark und Hadoop umgehen.

- Erfahrung mit Cloud-Plattformen wie AWS, Azure oder GCP.

- Kenntnisse über Kafka für Echtzeit-Daten-Streaming.

- Wichtige Tools, die benutzt werden:

- Apache Kafka

- Apache Spark

- Hadoop

- Bienenstock

- Cloud-Plattformen (AWS, Azure, GCP)

Softwareentwickler

Als Softwareentwickler wirst du Kafka nutzen, um Echtzeit-Apps wie Chat-Plattformen und Online-Spiele zu entwickeln. Du musst es in den Anwendungscode einbauen, um einen reibungslosen Datenfluss zu gewährleisten, indem du es mit verschiedenen Messaging-Systemen und APIs verbindest. Du wirst diese Anwendungen auch für Skalierbarkeit und Leistung optimieren, damit sie große Mengen an Echtzeitdaten verarbeiten können.

- Wichtige Fähigkeiten:

- Gute Programmierkenntnisse in Sprachen wie Java, Python oder Scala.

- Verständnis von Kafkas Publisher-Subscriber-Modell und API.

- Erfahrung mit dem Aufbau von verteilten Systemen und Anwendungen.

- Kenntnisse über bewährte Verfahren in der Softwareentwicklung.

- Wichtige Tools, die benutzt werden:

- Apache Kafka

- Programmiersprachen (Java, Python, Scala)

- Messaging-Systeme (z. B. RabbitMQ, ActiveMQ)

- Entwicklungswerkzeuge und Frameworks

|

Rolle |

Was du machst |

Deine wichtigsten Fähigkeiten |

Die Tools, die du benutzt |

|

Kafka Engineer |

Entwickle und setz Kafka-Cluster für hohe Verfügbarkeit und Skalierbarkeit ein. |

Kafka-Architektur, Komponenten, Verwaltung und Konfiguration, Konzepte der Stream-Verarbeitung. |

Apache Kafka, Kafka Connect, Kafka Streams, ZooKeeper |

|

Dateningenieur |

Entwerfen und setz Data Warehouses und Data Lakes auf, verbinde Kafka mit anderen Datenverarbeitungs- und Speichersystemen. |

Du solltest gut mit Datenverarbeitungs-Tools klarkommen, Erfahrung mit Cloud-Plattformen haben und dich mit Kafka auskennen. |

Apache Kafka, Apache Spark, Hadoop, Bienenstock, Cloud-Plattformen |

|

Softwareentwickler |

Entwickle Apps, die Kafka für Echtzeit-Datenkommunikation nutzen. |

Programmierkenntnisse, verteilte Systeme und Anwendungen, Kafka Publisher-Subscriber-Kenntnisse. |

Apache Kafka, Java, Python, Scala, RabbitMQ, ActiveMQ, Entwicklungswerkzeuge und Frameworks. |

Wie man einen Job findet, bei dem man Apache Kafka nutzt

Ein Abschluss kann zwar echt hilfreich sein, wenn du eine Karriere in einem datenbezogenen Job anstrebst, bei dem Apache Kafka zum Einsatz kommt, aber es ist nicht der einzige Weg zum Erfolg. Immer mehr Leute mit unterschiedlichen Hintergründen und Erfahrungen fangen an, in Jobs rund um Daten zu arbeiten. Mit Engagement, kontinuierlichem Lernen und einer proaktiven Herangehensweise kannst du deinen Traumjob finden, bei dem Apache Kafka zum Einsatz kommt.

Lerne weiter über Kafka

Bleib auf dem Laufenden über die neuesten Entwicklungen bei Kafka. Folge einflussreichen Profis, die sich mit Apache Kafka beschäftigen, auf Social Media, lies Blogs über Apache Kafka und hör dir Podcasts zu diesem Thema an.

Tausch dich mit einflussreichen Leuten aus, wie zum Beispiel Neha Narkhede, die Kafka mitentwickelt hat und auch CTO von Confluent ist. Du bekommst Einblicke in aktuelle Themen, neue Technologien und die Zukunftspläne von Apache Kafka. Du kannst auch lesen den Confluent-Blog lesen, der ausführliche Artikel und Tutorials zu einer Vielzahl von Kafka-Themen bietet, von Architektur und Verwaltung bis hin zu Anwendungsfällen und Best Practices.

Du solltest dir auch Branchenveranstaltungen wie Webinare unter Confluent oder dem jährlichen Kafka Summit.

Ein Portfolio aufbauen

Du musst dich von den anderen Bewerbern abheben. Eine gute Möglichkeit dafür ist, ein starkes Portfolio aufzubauen, das deine Fähigkeiten und abgeschlossenen Projekte zeigt.

Dein Portfolio sollte Projekte zeigen, die deine Fähigkeiten beim Aufbau von Datenpipelines, der Implementierung von Stream-Processing-Anwendungen und der Integration von Kafka in andere Systeme unter Beweis stellen.

Schreib einen guten Lebenslauf

Personalchefs müssen echt viele Lebensläufe durchgehen und die besten Kandidaten raussuchen. Außerdem wird dein Lebenslauf oft durch Bewerbermanagementsysteme (ATS) geschleust. Das sind automatisierte Softwaresysteme, die viele Firmen nutzen, um Lebensläufe zu checken und die, die bestimmte Kriterien nicht erfüllen, auszusortieren. Also, du solltest einen tollen Lebenslauf erstellen und ein beeindruckendes Anschreiben, um sowohl das ATS als auch deine Personalvermittler zu beeindrucken.

Mach dich bei einem Personalchef bemerkbar

Wenn du dem Personalchef auffällst oder dein guter Lebenslauf den Auswahlprozess übersteht, solltest du dich als Nächstes auf ein Fachgespräch vorbereiten. Um dich vorzubereiten, kannst du diesen Artikel lesen: 20 Kafka-Interviewfragen für Dateningenieure.

Fazit

Das Lernen von Apache Kafka kann dir neue Möglichkeiten und bessere Karrierechancen bieten. Der Weg zum Erlernen von Kafka ist lohnenswert, erfordert aber Ausdauer und praktische Übung. Das Ausprobieren und Lösen von Aufgaben mit diesem Tool kann dir beim Lernen helfen und dir Beispiele aus der Praxis liefern, mit denen du deine praktischen Fähigkeiten bei der Jobsuche zeigen kannst.

FAQs

Warum wird Apache Kafka immer beliebter?

Unternehmen müssen Echtzeit-Datenströme verarbeiten, skalierbare Anwendungen entwickeln und verschiedene Systeme integrieren – alles Dinge, in denen Kafka richtig gut ist.

Was sind die wichtigsten Funktionen von Apache Kafka?

ADie Hauptmerkmale von Kafka sind hoher Durchsatz, Fehlertoleranz, Skalierbarkeit und Echtzeit-Daten-Streaming-Fähigkeiten, was es ideal für den Aufbau robuster Datenpipelines und verteilter Anwendungen macht.

Welche Rollen nutzen Apache Kafka?

Dateningenieur, Kafka-Ingenieur und Softwareentwickler.