Cursus

Chaque fois que nous cliquons, publions ou diffusons quelque chose, nous créons des données qui peuvent être transformées en informations et prévisions pertinentes à l'aide des outils appropriés. D'ici 2028, on estime que nous générerons environ 394 zettaoctets de données par an (source : Statista).

La possibilité de traiter ces données en temps réel nous permet de prendre des mesures immédiates, telles que la détection des fraudes ou la formulation de recommandations personnalisées. C'est là qu'intervient Apache Kafka. Il permet aux entreprises de mettre à jour leurs stratégies en matière de données grâce à une architecture de streaming d'événements.

Ce guide vous expliquera comment apprendre Apache Kafka à partir de zéro. Je vous assisterai dans l'élaboration d'un plan d'apprentissage, je partagerai mes meilleurs conseils pour apprendre efficacement et je vous fournirai des ressources utiles pour vous aider à trouver des postes qui requièrent Apache Kafka.

Qu'est-ce qu'Apache Kafka ?

Le traitement des données en temps réel nous offre de grandes opportunités. Si une banque détecte une transaction inhabituelle effectuée avec notre carte de crédit, elle peutimmédiatement bloquer la transaction . Ou, si nous recherchons un produit, des suggestions de produits peuvent apparaître lorsque nous parcourons le site Web. Cette rapidité se traduit par de meilleures décisions, des clients plus satisfaits et une entreprise plus efficace.

Apache Kafka est un magasin de données distribué à haut débit optimisé pour la collecte, le traitement, le stockage et l'analyse en temps réel de données en continu. Il permet à différentes applications de publier et de s'abonner à des flux de données, leur permettant ainsi de communiquer et de réagir aux événements au fur et à mesure qu'ils se produisent.

Grâce à sa gestion efficace des flux de données, Kafka a acquis une grande popularité. Il est utilisé dans divers systèmes, allant du commerce en ligne et des réseaux sociaux aux services bancaires et aux soins de santé.

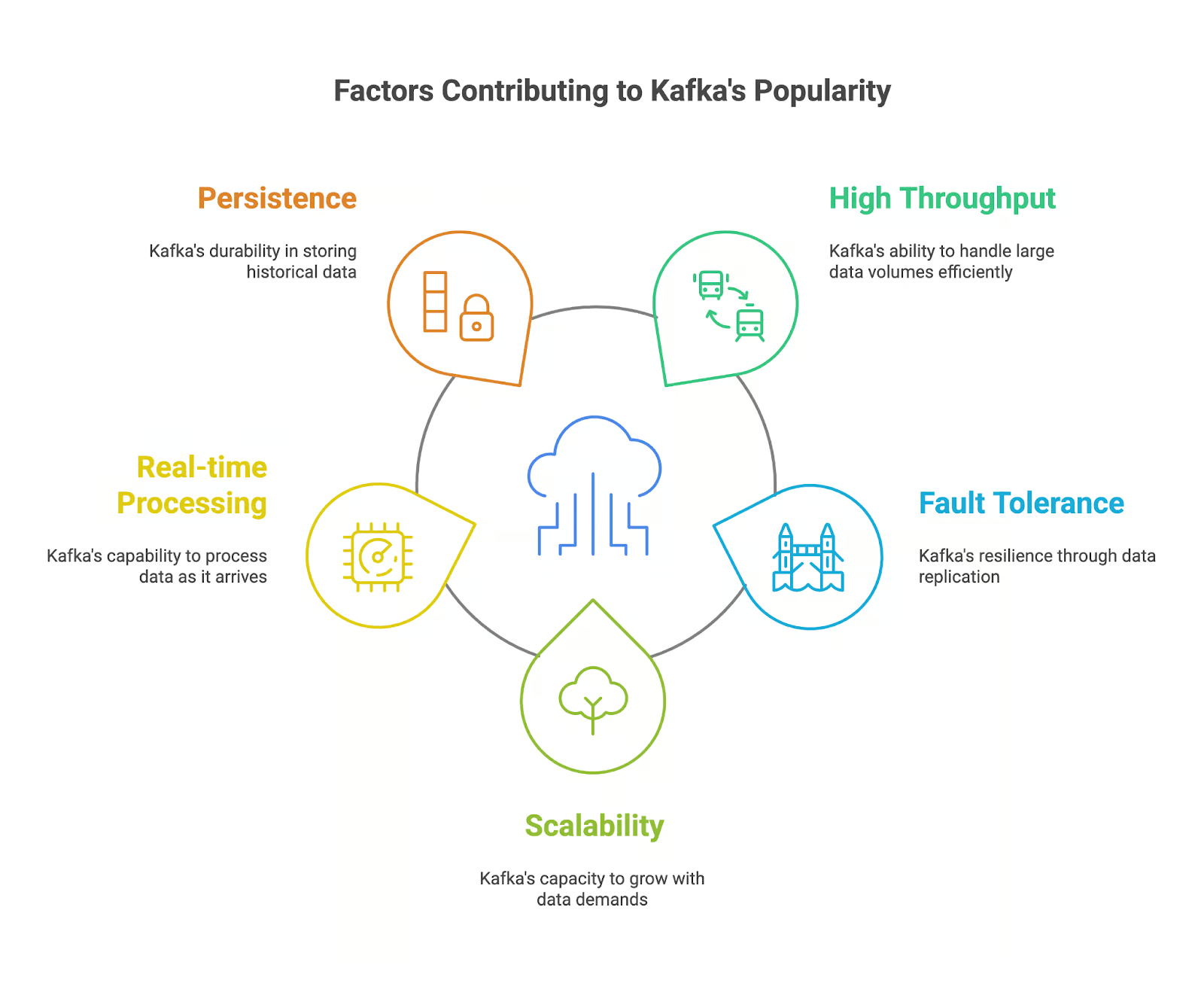

Quels sont les facteurs qui contribuent à la popularité d'Apache Kafka ?

Apache Kafka est devenu populaire parmi les professionnels des données qui sont confrontés aux défis liés au traitement des flux de données en temps réel. Nous pouvons expliquer sa popularité par plusieurs facteurs clés :

- Débit élevé : Kafka est capable de traiter d'énormes quantités de données avec une grande rapidité et une grande efficacité, ce qui le rend idéal pour le traitement des flux de données en temps réel.

- Tolérance aux défaillances : L'architecture distribuée de Kafka garantit que nos données sont répliquées sur plusieurs courtiers, ce qui confère à notre application une résilience face aux pannes et assure la durabilité des données.

- Évolutivité : Kafka peut facilement s'adapter pour gérer des volumes de données et des demandes utilisateur croissants en ajoutant davantage de brokers au cluster.

- Traitement en temps réel : La capacité de Kafka à traiter des flux de données en temps réel permet à nos applications de réagir aux événements dès qu'ils se produisent, ce qui nous offre des opportunités de prise de décision en temps réel.

- Persévérance : Kafka stocke les données de manière durable, ce qui permet à nos applications d'accéder aux données historiques à des fins d'analyse et d'audit.

Principales fonctionnalités d'Apache Kafka

Apache Kafka est actuellement utilisé dans des applications nécessitant le traitement et l'analyse de données en temps réel. Quelles sont les fonctionnalités qui en font un outil performant pour la gestion des données en continu ? Examinons-les :

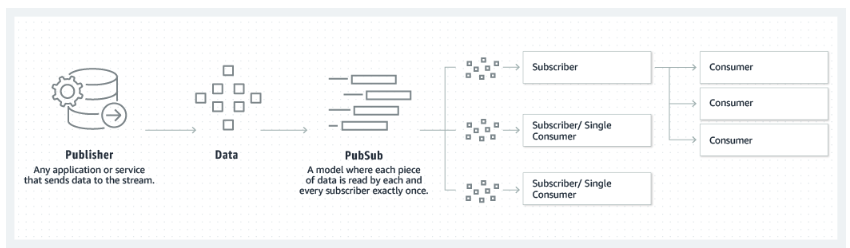

- Modèle éditeur-abonné : Kafka suit un modèle éditeur-abonné, dans lequel les producteurs publient des données sur des sujets, et les consommateurs s'abonnent à ces sujets pour recevoir les données.

- Thèmes et partitions : Les données dans Kafka sont organisées en thèmes, eux-mêmes divisés en partitions pour plus d'évolutivité et de parallélisme.

- Courtiers et groupements : Les brokers Kafka sont chargés de stocker et de fournir des données. Un cluster Kafka est constitué de plusieurs brokers qui collaborent afin d'assurer la tolérance aux pannes et la haute disponibilité.

- Producteurs et consommateurs : Les producteurs publient des données dans des rubriques Kafka, tandis que les consommateurs s'abonnent à ces rubriques et traitent les données.

- Intégration de ZooKeeper : Kafka s'appuie sur ZooKeeper pour gérer les métadonnées du cluster et assurer la coordination des brokers.

Le modèle éditeur-abonné sur lequel s'appuie Kafka. Source : Amazon

Pourquoi est-il si utile d'apprendre Apache Kafka ?

L'apprentissage d'Apache Kafka vous positionne comme un candidat de choix pour les employeurs et les entreprises qui génèrent et traitent des données à un rythme soutenu. Apache Kafka, grâce à ses fonctionnalités puissantes et son utilisation répandue, est devenu un outil essentiel pour la création d'architectures de données modernes. des architectures de données et d'applications.

Il existe une forte demande pour les compétences en Apache Kafka.

J'ai mentionné que Kafka est devenu très populaire ces dernières années. On estime qu'Apache Kafka est actuellement utilisé par plus de 80 % des entreprises du classement Fortune 100.

L'utilisation croissante de Kafka dans divers secteurs, ainsi que son rôle dans la mise en place de solutions de données en temps réel, rendent les compétences Kafka très recherchées sur le marché du travail. Selon PayScale et ZipRecruiter, en novembre 2024, le salaire moyen d'un ingénieur possédant des compétences en Kafka aux États-Unis était de 100 000 dollars par an.

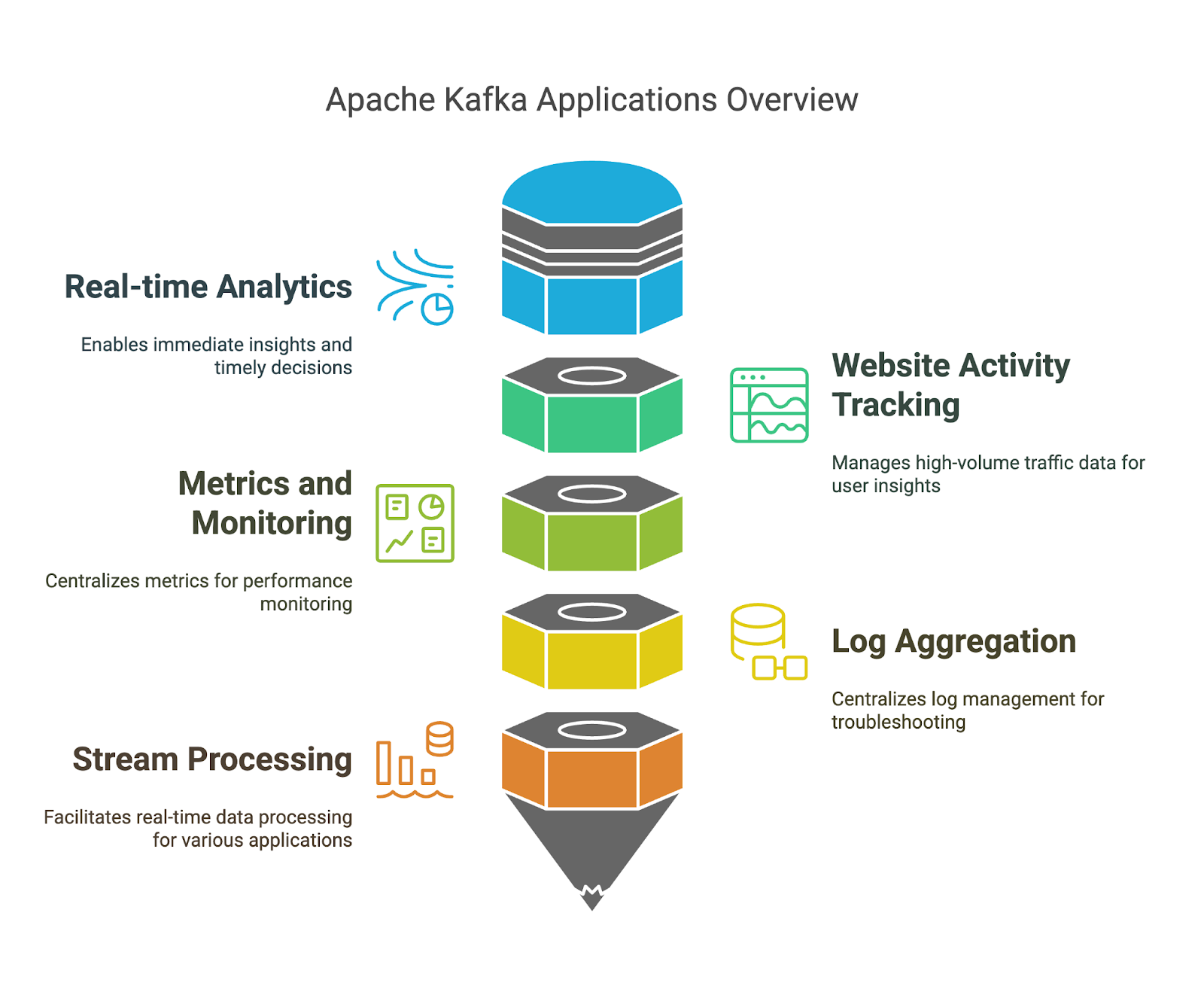

Apache Kafka offre une grande variété d'applications.

Nous avons déjà évoqué les points forts d'Apache Kafka, mais examinons quelques exemples concrets d'utilisation :

- Analyses en temps réel : Grâce à Kafka, nous pouvons effectuer l'ingestion et le traitement des données en temps réel, ce qui nous permet d'obtenir immédiatement des informations à partir des données en continu et de prendre des décisions opportunes.

- Suivi de l'activité sur le site Web : Grâce à la capacité de Kafka à traiter des volumes importants de données de trafic web, nous pouvons analyser le comportement des utilisateurs, les performances du site web et les contenus les plus populaires.

- Mesures et suivi : Kafka est capable de collecter et de traiter des métriques provenant de divers systèmes et applications. Nous pouvons tirer parti de sa plateforme centralisée pour surveiller les performances et identifier les problèmes potentiels.

- Agrégation des journaux : Kafka peut agréger des journaux provenant de plusieurs sources. Nous pouvons exploiter sa gestion et son analyse centralisées des journaux pour le dépannage et la surveillance de la sécurité.

- Traitement des flux : Kafka Streams nous permet de développer des applications qui traitent les données en temps réel. Cela nous permet de développer des modèles efficaces pour la détection des fraudes, la détection des anomalies et les recommandations en temps réel.

Comment acquérir des connaissances sur Apache Kafka à partir de zéro en 2026

En apprenant Apache Kafka de manière méthodique, vous augmentez vos chances de réussite. Concentrons-nous sur quelques principes que vous pouvez appliquer dans votre parcours d'apprentissage.

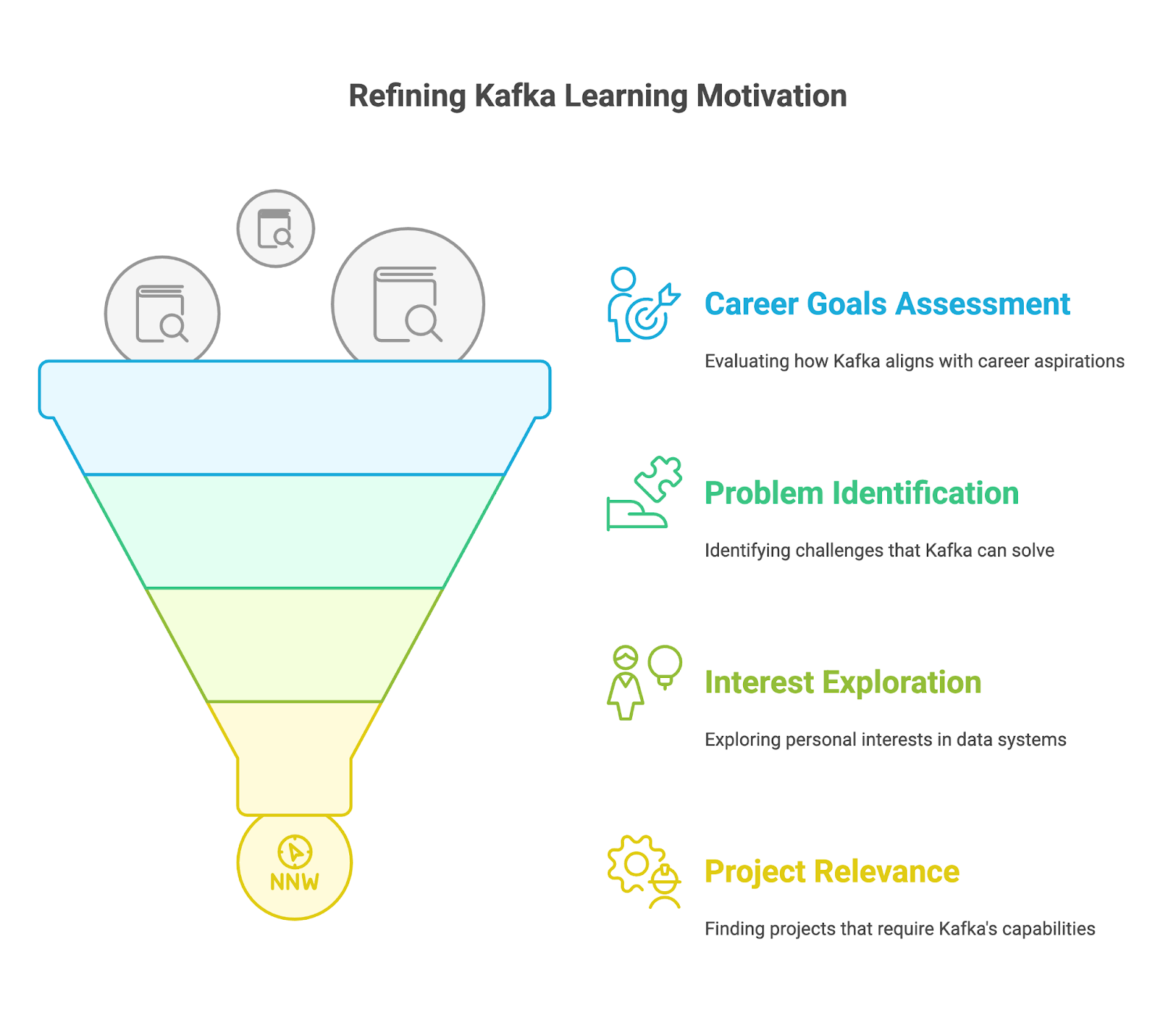

1. Comprenez pourquoi vous apprenez Apache Kafka

Avant d'aborder les détails techniques, veuillez définir votre motivation pour apprendre Apache Kafka. Veuillez vous poser la question suivante :

- Quels sont mes objectifs professionnels ?

- La maîtrise de Kafka est-elle une compétence nécessaire pour progresser dans votre poste actuel ou obtenir l'emploi de vos rêves ?

- Envisagez-vous une transition de carrière vers l'ingénierie des mégadonnées, le développement d'applications en temps réel ou le streaming de données ?

- Quelles opportunités voyez-vous s'ouvrir à vous grâce à la maîtrise de Kafka ? Envisagez des postes spécifiques tels que ingénieur Kafka, architecte de données ou ingénieur logiciel spécialisé dans les systèmes en temps réel.

- Quels problèmes est-ce que je cherche à résoudre ?

- Rencontrez-vous des difficultés avec les systèmes de messagerie existants que Kafka pourrait potentiellement résoudre ?

- Avez-vous besoin de développer des applications capables de gérer la complexité des flux de données en temps réel ?

- Traitez-vous des volumes importants d'événements provenant d'appareils IoT, de flux de réseaux sociaux ou de transactions financières ?

- Avez-vous des difficultés à intégrer de manière fiable et efficace des données provenant de différentes sources et de différents systèmes ?

- Qu'est-ce qui m'intéresse ?

- L'idée de développer des systèmes distribués hautement évolutifs et tolérants aux pannes vous intéresse-t-elle ?

- Êtes-vous intéressé par le traitement des données en temps réel et le potentiel qu'il offre aux entreprises et aux applications ?

- Souhaitez-vous explorer l'écosystème plus large des technologies du big data et comprendre comment Kafka s'y intègre ?

- Ai-je un projet spécifique en tête qui nécessite les capacités de Kafka ?

- Travaillez-vous sur un projet personnel impliquant le streaming de données en temps réel, tel que la création d'une application de chat ?

- Votre entreprise a-t-elle un projet à venir qui nécessite une expertise Kafka, tel que la migration vers un nouveau système de messagerie, la mise en œuvre d'analyses en temps réel ou la création d'une architecture de microservices ?

2. Commencer par les bases d'Apache Kafka

Une fois vos objectifs définis, veuillez acquérir les bases de Kafka et comprendre son fonctionnement.

Installation d'Apache Kafka

Pour apprendre Apache Kafka, il est nécessaire de l'installer sur notre ordinateur local. Étant donné que Kafka est développé à l'aide de Java, il est important de s'assurer que Java est correctement installé. Ensuite, il est nécessaire de télécharger les binaires Kafka depuis le site officiel et de les extraire.

Nous allons maintenant démarrer ZooKeeper, puis le serveur Kafka, à l'aide des scripts fournis. Enfin, nous pouvons utiliser les outils en ligne de commande pour créer des rubriques et tenter de produire et de consommer quelques messages afin de comprendre les principes fondamentaux. DataCamp's L'article Apache Kafka pour débutants de DataCamp peut vous aider à vous familiariser avec le sujet.

Comprendre le modèle éditeur-abonné

Le premier concept que nous devons acquérir est le modèle éditeur-abonné dans Kafka. C'est l'une des principales raisons pour lesquelles Apache Kafka est en mesure de traiter efficacement les données en continu. Comprenez comment les producteurs publient des messages et comment les consommateurs s'abonnent à ces sujets, recevant uniquement les messages pertinents pour leurs intérêts.

Introduction à Apache Kafka par DataCamp Introduction à Apache Kafka propose une introduction, avec des exercices interactifs et des exemples pratiques.

Exploration des composants Kafka

Lors de la description du modèle éditeur-abonné, nous avons mentionné certains composants clés de Kafka : Producteur et consommateur. Cependant, il est important d'examiner tous les composants essentiels. Il est important de comprendre comment Kafka organise les données en thèmes et en partitions, et de saisir comment les partitions contribuent à l'évolutivité et à la tolérance aux pannes.

Il est également important de comprendre comment les courtiers forment un cluster afin d'assurer une haute disponibilité et une tolérance aux pannes.

Veuillez consulter le cours d'introduction à Apache Kafka de DataCamp. Introduction à Apache Kafka ainsi que l'article article Apache Kafka pour débutants pour obtenir une vision claire de ces sujets.

3. Maîtrisez les compétences intermédiaires d'Apache Kafka

Une fois que vous maîtrisez les bases, il est temps d'approfondir vos connaissances sur Apache Kafka.

Kafka Connect pour l'intégration des données

L'une des principales caractéristiques d'Apache Kafka est sa capacité à traiter de grands volumes de données en continu. Kafka Connect est un composant open source et gratuit d'Apache Kafka qui simplifie l'intégration des données entre les systèmes de fichiers, les bases de données, les index de recherche et les magasins de valeurs-clés.

Apprendre à utiliser Connect peut nous aider à optimiser le flux de données pour l'analyse, l'intégration d'applications et la création d'une architecture de données robuste et évolutive. Veuillez consulter notre article Apache Kafka pour débutants pour plus de détails.

Kafka Streams pour le traitement des flux

Une autre fonctionnalité avancée de Kafka est Streams. Nous devrions apprendre à développer des applications de traitement de flux directement dans Kafka à l'aide de Streams. Il propose des API et un langage spécifique de haut niveau pour traiter, convertir et évaluer des flux de données continus. Pour en savoir plus, veuillez consulter l'article l'article Apache Kafka pour les débutants.

Surveillance et gestion de Kafka

Comme pour toute autre technologie, il est toujours judicieux de suivre ses performances. Pour ce faire, il est important d'apprendre à surveiller la santé et les performances de notre cluster Kafka. Nous pouvons examiner les outils et les techniques permettant de surveiller les indicateurs clés, de gérer les sujets et les partitions, et de garantir des performances optimales.

4. Apprenez Apache Kafka par la pratique

Suivre des cours sur Apache Kafka constitue un excellent moyen de se familiariser avec cette technologie. Cependant, pour maîtriser Kafka, il est nécessaire de résoudre des problèmes complexes et stimulants, tels que ceux que vous rencontrerez dans le cadre de projets réels.

Vous pouvez commencer par tester des tâches simples de streaming de données, telles que la production et la consommation de messages, puis augmenter progressivement la complexité en explorant des sujets tels que le partitionnement, la tolérance aux pannes et l'intégration avec des systèmes externes à l'aide de Kafka Connect.

Voici quelques méthodes pour exercer vos compétences :

- Configurez un cluster Kafka local : Veuillez installer Kafka sur votre ordinateur local et tester la production et la consommation de messages. Veuillez utiliser un fournisseur de cloud tel que Confluent Cloud, AWS MSK ou Azure HDInsight Kafka pour bénéficier d'un environnement Kafka géré. C'est un excellent moyen d'apprendre les aspects liés à la mise à l'échelle et à l'exploitation.

- Participez à des webinaires et à des sessions de codage en direct. Veuillez vérifier les les prochains webinaires DataCamp ou webinaires Confluent où vous pourrez suivre des tutoriels Apache Kafka et des exemples de code. Cela vous aidera à renforcer votre compréhension des concepts et à vous familiariser avec les modèles de codage.

- Contribuez aux projets open source. Contribuez aux projets Apache Kafka sur des plateformes telles que GitHub afin d'acquérir de l'expérience en matière de collaboration avec d'autres personnes et de travail sur des projets concrets. Apache Kafka offre en soi de telles opportunités. opportunités.

5. Construire un portefeuille de projets

Vous réaliserez différents projets tout au long de votre parcours d'apprentissage d'Apache Kafka. Afin de mettre en valeur vos compétences et votre expérience en matière d'Apache Kafka auprès d'employeurs potentiels, il est recommandé de les compiler dans un portfolio. Ce portfolio doit refléter vos compétences et vos centres d'intérêt, et être adapté à la carrière ou au secteur qui vous intéresse.

Veuillez vous efforcer de rendre vos projets originaux et de mettre en avant vos compétences en matière de résolution de problèmes. Veuillez inclure des projets qui démontrent votre maîtrise des différents aspects de Kafka, tels que la création de pipelines de données avec Kafka Connect, le développement d'applications de streaming avec Kafka Streams ou l'utilisation de clusters Kafka. Veuillez documenter vos projets de manière exhaustive, en fournissant le contexte, la méthodologie, le code et les résultats. Vous pouvez utiliser des plateformes telles que GitHub pour héberger votre code et Confluent Cloud pour un environnement Kafka géré.

6. Continuez à vous mettre au défi

L'apprentissage de Kafka est un processus continu. La technologie évolue constamment, et de nouvelles fonctionnalités et applications sont régulièrement développées. Kafka ne fait pas exception à cette règle.

Une fois que vous maîtrisez les principes fondamentaux, vous pouvez vous orienter vers des tâches et des projets plus complexes, tels que l'optimisation des performances pour les systèmes à haut débit et la mise en œuvre d'un traitement avancé des flux avec Kafka Streams. Concentrez-vous sur vos objectifs et spécialisez-vous dans des domaines pertinents pour vos objectifs de carrière et vos centres d'intérêt.

Restez informé des dernières nouveautés, telles que les nouvelles fonctionnalités ou les propositions KIP, et découvrez comment les appliquer à vos projets. Continuez à vous exercer, recherchez de nouveaux défis et opportunités, et considérez les erreurs comme un moyen d'apprendre.

Exemple de plan d'apprentissage Apache Kafka

Même si chaque individu a sa propre méthode d'apprentissage, il est toujours judicieux de disposer d'un plan ou d'un guide à suivre pour apprendre à utiliser un nouvel outil. J'ai élaboré un plan d'apprentissage potentiel qui indique où concentrer votre temps et vos efforts si vous débutez avec Apache Kafka.

Plan d'apprentissage pour les mois 1 à 3

- Concepts fondamentaux. Veuillez installer Apache Kafka et démarrer ZooKeeper ainsi que le serveur Kafka. Comprenez comment utiliser les outils en ligne de commande pour créer des rubriques.

- s Java et Scala. Étant donné que Kafka est développé dans ces langages de programmation, vous pouvez également acquérir les bases de Java et Scala.

- Modèle éditeur-abonné. Comprenez le système central derrière Kafka, le modèle éditeur-abonné. Veuillez examiner comment les messages sont générés et consommés de manière asynchrone. Veuillez suivre le cours cours Introduction à Apache Kafka.

- Composants Kafka : Maîtrisez les concepts et éléments clés de Kafka, notamment les sujets et partitions, les courtiers et clusters, les producteurs et les consommateurs. Comprenez leurs rôles et comment ils interagissent pour assurer la tolérance aux pannes et l'évolutivité. Découvrez des outils tels que Kafka Manager pour visualiser et surveiller votre cluster Kafka.

Plan d'apprentissage pour les mois 4 à 6

- Kafka Connect. Apprenez à connecter Kafka à divers systèmes tels que des bases de données (MySQL, PostgreSQL), des services cloud (AWS S3, Azure Blob Storage) et d'autres systèmes de messagerie (JMS, RabbitMQ) à l'aide de Kafka Connect. Veuillez examiner les différents types de connecteurs (source et récepteur) et les options de configuration.

- Flux Kafka. Explorez des concepts tels que les opérations avec état, le fenêtrage et la dualité tableau-flux. Apprenez à écrire, tester et déployer des applications de traitement de flux au sein de votre infrastructure Kafka.

- Surveillance et gestion de Kafka. Apprenez à surveiller les indicateurs clés de Kafka, tels que le débit, la latence et le retard des consommateurs, à l'aide d'outils tels que Burrow et Kafka Manager. Apprenez à identifier et à résoudre les problèmes de performances et à garantir le bon fonctionnement de votre cluster Kafka.

À partir du 7e mois

- Développer un projet. Explorez des sujets avancés liés à Kafka, tels que la sécurité, l'optimisation des performances et les techniques avancées de traitement des flux. Contribuez à la communauté Kafka et développez des projets concrets.

- Obtenez la certification Kafka. Préparez-vous et obtenez une certification Kafka, telle que la certification Confluent Certified Developer for Apache Kafka. Veuillez consulter ceci guide de certification Kafka.

- Ingénieur de données avec cursus Python. Veuillez compléter la cursus Data Engineer sur DataCamp, qui couvre les compétences essentielles en ingénierie des données telles que la manipulation des données, le langage SQL, le cloud computing et les pipelines de données.

Six conseils pour apprendre Apache Kafka

J'imagine qu'à présent, vous êtes prêt à vous lancer dans l'apprentissage de Kafka et à vous procurer un ensemble de données volumineux afin de mettre en pratique vos nouvelles compétences. Cependant, avant de vous lancer, permettez-moi de vous présenter ces conseils qui vous aideront à maîtriser Apache Kafka.

1. Réduisez votre champ d'action

Kafka est un outil polyvalent qui peut être utilisé de multiples façons. Il est important que vous identifiiez vos objectifs et vos intérêts spécifiques au sein de l'écosystème Kafka. Quel aspect de Kafka vous attire le plus ? Êtes-vous intéressé par l'ingénierie des données, le traitement des flux ou l'administration Kafka ? Une approche ciblée peut vous aider à acquérir les connaissances et les aspects les plus pertinents d'Apache Kafka pour répondre à vos intérêts.

2. Veuillez vous entraîner fréquemment et régulièrement.

La constance est essentielle pour maîtriser toute nouvelle compétence. Il est recommandé de consacrer du temps à la pratique de Kafka. Quelques instants chaque jour suffisent. Il n'est pas nécessaire d'aborder des concepts complexes quotidiennement. Vous pouvez réaliser des exercices pratiques, suivre des tutoriels et tester différentes fonctionnalités de Kafka. Plus vous vous entraînerez, plus vous vous sentirez à l'aise avec la plateforme.

3. Travaillez sur des projets concrets

Il s'agit d'un conseil essentiel, que vous retrouverez à plusieurs reprises dans ce guide. La pratique d'exercices est un excellent moyen de gagner en confiance. Cependant, c'est en appliquant vos compétences Kafka à des projets concrets que vous parviendrez à les maîtriser parfaitement.

Commencez par des projets et des questions simples, puis passez progressivement à des projets et des questions plus complexes. Cela pourrait impliquer la mise en place d'une application simple de type producteur-consommateur, puis la création d'un pipeline de données en temps réel avec Kafka Connect, ou même la conception d'une application de streaming tolérante aux pannes avec Kafka Streams. La clé réside dans le fait de se remettre continuellement en question et d'approfondir ses compétences pratiques en Kafka.

4. S'engager dans une communauté

L'apprentissage est souvent plus efficace lorsqu'il est effectué de manière collaborative. Partager vos expériences et apprendre des autres peut accélérer vos progrès et vous apporter des informations précieuses.

Pour échanger des connaissances, des idées et poser des questions, vous pouvez rejoindre des groupes liés à Apache Kafka et participer à des rencontres et des conférences. Vous pouvez également rejoindre des communautés en ligne telles que le canal Slack Confluent. canal Slack Confluent ou forum Confluent où vous pourrez interagir avec d'autres passionnés de Kafka. Vous pouvez également participer à des rencontres virtuelles ou en personne. rencontres, proposant des conférences données par des experts Kafka, ou à des conférences, telles que ApacheCon.

5. Faire des erreurs

Comme pour toute autre technologie, l'apprentissage d'Apache Kafka est un processus itératif. Apprendre de ses erreurs est une partie essentielle de ce processus. N'hésitez pas à expérimenter, à essayer différentes approches et à tirer des leçons de vos erreurs.

Veuillez tester différentes configurations pour vos producteurs et consommateurs Kafka, explorer diverses méthodes de sérialisation des données (JSON, Avro, Protobuf) et expérimenter différentes stratégies de partitionnement. Veuillez exploiter votre cluster Kafka à son maximum avec des volumes de messages élevés et observez comment il gère la charge. Analysez le retard des consommateurs, affinez les configurations et comprenez l'impact de vos optimisations sur les performances.

6. Veuillez ne pas vous précipiter.

Veuillez prendre le temps de bien comprendre les concepts fondamentaux tels que les thèmes, les partitions, les groupes de consommateurs et le rôle de ZooKeeper. Si vous établissez dès maintenant des bases solides, il vous sera plus facile de comprendre les sujets plus avancés et de résoudre efficacement les problèmes. Divisez le processus d'apprentissage en étapes plus petites et accordez-vous le temps nécessaire pour assimiler les informations. Une approche lente et régulière conduit souvent à une compréhension et une maîtrise plus approfondies.

Les meilleures méthodes pour apprendre Apache Kafka

Examinons quelques méthodes efficaces pour apprendre Apache Kafka.

Suivre des cours en ligne

Les cours en ligne constituent un excellent moyen d'apprendre Apache Kafka à votre rythme. DataCamp propose un cours intermédiaire sur Kafka. Ce cours aborde les concepts fondamentaux de Kafka, notamment le modèle éditeur-abonné, les sujets et les partitions, les courtiers et les clusters, les producteurs et les consommateurs.

Suivez les tutoriels en ligne

Les tutoriels constituent un autre excellent moyen d'apprendre Apache Kafka, en particulier si vous débutez avec cette technologie. Ils contiennent des instructions détaillées sur la manière d'effectuer des tâches spécifiques ou de comprendre certains concepts. Pour commencer, veuillez consulter ces tutoriels :

Consulter les blogs

Pour mieux comprendre les avantages d'Apache Kafka, il est également important de connaître les principales similitudes et différences avec d'autres technologies. Vous pouvez consulter des articles comparant Kafka à d'autres outils, tels que les suivants :

Découvrez Apache Kafka à travers des ouvrages

Les livres constituent une excellente ressource pour apprendre Apache Kafka. Ils offrent des connaissances approfondies et des informations provenant d'experts, ainsi que des extraits de code et des explications. Voici quelques-uns des ouvrages les plus populaires sur Kafka :

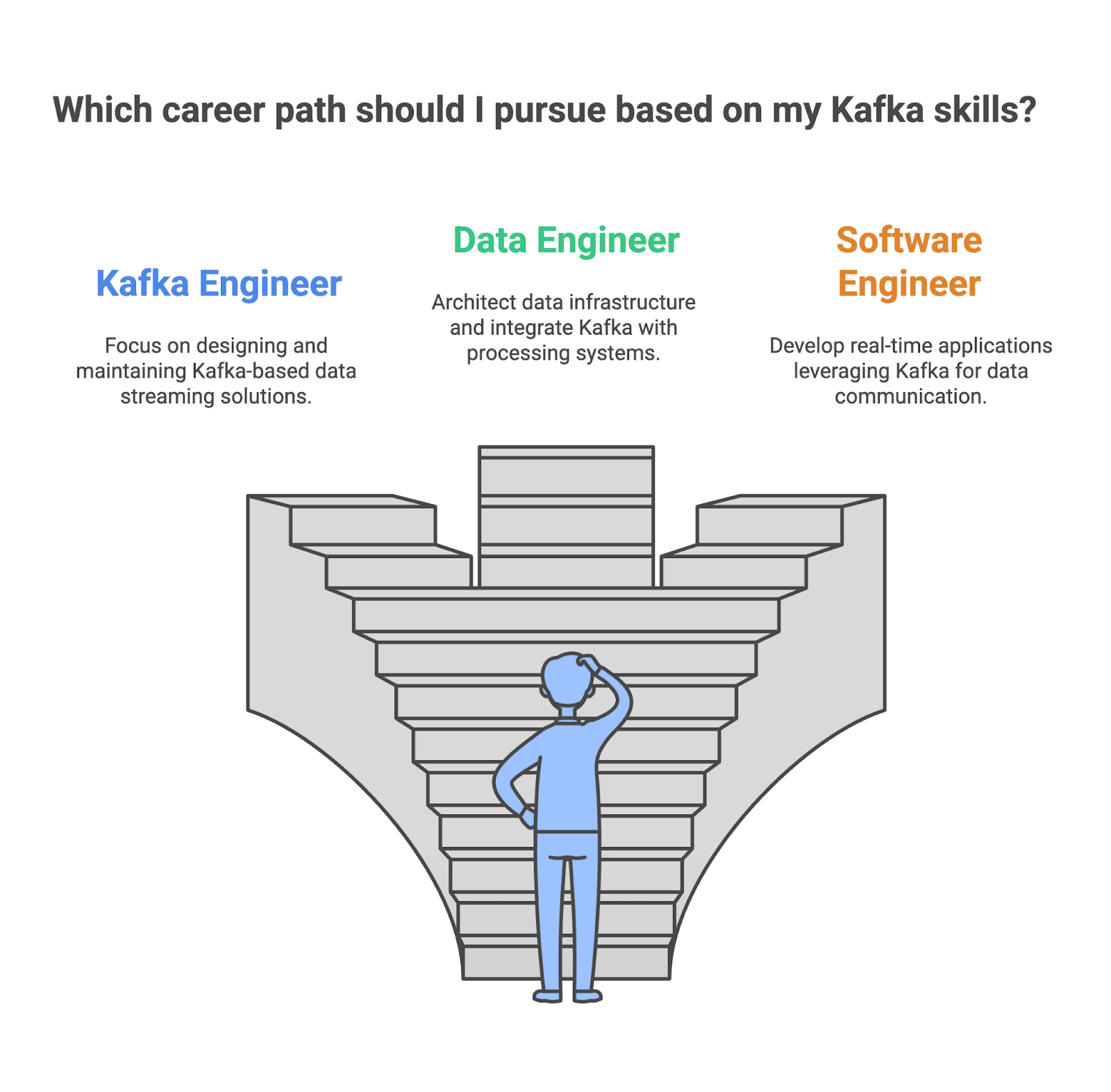

Les différentes carrières possibles aujourd'hui dans Apache Kafka

L'adoption d'Apache Kafka ne cessant de croître, les opportunités de carrière pour les professionnels possédant des compétences Kafka, qu'il s'agisse d'ingénieurs Kafka spécialisés ou d'ingénieurs logiciels, se multiplient également. Si vous évaluez l'adéquation de vos compétences Kafka, veuillez considérer les rôles suivants :

Ingénieur Kafka

En tant qu'ingénieur Kafka, vous êtes chargé de concevoir, de développer et de maintenir des solutions de streaming de données basées sur Kafka, offrant une haute disponibilité et une grande évolutivité. Vous devrez garantir la fiabilité et l'efficacité du flux de données au sein de l'entreprise, ainsi que surveiller et optimiser les performances de Kafka afin d'assurer un débit et une latence optimaux.

- Compétences clés :

- Excellente compréhension de l'architecture et des composants Kafka.

- Maîtrise de l'administration et de la configuration de Kafka.

- Expérience avec les pipelines de données et les processus ETL.

- Connaissance des concepts de traitement des flux et de Kafka Streams.

- Principaux outils utilisés :

- Apache Kafka

- Kafka Connect

- Kafka Streams

- ZooKeeper

- Outils de surveillance

Ingénieur de données

En tant qu'ingénieur de données, vous êtes l'architecte de l'infrastructure de données, chargé de concevoir et de construire les systèmes qui gèrent les données d'une entreprise. Kafka joue souvent un rôle important dans ces pipelines de données, permettant un streaming de données en temps réel efficace et évolutif entre différents systèmes. Il est nécessaire de veiller à ce que Kafka s'intègre parfaitement aux autres composants.

- Compétences clés :

- Excellente compréhension des concepts liés au stockage et à la modélisation des données.

- Maîtrise des outils de traitement de données tels que Spark et Hadoop.

- Expérience avec des plateformes de cloud telles qu'AWS, Azure ou GCP.

- Connaissance de Kafka pour le streaming de données en temps réel.

- Principaux outils utilisés :

- Apache Kafka

- Apache Spark

- Hadoop

- Ruche

- Plateformes cloud (AWS, Azure, GCP)

Ingénieur logiciel

En tant qu'ingénieur logiciel, vous utiliserez Kafka pour développer des applications en temps réel telles que des plateformes de chat et des jeux en ligne. Il sera nécessaire de l'intégrer au code de l'application afin de garantir un flux de données fluide en le connectant à divers systèmes de messagerie et API. Vous optimiserez également ces applications en termes d'évolutivité et de performances, leur permettant ainsi de traiter de grandes quantités de données en temps réel.

- Compétences clés :

- Solides compétences en programmation dans des langages tels que Java, Python ou Scala.

- Compréhension du modèle éditeur-abonné et de l'API de Kafka.

- Expérience dans la conception de systèmes et d'applications distribués.

- Connaissance des meilleures pratiques en matière d'ingénierie logicielle.

- Principaux outils utilisés :

- Apache Kafka

- Langages de programmation (Java, Python, Scala)

- Systèmes de messagerie (par exemple, RabbitMQ, ActiveMQ)

- Outils et cadres de développement

|

Rôle |

Ce que vous faites |

Vos compétences clés |

Outils que vous utilisez |

|

Kafka Engineer |

Concevoir et mettre en œuvre des clusters Kafka pour une haute disponibilité et une évolutivité optimales. |

Architecture Kafka, composants, administration et configuration, concepts de traitement des flux. |

Apache Kafka, Kafka Connect, Kafka Streams, ZooKeeper |

|

Ingénieur de données |

Concevoir et mettre en œuvre des entrepôts de données et des lacs de données, intégrer Kafka à d'autres systèmes de traitement et de stockage de données. |

Maîtrise des outils de traitement des données, expérience des plateformes cloud et connaissance de Kafka. |

Apache Kafka, Apache Spark, Hadoop, Ruche, Plateformes cloud |

|

Ingénieur logiciel |

Concevez et développez des applications qui exploitent Kafka pour la communication de données en temps réel. |

Compétences en programmation, systèmes et applications distribués, connaissance de Kafka en tant qu'éditeur-abonné. |

Apache Kafka, Java, Python, Scala, RabbitMQ, ActiveMQ, Outils et cadres de développement. |

Comment trouver un emploi qui utilise Apache Kafka

Bien qu'un diplôme puisse être très utile pour poursuivre une carrière dans un poste lié aux données qui utilise Apache Kafka, ce n'est pas la seule voie pour réussir. De plus en plus de personnes issues de divers horizons et ayant des expériences différentes commencent à occuper des postes liés aux données. Grâce à votre dévouement, à votre apprentissage continu et à votre approche proactive, vous pouvez décrocher l'emploi de vos rêves qui utilise Apache Kafka.

Continuez à découvrir Kafka

Restez informé des derniers développements concernant Kafka. Suivez les professionnels influents impliqués dans Apache Kafka sur les réseaux sociaux, consultez les blogs consacrés à Apache Kafka et écoutez les podcasts liés à Kafka.

Interagissez avec des personnalités influentes, telles que Neha Narkhede, co-fondatrice de Kafka et directrice technique de Confluent. Vous obtiendrez des informations sur les sujets d'actualité, les technologies émergentes et l'orientation future d'Apache Kafka. Vous pouvez également consulter le blog Confluent, qui propose des articles approfondis et des tutoriels sur un large éventail de sujets liés à Kafka, de l'architecture et l'administration aux cas d'utilisation et aux meilleures pratiques.

Nous vous recommandons également de consulter les événements du secteur, tels que les webinaires proposés par Confluent ou le sommet annuel Kafka Summit.

Élaborer un portfolio

Il est essentiel que vous vous démarquiez des autres candidats. Une bonne façon d'y parvenir est de constituer un solide portfolio qui met en valeur vos compétences et les projets que vous avez menés à bien.

Votre portfolio devrait inclure des projets qui démontrent votre maîtrise dans la création de pipelines de données, la mise en œuvre d'applications de traitement de flux et l'intégration de Kafka à d'autres systèmes.

Élaborez un CV efficace

Les responsables du recrutement doivent examiner de nombreux CV et identifier les meilleurs candidats. De plus, votre CV est souvent soumis à des systèmes de suivi des candidats (ATS), des logiciels automatisés utilisés par de nombreuses entreprises pour examiner les CV et éliminer ceux qui ne répondent pas à des critères spécifiques. Il est donc important de rédiger un CV de qualité et une lettre de motivation convaincante. lettre de motivation convaincante afin d'impressionner à la fois l'ATS et vos recruteurs.

Attirez l'attention d'un responsable du recrutement

Si vous retenez l'attention du responsable du recrutement ou si votre CV convaincant passe le processus de sélection, vous devriez ensuite vous préparer à un entretien technique. Pour vous préparer, vous pouvez consulter cet article sur 20 questions d'entretien Kafka pour les ingénieurs de données.

Conclusion

Apprendre Apache Kafka peut vous ouvrir les portes vers de meilleures opportunités et perspectives de carrière. L'apprentissage de Kafka est enrichissant, mais nécessite de la constance et une pratique intensive. Expérimenter et résoudre des défis à l'aide de cet outil peut accélérer votre processus d'apprentissage et vous fournir des exemples concrets pour mettre en valeur vos compétences pratiques lorsque vous recherchez un emploi.

Questions fréquentes

Pourquoi la demande en compétences Apache Kafka est-elle en augmentation ?

Les entreprises doivent gérer des flux de données en temps réel, créer des applications évolutives et intégrer divers systèmes, autant de domaines dans lesquels Kafka excelle.

Quelles sont les principales fonctionnalités d'Apache Kafka ?

Les principales caractéristiques de Kafka sont un débit élevé, la tolérance aux pannes, l'éLes principales caractéristiques de Pache Kafka sont un débit élevé, une tolérance aux pannes, une évolutivité et des capacités de streaming de données en temps réel, ce qui le rend idéal pour la création de pipelines de données robustes et d'applications distribuées.

Quels sont les rôles qui utilisent Apache Kafka ?

Ingénieur de données, ingénieur Kafka et ingénieur logiciel.