programa

Cuando chatGPT se lanzó en noviembre de 2022 y atrajo a cien millones de usuarios en solo dos meses, sinceramente lo descarté como un chatbot sobrevalorado. Esa valoración ha quedado desfasada. Hoy en día, yo (y casi todos tus compañeros de trabajo) utilizamos a diario herramientas de codificación basadas en inteligencia artificial, y los antiguos debates de 2023 sobre si un bot puede escribir un correo electrónico decente parecen completamente obsoletos. Entonces, ¿cuál es el futuro de la IA?

La industria ha superado esas cuestiones iniciales y ha pasado a una escala completamente diferente. Anthropic ha superado recientemente los 7000 millones de dólares en ingresos recurrentes, y los gigantes tecnológicos están invirtiendo en centros de datos a niveles que habrían parecido absurdos hace cinco años. Por lo tanto, la pregunta que importa ahora ya no es« » si la IA funciona, sino qué sucede cuando deja de esperar instrucciones y comienza a decidir qué hacer a continuación.

Este artículo trata sobre hacia dónde parece dirigirse la tecnología. Analizaré la IA agencial, el acalorado debate sobre la cronología de la IGA y el auge de los modelos más pequeños que se pueden ejecutar localmente. También analizaremos los cambios en el empleo, las herramientas de codificación, las aplicaciones sanitarias y la situación normativa. ¡Vamos a ello!

Si aún no estás familiarizado con algunos de los conceptos de IA, te recomiendo nuestro curso Fundamentos de IA , que cubre todos los conceptos básicos que necesitas saber en el programa.

De la IA generativa a la IA agencial

El modelo de chatbot bidireccional está dando paso a un enfoque más autónomo. En esta sección se describe cómo se traduce ese cambio en la práctica, cuáles son los verdaderos retos de implementación y por qué la mayoría de las organizaciones siguen teniendo dificultades para poner en marcha los agentes.

El auge de los agentes autónomos

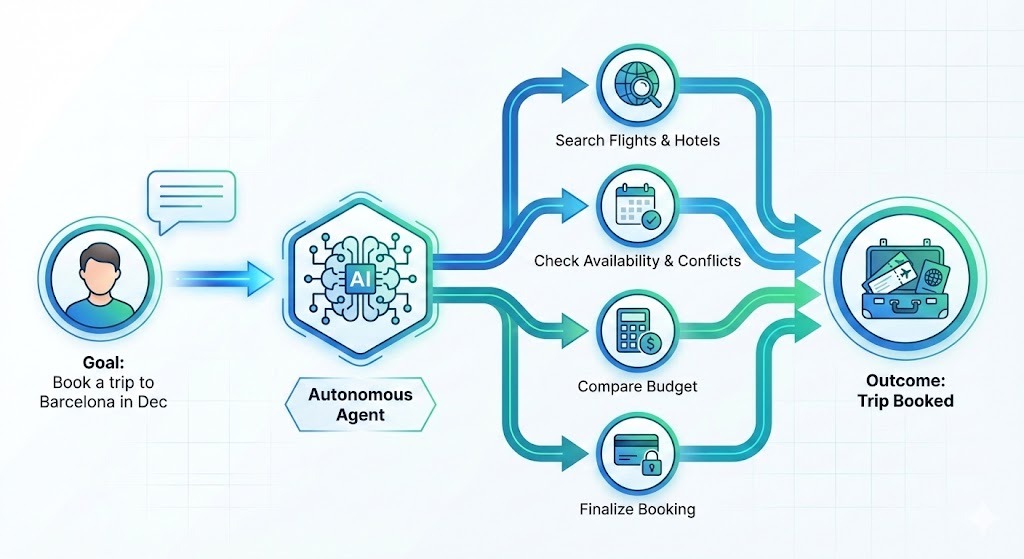

Durante los últimos dos años, las herramientas de IA han seguido un ritmo predecible. Tú preguntas, él responde. El humano conducía y la IA te acompañaba en el viaje. Esa dinámica está cambiando: La IA agencial no solo responden preguntas, sino que formulan planes para alcanzar objetivos.

Digamos que quieres reservar un viaje a Barcelona en diciembre. En lugar de elaborar una lista de hoteles para que tú los investigues, un agente haría lo siguiente:

- Buscar opciones

- Filtra según tus preferencias

- Comprueba que los precios se ajustan a tu presupuesto.

- Comprueba tu calendario para ver si hay conflictos.

- Haz la reserva

Tú describes un resultado y el sistema se encarga de los pasos necesarios para alcanzarlo.

El interés de las empresas por esto es enorme. Deloitte predice que el 75 % de las empresas invertirán en IA agencial a finales de 2026. Sin embargo, la realidad actualmente va por detrás de la visión. A mediados de 2025 UiPath reveló que, aunque el interés es alto, solo el 30 % de las implementaciones de agentes llegan realmente a la fase de producción.

Salvar la brecha con MCP

¿Por qué esta diferencia? Integración, principalmente. Cuando los investigadores preguntaron a las empresas qué les impedía avanzar, el 46 % señaló la conexión de los agentes de IA con los sistemas existentes. Escribir un agente que pueda redactar código es todo un reto. Hacer que funcione de forma fiable con tu CRM, tu plataforma de venta de entradas y tus API internas, sin causar problemas ni crear otros nuevos, resulta ser un reto completamente diferente.

Para resolver este problema, la industria se está uniendo en torno a estándares abiertos como el Protocolo de Contexto de Modelos (MCP) de Anthropic y la especificación AGENTS.md de OpenAI, que tienen como objetivo la administración neutral de la infraestructura abierta y que fueron aportados a la Fundación Agente de IA.

MCP, en particular, ha ganado mucho terreno. Piensa en ello como «USB-C para IA», un conector estándar que permite a los agentes comunicarse fácilmente con diferentes herramientas y plataformas. Por mencionar algunos, ofrece integración con Claude, Cursor, Microsoft Copilot, VSCode, Gemini y chatGPT.

Si deseas ir más allá de las demostraciones, consulta nuestros cursos sobre IA agencial para conocer los conceptos y Diseño de sistemas agenticos con LangChain para aplicaciones prácticas.

¿Está cerca la inteligencia artificial general (AGI)?

El calendario para inteligencia artificial general (IAG), sistemas de IA capaces de realizar tareas a nivel humano en distintos ámbitos, depende totalmente de a quién le preguntes.

Los directores generales de los principales laboratorios de IA son agresivos: Dario Amodei, de Anthropic, ha sugerido que en 2026-2027 habrá sistemas capaces de igualar a los premios Nobel en todos los campos («un país de genios en un centro de datos»). Del mismo modo, Sam Altman y Demis Hassabis apuntan a los próximos 3-5 años.

Cabe señalar que estas empresas dependen del entusiasmo de los inversores para financiar investigaciones costosas, por lo que los plazos optimistas tienen un propósito estratégico.

Los escépticos ofrecen una visión más fría. Gary Marcus califica los últimos meses como «devastadores» para el optimismo sobre la IGA, y el antiguo investigador de OpenAI Andrej Karpathy sitúa la IGA al menos a una década de distancia. Una amplia encuesta realizada en 2023 entre investigadores situó la fecha media de llegada aún más lejos, en 2047.

En última instancia, el HAI de Stanford ofrece el marco más útil: estamos pasando del «evangelismo a la evaluación». La pregunta más importante no es« » cuándo llegará la AGI, sino «how well» cómo de bien gestionan los sistemas actuales tareas específicas hoy en día frente a aquellas en las que aún requieren supervisión humana.

Tecnologías emergentes de IA más allá de los LLM

No todo lo interesante en IA consiste en crear modelos más grandes. Los modelos más pequeños, la computación cuántica y los gemelos digitales están redefiniendo lo que es posible en los límites de este campo.

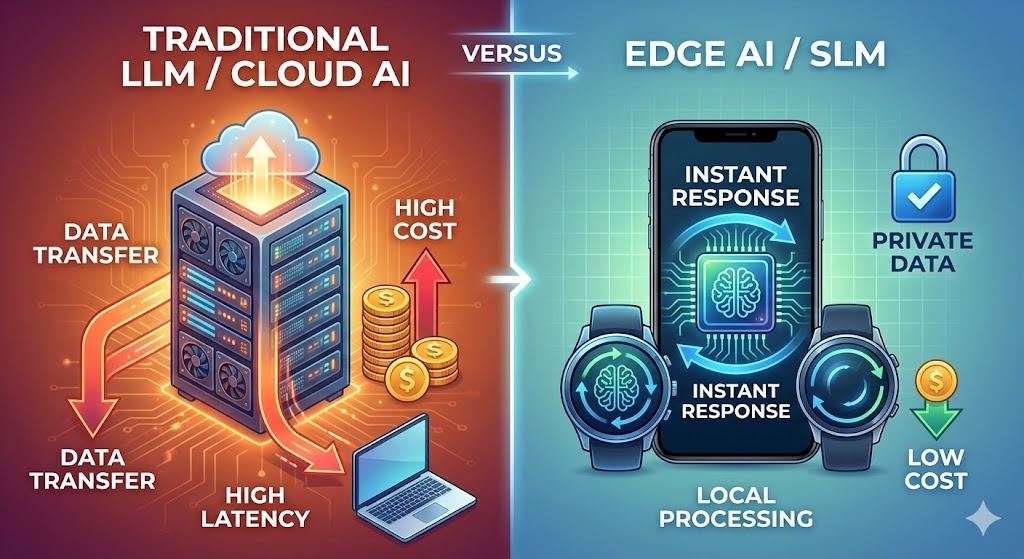

Modelos de lenguaje pequeños (SML) e inteligencia artificial periférica

Mientras todo el mundo habla de modelos cada vez más grandes, se están realizando importantes inversiones en los más pequeños. Gartner predice que las organizaciones implementarán modelos de lenguaje pequeños (SML), modelos específicos para tareas concretas, a un ritmo tres veces superior al de los modelos grandes de uso general para 2027.

Las razones son prácticas:

- Coste: Ejecutar modelos masivos es caro. Según se informa, OpenAI gastó casi el doble de sus ingresos en inferencia a principios de 2025. Los SLM reducen estos costes drásticamente.

- Privacidad: Los modelos integrados en los dispositivos mantienen los datos a nivel local, un requisito imprescindible para los sectores sanitario y financiero. En consecuencia, se prevé que el mercado de SLM crezca de 930 millones de dólares en 2025 a 5450 millones de dólares en 2032.

- Velocidad: La inferencia local elimina la latencia de la red. En el control de calidad de la fabricación o la detección de fraudes en la banca, cada milisegundo cuenta. La nube no siempre puede ofrecer eso.

Los investigadores de NVIDIA sostienen que el próximo avance en IA no será el tamaño, sino la especialización. Dado que tareas como el análisis de correos electrónicos o las consultas SQL no requieren conocimientos enciclopédicos, la arquitectura futura se asemeja a flotas de modelos: múltiples modelos especializados que trabajan en conjunto en lugar de un único modelo generalista de gran envergadura.

Google, Mistral, Microsoft y Alibaba están haciendo grandes esfuerzos en este sentido. Google AI Edge es compatible con más de una docena de modelos, incluido Gemma 3n, su primer modelo multimodal integrado en el dispositivo.

Comparación entre los enfoques de los SLM y los LLM

La siguiente tabla compara los dos enfoques. Para obtener más información, consulta nuestro artículo sobre SLM frente a LLM.

|

Aspecto |

Modelos lingüísticos de gran tamaño |

Modelos lingüísticos pequeños |

|

Donde corren |

Servidores en la nube |

Dispositivos, periféricos, servidores locales |

|

Coste por solicitud |

Más alto (entre 0,01 y 0,10 dólares) |

Fracciones de centavo |

|

Tiempo de respuesta |

Dependiente de la red (100-500 ms) |

Menos de 50 ms |

|

Tratamiento de datos |

Deja el dispositivo. |

Te quedas en tu localidad |

|

Personalización |

Que requiere muchos recursos |

Más accesible |

|

Ideal para |

Razonamiento complejo, trabajo creativo, amplios conocimientos. |

Tareas específicas, fiabilidad, rapidez |

|

Consumo de energía |

Sustancial |

Modesto |

Los modelos grandes no están dejando de ser relevantes. Los problemas complejos siguen beneficiándose de tu poder. Es probable que el futuro implique ambos, con interesantes cuestiones sobre cuándo utilizar cada uno.

La convergencia de la computación cuántica y la inteligencia artificial

La computación cuántica ha estado «a cinco años de distancia» o a décadas, pero algo cambió a finales de 2025, y vale la pena prestar atención.

Google demostró una aceleración de 13 000 veces con respecto al superordenador Frontier utilizando 65 qubits para simulaciones físicas. IBM tiene como objetivo alcanzar la ventaja cuántica para 2026, y los investigadores han comenzado a utilizar redes neuronales para predecir y corregir errores de qubits en tiempo real.

El campo pasó de ser una promesa teórica a un problema de ingeniería.

El término que está ganando popularidad es «utilidad cuántica». No se trata de una ventaja cuántica total en todos los problemas, sino de que los sistemas cuánticos resuelvan problemas específicos más rápido o más barato que las alternativas clásicas. Los problemas a los que se dirigen son muy matemáticos e implican tantas variables que los ordenadores clásicos se bloquean:

- Optimización de la química de las baterías

- Cribado de compuestos farmacológicos

- Modelización del riesgo del portafolio

Los investigadores de JPMorgan Chase han logrado recientemente un hito con un algoritmo de streaming cuántico que procesa grandes conjuntos de datos con una ventaja espacial exponencial. Eso no es un comunicado de prensa. Se trata de un trabajo revisado por pares con resultados medibles.

Dicho esto, el rango de predicción aquí es amplio.

Manifold Markets, que realiza un seguimiento de más de 100 previsiones relacionadas con la cuántica, muestra un amplio escepticismo sobre la posibilidad de que los ordenadores cuánticos superen a los sistemas clásicos en criptografía o simulación biológica compleja para 2026. La mayoría de los observadores esperan un progreso incremental en ingeniería, no una ventaja cuántica revolucionaria.

Pero esos mismos mercados muestran una gran confianza en que, en el plazo de una década, se dispondrá de ordenadores cuánticos útiles y tolerantes a fallos.

¿Qué significa esto en la práctica?

En la práctica, el ordenador cuántico autónomo es un mito. El estándar actual del sector es la «computación heterogénea»: arquitecturas híbridas en las que los procesadores cuánticos se encuentran dentro de centros de alto rendimiento junto con clústeres de GPU, y los sistemas de IA gestionan el flujo de trabajo.

Para los científicos de datos que trabajan en los sectores de I+D, esto crea un nuevo requisito en cuanto a habilidades. Las API cuánticas en la nube de IBM, Google, Amazon Braket y Microsoft Azure Quantum te permiten ejecutar subrutinas cuánticas sin necesidad de poseer hardware. La curva de aprendizaje no es trivial, pero es más accesible que construir tu propio laboratorio cuántico.

El cambio de enfoque es sutil, pero importante. Mientras que la ciencia de datos clásica se obsesiona con el «big data», la computación cuántica se preocupa por la «optimización compleja». Aborda problemas con explosiones combinatorias, como el modelado molecular, la logística o el riesgo financiero con miles de factores correlacionados. En estos campos, las herramientas cuánticas están pasando de ser teóricas a relevantes.

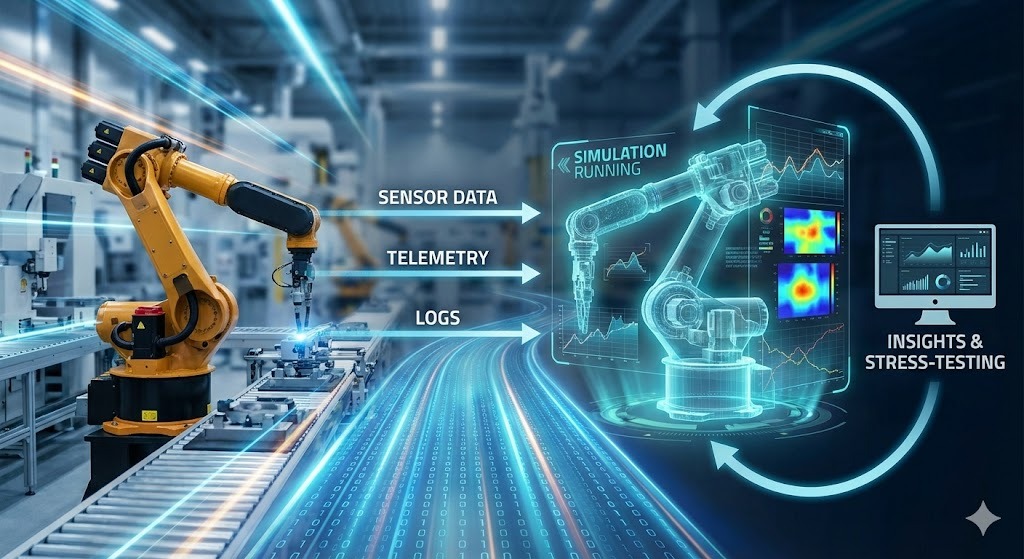

Gemelos digitales y simulación

Los gemelos digitales están pasando de ser una palabra de moda a convertirse en una infraestructura funcional. La idea es sencilla: construir una réplica virtual viva de un sistema físico (una línea de fábrica, una red de almacenes, una red eléctrica, un distrito urbano) y mantenerla sincronizada con el real mediante sensores, registros y datos operativos. A continuación, utilizas el gemelo para someter a pruebas de estrés las decisiones antes de enfrentarte a la realidad.

Las fábricas son el caso más limpio. Una planta moderna ya produce los datos que necesita un gemelo: Señales PLC, telemetría de máquinas, historial de mantenimiento, órdenes de trabajo, mediciones de calidad, movimientos de inventario. La IA convierte esa avalancha de datos en un modelo que puedes consultar. No solo paneles de control, sino también contrafactuales. Puedes responder a preguntas como:

- ¿Qué pasaría si una prensa de estampación se averiara durante seis horas el martes por la mañana?

- ¿Qué pasaría si cambiáramos el proveedor B por el proveedor C en este componente, con un perfil de defectos ligeramente diferente?

- ¿Qué pasaría si cambiáramos el horario de los turnos para que los operadores con experiencia se concentraran en las dos últimas estaciones?

El valor no predice la disrupción. Se trata de rastrear los efectos posteriores (ventanas perdidas, faltas de inventario, costes de redireccionamiento) para que puedas calcular soluciones por adelantado en lugar de improvisar a las 3 de la madrugada.

El cambio habilitador es que la IA está reduciendo el costo de crear y mantener estos modelos. Los modelos modernos de aprendizaje automático aprenden el comportamiento directamente a partir de datos en tiempo real, detectando desviaciones y manteniendo la alineación del gemelo a medida que cambia el sistema real.

Los modelos pequeños y especializados también encajan bien aquí: un modelo para la detección de anomalías en una turbina, otro para la optimización de horarios, otro para la previsión de la demanda, todos ellos alimentando el mismo entorno simulado.

Si deseas tener una visión más clara de lo que está por venir, te recomendamos leer 9 LLM de código abierto para 2026 para ejecutar y ajustar modelos sin proveedores y Las 13 mejores conferencias sobre IA para 2026, donde se hablará de la implementación real.

El futuro de la IA en el trabajo

Los titulares sobre la IA que sustituye puestos de trabajo tienden a pasar por alto los matices de los datos reales. La imagen que surge de la investigación es más confusa, más gradual y probablemente menos dramática de lo que sugieren tanto los optimistas como los pesimistas.

¿La IA reemplazará los puestos de trabajo?

Las cifras merecen más matices de los que suelen ofrecer los titulares.

El Foro Económico Mundial encuestó a más de 1000 empleadores líderes para su Informe sobre el futuro del empleo en 2025. Proyectaron la creación de 170 millones de nuevos puestos de trabajo y el desplazamiento de 92 millones entre 2025 y 2030, lo que supone un aumento neto de 78 millones de puestos de trabajo.

Aunque esto es positivo en términos netos, la distribución es muy importante. En un estudio publicado en noviembre de 2025, investigadores del MIT y de la Universidad de Boston estimaron que la IA sustituirá a alrededor de dos millones de trabajadores del sector manufacturero para 2026.

Vale la pena distinguir entre tareas y funciones. La IA tiende a automatizar actividades específicas dentro de los puestos de trabajo con más frecuencia que a eliminar puestos completos de una sola vez. Tu contable no va a ir a ninguna parte, pero las horas dedicadas a la introducción de datos y la conciliación se están reduciendo.

Una investigación del MIT de 2025 estimó que las tareas que actualmente se pueden automatizar cubren alrededor del 11,7 % de la actividad laboral en Estados Unidos, lo que equivale aproximadamente a 1,2 billones de dólares en salarios. Eso no significa que el 11,7 % de los trabajadores pierdan sus puestos de trabajo, sino que una parte importante de lo que hacen ahora puede realizarse mediante un software.

Los trabajos que se enfrentan a una mayor presión incluyen:

- Servicio de atención al cliente, especialmente asistencia por texto.

- Introducción y procesamiento de datos

- Trabajo administrativo que sigue patrones predecibles.

- Algunos puestos de cajero en tiendas minoristas

- Investigación jurídica rutinaria y tareas de asistente jurídico.

Los trabajos que impliquen las siguientes características estarán sujetos a menos presión:

- Gestión de personas

- Juicio especializado

- Situaciones ambiguas

- Presencia física en entornos impredecibles

Estos patrones se aplican a la atención sanitaria, los oficios especializados, el trabajo creativo y la toma de decisiones estratégicas, entre otros.

Nuevas trayectorias profesionales

Están apareciendo nuevas categorías laborales, algunas de las cuales ni siquiera existían hace cinco años:

- El arquitecto de sistemas de IA se encarga de diseñar cómo encajan los componentes de IA dentro de las organizaciones. Debes combinar conocimientos técnicos y conocimientos sobre procesos empresariales.

- El ingeniero de prompts se convirtió en un puesto de trabajo real, aunque está evolucionando hacia lo que la gente llama especialista en colaboración con IA. Comprender cómo trabajar eficazmente con estos sistemas, no solo escribir entradas ingeniosas.

- El responsable de ética y cumplimiento normativo en materia de IA se encarga de los requisitos normativos y de la auditoría. Las organizaciones necesitan personas que comprendan tanto las capacidades técnicas como el panorama legal para minimizar los riesgos relacionados con los sistemas de IA.

- El formador de IA y el curador de datos se encargan de los bucles de retroalimentación, la anotación de casos extremos y el control de calidad de los datos de entrenamiento.

El patrón que he descubierto es que la experiencia en el ámbito combinada con el dominio de la IA es lo que crea valor. Una enfermera que entiende las herramientas de diagnóstico basadas en IA obtiene mejores resultados que una que las evita. Un abogado que utiliza la IA para investigar, pero conoce sus límites, trabaja más rápido sin perder calidad.

Las encuestas a los empleadores sitúan sistemáticamente el pensamiento analítico como la habilidad más buscada. Siete de cada diez empresas lo consideran esencial. La resiliencia, la adaptabilidad y el liderazgo te siguen.

Cambios específicos del sector

Algunos campos adoptaron las herramientas de IA más rápido que otros, y los resultados varían más de lo que cabría esperar. La programación, la sanidad y las finanzas cuentan cada una una historia diferente sobre lo que funciona, lo que no funciona y dónde surgen las sorpresas.

Codificación y ciencia de datos

El desarrollo de software adoptó las herramientas de IA más rápido que la mayoría de los campos. Las herramientas siguen evolucionando.

Según la encuesta Stack Overflow de 2025, alrededor del 85 % de los programadores utilizan herramientas de IA de forma habitual a finales de 2025. GitHub informa que el 41 % del código creado por los usuarios de Copilot a nivel mundial cuenta con la ayuda de la IA. Ya hemos superado el autocompletado: Los sistemas actuales comprenden repositorios completos y realizan cambios en múltiples archivos.

Han surgido líderes del mercado: GitHub Copilot tiene alrededor del 42 % de la cuota de mercado, con más de 20 millones de usuarios y presencia en el 90 % de las empresas de la lista Fortune 100. Cursor apareció de la nada y alcanzó una cuota de mercado del 18 % en dieciocho meses. Según se informa, están generando 500 millones de dólares en ingresos recurrentes.

Las herramientas de IA destacan en determinados tipos de trabajos de programación:

- Patrones repetitivos y estereotipados

- Explorar API desconocidas

- Descifrando el código heredado

Sin embargo, la brecha entre la percepción y la realidad es importante.

En un estudio de METR de julio de 2025, programadores experimentados utilizaron herramientas como Cursor Pro y Claude 3.5 Sonnet. Esos programadores completaron las tareas un 19 % más lento que sin la ayuda de la IA, pero creían que estaban trabajando un 20 % más rápido.

La conclusión es que el aumento de la productividad depende del contexto. Las herramientas de IA pueden ralentizar tu trabajo cuando el tipo de tarea no se ajusta a sus puntos fuertes y tú comprendes el sistema mejor que la IA.

Hoy en día, la tendencia se dirige hacia capacidades más autónomas. El proyecto Padawan de GitHub representa un modelo en el que los desarrolladores asignan problemas a los sistemas de IA, la IA los implementa y los humanos los representa un modelo en el que los programadores asignan problemas a los sistemas de IA, la IA los implementa y los humanos los revisan. El cambio pasa de que la IA sugiera código a que la IA complete funciones.

En lo que respecta a la ciencia de datos, se espera que se dedique menos tiempo a la preparación y más a la interpretación. La IA puede encargarse de gestionar las consultas SQL y la limpieza de datos. Esto les da a los científicos de datos humanos tiempo para centrarse en formular las preguntas adecuadas y comprender el significado de los resultados.

Atención sanitaria

La IA en el ámbito sanitario se encuentra en un terreno complicado. Potencial real, pero implementación cautelosa, lo cual probablemente sea adecuado dada la importancia de lo que está en juego.

El descubrimiento de fármacos con ayuda de la inteligencia artificial se está acelerando. AlphaFold y otras herramientas similares predicen las estructuras de las proteínas en cuestión de horas, en lugar de años. El cribado de compuestos se realiza a escalas que antes eran inviables. Algunas estimaciones sugieren que la IA podría reducir los plazos de desarrollo de medicamentos en cuatro o cinco años por fármaco.

Los diagnósticos también han mejorado en áreas específicas, siendo la radiología, la patología y la oftalmología las que más han avanzado. La IA entrenada en imágenes médicas puede encontrar patrones que los revisores humanos pasan por alto.

Según McKinsey, la Clínica Mayo ha ampliado tu plantilla de radiología en más de un 50 % desde 2016, al tiempo que ha implementado cientos de modelos de inteligencia artificial. Esa combinación es notable: La IA complementó el trabajo en lugar de sustituir a las personas.

Sin embargo, es lógico actuar con cautela. Las decisiones sanitarias tienen consecuencias que las recomendaciones en las redes sociales no tienen: Los diagnósticos erróneos pueden perjudicar a los pacientes. La exigencia científica y médica de comprender cómo los modelos llegan a sus conclusiones, y no solo si son precisos, crea limitaciones reales.

La realidad a corto plazo es la IA como asistente de diagnóstico. Los sistemas pueden señalar posibles problemas, sugerir pruebas y detectar aspectos que podrían pasar desapercibidos en entornos muy activos. Pero, al final, los médicos toman las decisiones finales y mantienen las relaciones con los pacientes.

La monitorización remota se está acelerando a medida que los modelos de lenguaje pequeños pasan directamente a los dispositivos wearables. Al procesar los datos localmente en el dispositivo, estos sistemas minimizan la latencia y garantizan la privacidad, utilizando la inteligencia artificial para señalar solo anomalías específicas para su revisión por parte de personas.

Finanzas

Los servicios financieros fueron pioneros en la adopción de la IA, ya que hace años dominaban la detección de fraudes a alta velocidad, pero las capacidades agentivas están impulsando al sector hacia nuevos territorios.

Mientras que las herramientas establecidas se encargan del fraude y las consultas rutinarias de atención al cliente, la frontera activa es ahora la hiperpersonalización. Los nuevos sistemas pueden analizar la tolerancia al riesgo y los objetivos financieros individuales para ofrecer estrategias sofisticadas de gestión patrimonial a un público mucho más amplio.

Sin embargo, este avance viene acompañado de una advertencia: los reguladores están examinando cada vez más estos modelos para garantizar que los algoritmos no reproduzcan los sesgos históricos de los datos sobre préstamos.

Retos y regulación de la IA

Las limitaciones técnicas y las lagunas normativas crean restricciones reales sobre lo que la IA puede hacer de forma responsable. El problema de la caja negra, la desinformación generada y un panorama normativo fragmentado determinan lo que realmente se puede implementar frente a lo que es teóricamente posible.

Cuestiones técnicas y sociales

El problema de la caja negra no se ha resuelto. Cuando los modelos toman decisiones, sigue siendo difícil comprender por qué. Esto es problemático cuando las decisiones afectan a los préstamos, el empleo y la atención médica.

La investigación se centra en la interpretabilidad. El profesorado del HAI de Stanford espera que se preste más atención a lo que ustedes denominan «arqueología de las redes neuronales de alto rendimiento» en 2026. Técnicas como los autoencoders dispersos ayudan a identificar qué características de entrenamiento realmente impulsan el comportamiento.

El contenido generado crea más problemas: Los deepfakes y la desinformación producida por la inteligencia artificial son cada vez más difíciles de detectar. Algunas estimaciones sugieren que los artículos generados por IA en Internet ya podrían superar en volumen al contenido escrito por humanos.

El colapso del modelo puede ser una consecuencia y es otro tema que preocupa a los investigadores. Si los modelos se entrenan cada vez más con contenido generado por IA, que constituye una parte cada vez mayor de los datos disponibles, la calidad podría degradarse. Los modelos están consumiendo sus propios resultados de formas que agravan los errores.

Panorama normativo

Las jurisdicciones están adoptando diferentes enfoques.

La Ley de IA de la UE es el reglamento sobre IA más amplio que existe actualmente. Se basa en una escala de riesgo: cuanto mayor es el riesgo, mayores son las obligaciones. Los sistemas utilizados en las decisiones sobre empleo y crédito se encuentran en la categoría de «alto riesgo», lo que implica requisitos más estrictos en materia de documentación, controles y supervisión.

La ley entró en vigor el 1 de agosto de 2024, pero la mayoría de las obligaciones se aplicarán de forma gradual a lo largo de los próximos años.

La energía se presenta de una forma más limitada y práctica: es posible que los proveedores de modelos de IA de uso general tengan que documentar el consumo energético (o proporcionar estimaciones derivadas del cálculo cuando no sea posible realizar mediciones exactas). Aparte de la Ley de IA, se están endureciendo los requisitos de información sobre los centros de datos y la eficiencia energética de la UE, lo cual es importante porque las cargas de trabajo de IA son un nuevo factor importante que impulsa la demanda de electricidad.

En la práctica, esto lleva a los equipos a optar por una arquitectura «suficientemente buena» que prioriza la eficiencia sobre la potencia bruta. Al utilizar modelos más pequeños y ejecutar la inferencia en el borde, los programadores pueden procesar menos tokens a través de costosos sistemas en la nube, lo que en última instancia reduce los costes de computación, el consumo de energía y la transferencia de datos.

En Estados Unidos, la situación está mucho menos definida. La legislación federal sigue estancada y, con el fracaso de los esfuerzos de 2025 por anular las normas estatales, el entorno normativo se está fragmentando. En consecuencia, hasta 2026, los constructores se enfrentan a un objetivo cambiante de cumplimiento por parte de cada estado, en lugar de un marco federal unificado.

Preparándote para el futuro de la IA

¿Qué es lo que realmente ayuda a mantener la relevancia profesional? Para prepararte, te sugiero que estudies conceptos relacionados con la IA, desarrolles habilidades en áreas técnicas y adquieras experiencia práctica.

Conocimientos sobre datos e inteligencia artificial

La alfabetización en datos ya no es opcional. No es necesario ser un científico de datos, pero sí hay que comprender cómo se mueven los datos, qué los hace fiables y cómo interpretar los resultados de los modelos.

Si necesitas una base estructurada, el trayectoria profesional en alfabetización de datos el programa cubre todos los aspectos esenciales y te ofrece una certificación para demostrar lo que has aprendido. Para una introducción teórica más orientada a la IA, recomiendo inscribirse en el curso Fundamentos de IA.

Habilidades técnicas

Las habilidades técnicas básicas siguen siendo el factor diferenciador. Las herramientas de IA hacen que la programación sea más accesible, pero aún así es necesario comprender la lógica para verificar el resultado. Python y SQL son los «motores diarios» aquí.

Un enfoque sólido consiste en aprender primero el lenguaje y luego la capa de IA. Empieza con Introducción a Python para comprender la sintaxis. A continuación, sigue con Conceptos de IA generativa para comprender cómo se comportan los asistentes modernos y en qué aspectos fallan.

Experiencia en el sector y agentes

El mayor cambio es el paso de los chatbots a los agentes. El mero hecho de dar indicaciones se está convirtiendo en algo habitual. El valor reside en diseñar flujos de trabajo que se integren con los sistemas del mundo real.

La experiencia en el sector conserva su valor. Conocer bien las herramientas de IA, combinado con un profundo conocimiento del campo, produce más que cualquiera de ellos por separado. La forma más rápida de hacer realidad esa combinación es elegir un flujo de trabajo de dominio y aprender cómo se integrarían los agentes en él.

Para comprender esta arquitectura, inscríbete en nuestro curso Fundamentos de los agentes de IA programa para adquirir el modelo mental. Una vez que hayas cubierto la parte teórica, haz el Diseño de sistemas agenticos con LangChain para obtener experiencia práctica en la construcción de un sistema funcional de principio a fin. Ver dónde fallan estos agentes es tan valioso como verlos funcionar.

Gestionar la incertidumbre

Por último, aprende a sentirte cómodo con la incertidumbre. Los resultados de los modelos de IA son probabilísticos, por lo que a veces son erróneos. Comprender los modos de fallo es fundamental para cualquiera que desarrolle herramientas orientadas al cliente. Debes estar familiarizado con conceptos como colapso del modelo (cómo los datos sintéticos degradan los modelos) y la mecánica que hay detrás de los deepfakes.

Para mantener el ritmo de la industria en lugar del ciclo de exageración, sigue a los profesionales. Las 13 mejores conferencias sobre IA para 2026 es un buen lugar para descubrir dónde comparan los ingenieros sus notas sobre lo que realmente funciona en la producción.

Conclusión

El profesorado de Stanford ha caracterizado recientemente el momento actual como un cambio «del evangelismo a la evaluación». Esa formulación refleja perfectamente la realidad. Estamos dejando atrás la cuestión de si la IA es importante y entrando en los detalles concretos de dónde ayuda y cómo implementarla de forma responsable.

Aunque los plazos de la IGA siguen siendo especulativos y el panorama normativo cambia, la dirección práctica es clara: La IA agencial entrará en los flujos de trabajo de las empresas, y los modelos pequeños se encargarán de las tareas rutinarias. El tema recurrente es el aumento, no la sustitución. El futuro más interesante no es aquel en el que la IA lo hace todo, sino aquel en el que los humanos diseñan los sistemas que amplifican su propia experiencia.

La mejor estrategia ahora es muy clara: Utiliza las herramientas, mantén un escepticismo saludable tanto ante el optimismo excesivo como ante el pesimismo, y considera el aprendizaje como un proceso continuo. Los cambios se están produciendo independientemente de tu preparación, ¡así que es mejor que tomes las riendas!

Preguntas frecuentes sobre el futuro de la IA

¿Qué es la IA agencial y por qué es importante?

A diferencia de los chatbots estándar, que responden a una pregunta cada vez, la IA agencial crea y ejecuta un plan para alcanzar un objetivo. Si le pides que reserve un viaje a Madrid, no solo te muestra una lista de vuelos, sino que compara hoteles de forma autónoma, comprueba tu calendario y finaliza la reserva. Deloitte predice que el 75 % de las empresas invertirán en sistemas agenticos a finales de 2026.

¿Cuándo alcanzaremos la Inteligencia Artificial General (AGI)?

No hay consenso entre los expertos. Las estimaciones optimistas, como las que comenta Dario Amodei, sugieren que, si se mantienen las tendencias actuales (lo cual él duda), sería posible a finales de 2026 o en 2027. Otros, como Demis Hassabis, lo ven como un viaje de entre 5 y 10 años, mientras que los escépticos como Gary Marcus creen que está mucho más lejos. Una encuesta realizada en 2023 entre investigadores situó la predicción media alrededor de 2047.

¿La IA te quitará tu trabajo?

Es poco probable que la IA sustituya funciones completas de forma generalizada. El Foro Económico Mundial prevé un resultado «neto positivo» hasta 2030, con 92 millones de puestos de trabajo desplazados, pero 170 millones creados. El cambio se producirá en las tareas más que en los títulos, ya que la IA automatizará el trabajo rutinario. Esto ejerce presión sobre los puestos de atención al cliente y entrada de datos, mientras que los trabajos que requieren un juicio complejo y ambigüedad deberían seguir estando a salvo.

¿Qué son los modelos de lenguaje pequeños (SLM)?

Los SLM son versiones compactas de modelos de IA diseñados para tareas específicas en lugar de para conocimientos generales. Al ser más pequeños, pueden ejecutarse directamente en dispositivos (como teléfonos inteligentes), lo que ofrece menores costes y una mayor privacidad de los datos. Gartner prevé que, para 2027, las organizaciones utilizarán estos modelos especializados tres veces más que los modelos generales de uso masivo.

¿Cómo está cambiando la IA el desarrollo de software?

La IA se ha convertido en una herramienta habitual para los programadores. Según GitHub, el 41 % del código de los proyectos asistidos por Copilot ha sido generado por IA. Las herramientas modernas ahora pueden comprender repositorios de proyectos completos, no solo archivos individuales. Sin embargo, un estudio reveló que, aunque los programadores experimentados sentían que eran más rápidos utilizando la IA, en realidad completaban las tareas más lentamente.

Josep es Científico de Datos y Gestor de Proyectos en la Agencia Catalana de Turismo, utilizando datos para mejorar la experiencia de los turistas en Cataluña. Su experiencia incluye la gestión del almacenamiento y procesamiento de datos, junto con la analítica avanzada y la comunicación eficaz de las perspectivas de los datos.

También es un dedicado educador, que imparte clases en el Máster de Big Data de la Universidad de Navarra, y contribuye regularmente con artículos perspicaces sobre ciencia de datos en Medium y KDNuggets.

Es Licenciado en Ingeniería Física por la Universidad Politécnica de Cataluña y Máster en Sistemas Interactivos Inteligentes por la Universidad Pompeu Fabra.

En la actualidad, se dedica con pasión a hacer que las tecnologías relacionadas con los datos sean más accesibles a un público más amplio a través de la publicación de Medium ForCode'Sake.