Cursus

Lorsque chatGPT a été lancé en novembre 2022, attirant une centaine de millions d'utilisateurs en seulement deux mois, j'ai honnêtement considéré qu'il s'agissait d'un chatbot surestimé. Cette évaluation s'est avérée peu pertinente. Aujourd'hui, je (et presque tous mes collègues) utilisons quotidiennement des outils de codage basés sur l'IA, et les anciens débats de 2023 sur la capacité d'un bot à rédiger un e-mail correct semblent complètement dépassés. Quel est donc l'avenir de l'IA ?

L'industrie a dépassé ces questions initiales pour atteindre une échelle complètement différente. Anthropic a récemment dépassé les 7 milliards de dollars de revenus récurrents, et les géants de la technologie investissent dans les centres de données à des niveaux qui auraient semblé considérables il y a cinq ans. Par conséquent, la question qui importe désormais n'est plusde savoir si l'IA fonctionne, mais ce qui se passe lorsqu'elle cesse d'attendre des instructions et commence à décider elle-même de la marche à suivre.

Cet article traite de la direction que semble prendre cette technologie. Je vais examiner l'IA agentique, le débat animé sur le calendrier de l'AGI et l'essor des modèles plus petits que vous pouvez exécuter localement. Nous examinerons également les changements en matière d'emploi, les outils de codage, les applications dans le domaine de la santé et la situation réglementaire. Commençons sans plus attendre.

Si vous n'êtes pas encore familier avec certains concepts de l'IA, je vous recommande notre parcours de compétences « Principes fondamentaux de l'IA » , qui couvre toutes les notions de base que vous devez connaître dans le cursus.

De l'IA générative à l'IA agentique

Le modèle de chatbot interactif est progressivement remplacé par une approche plus autonome. Cette section décrit à quoi ressemble ce changement dans la pratique, où se situent les véritables défis de mise en œuvre et pourquoi la plupart des organisations rencontrent encore des difficultés pour mettre les agents en production.

L'émergence des agents autonomes

Au cours des deux dernières années, les outils d'IA ont suivi un rythme prévisible. Vous demandez, il répond. L'humain conduisait, et l'IA était présente pour l'accompagner. Cette dynamique est en train de changer : L'IA agentique ne se contentent pas de répondre à des questions ; elles élaborent des plans pour atteindre des objectifs.

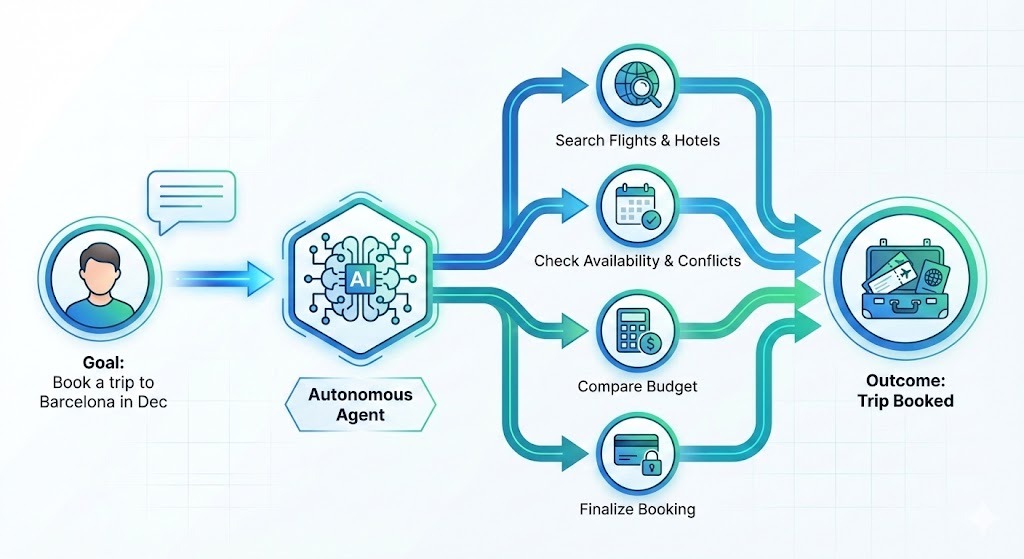

Supposons que vous souhaitiez réserver un voyage à Barcelone en décembre. Au lieu de vous fournir une liste d'hôtels à examiner, un agent procéderait comme suit :

- Rechercher des options

- Veuillez filtrer selon vos préférences.

- Vérifiez que les prix correspondent à votre budget.

- Veuillez vérifier votre calendrier pour éviter tout conflit.

- Effectuer la réservation

Vous décrivez un résultat, et le système gère les étapes nécessaires pour y parvenir.

L'intérêt des entreprises pour ce sujet est considérable. Deloitte prévoyant que 75 % des entreprises investiront dans l'IA agentique d'ici fin 2026. Cependant, la réalité est actuellement en retard par rapport à la vision. Une enquête UiPath réalisée mi-2025 enquête UiPath a révélé que, malgré un intérêt marqué, seuls 30 % des déploiements d'agents aboutissent réellement à la production.

Combler le fossé avec MCP

Pourquoi cet écart ? L'intégration, principalement. Lorsque les chercheurs ont interrogé les entreprises sur les obstacles rencontrés, 46 % ont mentionné la connexion des agents IA aux systèmes existants. Écrire un agent capable de rédiger du code constitue un défi. Le faire fonctionner de manière fiable avec votre CRM, votre plateforme de billetterie, vos API internes, sans causer de dysfonctionnements ni créer de nouveaux problèmes, s'avère être un défi tout à fait différent.

Pour résoudre ce problème, le secteur se mobilise autour de normes ouvertes telles que le Model Context Protocol (MCP) d'Anthropic et la spécification AGENTS.md d'OpenAI, qui visent toutes deux à assurer une gestion neutre des infrastructures ouvertes et ont été intégrées à l'Agentic AI Foundation. Fondation Agentic AI.

Le MCP, en particulier, a connu un grand succès. Considérez-le comme un « USB-C pour l'IA », un connecteur standard permettant aux agents de communiquer facilement avec différents outils et plateformes. Pour n'en citer que quelques-uns, il offre une intégration avec Claude, Cursor, Microsoft Copilot, VSCode, Gemini et chatGPT.

Si vous souhaitez aller au-delà des démonstrations, veuillez consulter nos cours sur l' IA agentique pour découvrir les concepts et Conception de systèmes agentique avec LangChain pour une application pratique.

L'intelligence artificielle générale (AGI) est-elle proche ?

Le calendrier de l'intelligence artificielle générale (AGI) l'intelligence artificielle générale (AGI), c'est-à-dire des systèmes d'IA capables d'effectuer des tâches à un niveau humain dans tous les domaines, dépend entièrement de la personne à qui vous posez la question.

Les PDG des principaux laboratoires d'IA sont déterminés : Dario Amodei, d'Anthropic, a suggéré 2026-2027 pour les systèmes qui correspondent aux lauréats du prix Nobel dans tous les domaines (« un pays de génies dans un centre de données »). De même, Sam Altman et Demis Hassabis évoquent les trois à cinq prochaines années.

Il convient de noter que ces entreprises dépendent de l'enthousiasme des investisseurs pour financer des recherches coûteuses, de sorte que des calendriers optimistes ont une fonction stratégique.

Les sceptiques adoptent une position plus modérée. Gary Marcus qualifie les derniers mois de « dévastateurs » pour l'optimisme envers l'AGI, et l'ancien chercheur d'OpenAI Andrej Karpathy estime que l'AGI n'est pas près d'arriver avant au moins une décennie. Une vaste enquête menée en 2023 auprès de chercheurs a repoussé la date médiane d'arrivée encore plus loin, à 2047.

En fin de compte, c'est le HAI de Stanford qui propose le cadre le plus pertinent : nous passons de « l'évangélisation à l'évaluation ». La question la plus importante n'est pasde savoir à quel moment l'AGI sera disponible, mais plutôt dans quelle mesure les systèmes actuels sont capables de gérer certaines tâches spécifiques aujourd'hui, par rapport à celles qui nécessitent encore une supervision humaine.

Technologies d'IA émergentes au-delà des LLM

Tout ce qui est intéressant dans le domaine de l'IA ne consiste pas uniquement à développer des modèles plus complexes. Les modèles plus compacts, l'informatique quantique et les jumeaux numériques redéfinissent les possibilités à la pointe de la technologie.

Modèles linguistiques de petite taille (SML) et intelligence artificielle de pointe

Alors que tout le monde évoque des modèles de plus en plus grands, des investissements importants sont réalisés dans des modèles plus petits. Gartner prévoit que les organisations déploieront des modèles linguistiques de petite taille (SML), des modèles spécifiques à certaines tâches, à un rythme trois fois supérieur à celui des grands modèles polyvalents d'ici 2027.

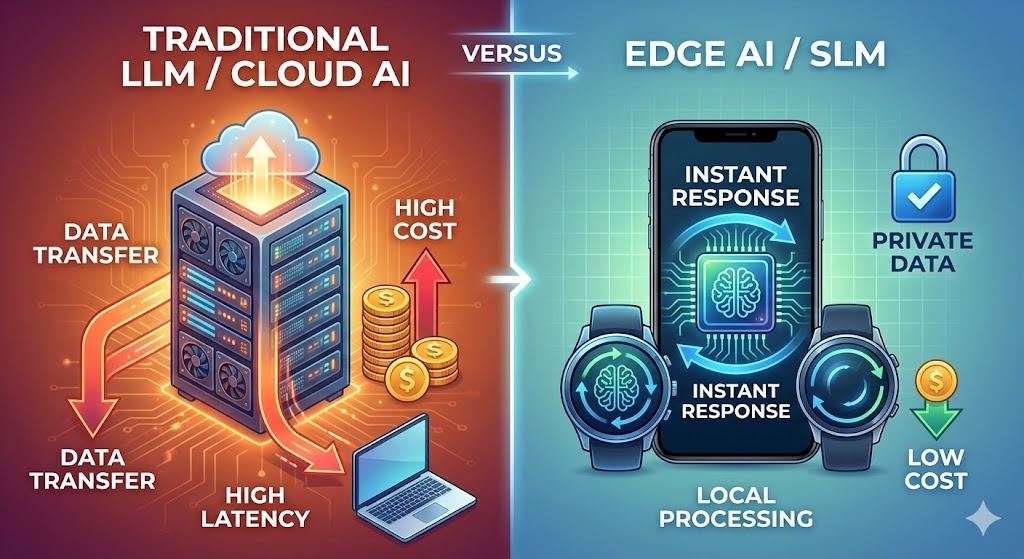

Les raisons sont pratiques :

- Coût : L'exécution de modèles volumineux est coûteuse. OpenAI aurait dépensé près du double de ses revenus en inférence au début de l'année 2025. Les SLM réduisent considérablement ces coûts.

- Confidentialité : Les modèles intégrés à l'appareil conservent les données localement, ce qui est une exigence dans les domaines de la santé et de la finance. Par conséquent, le marché du SLM devrait passer de 930 millions de dollars en 2025 à 5,45 milliards de dollars d'ici 2032.

- Vitesse : L'inférence locale élimine la latence du réseau. Dans le domaine du contrôle qualité en fabrication ou de la détection des fraudes bancaires, chaque milliseconde compte. Le cloud ne peut pas toujours offrir cela.

Les chercheurs de NVIDIA affirment que que la prochaine avancée majeure en matière d'IA ne sera pas une question de taille, mais de spécialisation. Étant donné que des tâches telles que l'analyse syntaxique des e-mails ou les requêtes SQL ne nécessitent pas de connaissances encyclopédiques, l'architecture future ressemble à des flottes de modèles : plusieurs modèles spécialisés travaillant de concert plutôt qu'un seul modèle généraliste massif.

Google, Mistral, Microsoft et Alibaba déploient tous d'importants efforts dans ce domaine. Google AI Edge prend en charge plus d'une douzaine de modèles, dont Gemma 3n, leur premier modèle multimodal sur appareil.

Comparaison des approches des SLM et des LLM

Le tableau suivant compare les deux approches. Pour approfondir le sujet, veuillez consulter notre article sur SLM vs LLM.

|

Aspect |

Modèles linguistiques de grande envergure |

Modèles linguistiques de petite taille |

|

Où ils courent |

Serveurs cloud |

Appareils, périphériques, serveurs locaux |

|

Coût par demande |

Plus élevé (fourchette comprise entre 0,01 et 0,10 dollar) |

Fractions de cent |

|

Temps de réponse |

Dépendant du réseau (100 à 500 ms) |

Moins de 50 ms |

|

Traitement des données |

Quitte l'appareil |

Reste local |

|

Personnalisation |

À forte intensité de ressources |

Plus accessible |

|

Idéal pour |

Raisonnement complexe, travail créatif, connaissances étendues |

Tâches spécifiques, fiabilité, rapidité |

|

Consommation d'énergie |

Important |

Modeste |

Les modèles de grande taille ne sont pas en train de perdre leur pertinence. Les problèmes complexes continuent de bénéficier de leur puissance. L'avenir impliquera probablement les deux, avec des questions pertinentes quant au moment opportun pour utiliser chacune d'elles.

La convergence de l'informatique quantique et de l'intelligence artificielle

L'informatique quantique est annoncée depuis « cinq ans » ou plusieurs décennies, mais un changement significatif s'est produit fin 2025, et il convient d'y prêter attention.

Google a démontré une accélération de 13 000 fois supérieure à celle du superordinateur Frontier en utilisant 65 qubits pour des simulations physiques. IBM vise à obtenir un avantage quantique d'ici 2026, et les chercheurs ont commencé à utiliser des réseaux neuronaux pour prédire et corriger les erreurs de qubits en temps réel.

Le domaine est passé d'une promesse théorique à un problème d'ingénierie.

Le terme qui gagne en popularité est « utilité quantique ». Il ne s'agit pas d'un avantage quantique complet pour tous les problèmes, mais plutôt de systèmes quantiques qui résolvent des problèmes spécifiques plus rapidement ou à moindre coût que les alternatives classiques. Les problèmes ciblés sont très mathématiques et impliquent tellement de variables que les ordinateurs classiques sont incapables de les traiter :

- Optimisation de la composition chimique des batteries

- Criblage de composés médicamenteux

- Modélisation des risques liés au portefeuille

Les chercheurs de JPMorgan Chase ont récemment franchi une étape importante avec un algorithme de streaming quantique qui traite de grands ensembles de données avec un avantage exponentiel en termes d'espace. Ceci n'est pas un communiqué de presse. Il s'agit d'un travail évalué par des pairs et dont les résultats sont mesurables.

Cela étant dit, la fourchette des prévisions est large dans ce cas.

Manifold Markets, qui suit plus de 100 prévisions liées au quantique, fait état d'un scepticisme généralisé quant à la capacité des ordinateurs quantiques à surpasser les systèmes classiques en matière de cryptographie ou de simulation biologique complexe d'ici 2026. La plupart des observateurs s'attendent à des progrès techniques progressifs, et non à une avancée révolutionnaire.

Cependant, ces mêmes marchés affichent une forte confiance dans l'arrivée, d'ici une dizaine d'années, d'ordinateurs quantiques tolérants aux pannes et réellement utiles.

Qu'est-ce que cela signifie concrètement ?

En réalité, l'ordinateur quantique autonome est un concept théorique. La norme dans le secteur est désormais le « calcul hétérogène » : des architectures hybrides où les processeurs quantiques sont intégrés à des centres de haute performance aux côtés de clusters de GPU, avec des systèmes d'IA gérant le flux de travail.

Pour les scientifiques des données travaillant dans les secteurs de la recherche et du développement, cela crée de nouvelles exigences en matière de compétences. Les API cloud quantiques d'IBM, Google, Amazon Braket et Microsoft Azure Quantum vous permettent d'exécuter des sous-programmes quantiques sans posséder de matériel. La courbe d'apprentissage n'est pas négligeable, mais elle est plus accessible que la construction de votre propre laboratoire quantique.

Le changement d'orientation est subtil mais significatif. Alors que la science des données classique se concentre sur le « big data », l'informatique quantique s'intéresse à « l'optimisation complexe ». Il traite les problèmes liés aux explosions combinatoires, tels que la modélisation moléculaire, la logistique ou les risques financiers impliquant des milliers de facteurs corrélés. Dans ces domaines, les outils quantiques passent du stade théorique à celui de la pertinence.

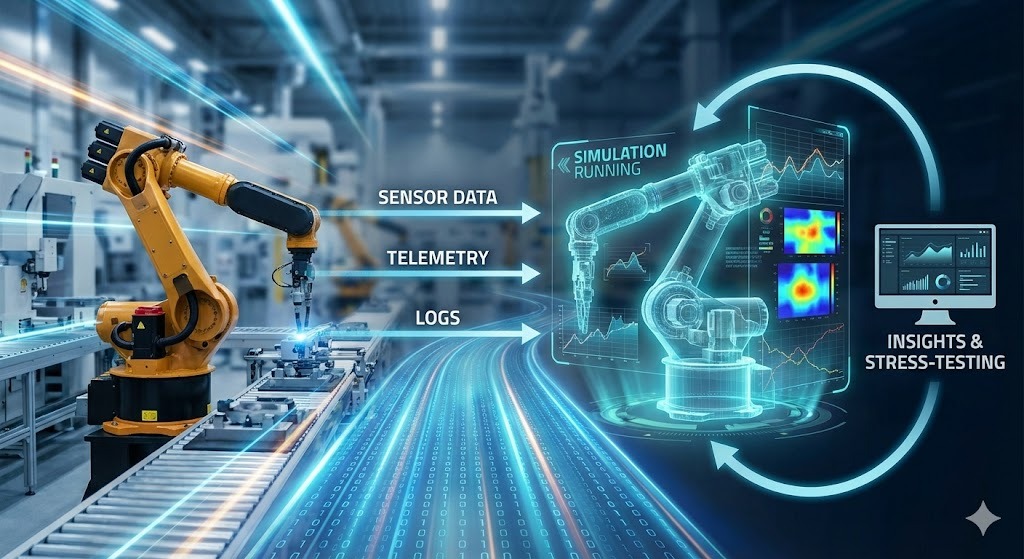

Jumeaux numériques et simulation

Les jumeaux numériques sont en train de passer du statut de mot à la mode à celui d'infrastructure opérationnelle. L'idée est simple : construire une réplique virtuelle active d'un système physique (une chaîne de production, un réseau d'entrepôts, un réseau électrique, un quartier urbain) et la synchroniser avec le système réel à l'aide de capteurs, de journaux et de données opérationnelles. Ensuite, vous utilisez le jumeau pour tester les décisions avant de les mettre en pratique.

Les usines constituent le cas le plus propre. Une usine moderne produit déjà les données dont un jumeau a besoin : Signaux PLC, télémétrie des machines, historique de maintenance, ordres de travail, mesures de qualité, mouvements de stock. L'IA transforme ce flux en un modèle que vous pouvez interroger. Il ne s'agit pas seulement de tableaux de bord, mais également de scénarios contrefactuels. Vous pouvez répondre à des questions telles que :

- Que se passerait-il si une presse à estamper tombait en panne pendant six heures mardi matin ?

- Que se passerait-il si nous remplacions le fournisseur B par le fournisseur C pour ce composant, dont le profil de défauts est légèrement différent ?

- Que diriez-vous de modifier l'horaire des équipes afin que les opérateurs expérimentés se concentrent sur les deux dernières stations ?

La valeur ne consiste pas à prédire la perturbation. Il s'agit de suivre les effets en aval (défauts de livraison, ruptures de stock, coûts de réacheminement) afin de pouvoir prévoir des solutions plutôt que d'improviser à 3 heures du matin.

Le changement déterminant réside dans le fait que l'IA réduit les coûts liés à la création et à la maintenance de ces modèles. Les modèles ML modernes apprennent le comportement directement à partir de données en temps réel, détectant les dérives et maintenant le jumeau aligné à mesure que le système réel évolue.

Les modèles spécialisés de petite taille sont également adaptés à cette situation : un modèle pour la détection des anomalies sur une turbine, un autre pour l'optimisation des plannings, un autre encore pour la prévision de la demande, tous alimentant le même environnement simulé.

Si vous souhaitez obtenir une vision plus précise de ce qui vous attend, nous vous recommandons la lecture de 9 modèles d'apprentissage automatique open source pour 2026 pour exécuter et affiner des modèles sans passer par des fournisseurs, ainsi que Les 13 principales conférences sur l'IA pour 2026, où se tiendront les véritables discussions sur la mise en œuvre.

L'avenir de l'IA dans le monde du travail

Les titres concernant l'impact de l'IA sur l'emploi ont tendance à omettre les nuances présentes dans les données réelles. Le tableau qui se dégage des recherches est plus complexe, plus progressif et probablement moins spectaculaire que ne le suggèrent les optimistes ou les pessimistes.

L'intelligence artificielle est-elle susceptible de remplacer des emplois ?

Les chiffres méritent d'être nuancés davantage que ne le permettent généralement les titres des journaux.

Le Forum économique mondial a interrogé plus de 1 000 employeurs de premier plan dans le cadre de son rapport rapport sur l'avenir de l'emploi en 2025. Ils ont estimé que 170 millions de nouveaux emplois seraient créés et 92 millions supprimés entre 2025 et 2030, soit un gain net de 78 millions d'emplois.

Bien que cela soit globalement positif, la répartition revêt une importance considérable. Dans une étude publiée en novembre 2025, des chercheurs du MIT et de l'université de Boston ont estimé que l'IA remplacerait environ deux millions de travailleurs du secteur manufacturier d'ici 2026.

Il convient de distinguer les tâches des rôles. L'IA a tendance à automatiser certaines tâches spécifiques au sein d'un poste plutôt qu'à supprimer des postes dans leur intégralité. Votre comptable ne partira pas, mais le temps consacré à la saisie et au rapprochement des données diminuera.

Une étude du MIT datant de 2025 estime que les tâches actuellement automatisables représentent environ 11,7 % de l'activité de la main-d'œuvre américaine, ce qui équivaut à environ 1 200 milliards de dollars de salaires. Cela ne signifie pas que 11,7 % des travailleurs perdront leur emploi, mais cela signifie qu'une partie importante de leur travail peut désormais être effectuée par un logiciel.

Les emplois soumis à une pression accrue comprennent :

- Service client, en particulier l'assistance par messagerie instantanée

- Saisie et traitement des données

- Travail administratif suivant des schémas prévisibles

- Certains postes de caissier dans le commerce de détail

- Recherches juridiques courantes et tâches parajuridiques

Les emplois présentant les caractéristiques suivantes seront soumis à moins de pression :

- Gestion du personnel

- Jugement spécialisé

- Situations ambiguës

- Présence physique dans des environnements imprévisibles

Ces modèles s'appliquent notamment aux soins de santé, aux métiers spécialisés, au travail créatif et à la prise de décisions stratégiques.

Nouvelles perspectives de carrière

De nouvelles catégories d'emplois apparaissent, dont certaines n'existaient pas il y a encore cinq ans :

- L'architecte de systèmes d'IA est chargé de concevoir l'intégration des composants d'IA au sein des organisations. Il est nécessaire de combiner à la fois une compréhension technique et une connaissance des processus opérationnels.

- Le métier d'ingénieur prompt est devenu un véritable titre professionnel, bien qu'il évolue vers ce que l'on appelle aujourd'hui le spécialiste en collaboration IA. Comprendre comment travailler efficacement avec ces systèmes, et pas seulement rédiger des contributions pertinentes.

- Le responsable de l'éthique et de la conformité en matière d'IA est chargé des exigences réglementaires et de l'audit. Les organisations ont besoin de personnes qui maîtrisent à la fois les capacités techniques et le cadre juridique afin de minimiser les risques liés aux systèmes d'IA.

- L'entraîneur IA et le conservateur de données gèrent les boucles de rétroaction, l'annotation des cas limites et le contrôle qualité des données d'entraînement.

J'ai constaté que l'expertise dans un domaine, combinée à une bonne maîtrise de l'IA, est ce qui crée de la valeur. Une infirmière qui comprend les outils de diagnostic basés sur l'intelligence artificielle obtient de meilleurs résultats qu'une infirmière qui les évite. Un avocat qui utilise l'IA pour ses recherches tout en connaissant ses limites travaille plus rapidement sans perte de qualité.

Les enquêtes auprès des employeurs classent systématiquement la pensée analytique comme la compétence la plus recherchée. Sept entreprises sur dix le considèrent comme essentiel. La résilience, l'adaptabilité et le leadership sont des qualités essentielles.

Changements spécifiques à l'industrie

Certains domaines ont adopté les outils d'IA plus rapidement que d'autres, et les résultats varient davantage que prévu. Le codage, les soins de santé et la finance offrent chacun une perspective différente sur ce qui fonctionne, ce qui ne fonctionne pas et les éventuelles surprises.

Programmation et science des données

Le développement logiciel a adopté les outils d'IA plus rapidement que la plupart des autres domaines. Les outils continuent d'évoluer.

Selon l'enquête Stack Overflow 2025, enquête Stack Overflow 2025, environ 85 % des développeurs utilisaient régulièrement des outils d'IA à la fin de l'année 2025. GitHub indique que que 41 % du code créé par les utilisateurs de Copilot dans le monde bénéficie de l'assistance de l'IA. Nous avons dépassé le stade de la saisie semi-automatique : Les systèmes actuels comprennent l'ensemble des référentiels et effectuent des modifications sur plusieurs fichiers.

Les leaders du marché se sont imposés : GitHub Copilot détient environ 42 % des parts de marché, avec plus de 20 millions d'utilisateurs et une présence dans 90 % des entreprises du classement Fortune 100. Cursor a atteint une part de marché de 18 % en seulement dix-huit mois. Ils généreraient 500 millions de dollars de revenus récurrents.

Les outils d'IA excellent dans certains types de travaux de codage :

- Formules standard, schémas répétitifs

- Exploration d'API peu familières

- Décryptage du code hérité

Cependant, l'écart entre la perception et la réalité est important.

Dans une étude METR de juillet 2025, des développeurs expérimentés ont utilisé des outils tels que Cursor Pro et Claude 3.5 Sonnet. Ces développeurs ont accompli leurs tâches 19 % plus lentement qu'ils ne l'auraient fait sans l'aide de l'IA, mais ils ont estimé qu'ils travaillaient 20 % plus rapidement.

En conclusion, les gains de productivité dépendent du contexte. Les outils d'IA peuvent en réalité vous ralentir lorsque le type de travail ne correspond pas à leurs points forts et que vous comprenez mieux le système que l'IA.

Actuellement, la tendance est à l'autonomisation accrue des capacités. Projet Padawan de GitHub représente un modèle dans lequel les développeurs attribuent des tâches aux systèmes d'IA, l'IA les met en œuvre et représente un modèle dans lequel les développeurs attribuent des tâches à des systèmes d'IA, qui les mettent en œuvre, puis sont examinées par des humains. Le changement consiste à passer d'une IA qui suggère du code à une IA qui complète des fonctionnalités.

En matière de science des données, prévoyez moins de temps pour la préparation et davantage pour l'interprétation. L'IA peut prendre en charge le traitement des requêtes SQL et le nettoyage des données. Cela permet aux scientifiques des données humains de se concentrer sur la formulation des bonnes questions et la compréhension de la signification des résultats.

Soins de santé

L'intelligence artificielle dans le domaine de la santé évolue dans un environnement complexe. Un potentiel réel, mais un déploiement prudent, ce qui est probablement approprié compte tenu des enjeux.

La découverte de médicaments assistée par l'intelligence artificielle progresse rapidement. AlphaFold et d'autres outils similaires prédisent les structures protéiques en quelques heures au lieu de plusieurs années. Le criblage des composés s'effectue à des échelles auparavant irréalisables. Certaines estimations indiquent que l'IA pourrait réduire de quatre à cinq ans le délai de développement d'un médicament.

Les diagnostics se sont également améliorés dans certains domaines spécifiques, notamment en radiologie, en pathologie et en ophtalmologie. L'intelligence artificielle formée à l'imagerie médicale est capable de détecter des schémas que les examinateurs humains ne remarquent pas.

Selon McKinsey, la Mayo Clinic a augmenté ses effectifs en radiologie de plus de 50 % depuis 2016, tout en déployant des centaines de modèles d'IA. Cette combinaison est remarquable : L'IA a amélioré le travail plutôt que de remplacer les personnes.

Cependant, la prudence est de mise. Les décisions en matière de santé ont des conséquences que les recommandations sur les réseaux sociaux n'ont pas : Les diagnostics erronés peuvent nuire aux patients. La nécessité scientifique et médicale de comprendre comment les modèles parviennent à leurs conclusions, et pas seulement s'ils sont précis, crée des contraintes réelles.

À court terme, l'IA servira d'assistant au diagnostic. Les systèmes peuvent signaler les problèmes potentiels, proposer des tests et détecter des éléments qui pourraient passer inaperçus dans des environnements très actifs. Cependant, en fin de compte, ce sont les médecins qui prennent les décisions finales et qui entretiennent les relations avec les patients.

La surveillance à distance s'accélère à mesure que les petits modèles linguistiques s'intègrent directement dans les appareils portables. En traitant les données localement sur l'appareil, ces systèmes minimisent la latence et garantissent la confidentialité, en utilisant l'IA pour signaler uniquement les anomalies spécifiques qui doivent être examinées par un humain.

Finance

Les services financiers ont été parmi les premiers à adopter l'IA, maîtrisant depuis plusieurs années déjà la détection rapide des fraudes, mais les capacités agentives poussent le secteur vers de nouveaux horizons.

Alors que les outils existants traitent les fraudes et les demandes courantes du service client, le domaine d'activité en pleine expansion est désormais l'hyper-personnalisation. De nouveaux systèmes sont en mesure d'analyser la tolérance au risque et les objectifs financiers individuels afin de proposer des stratégies sophistiquées de gestion de patrimoine à une population beaucoup plus large.

Cependant, ces progrès s'accompagnent d'une mise en garde : les régulateurs examinent de plus en plus attentivement ces modèles afin de s'assurer que les biais historiques dans les données sur les prêts ne sont pas reproduits par les algorithmes.

Défis et réglementation liés à l'IA

Les contraintes techniques et les lacunes politiques imposent des limites réelles à ce que l'IA peut accomplir de manière responsable. Le problème de la boîte noire, la désinformation générée et un paysage réglementaire fragmenté déterminent ce qui est réellement déployable par rapport à ce qui est théoriquement possible.

Questions techniques et sociales

Le problème de la boîte noire n'a pas été résolu. Lorsque les modèles prennent des décisions, il est souvent difficile de comprendre pourquoi. Cela pose problème lorsque les décisions ont une incidence sur les prêts, l'emploi et les soins médicaux.

La recherche se concentre sur l'interprétabilité. La faculté HAI de Stanford prévoit une attention accrue pour ce qu'elle appelle « archéologie des réseaux neuronaux hautement performants » en 2026. Des techniques telles que les auto-encodeurs clairsemés permettent d'identifier les caractéristiques de formation qui influencent réellement le comportement.

Le contenu généré pose d'autres problèmes : Les deepfakes et les informations erronées générées par l'IA sont de plus en plus difficiles à détecter. Certaines estimations indiquent que le volume des articles générés par l'IA en ligne pourrait déjà dépasser celui des contenus rédigés par des humains.

L'effondrement des modèles peut être une conséquence et constitue un autre sujet de préoccupation pour les chercheurs. Si les modèles s'entraînent de plus en plus sur du contenu généré par l'IA, qui représente une part croissante des données disponibles, la qualité pourrait se dégrader. Les modèles utilisent leurs propres résultats d'une manière qui aggrave les erreurs.

Cadre réglementaire

Les juridictions adoptent des approches différentes.

La loi européenne sur l'IA est le règlement le plus complet actuellement en vigueur en matière d'IA. Il est structuré autour d'une échelle de risque : plus le risque est élevé, plus les obligations sont importantes. Les systèmes utilisés dans le cadre des décisions en matière d'emploi et de crédit sont classés dans la catégorie « à haut risque », ce qui implique des exigences plus strictes en matière de documentation, de contrôles et de surveillance.

La loi est entrée en vigueur le 1er août 2024, mais la plupart des obligations seront mises en œuvre progressivement au cours des prochaines années.

L'énergie apparaît sous un angle plus restreint et plus pratique : les fournisseurs de modèles d'IA à usage général peuvent être amenés à documenter leur consommation d'énergie (ou à fournir des estimations dérivées des calculs lorsque des mesures exactes ne sont pas possibles). Indépendamment de la loi sur l'IA, les exigences en matière de rapports sur les centres de données et l'efficacité énergétique de l'UE sont renforcées, ce qui est important car les charges de travail liées à l'IA constituent un nouveau facteur majeur de la demande en électricité.

Dans la pratique, cela incite les équipes à adopter une architecture « suffisamment performante » qui privilégie l'efficacité plutôt que la puissance brute. En utilisant des modèles plus petits et en exécutant l'inférence à la périphérie, les développeurs peuvent traiter moins de jetons via des systèmes cloud coûteux, ce qui réduit au final les coûts de calcul, la consommation d'énergie et le transfert de données.

Aux États-Unis, la situation est beaucoup moins stable. La législation fédérale reste dans l'impasse et, avec l'échec des efforts déployés en 2025 pour passer outre les règles établies au niveau des États, l'environnement réglementaire se fragmente. Par conséquent, jusqu'en 2026, les constructeurs seront confrontés à une situation changeante en matière de conformité, qui variera d'un État à l'autre, plutôt qu'à un cadre fédéral unifié.

Se préparer pour l'avenir de l'IA

Qu'est-ce qui contribue réellement à rester compétent sur le plan professionnel ? Pour vous préparer, je vous recommande d'étudier les concepts liés à l'IA, de développer des compétences dans les domaines techniques et d'acquérir une expérience pratique.

Compétences en matière de données et d'IA

La maîtrise des données n'est plus facultative. Il n'est pas nécessaire d'être un expert en science des données, mais il est important de comprendre comment les données circulent, ce qui les rend fiables et comment interpréter les résultats des modèles.

Si vous avez besoin d'une base structurée, le formation Data Literacy Professional couvre tous les éléments essentiels et vous offre une certification attestant de vos acquis. Pour une initiation théorique davantage axée sur l'IA, je recommande de s'inscrire au cours parcours de compétences « Principes fondamentaux de l'IA ». skill cursus.

Compétences techniques

Les compétences techniques de base constituent toujours un facteur de différenciation. Les outils d'IA rendent le codage plus accessible, mais il est toujours nécessaire de comprendre la logique pour vérifier le résultat. Python et SQL sont les principaux outils utilisés quotidiennement ici.

Une approche efficace consiste à apprendre d'abord le langage, puis la couche IA. Commencer par Introduction à Python pour acquérir les bases de la syntaxe. Veuillez suivre cela avec Concepts d'IA générative pour comprendre comment les assistants modernes se comportent et où ils échouent.

Expertise dans le domaine et agents

Le changement le plus important concerne le passage des chatbots aux agents. Le simple fait de suggérer quelque chose devient monnaie courante. La valeur réside dans la conception de flux de travail qui s'intègrent aux systèmes réels.

L'expertise dans un domaine particulier conserve sa valeur. Une bonne connaissance des outils d'IA, combinée à une expertise approfondie dans le domaine, produit des résultats supérieurs à ceux obtenus avec l'un ou l'autre seul. Le moyen le plus rapide de concrétiser cette combinaison consiste à choisir un flux de travail de domaine et à apprendre comment les agents pourraient s'y intégrer.

Pour mieux appréhender cette architecture, nous vous invitons à vous inscrire à notre cours sur les parcours de compétences « Principes fondamentaux des agents IA » cursus pour acquérir le modèle mental. Une fois que vous avez couvert la partie théorique, veuillez prendre la cours « Concevoir des systèmes agentique avec LangChain » pour acquérir une expérience pratique dans la construction d'un système fonctionnel de bout en bout. Il est tout aussi important de comprendre où ces agents échouent que de les observer fonctionner.

Gérer l'incertitude

Enfin, cultivez votre capacité à accepter l'incertitude. Les résultats des modèles d'IA sont probabilistes, ils peuvent donc parfois être erronés. Il est essentiel de bien comprendre les modes de défaillance pour toute personne qui développe des outils destinés aux clients. Vous devriez être familier avec des concepts tels que l'effondrement des modèles (comment les données synthétiques dégradent les modèles) et les mécanismes derrière les deepfakes.

Pour rester en phase avec l'industrie plutôt qu'avec le cycle médiatique, il est recommandé de suivre les professionnels. Les 13 meilleures conférences sur l'IA pour 2026 est un excellent moyen de découvrir où les ingénieurs échangent leurs points de vue sur ce qui fonctionne réellement en production.

Conclusion

Les professeurs de Stanford ont récemment décrit la période actuelle comme un passage de « l'évangélisation à l'évaluation ». Cette formulation reflète parfaitement la réalité. Nous dépassons la question del' , à savoir si l'IA est importante, pour nous intéresser aux détails concrets de ses applications et à la manière de la déployer de manière responsable.

Bien que les délais relatifs à l'AGI restent hypothétiques et que le paysage réglementaire évolue, l'orientation pratique est claire : L'IA agentique sera intégrée aux flux de travail des entreprises, et de petits modèles se chargeront des tâches routinières. Le thème récurrent est l'augmentation, et non le remplacement. L'avenir le plus prometteur n'est pas celui où l'IA accomplit toutes les tâches, mais celui où les humains conçoivent des systèmes qui amplifient leur propre expertise.

La meilleure stratégie à adopter actuellement est simple : Utilisez les outils, gardez un scepticisme sain à l'égard du battage médiatique et des prévisions pessimistes, et considérez l'apprentissage comme un processus continu. Les changements se produisent indépendamment de votre état de préparation, il est donc préférable de prendre les commandes.

Questions fréquentes sur l'avenir de l'IA

Qu'est-ce que l'IA agentique et en quoi est-elle importante ?

Contrairement aux chatbots classiques qui répondent à une question à la fois, l'IA agentique élabore et met en œuvre un plan pour atteindre un objectif. Si vous lui demandez de réserver un voyage à Madrid, il ne se contente pas de vous proposer une liste de vols, mais compare également de manière autonome les hôtels, vérifie votre calendrier et finalise la réservation. Deloitte prévoit que 75 % des entreprises investiront dans des systèmes agentifs d'ici fin 2026.

À quand l'intelligence artificielle générale (AGI) ?

Il n'existe pas de consensus parmi les experts. Des estimations optimistes, telles que celles évoquées par Dario Amodei, suggèrent que la fin de l'année 2026 ou 2027 est envisageable si les tendances actuelles se maintiennent (ce dont il doute). D'autres, comme Demis Hassabis, considèrent qu'il s'agit d'un parcours de 5 à 10 ans, tandis que des sceptiques comme Gary Marcus estiment que l'objectif est beaucoup plus éloigné. Une enquête menée en 2023 auprès de chercheurs a établi la prévision médiane autour de 2047.

L'intelligence artificielle pourrait-elle remplacer mon poste ?

Il est peu probable que l'IA remplace entièrement des postes dans leur intégralité. Le Forum économique mondial prévoit un résultat « positif net » jusqu'en 2030, avec 92 millions d'emplois supprimés, mais 170 millions créés. Le changement concernera davantage les tâches que les titres, l'IA automatisant les tâches routinières. Cela exerce une pression sur les postes liés au service à la clientèle et à la saisie de données, tandis que les emplois nécessitant un jugement complexe et faisant face à l'ambiguïté devraient rester à l'abri.

Que sont les modèles linguistiques de petite taille (SLM) ?

Les SLM sont des versions compactes de modèles d'IA conçus pour des tâches spécifiques plutôt que pour des connaissances générales. Étant donné qu'ils sont plus petits, ils peuvent fonctionner directement sur des appareils (tels que les smartphones), ce qui permet de réduire les coûts et d'améliorer la confidentialité des données. Gartner prévoit que d'ici 2027, les organisations utiliseront ces modèles spécialisés trois fois plus souvent que les modèles généraux à grande échelle.

Comment l'IA transforme-t-elle le développement logiciel ?

L'IA est devenue un outil incontournable pour les programmeurs. Selon GitHub, 41 % du code des projets assistés par Copilot est généré par l'IA. Les outils modernes sont désormais capables de comprendre l'ensemble des référentiels de projet, et non plus seulement des fichiers individuels. Cependant, une étude a révélé que, bien que les développeurs expérimentés aient estimé travailler plus rapidement grâce à l'IA, ils accomplissaient en réalité leurs tâches plus lentement.

Josep est data scientist et chef de projet à l'Office du tourisme de Catalogne, où il utilise les données pour améliorer l'expérience des touristes en Catalogne. Son expertise comprend la gestion du stockage et du traitement des données, associée à des analyses avancées et à la communication efficace des données.

Il est également un éducateur dévoué, enseignant le programme de Master Big Data à l'Université de Navarre, et contribuant régulièrement à des articles perspicaces sur la science des données sur Medium et KDNuggets.

Il est titulaire d'une licence en ingénierie physique de l'université polytechnique de Catalogne et d'une maîtrise en systèmes interactifs intelligents de l'université Pompeu Fabra.

Actuellement, il s'engage avec passion à rendre les technologies liées aux données plus accessibles à un public plus large par le biais de la publication ForCode'Sake sur Medium.