Programa

Quando o chatGPT foi lançado em novembro de 2022, atraindo cem milhões de usuários em apenas dois meses, eu sinceramente achei que era só mais um chatbot superestimado. Essa avaliação não resistiu ao tempo. Hoje, eu (e quase todo mundo com quem trabalho) uso ferramentas de codificação de IA todo dia, e as discussões antigas de 2023 sobre se um bot consegue escrever um e-mail decente parecem completamente ultrapassadas. Então, qual é o futuro da IA?

A indústria já passou dessas questões iniciais e chegou a um nível totalmente diferente. A Anthropic recentemente passou dos US$ 7 bilhões em receita recorrente, e as grandes empresas de tecnologia estão investindo pesado em centros de dados em níveis que pareceriam absurdos há cinco anos. Então, a questão que importa agora não é mais“ ” se a IA funciona, mas o que rola quando ela para de esperar por comandos e começa a decidir o que fazer a seguir.

Este artigo fala sobre para onde a tecnologia parece estar indo. Vou dar uma olhada na IA agênica, no debate acalorado sobre o cronograma da IGA e na ascensão de modelos menores que você pode rodar localmente. Também vamos analisar as mudanças no emprego, as ferramentas de codificação, as aplicações na área da saúde e a situação regulatória. Vamos lá!

Se você ainda não está familiarizado com alguns dos conceitos de IA, recomendo nosso Fundamentos de IA , que aborda todos os conceitos básicos que você precisa saber.

Da IA generativa à IA agênica

O modelo de chatbot de interação bidirecional está dando lugar a uma abordagem mais autônoma. Esta seção fala sobre como essa mudança funciona na prática, quais são os desafios reais da implementação e por que a maioria das organizações ainda tem dificuldade para colocar os agentes em produção.

A ascensão dos agentes autônomos

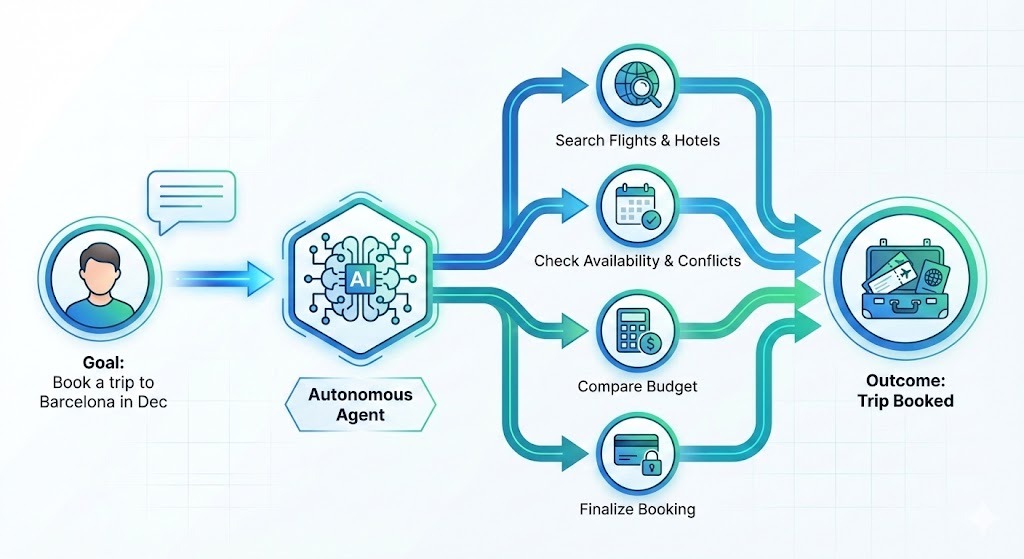

Nos últimos dois anos, as ferramentas de IA seguiram um ritmo previsível. Você pergunta, ele responde. O humano dirigia e a IA estava junto na viagem. Essa dinâmica está mudando: A IA agênica não respondem só perguntas; elas criam planos pra atingir objetivos.

Digamos que você queira reservar uma viagem para Barcelona em dezembro. Em vez de te dar uma lista de hotéis para você pesquisar, um agente faria o seguinte:

- Pesquisar opções

- Filtre de acordo com suas preferências

- Confira se os preços estão dentro do seu orçamento.

- Dá uma olhada na sua agenda pra ver se não tem nenhum conflito.

- Faça a reserva

Você descreve um resultado — o sistema cuida das etapas necessárias para chegar lá.

As empresas estão super interessadas nisso. A Deloitte acha que 75% das empresas vão investir em IA agênica até o final de 2026. Mas, a realidade ainda tá um pouco atrás dessa ideia. Em meados de 2025 UiPath descobriu que, embora o interesse seja grande, só 30% das implementações de agentes realmente chegam à produção.

Preenchendo a lacuna com o MCP

Por que essa diferença? Integração, principalmente. Quando os pesquisadores perguntaram às empresas o que as impedia, 46% apontaram a conexão de agentes de IA com os sistemas já existentes. Escrever um agente que consiga criar código é um desafio. Fazer com que funcione de forma confiável com seu CRM, sua plataforma de tickets, suas APIs internas, sem quebrar nada ou criar novos problemas, acaba sendo um desafio totalmente diferente.

Pra resolver isso, o setor tá se unindo em torno de padrões abertos, tipo o Protocolo de Contexto de Modelo (MCP) da Anthropic e a especificação AGENTS.md da OpenAI, que buscam uma gestão neutra pra infraestrutura aberta e foram contribuídos pra Fundação Agentic AI. Fundação de IA Agente.

O MCP, em especial, ganhou bastante força. Pense nisso como “USB-C para IA” — um conector padrão que permite que os agentes se comuniquem facilmente com diferentes ferramentas e plataformas. Pra citar alguns, ele oferece integração com Claude, Cursor, Microsoft Copilot, VSCode, Gemini e chatGPT.

Se você quiser ir além das demonstrações, confira nossos cursos sobre IA Agente para conceitos e Designing Agentic Systems with LangChain para aplicação prática.

A Inteligência Artificial Geral (AGI) está próxima?

O cronograma para Inteligência Artificial Geral (AGI), sistemas de IA capazes de realizar tarefas em nível humano em vários domínios, depende totalmente de para quem você perguntar.

Os CEOs dos principais laboratórios de IA são agressivos: Dario Amodei, da Anthropic, sugeriu 2026-2027 para sistemas que combinam ganhadores do Prêmio Nobel em várias áreas (“um país de gênios em um centro de dados”). Da mesma forma, Sam Altman e Demis Hassabis apontam para os próximos 3 a 5 anos.

Vale a pena notar que essas empresas dependem do entusiasmo dos investidores para financiar pesquisas caras, então cronogramas otimistas têm um propósito estratégico.

Os céticos têm uma visão mais fria. Gary Marcus diz que os últimos meses foram “devastadores” para o otimismo em relação à IGA, e o ex-pesquisador da OpenAI, Andrej Karpathy, acha que ainda vai demorar pelo menos uma década para a IGA chegar. Uma ampla pesquisa realizada em 2023 com pesquisadores estimou a data média de chegada ainda mais distante, em 2047.

No fim das contas, o HAI da Stanford oferece a estrutura mais útil: estamos passando do “evangelismo para a avaliação”. A questão mais importante não é quando a AGI vai chegar, mas como os sistemas atuais lidam com tarefas específicas hoje em dia em comparação com aquelas que ainda precisam de supervisão humana.

Tecnologias emergentes de IA além dos LLMs

Nem tudo que é interessante na IA envolve fazer modelos maiores. Modelos menores, computação quântica e gêmeos digitais estão mudando o que é possível fazer nas bordas do campo.

Modelos de linguagem pequenos (SMLs) e IA de ponta

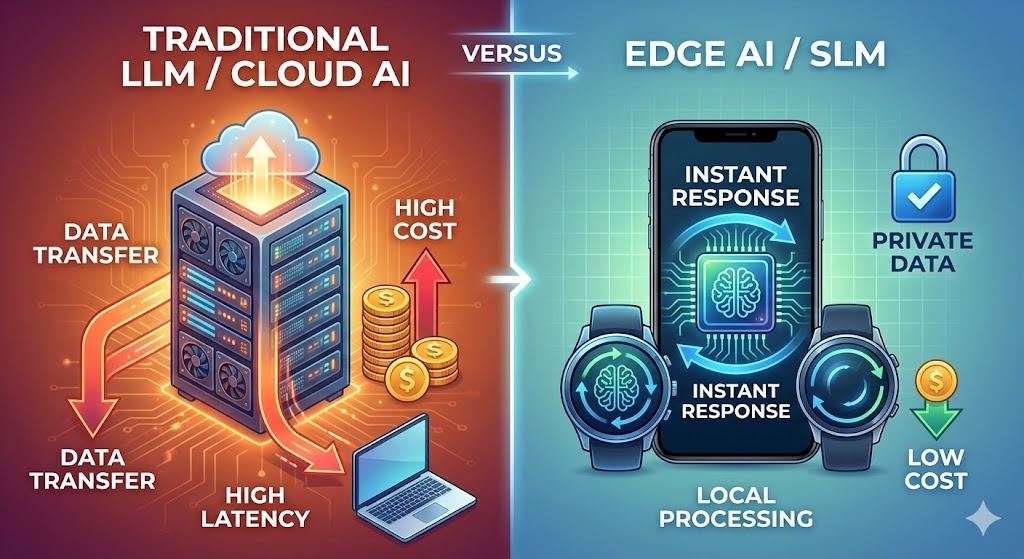

Enquanto todo mundo fala sobre modelos cada vez maiores, um investimento significativo está sendo feito em modelos menores. A Gartner prevê que as organizações vão usar modelos de linguagem pequenos (SMLs), que são modelos específicos para tarefas, três vezes mais rápido do que os grandes modelos de uso geral até 2027.

As razões são práticas:

- Custo: Executar modelos enormes é caro. A OpenAI gastou quase o dobro de sua receita em inferência no início de 2025. Os SLMs reduzem drasticamente esses custos.

- Privacidade: Os modelos no dispositivo mantêm os dados locais, um requisito para os setores de saúde e finanças. Então, o mercado de SLM deve crescer de US$ 930 milhões em 2025 para US$ 5,45 bilhões até 2032.

- Velocidade: A inferência local acaba com a latência da rede. Para o controle de qualidade da fabricação ou a detecção de fraudes no setor bancário, milissegundos fazem toda a diferença. A nuvem nem sempre consegue fazer isso.

Os pesquisadores da NVIDIA acham que o próximo salto na IA não vai ser o tamanho, mas a especialização. Como tarefas como análise de e-mails ou consultas SQL não exigem um conhecimento enciclopédico, a arquitetura do futuro parece com frotas de modelos: vários modelos especializados trabalhando juntos, em vez de um único modelo generalista gigante.

Google, Mistral, Microsoft e Alibaba estão todos se esforçando bastante nessa área. O Google AI Edge dá suporte a mais de uma dúzia de modelos, incluindo o Gemma 3n, o primeiro modelo multimodal no dispositivo deles.

Comparando as abordagens dos SLMs e LLMs

A tabela a seguir compara as duas abordagens. Para saber mais, dá uma olhada no nosso artigo sobre SLMs vs LLMs.

|

Aspecto |

Modelos de linguagem grandes |

Modelos de linguagem pequenos |

|

Onde eles correm |

Servidores em nuvem |

Dispositivos, borda, servidores locais |

|

Custo por solicitação |

Mais alto (faixa de US$ 0,01 a US$ 0,10) |

Frações de centavo |

|

Tempo de resposta |

Depende da rede (100-500 ms) |

Menos de 50 ms |

|

Tratamento de dados |

Sai do dispositivo |

Fica por aqui |

|

Personalização |

Que consome muitos recursos |

Mais acessível |

|

Ideal para |

Raciocínio complexo, trabalho criativo, amplo conhecimento |

Tarefas específicas, confiabilidade, rapidez |

|

Consumo de energia |

Sustancial |

Modesto |

Os modelos grandes não estão ficando obsoletos. Problemas complexos ainda se beneficiam do poder deles. O futuro provavelmente envolve ambos, com questões interessantes sobre quando usar cada um.

A convergência da computação quântica e da IA

A computação quântica está “a cinco anos de distância” ou décadas, mas algo mudou no final de 2025, e vale a pena prestar atenção.

O Google mostrou um aumento de velocidade de 13.000 vezes em relação ao supercomputador Frontier usando 65 qubits para simulações físicas. A IBM quer alcançar a vantagem quântica até 2026, e os pesquisadores já começaram a usar redes neurais para prever e corrigir erros de qubit em tempo real.

O campo passou de uma promessa teórica para um problema de engenharia.

O termo que está ganhando força é “utilidade quântica”. Não se trata de uma vantagem quântica total em todos os problemas, mas sim de sistemas quânticos que resolvem problemas específicos de forma mais rápida ou mais barata do que as alternativas clássicas. Os problemas visados são bem matemáticos, envolvendo tantas variáveis que os computadores clássicos não conseguem lidar:

- Otimização da química da bateria

- Triagem de compostos farmacêuticos

- Modelagem de risco de portfólio

Pesquisadores do JPMorgan Chase recentemente alcançaram um marco com um algoritmo de streaming quântico que processa grandes conjuntos de dados com uma vantagem espacial exponencial. Isso não é um comunicado à imprensa. É um trabalho revisado por especialistas com resultados mensuráveis.

Dito isso, a variação das previsões aqui é grande.

A Manifold Markets, que acompanha mais de 100 previsões relacionadas à computação quântica, mostra um grande ceticismo de que os computadores quânticos vão superar os sistemas clássicos em criptografia ou simulação biológica complexa até 2026. A maioria dos observadores espera um progresso gradual na engenharia, e não uma vantagem quântica revolucionária.

Mas os mesmos mercados mostram uma forte confiança de que computadores quânticos úteis e tolerantes a falhas chegarão dentro de uma década.

O que isso significa na prática?

Na prática, o computador quântico autônomo é um mito. O padrão da indústria agora é a “computação heterogênea”: arquiteturas híbridas onde processadores quânticos ficam dentro de centros de alto desempenho junto com clusters de GPU, com sistemas de IA gerenciando o fluxo de trabalho.

Para os cientistas de dados que trabalham nos setores de P&D, isso cria uma nova exigência de habilidades. As APIs de nuvem quântica da IBM, Google, Amazon Braket e Microsoft Azure Quantum permitem que você execute sub-rotinas quânticas sem precisar ter um hardware. A curva de aprendizado não é fácil, mas é mais acessível do que montar seu próprio laboratório quântico.

A mudança de foco é sutil, mas importante. Enquanto a ciência de dados clássica fica obcecada com “big data”, a computação quântica se preocupa com “otimização complexa”. Ele lida com problemas com explosões combinatórias, como modelagem molecular, logística ou risco financeiro com milhares de fatores relacionados. Nesses campos, as ferramentas quânticas estão passando de teóricas para relevantes.

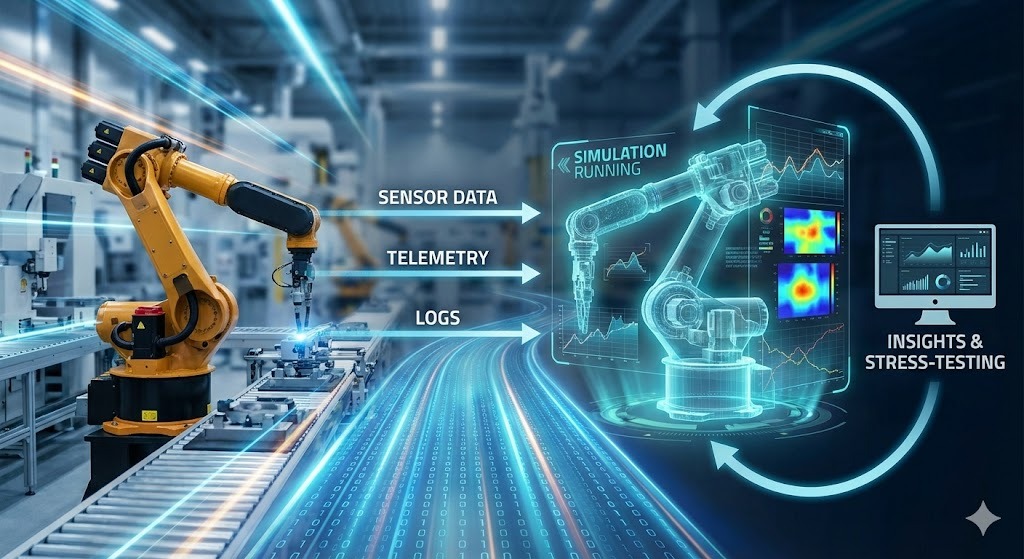

Gêmeos digitais e simulação

Os gêmeos digitais estão deixando de ser só uma palavra da moda e virando uma infraestrutura que funciona mesmo. A ideia é simples: criar uma réplica virtual de um sistema físico (uma linha de fábrica, uma rede de warehouses, uma rede elétrica, um bairro) e mantê-la sincronizada com o sistema real por meio de sensores, registros e dados operacionais. Então você usa o gêmeo para testar as decisões antes de entrar em contato com a realidade.

As fábricas são o caso mais limpo inicial. Uma fábrica moderna já gera os dados que um gêmeo precisa: Sinais PLC, telemetria da máquina, histórico de manutenção, ordens de serviço, medições de qualidade, movimentações de estoque. A IA transforma essa enxurrada de dados num modelo que você pode consultar. Não só painéis, mas também cenários contrafactuais. Você pode responder a perguntas como:

- E se uma prensa de estampagem parar por seis horas na terça de manhã?

- E se trocarmos o fornecedor B pelo fornecedor C para este componente, com um perfil de defeitos ligeiramente diferente?

- E se mudarmos o horário dos turnos para que os operadores experientes se concentrem nas duas últimas estações?

O valor não está em prever a disrupção. Ele rastreia os efeitos a jusante – janelas perdidas, lacunas no estoque, custo de redirecionamento – para que você possa calcular soluções com antecedência, em vez de improvisar às 3 da manhã.

A mudança que está possibilitando isso é que a IA está reduzindo o custo de construção e manutenção desses modelos. Os modelos modernos de ML aprendem o comportamento diretamente a partir de dados em tempo real, detectando desvios e mantendo o gêmeo alinhado à medida que o sistema real muda.

Modelos pequenos e especializados também se encaixam bem aqui: um modelo para detecção de anomalias em uma turbina, outro para otimização de programação, outro para previsão de demanda, todos alimentando o mesmo ambiente simulado.

Se você quer um mapa mais detalhado do que está por vir, dê uma olhada em 9 LLMs de código aberto para 2026 para executar e ajustar modelos sem fornecedores e As 13 principais conferências de IA para 2026, onde rolarão discussões sobre a implementação real.

O futuro da IA no trabalho

As manchetes sobre a IA roubando empregos geralmente não mostram as nuances dos dados reais. O quadro que surge da pesquisa é mais confuso, mais gradual e provavelmente menos dramático do que sugerem tanto os otimistas quanto os pessimistas.

A inteligência artificial vai substituir os empregos?

Os números merecem mais detalhes do que as manchetes normalmente mostram.

O Fórum Econômico Mundial entrevistou mais de 1.000 empregadores importantes para o seu Relatório Futuro dos Empregos 2025. Eles projetaram 170 milhões de novos empregos criados e 92 milhões de deslocados entre 2025 e 2030, um ganho líquido de 78 milhões de empregos.

Embora isso seja positivo, a distribuição é super importante. Num estudo publicado em novembro de 2025, pesquisadores do MIT e da Universidade de Boston estimaram que a IA vai substituir cerca de dois milhões de trabalhadores da indústria até 2026.

A diferença que vale a pena fazer é entre tarefas e funções. A IA costuma automatizar tarefas específicas dentro dos trabalhos com mais frequência do que eliminar cargos inteiros de uma vez. Seu contador não vai a lugar nenhum, mas as horas gastas com entrada de dados e reconciliação estão diminuindo.

Uma pesquisa do MIT de 2025 estimou que as tarefas que podem ser automatizadas hoje cobrem cerca de 11,7% da atividade da força de trabalho dos EUA, o que equivale a aproximadamente US$ 1,2 trilhão em salários. Isso não quer dizer que 11,7% dos trabalhadores vão perder seus empregos, mas sim que uma boa parte do que eles fazem agora pode ser feita por um software.

Os empregos que enfrentam mais pressão incluem:

- Atendimento ao cliente, especialmente suporte por texto

- Entrada e processamento de dados

- Trabalho administrativo seguindo padrões previsíveis

- Algumas vagas de caixa em lojas de varejo

- Pesquisa jurídica de rotina e tarefas paralegais

Os trabalhos que envolvem as seguintes características vão ter menos pressão:

- Gerenciando pessoas

- Julgamento especializado

- Situações confusas

- Estar presente fisicamente em lugares imprevisíveis

Esses padrões se aplicam à área da saúde, ofícios especializados, trabalho criativo e tomada de decisões estratégicas, entre outros.

Carreiras em ascensão

Novas categorias de trabalho estão surgindo, algumas das quais nem existiam há cinco anos:

- O arquiteto de sistemas de IA cuida de projetar como os componentes de IA se encaixam nas organizações. Você precisa juntar o entendimento técnico com o conhecimento dos processos de negócios.

- O Prompt Engineer virou um cargo de verdade, mas tá mudando pra algo que as pessoas chamam de especialista em colaboração com IA. Entender como trabalhar de forma eficaz com esses sistemas, não só escrever entradas inteligentes.

- O Gerente de Ética e Conformidade de IA cuida dos requisitos regulatórios e da auditoria. As organizações precisam de pessoas que entendam tanto as capacidades técnicas quanto o panorama jurídico para minimizar os riscos relacionados aos sistemas de IA.

- O treinador de IA e o curador de dados cuidam dos ciclos de feedback, das anotações de casos extremos e do controle de qualidade dos dados de treinamento.

O padrão que descobri é que o conhecimento especializado na área, junto com a fluência em IA, é o que gera valor. Uma enfermeira que entende as ferramentas de diagnóstico de IA tem resultados melhores do que uma que evita usá-las. Um advogado que usa IA para pesquisa, sabendo dos limites dela, trabalha mais rápido sem perder a qualidade.

Pesquisas com empregadores sempre colocam o pensamento analítico como a habilidade mais procurada. Sete em cada dez empresas acham isso essencial. Resiliência, adaptabilidade e liderança vêm em seguida.

Mudanças específicas do setor

Alguns campos adotaram as ferramentas de IA mais rápido do que outros, e os resultados variam mais do que você imagina. Codificação, saúde e finanças contam histórias diferentes sobre o que funciona, o que não funciona e onde surgem as surpresas.

Programação e ciência de dados

O desenvolvimento de software adotou as ferramentas de IA mais rápido do que a maioria dos campos. As ferramentas estão sempre mudando.

De acordo com a pesquisa Stack Overflow de 2025, pesquisa Stack Overflow de 2025, cerca de 85% dos desenvolvedores usam ferramentas de IA regularmente no final de 2025. Relatórios do GitHub que 41% do código criado por usuários do Copilot no mundo todo tem a ajuda da inteligência artificial. Já passamos da fase do preenchimento automático: Os sistemas atuais entendem repositórios inteiros e fazem alterações em vários arquivos.

Os líderes de mercado surgiram: O GitHub Copilot tem cerca de 42% do mercado, com mais de 20 milhões de usuários e presença em 90% das empresas da Fortune 100. A Cursor surgiu do nada e conquistou 18% do mercado em dezoito meses. Eles estão supostamente faturando US$ 500 milhões em receita recorrente.

As ferramentas de IA são ótimas em certos tipos de trabalho de codificação:

- Padrões repetitivos e clichês

- Explorando APIs desconhecidas

- Decifrando código legado

Mas, a diferença entre o que a gente pensa e o que realmente acontece é importante.

Em um estudo METR de julho de 2025, desenvolvedores experientes usaram ferramentas como Cursor Pro e Claude 3.5 Sonnet. Esses desenvolvedores fizeram as tarefas 19% mais devagar do que sem a ajuda da IA, mas achavam que estavam trabalhando 20% mais rápido.

A lição é que o aumento da produtividade depende do contexto. As ferramentas de IA podem, na verdade, atrasar o seu trabalho quando o tipo de tarefa não combina com os pontos fortes delas e você entende o sistema melhor do que a própria IA.

Hoje em dia, a tendência é ter mais recursos autônomos. O representa um modelo em que os desenvolvedores atribuem problemas aos sistemas de IA, a IA implementa e os humanos revisam. representa um modelo em que os desenvolvedores atribuem problemas aos sistemas de IA, a IA os implementa e os humanos os revisam. A mudança vai da IA sugerindo código para a IA completando recursos.

Para a ciência de dados, espere menos tempo na preparação e mais na interpretação. A IA pode assumir o controle das consultas SQL e da limpeza de dados. Isso dá aos cientistas de dados humanos tempo para se concentrarem em fazer as perguntas certas e entender o que os resultados significam.

Saúde

A IA na área da saúde é um assunto complicado. Potencial real, mas implantação cautelosa – o que provavelmente é apropriado, considerando o que está em jogo.

A descoberta de medicamentos com ajuda da inteligência artificial está a acelerar. AlphaFold e ferramentas parecidas conseguem prever estruturas de proteínas em horas, em vez de anos. A triagem de compostos acontece em escalas que antes eram impossíveis. Algumas estimativas sugerem que a IA poderia reduzir o tempo de desenvolvimento de medicamentos em quatro ou cinco anos por medicamento.

Os diagnósticos também melhoraram em áreas específicas, com radiologia, patologia e oftalmologia sendo as que mais avançaram. A IA treinada em imagens médicas consegue encontrar padrões que os revisores humanos deixam passar.

De acordo com a McKinsey, a Mayo Clinic aumentou sua equipe de radiologia em mais de 50% desde 2016, ao mesmo tempo em que implementou centenas de modelos de IA. Essa combinação é notável: A IA ajudou no trabalho, em vez de substituir as pessoas.

Mas é bom ter cuidado. As decisões sobre saúde têm consequências que as recomendações nas redes sociais não têm: Diagnósticos errados podem prejudicar os pacientes. A necessidade científica e médica de entender como os modelos chegam às conclusões, e não só se são precisos, cria limitações reais.

A realidade a curto prazo é a IA como assistente de diagnóstico. Os sistemas podem sinalizar possíveis problemas, sugerir testes e detectar coisas que podem passar despercebidas em ambientes movimentados. Mas, no final das contas, os médicos tomam as decisões finais e mantêm o relacionamento com os pacientes.

O monitoramento remoto está ficando mais rápido à medida que pequenos modelos de linguagem passam a ser usados diretamente em dispositivos vestíveis. Ao processar os dados localmente no dispositivo, esses sistemas minimizam a latência e garantem a privacidade, usando IA para sinalizar apenas anomalias específicas para revisão humana.

Finanças

Os serviços financeiros foram os primeiros a usar a IA, já dominando a detecção rápida de fraudes há anos, mas as capacidades de agência estão levando o setor a novos territórios.

Enquanto as ferramentas já conhecidas cuidam de fraudes e perguntas rotineiras de atendimento ao cliente, a grande novidade agora é a hiperpersonalização. Novos sistemas podem analisar a tolerância individual ao risco e as metas financeiras para oferecer estratégias sofisticadas de gestão de patrimônio a uma população muito mais ampla.

Mas, esse progresso vem com um aviso: os reguladores estão cada vez mais de olho nesses modelos para garantir que os vieses históricos nos dados de empréstimos não sejam reproduzidos pelos algoritmos.

Desafios e regulamentação da IA

Limitações técnicas e lacunas nas políticas criam restrições reais ao que a IA pode fazer de forma responsável. O problema da caixa preta, a desinformação gerada e um cenário regulatório fragmentado moldam o que é realmente implantável em comparação com o que é teoricamente possível.

Questões técnicas e sociais

O problema da caixa preta ainda não foi resolvido. Quando os modelos tomam decisões, ainda é difícil entender o porquê. Isso é complicado quando as decisões afetam empréstimos, empregos e assistência médica.

A pesquisa foca na interpretabilidade. O corpo docente da Stanford HAI espera que a gente preste mais atenção no que eles chamam de “arqueologia das redes neurais de alto desempenho” em 2026. Técnicas como autoencoders esparsos ajudam a identificar quais recursos de treinamento realmente influenciam o comportamento.

O conteúdo gerado cria mais problemas: Deepfakes e desinformação produzida por IA estão ficando cada vez mais difíceis de detectar. Algumas estimativas sugerem que os artigos gerados por IA online já podem ter mais conteúdo do que os escritos por humanos.

O colapso do modelo pode ser uma consequência e é outra questão que preocupa os pesquisadores. Se os modelos forem cada vez mais treinados com conteúdo gerado por IA, que é uma parte cada vez maior dos dados disponíveis, a qualidade pode piorar. Os modelos estão usando seus próprios resultados de maneiras que aumentam os erros.

Cenário regulatório

As jurisdições estão adotando diferentes abordagens.

A Lei da IA da UE é o regulamento mais abrangente sobre IA atualmente em vigor. É baseado numa escala de risco: quanto maior o risco, mais pesadas são as obrigações. Os sistemas usados em decisões de emprego e crédito estão na categoria de “alto risco”, o que significa requisitos mais rigorosos em relação à documentação, controles e supervisão.

A lei entrou em vigor em 1º de agosto de 2024, mas a maioria das obrigações vai ser implementada em etapas ao longo dos próximos anos.

A energia aparece de uma forma mais restrita e prática: quem fornece modelos de IA de uso geral pode precisar documentar o uso de energia (ou dar estimativas baseadas em cálculos quando não dá pra fazer medições exatas). Além da Lei da IA, os relatórios sobre centros de dados e eficiência energética da UE estão ficando mais rigorosos, o que é importante porque as cargas de trabalho de IA são um novo fator importante para a demanda de eletricidade.

Na prática, isso leva as equipes a buscar uma arquitetura “boa o suficiente” que prioriza a eficiência em vez da potência bruta. Usando modelos menores e fazendo inferência na borda, os desenvolvedores podem processar menos tokens em sistemas de nuvem caros, reduzindo custos de computação, consumo de energia e transferência de dados.

Nos EUA, a situação é bem menos estável. A legislação federal continua em impasse e, com o fracasso das tentativas de 2025 de anular as regras estaduais, o ambiente regulatório está se fragmentando. Então, até 2026, as construtoras vão ter que lidar com regras diferentes em cada estado, em vez de um sistema federal único.

Preparando-se para o futuro da IA

O que realmente ajuda a manter a relevância profissional? Pra se preparar, eu sugiro estudar conceitos relacionados à IA, desenvolver habilidades em áreas técnicas e ganhar experiência prática.

Conhecimento sobre dados e IA

A alfabetização de dados não é mais opcional. Você não precisa ser um cientista de dados, mas precisa entender como os dados se movem, o que os torna confiáveis e como interpretar os resultados dos modelos.

Se você precisa de uma base estruturada, o Curso Profissional de Alfabetização de Dados o programa cobre todos os fundamentos essenciais e oferece uma certificação para mostrar o que você aprendeu. Pra quem quer começar com uma base teórica mais voltada pra IA, recomendo se inscrever no curso Fundamentos de IA.

Habilidades técnicas

As habilidades técnicas básicas continuam sendo o diferencial. As ferramentas de IA tornam a codificação mais acessível, mas você ainda precisa entender a lógica para verificar o resultado. Python e SQL são os “motores diários” aqui.

Uma boa ideia é aprender primeiro a linguagem e depois a parte de inteligência artificial. Comece com Introdução ao Python para entender a sintaxe. Depois, dá uma olhada em Conceitos de IA Generativa para entender como os assistentes modernos funcionam — e onde eles falham.

Conhecimento especializado e agentes

A maior mudança é dos chatbots para os agentes. A simples sugestão está se tornando algo comum. O valor está em criar fluxos de trabalho que se juntam com os sistemas do mundo real.

A experiência no setor mantém o valor. Conhecer bem as ferramentas de IA, junto com um conhecimento profundo da área, traz mais resultados do que só uma coisa ou outra. A maneira mais rápida de tornar essa combinação realidade é escolher um fluxo de trabalho de domínio e aprender como os agentes se conectariam a ele.

Para entender essa arquitetura, inscreva-se em nosso Fundamentos do Agente de IA para entender o modelo mental. Depois de aprender a parte teórica, o Designing Agentic Systems with LangChain para ter uma experiência prática na construção de um sistema funcional de ponta a ponta. Ver onde esses agentes falham é tão importante quanto ver como eles funcionam.

Lidando com a incerteza

Por fim, aprenda a lidar com a incerteza. Os resultados dos modelos de IA são probabilísticos, então às vezes podem estar errados. Entender os modos de falha é essencial para quem desenvolve ferramentas voltadas para o cliente. Você deve estar por dentro de conceitos como colapso do modelo (como os dados sintéticos prejudicam os modelos) e a mecânica por trás dos deepfakes.

Para acompanhar o ritmo do setor, em vez do ciclo de hype, siga os profissionais. As 13 principais conferências de IA para 2026 é um bom lugar pra ver onde os engenheiros estão trocando ideias sobre o que realmente funciona na produção.

Conclusão

Os professores da Universidade de Stanford descreveram recentemente o momento atual como uma mudança do “evangelismo para a avaliação”. Essa formulação capta perfeitamente a realidade. Estamos deixando de lado a questão sobre a importância da IA e entrando nos detalhes concretos de onde ela ajuda e como implantá-la de forma responsável.

Embora os prazos da AGI continuem sendo especulativos e o cenário regulatório esteja mudando, a direção prática é clara: A IA agênica vai entrar nos fluxos de trabalho das empresas, e modelos pequenos vão cuidar das tarefas rotineiras. O tema recorrente é o aumento, não a substituição. O futuro mais interessante não é aquele em que a IA faz tudo, mas aquele em que os humanos criam os sistemas que amplificam sua própria experiência.

A melhor estratégia agora é simples: Interaja com as ferramentas, mantenha um ceticismo saudável tanto em relação ao entusiasmo exagerado quanto ao pessimismo e encare o aprendizado como um processo contínuo. As mudanças estão rolando, não importa se você tá pronto ou não, então é melhor assumir o controle!

Perguntas frequentes sobre o futuro da IA

O que é IA agênica e por que ela é importante?

Diferente dos chatbots comuns, que respondem uma pergunta de cada vez, a IA agênica cria e executa um plano para atingir um objetivo. Se você pedir pra reservar uma viagem pra Madri, ele não só mostra os voos; ele compara hotéis sozinho, dá uma olhada na sua agenda e finaliza a reserva. A Deloitte acha que 75% das empresas vão investir em sistemas de inteligência artificial até o final de 2026.

Quando vamos chegar à Inteligência Artificial Geral (AGI)?

Não há consenso entre os especialistas. Estimativas otimistas, como as discutidas por Dario Amodei, sugerem que o final de 2026 ou 2027 é possível se as tendências atuais se mantiverem (o que ele duvida). Outros, como Demis Hassabis, acham que isso vai levar de 5 a 10 anos, enquanto os céticos, como Gary Marcus, acham que ainda vai demorar muito mais tempo. Uma pesquisa de 2023 com pesquisadores colocou a previsão média por volta de 2047.

A IA vai tirar meu emprego?

É improvável que a IA substitua funções inteiras de uma vez só. O Fórum Econômico Mundial prevê um resultado “positivo líquido” até 2030, com 92 milhões de empregos perdidos, mas 170 milhões criados. A mudança vai ser mais nas tarefas do que nos cargos, com a IA automatizando o trabalho rotineiro. Isso coloca pressão sobre as funções de atendimento ao cliente e entrada de dados, enquanto os empregos que exigem julgamento complexo e ambiguidade devem permanecer seguros.

O que são Modelos de Linguagem Pequenos (SLMs)?

Os SLMs são versões compactas de modelos de IA projetados para tarefas específicas, em vez de conhecimento geral. Como são menores, podem ser executados diretamente em dispositivos (como smartphones), oferecendo custos mais baixos e melhor privacidade de dados. A Gartner acha que, até 2027, as empresas vão usar esses modelos especializados três vezes mais do que os modelos genéricos.

Como a IA está mudando o desenvolvimento de software?

A IA virou uma parceira padrão dos programadores, com o GitHub dizendo que 41% do código nos projetos com ajuda do Copilot é gerado por IA. As ferramentas modernas agora conseguem entender repositórios de projetos inteiros, não só arquivos individuais. Mas, um estudo mostrou que, mesmo que os desenvolvedores experientes achassem que estavam mais rápidos com a IA, na verdade eles estavam demorando mais pra terminar as tarefas.

Josep é cientista de dados e gerente de projetos no Conselho de Turismo da Catalunha, usando dados para melhorar a experiência dos turistas na Catalunha. Sua experiência inclui o gerenciamento de armazenamento e processamento de dados, juntamente com análises avançadas e a comunicação eficaz de insights de dados.

Ele também é um educador dedicado, lecionando no programa de mestrado em Big Data da Universidade de Navarra e contribuindo regularmente com artigos perspicazes sobre ciência de dados para o Medium e o KDNuggets.

Ele é bacharel em Engenharia Física pela Universidade Politécnica da Catalunha e mestre em Sistemas Interativos Inteligentes pela Universidade Pompeu Fabra.

Atualmente, ele está empenhado em tornar as tecnologias relacionadas a dados mais acessíveis a um público mais amplo por meio da publicação ForCode'Sake no Medium.