Lernpfad

Als chatGPT im November 2022 auf den Markt kam und innerhalb von nur zwei Monaten hundert Millionen Nutzer anzog, hab ich es ehrlich gesagt als überbewerteten Chatbot abgetan. Diese Einschätzung hat sich nicht bewährt. Heute benutze ich (und fast alle, mit denen ich arbeite) täglich KI-Codierungstools, und die alten Diskussionen von 2023 darüber, ob ein Bot eine anständige E-Mail schreiben kann, kommen mir total veraltet vor. Wie sieht also die Zukunft der KI aus?

Die Branche hat sich von diesen anfänglichen Fragen wegbewegt und ist jetzt auf einer ganz anderen Ebene angekommen. Anthropic hat kürzlich die Marke von 7 Milliarden Dollar an wiederkehrenden Einnahmen geknackt, und die Tech-Giganten stecken so viel Geld in Rechenzentren, wie man sich vor fünf Jahren noch nicht mal vorstellen konnte. Deshalb geht's jetzt nicht mehr darum,ob KI funktioniert, sondern was passiert, wenn sie nicht mehr auf Anweisungen wartet und selbst entscheidet, was als Nächstes zu tun ist.

Dieser Artikel geht drauf ein, wohin sich die Technologie wohl entwickeln wird. Ich werde mich mit agentenbasierter KI, der hitzigen Debatte über den Zeitplan für AGI und dem Aufkommen kleinerer Modelle beschäftigen, die man lokal ausführen kann. Wir werden uns auch mit Veränderungen auf dem Arbeitsmarkt, Programmierwerkzeugen, Anwendungen im Gesundheitswesen und der regulatorischen Situation beschäftigen. Los geht's!

Wenn du mit einigen der KI-Konzepte noch nicht vertraut bist, empfehle ich dir unsere KI-Grundlagen Skill-Lernpfad, der alle wichtigen Grundlagen abdeckt, die du wissen musst.

Von generativer zu agentialer KI

Das Chatbot-Modell mit Hin- und Her-Gesprächen wird durch einen autonomeren Ansatz ersetzt. In diesem Abschnitt geht's darum, wie dieser Wandel in der Praxis aussieht, wo die echten Herausforderungen bei der Umsetzung liegen und warum die meisten Unternehmen immer noch Probleme haben, Agenten in die Produktion zu bringen.

Der Aufstieg autonomer Agenten

In den letzten Jahren haben sich KI-Tools nach einem vorhersehbaren Muster entwickelt. Du fragst, es antwortet. Der Mensch hat gefahren, und die KI war einfach nur mit dabei. Diese Dynamik ändert sich gerade: Agentische KI beantworten nicht nur Fragen, sondern machen auch Pläne, um Ziele zu erreichen.

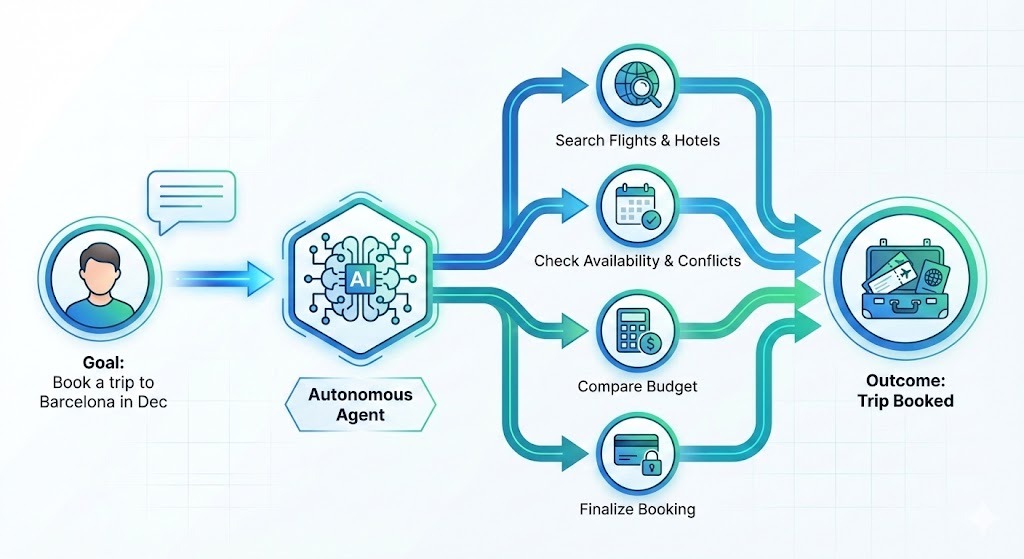

Angenommen, du willst im Dezember eine Reise nach Barcelona buchen. Anstatt dir eine Liste mit Hotels zu geben, die du selbst recherchieren musst, würde ein Reisebüro lieber:

- Optionen suchen

- Filtere nach deinen Vorlieben

- Vergleich die Preise mit deinem Budget

- Schau mal in deinem Kalender nach, ob da irgendwelche Terminkonflikte sind.

- Mach die Buchung

Du sagst, was du erreichen willst – das System kümmert sich um die Schritte, die nötig sind, um dahin zu kommen.

Die Nachfrage der Unternehmen danach ist riesig. Deloitte sagt voraus, dass bis Ende 2026 75 % der Unternehmen in agentenbasierte KI investieren werden. Aber die Realität hinkt der Vision gerade hinterher. Mitte 2025 UiPath-Umfrage zeigte, dass das Interesse zwar groß ist, aber nur 30 % der Agenten-Implementierungen tatsächlich in die Produktion gehen.

Die Lücke mit MCP schließen

Wieso gibt's da 'ne Lücke? Integration, meistens. Als die Forscher die Unternehmen fragten, was sie am meisten nervt, sagten 46 %, dass es schwierig ist, KI-Agenten mit den vorhandenen Systemen zu verbinden. Einen Agenten zu schreiben, der Code entwerfen kann, ist eine Herausforderung. Es zuverlässig mit deinem CRM, deiner Ticketing-Plattform und deinen internen APIs zum Laufen zu bringen, ohne dass dabei was kaputt geht oder neue Probleme entstehen, ist eine ganz andere Herausforderung.

Um dieses Problem zu lösen, setzt die Branche auf offene Standards wie das Model Context Protocol (MCP) von Anthropic und die AGENTS.md-Spezifikation von OpenAI, die beide auf eine neutrale Verwaltung offener Infrastrukturen abzielen und zur Agentic AI Foundation.

Vor allem MCP hat richtig an Fahrt gewonnen. Stell dir das wie „USB-C für KI” vor – einen Standardanschluss, mit dem Agenten problemlos mit verschiedenen Tools und Plattformen kommunizieren können. Um ein paar zu nennen: Es lässt sich mit Claude, Cursor, Microsoft Copilot, VSCode, Gemini und chatGPT verbinden.

Wenn du mehr als nur Demos sehen willst, schau dir unsere Kurse zu Agentische KI für Konzepte und Entwerfen agentenbasierter Systeme mit LangChain für praktische Anwendungen.

Ist die künstliche allgemeine Intelligenz (AGI) schon bald da?

Der Zeitplan für künstliche allgemeine Intelligenz (AGI), also KI-Systeme, die Aufgaben auf menschlichem Niveau in verschiedenen Bereichen erledigen können, hängt ganz davon ab, wen man fragt.

Die Chefs der großen KI-Labore sind ziemlich ehrgeizig: Dario Amodei von Anthropic meint, dass Systeme, die Nobelpreisträger aus verschiedenen Bereichen zusammenbringen („ein Land der Genies in einem Rechenzentrum“), bis 2026–2027 fertig sein könnten. Ähnlich sehen das Sam Altman und Demis Hassabis, die auf die nächsten drei bis fünf Jahre setzen.

Man sollte bedenken, dass diese Firmen auf die Begeisterung der Investoren angewiesen sind, um teure Forschung zu finanzieren, sodass optimistische Zeitpläne einen strategischen Zweck erfüllen.

Skeptiker sehen das Ganze etwas nüchterner. Gary Marcus sagt, die letzten Monate seien für den Optimismus in Sachen AGI echt vernichtend gewesen, und der ehemalige OpenAI-Forscher Andrej Karpathy meint, dass es noch mindestens ein Jahrzehnt dauern wird, bis wir AGI haben. Eine große Umfrage unter Forschern aus dem Jahr 2023 hat das durchschnittliche Ankunftsdatum sogar noch weiter nach hinten verschoben, nämlich auf 2047.

Letztendlich bietet das HAI von Stanford den nützlichsten Rahmen: Wir gehen von „Evangelismus zu Bewertung“ über. Die wichtigste Frage ist nicht, wann die allgemeine künstliche Intelligenz (AGI) kommt, sondern wie gut die aktuellen Systeme bestimmte Aufgaben heute schon machen und wo sie noch menschliche Aufsicht brauchen.

Neue KI-Technologien jenseits von LLMs

Nicht alles, was bei KI interessant ist, dreht sich darum, Modelle größer zu machen. Kleinere Modelle, Quantencomputer und digitale Zwillinge verändern, was an den Rändern des Feldes möglich ist.

Kleine Sprachmodelle (SMLs) und Edge-KI

Während alle über immer größere Modelle reden, wird viel Geld in kleinere Modelle gesteckt. Gartner sagt voraus, , dass Unternehmen kleine Sprachmodelle (SMLs), also Modelle für bestimmte Aufgaben, bis 2027 dreimal so oft einsetzen werden wie allgemeine große Modelle.

Die Gründe sind ganz praktisch:

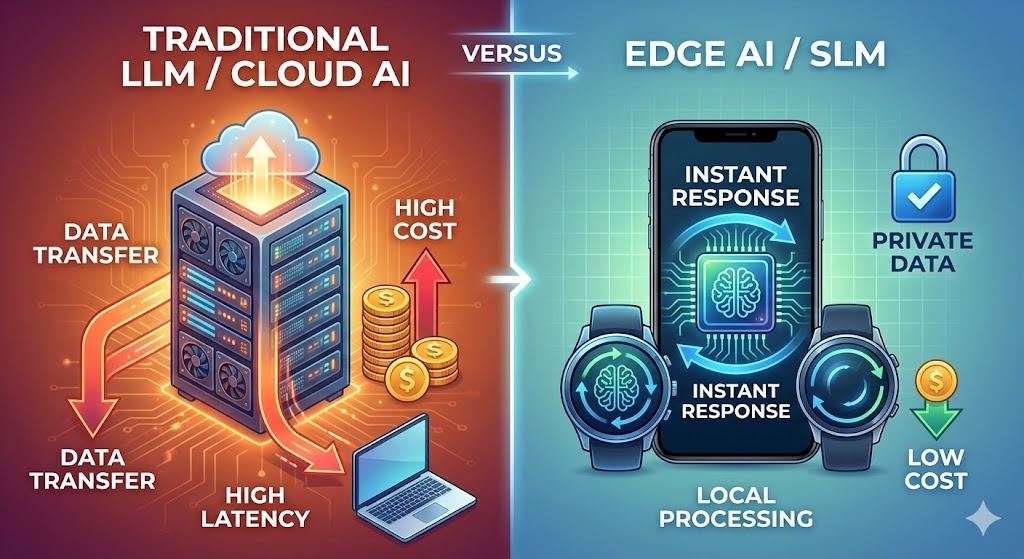

- Kosten: Große Modelle zu betreiben ist teuer. OpenAI hat Anfang 2025 angeblich fast doppelt so viel wie seine Einnahmen für Inferenz ausgegeben. SLMs sparen diese Kosten echt ein.

- Datenschutz: Gerätebasierte Modelle speichern Daten lokal, was im Gesundheitswesen und im Finanzbereich echt wichtig ist. Deshalb wird erwartet, dass der SLM-Markt von 930 Millionen Dollar im Jahr 2025 auf 5,45 Milliarden Dollar bis 2032 wächst.

- Geschwindigkeit: Lokale Inferenz macht Netzwerkverzögerungen überflüssig. Bei der Qualitätskontrolle in der Fertigung oder der Betrugsaufdeckung im Bankwesen kommt es auf Millisekunden an. Die Cloud kann das nicht immer bieten.

Forscher von NVIDIA sagen, dass der nächste Sprung in der KI nicht die Größe, sondern die Spezialisierung sein wird. Da Aufgaben wie das Parsen von E-Mails oder SQL-Abfragen kein riesiges Wissen brauchen, sieht die Architektur der Zukunft aus wie Modellflotten: mehrere spezialisierte Modelle, die zusammenarbeiten, statt ein einziges großes Allroundmodell.

Google, Mistral, Microsoft und Alibaba geben hier echt Gas. Google AI Edge checkt mehr als ein Dutzend Modelle ab, darunter Gemma 3n, ihr erstes multimodales Modell für Geräte.

Vergleich der Ansätze von SLMs und LLMs

Die folgende Tabelle zeigt, wie die beiden Ansätze sich unterscheiden. Wenn du mehr wissen willst, schau dir unseren Artikel über SLMs vs. LLMs.

|

Aspekt |

Große Sprachmodelle |

Kleine Sprachmodelle |

|

Wo sie laufen |

Cloud-Server |

Geräte, Edge, lokale Server |

|

Kosten pro Anfrage |

Höher (im Bereich von 0,01 bis 0,10 Dollar) |

Bruchteile eines Cent |

|

Reaktionszeit |

Netzwerkabhängig (100–500 ms) |

Unter 50 ms |

|

Datenverarbeitung |

Verlässt das Gerät |

Bleibt lokal |

|

Anpassung |

Ressourcenintensiv |

Leichter zugänglich |

|

Am besten geeignet für |

Komplexes Denken, kreatives Arbeiten, breites Wissen |

Spezifische Aufgaben, Zuverlässigkeit, Schnelligkeit |

|

Energieverbrauch |

Erheblich |

Bescheiden |

Große Modelle werden nicht irrelevant. Komplexe Probleme profitieren immer noch von ihrer Stärke. Die Zukunft wird wahrscheinlich beides bringen, mit spannenden Fragen, wann man was am besten einsetzt.

Die Verbindung von Quantencomputern und KI

Quantencomputing war schon immer „fünf Jahre entfernt“ oder Jahrzehnte, aber Ende 2025 hat sich was geändert, und das sollte man im Auge behalten.

Google hat bei Physiksimulationen mit 65 Qubits eine 13.000-fache Beschleunigung gegenüber dem Supercomputer Frontier gezeigt. IBM will bis 2026 einen Quantenvorteil erreichen, und die Forscher haben angefangen, neuronale Netze zu nutzen, um Qubit-Fehler in Echtzeit vorherzusagen und zu korrigieren.

Das Gebiet hat sich von einem theoretischen Versprechen zu einem technischen Problem entwickelt.

Der Begriff, der gerade an Bedeutung gewinnt, ist „Quanten-Nutzen“. Es geht nicht darum, dass Quanten bei allen Problemen einen kompletten Vorteil haben, sondern dass Quanten bestimmte Probleme schneller oder günstiger lösen können als klassische Alternativen. Die Probleme, die wir angehen wollen, sind echt mathematisch anspruchsvoll und haben so viele Variablen, dass klassische Computer damit überfordert sind:

- Optimierung der Batteriechemie

- Screening von Wirkstoffverbindungen

- Portfoliorisikomodellierung

Forscher von JPMorgan Chase haben kürzlich einen Meilenstein mit einem Quanten-Streaming-Algorithmus erreicht, der große Datensätze mit einem exponentiellen Platzvorteil verarbeitet. Das ist keine Pressemitteilung. Das ist eine von Fachkollegen begutachtete Arbeit mit messbaren Ergebnissen.

Allerdings ist der Vorhersagebereich hier ziemlich groß.

Manifold Markets, das über 100 Prognosen zum Thema Quantencomputer verfolgt, zeigt sich ziemlich skeptisch, dass Quantencomputer bis 2026 klassische Systeme in Sachen Kryptografie oder komplexe biologische Simulationen übertreffen werden. Die meisten Leute denken, dass es eher kleine technische Fortschritte geben wird und nicht so einen riesigen Durchbruch.

Aber dieselben Märkte sind ziemlich zuversichtlich, dass es in den nächsten zehn Jahren nützliche fehlertolerante Quantencomputer geben wird.

Was heißt das konkret?

Eigentlich ist der eigenständige Quantencomputer nur ein Mythos. Der aktuelle Standard in der Branche ist jetzt „heterogenes Rechnen“: hybride Architekturen, bei denen Quantenprozessoren zusammen mit GPU-Clustern in Hochleistungszentren stehen und KI-Systeme den Arbeitsablauf regeln.

Für Datenwissenschaftler, die in der Forschung und Entwicklung arbeiten, bedeutet das, dass sie neue Fähigkeiten brauchen. Mit den Quanten-Cloud-APIs von IBM, Google, Amazon Braket und Microsoft Azure Quantum kannst du Quanten-Subroutinen ausführen, ohne die Hardware selbst zu besitzen. Die Lernkurve ist nicht einfach, aber es ist einfacher, als ein eigenes Quantenlabor aufzubauen.

Die Veränderung im Fokus ist subtil, aber wichtig. Während sich die klassische Datenwissenschaft total auf „Big Data“ konzentriert, geht es beim Quantencomputing um „komplexe Optimierung“. Es geht Probleme mit kombinatorischen Explosionen an, wie Molekülmodellierung, Logistik oder finanzielle Risiken mit Tausenden von miteinander verbundenen Faktoren. In diesen Bereichen werden Quantenwerkzeuge immer mehr von der Theorie zur Praxis.

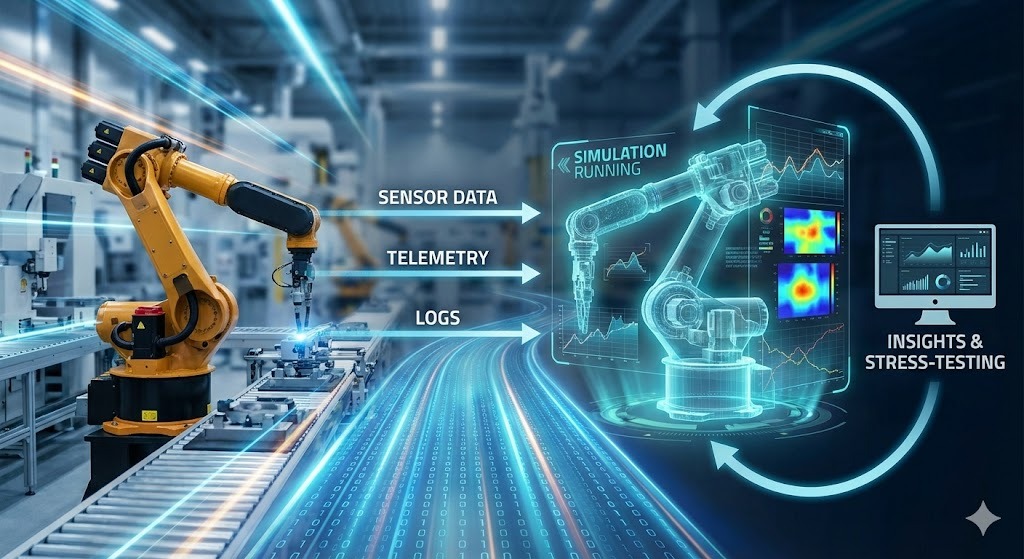

Digitale Zwillinge und Simulation

Digitale Zwillinge werden immer mehr von einem Modewort zu einer funktionierenden Infrastruktur. Die Idee ist einfach: Man baut eine virtuelle Kopie eines echten Systems (wie eine Fabriklinie, ein Lagernetzwerk, ein Stromnetz oder einen Stadtbezirk) und hält sie mit Sensoren, Protokollen und Betriebsdaten immer auf dem neuesten Stand. Dann nutzt du den Zwilling, um Entscheidungen einem Stresstest zu unterziehen, bevor du dich in die Realität stürzt.

Fabriken sind die saubersten frühen Fälle. Eine moderne Anlage macht schon die Daten, die ein Zwilling braucht: SPS-Signale, Maschinentelemetrie, Wartungshistorie, Arbeitsaufträge, Qualitätsmessungen, Lagerbewegungen. KI verwandelt diese Flut in ein Modell, das du abfragen kannst. Nicht nur Dashboards, sondern auch kontrafaktische Szenarien. Du kannst Fragen beantworten wie:

- Was passiert, wenn eine Stanzpresse am Dienstagmorgen für sechs Stunden ausfällt?

- Was wäre, wenn wir bei diesem Teil Lieferant B durch Lieferant C ersetzen würden, der ein etwas anderes Fehlerprofil hat?

- Was wäre, wenn wir den Schichtplan so ändern würden, dass sich die erfahrenen Bediener auf die letzten beiden Stationen konzentrieren?

Der Wert liegt nicht darin, die Störung vorherzusagen. Es geht darum, die Auswirkungen nachzuvollziehen – verpasste Gelegenheiten, Lücken im Lagerbestand, Kosten für Umleitungen –, damit du Lösungen im Voraus planen kannst, anstatt um 3 Uhr morgens improvisieren zu müssen.

Der entscheidende Vorteil ist, dass KI die Kosten für die Entwicklung und Wartung dieser Modelle senkt. Moderne ML-Modelle lernen direkt aus Live-Daten, erkennen Abweichungen und halten den Zwilling auf Kurs, wenn sich das echte System ändert.

Auch kleine, spezialisierte Modelle passen hier gut rein: ein Modell für die Erkennung von Anomalien an einer Turbine, ein anderes für die Optimierung von Zeitplänen, ein weiteres für die Nachfrageprognose – alle speisen dieselbe simulierte Umgebung.

Wenn du dir ein genaueres Bild von den nächsten Schritten machen willst, solltest du dir das hier durchlesen 9 Open-Source-LLMs für 2026 , um Modelle ohne Anbieter auszuführen und zu optimieren, sowie Top 13 AI Conferences for 2026, wo es um die echte Umsetzung geht.

Die Zukunft der KI in der Arbeitswelt

Schlagzeilen, die behaupten, dass KI Arbeitsplätze wegnehmen würde, lassen oft die Feinheiten der tatsächlichen Daten außer Acht. Das Bild, das sich aus der Forschung ergibt, ist chaotischer, allmählicher und wahrscheinlich weniger dramatisch, als Optimisten oder Pessimisten vermuten lassen.

Wird KI Jobs ersetzen?

Die Zahlen sind viel differenzierter, als es die Schlagzeilen normalerweise zeigen.

Das Weltwirtschaftsforum hat über 1.000 führende Arbeitgeber für seinen Bericht „Die Zukunft der Arbeitsplätze 2025”. Sie haben geschätzt, dass zwischen 2025 und 2030 170 Millionen neue Jobs entstehen und 92 Millionen wegfallen werden, was einen Nettozuwachs von 78 Millionen Arbeitsplätzen bedeutet.

Auch wenn das insgesamt positiv ist, kommt es echt drauf an, wie die Verteilung aussieht. In einer Studie, die im November 2025 veröffentlicht wurde, schätzen Forscher vom MIT und der Boston University, dass KI bis 2026 etwa zwei Millionen Arbeiter in der Fertigungsindustrie ersetzen wird.

Man sollte zwischen Aufgaben und Rollen unterscheiden. KI macht eher bestimmte Aufgaben in Jobs automatisch, als dass sie gleich ganze Jobs wegfallen lässt. Dein Buchhalter bleibt dir erhalten, aber die Zeit, die du für die Dateneingabe und den Abgleich brauchst, wird immer weniger.

Eine Studie des MIT aus dem Jahr 2025 schätzt, dass derzeit automatisierbare Aufgaben etwa 11,7 % der Arbeitsaktivitäten in den USA ausmachen, was einem Lohnvolumen von rund 1,2 Billionen US-Dollar entspricht. Das heißt nicht, dass 11,7 % der Leute ihren Job verlieren, aber es heißt, dass ein großer Teil ihrer Arbeit jetzt von einer Software erledigt werden kann.

Zu den Jobs, die mehr Druck haben, gehören:

- Kundenservice, vor allem Support per Text

- Dateneingabe und -verarbeitung

- Verwaltungsarbeit, die nach vorhersehbaren Mustern abläuft

- Einige Stellen als Kassierer im Einzelhandel

- Regelmäßige juristische Recherchen und Aufgaben als Rechtsanwaltsfachangestellter

Jobs mit den folgenden Merkmalen sind weniger stressig:

- Leitungsaufgaben

- Fachliches Urteil

- Unklare Situationen

- Physische Präsenz in unvorhersehbaren Umgebungen

Diese Muster gelten unter anderem für das Gesundheitswesen, Handwerksberufe, kreative Tätigkeiten und strategische Entscheidungen.

Neue Karrierewege

Es gibt neue Jobkategorien, von denen einige vor fünf Jahren noch nicht mal existierten:

- Als KI-Systemarchitekt planst du, wie KI-Komponenten in Unternehmen eingebaut werden. Du musst sowohl technisches Verständnis als auch Kenntnisse über Geschäftsprozesse haben.

- Der Prompt Engineer ist jetzt ein richtiger Jobtitel, entwickelt sich aber immer mehr zu dem, was man als KI-Kollaborationsspezialist bezeichnet. Verstehen, wie man mit diesen Systemen effektiv arbeitet, und nicht nur clevere Eingaben macht.

- Der AI Ethics and Compliance Manager kümmert sich um die gesetzlichen Anforderungen und die Prüfung. Unternehmen brauchen Leute, die sowohl die technischen Möglichkeiten als auch die rechtlichen Rahmenbedingungen verstehen, um die Risiken im Zusammenhang mit KI-Systemen zu minimieren.

- Der KI-Trainer und Datenkurator kümmert sich um Feedbackschleifen, Annotationen von Randfällen und die Qualitätskontrolle der Trainingsdaten.

Ich hab gemerkt, dass Fachwissen in Kombination mit guten KI-Kenntnissen echt was bringt. Eine Krankenschwester, die sich mit KI-Diagnosetools auskennt, macht bessere Arbeit als eine, die sie nicht benutzt. Ein Anwalt, der KI für Recherchen nutzt und dabei ihre Grenzen kennt, arbeitet schneller, ohne dass die Qualität leidet.

In Arbeitgeberumfragen wird analytisches Denken immer als die wichtigste Fähigkeit genannt. Sieben von zehn Firmen sagen, dass es super wichtig ist. Resilienz, Anpassungsfähigkeit und Führungsqualitäten kommen gleich danach.

Branchenspezifische Änderungen

Einige Bereiche haben KI-Tools schneller angenommen als andere, und die Ergebnisse sind vielfältiger, als man denken würde. Programmierung, Gesundheitswesen und Finanzen zeigen alle, was funktioniert, was nicht und wo es Überraschungen gibt.

Programmierung und Datenwissenschaft

Die Softwareentwicklung hat KI-Tools schneller angenommen als die meisten anderen Bereiche. Die Tools entwickeln sich ständig weiter.

Laut der Stack Overflow-Umfrage von 2025nutzen Ende 2025 etwa 85 % der Entwickler regelmäßig KI-Tools. GitHub sagt 41 % des Codes, der von Copilot-Nutzern weltweit erstellt wird, kommt mit KI-Unterstützung. Wir sind über die Autovervollständigung hinaus: Die aktuellen Systeme verstehen ganze Repositorys und nehmen Änderungen an mehreren Dateien vor.

Es haben sich Marktführer herausgebildet: GitHub Copilot hat einen Marktanteil von etwa 42 %, über 20 Millionen Nutzer und ist in 90 % der Fortune-100-Unternehmen vertreten. Cursor hat sich innerhalb von achtzehn Monaten aus dem Nichts einen Marktanteil von 18 % geholt. Es heißt, sie machen 500 Millionen Dollar an wiederkehrenden Einnahmen.

KI-Tools sind bei bestimmten Arten von Programmierarbeiten echt gut:

- Boilerplate, sich wiederholende Muster

- Unbekannte APIs ausprobieren

- Alten Code entschlüsseln

Aber der Unterschied zwischen dem, was man denkt, und dem, was wirklich passiert, ist wichtig.

In einer METR-Studie vom Juli 2025benutzten erfahrene Entwickler Tools wie Cursor Pro und Claude 3.5 Sonnet. Diese Entwickler haben Aufgaben 19 % langsamer erledigt als ohne KI-Unterstützung – trotzdem dachten sie, dass sie 20 % schneller arbeiten.

Das Fazit ist, dass Produktivitätssteigerungen vom Kontext abhängen. KI-Tools können dich tatsächlich ausbremsen, wenn die Art der Arbeit nicht zu ihren Stärken passt und du das System besser verstehst als die KI.

Heutzutage geht's mehr in Richtung autonomer Funktionen. GitHubs Projekt Padawan ist ein Modell, bei dem Entwickler Probleme an KI-Systeme weitergeben, die KI sie umsetzt und Menschen sie dann überprüfen. Der Wandel geht von KI, die Code vorschlägt, zu KI, die Funktionen fertigstellt.

Bei der Datenwissenschaft solltest du weniger Zeit für die Vorbereitung und mehr für die Interpretation einplanen. KI kann SQL-Abfragen und die Datenbereinigung übernehmen. So haben die Datenwissenschaftler Zeit, sich auf die richtigen Fragen zu konzentrieren und zu verstehen, was die Ergebnisse bedeuten.

Gesundheitswesen

KI im Gesundheitswesen ist ein kompliziertes Thema. Echtes Potenzial, aber vorsichtiger Einsatz – was angesichts der Risiken wahrscheinlich richtig ist.

Die KI-gestützte Arzneimittelforschung geht immer schneller voran. AlphaFold und ähnliche Tools sagen Proteinstrukturen in Stunden statt in Jahren voraus. Das Screening von Verbindungen läuft jetzt in Größenordnungen ab, die vorher einfach nicht machbar waren. Einige Schätzungen sagen, dass KI die Zeit für die Entwicklung von Medikamenten um vier oder fünf Jahre pro Medikament verkürzen könnte.

Auch in bestimmten Bereichen hat sich die Diagnostik verbessert, am weitesten fortgeschritten sind dabei die Radiologie, Pathologie und Augenheilkunde. KI, die mit medizinischen Bildern trainiert wurde, kann Muster erkennen, die menschliche Prüfer übersehen.

Laut McKinseyhat die Mayo Clinic seit 2016 ihr Radiologiepersonal um über 50 % aufgestockt und gleichzeitig Hunderte von KI-Modellen eingesetzt. Diese Kombination ist bemerkenswert: KI hat die Arbeit verbessert, statt die Leute zu ersetzen.

Aber Vorsicht ist echt wichtig. Entscheidungen im Gesundheitswesen haben Konsequenzen, die Empfehlungen in sozialen Medien nicht haben: Falsche Diagnosen können Patienten schaden. Der wissenschaftliche und medizinische Bedarf, zu verstehen, wie Modelle zu ihren Schlussfolgerungen kommen, und nicht nur, ob sie richtig sind, bringt echte Einschränkungen mit sich.

Die Realität in naher Zukunft ist KI als Diagnoseassistent. Systeme können auf mögliche Probleme hinweisen, Tests vorschlagen und Dinge erkennen, die in stressigen Umgebungen leicht übersehen werden könnten. Aber am Ende entscheiden die Ärzte und pflegen die Beziehungen zu den Patienten.

Die Fernüberwachung wird immer schneller, weil kleine Sprachmodelle jetzt direkt auf Wearables laufen. Durch die lokale Verarbeitung der Daten auf dem Gerät minimieren diese Systeme die Latenz und schützen die Privatsphäre, indem sie mithilfe von KI nur bestimmte Anomalien zur Überprüfung durch Menschen markieren.

Finanzen

Die Finanzdienstleistungsbranche hat schon früh auf KI gesetzt und schon vor Jahren die schnelle Betrugserkennung drauf gehabt, aber die neuen Möglichkeiten bringen die Branche jetzt in ganz neue Bereiche.

Während die bekannten Tools sich um Betrugsfälle und normale Kundendienstanfragen kümmern, geht's jetzt vor allem um Hyper-Personalisierung. Neue Systeme können die Risikobereitschaft und die finanziellen Ziele von Leuten analysieren und so einer viel größeren Gruppe ausgefeilte Vermögensverwaltungsstrategien anbieten.

Aber dieser Fortschritt hat auch eine Kehrseite: Die Regulierungsbehörden schauen sich diese Modelle immer genauer an, um sicherzustellen, dass alte Verzerrungen in den Kreditdaten nicht von den Algorithmen übernommen werden.

Herausforderungen und Regulierung im Bereich KI

Technische Einschränkungen und politische Lücken machen es echt schwierig, was KI verantwortungsvoll machen kann. Das Problem der Black Box, falsche Infos und eine uneinheitliche Regulierungslandschaft bestimmen, was wirklich einsetzbar ist und was nur theoretisch möglich.

Technische und soziale Themen

Das Problem mit der Blackbox ist noch nicht gelöst. Wenn Modelle Entscheidungen treffen, ist es immer noch schwer zu verstehen, warum. Das ist echt ein Problem, wenn Entscheidungen Kredite, Jobs und medizinische Versorgung betreffen.

Die Forschung konzentriert sich auf Interpretierbarkeit. Die Stanford HAI-Fakultät denkt, dass das, was sie „Archäologie hochleistungsfähiger neuronaler Netze” im Jahr 2026 mehr Aufmerksamkeit bekommen wird. Techniken wie Sparse Autoencoder helfen dabei, herauszufinden, welche Trainingsmerkmale das Verhalten wirklich beeinflussen.

Generierte Inhalte bringen noch mehr Probleme mit sich: Deepfakes und KI-erzeugte Falschinformationen werden von Tag zu Tag schwerer zu erkennen. Einige Schätzungen sagen, dass die Menge der KI-generierten Online-Artikel die von Menschen geschriebene Inhalte vielleicht schon überholt hat.

Modellzusammenbruch kann eine Folge sein und ist ein weiteres Thema, das Forscher beschäftigt. Wenn Modelle immer mehr mit KI-generierten Inhalten trainiert werden, die einen immer größeren Teil der verfügbaren Daten ausmachen, könnte die Qualität schlechter werden. Modelle nutzen ihre eigenen Ergebnisse auf eine Art und Weise, die Fehler verstärkt.

Regulatorisches Umfeld

Die Gerichtsbarkeiten gehen unterschiedlich vor.

Das EU-KI-Gesetz ist das umfassendste Regelwerk für KI, das es gerade gibt. Es basiert auf einer Risikoleiter: Je höher das Risiko, desto größer die Verpflichtungen. Systeme, die bei Einstellungs- und Kreditentscheidungen genutzt werden, fallen in die Kategorie „hohes Risiko“, was strengere Anforderungen an Dokumentation, Kontrollen und Aufsicht bedeutet.

Das Gesetz ist am 1. August 2024 in Kraft getreten, aber die meisten Pflichten werden in den nächsten Jahren nach und nach eingeführt.

Energie wird hier auf eine engere, praktischere Art betrachtet: Anbieter von allgemeinen KI-Modellen müssen vielleicht den Energieverbrauch dokumentieren (oder Schätzungen liefern, die auf Berechnungen basieren, wenn genaue Messungen nicht möglich sind). Abgesehen vom KI-Gesetz werden die Vorschriften für die Berichterstattung über Rechenzentren und Energieeffizienz in der EU verschärft, was wichtig ist, weil KI-Workloads ein wichtiger neuer Treiber für den Strombedarf sind.

In der Praxis führt das dazu, dass Teams eine „ausreichend gute“ Architektur anstreben, bei der Effizienz wichtiger ist als pure Leistung. Durch die Verwendung kleinerer Modelle und die Ausführung von Inferenzprozessen am Rand können Entwickler weniger Token über teure Cloud-Systeme verarbeiten, was letztlich zu einer Reduzierung der Rechenkosten, des Stromverbrauchs und der Datenübertragung führt.

In den USA ist die Lage noch nicht so klar. Die Bundesgesetzgebung ist immer noch festgefahren, und weil es 2025 nicht geklappt hat, die Vorschriften auf Landesebene zu überstimmen, wird das Regelwerk immer uneinheitlicher. Deshalb müssen sich Bauunternehmer bis 2026 mit unterschiedlichen Vorschriften in den einzelnen Bundesstaaten auseinandersetzen, statt mit einem einheitlichen Bundesrahmen.

Bereit für die Zukunft der KI

Was hilft wirklich dabei, beruflich auf dem Laufenden zu bleiben? Zur Vorbereitung empfehle ich, sich mit KI-bezogenen Konzepten zu beschäftigen, technische Fähigkeiten zu entwickeln und praktische Erfahrungen zu sammeln.

Daten- und KI-Kompetenz

Datenkompetenz ist nicht mehr nur eine Option. Du musst kein Datenwissenschaftler sein, aber du solltest wissen, wie Daten fließen, was sie zuverlässig macht und wie man Modellergebnisse interpretiert.

Wenn du eine strukturierte Grundlage brauchst, dann ist der Skill Track „Data Literacy Professional“ Der Lernpfad deckt alle wichtigen Themen ab und gibt dir eine Zertifizierung, mit der du zeigen kannst, was du gelernt hast. Für einen eher auf KI ausgerichteten theoretischen Einstieg empfehle ich die Teilnahme am Kurs AI Fundamentals Skill Track als Lernpfad einzuschreiben.

Technische Fähigkeiten

Grundlegende technische Fähigkeiten sind immer noch das, was den Unterschied macht. KI-Tools machen das Programmieren einfacher zugänglich, aber du musst trotzdem die Logik verstehen, um das Ergebnis zu überprüfen. Python und SQL sind hier die „täglichen Arbeitsmittel“.

Ein guter Ansatz ist, erst die Sprache zu lernen und dann die KI-Ebene. Los geht's mit Einführung in Python, um die Syntax zu verstehen. Weiter geht's mit Generative KI-Konzepte, um zu verstehen, wie moderne Assistenten funktionieren – und wo sie noch Probleme haben.

Fachwissen und Agenten

Die größte Veränderung ist der Wechsel von Chatbots zu Agenten. Einfach nur Aufforderungen zu machen, wird immer mehr zur Routine. Der Wert liegt in der Gestaltung von Arbeitsabläufen, die sich in reale Systeme einfügen.

Fachwissen behält seinen Wert. Wenn man KI-Tools gut kennt und dazu noch viel Ahnung von seinem Fachgebiet hat, kann man mehr erreichen als mit nur einem dieser beiden Dinge. Der schnellste Weg, diese Kombination umzusetzen, ist, einen Domain-Workflow auszuwählen und zu lernen, wie Agenten sich darin einklinken können.

Um diese Architektur zu verstehen, melde dich für unseren Kurs AI Agent Fundamentals Lernpfad an, um dir ein mentales Modell anzueignen. Wenn du den theoretischen Teil durch hast, mach den Designing Agentic Systems with LangChain, um praktische Erfahrungen beim Aufbau eines funktionierenden End-to-End-Systems zu sammeln. Zu sehen, wo diese Agenten versagen, ist genauso wichtig wie zu sehen, wie sie funktionieren.

Mit Unsicherheit umgehen

Lerne, mit Unsicherheit umzugehen. Die Ergebnisse von KI-Modellen sind wahrscheinlich, also können sie manchmal falsch sein. Das Verständnis von Fehlermodi ist für jeden, der Tools für den Kundenkontakt entwickelt, super wichtig. Du solltest mit Begriffen wie Modellkollaps (wie synthetische Daten Modelle beeinträchtigen) und die Mechanismen hinter Deepfakes.

Um mit der Branche Schritt zu halten und nicht dem Hype-Zyklus, solltest du den Praktikern folgen. Die Top 13 der KI-Konferenzen für 2026 ist ein guter Ort, um herauszufinden, wo Ingenieure sich darüber austauschen, was in der Produktion wirklich funktioniert.

Fazit

Die Stanford-Fakultät hat die aktuelle Situation kürzlich als einen Wechsel von „Evangelismus zu Bewertung“ beschrieben. Dieser Rahmen spiegelt die Realität perfekt wider. Wir lassen die Frage,ob KI wichtig ist, hinter uns und beschäftigen uns jetzt mit den Details, wo sie nützlich ist und wie man sie verantwortungsvoll einsetzt.

Auch wenn die Zeitpläne für AGI noch unklar sind und sich die regulatorischen Rahmenbedingungen ändern, ist die praktische Richtung klar: Agentische KI wird in die Arbeitsabläufe von Unternehmen einziehen, und kleine Modelle werden Routineaufgaben übernehmen. Das immer wiederkehrende Thema ist Erweiterung, nicht Ersatz. Die spannendste Zukunft ist nicht die, in der KI alles macht, sondern die, in der Menschen Systeme entwickeln, die ihr eigenes Fachwissen erweitern.

Die beste Strategie ist jetzt ganz klar: Probier die Tools aus, bleib skeptisch gegenüber Hype und Untergangsstimmung und sieh das Lernen als einen fortlaufenden Prozess. Die Veränderungen passieren, egal ob du bereit bist oder nicht, also ist es besser, das Ruder in die Hand zu nehmen!

Häufig gestellte Fragen zur Zukunft der KI

Was ist agentenbasierte KI und warum ist sie wichtig?

Im Gegensatz zu normalen Chatbots, die immer nur eine Frage auf einmal beantworten, macht sich die agentenbasierte KI einen Plan, um ein Ziel zu erreichen. Wenn du es bittest, eine Reise nach Madrid zu buchen, listet es nicht nur Flüge auf, sondern vergleicht selbstständig Hotels, checkt deinen Kalender und macht die Buchung fertig. Deloitte meint, dass bis Ende 2026 75 % der Firmen in agentenbasierte Systeme investieren werden.

Wann werden wir allgemeine künstliche Intelligenz (AGI) erreichen?

Die Experten sind sich nicht einig. Optimistische Schätzungen, wie die von Dario Amodei, sagen, dass Ende 2026 oder 2027 möglich ist, wenn die aktuellen Trends so bleiben (was er aber bezweifelt). Andere, wie Demis Hassabis, denken, dass es noch 5 bis 10 Jahre dauern wird, während Skeptiker wie Gary Marcus glauben, dass es noch viel länger dauern wird. Eine Umfrage unter Forschern aus dem Jahr 2023 hat ergeben, dass die meisten denken, dass es so um 2047 so weit sein wird.

Wird KI meinen Job wegnehmen?

Es ist unwahrscheinlich, dass KI ganze Jobs komplett ersetzen wird. Das Weltwirtschaftsforum sagt bis 2030 ein „insgesamt positives” Ergebnis voraus, mit 92 Millionen wegfallenden Arbeitsplätzen, aber 170 Millionen neuen Jobs. Die Veränderung wird eher bei den Aufgaben als bei den Titeln stattfinden, da KI Routinearbeiten übernimmt. Das setzt Kundenservice- und Dateneingabejobs unter Druck, während Jobs, die komplexe Entscheidungen und Unklarheiten erfordern, sicher bleiben sollten.

Was sind kleine Sprachmodelle (SLMs)?

SLMs sind kompakte Versionen von KI-Modellen, die für bestimmte Aufgaben und nicht für allgemeines Wissen entwickelt wurden. Weil sie kleiner sind, können sie direkt auf Geräten (wie Smartphones) laufen, was die Kosten senkt und den Datenschutz verbessert. Gartner geht davon aus, dass Unternehmen bis 2027 diese speziellen Modelle dreimal häufiger nutzen werden als die großen Allzweckmodelle.

Wie verändert KI die Softwareentwicklung?

KI ist mittlerweile ein fester Bestandteil der Arbeit von Programmierern geworden. GitHub sagt, dass 41 % des Codes in Projekten, die mit Copilot gemacht werden, von KI kommt. Moderne Tools können jetzt ganze Projekt-Repositorys verstehen, nicht nur einzelne Dateien. Eine Studie hat aber gezeigt, dass erfahrene Entwickler zwar das Gefühl hatten, mit KI schneller zu sein, aber eigentlich haben sie Aufgaben langsamer erledigt.

Josep ist Data Scientist und Projektmanager beim katalanischen Fremdenverkehrsamt und nutzt Daten, um die Erfahrungen von Touristen in Katalonien zu verbessern. Sein Fachwissen umfasst das Management von Datenspeicherung und -verarbeitung, gekoppelt mit fortschrittlichen Analysen und der effektiven Kommunikation von Datenerkenntnissen.

Er ist auch ein engagierter Pädagoge, der den Big-Data-Masterstudiengang an der Universität von Navarra unterrichtet und regelmäßig aufschlussreiche Artikel über Datenwissenschaft auf Medium und KDNuggets veröffentlicht.

Er hat einen BS in technischer Physik von der Polytechnischen Universität von Katalonien und einen MS in intelligenten interaktiven Systemen von der Universität Pompeu Fabra.

Derzeit engagiert er sich leidenschaftlich dafür, datenbezogene Technologien durch die Medium-Publikation ForCode'Sake einem breiteren Publikum zugänglich zu machen.