Curso

El procesamiento de big data a menudo implica trabajar con datos no estructurados, que pueden ser difíciles de gestionar y analizar. En cualquier momento pueden producirse borrados accidentales u otros errores, lo que supone un grave riesgo para la integridad de los datos.

Apache Iceberg y Delta Lake son formatos de tablas de código abierto que se utilizan principalmente para gestionar lagos de datos a gran escala. Ambas plataformas ofrecen funciones como la evolución de esquemas, el viaje en el tiempo y las transacciones ACID para afrontar los retos de manejar conjuntos de datos masivos. Aunque cada uno de ellos tiene ventajas únicas, comparten un objetivo común: mantener la coherencia de los datos en todos los conjuntos de datos.

En este artículo, te explicaré las principales características, similitudes y diferencias arquitectónicas entre Apache Iceberg y Delta Lake para ayudarte a elegir la herramienta adecuada a tus necesidades.

¿Qué es el Iceberg Apache?

Desarrollado por Netflix y posteriormente donado a la Fundación del Software Apache, Iceberg pretende resolver los retos de la gestión de lagos de datos a gran escala. Es un formato de alto rendimiento para grandes tablas analíticas que gestiona y consulta eficazmente conjuntos de datos masivos. Sus características abordan muchas de las limitaciones de los enfoques tradicionales de almacenamiento en lagos de datos.

Entendamos el Iceberg Apache con más detalle.

Características de Apache Iceberg

Éstas son algunas de las características más destacadas de Apache Iceberg, que son muy útiles para los ingenieros de datos cuando trabajan con conjuntos de datos.

- Evolución del esquema: En las bases de datos tradicionales, cambiar la estructura de tus datos (como añadir una nueva columna) puede ser una gran molestia. Iceberg te lo pone fácil. Por ejemplo, si haces un seguimiento de los datos de un cliente y quieres añadir un campo

loyalty_points, puedes hacerlo sin afectar a los datos existentes ni romper las consultas actuales. Esta flexibilidad es especialmente útil para proyectos de datos a largo plazo que necesitan adaptarse con el tiempo. - Partición: Ayuda a organizar tus datos en trozos más pequeños y manejables. Esto hace que las consultas sean más rápidas porque no tienes que buscar en todos los datos cada vez. Por ejemplo, tengo un enorme conjunto de datos de registros de ventas. Iceberg puede organizar automáticamente estos datos por fecha, ubicación o cualquier otro factor relevante.

- Viaje en el tiempo: Esta función te permite acceder fácilmente a las versiones históricas de los datos. Si alguien borra accidentalmente información importante o necesitas comparar los datos actuales con un estado pasado, puedes retroceder hasta un punto concreto en el tiempo. Estas consultas puntuales simplifican los procesos de auditoría y recuperación de datos.

- Integridad de los datos: La corrupción de datos puede ocurrir por muchas razones, como problemas de red, de almacenamiento o fallos de software. Iceberg utiliza técnicas matemáticas (sumas de comprobación) para detectar si un solo bit de tus datos ha cambiado inesperadamente. Esto garantiza que los datos que estás analizando son exactamente los que se almacenaron originalmente.

- Compactación y optimización: Con el tiempo, los sistemas de datos pueden saturarse con muchos archivos pequeños, lo que ralentiza el procesamiento. Iceberg limpia esto periódicamente combinando archivos pequeños y organizando los datos de forma más eficiente.

Estas características hacen que Iceberg sea especialmente bueno para el análisis de datos a gran escala, sobre todo si tratas con datos que cambian con frecuencia o a los que hay que acceder de diversas formas durante largos periodos.

Consulta la entrada del blog Apache Iceberg Explicado para profundizar en esta apasionante tecnología.

¿Qué es el Lago Delta?

Desarrollado por Databricks, Delta Lake funciona perfectamente con Spark, lo que lo convierte en una opción popular para las organizaciones que ya han invertido en el ecosistema Spark. Es una capa de almacenamiento de código abierto que aporta transacciones ACID (Atomicidad, Consistencia, Aislamiento, Durabilidad) a Apache Spark y a las cargas de trabajo de big data.

Los lagos de datos basados en Delta Lake agilizan el almacenamiento de datos y el aprendizaje automático para mantener la calidad de los datos mediante metadatos escalables, versionado y aplicación de esquemas.

Características del lago Delta

Éstas son las características clave que hacen de Delta Lake una buena solución para el procesamiento moderno de datos:

- Transacciones ACID: Los lagos de datos tradicionales suelen tener dificultades para mantener la coherencia de los datos. Para superar esto, Delta Lake lleva las propiedades ACID asociadas a las bases de datos a los lagos de datos. Esto significa que puedes realizar operaciones complejas con tus datos sin preocuparte de que se corrompan o se produzcan incoherencias, incluso si algo sale mal a mitad del proceso.

- Versionado de datos y viaje en el tiempo: A medida que las normativas sobre datos, como la GDPR , se hacen más estrictas, el seguimiento de los cambios en los datos a lo largo del tiempo se ha convertido en algo muy valioso. La función de viaje en el tiempo de Delta Lake te permite acceder a versiones anteriores de tus datos y restaurarlas. Esto es útil para el cumplimiento y la realización de experimentos con diferentes versiones de tus conjuntos de datos.

- Batch y streaming unificados: Tradicionalmente, las organizaciones necesitaban sistemas separados para el procesamiento por lotes (manejar grandes volúmenes de datos a la vez) y el procesamiento por flujos (manejar datos en tiempo real). Delta Lake salva esta distancia para que puedas utilizar el mismo sistema para ambas cosas. Esto simplifica tu arquitectura de datos y te permite construir canalizaciones de datos más flexibles.

- Manejo escalable de metadatos: A medida que los volúmenes de datos crecen a escala de petabytes, la gestión de los metadatos (datos sobre tus datos) se hace difícil. Como resultado, muchos sistemas se ralentizan considerablemente cuando tratan con millones de archivos. Sin embargo, Delta Lake puede manejar escalas masivas sin degradación del rendimiento, lo que lo hace adecuado para lagos de datos muy grandes.

- Lecturas y escrituras optimizadas: El rendimiento es fundamental en los escenarios de big data. Delta Lake incorpora omisión de datos, almacenamiento en caché y compactación para acelerar las operaciones de lectura y escritura. Esto significa consultas más rápidas y un uso más eficiente de los recursos informáticos, lo que ahorra costes en los entornos de nube.

El curso Fundamentos de Big Data con PySpark profundiza en el procesamiento moderno de datos con Spark. Es un gran repaso a esta potente tecnología.

Conviértete en Ingeniero de Datos

Iceberg Apache y Lago Delta: Similitudes

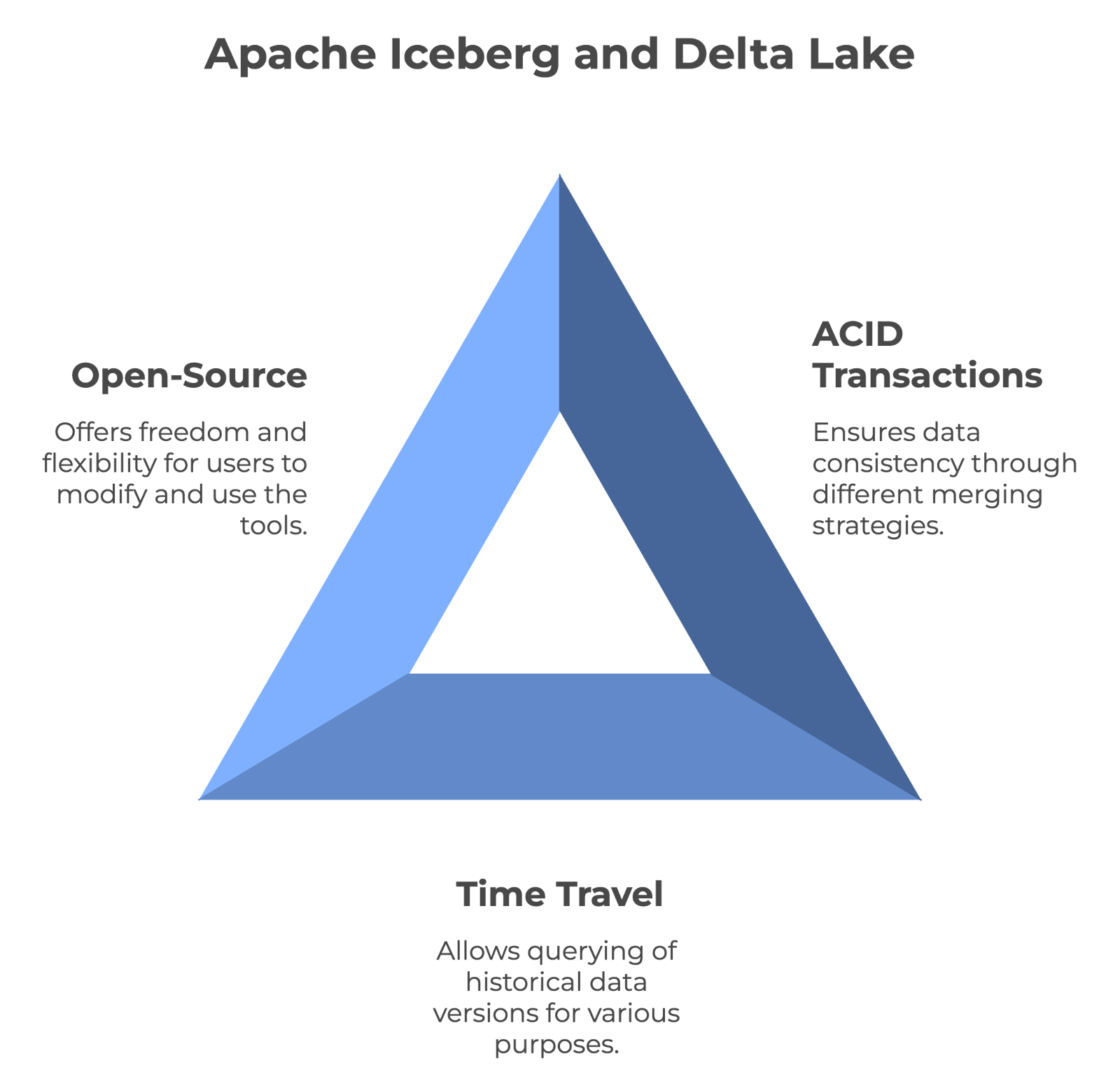

Dado que tanto Apache Iceberg como Delta Lake gestionan grandes cantidades de datos, examinemos sus similitudes fundamentales.

Transacciones ACID y coherencia de datos

Ambas herramientas pueden proporcionar una coherencia total de los datos mediante transacciones ACID y versionado. Sin embargo, Iceberg utiliza el enfoque de fusión en lectura, mientras que Delta Lake utiliza la estrategia de fusión en escritura.

Como resultado, cada uno gestiona el rendimiento y los datos de forma diferente. Iceberg puede proporcionar soporte completo para la evolución de esquemas, mientras que Delta Lake impone el cumplimiento de los esquemas.

Apoyo a los viajes en el tiempo

La funcionalidad de viaje en el tiempo permite a los usuarios consultar versiones históricas de los datos. Esto lo hace inestimable para auditar, depurar e incluso reproducir experimentos. Tanto Iceberg como Delta Lake admiten el viaje en el tiempo, lo que significa que puedes acceder a estados anteriores de los datos sin preocuparte.

Naturaleza de código abierto

Apache Iceberg y Delta Lake son tecnologías de código abierto. Esto significa que cualquiera puede utilizarlos gratuitamente e incluso ayudar a mejorarlos. Además, ser de código abierto significa que no estás atado al producto de una empresa: tienes más libertad para cambiar o combinar herramientas según necesites. Y como su código es público, puedes incluso optimizarlo para tus necesidades específicas.

Las principales características que comparten Apache Iceberg y Delta Lake. Imagen del Autor creada con napkin.ai.

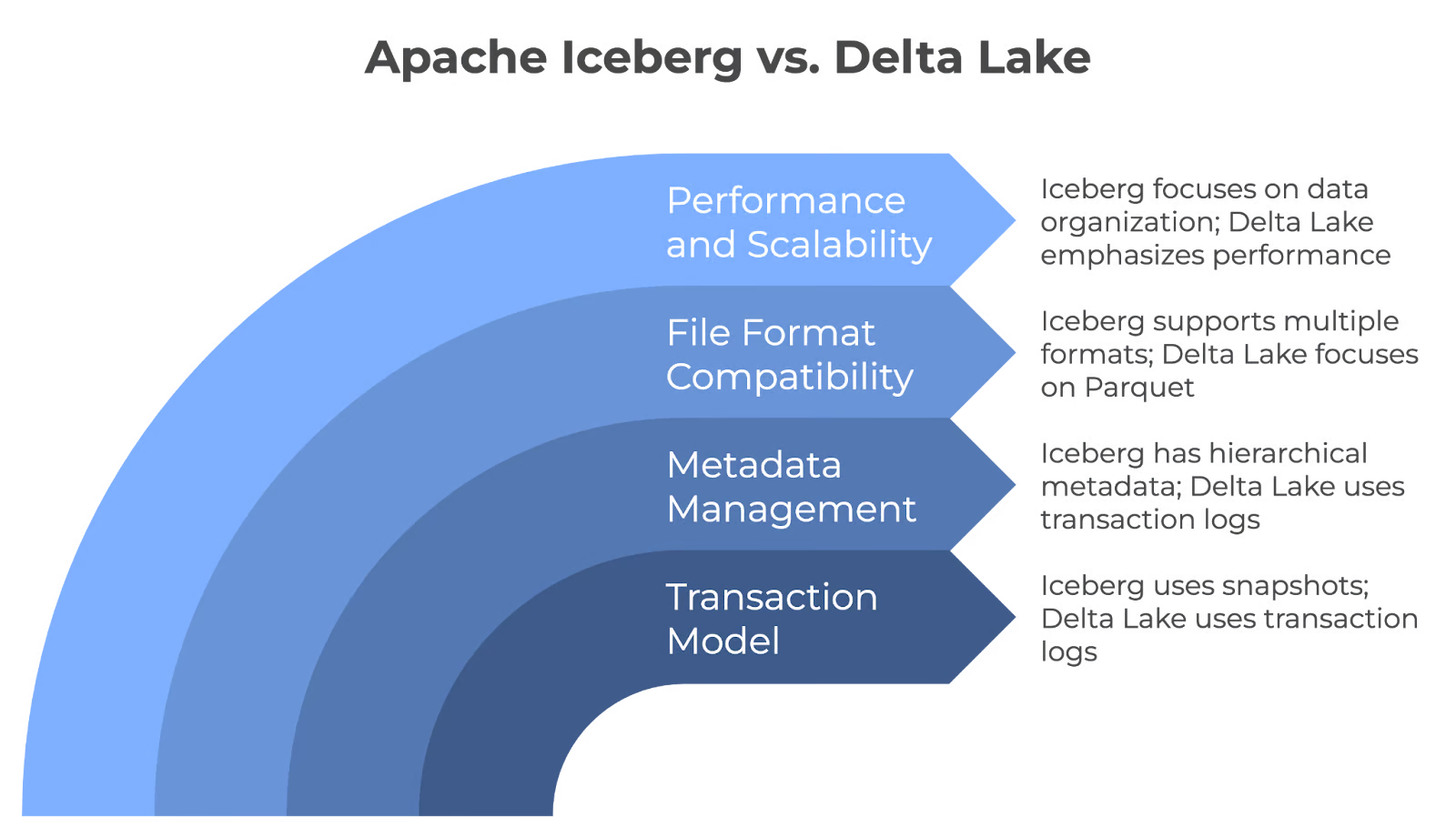

Iceberg contra Delta Lake: Diferencias arquitectónicas básicas

Aunque Iceberg y Delta Lake comparten similitudes, difieren en su arquitectura. Veamos cómo:

Modelo de transacción

Iceberg y Delta Lake garantizan la fiabilidad de los datos en los lagos de datos, pero lo consiguen mediante mecanismos diferentes. Iceberg utiliza instantáneas para las transacciones atómicas con el fin de garantizar que los cambios se consignan o revierten completamente. Pero Delta Lake utiliza registros de transacciones para garantizar que sólo se consignan en la tabla los cambios validados y proporciona fiabilidad en las actualizaciones de datos.

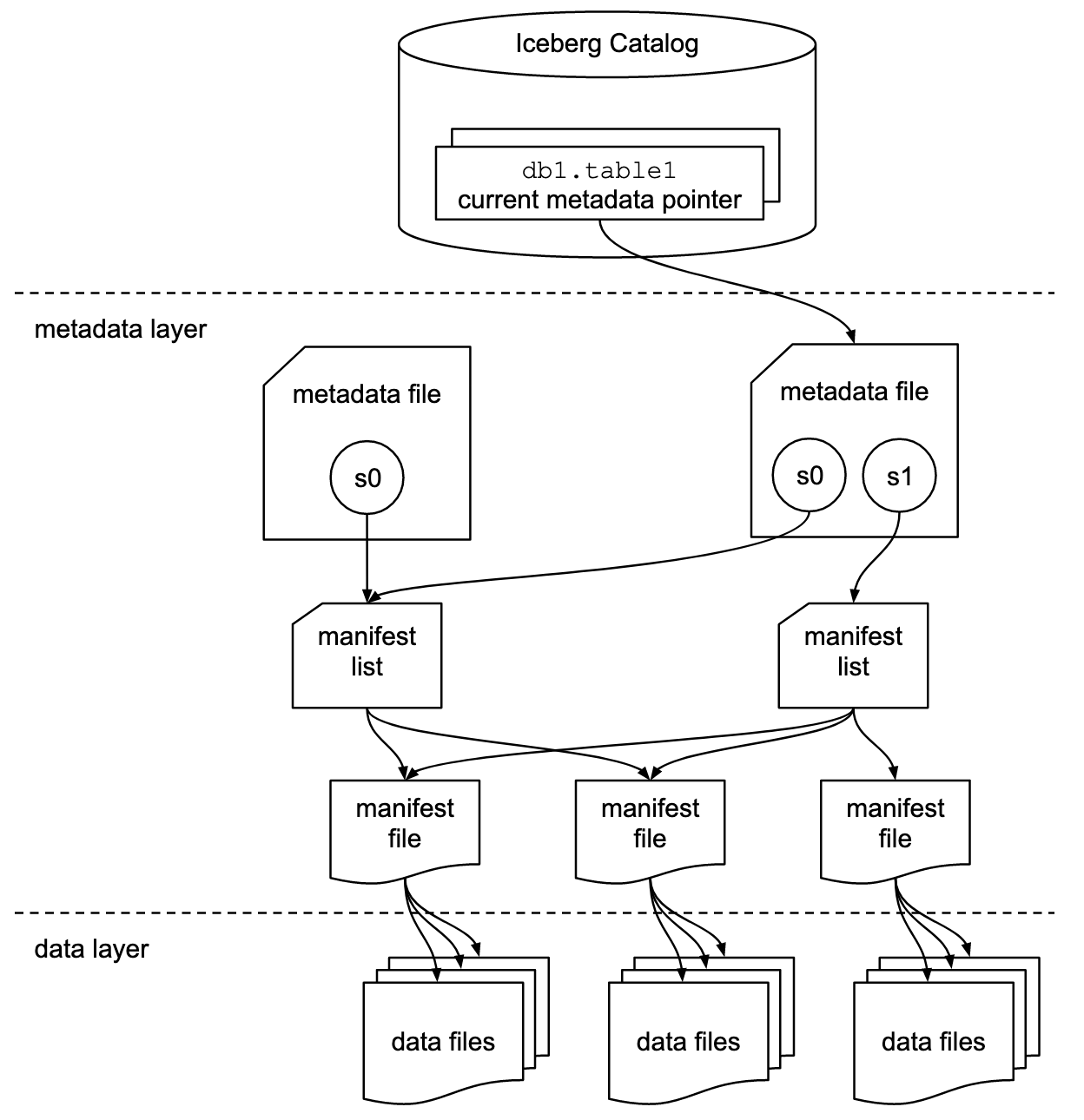

Gestión de metadatos

Apache Iceberg emplea una estructura jerárquica de metadatos, que incluye archivos de manifiesto, listas de manifiesto y archivos de metadatos. Este diseño agiliza el procesamiento de las consultas, eliminando operaciones costosas como listar y renombrar archivos.

Sin embargo, Delta Lake adopta un enfoque basado en transacciones para registrar cada transacción en un registro. Para mejorar la eficacia de las consultas y simplificar la gestión de los registros, consolida periódicamente estos registros enarchivos de puntos de control Parquet , que capturan el estado completo de las tablas.

Compatibilidad de formatos de archivo

Iceberg es flexible con los formatos de archivo y puede trabajar de forma nativa con archivos Parquet, ORC y Avro. Esto es útil si tienes datos en distintos formatos o si quieres cambiar de formato en el futuro sin cambiar todo el sistema.

Delta Lake almacena los datos principalmente en formato Parquet porque éste es eficiente, especialmente para consultas analíticas. Sólo se centra en un formato para ofrecer el mejor rendimiento posible para ese tipo de archivo concreto.

Rendimiento y escalabilidad

Iceberg y Delta Lake son lagos de datos a escala, pero emplean estrategias diferentes. Iceberg prioriza la organización avanzada de datos con funciones como la partición y la compactación, mientras que Delta Lake hace hincapié en el alto rendimiento a través de su motor Delta, la autocompactación y las funciones de indexación.

Diferencias entre los núcleos de Apache Iceberg y Delta Lake. Imagen del Autor creada con napkin.ai.

Casos de uso de Apache Iceberg

Debido a sus características únicas, Apache Iceberg se ha convertido rápidamente en una solución de referencia para la gestión moderna de los lagos de datos. Examinemos algunos de sus principales casos de uso para comprender sus puntos fuertes.

Lagos de datos nativos en la nube

He aquí por qué Iceberg es una opción popular para las organizaciones que construyen lagos de datos que operan a escala de nube:

- Fuerte evolución del esquema: Te permite añadir, eliminar o modificar columnas sin afectar a las consultas existentes. Por ejemplo, si necesitas añadir un nuevo campo para hacer un seguimiento de las preferencias del usuario, puedes hacerlo sin tener que reconstruir todo el conjunto de datos ni actualizar todas las consultas.

- Rendimiento: Técnicas avanzadas como la agrupación de datos y la gestión de metadatos optimizan el rendimiento de las consultas. Podan rápidamente los archivos de datos innecesarios para reducir la cantidad de datos escaneados y mejorar la velocidad de consulta.

- Escalabilidad: Gestiona miles de millones de archivos y petabytes de datos. Además, su función de evolución de particiones te permite cambiar la organización de los datos sin tiempos de inactividad ni costosas migraciones.

Modelos de datos complejos

Los equipos que trabajan con modelos de datos complejos encuentran Iceberg especialmente útil por lo siguiente:

- Flexibilidad del esquema: Admite tipos de datos anidados (structs, listas y mapas) para representar relaciones complejas. Por ejemplo, una plataforma de comercio electrónico podría almacenar los detalles del pedido, incluyendo estructuras anidadas para los artículos y los datos del cliente, todo dentro de una única tabla.

- Consultas sobre viajes en el tiempo: Este método mantiene instantáneas de tus datos para consultarlos tal y como existían en cualquier momento del pasado. Esto tiene un valor incalculable para reconstruir el estado de tus datos en un momento dado con fines de cumplimiento o para volver a ejecutar análisis sobre instantáneas de datos históricos.

Integración con herramientas

Iceberg es compatible con herramientas diversificadas, lo que lo convierte en una opción versátil para el ecosistema de datos. Veamos algunas de sus principales integraciones:

Iceberg funciona perfectamente con lo siguiente:

- Apache Spark para el procesamiento de datos a gran escala y el aprendizaje automático.

- Trino para realizar consultas SQL rápidas y distribuidas en múltiples fuentes de datos.

- Apache Flink para el procesamiento de flujos en tiempo real y el cálculo por lotes.

Los siguientes proveedores principales de la nube ofrecen soporte nativo para Iceberg:

- Amazon Web Services (AWS ) se integra con AWS Glue, Redshift, EMR y Athena.

- Google Cloud Platform (GCP) funciona con BigQuery y Dataproc.

- Microsoft Azure es compatible con Azure Synapse Analytics.

Iceberg también proporciona bibliotecas cliente para distintos lenguajes de programación, como:

- SQL escribe consultas SQL estándar contra las tablas de Iceberg.

- Python utiliza PySpark o bibliotecas como pyiceberg para la manipulación de datos.

- Java aprovecha la API nativa de Java para operaciones de bajo nivel e integraciones personalizadas.

Especificación del formato de la tabla Apache Iceberg. Fuente de la imagen: Documentación de Iceberg.

Casos prácticos de Delta Lake

Delta Lake puede resolver retos comunes y facilitar la gestión de datos. Examinemos algunas situaciones clave en las que realmente ayuda.

Cargas de trabajo batch y streaming unificadas

Con Delta Lake, no necesitas sistemas separados para distintos tipos de datos. En su lugar, puedes tener un sistema que se encargue de todo. Puedes añadir nuevos datos a tus tablas en tiempo real, y estarán inmediatamente listos para el análisis. Esto significa que tus datos están siempre actualizados.

Puedes crear un único flujo de trabajo que gestione datos antiguos y nuevos para que todo tu sistema sea menos complejo y más fácil de gestionar. Este enfoque unificado simplificará tus canalizaciones de datos.

Transacciones ACID para lagos de datos

Delta Lake aporta una gran fiabilidad a los lagos de datos mediante transacciones ACID. Por ejemplo:

- Los hospitales pueden mantener registros de pacientes precisos y actualizados para prestar una atención adecuada y cumplir las normas de privacidad.

- Los bancos pueden garantizar que todas las transacciones financieras se registran con precisión y no pueden modificarse accidentalmente.

- Las tiendas pueden mantener un recuento preciso de sus existencias, incluso cuando se producen muchas actualizaciones simultáneamente. Esto ayuda a evitar problemas como la venta de artículos que en realidad no están en stock.

Delta Lake consigue esta fiabilidad garantizando que todos los cambios se apliquen completamente o no se apliquen en absoluto. Además, garantiza que los datos pasen siempre de un estado válido a otro y que las distintas operaciones no interfieran entre sí.

Ecosistema Apache Spark

Delta Lake también funciona a la perfección con Apache Spark, una gran ventaja para muchas organizaciones. Si ya utilizas Spark, añadir Delta Lake será sencillo y no requerirá grandes cambios en tu configuración actual. Tu equipo puede utilizar las mismas herramientas Spark y comandos SQL con los que están familiarizados.

Como resultado, hará que tus trabajos Spark se ejecuten más rápido, especialmente cuando se trate de grandes cantidades de datos. Lo hace organizando los datos de forma más eficiente y utilizando técnicas de indexación inteligentes.

Apache Iceberg vs Delta Lake: Un resumen

Vamos a resumir las principales diferencias entre Apache Iceberg y Delta Lake para ayudarte a comprender rápidamente los puntos fuertes y las características clave de sus formatos.

|

Características |

Apache Iceberg |

Delta Lake |

|

Transacción ACID |

Sí |

Sí |

|

Viaje en el tiempo |

Sí |

Sí |

|

Versionado de datos |

Sí |

Sí |

|

Formato de archivo |

Parquet, ORC, Avro |

Parquet |

|

Evolución del esquema |

Completo |

Parcial |

|

Integración con otros motores |

Apache Spark, Trino, Flink |

Principalmente Apache Spark |

|

Compatibilidad con la nube |

AWS, GCP, Azure |

AWS, GCP |

|

Motores de consulta |

Spark, Trino, Flink |

Chispa |

|

Lenguaje de programación |

SQL, Python, Java |

SQL, Python |

Nota: La mejor elección depende de tus necesidades, requisitos de escalabilidad y estrategia de datos a largo plazo.

Conclusión

A la hora de elegir entre Apache Iceberg y Delta Lake, ten en cuenta tu caso de uso específico y la pila tecnológica existente. La flexibilidad de Iceberg con los formatos de archivo y los motores de consulta lo hacen ideal para los entornos nativos de la nube. Sin embargo, la estrecha integración de Delta Lake con Apache Spark es una buena opción para las organizaciones que hayan invertido mucho en el ecosistema Spark.

También puedes consultar algunos recursos relevantes del DataCamp para reforzar tu comprensión de los datos:

- Curso de Ingeniería de Datos para comprender los conceptos fundamentales

- Cursos de Diseño de Bases de Datos y Almacenamiento de Datos para estructurar eficazmente los datos a gran escala.

- Curso de Arquitectura Moderna de Datos para conocer las mejores prácticas y tendencias actuales.

¡Feliz aprendizaje!

Conviértete en Ingeniero de Datos

Preguntas frecuentes

¿Cuál es la principal diferencia entre las estrategias Fusionar al leer y Fusionar al escribir?

La fusión en lectura (utilizada por Iceberg) lee los datos de los archivos existentes y aplica los cambios durante la consulta. La fusión en escritura (utilizada por Delta Lake) fusiona las actualizaciones en los datos base durante el proceso de escritura para garantizar lecturas más rápidas a costa de operaciones de escritura más lentas.

¿Pueden Apache Iceberg y Delta Lake manejar datos a escala de petabytes?

Sí, tanto Apache Iceberg como Delta Lake manejan eficazmente conjuntos de datos a escala de petabytes. Proporcionan funciones avanzadas como la partición, la gestión de metadatos y la compactación para optimizar el rendimiento de los grandes lagos de datos.

¿Cómo se comportan Apache Iceberg y Delta Lake cuando consultan estructuras de datos profundamente anidadas?

Apache Iceberg es excelente para consultar estructuras de datos profundamente anidadas. Admite formatos de almacenamiento tabular como Parquet, que están optimizados para datos anidados. Por otro lado, Delta Lake también admite datos anidados, pero su rendimiento puede variar en función de la complejidad de la consulta y del tamaño del conjunto de datos.

¿Pueden Apache Iceberg y Delta Lake trabajar juntos en la misma arquitectura de lago de datos?

Sí, tanto Apache Iceberg como Delta Lake pueden coexistir dentro del mismo lago de datos. Cada uno puede utilizarse para casos de uso diferentes, según los requisitos. Por ejemplo, podrías utilizar Delta Lake para cargas de trabajo centradas en Apache Spark e Iceberg para una integración más flexible con diversos motores de consulta.

¿Existen limitaciones al utilizar Delta Lake con motores que no sean Spark?

Delta Lake está estrechamente integrado con Apache Spark, y aunque puede funcionar con otros motores como Presto o Hive, estas integraciones aún están evolucionando. El rendimiento podría no estar tan optimizado como con Spark, lo que podría limitar su eficacia fuera del ecosistema Spark.

¿Cómo gestionan Iceberg y Delta Lake los problemas de archivos pequeños en los lagos de datos?

Tanto Apache Iceberg como Delta Lake abordan el problema de los archivos pequeños mediante la compactación. Iceberg combina periódicamente archivos pequeños para optimizar el rendimiento de las consultas, mientras que Delta Lake utiliza la autocompactación para consolidar los archivos durante las operaciones de escritura. Esto garantiza un mejor rendimiento al reducir la sobrecarga causada por muchos archivos pequeños.

¿Por qué Databricks adquirió Tabular (la empresa detrás de Iceberg)?

Databricks adquirió Tabular para reforzar sus capacidades con Apache Iceberg, creado originalmente por los fundadores de Tabular. La adquisición pretende mejorar la compatibilidad y la interoperabilidad entre Delta Lake e Iceberg, trabajando en última instancia hacia un formato de lago unificado que combine los puntos fuertes de ambos proyectos de código abierto.

¿Qué significa la adquisición de Tabular para los usuarios de Delta Lake e Iceberg?

La adquisición significa que Databricks trabajará activamente para acercar Delta Lake e Iceberg en términos de compatibilidad. Los usuarios se beneficiarán de una mejor integración, ya que Delta Lake UniForm ya sirve como plataforma para permitir la interoperabilidad entre Delta Lake, Iceberg y Apache Hudi. Esto permite a los usuarios trabajar con distintos formatos sin tener que limitarse a una única solución.

¿Seguirá Databricks dando soporte tanto a Delta Lake como a Iceberg?

Sí, Databricks ha indicado su compromiso con ambos formatos. Con la adquisición de Tabular y la incorporación al redil de los creadores originales de Apache Iceberg, Databricks pretende fomentar la colaboración entre las comunidades de Iceberg y Delta Lake. Su objetivo es desarrollar una norma única y abierta para la interoperabilidad de los formatos de las casas lacustres, que proporcionará a los usuarios más opciones y flexibilidad.

Soy una estratega de contenidos a la que le encanta simplificar temas complejos. He ayudado a empresas como Splunk, Hackernoon y Tiiny Host a crear contenidos atractivos e informativos para su público.