Kurs

Bei der Verarbeitung von Big Data wird oft mit unstrukturierten Daten gearbeitet, deren Verwaltung und Analyse eine Herausforderung darstellen kann. Versehentliche Löschungen oder andere Fehler können jederzeit auftreten und stellen ein großes Risiko für die Datenintegrität dar.

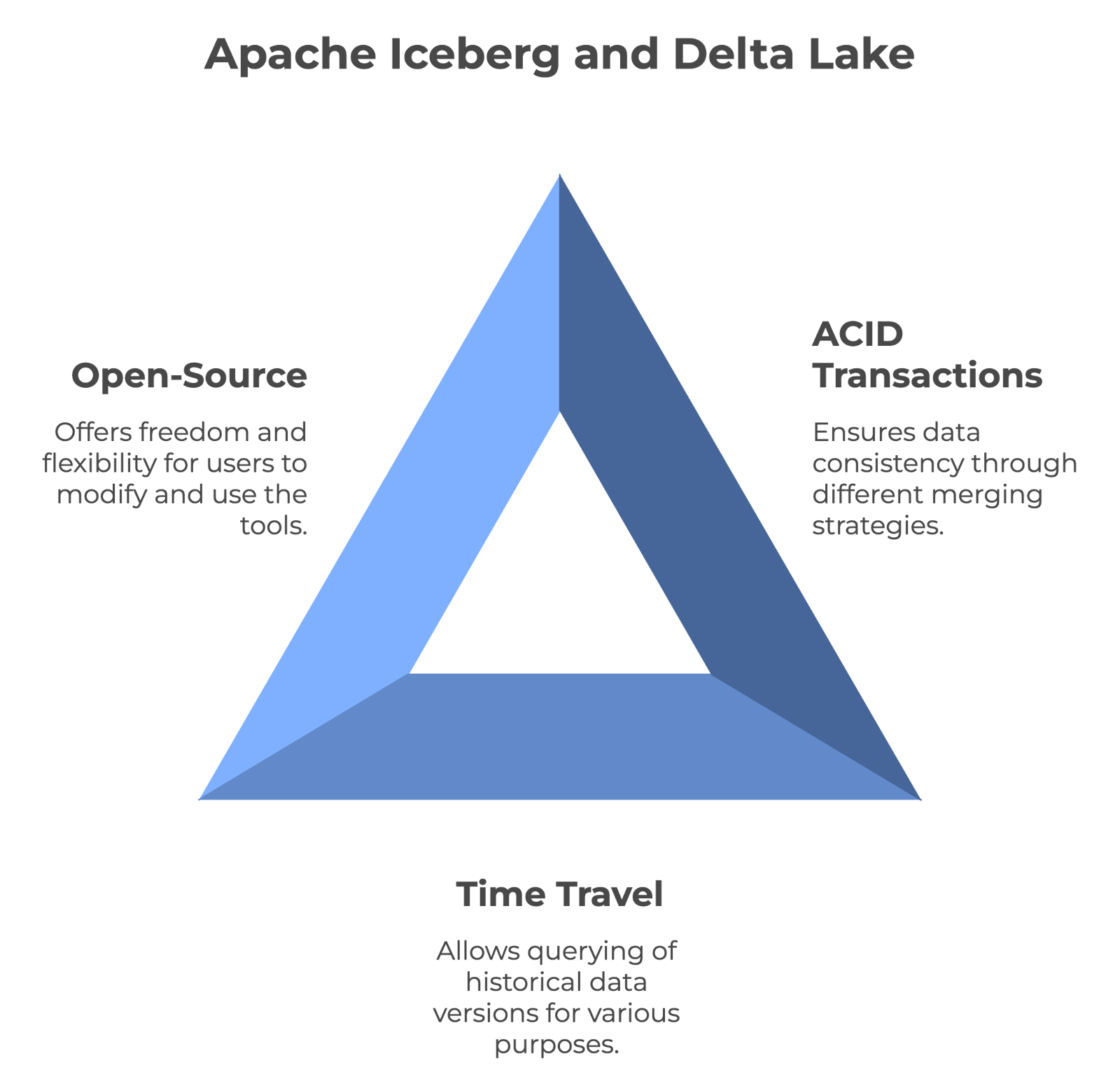

Apache Iceberg und Delta Lake sind Open-Source-Tabellenformate, die hauptsächlich für die Verwaltung großer Data Lakes und Lakehouses verwendet werden. Beide Plattformen bieten Funktionen wie Schema-Evolution, Zeitreisen und ACID-Transaktionen, um die Herausforderungen beim Umgang mit großen Datenmengen zu bewältigen. Jede hat ihre eigenen Vorteile, aber sie haben ein gemeinsames Ziel: die Erhaltung der Datenkonsistenz über verschiedene Datensätze hinweg.

In diesem Artikel erkläre ich die wichtigsten Funktionen, Gemeinsamkeiten und architektonischen Unterschiede zwischen Apache Iceberg und Delta Lake, damit du das richtige Tool für deine Bedürfnisse auswählen kannst.

Was ist Apache Iceberg?

Iceberg wurde von Netflix entwickelt und später an die Apache Software Foundation gespendet, um die Herausforderungen bei der Verwaltung großer Data Lakes zu lösen. Es ist ein hochleistungsfähiges Format für große Analysetabellen, das große Datenmengen effizient verwaltet und abfragt. Seine Funktionen beseitigen viele der Einschränkungen herkömmlicher Data-Lake-Speicheransätze.

Lass uns den Apache Iceberg genauer verstehen.

Eigenschaften von Apache Iceberg

Hier sind einige der wichtigsten Funktionen von Apache Iceberg, die für Datentechniker bei der Arbeit mit Datensätzen sehr hilfreich sind.

- Schema-Evolution: In herkömmlichen Datenbanken kann es sehr mühsam sein, die Struktur deiner Daten zu ändern (z. B. eine neue Spalte hinzuzufügen). Mit Iceberg ist das ganz einfach. Wenn du zum Beispiel Kundendaten verfolgst und ein

loyalty_pointsFeld hinzufügen möchtest, kannst du das tun, ohne dass sich das auf bestehende Daten auswirkt oder aktuelle Abfragen unterbrochen werden. Diese Flexibilität ist besonders nützlich für langfristige Datenprojekte, die im Laufe der Zeit angepasst werden müssen. - Partitionierung: Es hilft dir, deine Daten in kleinere, überschaubare Einheiten zu unterteilen. Dadurch werden Abfragen schneller, weil du nicht jedes Mal alle Daten durchsuchen musst. Ich habe zum Beispiel einen riesigen Datensatz mit Verkaufsdaten. Iceberg kann diese Daten automatisch nach Datum, Ort oder einem anderen relevanten Faktor ordnen.

- Zeitreisen: Mit dieser Funktion kannst du ganz einfach auf historische Datenversionen zugreifen. Wenn jemand versehentlich wichtige Informationen löscht oder du aktuelle Daten mit einem früheren Zustand vergleichen musst, kannst du mit zurückreisen zu einem bestimmten Zeitpunkt. Diese zeitpunktbezogenen Abfragen vereinfachen Prüfungen und Datenwiederherstellungsprozesse.

- Datenintegrität: Daten können aus vielen Gründen beschädigt werden, z. B. durch Netzwerkprobleme, Speicherprobleme oder Softwarefehler. Iceberg verwendet mathematische Verfahren (Prüfsummen), um zu erkennen, ob sich auch nur ein einziges Bit deiner Daten unerwartet verändert hat. So wird sichergestellt, dass die Daten, die du analysierst, genau die Daten sind, die ursprünglich gespeichert wurden.

- Verdichtung und Optimierung: Mit der Zeit können die Datensysteme mit vielen kleinen Dateien überladen werden, was die Verarbeitung verlangsamt. Iceberg räumt regelmäßig damit auf, indem es kleine Dateien zusammenfasst und die Daten effizienter organisiert.

Dank dieser Funktionen eignet sich Iceberg besonders gut für umfangreiche Datenanalysen, vor allem, wenn du mit Daten arbeitest, die sich häufig ändern oder auf die du über lange Zeiträume hinweg auf verschiedene Arten zugreifen musst.

Im Blogbeitrag "Apache Iceberg Explained " erfährst du mehr über diese spannende Technologie.

Was ist der Deltasee?

Delta Lake wurde von Databricks entwickelt und arbeitet nahtlos mit Spark zusammen, was es zu einer beliebten Wahl für Unternehmen macht, die bereits in das Spark-Ökosystem investiert haben. Es ist eine Open-Source-Speicherschicht, die ACID-Transaktionen (Atomicity, Consistency, Isolation, Durability) für Apache Spark und Big-Data-Workloads ermöglicht.

Delta Lake-basierte Data Lakehouses rationalisieren Data Warehousing und maschinelles Lernen, um die Datenqualität durch skalierbare Metadaten, Versionierung und Schemaerzwingung zu erhalten.

Merkmale des Deltasees

Hier sind die wichtigsten Merkmale, die Delta Lake zu einer guten Lösung für die moderne Datenverarbeitung machen:

- ACID-Transaktionen: Herkömmliche Data Lakes haben oft Probleme, die Datenkonsistenz zu wahren. Um dies zu überwinden, bringt Delta Lake die mit Datenbanken verbundenen ACID-Eigenschaften in Data Lakes ein. Das bedeutet, dass du komplexe Operationen mit deinen Daten durchführen kannst, ohne dir Sorgen über Datenbeschädigungen oder Inkonsistenzen machen zu müssen, selbst wenn während des Prozesses etwas schief läuft.

- Datenversionierung und Zeitreisen: Da Datenvorschriften wie GDPR immer strenger werden, ist es von unschätzbarem Wert, Datenänderungen im Laufe der Zeit zu verfolgen. Mit der Zeitreisefunktion von Delta Lake kannst du auf frühere Versionen deiner Daten zugreifen und sie wiederherstellen. Dies ist hilfreich für die Einhaltung von Vorschriften und die Durchführung von Experimenten mit verschiedenen Versionen deiner Datensätze.

- Vereinheitlichung von Batch und Streaming: Bisher brauchten Unternehmen getrennte Systeme für die Stapelverarbeitung (Verarbeitung großer Datenmengen auf einmal) und die Datenstromverarbeitung (Verarbeitung von Echtzeitdaten). Delta Lake überbrückt diese Lücke, sodass du das gleiche System für beides verwenden kannst. Das vereinfacht deine Datenarchitektur und ermöglicht dir den Aufbau flexibler Datenpipelines.

- Skalierbarer Umgang mit Metadaten: Wenn die Datenmengen in den Petabyte-Bereich wachsen, wird die Verwaltung von Metadaten (Daten über deine Daten) schwierig. Das führt dazu, dass viele Systeme beim Umgang mit Millionen von Dateien erheblich langsamer werden. Delta Lake kann jedoch massive Skalierungen ohne Leistungseinbußen bewältigen, was es für sehr große Data Lakes geeignet macht.

- Optimierte Lese- und Schreibvorgänge: In Big-Data-Szenarien ist die Leistung entscheidend. Delta Lake nutzt das Überspringen von Daten, Zwischenspeicherung und Verdichtung, um Lese- und Schreibvorgänge zu beschleunigen. Das bedeutet schnellere Abfragen und eine effizientere Nutzung von Rechenressourcen, was in Cloud-Umgebungen Kosten spart.

Der Kurs Big Data Fundamentals with PySpark geht tief in die moderne Datenverarbeitung mit Spark. Es ist eine tolle Auffrischung dieser leistungsstarken Technologie.

Werde Dateningenieur

Apache Iceberg und Delta Lake: Ähnlichkeiten

Da Apache Iceberg und Delta Lake beide große Datenmengen verwalten, wollen wir ihre grundlegenden Gemeinsamkeiten untersuchen.

ACID-Transaktionen und Datenkonsistenz

Beide Tools können mit ACID-Transaktionen und Versionierung volle Datenkonsistenz gewährleisten. Iceberg verwendet jedoch den Merge-on-Read-Ansatz, während Delta Lake die Merge-on-Write-Strategie verwendet .

Daher handhabt jeder die Leistung und das Datenmanagement anders. Iceberg kann eine vollständige Schemaentwicklung unterstützen, während Delta Lake die Schemakonformität durchsetzt.

Unterstützung für Zeitreisen

Mit der Zeitreisefunktion können Nutzer historische Versionen von Daten abfragen. Das macht sie unschätzbar wertvoll für die Prüfung, Fehlersuche und sogar für die Reproduktion von Experimenten. Sowohl Iceberg als auch Delta Lake unterstützen Zeitreisen, d.h. du kannst unbesorgt auf frühere Datenstände zugreifen.

Open-Source-Charakter

Apache Iceberg und Delta Lake sind Open-Source-Technologien. Das heißt, jeder kann sie kostenlos nutzen und sogar helfen, sie zu verbessern. Außerdem bedeutet Open-Source, dass du nicht an das Produkt eines Unternehmens gebunden bist - du hast mehr Freiheit, die Tools nach Bedarf zu wechseln oder zu kombinieren. Und da ihr Code öffentlich ist, kannst du ihn sogar für deine eigenen Bedürfnisse optimieren.

Die wichtigsten Merkmale haben Apache Iceberg und Delta Lake gemeinsam. Bild vom Autor erstellt mit napkin.ai.

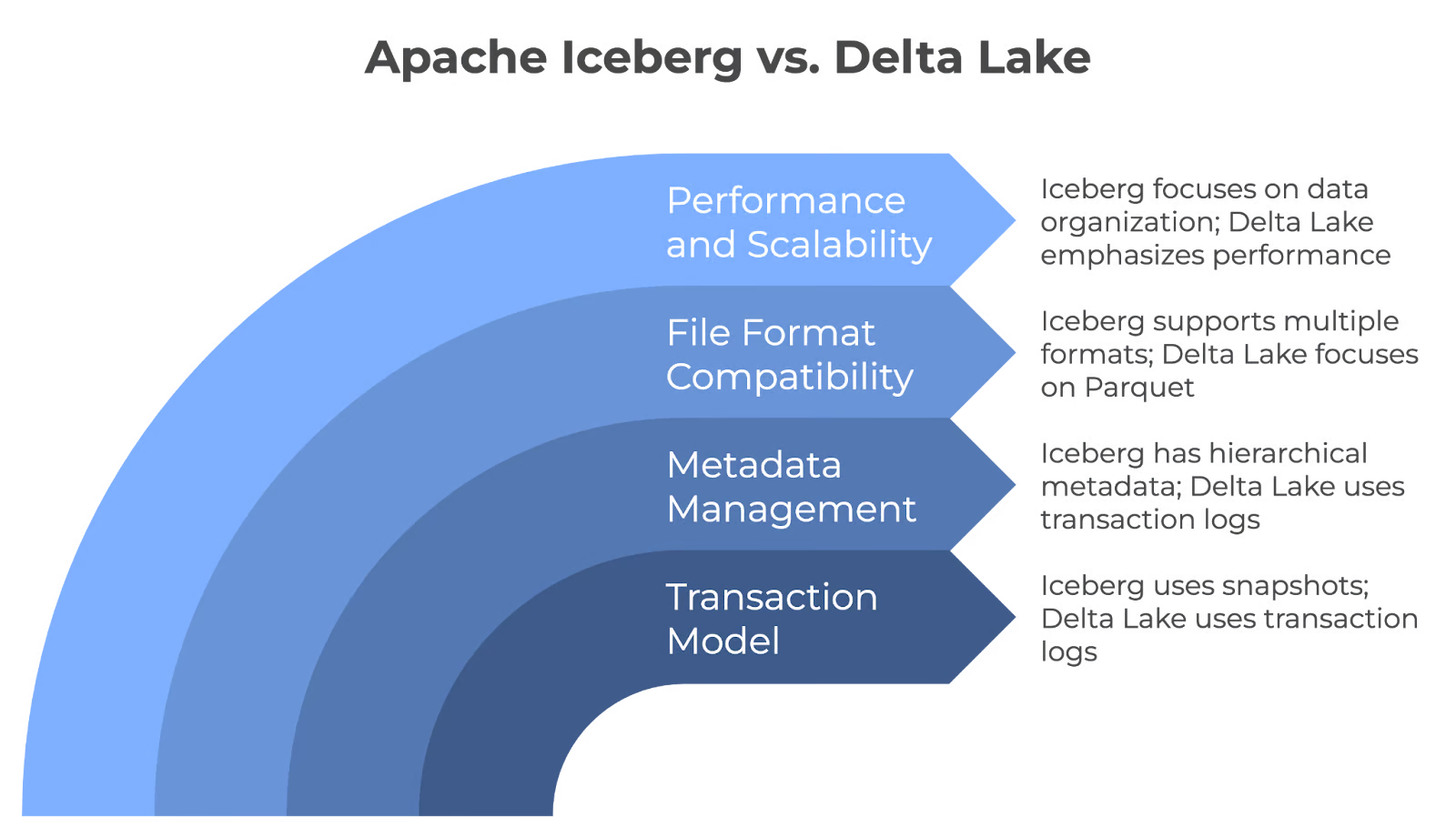

Eisberg gegen Delta Lake: Zentrale Unterschiede in der Architektur

Iceberg und Delta Lake haben zwar Gemeinsamkeiten, aber sie unterscheiden sich in ihrer Architektur. Lass uns sehen, wie:

Transaktionsmodell

Iceberg und Delta Lake gewährleisten die Zuverlässigkeit der Daten in Data Lakes, aber sie erreichen dies durch unterschiedliche Mechanismen. Iceberg verwendet Snapshots für atomare Transaktionen, um sicherzustellen, dass Änderungen vollständig übertragen oder rückgängig gemacht werden. Aber Delta Lake verwendet Transaktionsprotokolle, um sicherzustellen, dass nur validierte Änderungen in die Tabelle übertragen werden, und sorgt für eine zuverlässige Datenaktualisierung.

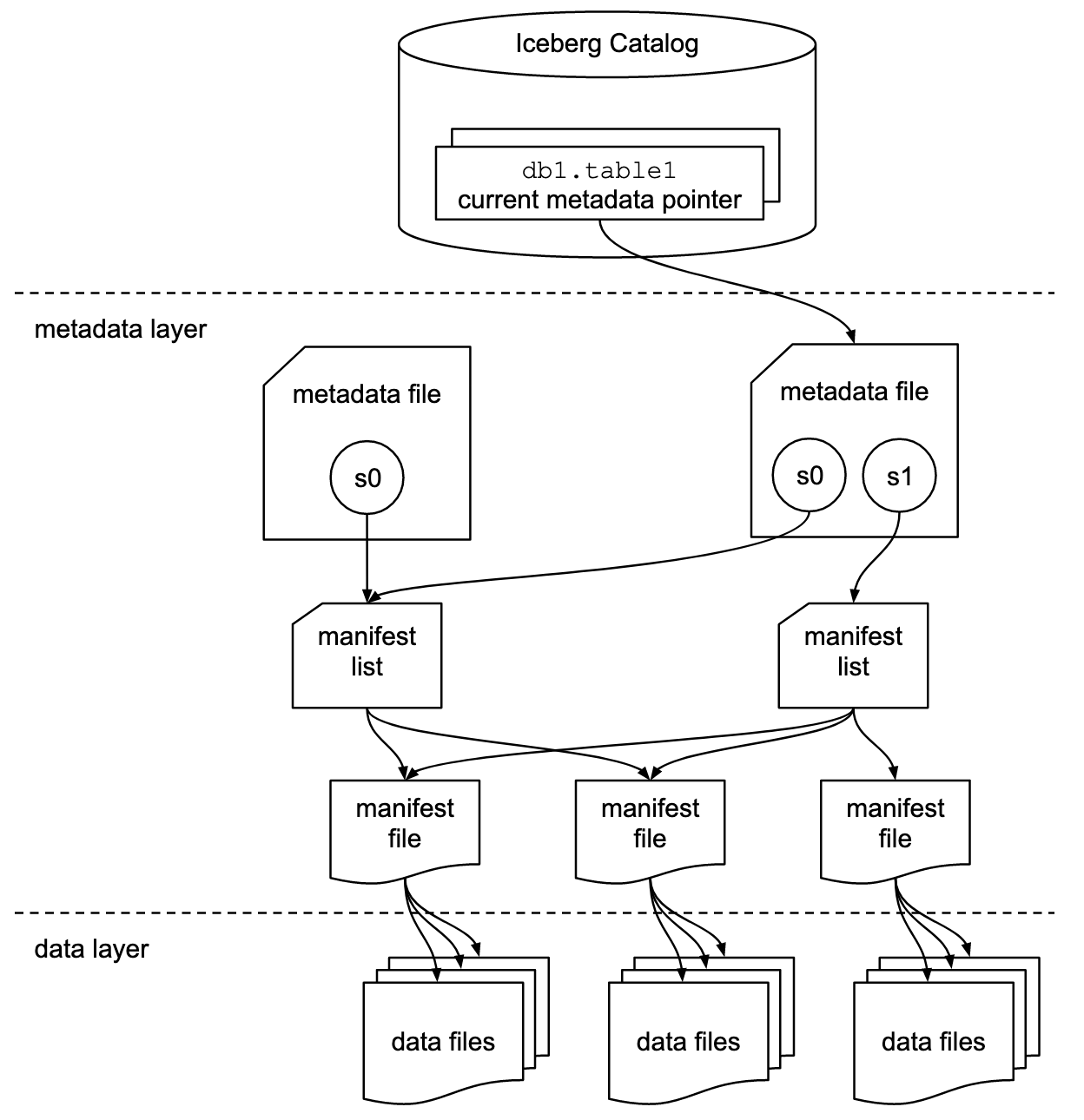

Metadaten-Management

Apache Iceberg verwendet eine hierarchische Metadatenstruktur, die Manifestdateien, Manifestlisten und Metadatendateien umfasst. Dieses Design rationalisiert die Abfrageverarbeitung, da kostspielige Operationen wie das Auflisten und Umbenennen von Dateien entfallen.

Delta Lake verwendet jedoch einen transaktionsbasierten Ansatz, um jede Transaktion in einem Protokoll aufzuzeichnen. Um die Abfrageeffizienz zu verbessern und die Protokollverwaltung zu vereinfachen, werden diese Protokolle regelmäßig in Parquet Checkpoint-Dateien konsolidiert, die den kompletten Tabellenstatus erfassen.

Dateiformat-Kompatibilität

Iceberg ist flexibel mit Dateiformaten und kann nativ mit Parquet-, ORC- und Avro-Dateien arbeiten. Das ist hilfreich, wenn du Daten in verschiedenen Formaten hast oder wenn du in Zukunft die Formate wechseln willst, ohne dein ganzes System zu ändern.

Delta Lake speichert Daten hauptsächlich im Parquet-Format, weil Parquet effizient ist, insbesondere für analytische Abfragen. Sie konzentriert sich nur auf ein Format, um die bestmögliche Leistung für diesen speziellen Dateityp zu erzielen.

Leistung und Skalierbarkeit

Iceberg und Delta Lake skalieren Data Lakes, verwenden aber unterschiedliche Strategien. Iceberg legt den Schwerpunkt auf fortschrittliche Datenorganisation mit Funktionen wie Partitionierung und Verdichtung, während Delta Lake mit seiner Delta Engine, der automatischen Verdichtung und den Indizierungsfunktionen auf hohe Leistung setzt.

Apache Iceberg und Delta Lake Kernunterschiede. Bild vom Autor erstellt mit napkin.ai.

Anwendungsfälle für Apache Iceberg

Aufgrund seiner einzigartigen Funktionen hat sich Apache Iceberg schnell zu einer Standardlösung für modernes Data Lake Management entwickelt. Schauen wir uns einige seiner wichtigsten Anwendungsfälle an, um seine Stärken zu verstehen.

Cloud-native Data Lakes

Hier erfährst du, warum Iceberg eine beliebte Wahl für Unternehmen ist, die Data Lakes in der Cloud betreiben:

- Starke Schema-Evolution: Damit kannst du Spalten hinzufügen, löschen oder ändern, ohne dass sich dies auf bestehende Abfragen auswirkt. Wenn du zum Beispiel ein neues Feld hinzufügen musst, um die Vorlieben der Nutzer zu erfassen, kannst du das tun, ohne deinen gesamten Datensatz neu zu erstellen oder alle Abfragen zu aktualisieren.

- Leistung: Fortgeschrittene Techniken wie Daten-Clustering und Metadatenmanagement optimieren die Abfrageleistung. Sie bereinigen überflüssige Dateien schnell, um die Menge der gescannten Daten zu reduzieren und die Abfragegeschwindigkeit zu erhöhen.

- Skalierbarkeit: Verwalte Milliarden von Dateien und Petabytes an Daten. Außerdem kannst du mit der Partitionsentwicklungsfunktion die Organisation deiner Daten ohne Ausfallzeiten oder teure Migrationen ändern.

Komplexe Datenmodelle

Teams, die mit komplexen Datenmodellen arbeiten, finden Iceberg aus folgenden Gründen besonders nützlich:

- Flexibilität des Schemas: Unterstützt verschachtelte Datentypen (Structs, Listen und Maps), um komplexe Beziehungen darzustellen. Eine E-Commerce-Plattform könnte zum Beispiel Bestelldetails, einschließlich verschachtelter Strukturen für Artikel und Kundendaten, in einer einzigen Tabelle speichern.

- Zeitreise-Anfragen: Bei dieser Methode werden Schnappschüsse deiner Daten aufbewahrt, um die Daten so abzufragen, wie sie zu einem beliebigen Zeitpunkt in der Vergangenheit existierten. Dies ist von unschätzbarem Wert, wenn du den Zustand deiner Daten zu einem bestimmten Zeitpunkt rekonstruieren willst, um die Vorschriften einzuhalten, oder wenn du Analysen mit historischen Daten-Snapshots wiederholen willst.

Integration mit Tools

Iceberg ist mit verschiedenen Tools kompatibel, was es zu einer vielseitigen Wahl für das Datenökosystem macht. Werfen wir einen Blick auf einige der wichtigsten Integrationen:

Iceberg funktioniert nahtlos mit den folgenden Produkten:

- Apache Spark für groß angelegte Datenverarbeitung und maschinelles Lernen.

- Trino für schnelle, verteilte SQL-Abfragen über mehrere Datenquellen.

- Apache Flink für Echtzeit-Stream-Verarbeitung und Batch-Berechnungen.

Die folgenden großen Cloud-Anbieter bieten native Unterstützung für Iceberg:

- Amazon Web Services (AWS) lässt sich mit AWS Glue, Redshift, EMR und Athena integrieren.

- Google Cloud Platform (GCP) arbeitet mit BigQuery und Dataproc.

- Microsoft Azure ist mit Azure Synapse Analytics kompatibel.

Iceberg bietet auch Client-Bibliotheken für verschiedene Programmiersprachen, wie z.B.:

- SQL schreibt Standard-SQL-Abfragen gegen Iceberg-Tabellen.

- Python verwendet PySpark oder Bibliotheken wie pyiceberg zur Datenmanipulation.

- Java nutzt die native Java-API für Low-Level-Operationen und individuelle Integrationen.

Apache Iceberg Tabellenformat Spezifikation. Bildquelle: Eisberg Dokumentation.

Anwendungsfälle für Delta Lake

Delta Lake kann gängige Herausforderungen lösen und die Datenverwaltung vereinfachen. Schauen wir uns einige Schlüsselsituationen an, in denen es wirklich hilft.

Vereinheitlichte Batch- und Streaming-Workloads

Mit Delta Lake brauchst du keine separaten Systeme für verschiedene Datentypen. Stattdessen kannst du ein System haben, das alles regelt. Du kannst neue Daten in Echtzeit zu deinen Tabellen hinzufügen und sie sind sofort für die Analyse bereit. Das bedeutet, dass deine Daten immer aktuell sind.

Du kannst einen einzigen Arbeitsablauf erstellen, der alte und neue Daten verarbeitet, damit dein ganzes System weniger komplex und einfacher zu verwalten ist. Dieser einheitliche Ansatz wird deine Datenpipelines vereinfachen.

ACID-Transaktionen für Data Lakes

Delta Lake bringt durch ACID-Transaktionen eine hohe Datensicherheit in Data Lakes. Zum Beispiel:

- Krankenhäuser können genaue und aktuelle Patientenakten führen, um eine angemessene Pflege zu gewährleisten und die Datenschutzbestimmungen einzuhalten.

- Banken können sicherstellen, dass alle finanziellen Transaktionen genau aufgezeichnet werden und nicht versehentlich geändert werden können.

- Einzelhandelsgeschäfte können ihre Bestände genau zählen, auch wenn viele Aktualisierungen gleichzeitig stattfinden. Das hilft, Probleme zu vermeiden, wie z.B. den Verkauf von Artikeln, die eigentlich nicht auf Lager sind.

Delta Lake erreicht diese Zuverlässigkeit, indem es sicherstellt, dass alle Änderungen entweder vollständig oder gar nicht übernommen werden. Außerdem stellt es sicher, dass die Daten immer von einem gültigen Zustand in einen anderen übergehen und dass sich die verschiedenen Vorgänge nicht gegenseitig stören.

Apache Spark Ökosystem

Delta Lake arbeitet auch nahtlos mit Apache Spark zusammen, ein großer Vorteil für viele Unternehmen. Wenn du bereits Spark verwendest, ist das Hinzufügen von Delta Lake ganz einfach und erfordert keine großen Änderungen an deinem bestehenden System. Dein Team kann die gleichen Spark-Tools und SQL-Befehle verwenden, mit denen es vertraut ist.

Dadurch werden deine Spark-Jobs schneller ausgeführt, vor allem wenn du mit großen Datenmengen arbeitest. Dies geschieht durch eine effizientere Organisation der Daten und intelligente Indexierungstechniken.

Apache Iceberg gegen Delta Lake: Eine Zusammenfassung

Im Folgenden fassen wir die wichtigsten Unterschiede zwischen Apache Iceberg und Delta Lake zusammen, damit du die Stärken und wichtigsten Funktionen der beiden Formate schnell verstehst.

|

Eigenschaften |

Apache Iceberg |

Deltasee |

|

ACID-Transaktion |

Ja |

Ja |

|

Zeitreise |

Ja |

Ja |

|

Datenversionierung |

Ja |

Ja |

|

Dateiformat |

Parquet, ORC, Avro |

Parquet |

|

Schema-Entwicklung |

Vollständig |

Partial |

|

Integration mit anderen Engines |

Apache Spark, Trino, Flink |

Vor allem Apache Spark |

|

Cloud-Kompatibilität |

AWS, GCP, Azure |

AWS, GCP |

|

Query Engines |

Spark, Trino, Flink |

Funke |

|

Programmiersprache |

SQL, Python, Java |

SQL, Python |

Hinweis: Die beste Wahl hängt von deinen Bedürfnissen, deinen Anforderungen an die Skalierbarkeit und deiner langfristigen Datenstrategie ab.

Fazit

Wenn du dich zwischen Apache Iceberg und Delta Lake entscheidest, solltest du deinen spezifischen Anwendungsfall und deinen bestehenden Technologie-Stack berücksichtigen. Icebergs Flexibilität bei Dateiformaten und Abfrage-Engines macht es ideal für Cloud-native Umgebungen. Die enge Integration von Delta Lake mit Apache Spark ist jedoch eine gute Option für Unternehmen, die stark in das Spark-Ökosystem investiert haben.

Du kannst dir auch einige relevante DataCamp-Ressourcen ansehen, um dein bestehendes Datenverständnis zu stärken:

- Kurs zum Verständnis von Data Engineering, um die grundlegenden Konzepte zu verstehen

- Kurse zu Datenbankdesign und Data Warehousing, um große Datenmengen effektiv zu strukturieren.

- Modern Data Architecture Kurs, um mehr über aktuelle Best Practices und Trends zu erfahren.

Viel Spaß beim Lernen!

Werde Dateningenieur

FAQs

Was ist der Hauptunterschied zwischen Merge-on-Read und Merge-on-Write Strategien?

Merge-on-Read (wird von Iceberg verwendet) liest Daten aus bestehenden Dateien und wendet Änderungen während der Abfragezeit an. Merge-on-Write (verwendet von Delta Lake) fügt Aktualisierungen während des Schreibvorgangs in die Basisdaten ein, um schnellere Lesevorgänge auf Kosten langsamerer Schreibvorgänge zu gewährleisten.

Können Apache Iceberg und Delta Lake Daten im Petabyte-Bereich verarbeiten?

Ja, sowohl Apache Iceberg als auch Delta Lake verarbeiten effizient Datenmengen im Petabyte-Bereich. Sie bieten fortschrittliche Funktionen wie Partitionierung, Metadatenmanagement und Komprimierung, um die Leistung großer Data Lakes zu optimieren.

Wie funktionieren Apache Iceberg und Delta Lake bei der Abfrage von tief verschachtelten Datenstrukturen?

Apache Iceberg eignet sich hervorragend zum Abfragen von tief verschachtelten Datenstrukturen. Es unterstützt tabellarische Speicherformate wie Parquet, die für verschachtelte Daten optimiert sind. Auf der anderen Seite unterstützt Delta Lake auch verschachtelte Daten, aber die Leistung kann je nach Komplexität der Abfrage und Größe des Datensatzes variieren.

Können Apache Iceberg und Delta Lake in derselben Data-Lake-Architektur zusammenarbeiten?

Ja, Apache Iceberg und Delta Lake können innerhalb desselben Data Lake nebeneinander existieren. Jede kann je nach Anforderung für unterschiedliche Anwendungsfälle genutzt werden. Du könntest zum Beispiel Delta Lake für Workloads verwenden, die sich auf Apache Spark konzentrieren, und Iceberg für eine flexiblere Integration mit verschiedenen Abfrage-Engines.

Gibt es Einschränkungen bei der Verwendung von Delta Lake mit Nicht-Spark-Motoren?

Delta Lake ist eng mit Apache Spark integriert und kann auch mit anderen Engines wie Presto oder Hive zusammenarbeiten, aber diese Integrationen sind noch in der Entwicklung. Die Leistung ist möglicherweise nicht so optimiert wie bei Spark, was die Effektivität außerhalb des Spark-Ökosystems einschränken könnte.

Wie gehen Iceberg und Delta Lake mit Problemen mit kleinen Dateien in Data Lakes um?

Sowohl Apache Iceberg als auch Delta Lake lösen das Problem der kleinen Dateien durch Verdichtung. Iceberg fasst regelmäßig kleine Dateien zusammen, um die Abfrageleistung zu optimieren, während Delta Lake die automatische Verdichtung nutzt, um Dateien bei Schreibvorgängen zu konsolidieren. Dies sorgt für eine bessere Leistung, indem der durch viele kleine Dateien verursachte Overhead reduziert wird.

Warum hat Databricks Tabular (das Unternehmen hinter Iceberg) übernommen?

Databricks hat Tabular übernommen, um seine Fähigkeiten mit Apache Iceberg zu stärken, das ursprünglich von den Gründern von Tabular entwickelt wurde. Ziel der Übernahme ist es, die Kompatibilität und Interoperabilität zwischen Delta Lake und Iceberg zu verbessern und letztendlich auf ein einheitliches Lakehouse-Format hinzuarbeiten, das die Stärken der beiden Open-Source-Projekte vereint.

Was bedeutet die Übernahme von Tabular für die Nutzer von Delta Lake und Iceberg?

Die Übernahme bedeutet, dass Databricks aktiv daran arbeiten wird, Delta Lake und Iceberg in Bezug auf die Kompatibilität näher zusammenzubringen. Die Nutzer werden von einer verbesserten Integration profitieren, da Delta Lake UniForm bereits als Plattform für die Interoperabilität zwischen Delta Lake, Iceberg und Apache Hudi dient. So können die Nutzer/innen mit verschiedenen Formaten arbeiten, ohne an eine einzige Lösung gebunden zu sein.

Wird Databricks weiterhin sowohl Delta Lake als auch Iceberg unterstützen?

Ja, Databricks hat sein Engagement für beide Formate angekündigt. Mit der Übernahme von Tabular und der Einbindung der ursprünglichen Entwickler von Apache Iceberg will Databricks die Zusammenarbeit zwischen der Iceberg- und der Delta Lake-Community fördern. Ihr Ziel ist es, einen einheitlichen, offenen Standard für die Interoperabilität von Seehausformaten zu entwickeln, der den Nutzern mehr Möglichkeiten und Flexibilität bietet.

Ich bin ein Inhaltsstratege, der es liebt, komplexe Themen zu vereinfachen. Ich habe Unternehmen wie Splunk, Hackernoon und Tiiny Host geholfen, ansprechende und informative Inhalte für ihr Publikum zu erstellen.