programa

Alibaba acaba de lanzar Qwen2.5-Max, su modelo de IA más avanzado hasta la fecha. No se trata de un modelo de razonamiento como DeepSeek R1 o el o1 de OpenAI, lo que significa que no puedes ver su proceso de pensamiento.

Es mejor pensar en Qwen2.5-Max como un modelo generalista y competidor de GPT-4o, Claude 3.5 Sonnet o DeepSeek V3.

En este blog, repasaré qué es Qwen2.5-Max, cómo se desarrolló, cómo se compara con la competencia y cómo puedes acceder a él.

¿Qué es Qwen2,5-Max?

Qwen2.5-Max es el modelo de IA más potente de Alibaba hasta la fecha, diseñado para competir con modelos de primer nivel como GPT-4o, Claude 3.5 Sonnet y DeepSeek V3.

Alibaba, una de las mayores empresas tecnológicas de China, es más conocida por sus plataformas de comercio electrónico, pero también ha construido una fuerte presencia en computación en nube y inteligencia artificial. La serie Qwen forma parte de su ecosistema de IA más amplio, que abarca desde modelos más pequeños de peso abierto hasta sistemas propietarios a gran escala.

A diferencia de algunos modelos Qwen anteriores, Qwen2.5-Max no es de código abierto, lo que significa que sus pesos no están disponibles públicamente.

Entrenado con 20 billones de fichas, Qwen2.5-Max tiene una amplia base de conocimientos y una gran capacidad de IA general. Sin embargo, no es un modelo de razonamiento como DeepSeek R1 o el o1 de OpenAI, lo que significa que no muestra explícitamente su proceso de pensamiento. Sin embargo, dada la actual expansión de la IA de Alibaba, es posible que veamos un modelo de razonamiento dedicado en el futuro, posiblemente con Qwen 3.

¿Cómo funciona Qwen2,5-Max?

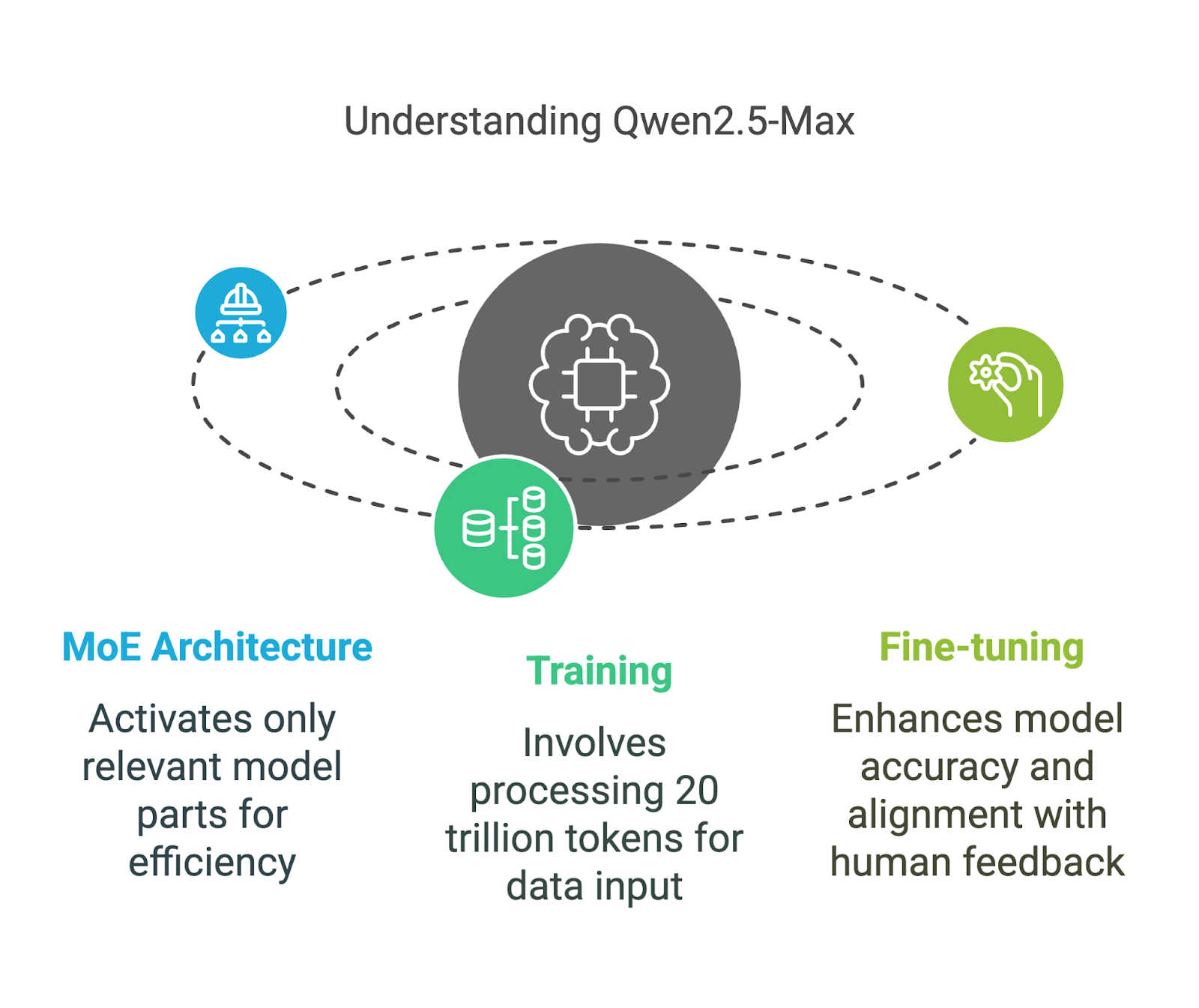

Qwen2.5-Max utiliza una Mezcla de Expertos (MoE) una técnica que también emplea DeepSeek V3. Este planteamiento permite ampliar el modelo manteniendo unos costes computacionales manejables. Vamos a desglosar sus componentes clave de una forma fácil de entender.

Arquitectura de Mezcla de Expertos (MDE)

A diferencia de los modelos de IA tradicionales, que utilizan todos sus parámetros para cada tarea, los modelos MoE como Qwen2.5-Max y DeepSeek V3 sólo activan las partes más relevantes del modelo en cada momento.

Puedes pensar en ello como en un equipo de especialistas: si haces una pregunta compleja sobre física, sólo responden los expertos en física, mientras que el resto del equipo permanece inactivo. Esta activación selectiva significa que el modelo puede manejar el procesamiento a gran escala de forma más eficiente sin requerir cantidades extremas de potencia de cálculo.

Este método hace que Qwen2.5-Max sea potente y escalable, lo que le permite competir con modelos densos como GPT-4o y Claude 3.5 Sonnet, y al mismo tiempo consume menos recursos: un modelo denso es aquel en el que todos los parámetros se activan para cada entrada.

Formación y puesta a punto

Qwen2.5-Max se entrenó con 20 billones de tokens, cubriendo una amplia gama de temas, idiomas y contextos.

Para poner 20 billones de tokens en perspectiva, eso equivale aproximadamente a 15 billones de palabras, una cantidad tan enorme que es difícil de comprender. A modo de comparación, la obra de George Orwell 1984 contiene unas 89.000 palabras, lo que significa que Qwen2.5-Max se ha entrenado en el equivalente a 168 millones de ejemplares de 1984.

Sin embargo, los datos de entrenamiento en bruto por sí solos no garantizan un modelo de IA de alta calidad, por lo que Alibaba lo perfeccionó aún más con:

- Ajuste fino supervisado (SFT): Los anotadores humanos proporcionaron respuestas de alta calidad para guiar al modelo en la producción de resultados más precisos y útiles.

- Aprendizaje por refuerzo a partir de la retroalimentación humana (RLHF): El modelo fue entrenado para alinear sus respuestas con las preferencias humanas, garantizando que las respuestas sean más naturales y conscientes del contexto.

Puntos de referencia de Qwen2.5-Max

Qwen2.5-Max se ha probado frente a otros modelos de IA líderes para medir sus capacidades en diversas tareas. Estas pruebas evalúan tanto los modelos instructores (que se ajustan para tareas como chatear y codificar) como los modelos base (que sirven de base bruta antes del ajuste). Comprender esta distinción ayuda a aclarar lo que significan realmente las cifras.

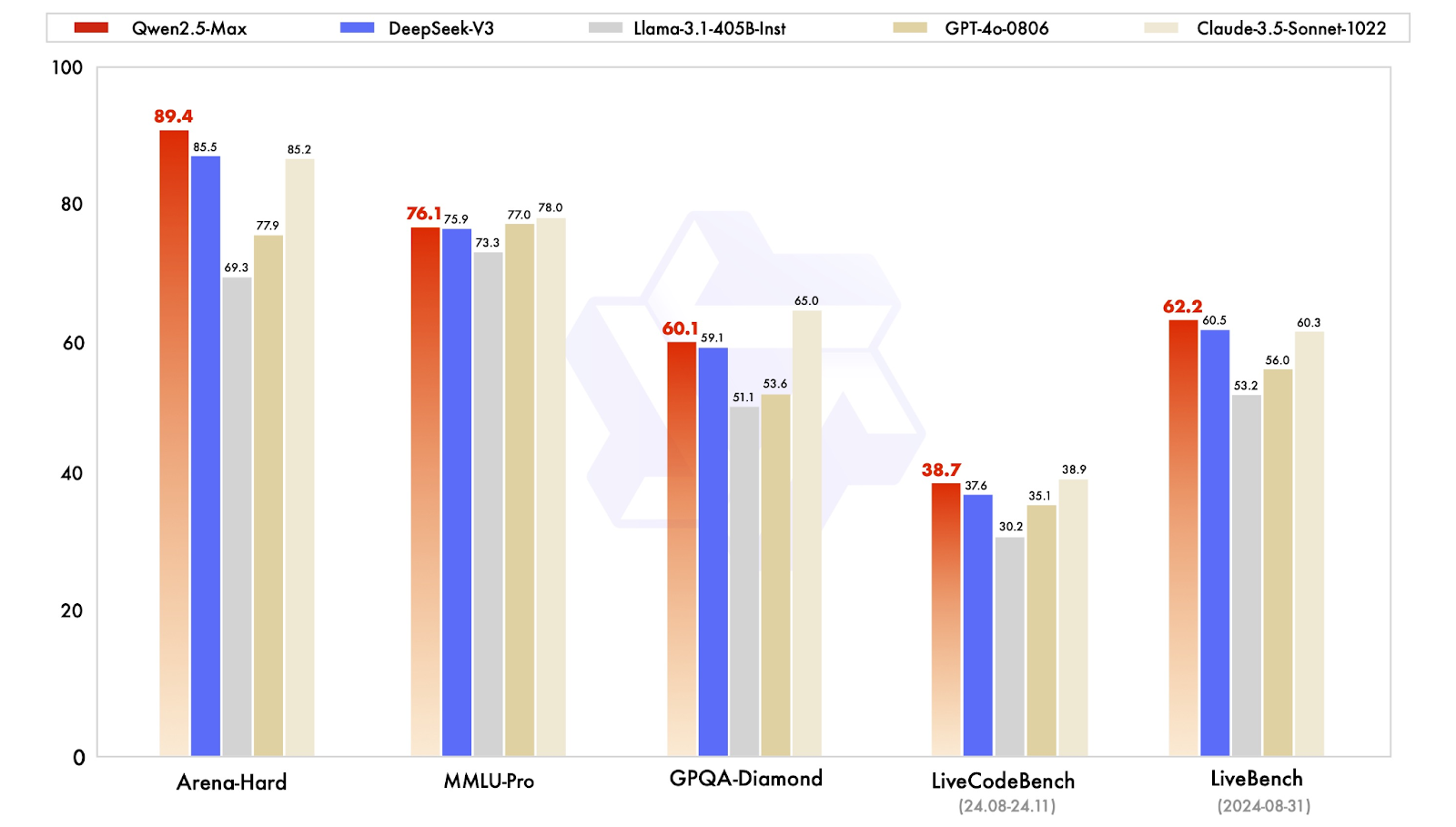

Instruye a los modelos de referencia

Los modelos de instrucción se ajustan a las aplicaciones del mundo real, como la conversación, la codificación y las tareas de conocimiento general. Qwen2.5-Max se compara aquí con modelos como GPT-4o, Claude 3.5 Sonnet, Llama 3.1 405By DeepSeek V3.

Comparación de los modelos instructores. Fuente: QwenLM

Desglosemos rápidamente los resultados:

- Arena-Hard (punto de referencia de preferencias): Qwen2.5-Max obtiene una puntuación de 89,4, por delante de DeepSeek V3 (85,5) y Claude 3.5 Sonnet (85,2). Este punto de referencia se aproxima a la preferencia humana en las respuestas generadas por la IA.

- MMLU-Pro (conocimiento y razonamiento): Qwen2.5-Max obtiene una puntuación de 76,1, ligeramente por delante de DeepSeek V3 (75,9), pero también ligeramente por detrás del líder Claude 3.5 Sonnet (78,0), y del subcampeón GPT-4o (77,0).

- GPQA-Diamante (garantía de calidad de conocimientos generales): Con una puntuación de 60,1, Qwen2.5-Max supera a DeepSeek V3 (59,1), mientras que Claude 3.5 Sonnet lidera con 65,0.

- LiveCodeBench (capacidad de codificación): Con 38,7, Qwen2.5-Max está más o menos a la par con DeepSeek V3 (37,6), pero por detrás de Claude 3.5 Sonnet (38,9).

- LiveBench (capacidades generales): Qwen2.5-Max lidera con una puntuación de 62,2, superando a DeepSeek V3 (60,5) y Claude 3.5 Sonnet (60,3), lo que indica una amplia competencia en tareas de IA del mundo real.

En general, Qwen2.5-Max demuestra ser un modelo de IA completo, que destaca en tareas basadas en preferencias y en capacidades generales de IA, al tiempo que mantiene conocimientos competitivos y habilidades de codificación.

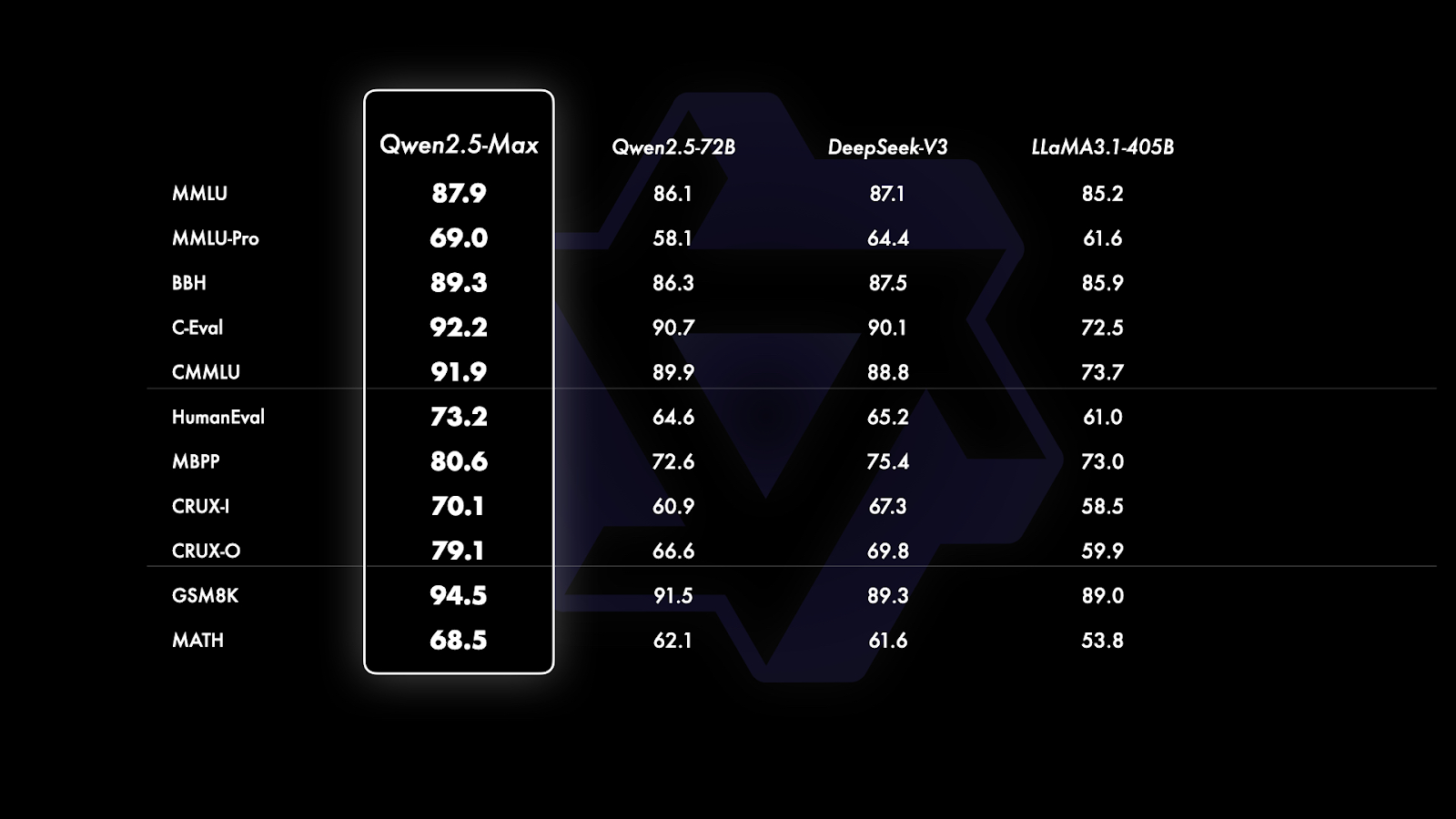

Modelos base de referencia

Desde GPT-4o y Claude 3.5 Sonnet son modelos propietarios sin versiones base disponibles públicamente, la comparación se limita a modelos de peso abierto como Qwen2.5-Max, DeepSeek V3, LLaMA 3.1-405B y Qwen 2.5-72B. Esto proporciona una imagen más clara de la posición de Qwen2.5-Max frente a los principales modelos abiertos a gran escala.

Comparación de los modelos base. Fuente: QwenLM

Si te fijas bien en el gráfico anterior, está dividido en tres secciones basadas en el tipo de puntos de referencia que se evalúan:

- Conocimientos generales y comprensión lingüística (MMLU, MMLU-Pro, BBH, C-Eval, CMMU): Qwen2.5-Max lidera todas las pruebas comparativas en esta categoría, con una puntuación de 87,9 en MMLU y 92,2 en C-Eval, superando a DeepSeek V3 y Llama 3.1-405B. Estos puntos de referencia se centran en la amplitud y profundidad de los conocimientos y en la capacidad de aplicarlos en un contexto de razonamiento.

- Codificación y resolución de problemas (HumanEval, MBPP, CRUX-I, CRUX-O): Qwen2.5-Max también es líder en todas las pruebas de rendimiento y rinde bien en tareas relacionadas con la codificación, con una puntuación de 73,2 en HumanEval y 80,6 en MBPP, ligeramente por delante de DeepSeek V3 y significativamente por delante de Llama 3.1-405B. Estos puntos de referencia miden las habilidades de codificación, la resolución de problemas y la capacidad de seguir instrucciones o generar soluciones de forma independiente.

- Resolución de problemas matemáticos (GSM8K, MATH): El razonamiento matemático es una de las áreas más fuertes de Qwen2.5-Max, que alcanza 94,5 en GSM8K, muy por delante de DeepSeek V3 (89,3) y Llama 3.1-405B (89,0). Sin embargo, en MATEMÁTICAS, que se centra en la resolución de problemas más complejos, Qwen2.5-Max obtiene una puntuación de 68,5, superando ligeramente a sus competidores pero dejando margen de mejora.

Cómo acceder a Qwen2.5-Max

Acceder a Qwen2.5-Max es sencillo, y puedes probarlo gratis sin ninguna configuración complicada.

Chat de Qwen

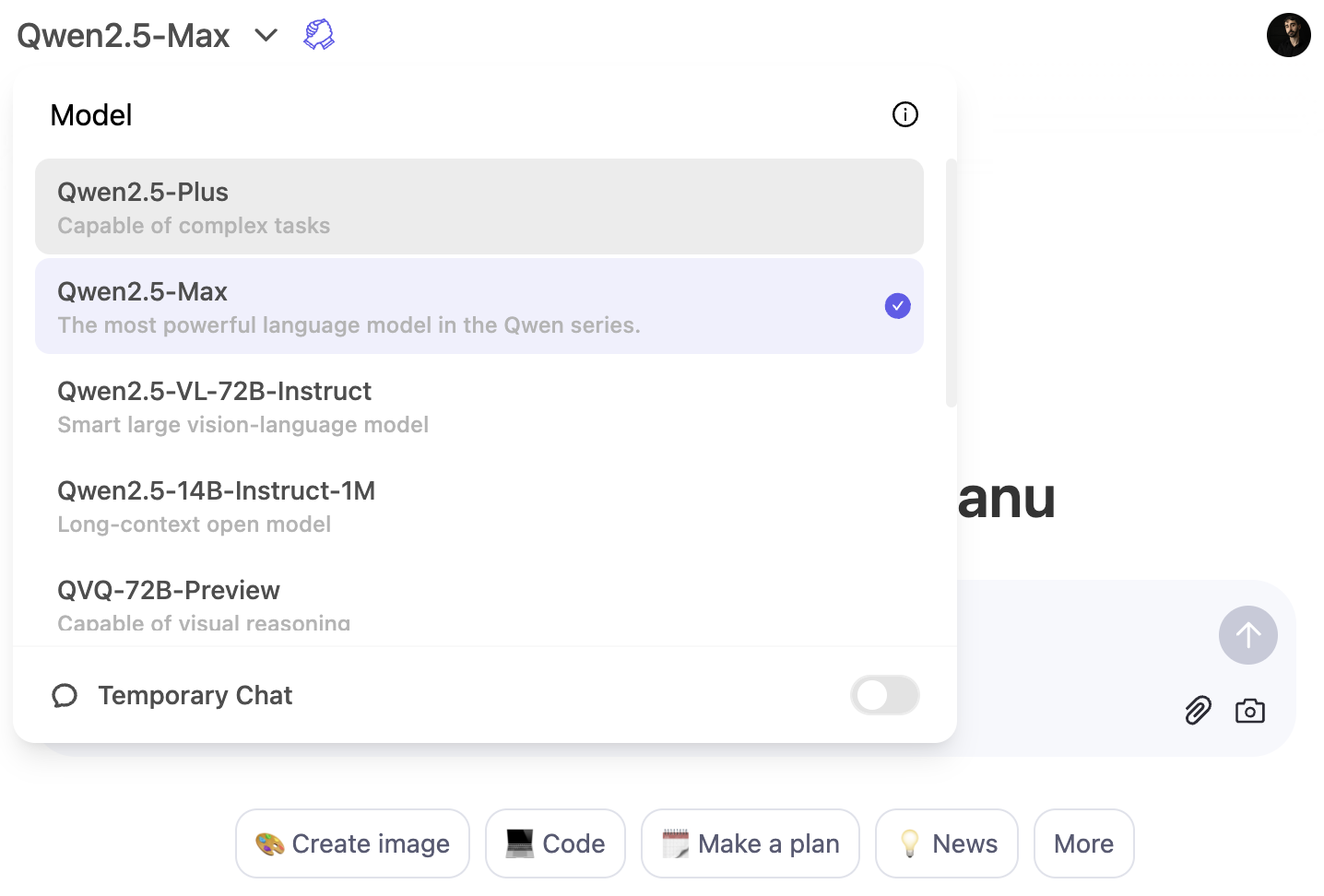

La forma más rápida de experimentar Qwen2.5-Max es a través del Chat Qwen de Qwen. Se trata de una interfaz basada en web que te permite interactuar con el modelo directamente en tu navegador, igual que usarías ChatGPT en tu navegador.

Para utilizar el modelo Qwen2,5-Max, haz clic en el menú desplegable del modelo y selecciona Qwen2,5-Max:

Acceso a la API a través de Alibaba Cloud

Para los desarrolladores, Qwen2.5-Max está disponible a través de la API Alibaba Cloud Model Studio. Para utilizarlo, tendrás que registrarte en una cuenta de Alibaba Cloud, activar el servicio Model Studio y generar una clave API.

Como la API sigue el formato de OpenAI, la integración debería ser sencilla si ya estás familiarizado con los modelos de OpenAI. Para obtener instrucciones detalladas de configuración, visita el blog oficial de Qwen2.5-Max.

Conclusión

Qwen2.5-Max es el modelo de IA más capaz de Alibaba hasta la fecha, creado para competir con modelos de primer nivel como GPT-4o, Claude 3.5 Sonnet y DeepSeek V3.

A diferencia de algunos modelos anteriores de Qwen, Qwen2.5-Max no es de código abierto, pero está disponible para probarlo a través del chat de Qwen o mediante el acceso a la API en Alibaba Cloud.

Dada la continua inversión de Alibaba en IA, no sería sorprendente ver un modelo centrado en el razonamiento en el futuro, posiblemente con Qwen 3.

Si quieres leer más noticias sobre IA, te recomiendo estos artículos:

Preguntas frecuentes

¿Puedes configurar Qwen2.5-Max localmente?

No, Qwen2.5-Max no está disponible como modelo de peso abierto, por lo que no puedes ejecutarlo en tu propio hardware. Sin embargo, Alibaba proporciona acceso a través de Qwen Chat y la API de Alibaba Cloud.

¿Puedes ajustar Qwen2.5-Max?

No, dado que el modelo no es de código abierto, Alibaba no ha proporcionado a los usuarios una forma de ajustar Qwen2.5-Max. Sin embargo, es posible que ofrezcan variaciones afinadas en el futuro o que permitan una personalización limitada a través de los ajustes de la API.

¿Será Qwen2.5-Max de código abierto en el futuro?

Alibaba no ha indicado planes para lanzar Qwen2.5-Max como modelo de peso abierto, pero dado su historial de lanzamiento de modelos abiertos más pequeños, es posible que futuras iteraciones incluyan versiones de peso abierto.

¿Puede Qwen2.5-Max generar imágenes como DALL-E 3 o Janus-Pro?

No, Qwen2.5-Max es un modelo de IA basado en texto y centrado en tareas como conocimientos generales, codificación y resolución de problemas matemáticos. No admite la generación de imágenes.