Lernpfad

Alibaba hat gerade Qwen2.5-Maxveröffentlicht , sein bisher fortschrittlichstes KI-Modell. Es handelt sich nicht um ein Argumentationsmodell wie DeepSeek R1 oder OpenAIs o1, das heißt, du kannst seinen Denkprozess nicht sehen.

Es ist besser, Qwen2.5-Max als generalistisches Modell zu betrachten und als Konkurrenz zu GPT-4o, Claude 3.5 Sonnet oder DeepSeek V3.

In diesem Blog gehe ich darauf ein, was Qwen2.5-Max ist, wie es entwickelt wurde, wie es sich von der Konkurrenz abhebt und wie du es nutzen kannst.

Was ist Qwen2.5-Max?

Qwen2.5-Max ist das bisher leistungsstärkste KI-Modell von Alibaba, das mit Spitzenmodellen wie GPT-4o, Claude 3.5 Sonnet und DeepSeek V3 konkurrieren soll.

Alibaba, eines der größten Tech-Unternehmen Chinas, ist vor allem für seine E-Commerce-Plattformen bekannt, hat sich aber auch eine starke Präsenz im Cloud Computing und künstlicher Intelligenz. Die Qwen-Reihe ist Teil des breiteren KI-Ökosystems, das von kleineren offenen Modellen bis hin zu großen proprietären Systemen reicht.

Im Gegensatz zu einigen früheren Qwen-Modellen ist Qwen2.5-Max nicht quelloffen, d.h. seine Gewichte sind nicht öffentlich zugänglich.

Qwen2.5-Max wurde auf 20 Billionen Token trainiert und verfügt über eine umfangreiche Wissensbasis und starke allgemeine KI-Fähigkeiten. Es ist jedoch kein Denkmodell wie DeepSeek R1 oder OpenAIs o1, d.h. es zeigt nicht explizit seinen Denkprozess. Angesichts der fortschreitenden KI-Expansion von Alibaba könnten wir jedoch in Zukunft ein spezielles Argumentationsmodell sehen - möglicherweise mit Qwen 3.

Wie funktioniert Qwen2.5-Max?

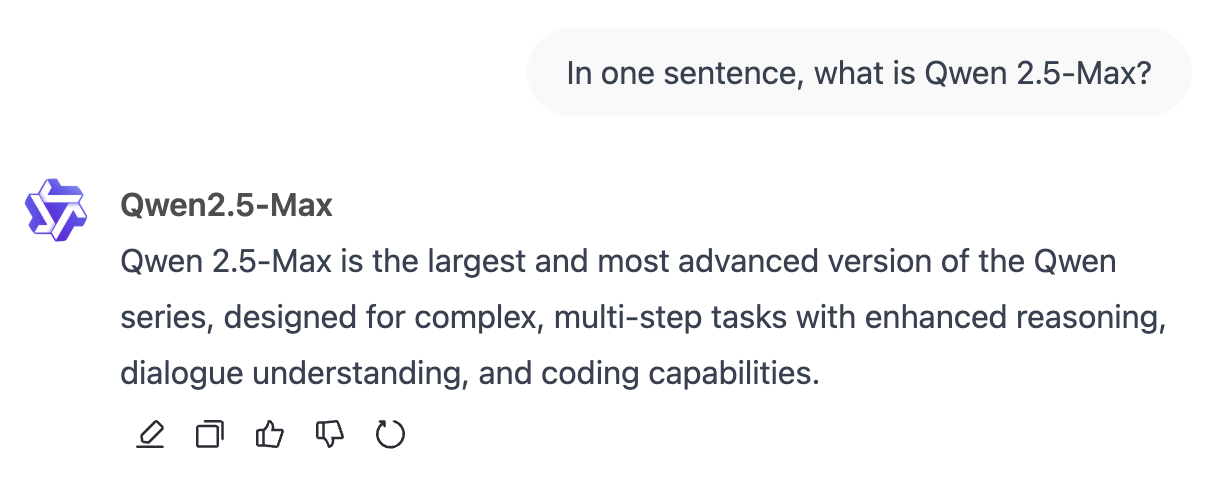

Qwen2.5-Max verwendet eine Mixture-of-Experts (MoE) Architektur, eine Technik, die auch von DeepSeek V3. Mit diesem Ansatz kann das Modell skaliert werden, während die Rechenkosten überschaubar bleiben. Schauen wir uns die wichtigsten Komponenten so an, dass sie leicht zu verstehen sind.

Mixture-of-Experts (MoE) Architektur

Im Gegensatz zu traditionellen KI-Modellen, die alle Parameter für jede Aufgabe nutzen, aktivieren MoE-Modelle wie Qwen2.5-Max und DeepSeek V3 nur die jeweils wichtigsten Teile des Modells.

Du kannst es dir wie ein Team von Spezialisten vorstellen: Wenn du eine komplexe Frage zur Physik stellst, antworten nur die Experten für Physik, während der Rest des Teams untätig bleibt. Diese selektive Aktivierung bedeutet, dass das Modell große Datenmengen effizienter verarbeiten kann, ohne extrem viel Rechenleistung zu benötigen.

Diese Methode macht Qwen2.5-Max sowohl leistungsfähig als auch skalierbar und ermöglicht es, sich mit dichten Modellen wie GPT-4o und Claude 3.5 Sonnet konkurrieren und gleichzeitig ressourceneffizienter sein - ein dichtes Modell ist ein Modell, bei dem alle Parameter für jede Eingabe aktiviert werden.

Ausbildung und Feinabstimmung

Qwen2.5-Max wurde auf 20 Billionen Token trainiert, die eine große Bandbreite an Themen, Sprachen und Kontexten abdecken.

Um die 20 Billionen Token in die richtige Perspektive zu rücken, sind das etwa 15 Billionen Wörter - eine so große Menge, dass sie kaum zu fassen ist. Zum Vergleich: George Orwells 1984 enthält etwa 89.000 Wörter, was bedeutet, dass Qwen2.5-Max auf das Äquivalent von 168 Millionen Exemplaren von 1984 trainiert wurde .

Da rohe Trainingsdaten allein jedoch kein Garant für ein hochwertiges KI-Modell sind, hat Alibaba es weiter verfeinert:

- Überwachte Feinabstimmung (SFT): Menschliche Annotatoren lieferten qualitativ hochwertige Antworten, um das Modell bei der Erstellung genauer und nützlicher Ergebnisse zu unterstützen.

- Verstärkungslernen aus menschlichem Feedback (RLHF): Das Modell wurde so trainiert, dass es seine Antworten an die menschlichen Präferenzen anpasst, damit die Antworten natürlicher und kontextbezogener sind.

Qwen2.5-Max Benchmarks

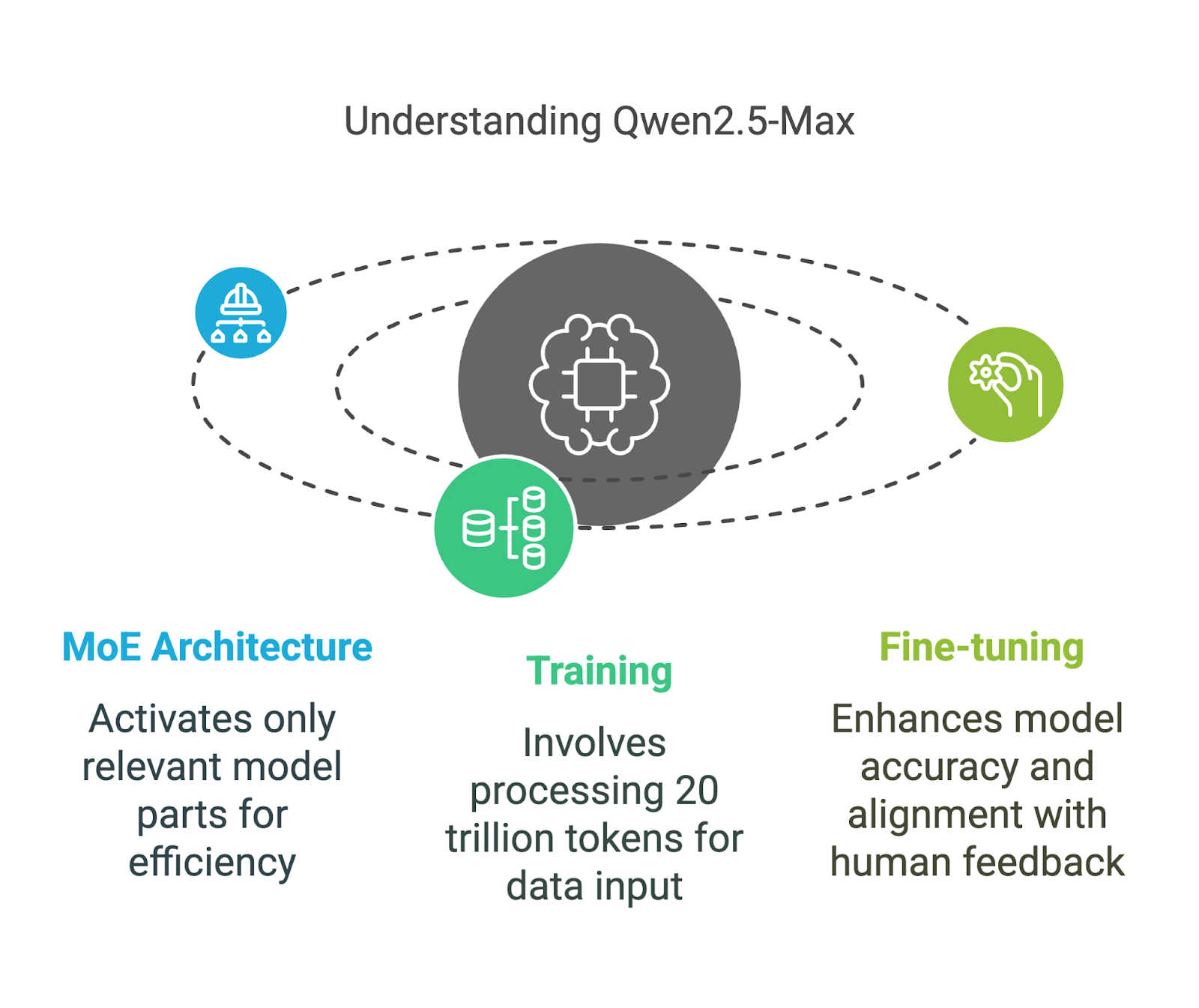

Qwen2.5-Max wurde gegen andere führende KI-Modelle getestet, um seine Fähigkeiten bei verschiedenen Aufgaben zu messen. Diese Benchmarks bewerten sowohl Instruct-Modelle (die für Aufgaben wie Chatten und Codieren fein abgestimmt sind) als auch Basismodelle (die als Rohbasis vor der Feinabstimmung dienen). Wenn du diesen Unterschied verstehst, wird klar, was die Zahlen wirklich bedeuten.

Modelle anleiten Benchmarks

Die Unterrichtsmodelle sind auf reale Anwendungen abgestimmt, darunter Konversation, Codierung und allgemeine Wissensaufgaben. Qwen2.5-Max wird hier mit Modellen wie GPT-4o, Claude 3.5 Sonnet verglichen, Llama 3.1 405Bund DeepSeek V3.

Vergleich der Instruktionsmodelle. Quelle: QwenLM

Schauen wir uns die Ergebnisse kurz an:

- Arena-Hard (Präferenz-Benchmark): Qwen2.5-Max erreicht 89,4 Punkte und liegt damit vor DeepSeek V3 (85,5) und Claude 3.5 Sonnet (85,2). Dieser Benchmark nähert sich der menschlichen Präferenz bei KI-generierten Antworten an.

- MMLU-Pro (Wissen und logisches Denken): Qwen2.5-Max liegt mit 76,1 Punkten leicht vor DeepSeek V3 (75,9), aber auch leicht hinter dem Spitzenreiter Claude 3.5 Sonnet (78,0) und dem Zweitplatzierten GPT-4o (77,0).

- GPQA-Diamond (general knowledge QA): Mit 60,1 Punkten liegt Qwen2.5-Max vor DeepSeek V3 (59,1), während Claude 3.5 Sonnet mit 65,0 Punkten führt.

- LiveCodeBench (Codierfähigkeit): Mit 38,7 liegt Qwen2.5-Max ungefähr gleichauf mit DeepSeek V3 (37,6), aber hinter Claude 3.5 Sonnet (38,9).

- LiveBench (allgemeine Fähigkeiten): Qwen2.5-Max führt mit einer Punktzahl von 62,2 vor DeepSeek V3 (60,5) und Claude 3.5 Sonnet (60,3), was auf eine breite Kompetenz bei realen KI-Aufgaben hinweist.

Insgesamt erweist sich Qwen2.5-Max als ein vielseitiges KI-Modell, das sich bei präferenzbasierten Aufgaben und allgemeinen KI-Fähigkeiten auszeichnet und gleichzeitig wettbewerbsfähige Kenntnisse und Programmierfähigkeiten besitzt.

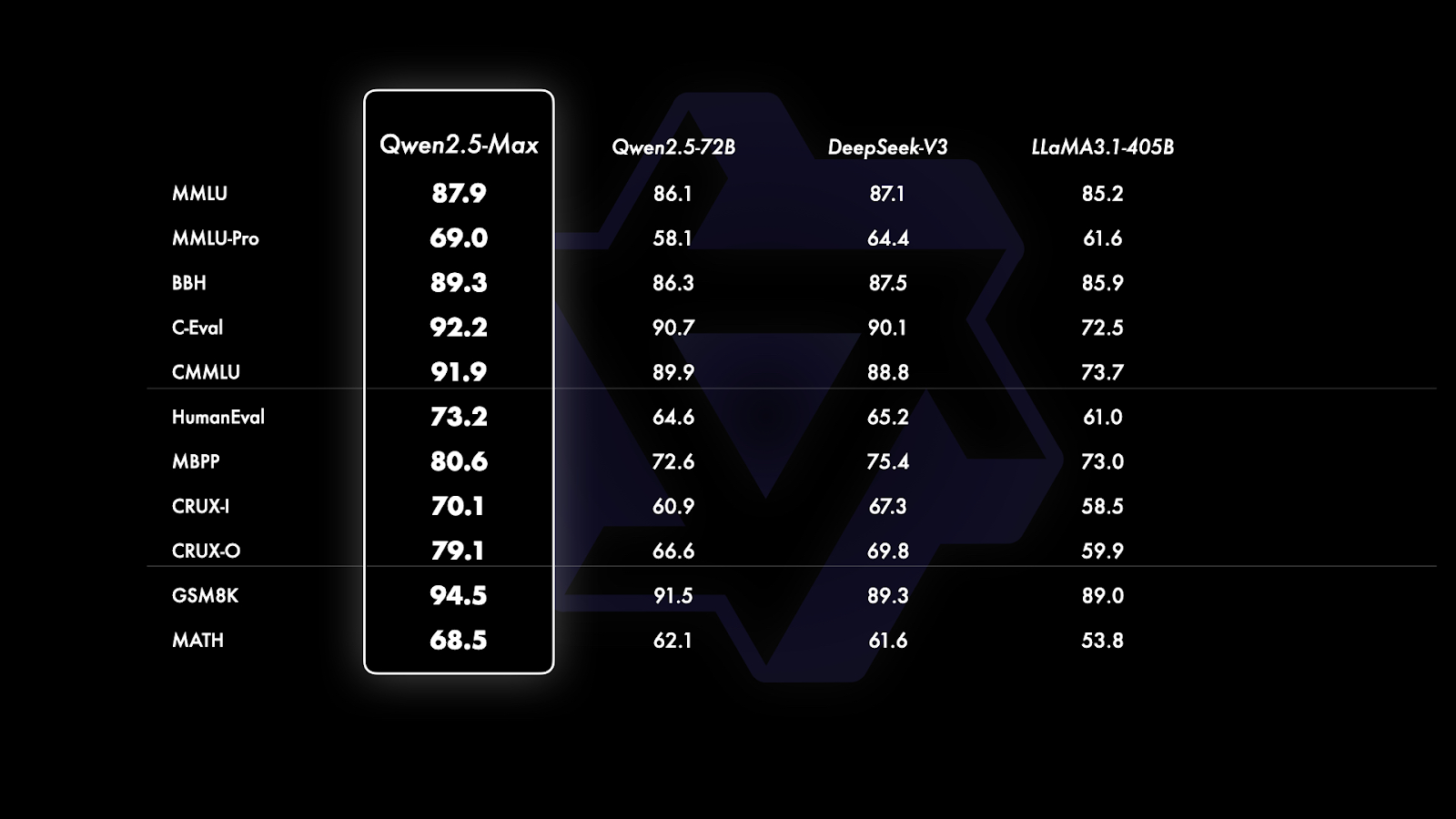

Basis Modelle Benchmarks

Seit GPT-4o und Claude 3.5 Sonnet proprietäre Modelle ohne öffentlich verfügbare Basisversionen sind, beschränkt sich der Vergleich auf Modelle mit offenem Gewicht wie Qwen2.5-Max, DeepSeek V3, LLaMA 3.1-405B und Qwen 2.5-72B. Dadurch wird klarer, wie Qwen2.5-Max im Vergleich zu führenden offenen Großmodellen abschneidet.

Vergleich der Basismodelle. Quelle: QwenLM

Wenn du dir die Grafik oben genau ansiehst, ist sie in drei Abschnitte unterteilt, die sich auf die Art der bewerteten Benchmarks beziehen:

- Allgemeinwissen und Sprachverständnis (MMLU, MMLU-Pro, BBH, C-Eval, CMMU): Qwen2.5-Max ist in dieser Kategorie in allen Benchmarks führend, erreicht 87,9 Punkte bei MMLU und 92,2 Punkte bei C-Eval und übertrifft damit DeepSeek V3 und Llama 3.1-405B. Diese Benchmarks konzentrieren sich auf die Breite und Tiefe des Wissens und die Fähigkeit, dieses Wissen in einem begründeten Kontext anzuwenden.

- Codierung und Problemlösung (HumanEval, MBPP, CRUX-I, CRUX-O): Qwen2.5-Max ist auch in allen Benchmarks führend und schneidet bei kodierungsbezogenen Aufgaben gut ab. Mit 73,2 Punkten bei HumanEval und 80,6 Punkten bei MBPP liegt er leicht vor DeepSeek V3 und deutlich vor Llama 3.1-405B. Diese Benchmarks messen die Programmierfähigkeiten, die Problemlösungskompetenz und die Fähigkeit, Anweisungen zu befolgen oder selbstständig Lösungen zu finden.

- Mathematisches Problemlösen (GSM8K, MATH): Mathematisches Denken ist einer der stärksten Bereiche von Qwen2.5-Max. Mit einem Wert von 94,5 auf GSM8K liegt es deutlich vor DeepSeek V3 (89,3) und Llama 3.1-405B (89,0). Im Fach MATH, das sich auf komplexere Problemlösungen konzentriert, erreicht Qwen2.5-Max jedoch 68,5 Punkte und übertrifft damit seine Konkurrenten leicht, lässt aber noch Raum für Verbesserungen.

Wie man auf Qwen2.5-Max zugreift

Der Zugang zu Qwen2.5-Max ist ganz einfach und du kannst es kostenlos und ohne komplizierte Einrichtung ausprobieren.

Qwen Chat

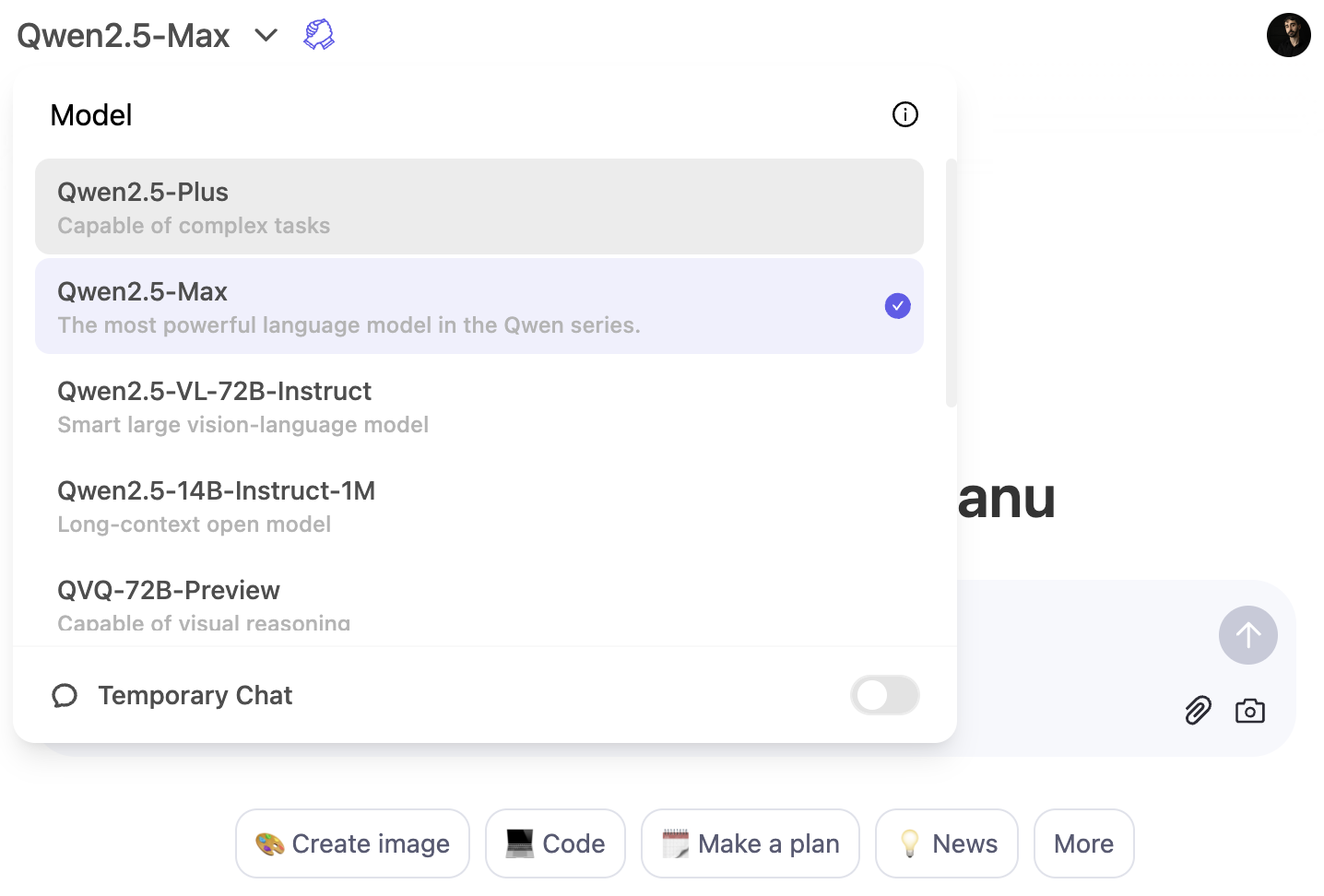

Der schnellste Weg, Qwen2.5-Max zu erleben, ist über den Qwen Chat Plattform. Dabei handelt es sich um eine webbasierte Schnittstelle, mit der du direkt in deinem Browser mit dem Modell interagieren kannst - so wie du ChatGPT in deinem Browser nutzen würdest.

Um das Modell Qwen2.5-Max zu verwenden, klicke auf das Modell-Dropdown-Menü und wähle Qwen2.5-Max:

API-Zugang über Alibaba Cloud

Für Entwickler ist Qwen2.5-Max über die Alibaba Cloud Model Studio API verfügbar. Um es zu nutzen, musst du dich für ein Alibaba Cloud-Konto anmelden, den Model Studio-Dienst aktivieren und einen API-Schlüssel generieren.

Da die API dem Format von OpenAI folgt, sollte die Integration einfach sein, wenn du bereits mit den OpenAI-Modellen vertraut bist. Detaillierte Anweisungen zur Einrichtung findest du im offiziellen Qwen2.5-Max Blog.

Fazit

Qwen2.5-Max ist das bisher leistungsstärkste KI-Modell von Alibaba, das mit Spitzenmodellen wie GPT-4o, Claude 3.5 Sonnet und DeepSeek V3 konkurrieren soll.

Im Gegensatz zu einigen früheren Qwen-Modellen ist Qwen2.5-Max nicht quelloffen, kann aber über den Qwen-Chat oder über den API-Zugang auf der Alibaba Cloud getestet werden.

Angesichts der kontinuierlichen Investitionen von Alibaba in KI wäre es nicht verwunderlich, wenn wir in Zukunft ein Modell sehen, das sich auf das Denken konzentriert - möglicherweise mit Qwen 3.

Wenn du mehr über KI lesen willst, empfehle ich dir diese Artikel:

FAQs

Kannst du Qwen2.5-Max lokal einrichten?

Nein, Qwen2.5-Max ist nicht als Open-Weight-Modell verfügbar, du kannst es also nicht auf deiner eigenen Hardware betreiben. Alibaba bietet jedoch Zugang über Qwen Chat und die Alibaba Cloud API.

Kannst du Qwen2.5-Max feinabstimmen?

Nein, da das Modell nicht quelloffen ist, hat Alibaba keine Möglichkeit für die Nutzer/innen vorgesehen, Qwen2.5-Max zu optimieren. Vielleicht bieten sie aber in Zukunft fein abgestimmte Variationen an oder erlauben eine begrenzte Anpassung über API-Einstellungen.

Wird Qwen2.5-Max in Zukunft als Open Source verfügbar sein?

Alibaba hat noch keine Pläne geäußert, Qwen2.5-Max als offenes Modell zu veröffentlichen, aber angesichts der Tatsache, dass Alibaba in der Vergangenheit bereits kleinere offene Modelle veröffentlicht hat, könnten zukünftige Iterationen Open-Source-Versionen enthalten.

Kann Qwen2.5-Max Bilder wie DALL-E 3 oder Janus-Pro erzeugen?

Nein, Qwen2.5-Max ist ein textbasiertes KI-Modell, das sich auf Aufgaben wie Allgemeinwissen, Codierung und mathematisches Problemlösen konzentriert. Es unterstützt keine Bilderzeugung.