Cursus

Alibaba vient de lancer Qwen2.5-Max, son modèle d'IA le plus avancé à ce jour. Il ne s'agit pas d'un modèle de raisonnement comme DeepSeek R1 ou o1 d'OpenAI, ce qui signifie que vous ne pouvez pas voir son processus de réflexion.

Il vaut mieux considérer Qwen2.5-Max comme un modèle généraliste et un concurrent de GPT-4o, Claude 3.5 Sonnet, ou de DeepSeek V3.

Dans ce blog, j'expliquerai ce qu'est Qwen2.5-Max, comment il a été développé, comment il se situe par rapport à la concurrence et comment vous pouvez y accéder.

Qu'est-ce que le Qwen2.5-Max ?

Qwen2.5-Max est le modèle d'IA le plus puissant d'Alibaba à ce jour, conçu pour rivaliser avec des modèles de premier plan tels que GPT-4o, Claude 3.5 Sonnet et DeepSeek V3.

Alibaba, l'une des plus grandes entreprises technologiques chinoises, est surtout connue pour ses plates-formes de commerce électronique, mais elle s'est également forgée une solide présence dans les domaines suivants l'informatique en nuage et de l l'intelligence artificielle. La série Qwen fait partie de son écosystème d'IA plus large, qui va des petits modèles à poids libre aux systèmes propriétaires à grande échelle.

Contrairement à certains modèles Qwen précédents, Qwen2.5-Max n'est pas open-source, ce qui signifie que ses poids ne sont pas accessibles au public.

Entraîné sur 20 billions de jetons, Qwen2.5-Max dispose d'une vaste base de connaissances et de solides capacités d'IA générale. Cependant, il ne s'agit pas d'un modèle de raisonnement comme DeepSeek R1 ou OpenAI's o1, ce qui signifie qu'il ne montre pas explicitement son processus de réflexion. Toutefois, compte tenu de l'expansion continue de l'IA d'Alibaba, nous pourrions voir un modèle de raisonnement dédié à l'avenir, peut-être avec Qwen 3.

Comment fonctionne Qwen2.5-Max ?

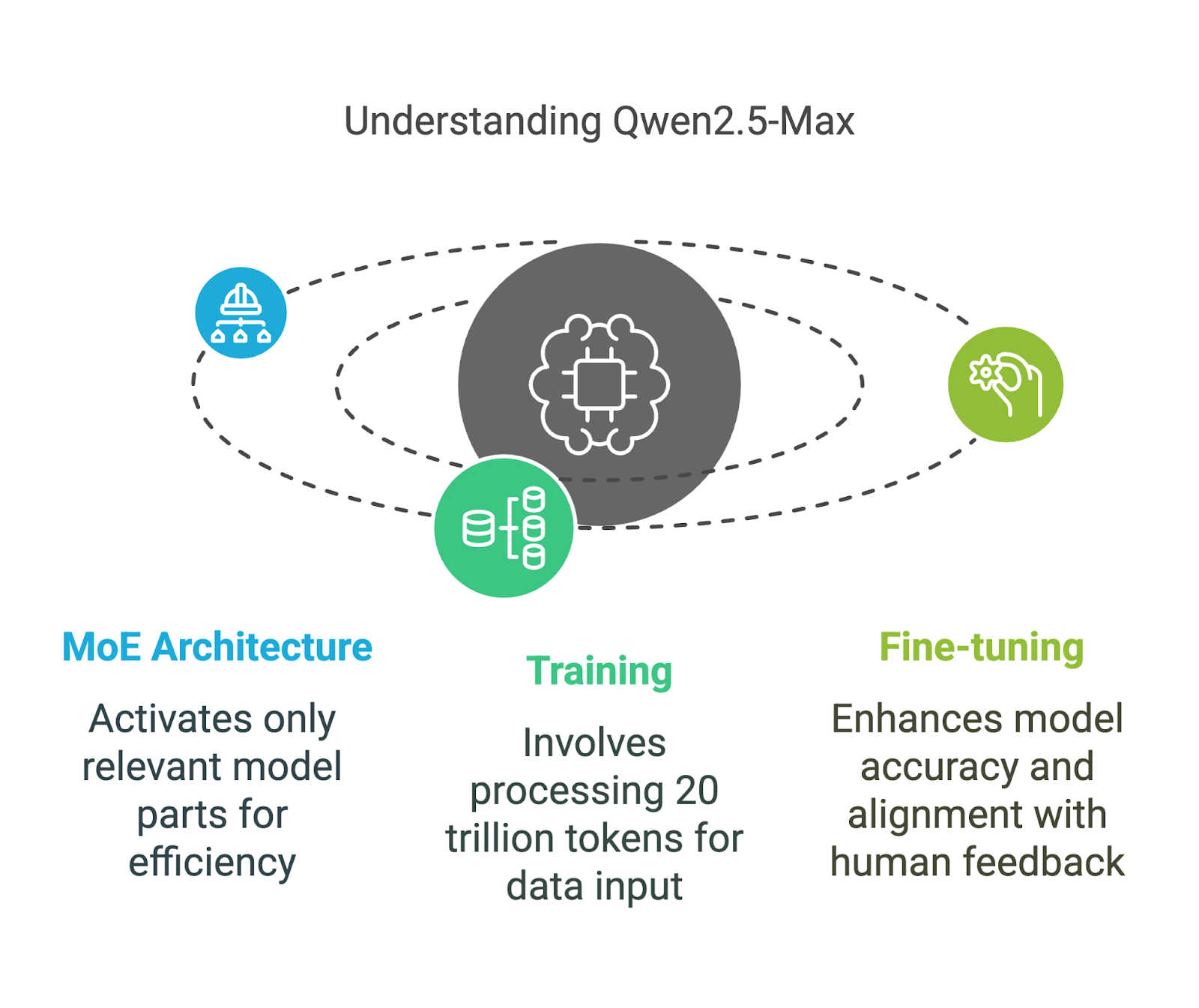

Qwen2.5-Max utilise un mélange d'experts (MoE) une technique également employée par DeepSeek V3. Cette approche permet de faire évoluer le modèle tout en maintenant les coûts de calcul à un niveau raisonnable. Décortiquons ses principaux éléments de manière à ce qu'ils soient faciles à comprendre.

Architecture de mélange d'experts (MoE)

Contrairement aux modèles d'IA traditionnels qui utilisent tous leurs paramètres pour chaque tâche, les modèles MoE tels que Qwen2.5-Max et DeepSeek V3 n'activent que les parties les plus pertinentes du modèle à un moment donné.

Vous pouvez l'envisager comme une équipe de spécialistes : si vous posez une question complexe sur la physique, seuls les experts en physique répondent, tandis que le reste de l'équipe reste inactif. Cette activation sélective permet au modèle de gérer plus efficacement les traitements à grande échelle sans nécessiter une puissance de calcul extrême.

Cette méthode rend Qwen2.5-Max à la fois puissant et évolutif, ce qui lui permet de concurrencer les modèles denses comme GPT-4o et Claude 3.5 Sonnet tout en étant plus économe en ressources - un modèle dense est un modèle dans lequel tous les paramètres sont activés pour chaque entrée.

Formation et perfectionnement

Qwen2.5-Max a été formé sur 20 billions de tokens, couvrant un large éventail de sujets, de langues et de contextes.

Pour mettre en perspective 20 000 milliards de jetons, cela représente environ 15 000 milliards de mots, une quantité si importante qu'elle est difficile à appréhender. À titre de comparaison, l'ouvrage de George Orwell 1984 contient environ 89 000 mots, ce qui signifie que Qwen2.5-Max a été formé sur l'équivalent de 168 millions d'exemplaires de 1984.

Cependant, les données d'entraînement brutes ne garantissent pas à elles seules un modèle d'IA de haute qualité, c'est pourquoi Alibaba l'a encore affiné avec :

- Réglage fin supervisé (SFT): Les annotateurs humains ont fourni des réponses de grande qualité pour aider le modèle à produire des résultats plus précis et plus utiles.

- Apprentissage par renforcement à partir du feedback humain (RLHF): Le modèle a été entraîné à aligner ses réponses sur les préférences humaines, ce qui garantit des réponses plus naturelles et adaptées au contexte.

Benchmarks Qwen2.5-Max

Qwen2.5-Max a été testé par rapport à d'autres modèles d'IA de premier plan afin de mesurer ses capacités dans diverses tâches. Ces critères évaluent à la fois les modèles d'instruction (qui sont affinés pour des tâches telles que le chat et le codage) et les modèles de base (qui servent de base brute avant l'affinement). Comprendre cette distinction permet de clarifier la signification réelle des chiffres.

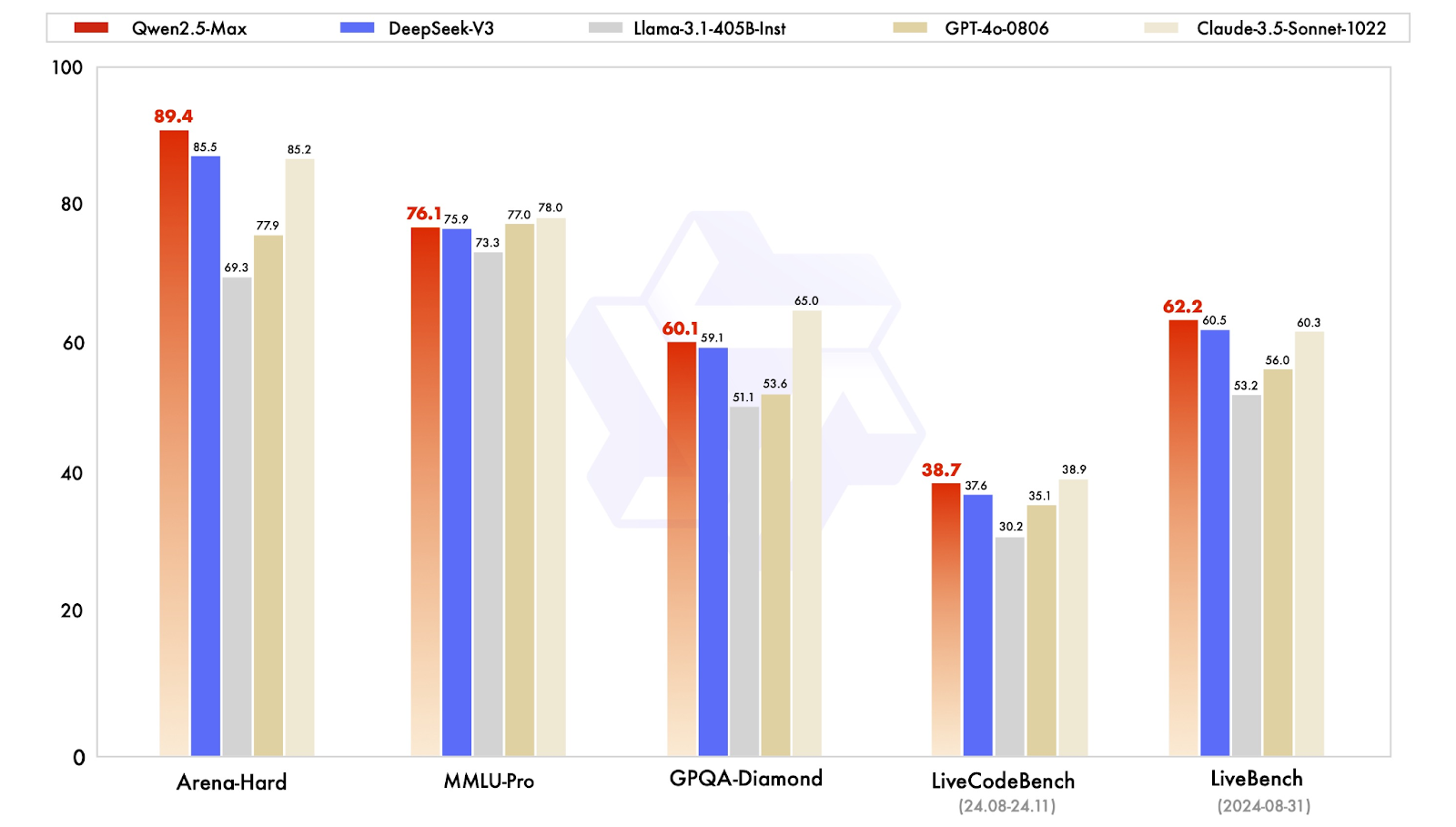

Instruire des modèles de référence

Les modèles d'instruction sont affinés pour des applications réelles, notamment la conversation, le codage et les tâches de connaissances générales. Qwen2.5-Max est comparé ici à des modèles tels que GPT-4o, Claude 3.5 Sonnet, Llama 3.1 405Bet DeepSeek V3.

Comparaison des modèles d'instruction. Source : QwenLM

Analysons rapidement les résultats :

- Arena-Hard (benchmark des préférences): Qwen2.5-Max obtient un score de 89,4, devançant DeepSeek V3 (85,5) et Claude 3.5 Sonnet (85,2). Ce critère se rapproche de la préférence humaine dans les réponses générées par l'IA.

- MMLU-Pro (connaissance et raisonnement): Qwen2.5-Max obtient un score de 76,1, légèrement supérieur à DeepSeek V3 (75,9), mais aussi légèrement inférieur au leader Claude 3.5 Sonnet (78,0) et au second GPT-4o (77,0).

- GPQA-Diamond (QA de connaissances générales): Avec un score de 60,1, Qwen2.5-Max devance DeepSeek V3 (59,1), tandis que Claude 3.5 Sonnet est en tête avec 65,0.

- LiveCodeBench (capacité de codage): Avec 38,7, Qwen2.5-Max est à peu près au même niveau que DeepSeek V3 (37,6) mais derrière Claude 3.5 Sonnet (38,9).

- LiveBench (capacités globales): Qwen2.5-Max arrive en tête avec un score de 62,2, dépassant DeepSeek V3 (60,5) et Claude 3.5 Sonnet (60,3), ce qui indique une grande compétence dans les tâches d'IA du monde réel.

Dans l'ensemble, Qwen2.5-Max s'avère être un modèle d'IA bien équilibré, excellant dans les tâches basées sur les préférences et les capacités générales d'IA, tout en conservant des connaissances compétitives et des capacités de codage.

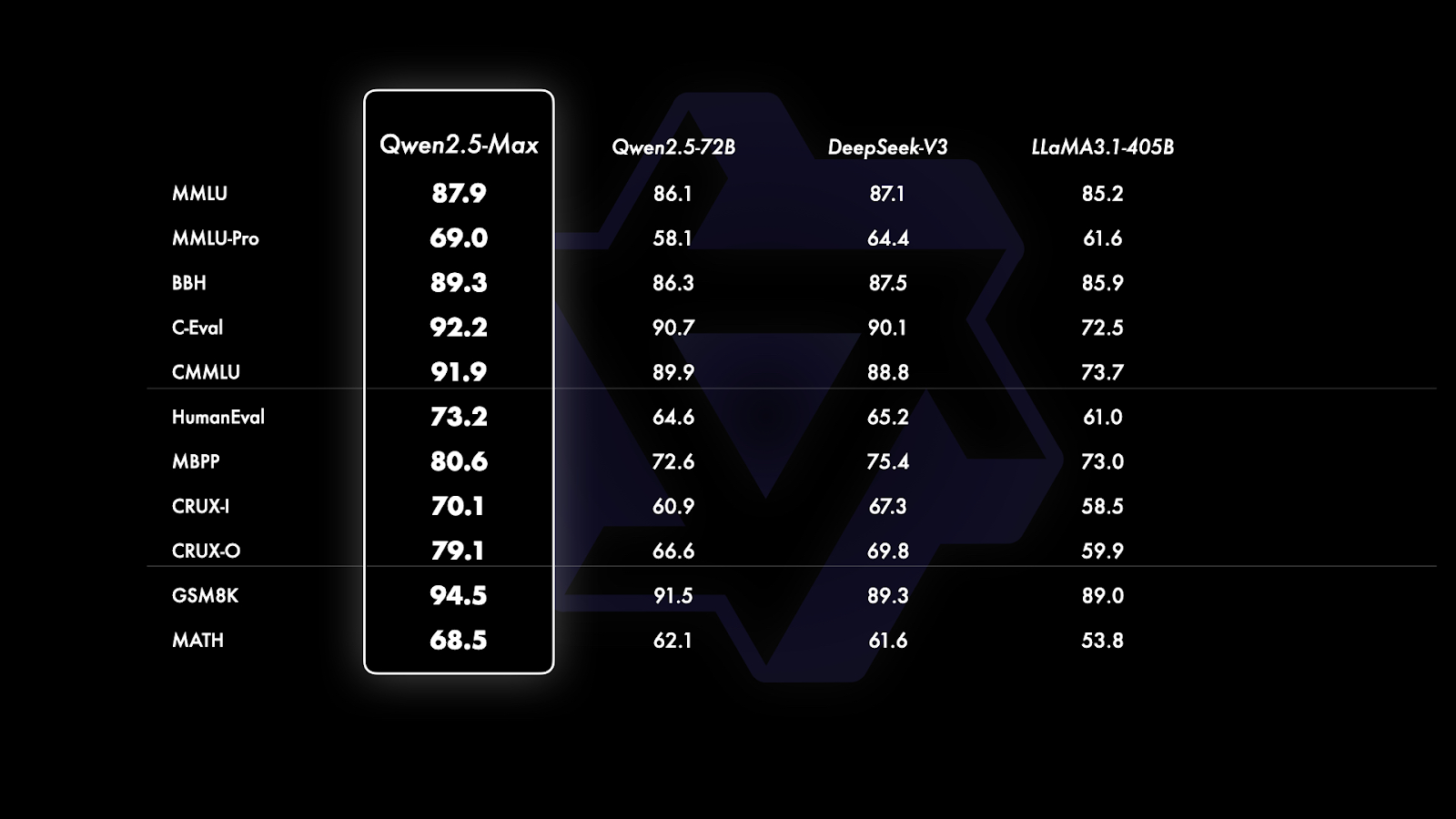

Modèles de base - Points de repère

Depuis le GPT-4o et Claude 3.5 Sonnet sont des modèles propriétaires dont les versions de base ne sont pas accessibles au public, la comparaison se limite aux modèles à poids ouvert tels que Qwen2.5-Max, DeepSeek V3, LLaMA 3.1-405B et Qwen 2.5-72B. Cela permet de se faire une idée plus précise de la position de Qwen2.5-Max par rapport aux principaux modèles ouverts à grande échelle.

Comparaison des modèles de base. Source : QwenLM

Si vous regardez attentivement le graphique ci-dessus, vous constaterez qu'il est divisé en trois sections en fonction du type de critères de référence évalués :

- Connaissance générale et compréhension de la langue (MMLU, MMLU-Pro, BBH, C-Eval, CMMU): Qwen2.5-Max est en tête de tous les benchmarks dans cette catégorie, avec un score de 87,9 sur MMLU et de 92,2 sur C-Eval, surpassant DeepSeek V3 et Llama 3.1-405B. Ces critères se concentrent sur l'étendue et la profondeur des connaissances et sur la capacité à appliquer ces connaissances dans un contexte de raisonnement.

- Codage et résolution de problèmes (HumanEval, MBPP, CRUX-I, CRUX-O): Qwen2.5-Max est également en tête de tous les benchmarks et obtient de bons résultats dans les tâches liées au codage, avec un score de 73,2 sur HumanEval et de 80,6 sur MBPP, soit une légère avance sur DeepSeek V3 et une avance significative sur Llama 3.1-405B. Ces critères mesurent les compétences en matière de codage, la résolution de problèmes et la capacité à suivre des instructions ou à trouver des solutions de manière autonome.

- Résolution de problèmes mathématiques (GSM8K, MATH): Le raisonnement mathématique est l'un des domaines les plus forts de Qwen2.5-Max, qui a obtenu 94,5 sur GSM8K, loin devant DeepSeek V3 (89,3) et Llama 3.1-405B (89,0). Cependant, en MATH, qui se concentre sur la résolution de problèmes plus complexes, Qwen2.5-Max obtient un score de 68,5, ce qui est légèrement supérieur à ses concurrents, mais laisse une marge d'amélioration.

Comment accéder à Qwen2.5-Max

L'accès à Qwen2.5-Max est simple et vous pouvez l'essayer gratuitement sans aucune installation compliquée.

Chat Qwen

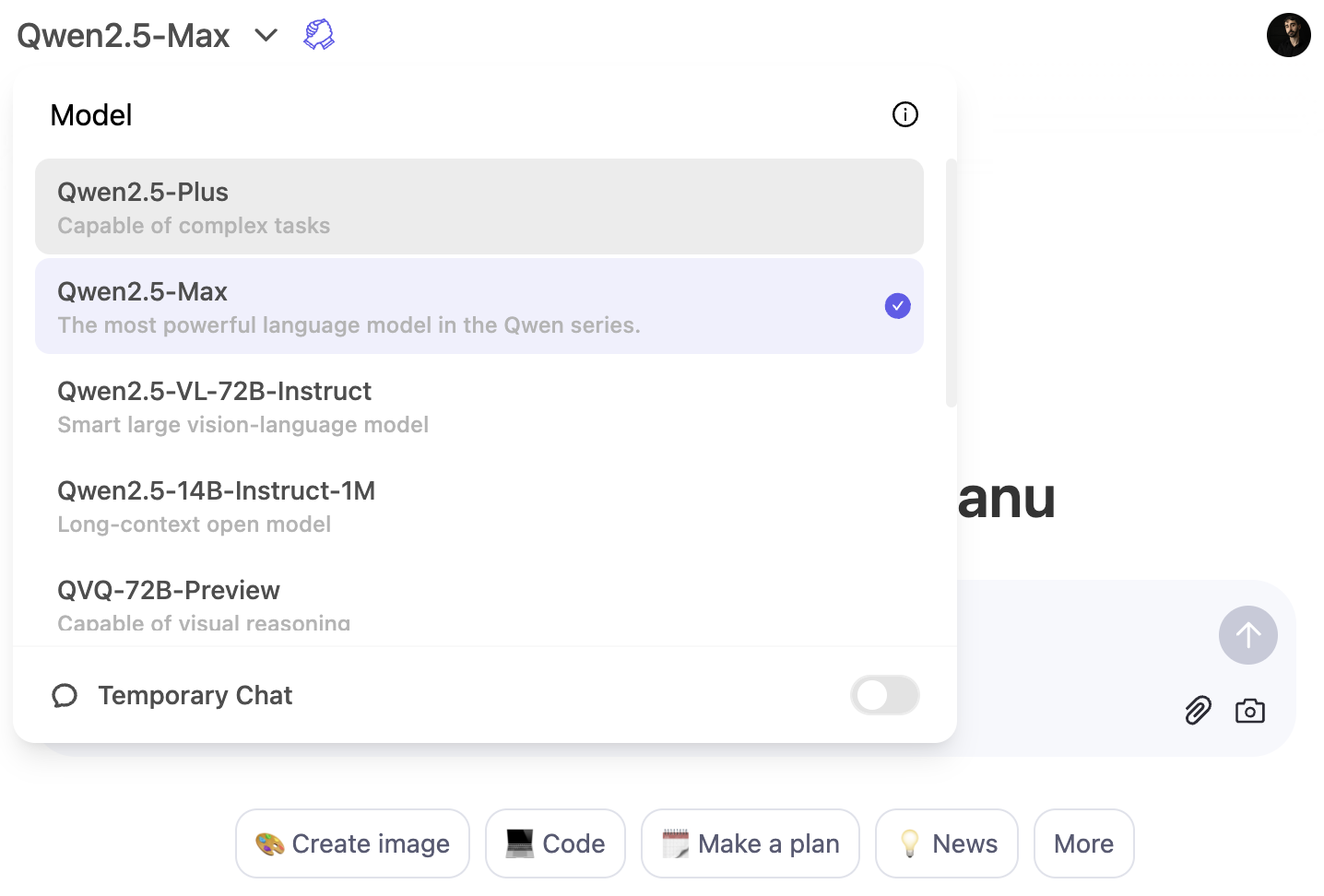

La façon la plus rapide d'expérimenter Qwen2.5-Max est de passer par le Qwen Chat de Qwen. Il s'agit d'une interface web qui vous permet d'interagir avec le modèle directement dans votre navigateur - tout comme vous utiliseriez ChatGPT dans votre navigateur.

Pour utiliser le modèle Qwen2.5-Max, cliquez sur le menu déroulant du modèle et sélectionnez Qwen2.5-Max :

Accès à l'API via Alibaba Cloud

Pour les développeurs, Qwen2.5-Max est disponible via l'API Alibaba Cloud Model Studio. Pour l'utiliser, vous devrez vous inscrire à un compte Alibaba Cloud, activer le service Model Studio et générer une clé API.

Comme l'API suit le format d'OpenAI, l'intégration devrait être simple si vous êtes déjà familiarisé avec les modèles d'OpenAI. Pour des instructions d'installation détaillées, visitez le blog officiel de Qwen2.5-Max.

Conclusion

Qwen2.5-Max est le modèle d'IA le plus performant d'Alibaba à ce jour, conçu pour rivaliser avec des modèles de premier plan tels que GPT-4o, Claude 3.5 Sonnet et DeepSeek V3.

Contrairement à certains modèles précédents de Qwen, Qwen2.5-Max n'est pas open-source, mais il est possible de le tester via Qwen Chat ou via un accès API sur Alibaba Cloud.

Compte tenu de l'investissement continu d'Alibaba dans l'IA, il ne serait pas surprenant de voir un modèle axé sur le raisonnement à l'avenir, peut-être avec Qwen 3.

Si vous souhaitez lire d'autres nouvelles sur l'IA, je vous recommande ces articles :

FAQ

Pouvez-vous installer Qwen2.5-Max localement ?

Non, Qwen2.5-Max n'est pas disponible en tant que modèle de poids ouvert, vous ne pouvez donc pas l'exécuter sur votre propre matériel. Toutefois, Alibaba fournit un accès par le biais de Qwen Chat et de l'API du cloud d'Alibaba.

Pouvez-vous affiner Qwen2.5-Max ?

Non, comme le modèle n'est pas open-source, Alibaba n'a pas fourni aux utilisateurs un moyen d'affiner Qwen2.5-Max. Toutefois, il est possible qu'ils proposent à l'avenir des variantes affinées ou qu'ils autorisent une personnalisation limitée par le biais des paramètres de l'API.

Qwen2.5-Max sera-t-il ouvert à l'avenir ?

Alibaba n'a pas indiqué son intention de commercialiser le Qwen2.5-Max en tant que modèle à poids ouvert, mais compte tenu de ses antécédents en matière de commercialisation de modèles ouverts plus petits, les futures itérations pourraient inclure des versions à code source ouvert.

Qwen2.5-Max peut-il générer des images comme DALL-E 3 ou Janus-Pro ?

Non, Qwen2.5-Max est un modèle d'IA basé sur le texte et axé sur des tâches telles que les connaissances générales, le codage et la résolution de problèmes mathématiques. Il ne permet pas de générer des images.