programa

Como usuario habitual de modelos avanzados como el ChatGPT de OpenAI y el Claude de Anthropic, he observado de primera mano cómo su rendimiento disminuye a medida que aumenta la longitud de las entradas, lo que provoca problemas para mantener la coherencia y la relevancia en textos extensos.

Para hacer frente a estas limitaciones, investigadores de Microsoft y de la Universidad de Illinois introducen SAMBA-una novedosa arquitectura híbrida que combina los modelos de espacio de estados (SSM) con la atención de ventana deslizante (SWA).

Su enfoque aprovecha los puntos fuertes tanto de los SSM, que son excelentes para gestionar las dependencias a largo plazo, como de los SWA, que manejan las ventanas de contexto y mantienen la tractabilidad computacional. Al fusionar estas técnicas, SAMBA consigue un modelado lingüístico eficaz con unalongitud de contexto prácticamente ilimitada.

En este artículo, exploraremos la arquitectura de SAMBA y su capacidad única para manejar grandes extensiones de texto sin perder el contexto. También destacamos su potencial para mejorar significativamente las capacidades de los modelos lingüísticos en el procesamiento y la generación de secuencias ampliadas, estableciendo un nuevo estándar en el modelado lingüístico.

Comprender el cuello de botella del contexto

Para entender por qué SAMBA es tan innovador, primero tenemos que comprender los retos a los que se enfrentan los modelos lingüísticos tradicionales cuando tratan secuencias de texto largas.

Contexto limitado en transformadores

Tradicional Modelos basados en transformadoresaunque son inmensamente potentes, se enfrentan a importantes retos cuando tratan secuencias de texto largas, debido a su complejidad cuadrática en relación con la longitud del contexto. Esta complejidad cuadrática surge del mecanismo de autoatenciónque requiere que cada ficha atienda a todas las demás fichas de la secuencia.

Como resultado, los costes computacionales y de memoria crecen rápidamente al aumentar la longitud de la secuencia, lo que hace que estos modelos sean poco prácticos para tareas que requieran el procesamiento de textos muy largos.

Esta limitación nos obliga a menudo a truncar las entradas o a utilizar otras estrategias subóptimas para ajustarnos a las restricciones del hardware disponible. En última instancia, este compromiso reduce la capacidad del modelo para mantener el rendimiento en secuencias largas, un reto que me encontré al desarrollar una aplicación que necesita procesar documentos largos.

Los SSM y sus limitaciones

Los Modelos de Espacio de Estados (MES) ofrecen una alternativa con complejidad lineal, lo que los hace más eficientes computacionalmente para manejar secuencias largas. Los SSM mantienen un estado evolutivo, lo que les permite manejar dependencias ampliadas sin el coste prohibitivo de los transformadores.

Sin embargo, los SSM tienen sus limitaciones. Debido a su naturaleza markoviana, en la que el estado actual sólo depende del estado anterior, suelen tener dificultades para recordar secuencias largas. Esta memoria limitada reduce su eficacia en el modelado contextual exhaustivo, sobre todo en aplicaciones que requieren la retención y referencia de información de fases muy anteriores de la secuencia.

La necesidad de enfoques híbridos

Dados los puntos fuertes y débiles tanto de los Transformadores como de los SSM, existe una necesidad imperiosa de enfoques híbridos que puedan aprovechar las ventajas de cada uno y, al mismo tiempo, mitigar sus limitaciones. Combinar los SSM con mecanismos de atención presenta una solución prometedora.

Este enfoque híbrido utiliza las propiedades de eficacia y dependencia de largo alcance de los SSM junto con el mecanismo de atención dinámica y focalizada de los Transformadores. Integrando estos dos métodos, podemos crear un modelo que procese suavemente las secuencias largas con un recuerdo y una comprensión contextual mejorados.

SAMBA: Modelos híbridos simples de espacio de estados

SAMBA ofrece una solución elegante a este cuello de botella contextual, combinando los puntos fuertes de dos enfoques distintos.

Idea central

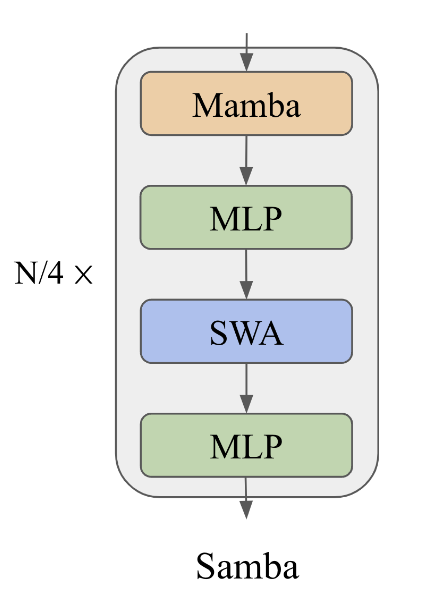

La idea central de SAMBA es intercalar Mambaun SSM, con SwiGLU y capas de atención de ventana deslizante (SWA). Esta estructura híbrida capta tanto las estructuras recurrentes como la recuperación precisa de la memoria.

SAMBA ejemplifica este enfoque combinando los puntos fuertes de los SSM y los mecanismos de atención para gestionar contextos largos conservando información detallada.

Un diagrama que ilustra la arquitectura SAMBA. Fuente: Ren et. al (2024)

Capas de mamba

Las capas Mamba de SAMBA son expertas en captar la semántica dependiente del tiempo, proporcionando un marco robusto para manejar datos secuenciales. Estas capas funcionan manteniendo y actualizando un estado que refleja las dependencias temporales de los datos.

Mamba lo consigue utilizando espacios de estado selectivos que permiten al modelo centrarse en las entradas relevantes y mantener la información importante durante secuencias largas. Este mecanismo de compuerta selectiva es crucial para una descodificación rápida y garantiza que el modelo pueda interpretar y predecir patrones secuenciales con gran precisión y una sobrecarga computacional mínima.

Capas SWA

Las capas de atención de ventana deslizante complementan a las capas Mamba abordando las dependencias complejas no markovianas dentro de una ventana de contexto limitada. SWA funciona con un tamaño de ventana que se desliza sobre la secuencia de entrada, garantizando una complejidad computacional lineal.

Esto permite al modelo recuperar señales de alta definición de la historia a medio y corto plazo que no pueden ser captadas por los estados recurrentes de Mamba. Al ajustar dinámicamente su enfoque, las capas SWA permiten al modelo mantener la coherencia y el contexto, sobre todo en tareas que requieren respuestas contextualmente relevantes a lo largo de entradas largas.

Capas SwiGLU

Las capas SwiGLU de SAMBA facilitan la transformación no lineal y mejoran la recuperación de conocimientos. Estas capas introducen la no linealidad en el modelo, permitiéndole captar pautas e interacciones más complejas dentro de los datos.

Además, las capas SwiGLU garantizan que el modelo pueda procesar y recuperar información, lo que contribuye a su robustez y versatilidad. Esta transformación no lineal es esencial para que el modelo pueda generalizar de los datos de entrenamiento a las aplicaciones del mundo real.

SAMBA: Rendimiento y escalabilidad

Una vez explorada la arquitectura de SAMBA, examinemos ahora su rendimiento y eficacia en comparación con otros modelos.

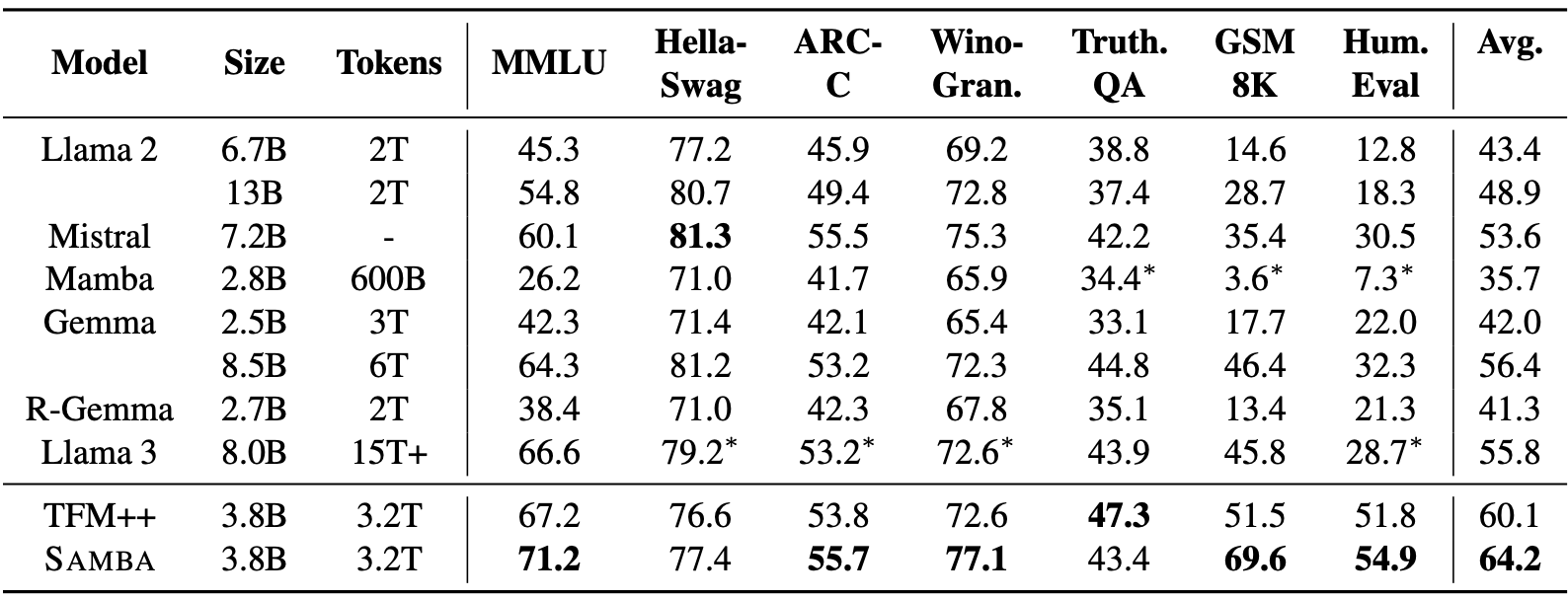

Buen rendimiento en los puntos de referencia

SAMBA demuestra un buen rendimiento en una serie de pruebas de comprensión y razonamiento lingüísticos, superando tanto a los modelos basados en la atención pura como a los basados en SSM. En concreto, SAMBA ha sido evaluado en tareas como MMLU, GSM8K y HumanEval, obteniendo una puntuación de 71,2 en MMLU, 69,6 en GSM8K y 54,9 en HumanEval.

Fuente: Ren et. al (2024)

Estos resultados superan significativamente los de otros modelos del estado de la técnica, como TFM++ y Llama-3, lo que demuestra la capacidad de SAMBA para manejar diversas tareas de comprensión lingüística. Por ejemplo, SAMBA consiguió un 18,1% más de precisión en GSM8K en comparación con TFM++, lo que pone de relieve la competencia de su arquitectura híbrida que combina SSM con mecanismos de atención.

Extrapolación eficiente de la longitud

Una de las características más notables de SAMBA es su capacidad para manejar longitudes de contexto significativamente mayores, manteniendo la eficiencia. A pesar de estar preentrenado en secuencias de 4K de longitud, SAMBA puede extrapolar hasta 1M de tokens con una perplejidad mejorada y seguir manteniendo una complejidad de tiempo de descodificación lineal.

Esto se consigue mediante la combinación por capas de los espacios de estado selectivos de Mamba con SWA, lo que permite al modelo mantener un alto rendimiento sin una complejidad de cálculo cuadrática.

En la práctica, SAMBA consigue un rendimiento de descodificación 3,64 veces más rápido que la arquitectura Llama-3, en particular para secuencias de hasta 128K tokens de longitud, lo que demuestra su escalabilidad y capacidad para procesar contextos largos..

Mejora el recuerdo

La arquitectura híbrida de SAMBA amplía significativamente su capacidad de recuperación de memoria en comparación con los SSM puros. En pruebas como la Recuperación de Claves de Acceso, SAMBA mostró una recuperación de memoria casi perfecta hasta una longitud de contexto de 256K tras un ajuste fino con sólo 500 pasos, mientras que los modelos basados en SWA tuvieron problemas más allá de longitudes de 4K.

Este rendimiento excepcional se atribuye a la fuerza combinada de las estructuras recurrentes de Mamba para la semántica dependiente del tiempo y la capacidad de recuperación de memoria de SWA. En consecuencia, SAMBA destaca en tareas de recuerdo a corto y largo plazo, lo que lo convierte en una solución sólida para aplicaciones que requieren una amplia comprensión del contexto.

Análisis técnico y perspectivas

Echemos un vistazo más de cerca a las opciones y estrategias de diseño específicas que contribuyen al impresionante rendimiento de SAMBA.

Estrategias de hibridación

SAMBA emplea una sofisticada estrategia de hibridación que combina capas Mamba, SWA y Perceptrón Multicapa (MLP). Este enfoque optimiza el rendimiento del modelado lingüístico de contexto largo aprovechando las propiedades únicas de cada componente:

- Capas de mamba: Diseñado para capturar estructuras secuenciales recurrentes, Mamba utiliza la activación dependiente de la entrada para comprimir selectivamente la información secuencial en estados ocultos recurrentes. Esto permite a SAMBA manejar sin problemas las dependencias de largo alcance, al tiempo que proporciona una columna vertebral para el procesamiento secuencial de datos.

- Capas SWA: Estas capas aplican la atención dentro de una ventana deslizante para responder a la necesidad del modelo de recuperar la memoria con precisión. El SWA gestiona las dependencias complejas no markovianas dentro de una ventana de contexto limitada, mejorando la capacidad del modelo para recordar dinámicamente información específica.

- Capas MLP: Las capas MLP introducen transformaciones no lineales, que facilitan el recuerdo de los conocimientos factuales. Al incorporar estas capas, SAMBA potencia su capacidad de generalizar a partir de los datos de entrenamiento y captar patrones intrincados dentro de los datos.

Exploración de alternativas

El documento SAMBA explora varios modelos recurrentes lineales y mecanismos de atención para identificar la combinación más óptima. Alternativas como la Retención Multiescala y la GLA se consideraron posibles sustitutos de la Mamba. Puedes encontrar más información sobre la arquitectura Mamba en esta introducción a la guía de arquitectura Mamba LLM.

Estas exploraciones pretendían equilibrar la eficiencia computacional y el rendimiento en las tareas de modelado lingüístico. La comparación reveló que, aunque estas alternativas ofrecían algunas ventajas, la combinación de Mamba con capas SWA y MLP conseguía el mejor rendimiento global y escalabilidad.

Análisis de la entropía de la atención

El análisis de la entropía de las distribuciones de la atención permitió obtener valiosos conocimientos sobre el rendimiento de SAMBA y de modelos comparables como Mistral. El análisis de la entropía de la atención reveló que SAMBA mantiene un recuerdo más estable y fiable en contextos prolongados.

Por ejemplo, en la tarea de recuperación de claves de acceso, SAMBA demostró una recuperación casi perfecta hasta longitudes de contexto de 256K, superando significativamente a Mistral. El análisis del mapa de calor indicó que la arquitectura híbrida de SAMBA le permite mantener una alta precisión de recuperación en varias posiciones de clave de paso, lo que subraya su excepcional capacidad de recuperación de largo alcance.

Aplicaciones SAMBA

Dada su capacidad para procesar eficazmente secuencias largas, SAMBA abre un amplio abanico de aplicaciones potenciales.

Tareas de contexto largo

La capacidad de SAMBA para manejar una longitud de contexto ilimitada abre importantes posibilidades para diversas tareas de contexto largo. Es capaz de mantener la coherencia y la relevancia a lo largo de extensas secuencias, lo que la hace especialmente adecuada para aplicaciones como:

- Resumir documentos largos: SAMBA resume eficazmente documentos extensos conservando el contexto y la información clave a lo largo de todo el texto, lo que garantiza resúmenes completos y coherentes.

- Respuesta a preguntas sobre bases de conocimiento extensas: Con su memoria mejorada y su capacidad para manejar grandes ventanas de contexto, SAMBA puede dar respuestas precisas a preguntas basadas en extensas bases de conocimientos o en textos largos.

- Generación de código: La capacidad de SAMBA para procesar y recuperar un contexto amplio lo hace ideal para generar o comprender grandes bases de código, así como para mejorar tareas como la finalización de código, la documentación y la corrección de errores.

Eficacia y utilización de los recursos

La arquitectura de SAMBA se ha diseñado pensando en la eficiencia, abordando las limitaciones típicas de los modelos basados en la atención pura y los basados en SSM. Algunas ventajas clave son:

- Complejidad en tiempo lineal: SAMBA mantiene una complejidad temporal lineal para la descodificación, lo que reduce significativamente la carga computacional en comparación con los modelos tradicionales de Transformador, que presentan una complejidad cuadrática. Esto hace que SAMBA sea más adecuado para su implantación en dispositivos con recursos limitados.

- Requisitos de memoria reducidos: Combinando los espacios de estados selectivos con la atención de ventana deslizante, SAMBA consigue una utilización eficiente de la memoria. Esto garantiza que, incluso cuando se manejan secuencias largas, la huella de memoria sigue siendo manejable, lo que hace que SAMBA sea más accesible para diversas aplicaciones sin necesidad de grandes recursos de hardware.

- Alto rendimiento: SAMBA demuestra un rendimiento de descodificación 3,64× más rápido en comparación con los modelos más avanzados, como Llama-3, sobre todo para secuencias largas. Este alto rendimiento es crucial para aplicaciones en tiempo real y escenarios en los que la velocidad de procesamiento es crítica.

SAMBA: Orientaciones futuras

De cara al futuro, hay varias vías de trabajo interesantes que pueden desarrollar aún más las capacidades de SAMBA:

- Exploración de arquitecturas dinámicas adaptables a las tareas: Investigar arquitecturas dinámicas que puedan adaptarse a tareas y conjuntos de datos específicos podría optimizar aún más el rendimiento y la eficacia de SAMBA. Esto incluye explorar diversas configuraciones y estrategias de hibridación adaptadas a aplicaciones específicas.

- Optimización de las implementaciones de hardware: Una mayor optimización de las implementaciones de hardware de SAMBA puede facilitar su despliegue en dispositivos con recursos limitados. Esto incluye perfeccionar las técnicas de paralelización y gestión de memoria para maximizar la eficacia y la escalabilidad.

- Ampliación de los dominios de aplicación: La aplicación de SAMBA a una gama más amplia de tareas e industrias del mundo real puede validar su impacto práctico e identificar áreas adicionales de mejora. Esto incluye ámbitos como el análisis de documentos jurídicos, el resumen de historiales médicos y la gestión de bases de conocimiento a gran escala.

Conclusión

SAMBA representa un avance significativo en el modelado del lenguaje, ya que ofrece una novedosa arquitectura híbrida que combina SSM con SWA deslizante y capas MLP. Las innovaciones y ventajas clave de la arquitectura SAMBA incluyen la hibridación de los mecanismos SSM y de atención, la eficacia en el manejo de contextos largos y la mejora de la recuperación de la memoria.

Aunque con esto hemos concluido nuestra exploración de la arquitectura SAMBA, una buena forma de profundizar en la arquitectura SAMBA y sus innovaciones es experimentar con la aplicación disponible en GitHub.

Si quieres saber más sobre las últimas innovaciones en IA, te recomiendo estas entradas de blog: