Curso

Scala es un potente lenguaje que combina la programación funcional y la programación orientada a objetos. Se utiliza ampliamente en el procesamiento de big data y en aplicaciones web, debido a su sintaxis concisa, su escalabilidad y sus ventajas en cuanto a rendimiento.

Dado que los conocimientos sobre Scala son cada vez más solicitados en el sector de los datos, este artículo ofrece una guía completa con preguntas de entrevista sobre Scala, que abarca diversos temas, desde conceptos básicos hasta técnicas avanzadas y preguntas sobre ingeniería de datos.

Preguntas básicas para una entrevista sobre Scala

Comencemos por explorar algunas preguntas fundamentales de la entrevista sobre Scala que evalúan tu comprensión de los conceptos básicos y las ventajas de este potente lenguaje.

Si eres nuevo en el lenguaje, comienza con nuestrocurso Introducción a Scalapara adquirir una base sólida antes de abordar las preguntas de la entrevista.

¿Qué es Scala y en qué se diferencia de Java?

El nombre Scala proviene de la palabra «escalable» (). Scala es un lenguaje de programación de tipado estático que combina paradigmas de programación orientada a objetos y funcional. Es conciso, expresivo y está diseñado para solucionar muchas de las deficiencias de Java. Por ejemplo, Scala se ejecuta en la máquina virtual Java (JVM), lo que significa que puedes utilizar bibliotecas y marcos de trabajo Java sin problemas.

Mientras que Java es estrictamente orientado a objetos, Scala permite tanto la programación orientada a objetos como la funcional. Scala también ofrece características avanzadas como inmutabilidad, funciones de orden superior, coincidencia de patrones y mucho más, todo ello con una sintaxis concisa.

Si tienes experiencia en Java, echa un vistazo alcurso Introducción a Java para repasar los conceptos básicos. Para comparar los principios orientados a objetos en Java y Scala, prueba el curso Introducción a la POO en Java.

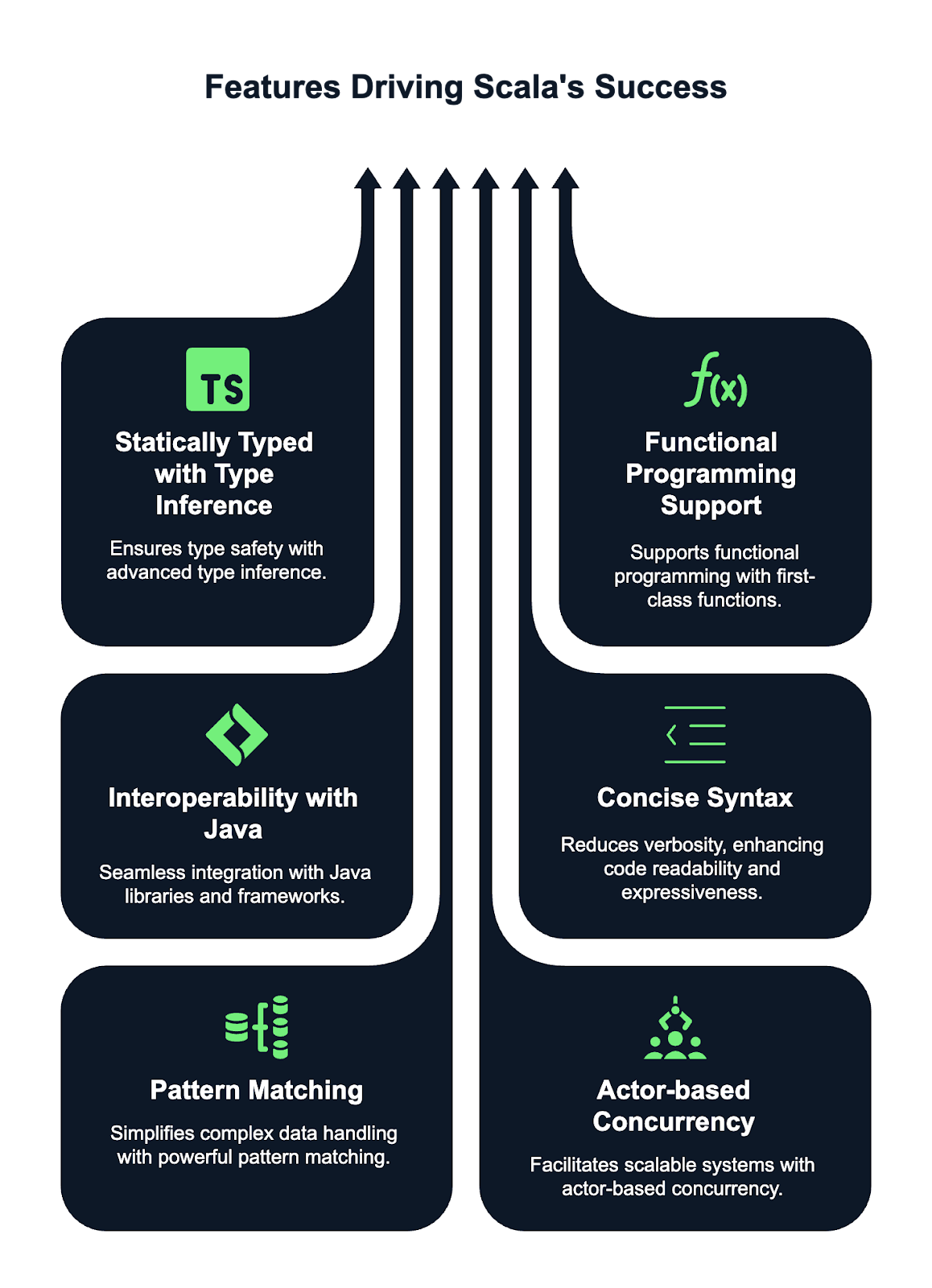

¿Cuáles son las características principales de Scala?

Scala tiene algunas características potentes que lo hacen destacar y ser popular entre los programadores. Estas son algunas de estas características:

- Tipado estático con inferencia de tipos. Scala es un lenguaje de tipado estático, lo que significa que los tipos se comprueban en tiempo de compilación, lo que garantiza la seguridad de los tipos. Gracias al avanzado sistema de inferencia de tipos de Scala, en la mayoría de los casos no es necesario declarar explícitamente los tipos de variables y funciones. El compilador puede deducir automáticamente los tipos.

- Compatibilidad con programación funcional. Scala ofrece un soporte de primera clase para la programación funcional. Te permite tratar las funciones como valores de primera clase, pasarlas como argumentos y devolverlas desde otras funciones. La inmutabilidad es un concepto fundamental, y las colecciones inmutables son las predeterminadas. Scala también admite funciones de orden superior, lo que permite un código más abstracto y reutilizable.

- Interoperabilidad con Java. Scala se ejecuta en la JVM, lo que permite una integración perfecta con el código Java. Esto significa que puedes aprovechar las bibliotecas y los marcos de Java directamente en el código Scala y viceversa. Scala puede llamar código Java, y Java puede interactuar con componentes Scala, lo que lo hace muy versátil y compatible con proyectos Java existentes.

- Sintaxis concisa. Scala se diseñó para reducir la verbosidad en comparación con Java, haciéndolo más expresivo y conciso. Permite a los programadores escribir código más limpio y legible con menos código repetitivo. Características como los paréntesis opcionales, la inferencia de tipos y las estructuras de control concisas hacen que Scala sea más fácil de escribir y mantener que Java, al tiempo que conserva toda su expresividad.

- Coincidencia de patrones. La coincidencia de patrones de Scala es una característica potente y flexible que simplifica el trabajo con estructuras de datos complejas. Te permite hacer coincidir tipos, valores y estructuras, lo que puede eliminar la necesidad de múltiples sentencias if-else o switch. Esto hace que el código sea más conciso, legible y fácil de mantener, especialmente cuando se trata de patrones de datos complejos.

- Modelo de concurrencia basado en actores. Scala proporciona herramientas integradas para gestionar la concurrencia a través del modelo basado en actores popularizado por el marco Akka. Este modelo te permite crear sistemas altamente concurrentes, distribuidos y tolerantes a fallos mediante la desacoplamiento de los cálculos en «actores» independientes que se comunican mediante el intercambio de mensajes. Este enfoque simplifica la gestión del estado y evita los inconvenientes de los modelos de concurrencia tradicionales basados en subprocesos, lo que hace que Scala sea ideal para crear aplicaciones escalables y resistentes.

¿Qué es una clase de caso en Scala y para qué se utiliza?

Una clase de caso en Scala es una clase especial optimizada para su uso con estructuras de datos inmutables. Proporciona automáticamente implementaciones para métodos como toString, equals y hashCode. Las clases de caso también se pueden comparar con patrones, lo que las hace increíblemente útiles para manejar datos de forma funcional.

Normalmente, las clases de caso se utilizan para representar objetos de datos que no deben cambiar una vez creados. Te dejo un ejemplo a continuación:

case class Person(name: String, age: Int)

val person1 = Person("John", 30)¿Cómo gestiona Scala la inmutabilidad?

En Scala, se fomenta la inmutabilidad, especialmente para la programación funcional. Puedes declarar una variable inmutable utilizando val en lugar de var, que es mutable. Una vez que asignas un valor a un val, no se puede cambiar. La inmutabilidad conduce a un código más seguro y predecible, ya que hay menos margen para efectos secundarios no deseados. Mira mi ejemplo a continuación:

val name = "Alice"

// Trying to change it will result in a compile-time error

name = "Bob" // Error: reassignment to val¿Qué son los objetos complementarios en Scala?

Un objeto complementario es un objeto que comparte el mismo nombre que una clase y se define en el mismo archivo. El objetivo principal de un objeto complementario es proporcionar métodos y funciones que están estrechamente relacionados con la clase, pero que no están vinculados a una instancia de la misma.

El objeto complementario puede contener métodos de fábrica u otras funciones de utilidad, como el ejemplo que he escrito a continuación:

class Person(val name: String, val age: Int)

object Person {

def apply(name: String, age: Int): Person = new Person(name, age)

}El método apply del objeto complementario Person me permite crear un Person sin utilizar la palabra clave new, tal y como se muestra a continuación:

val p = Person("John", 25)¿Cuál es la diferencia entre var, val y lazy val en Scala?

En Scala, las palabras clave ` var`, ` val` y ` lazy val ` se utilizan para definir variables, pero difieren en términos de mutabilidad, inicialización y momento de evaluación.

Un var es una variable mutable, lo que significa que su valor puede cambiarse después de inicializarlo. Puedes reasignar un nuevo valor a un var:

var x = 10

x = 20 // ReassignablePor otro lado, un « val » es una referencia inmutable, lo que significa que una vez que se le asigna un valor, no se puede reasignar, pero el objeto al que hace referencia sigue siendo mutable.

val y = 10

// y = 20 // Error: reassignment to valUn « lazy val » es un tipo especial de « val » que no se evalúa hasta que se accede a él por primera vez, lo que se denomina «evaluación perezosa». Esto puede resultar útil para optimizar el rendimiento cuando se trabaja con cálculos costosos o que consumen muchos recursos.

lazy val z = {

println("Computing z")

42

}Para obtener más información sobre las declaraciones de variables y las prácticas recomendadas en Scala, consulta este tutorialsobre variables en Scala.

¿Puedes explicar el concepto de funciones de orden superior en Scala?

En Scala, una función de orden superior es una función que toma una o más funciones como parámetros o devuelve una función como resultado. Este concepto permite tratar las funciones como valores de primera clase, lo que proporciona una mayor flexibilidad y abstracción en tu código.

Las funciones de orden superior permiten que los comportamientos se transmitan y personalicen, lo que hace que el código sea más modular, reutilizable y expresivo.

A continuación, dejo un ejemplo de una función de orden superior que acepta otra función como argumento:

// Define a higher-order function that takes a function as a parameter

def applyFunction(f: Int => Int, x: Int): Int = f(x)

// Call the higher-order function with a function that multiplies the input by 2

val result = applyFunction(x => x * 2, 5) // 10En este caso, applyFunction es una función de orden superior que toma una función f, que multiplica por 2, y la aplica a 5.

¿Cuál es la diferencia entre String y StringBuilder en Scala?

En Scala, String es inmutable, lo que significa que las modificaciones crean nuevos objetos, lo que puede resultar ineficiente en caso de cambios repetidos. Es adecuado para operaciones con cadenas poco frecuentes.

Por el contrario, StringBuilder es mutable, lo que permite realizar modificaciones in situ sin crear nuevos objetos. Esto hace que sea más eficiente para manipulaciones frecuentes de cadenas, como añadir o modificar contenido.

Recomiendo utilizar String cuando se prefiera la inmutabilidad y el rendimiento no sea crítico, y optar por StringBuilder cuando se necesite un mejor rendimiento en escenarios que impliquen múltiples modificaciones de cadenas.

¿Cuál es el propósito de la anotación @tailrec en Scala?

La anotación ` @tailrec ` se utiliza para marcar un método como recursivo de cola, lo que significa que la llamada recursiva es la última operación del método. Esto permite al compilador Scala optimizar el método para evitar errores de desbordamiento de pila transformando la recursividad en un bucle. Si el método no es recursivo por la cola, el compilador generará un error.

Veamos un ejemplo:

@tailrec

def factorial(n: Int, accumulator: Int = 1): Int = {

if (n <= 0) accumulator

else factorial(n - 1, n * accumulator)

}Preguntas de entrevista sobre Scala para nivel intermedio

Una vez cubiertos los conceptos básicos, pasemos a algunas preguntas de nivel intermedio sobre Scala que te ayudarán a comprender mejor cómo funciona el lenguaje.

¿Cuál es la diferencia entre map, flatMap y foreach en Scala?

En Scala, map, flatMap y foreach son funciones de orden superior que se utilizan en colecciones, pero tienen diferentes propósitos.

mapTransforma cada elemento de una colección y devuelve una nueva colección del mismo tamaño con los elementos transformados.- Por otro lado,

flatMaptambién transforma cada elemento, pero aplana la estructura resultante, lo que resulta útil cuando la transformación en sí misma da lugar a colecciones. - Por último,

foreachse utiliza para los efectos secundarios, aplicando una función a cada elemento sin devolver nada, y se utiliza habitualmente para operaciones como imprimir o actualizar estados externos.

¿Puedes explicar qué es el patrón de coincidencia en Scala y cuáles son sus casos de uso?

La coincidencia de patrones en Scala es una potente característica que te permite comparar valores con patrones, lo que hace que el código sea más expresivo y conciso. Es similar a las instrucciones « switch » o « case » de otros lenguajes, pero es más flexible y se puede utilizar con una gran variedad de tipos, como enteros, cadenas, listas e incluso estructuras de datos complejas. Se puede utilizar con expresiones de tipo « match », que comparan el valor de una expresión con múltiples patrones.

Algunos casos de uso de la coincidencia de patrones incluyen:

- Manejo de diferentes tipos de datos: Coincidencia con tipos específicos en una jerarquía de clases o uniones discriminadas (rasgos sellados).

- Descomposición de estructuras de datos: Emparejar clases de casos, extraer valores o realizar operaciones basadas en el contenido de los datos.

- Gestión de opciones: Comprobación de los valores

SomeoNoneenOption, lo que permite un manejo conciso de los valores nulos. - Descomposición de listas y tuplas: Coincidencia de elementos de listas, tuplas o secuencias para facilitar la extracción y manipulación.

Aquí te dejo un ejemplo:

// Define a variable x with value 3

val x = 3

// Pattern matching on the value of x

x match {

// If 'x' is equal to 1, print "One"

case 1 => println("One")

// If 'x' is equal to 2, print "Two"

case 2 => println("Two")

// If 'x' doesn't match any of the above cases, print "Other"

case _ => println("Other")

}¿Cuál es el propósito de Option, Some y None en Scala?

En Scala, un valor nulo ( Option ) es un tipo de contenedor que se utiliza para representar un valor que puede existir o no, lo que ayuda a evitar valores nulos ( null ) y excepciones de puntero nulo (null pointer exceptions). Tiene dos subtipos: Some y None.

Some envuelve un valor válido, indicando la presencia de un valor, mientras que None significa la ausencia de un valor. Esto permite a los programadores gestionar explícitamente los casos en los que podría faltar un valor, lo que favorece un código más seguro y funcional.

Option Se utiliza a menudo en métodos que pueden no devolver un resultado, lo que reduce la necesidad de realizar comprobaciones nulas propensas a errores.

Revisa el código a continuación:

// Function that returns an Option

def findFirstEvenNumber(list: List[Int]): Option[Int] = {

list.find(_ % 2 == 0) // Returns Some(number) if an even number is found, otherwise None

}

// Example usage:

val numbers = List(1, 3, 5, 7, 8)

val result = findFirstEvenNumber(numbers)

result match {

case Some(number) => println(s"Found an even number: $number") // Output: Found an even number: 8

case None => println("No even number found")

}¿Cómo maneja Scala las colecciones y cuáles son los principales tipos de colecciones?

Scala proporciona un amplio conjunto de colecciones clasificadas en tipos mutables e inmutables.

- Las colecciones inmutables, como

List,Set,MapyVector, no pueden modificarse después de su creación, lo que fomenta las prácticas de programación funcional. - Las colecciones mutables, como

ArrayBuffer,HashSetyHashMap, permiten modificaciones.

Las colecciones son muy flexibles y admiten diversas operaciones, como filtrado, mapeo y plegado. La biblioteca estándar también ofrece colecciones especializadas como Queue, Stack y SortedSet, que satisfacen de manera eficiente diferentes necesidades de manipulación de datos. Las colecciones inmutables son preferibles para garantizar la seguridad de los subprocesos y la pureza funcional.

¿Puedes explicar el concepto de parámetros implícitos en Scala?

En Scala, los parámetros implícitos son valores que el compilador pasa automáticamente a un método o constructor sin especificarlos explícitamente. Se marcan con la palabra clave ` implicit ` y se suelen utilizar para cosas como la inyección de dependencias, la configuración o el paso de contexto.

// Define a function that takes an implicit parameter 'name' of type String

def greet(implicit name: String) = s"Hello, $name"

// Define an implicit value 'myName' of type String in the scope

implicit val myName = "Alice"

// Call the greet function without explicitly passing 'name'

// The compiler automatically uses the implicit value 'myName'

println(greet) // Output: "Hello, Alice"¿Qué son los rasgos en Scala y en qué se diferencian de las interfaces en Java?

En Scala, los objetos de tipo « traits » son similares a los objetos de tipo « interfaces » en Java, pero con capacidades adicionales. Un rasgo es un componente reutilizable que se puede combinar con clases u otros rasgos. Te permite definir tanto métodos abstractos como métodos concretos. Los rasgos también pueden mantener el estado, a diferencia de las interfaces Java, que solo pueden definir firmas de métodos.

Scala admite la combinación de múltiples rasgos en una sola clase, lo que permite la herencia múltiple, mientras que Java permite implementar múltiples interfaces, pero solo una clase, lo que limita la flexibilidad de la herencia.

Aquí tienes un ejemplo:

trait Logger {

def log(message: String): Unit = println(s"Log: $message")

}¿Cómo funciona el REPL (bucle de lectura, evaluación e impresión) de Scala?

El REPL de Scala es una terminal interactiva que te permite escribir y evaluar código Scala en tiempo real. Funciona en cuatro pasos:

- Lee « » (El arte de la persuasión): El REPL lee el código Scala del usuario.

- Eval: Evalúa la entrada compilando y ejecutando el código.

- Imprimir: El resultado de la evaluación se imprime en la consola.

- : El proceso se repite, lo que permite una interacción continua con el código.

Este proceso permite experimentar y probar rápidamente el código Scala, lo que lo convierte en una potente herramienta para aprender, depurar y crear prototipos en Scala. Puedes definir variables y funciones, y explorar bibliotecas de forma interactiva.

Figura: El REPL de Scala es un intérprete de línea de comandos que puedes utilizar para probar tu código Scala como si fuera un área de pruebas. Fuente: Documentación de Scala

Preguntas avanzadas para entrevistas sobre Scala

Para aquellos que buscan puestos de mayor responsabilidad o que desean demostrar un conocimiento más profundo de Scala, veamos algunas preguntas avanzadas para entrevistas que se centran en el manejo de cálculos asíncronos y concurrencia, así como en estructuras y conversiones complejas.

Estas preguntas evaluarán tus conocimientos sobre programación funcional, concurrencia y diseño de sistemas escalables.

¿Cuál es la diferencia entre Future y Await en Scala?

En Scala, Future y Await están relacionados con el manejo de cálculos asíncronos, pero tienen fines diferentes.

Futurerepresenta un cálculo que finalmente se completará con un resultado o una excepción. Permite que otras tareas continúen mientras se espera el resultado del cálculo.AwaitSe utiliza para bloquear el subproceso actual hasta que esté disponible el resultado de unFuture. Obliga a un subproceso a esperar a que finalice un subproceso (Future). Se utiliza a menudo cuando necesitas sincronizar y esperar el resultado en un contexto no asíncrono.

A continuación, muestro algunos ejemplos de cómo utilizar estas funcionalidades:

import scala.concurrent.Future

import scala.concurrent.ExecutionContext.Implicits.global

import scala.concurrent.Await

import scala.concurrent.duration._

val futureValue = Future { 42 } // A Future that computes the value 42 asynchronously.

val result = Await.result(futureValue, 2.seconds) // Blocks the thread for up to 2 seconds, waiting for the result of the Future.¿Cómo gestiona Scala la concurrencia y qué bibliotecas se utilizan habitualmente?

Scala gestiona la concurrencia utilizando tanto mecanismos de bajo nivel, como subprocesos, como abstracciones de alto nivel, como Futures y Promises para la programación asíncrona.

La biblioteca estándar incluye scala.concurrent.Future, que permite realizar cálculos sin bloqueo, y ExecutionContext para gestionar los subprocesos de ejecución.

Para una concurrencia más avanzada, se utiliza ampliamente Akka, que proporciona herramientas para crear sistemas distribuidos altamente concurrentes utilizando el modelo Actor. Además, bibliotecas como Cats Effect y ZIO ofrecen enfoques de programación funcional para gestionar la concurrencia, proporcionando abstracciones seguras y combinables para gestionar efectos secundarios, tareas asíncronas y recursos.

¿Puedes explicar el concepto de mónadas en Scala y dar un ejemplo?

Las mónadas son un patrón de diseño utilizado para gestionar cálculos de forma estructurada, especialmente cuando se trata de efectos secundarios como operaciones asíncronas o valores nulos. Una mónada proporciona una forma de envolver un valor y aplicar transformaciones manteniendo la estructura. En Scala, Option y Future son ejemplos de mónadas.

val result = Some(5).flatMap(x => Some(x * 2))¿Cómo funciona el marco Akka con Scala para crear sistemas distribuidos?

El marco Akka en Scala está diseñado para simplificar la creación de sistemas distribuidos, concurrentes y tolerantes a fallos. Utiliza el modelo de actor ( Actor model), en el que cada actor es una unidad ligera e independiente que se comunica de forma asíncrona mediante el intercambio de mensajes.

Akka abstrae los detalles de concurrencia de bajo nivel, lo que permite a los programadores centrarse en la lógica empresarial. Admite sistemas distribuidos al permitir que los actores se ejecuten en diferentes nodos. El módulo Cluster de Akka facilita una comunicación fluida, el equilibrio de carga y la resiliencia, lo que lo hace ideal para sistemas escalables y de alta disponibilidad.

¿Qué son las conversiones implícitas en Scala y cómo funcionan?

En Scala, las conversiones implícitas permiten la transformación automática de un tipo a otro. Se definen utilizando la palabra clave « implicit » y se utilizan para permitir operaciones entre tipos que normalmente no serían compatibles. El compilador aplica conversiones implícitas cuando es necesario, lo que reduce el código repetitivo.

A modo de ejemplo, te muestro cómo convertir automáticamente un String en un Int al realizar operaciones aritméticas:

implicit def intToString(x: Int): String = x.toString

val str: String = 42 // Implicitly converted to “42”¿Puedes explicar la varianza de tipos en Scala (+, -, y =)?

En Scala, la varianza de tipos se refiere a cómo se relacionan entre sí los subtipos de un tipo genérico. Se controla mediante parámetros de tipo covariantes (+), contravariantes (-) e invariantes (=).

- covariante (+): Si un tipo es covariante, un subtipo puede reemplazar el parámetro de tipo. Por ejemplo,

List[+A]significa que unListdel tipoApuede utilizarse siempre que se espere unListde un supertipo deA. Ejemplo:List[Dog]se puede utilizar comoList[Animal]siDogamplíaAnimal. - contravariantes (-): Un tipo contravariable permite que un supertipo sustituya al parámetro de tipo. Por ejemplo,

Function1[-A, +B]significa que unFunction1puede aceptar un supertipo deAy devolver un subtipo deB. Ejemplo:Function1[Animal, Dog]se puede utilizar comoFunction1[Dog, Dog]. - Invariante (=): El tipo es fijo y no puede sustituirse por sus subtipos o supertipos. Por ejemplo,

List[A]es invariante, lo que significa queList[Dog]yList[Animal]no son intercambiables.

Preguntas de entrevista sobre Scala para ingenieros de datos

Si estás realizando una entrevista para un puesto de ingeniería de datos, prepárate para responder preguntas que evalúen tu capacidad para diseñar, optimizar y resolver problemas en aplicaciones Scala en un entorno de producción. Veamos algunas preguntas típicas que te pueden hacer en una entrevista.

¿Cómo se definen y utilizan las anotaciones personalizadas en Scala?

Para definir una anotación personalizada en Scala, debes crear una clase que extienda scala.annotation.Annotation. Esta clase toma parámetros del constructor para almacenar metadatos. Las anotaciones se aplican a clases, métodos o campos con el operador ` @symbol`.

Descubrí que una característica útil de las anotaciones es que se puede acceder a las anotaciones personalizadas en tiempo de ejecución utilizando la reflexión para recuperar sus metadatos, normalmente a través de getAnnotations o métodos similares.

import scala.annotation.StaticAnnotation

class MyAnnotation extends StaticAnnotation

@MyAnnotation class MyClass¿Cómo se utiliza Scala con Apache Spark para el procesamiento de big data?

Scala es el lenguaje nativo de Apache Spark, lo que proporciona una integración perfecta y un alto rendimiento.

Se utiliza para escribir trabajos de procesamiento de datos distribuidos, aprovechando las características principales de Spark, como RDD (conjuntos de datos distribuidos resilientes), DataFrame y conjuntos de datos. Con Scala, puedes crear y manipular grandes conjuntos de datos, aplicar transformaciones y ejecutar operaciones complejas de manera eficiente en un clúster.

La API Scala de Spark ofrece una sintaxis concisa y expresiva para gestionar tareas de big data, desde el procesamiento por lotes hasta los procesos de machine learning, lo que permite el análisis y el procesamiento de datos a gran escala en paralelo.

Quizás también te interese aprender PySpark desde cero: esta guía completa sobre PySpark es unexcelente punto de partida.

¿Cuál es la diferencia entre RDD, DataFrame y Datasets en Spark con Scala?

En Spark, los RDD (conjuntos de datos distribuidos resilientes) son la abstracción de bajo nivel, que representan datos distribuidos que pueden procesarse en paralelo. Los DataFrame son abstracciones de alto nivel construidas sobre RDD, que ofrecen un manejo estructurado de datos con una ejecución optimizada mediante el optimizador Catalyst de Spark.

Los conjuntos de datos combinan lo mejor de los RDD y los DataFrame, ya que ofrecen la seguridad de tipos de los RDD y las optimizaciones de los DataFrame. Los conjuntos de datos son fuertemente tipados, mientras que los DataFrame no lo son, lo que permite transformaciones y acciones más eficientes en Spark.

¿Cómo se escribe un trabajo básico de Spark en Scala?

Un trabajo básico de Spark en Scala implica:

- Inicializando un

SparkSession. - Creación o carga de datos en un RDD, DataFrame o Dataset.

- Realizar transformaciones y acciones sobre esos datos.

- Ejecutar el trabajo en un clúster Spark.

Aquí puedes ver un ejemplo:

// Import the SparkSession class which is the entry point for Spark SQL

import org.apache.spark.sql.SparkSession

// Create a SparkSession.

val spark = SparkSession.builder.appName("MySparkApp").getOrCreate()

// Read the input text file as a DataFrame.

val data = spark.read.text("data.txt")

// Perform the transformation on the text file

val wordCount = textFile.flatMap(_.split(" ")).groupByKey(identity).count()

wordCount.show()¿Qué son las transformaciones y las acciones en Spark, y cómo se implementan en Scala?

Las transformaciones en Spark son operaciones que definen un nuevo RDD, DataFrame o Dataset, como map(), filter() o groupBy(). Se evalúan de forma perezosa, lo que significa que no se ejecutan hasta que se desencadena una acción.

Las acciones son operaciones que activan la ejecución, como collect(), count() o save(). Las transformaciones se aplican a los datos de forma diferida, mientras que las acciones obligan a Spark a ejecutar el DAG deoperaciones y devolver un resultado o conservar los datos.

¿Puedes explicar la importancia de la evaluación perezosa en Spark con Scala?

La evaluación perezosa en Spark significa que las transformaciones no se ejecutan inmediatamente. En su lugar, Spark crea un plan de ejecución (DAG) y solo ejecuta los cálculos cuando se llama a una acción. Esto permite a Spark optimizar la ejecución minimizando la reorganización de datos, combinando operaciones y aplicando filtros en una fase más temprana del proceso.

¿Cómo se optimizan los trabajos de Spark escritos en Scala?

La optimización de los trabajos de Spark implica varias estrategias, como minimizar la reorganización de datos, almacenar en caché los resultados intermedios y utilizar una partición adecuada.

Algunas de las estrategias que recomiendo utilizar para optimizar los trabajos de Spark son:

- Utiliza DataFrame/Datasets en lugar de RDD para obtener una mejor optimización a través del optimizador de consultas Catalyst de Spark.

- Utilizar el almacenamiento en caché cuando sea apropiado.

- Evitar transformaciones amplias que mezclen datos (como

groupBy). - Uso de uniones de difusión para evitar la reorganización de grandes conjuntos de datos.

- Ajustar la configuración de Spark, como modificar el número de particiones o utilizar el filtrado descendente.

¿Cuáles son algunos de los retos más comunes a los que te has enfrentado al utilizar Scala para proyectos de big data?

Entre los retos habituales en Scala para proyectos de big data se incluyen la gestión de la memoria y el rendimiento para grandes conjuntos de datos, el manejo de la asimetría de datos y el tratamiento eficiente de los fallos en entornos distribuidos.

La depuración de trabajos de Spark puede resultar complicada debido a la complejidad de los sistemas distribuidos y la evaluación perezosa. Además, optimizar los trabajos de Spark para evitar cuellos de botella y reducir la sobrecarga suele requerir ajustar las configuraciones y comprender el plan de ejecución subyacente.

Además, lidiar con formatos de datos inconsistentes, problemas de calidad de los datos y la complejidad de escribir y mantener código escalable puede resultar difícil en escenarios de big data.

Conclusión

En este artículo, hemos cubierto una amplia gama de preguntas de entrevista sobre Scala que abarcan temas básicos, intermedios y avanzados. Desde comprender los conceptos básicos y las ventajas de Scala hasta profundizar en optimizaciones, manejos y conversiones más complejos, hemos explorado las áreas clave sobre las que los posibles empleadores podrían preguntar.

Para consolidar tu preparación, comienza a practicar con nuestro curso Introducción a Scala o haz un repaso rápido. ¿Te estás preparando para desempeñar una función dual en Java y Scala? No te pierdas nuestra guía de preguntas de entrevista sobre Java para obtener una perspectiva completa.

Conviértete en Ingeniero de Datos