Kurs

Scala ist eine coole Sprache, die funktionale und objektorientierte Programmierung kombiniert. Es wird oft in der Verarbeitung von großen Datenmengen und in Web-Apps benutzt, weil es eine einfache Syntax hat, gut skalierbar ist und gut läuft.

Da Scala-Kenntnisse in der Datenbranche immer gefragter werden, gibt dieser Artikel einen umfassenden Überblick über Scala-Interviewfragen, die verschiedene Themen von grundlegenden Konzepten bis hin zu fortgeschrittenen Techniken und Fragen zum Data Engineering abdecken.

Grundlegende Fragen zum Thema Scala

Schauen wir uns erstmal ein paar grundlegende Scala-Interviewfragen an, die zeigen, wie gut du die Kernkonzepte und Vorteile dieser starken Sprache verstehst.

Wenn du noch keine Erfahrung mit der Sprache hast, fang mit unseremKurs „Einführung in Scala“ an,um dir eine solide Grundlage zu schaffen, bevor du dich mit Interviewfragen beschäftigst.

Was ist Scala und wie unterscheidet es sich von Java?

Der Name Scala kommt von „scalable“ ( skalierbar) . Scala ist eine statisch typisierte Programmiersprache, die objektorientierte und funktionale Programmierparadigmen kombiniert. Es ist kurz, klar und soll viele der Schwächen von Java beheben. Scala läuft zum Beispiel auf der Java Virtual Machine (JVM), was bedeutet, dass du Java-Bibliotheken und -Frameworks problemlos nutzen kannst.

Während Java komplett objektorientiert ist, kann man mit Scala sowohl objektorientiert als auch funktional programmieren. Scala hat auch coole Sachen wie Unveränderlichkeit, Funktionen höherer Ordnung, Mustervergleich und mehr, alles mit einer knackigen Syntax.

Wenn du Java schon kennst, schau dir denKurs „Einführung in Java“ an, um die Grundlagen noch mal aufzufrischen. Um die objektorientierten Prinzipien in Java und Scala zu vergleichen, probier doch mal den Kurs „Einführung in die OOP in Java“ aus.

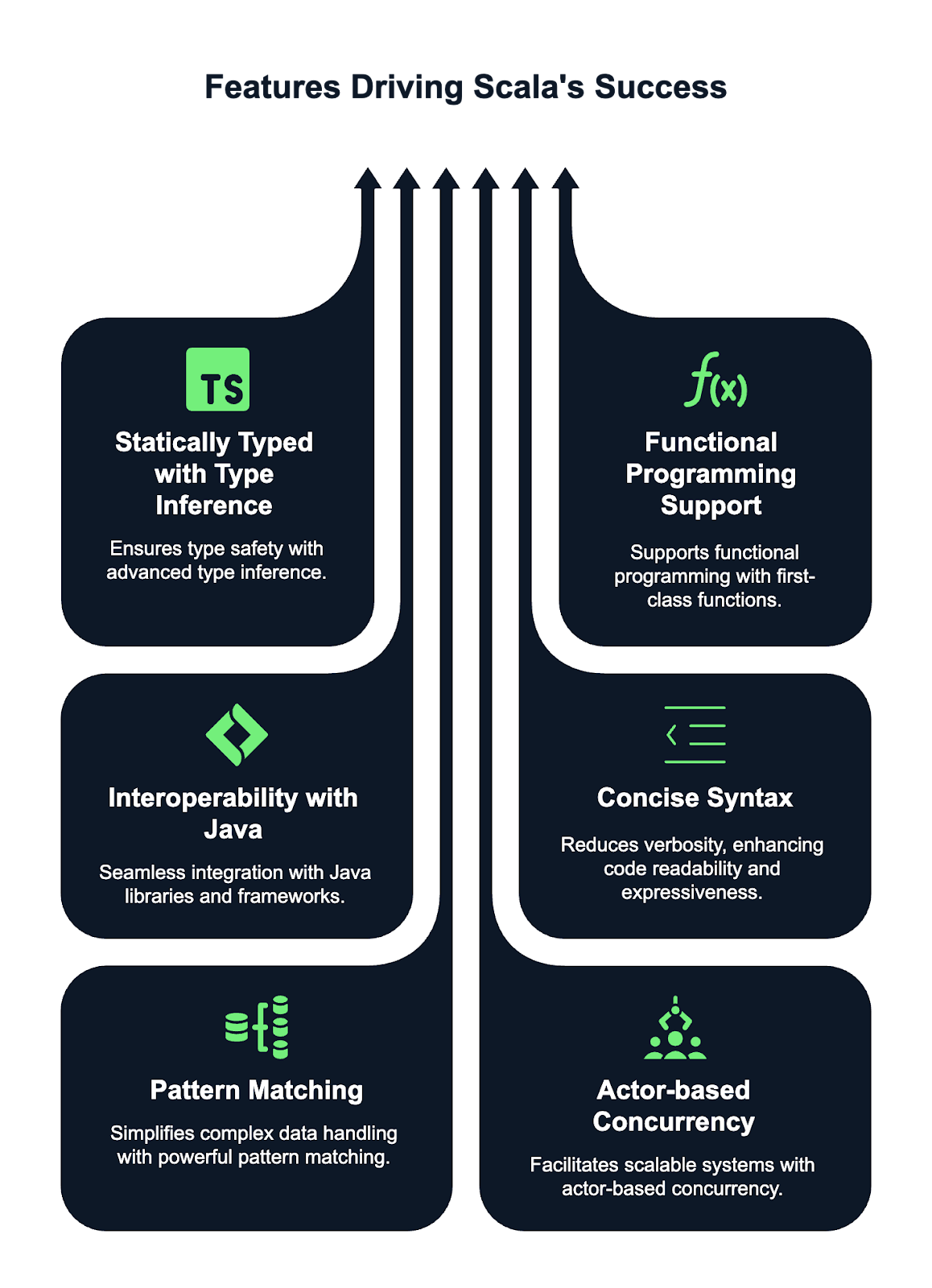

Was sind die wichtigsten Features von Scala?

Scala hat ein paar coole Features, die es besonders machen und bei Programmierern beliebt sind. Hier sind ein paar dieser Funktionen:

- Statisch typisiert mit Typinferenz. Scala ist eine statisch typisierte Sprache, was heißt, dass die Typen beim Kompilieren überprüft werden, um die Typsicherheit zu gewährleisten. Dank Scalas ausgeklügeltem System zur Typinferenz musst du in den meisten Fällen die Typen von Variablen und Funktionen nicht extra angeben. Der Compiler kann die Typen automatisch ermitteln.

- Unterstützung für funktionale Programmierung. Scala bietet erstklassige Unterstützung für funktionale Programmierung. Damit kannst du Funktionen wie normale Werte behandeln, sie als Argumente weitergeben und aus anderen Funktionen zurückgeben. Unveränderlichkeit ist ein zentrales Konzept, wobei unveränderliche Sammlungen der Standard sind. Scala unterstützt auch Funktionen höherer Ordnung, was abstrakteren und wiederverwendbaren Code ermöglicht.

- Funktioniert das mit Java-? Scala läuft auf der JVM, was eine nahtlose Integration mit Java-Code ermöglicht. Das heißt, du kannst Java-Bibliotheken und -Frameworks direkt im Scala-Code nutzen und umgekehrt. Scala kann Java-Code aufrufen, und Java kann mit Scala-Komponenten interagieren, was es super vielseitig und kompatibel mit bestehenden Java-Projekten macht.

- Kurze Syntax. Scala wurde entwickelt, um im Vergleich zu Java weniger Text zu brauchen, was es ausdrucksstärker und prägnanter macht. Damit können Entwickler saubereren und besser lesbaren Code mit weniger Boilerplate schreiben. Funktionen wie optionale Klammern, Typinferenz und knappe Kontrollstrukturen machen Scala einfacher zu schreiben und zu pflegen als Java, ohne dass es an Ausdruckskraft verliert.

- Mustervergleich. Das Pattern Matching von Scala ist eine echt mächtige und flexible Funktion, die die Arbeit mit komplizierten Datenstrukturen einfacher macht. Damit kannst du Typen, Werte und Strukturen abgleichen, was mehrere if-else- oder switch-Anweisungen überflüssig machen kann. Dadurch wird der Code übersichtlicher, besser lesbar und einfacher zu pflegen, vor allem bei komplexen Datenmustern.

- Akteursbasiertes Parallelitätsmodell. Scala hat eingebaute Tools, um Parallelität über das Akteurmodell zu verwalten, das durch das Akka-Framework bekannt geworden ist. Mit diesem Modell kannst du hochgradig parallele, verteilte und fehlertolerante Systeme aufbauen, indem du die Berechnung in unabhängige „Akteure” aufteilst, die über Nachrichtenübermittlung miteinander reden. Dieser Ansatz macht die Verwaltung von Zuständen einfacher und vermeidet die Probleme herkömmlicher Thread-basierter Parallelitätsmodelle, sodass Scala perfekt für die Entwicklung skalierbarer und robuster Anwendungen ist.

Was ist eine Fallklasse in Scala und wozu wird sie benutzt?

Eine Fallklasse in Scala ist eine spezielle Klasse, die für die Verwendung mit unveränderlichen Datenstrukturen optimiert ist. Es stellt automatisch Implementierungen für Methoden wie „ toString “, „ equals “ und „ hashCode “ bereit. Fallklassen können auch mit Mustern abgeglichen werden, was sie super nützlich für die Datenverarbeitung im funktionalen Stil macht.

Normalerweise benutzt man Fallklassen, um Datenobjekte darzustellen, die sich nach ihrer Erstellung nicht mehr ändern sollten. Ich hab dir unten ein Beispiel hinterlassen:

case class Person(name: String, age: Int)

val person1 = Person("John", 30)Wie geht Scala mit Unveränderlichkeit um?

In Scala wird Unveränderlichkeit gefördert, vor allem bei der funktionalen Programmierung. Du kannst eine unveränderliche Variable mit „ val “ deklarieren, im Gegensatz zu „ var “, das veränderbar ist. Sobald du einem „ val “ einen Wert zugewiesen hast, kannst du ihn nicht mehr ändern. Unveränderlichkeit macht den Code sicherer und berechenbarer, weil es weniger Raum für ungewollte Nebeneffekte gibt. Schau dir mein Beispiel unten an:

val name = "Alice"

// Trying to change it will result in a compile-time error

name = "Bob" // Error: reassignment to valWas sind Begleitobjekte in Scala?

Ein Begleitojekt ist ein Objekt, das denselben Namen wie eine Klasse hat und in derselben Datei definiert ist. Der Hauptzweck eines Begleitobjekts ist es, Methoden und Funktionen bereitzustellen, die eng mit der Klasse zusammenhängen, aber nicht an eine Instanz davon gebunden sind.

Das Begleitojekt kann Factory-Methoden oder andere Hilfsfunktionen enthalten, wie in dem Beispiel unten:

class Person(val name: String, val age: Int)

object Person {

def apply(name: String, age: Int): Person = new Person(name, age)

}Mit der Methode „apply“ im Begleitojekt „ Person “ kann ich ein „ Person “ erstellen, ohne das Schlüsselwort „new“ zu benutzen, wie ich unten zeige:

val p = Person("John", 25)Was ist der Unterschied zwischen var, val und lazy val in Scala?

In Scala benutzt man die Schlüsselwörter ` var`, ` val` und ` lazy val `, um Variablen zu definieren, aber sie unterscheiden sich in Bezug auf Veränderbarkeit, Initialisierung und Auswertungszeitpunkt.

Eine „ var “ ist eine veränderbare Variable, was bedeutet, dass ihr Wert nach der Initialisierung geändert werden kann. Du kannst einem „ var “ einen neuen Wert zuweisen:

var x = 10

x = 20 // ReassignableAndererseits ist eine Referenz ( val ) unveränderlich, was bedeutet, dass sie, sobald ihr ein Wert zugewiesen wurde, nicht mehr neu zugewiesen werden kann, aber das Objekt, auf das sie verweist, kann trotzdem veränderbar sein.

val y = 10

// y = 20 // Error: reassignment to valEin „ lazy val ” ist eine spezielle Art von „ val ”, die erst beim ersten Zugriff ausgewertet wird. Das nennt man „lazy evaluation” (verzögerte Auswertung). Das kann bei der Leistungsoptimierung nützlich sein, wenn man mit aufwendigen oder ressourcenintensiven Berechnungen arbeitet.

lazy val z = {

println("Computing z")

42

}Wenn du mehr über Variablendeklarationen und Best Practices in Scala wissen willst, schau dir dieses Tutorial zu Variablen in Scalaan .

Kannst du das Konzept der Funktionen höherer Ordnung in Scala erklären?

In Scala ist eine Funktion höherer Ordnung eine Funktion, die entweder eine oder mehrere Funktionen als Parameter nimmt oder eine Funktion als Ergebnis zurückgibt. Mit diesem Konzept kannst du Funktionen wie erstklassige Werte behandeln, was dir mehr Flexibilität und Abstraktion in deinem Code gibt.

Mit Funktionen höherer Ordnung kann man Verhaltensweisen weitergeben und anpassen, was den Code modularer, wiederverwendbarer und ausdrucksstärker macht.

Unten habe ich ein Beispiel für eine Funktion höherer Ordnung hinterlassen, die eine andere Funktion als Argument nimmt:

// Define a higher-order function that takes a function as a parameter

def applyFunction(f: Int => Int, x: Int): Int = f(x)

// Call the higher-order function with a function that multiplies the input by 2

val result = applyFunction(x => x * 2, 5) // 10In diesem Fall ist „ applyFunction “ eine Funktion höherer Ordnung, die eine Funktion „ f “ nimmt, die mit 2 multipliziert, und sie auf 5 anwendet.

Was ist der Unterschied zwischen String und StringBuilder in Scala?

In Scala ist „ String “ unveränderlich, was bedeutet, dass Änderungen neue Objekte erzeugen, was bei wiederholten Änderungen ineffizient sein kann. Es ist gut für gelegentliche String-Operationen.

Im Gegensatz dazu ist „ StringBuilder “ veränderbar, sodass Änderungen direkt vorgenommen werden können, ohne dass neue Objekte erstellt werden müssen. Das macht es effizienter für häufige String-Manipulationen wie das Anhängen oder Ändern von Inhalten.

Ich empfehle, „ String ” zu verwenden, wenn Unveränderlichkeit wichtig ist und die Leistung nicht so entscheidend ist, und „ StringBuilder ” zu wählen, wenn du in Szenarien mit mehreren String-Änderungen eine bessere Leistung brauchst.

Wozu dient die Anmerkung @tailrec in Scala?

Die Anmerkung „ @tailrec “ wird benutzt, um eine Methode als tail-rekursiv zu kennzeichnen, was bedeutet, dass der rekursive Aufruf die letzte Operation in der Methode ist. Dadurch kann der Scala-Compiler die Methode optimieren, um Stack-Überlauf-Fehler zu vermeiden, indem er die Rekursion in eine Schleife umwandelt. Wenn die Methode nicht tail-rekursiv ist, gibt der Compiler 'ne Fehlermeldung raus.

Schauen wir uns mal ein Beispiel an:

@tailrec

def factorial(n: Int, accumulator: Int = 1): Int = {

if (n <= 0) accumulator

else factorial(n - 1, n * accumulator)

}Fragen für Scala-Interviews für Fortgeschrittene

Nachdem wir die Grundlagen geklärt haben, schauen wir uns jetzt ein paar Scala-Interviewfragen für Fortgeschrittene an, die dir helfen, besser zu verstehen, wie die Sprache funktioniert.

Was ist der Unterschied zwischen map, flatMap und foreach in Scala?

In Scala sind „ map “, „ flatMap “ und „ foreach “ Funktionen höherer Ordnung, die auf Sammlungen angewendet werden, aber sie haben unterschiedliche Zwecke.

mapverändert jedes Element einer Sammlung und gibt eine neue Sammlung gleicher Größe mit den veränderten Elementen zurück.- Andererseits transformiert auch „

flatMap“ jedes Element, macht aber die resultierende Struktur flach, was praktisch ist, wenn die Transformation selbst zu Sammlungen führt. - Zu guter Letzt wird „

foreach“ für Nebenwirkungen genutzt, indem eine Funktion auf jedes Element angewendet wird, ohne dass etwas zurückgegeben wird. Das wird oft für Sachen wie das Drucken oder das Aktualisieren von externen Zuständen verwendet.

Kannst du Pattern Matching in Scala und seine Anwendungsfälle erklären?

Das Pattern Matching in Scala ist eine coole Funktion, mit der du Werte mit Mustern abgleichen kannst, was den Code ausdrucksstärker und knapper macht. Es ist ähnlich wie die Anweisungen „ switch “ oder „ case “ in anderen Sprachen, aber flexibler und kann mit verschiedenen Typen wie Ganzzahlen, Zeichenfolgen, Listen und sogar komplexen Datenstrukturen verwendet werden. Es kann mit Ausdrücken vom Typ „ match “ verwendet werden, die den Wert eines Ausdrucks mit mehreren Mustern vergleichen.

Ein paar Anwendungsfälle für Mustervergleich sind:

- Umgang mit verschiedenen Datentypen: Abgleich mit bestimmten Typen in einer Klassenhierarchie oder diskriminierten Vereinigungen (versiegelte Merkmale).

- Datenstrukturen zerlegen: Abgleichen von Fallklassen, Extrahieren von Werten oder Durchführen von Operationen basierend auf Dateninhalten.

- Optionen verarbeiten: Überprüfe, ob die Werte „

Some” oder „None” in „Option” vorkommen, damit du nullbare Werte einfach handhaben kannst. - Listen- und Tupelzerlegung: Abgleich von Elementen aus Listen, Tupeln oder Sequenzen für einfaches Extrahieren und Bearbeiten.

Hier habe ich ein Beispiel hinterlassen:

// Define a variable x with value 3

val x = 3

// Pattern matching on the value of x

x match {

// If 'x' is equal to 1, print "One"

case 1 => println("One")

// If 'x' is equal to 2, print "Two"

case 2 => println("Two")

// If 'x' doesn't match any of the above cases, print "Other"

case _ => println("Other")

}Was machen Option, Some und None in Scala?

In Scala ist „ Option “ ein Containertyp, der einen Wert darstellt, der vorhanden sein kann oder auch nicht, und hilft dabei, „ null “-Werte und Null-Pointer-Ausnahmen zu vermeiden. Es gibt zwei Untertypen: Some und None.

Some umschließt einen gültigen Wert und zeigt an, dass ein Wert vorhanden ist, während „ None “ bedeutet, dass kein Wert vorhanden ist. Dadurch können Entwickler Fälle, in denen ein Wert fehlen könnte, explizit behandeln, was zu sichererem und funktionalerem Code führt.

Option wird oft in Methoden benutzt, die vielleicht kein Ergebnis liefern, und macht so fehleranfällige Null-Prüfungen weniger nötig.

Schau dir mal den Code unten an:

// Function that returns an Option

def findFirstEvenNumber(list: List[Int]): Option[Int] = {

list.find(_ % 2 == 0) // Returns Some(number) if an even number is found, otherwise None

}

// Example usage:

val numbers = List(1, 3, 5, 7, 8)

val result = findFirstEvenNumber(numbers)

result match {

case Some(number) => println(s"Found an even number: $number") // Output: Found an even number: 8

case None => println("No even number found")

}Wie geht Scala mit Sammlungen um und was sind die wichtigsten Sammlungstypen?

Scala hat eine ganze Reihe von Sammlungen, die in veränderbare und unveränderbare Typen unterteilt sind.

- Unveränderliche Sammlungen wie

List,Set,MapundVectorkönnen nach dem Erstellen nicht mehr geändert werden, was funktionale Programmierpraktiken fördert. - Veränderbare Sammlungen wie

ArrayBuffer,HashSetundHashMaplassen Änderungen zu.

Sammlungen sind echt flexibel und unterstützen verschiedene Vorgänge wie Filtern, Zuordnen und Falten. Die Standardbibliothek hat auch spezielle Sammlungen wie Queue, Stack und SortedSet, die verschiedene Anforderungen an Datenbearbeitung effizient abdecken. Unveränderliche Sammlungen sind wegen Thread-Sicherheit und funktionaler Reinheit besser.

Kannst du mir das Konzept der impliziten Parameter in Scala erklären?

In Scala sind implizite Parameter Werte, die der Compiler automatisch an eine Methode oder einen Konstruktor weitergibt, ohne sie explizit anzugeben. Sie sind mit dem Schlüsselwort „ implicit “ gekennzeichnet und werden normalerweise für Sachen wie Dependency Injection, Konfiguration oder Kontextübergabe benutzt.

// Define a function that takes an implicit parameter 'name' of type String

def greet(implicit name: String) = s"Hello, $name"

// Define an implicit value 'myName' of type String in the scope

implicit val myName = "Alice"

// Call the greet function without explicitly passing 'name'

// The compiler automatically uses the implicit value 'myName'

println(greet) // Output: "Hello, Alice"Was sind Traits in Scala und wie unterscheiden sie sich von Interfaces in Java?

In Scala sind „ traits ” ähnlich wie „ interfaces ” in Java, haben aber ein paar zusätzliche Funktionen. Ein Merkmal ist so 'ne wiederverwendbare Komponente, die man in Klassen oder andere Merkmale einbauen kann. Damit kannst du sowohl abstrakte als auch konkrete Methoden definieren. Eigenschaften können auch Zustände speichern, im Gegensatz zu Java-Schnittstellen, die nur Methodensignaturen definieren können.

Scala kann mehrere Eigenschaften in einer Klasse mischen, was Mehrfachvererbung möglich macht, während Java zwar mehrere Schnittstellen implementieren lässt, aber nur eine Klasse, was die Flexibilität bei der Vererbung einschränkt.

Hier ist ein Beispiel:

trait Logger {

def log(message: String): Unit = println(s"Log: $message")

}Wie läuft die Scala REPL (Read-Eval-Print Loop) ab?

Die Scala REPL ist eine interaktive shell, mit der du Scala-Code in Echtzeit schreiben und auswerten kannst. Es läuft in vier Schritten ab:

- Lies „ “: Die REPL liest den Scala-Code vom Benutzer.

- Eval-: Es checkt die Eingabe, indem es den Code kompiliert und ausführt.

- Druck-: Das Ergebnis der Auswertung wird auf der Konsole angezeigt.

- Loop: Der Prozess wiederholt sich und ermöglicht so eine ständige Interaktion mit dem Code.

Dieser Prozess macht es einfach, schnell mit Scala-Code rumzuexperimentieren und ihn zu testen, was ihn zu einem super Tool fürs Lernen, Debuggen und Prototyping in Scala macht. Du kannst Variablen und Funktionen definieren und Bibliotheken interaktiv erkunden.

Abbildung: Die Scala REPL ist ein Befehlszeileninterpreter, mit dem du deinen Scala-Code wie in einem Spielbereich testen kannst. Quelle: Scala-Dokumentation

Fragen für Fortgeschrittene zu Scala

Für alle, die nach höheren Positionen suchen oder zeigen wollen, dass sie Scala richtig gut verstehen, schauen wir uns ein paar fortgeschrittene Interviewfragen an, die sich mit asynchronen Berechnungen und Parallelität sowie komplexen Strukturen und Konvertierungen beschäftigen.

Diese Fragen prüfen deine Kenntnisse in funktionaler Programmierung, Parallelität und skalierbarem Systemdesign.

Was ist der Unterschied zwischen „Future“ und „Await“ in Scala?

In Scala haben sowohl ` Future ` als auch ` Await ` mit der Verarbeitung asynchroner Berechnungen zu tun, erfüllen aber unterschiedliche Zwecke.

Futuresteht für eine Berechnung, die irgendwann mit einem Ergebnis oder einer Ausnahme fertig wird. Es lässt andere Aufgaben weiterlaufen, während man auf das Ergebnis der Berechnung wartet.Awaitwird benutzt, um den aktuellen Thread zu blockieren, bis das Ergebnis von „Future“ da ist. Es zwingt einen Thread, auf das Ende eines „Future“ zu warten. Es wird oft benutzt, wenn du in einem nicht-asynchronen Kontext synchronisieren und auf das Ergebnis warten musst.

Hier zeige ich dir ein paar Beispiele, wie du diese Funktionen nutzen kannst:

import scala.concurrent.Future

import scala.concurrent.ExecutionContext.Implicits.global

import scala.concurrent.Await

import scala.concurrent.duration._

val futureValue = Future { 42 } // A Future that computes the value 42 asynchronously.

val result = Await.result(futureValue, 2.seconds) // Blocks the thread for up to 2 seconds, waiting for the result of the Future.Wie geht Scala mit Parallelität um und welche Bibliotheken werden normalerweise benutzt?

Scala macht das mit Parallelität über Low-Level-Mechanismen wie Threads und High-Level-Abstraktionen wie „ Futures ” und „ Promises ” für asynchrone Programmierung.

Die Standardbibliothek hat scala.concurrent.Future, das nicht blockierende Berechnungen ermöglicht, und ExecutionContext zum Verwalten von Ausführungsthreads.

Für fortgeschrittenere Parallelität wird häufig „ Akka “ genutzt, das Tools zum Aufbau hochgradig paralleler, verteilter Systeme unter Verwendung des Akteurmodells bereitstellt. Außerdem bieten Bibliotheken wie Cats Effect und ZIO funktionale Programmieransätze für die Behandlung von Parallelität und stellen sichere, kombinierbare Abstraktionen für die Verwaltung von Nebenwirkungen, asynchronen Aufgaben und Ressourcen bereit.

Kannst du das Konzept der Monaden in Scala erklären und ein Beispiel geben?

Monaden sind ein Designmuster, das man benutzt, um Berechnungen strukturiert zu machen, vor allem wenn es um Nebenwirkungen wie asynchrone Operationen oder nullbare Werte geht. Eine Monade ist eine Möglichkeit, einen Wert zu verpacken und Transformationen anzuwenden, ohne die Struktur zu verändern. In Scala sind „ Option “ und „ Future “ Beispiele für Monaden.

val result = Some(5).flatMap(x => Some(x * 2))Wie funktioniert das Akka-Framework mit Scala beim Aufbau verteilter Systeme?

Das Akka-Framework in Scala soll das Erstellen von verteilten, parallelen und fehlertoleranten Systemen einfacher machen. Es nutzt das „ Actor model “, wo jeder Akteur eine leichte, unabhängige Einheit ist, die über Nachrichtenübermittlung asynchron kommuniziert.

Akka abstrahiert Details der Low-Level-Parallelität, sodass Entwickler sich auf die Geschäftslogik konzentrieren können. Es unterstützt verteilte Systeme, indem es Akteuren ermöglicht, auf verschiedenen Knoten zu laufen. Das Modul „ Cluster “ von Akka macht nahtlose Kommunikation, Lastenausgleich und Ausfallsicherheit möglich und ist damit super für skalierbare Systeme mit hoher Verfügbarkeit.

Was sind implizite Konvertierungen in Scala und wie funktionieren sie?

In Scala kann man mit impliziten Konvertierungen einen Typ automatisch in einen anderen umwandeln. Sie werden mit dem Schlüsselwort „ implicit “ definiert und ermöglichen Operationen zwischen Typen, die normalerweise nicht kompatibel wären. Der Compiler macht implizite Konvertierungen, wenn's nötig ist, und reduziert so den Boilerplate-Code.

Als Beispiel zeige ich dir, wie du bei Rechenoperationen automatisch von einem „ String ” zu einem „ Int ” umrechnest:

implicit def intToString(x: Int): String = x.toString

val str: String = 42 // Implicitly converted to “42”Kannst du mir die Typvarianten in Scala (+, -, und =) erklären?

In Scala geht es bei der Typenvarianz darum, wie Untertypen eines generischen Typs miteinander zusammenhängen. Die Steuerung erfolgt über kovarianten (+), kontravarianten (-) und invarianten (=) Typparameter.

- Kovariant (+): Wenn ein Typ kovariant ist, kann ein Untertyp den Typparameter ersetzen. Zum Beispiel heißt „

List[+A]”, dass ein „List” vom Typ „A” überall verwendet werden kann, wo ein „List” eines Supertyps von „A” erwartet wird. Beispiel:List[Dog]kann alsList[Animal]genutzt werden, wennDogAnimalerweitert. - Kontravariant (-): Ein kontravarianten Typ lässt einen Supertyp den Typparameter ersetzen. Zum Beispiel heißt „

Function1[-A, +B]”, dass ein „Function1” einen Supertyp von „A” akzeptieren und einen Subtyp von „B” zurückgeben kann. Beispiel:Function1[Animal, Dog]kann alsFunction1[Dog, Dog]genutzt werden. - Invariant (=): Der Typ ist festgelegt und kann nicht durch seine Untertypen oder Obertypen ersetzt werden. Zum Beispiel ist „

List[A]“ unveränderlich, was bedeutet, dass „List[Dog]“ und „List[Animal]“ nicht austauschbar sind.

Scala-Interviewfragen für Dateningenieure

Wenn du dich für eine Stelle im Bereich Data Engineering bewirbst, solltest du dich auf Fragen einstellen, die deine Fähigkeit beurteilen, Scala-Anwendungen in einer Produktionsumgebung zu entwerfen, zu optimieren und Fehler zu beheben. Schauen wir uns mal ein paar typische Interviewfragen an, die dir begegnen könnten.

Wie definiert und nutzt man benutzerdefinierte Anmerkungen in Scala?

Um eine benutzerdefinierte Anmerkung in Scala zu definieren, musst du eine Klasse erstellen, die „ scala.annotation.Annotation “ erweitert. Diese Klasse nimmt Konstruktorparameter, um Metadaten zu speichern. Annotationen werden dann mit dem Schlüsselwort „ @symbol “ auf Klassen, Methoden oder Felder angewendet.

Ich hab festgestellt, dass eine coole Sache an Annotationen ist, dass man bei der Laufzeit auf benutzerdefinierte Annotationen zugreifen kann, indem man Reflection nutzt, um ihre Metadaten abzurufen, meistens über „ getAnnotations “ oder ähnliche Methoden.

import scala.annotation.StaticAnnotation

class MyAnnotation extends StaticAnnotation

@MyAnnotation class MyClassWie wird Scala mit Apache Spark für die Verarbeitung von Big Data genutzt?

Scala ist die native Sprache für Apache Spark und sorgt für nahtlose Integration und hohe Leistung.

Es wird benutzt, um Jobs für die verteilte Datenverarbeitung zu schreiben, und nutzt dabei die Kernfunktionen von Spark wie RDDs (Resilient Distributed Datasets), DataFrames und Datasets. Mit Scala kannst du große Datensätze erstellen und bearbeiten, Transformationen anwenden und komplexe Operationen effizient über einen Cluster ausführen.

Die Scala-API von Spark hat eine knappe und ausdrucksstarke Syntax für die Bearbeitung von Big-Data-Aufgaben, von der Stapelverarbeitung bis hin zu Machine-Learning-Pipelines, und ermöglicht so die parallele Analyse und Verarbeitung großer Datenmengen.

Vielleicht willst du auch PySpark von Grund auf lernen– dieser umfassende Leitfaden zu PySpark ist einsuper Einstieg.

Was ist der Unterschied zwischen RDDs, DataFrame und Datasets in Spark mit Scala?

In Spark sind RDDs (Resilient Distributed Datasets) die Low-Level-Abstraktion, die verteilte Daten darstellen, die parallel bearbeitet werden können. DataFrames sind höhere Abstraktionen, die auf RDDs aufbauen und eine strukturierte Datenverarbeitung mit optimierter Ausführung mithilfe des Catalyst-Optimierers von Spark bieten.

Datensätze vereinen das Beste aus RDDs und DataFrame und bieten die Typsicherheit von RDDs sowie die Optimierungen von DataFrame. Datensätze sind stark typisiert, während DataFrame untypisiert ist, was effizientere Transformationen und Aktionen in Spark ermöglicht.

Wie schreibt man einen einfachen Spark-Job in Scala?

Ein einfacher Spark-Job in Scala umfasst:

SparkSessionwird gestartet.- Erstellen oder Laden von Daten in ein RDD, DataFrame oder Dataset.

- Transformationen und Aktionen an diesen Daten durchführen.

- Den Job auf einem Spark-Cluster ausführen.

Hier siehst du ein Beispiel:

// Import the SparkSession class which is the entry point for Spark SQL

import org.apache.spark.sql.SparkSession

// Create a SparkSession.

val spark = SparkSession.builder.appName("MySparkApp").getOrCreate()

// Read the input text file as a DataFrame.

val data = spark.read.text("data.txt")

// Perform the transformation on the text file

val wordCount = textFile.flatMap(_.split(" ")).groupByKey(identity).count()

wordCount.show()Was sind Transformationen und Aktionen in Spark und wie werden sie in Scala gemacht?

Transformationen in Spark sind Operationen, die ein neues RDD, DataFrame oder Dataset definieren, wie z. B. „ map() “, „ filter() “ oder „ groupBy() “. Sie werden nachlässig ausgewertet, was bedeutet, dass sie erst ausgeführt werden, wenn eine Aktion ausgelöst wird.

Aktionen sind Vorgänge, die die Ausführung auslösen, wie z. B. „ collect() “, „ count() “ oder „save()“. Transformationen werden auf Daten verzögert angewendet, während Aktionen Spark dazu bringen, die DAG vonOperationen auszuführenund ein Ergebnis zurückzugeben oder Daten zu speichern.

Kannst du mir erklären, warum die verzögerte Auswertung in Spark mit Scala so wichtig ist?

Lazy Evaluation in Spark heißt, dass Transformationen nicht sofort gemacht werden. Stattdessen erstellt Spark einen Ausführungsplan (DAG) und führt die Berechnungen nur aus, wenn eine Aktion aufgerufen wird. Dadurch kann Spark die Ausführung optimieren, indem es das Verschieben von Daten minimiert, Operationen kombiniert und Filter früher in der Verarbeitungspipeline anwendet.

Wie optimiert man Spark-Jobs, die in Scala geschrieben sind?

Um Spark-Jobs zu optimieren, gibt's ein paar Strategien, wie zum Beispiel das Minimieren von Datenverschiebungen, das Zwischenspeichern von Zwischenergebnissen und die richtige Partitionierung.

Einige Strategien, die ich zur Optimierung von Spark-Jobs empfehle, sind:

- Benutze DataFrames/Datasets statt RDDs, um mit dem Catalyst-Abfrageoptimierer von Spark bessere Ergebnisse zu kriegen.

- Caching nutzen, wo es sinnvoll ist.

- Vermeide umfangreiche Umwandlungen, die Daten durcheinanderbringen (wie

groupBy). - Broadcast-Joins nutzen, um das Mischen großer Datensätze zu vermeiden.

- Die Spark-Konfiguration anpassen, zum Beispiel die Anzahl der Partitionen ändern oder Filter-Pushdown nutzen.

Was sind ein paar typische Probleme, auf die du bei der Verwendung von Scala für Big-Data-Projekte gestoßen bist?

Zu den typischen Herausforderungen bei Big-Data-Projekten mit Scala gehören die Verwaltung von Speicher und Leistung für große Datensätze, der Umgang mit Datenverzerrungen und die effiziente Behandlung von Fehlern in verteilten Umgebungen.

Das Debuggen von Spark-Jobs kann wegen der Komplexität verteilter Systeme und der verzögerten Auswertung echt knifflig sein. Außerdem braucht man oft eine genaue Konfiguration und muss den zugrunde liegenden Ausführungsplan verstehen, um Spark-Jobs zu optimieren, damit es nicht zu Engpässen kommt und der Aufwand reduziert wird.

Außerdem kann es bei Big-Data-Szenarien echt schwierig sein, mit uneinheitlichen Datenformaten, Datenqualitätsproblemen und der Komplexität des Schreibens und der Pflege skalierbarer Codes umzugehen.

Fazit

In diesem Artikel haben wir eine breite Palette von Scala-Interviewfragen behandelt, die grundlegende, mittlere und fortgeschrittene Themen abdecken. Vom Verständnis der Kernkonzepte und Vorteile von Scala bis hin zu komplexeren Optimierungen, Handhabungen und Konvertierungen haben wir die wichtigsten Bereiche erkundet, nach denen potenzielle Arbeitgeber fragen könnten.

Um deine Vorbereitung zu festigen, fang mit unserem Kurs „Einführung in Scala “ an oder hol dir eine schnelle Auffrischung! Bereit für eine Stelle, wo du sowohl Java als auch Scala brauchst? Verpass nicht unseren Leitfaden mit Java-Interviewfragen, um dir einen umfassenden Überblick zu verschaffen.

Werde Dateningenieur