Curso

Se estima que alrededor de 328,77 millones de terabytes de datos. Cada clic y cada compra generan datos que pueden procesarse para obtener información y predicciones significativas con las herramientas adecuadas.

Sin embargo, necesitamos una biblioteca de alto rendimiento que nos ayude a procesar esa cantidad de datos. Ahí es donde entra en juego PySpark.

En esta guía, exploraremos cómo aprender PySpark desde cero. Te ayudaré a elaborar un plan de aprendizaje, compartiré mis mejores consejos para aprender de forma eficaz y te proporcionaré recursos útiles que te ayudarán a encontrar puestos de trabajo que requieran PySpark.

Aprende PySpark desde cero

¿Qué es PySpark?

PySpark es la combinación de dos potentes tecnologías: Python y Apache Spark.

Python es uno de los lenguajes de programación más utilizados en el desarrollo de software, especialmente para la ciencia de datos y machine learning, debido principalmente a su sintaxis sencilla y fácil de usar.

Por otro lado, Apache Spark es un marco de trabajo capaz de gestionar grandes cantidades de datos no estructurados. Spark se ha creado utilizando Scala, un lenguaje que nos permite un mayor control sobre él. Sin embargo, Scala no es un lenguaje de programación popular entre los profesionales de los datos. Por lo tanto, PySpark se creó para superar esta brecha.

PySpark ofrece una API y una interfaz fácil de usar para interactuar con Spark. Aprovecha la simplicidad y flexibilidad de Python para hacer que el procesamiento de big data sea accesible a un público más amplio.

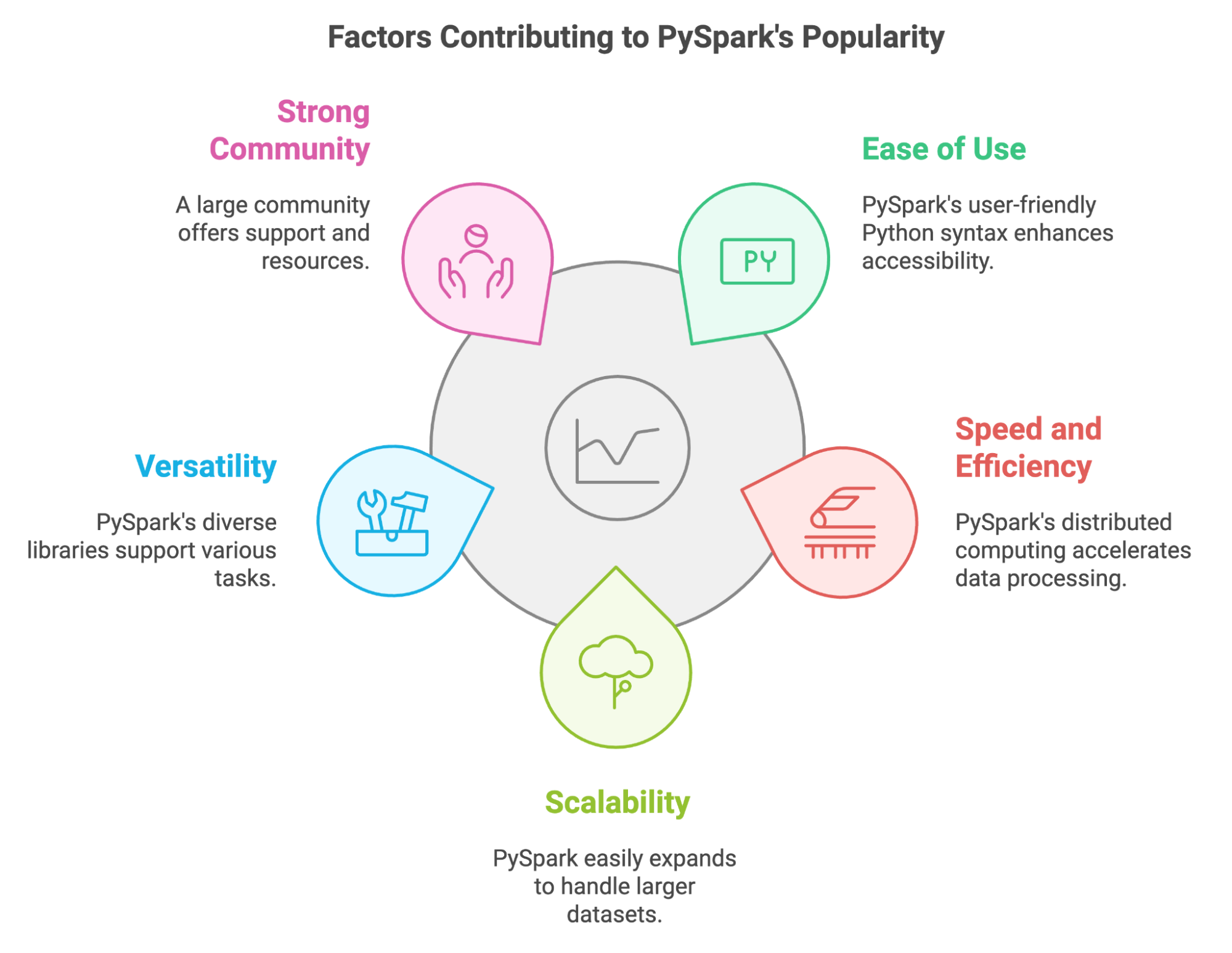

¿Qué hace que PySpark sea tan popular?

En los últimos años, PySpark se ha convertido en una herramienta importante para los profesionales de datos que necesitan procesar grandes cantidades de datos. Podemos explicar tu popularidad por varios factores clave:

- Facilidad de uso: PySpark utiliza la sintaxis familiar de Python, lo que lo hace más accesible para los profesionales de datos como nosotros.

- Rapidez y eficiencia: Al distribuir los cálculos entre clústeres de máquinas, PySpark maneja grandes conjuntos de datos a gran velocidad.

- Escalabilidad: PySpark se adapta al creciente volumen de datos, lo que nos permite ampliar nuestras aplicaciones añadiendo más recursos informáticos.

- Versatilidad: Ofrece un amplio ecosistema de bibliotecas para diferentes tareas, desde la manipulación de datos hasta machine learning.

- Comunidad fuerte: Podemos contar con una comunidad amplia y activa que nos brinda apoyo y recursos cuando nos enfrentamos a problemas y desafíos.

PySpark también nos permite aprovechar los conocimientos y las bibliotecas de Python existentes. Podemos integrarlo fácilmente con herramientas populares como Pandas y Scikit-learn, y nos permite utilizar diversas fuentes de datos.

Características principales de PySpark

PySpark se creó especialmente para big data y machine learning. Pero, ¿qué características lo convierten en una herramienta tan potente para manejar grandes cantidades de datos? Echemos un vistazo a ellos:

- Conjuntos de datos distribuidos resilientes (RDD): Estas son las estructuras de datos fundamentales que hay detrás de PySpark. Gracias a ellos, la transformación, el filtrado y la agregación de datos pueden realizarse en paralelo.

- DataFrame y SQL: En PySpark, DataFrame representa una abstracción de nivel superior construida sobre RDD. Podemos utilizarlos con Spark SQL y consultas para realizar manipulaciones y análisis de datos.

- Bibliotecas de machine learning: Uso de la biblioteca MLlib , podemos crear y utilizar modelos de machine learning escalables para tareas como la clasificación y la regresión.

- Admite diferentes formatos de datos: PySpark proporciona bibliotecas y API para leer, escribir y procesar datos en diferentes formatos, como CSV, JSON, Parquet y Avro, entre otros.

- Tolerancia a fallos: PySpark realiza un seguimiento de cada RDD. Si un nodo falla durante la ejecución, PySpark reconstruye la partición RDD perdida utilizando esa información de seguimiento. Por lo tanto, el riesgo de pérdida de datos es mínimo.

- Procesamiento en memoria: PySpark almacena los datos intermedios en la memoria, lo que reduce la necesidad de operaciones en el disco y, a su vez, mejora el rendimiento del procesamiento de datos.

- Transmisión y procesamiento en tiempo real: Podemos aprovechar el componente Spark Streaming para procesar flujos de datos en tiempo real y realizar análisis casi en tiempo real.

¿Por qué es tan útil aprender PySpark?

El volumen de datos no deja de aumentar. Hoy en día, las tareas de gestión de datos, análisis de datos y machine learning implican trabajar con grandes cantidades de datos. Necesitamos utilizar herramientas potentes que procesen esos datos de manera eficiente y rápida. PySpark es una de esas herramientas.

PySpark tiene una gran variedad de aplicaciones.

Ya hemos mencionado las ventajas de PySpark, pero veamos algunos ejemplos concretos en los que puedes utilizarlas:

- Data ETL. La capacidad de PySpark para limpiar y transformar datos de forma eficiente se utiliza para procesar datos de sensores y registros de producción en los ámbitos de la fabricación y la logística.

- Machine learning. La biblioteca MLlib se utiliza para desarrollar e implementar modelos para recomendaciones personalizadas, segmentación de clientes y previsión de ventas en el comercio electrónico.

- Procesamiento de gráficos. Los GraphFrames de PySpark se utilizan para analizar redes sociales y comprender las relaciones entre los usuarios.

- Procesamiento de flujos. La API de streaming estructurado de PySpark permite el procesamiento en tiempo real de transacciones financieras para detectar fraudes.

- Procesamiento de datos SQL. La interfaz SQL de PySpark facilita a los investigadores y analistas del sector sanitario la consulta y el análisis de grandes conjuntos de datos genómicos.

Existe demanda de habilidades en PySpark.

Con el auge de la ciencia de datos y machine learning, y el aumento de los datos disponibles, existe una gran demanda de profesionales con habilidades para la manipulación de datos. Según el informe «The State of Data & AI Literacy Report 2024», el 80 % de los líderes valoran las habilidades de análisis y manipulación de datos.

Aprender PySpark puede abrirte un amplio abanico de oportunidades profesionales. Más de 800 ofertas de empleo en Indeed, desde ingenieros de datos hasta científicos de datos, ponen de relieve la demanda de conocimientos de PySpark en ofertas de trabajo relacionadas con los datos.

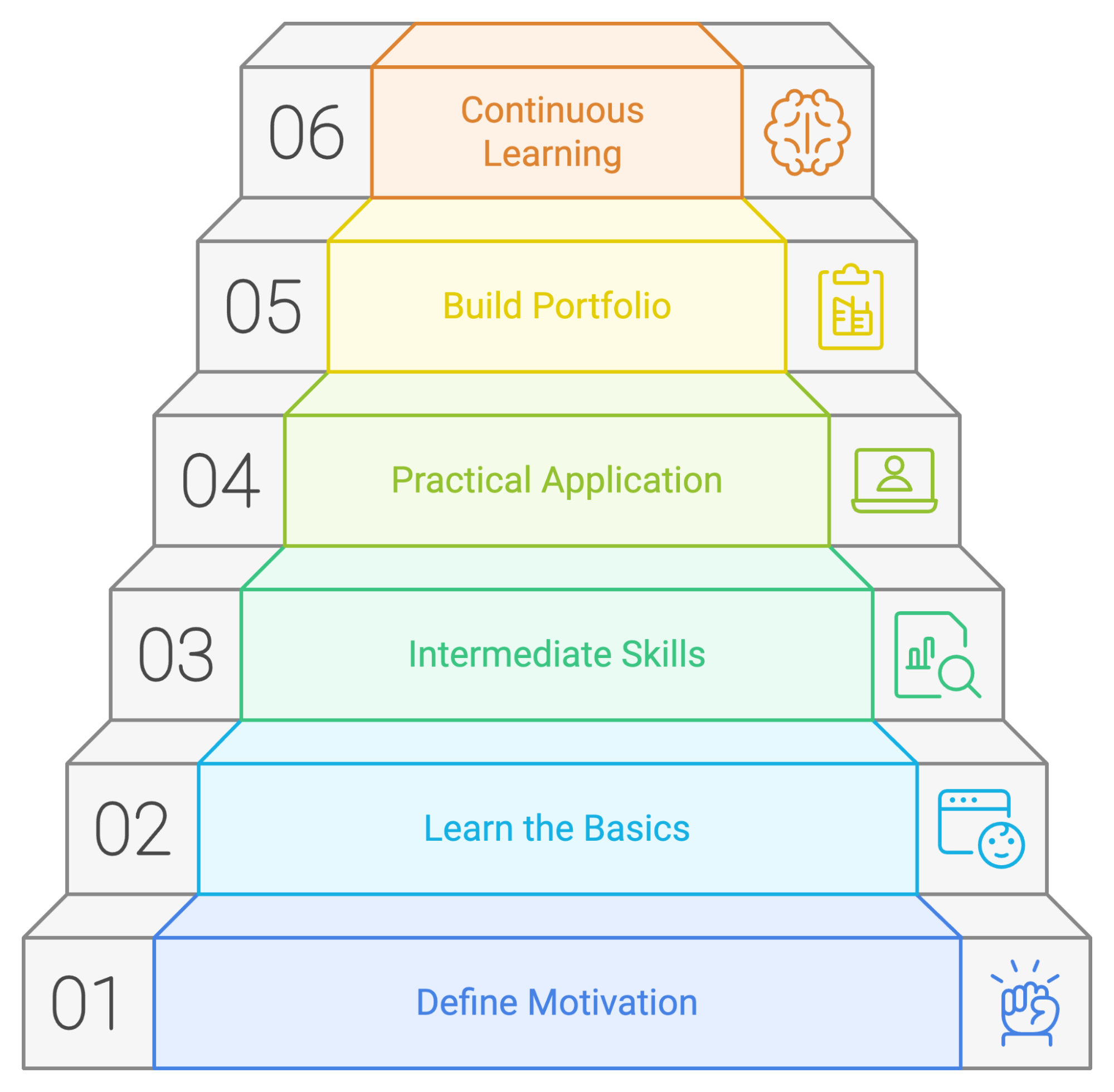

Cómo aprender PySpark desde cero en 2026

Si aprendes PySpark de forma metódica, tendrás más posibilidades de éxito. Centrémonos en algunos principios que puedes utilizar en tu proceso de aprendizaje.

1. Comprende por qué estás aprendiendo PySpark.

Antes de aprender los detalles técnicos, define tu motivación para aprender PySpark. Pregúntate a ti mismo:

- ¿Cuáles son tus objetivos profesionales?

- ¿Es PySpark una habilidad que necesitas para avanzar en tu puesto actual o conseguir el trabajo de tus sueños?

- ¿Qué oportunidades esperas que se te abran si dominas PySpark?

- ¿Qué problemas estoy tratando de resolver?

- ¿Tienes dificultades para procesar grandes conjuntos de datos que las herramientas actuales que conoces no pueden manejar?

- ¿Necesitas realizar transformaciones de datos complejas o crear modelos avanzados de machine learning?

- ¿Qué me interesa?

- ¿Te entusiasma la idea de crear canales de datos escalables?

- ¿Te interesa el big data y su potencial para descubrir nuevos conocimientos?

- ¿Tienes en mente algún proyecto específico que requiera las capacidades de PySpark?

- ¿Estás trabajando en un proyecto personal que implica el procesamiento o análisis de datos a gran escala?

- ¿Tu empresa necesita experiencia en PySpark para un próximo proyecto?

2. Comienza con los conceptos básicos de PySpark.

Una vez identificados tus objetivos, domina los conceptos básicos de PySpark y comprende cómo funcionan.

Fundamentos de Python

Dado que PySpark se basa en Python, debes familiarizarte con Python antes de utilizar PySpark. Debes sentirte cómodo trabajando con variables y funciones. Además, puede ser una buena idea familiarizarse con bibliotecas de manipulación de datos como Pandas. Curso de introducción a Python de DataCamp Introducción a Python y Manipulación de datos con Pandas pueden ayudarte a ponerte al día.

Instalación de PySpark y aprendizaje de los conceptos básicos

Debes instalar PySpark para empezar a utilizarlo. Puedes descargar PySpark utilizando pip o Conda, descargarlo manualmente desde el sitio web oficial o empezar con DataLab para empezar a utilizar PySpark en tu navegador.

Si deseas obtener una explicación detallada sobre cómo configurar PySpark, consulta esta guía sobre cómo instalar PySpark en Windows, Mac y Linux.

PySpark DataFrames

El primer concepto que debes aprender es cómo funcionan los DataFrame de PySpark. Son una de las razones principales por las que PySpark funciona de forma tan rápida y eficiente. Comprender cómo crearlos, transformarlos (mapearlos y filtrarlos) y manipularlos. El tutorial sobre cómo empezar a trabajar con PySpark te ayudará con estos conceptos.

3. Domina las habilidades intermedias de PySpark

Una vez que te sientas cómodo con los conceptos básicos, es hora de explorar las habilidades intermedias de PySpark.

Spark SQL

Una de las mayores ventajas de PySpark es su capacidad para realizar consultas similares a SQL para leer y manipular DataFrame, realizar agregaciones y utilizar funciones de ventana. Entre bastidores, PySpark utiliza Spark SQL. Esta introducción a Spark SQL en Python puede ayudarte a adquirir esta habilidad.

Recopilación y transformación de datos

Trabajar con datos implica dominar las tareas de limpieza, transformación y preparación de los mismos para su análisis. Esto incluye gestionar valores perdidos, administrar diferentes tipos de datos y realizar agregaciones utilizando PySpark. Toma el Curso de limpieza de datos con PySpark de DataCamp para adquirir experiencia práctica y dominar estas habilidades.

Machine learning con MLlib

PySpark también se puede utilizar para desarrollar e implementar modelos de machine learning, gracias a tu biblioteca MLlib. Debes aprender a realizar ingeniería de características, evaluación de modelos y ajuste de hiperparámetros utilizando esta biblioteca. DataCamp's Machine learning con PySpark ofrece una introducción completa.

4. Aprende PySpark practicando

Realizar cursos y practicar ejercicios con PySpark es una forma excelente de familiarizarse con la tecnología. Sin embargo, para dominar PySpark, es necesario resolver problemas desafiantes y que permitan desarrollar habilidades, como los que se encuentran en proyectos del mundo real. Puedes empezar realizando tareas sencillas de análisis de datos y pasar gradualmente a retos más complejos.

Aquí tienes algunas formas de practicar tus habilidades:

- Participa en seminarios web y sesiones de programación conjunta. Consulta los los próximos seminarios web de DataCamp y eventos en línea de DataCamp, donde podrás seguir tutoriales y ejemplos de código de PySpark. Esto te ayudará a reforzar tu comprensión de los conceptos y a familiarizarte con los patrones de codificación.

- Desarrolla proyectos independientes. Identifica los conjuntos de datos que te interesen y aplica tus conocimientos de PySpark para analizarlos. Esto podría implicar desde analizar las tendencias en las redes sociales hasta explorar los datos de los mercados financieros.

- Contribuye a proyectos de código abierto. Contribuye a proyectos PySpark en plataformas como GitHub para adquirir experiencia colaborando con otras personas y trabajando en proyectos reales.

- Crea un blog personal. Escribe sobre tus proyectos PySpark, comparte tus conocimientos y contribuye a la comunidad PySpark creando un blog personal.

5. Crea un portafolio de proyectos.

A medida que avances en tu aprendizaje de PySpark, completarás diferentes proyectos. Para mostrar tus habilidades y experiencia en PySpark a posibles empleadores, debes recopilarlas en un portafolio. Este portafolio debe reflejar tus habilidades e intereses y estar adaptado a la carrera o industria que te interesa.

Intenta que tus proyectos sean originales y demuestren tu capacidad para resolver problemas. Incluye proyectos que demuestren tu dominio de diversos aspectos de PySpark, como el manejo de datos, machine learning y la visualización de datos. Documenta tus proyectos, proporcionando contexto, metodología, código y resultados. Puedes utilizar DataLab, un IDE en línea que te permite escribir código, analizar datos de forma colaborativa y compartir tus conocimientos.

Aquí tienes dos proyectos PySpark en los que puedes trabajar:

- Limpieza de un conjunto de datos de pedidos con PySpark

- Creación de un modelo de previsión de la demanda

6. Sigue desafiándote a ti mismo.

Aprender PySpark es un proceso continuo. La tecnología evoluciona constantemente y se desarrollan nuevas funciones y aplicaciones con regularidad. PySpark no es una excepción.

Una vez que domines los fundamentos, podrás buscar tareas y proyectos más desafiantes, como la optimización del rendimiento o GraphX. Céntrate en tus objetivos y especialízate en áreas que sean relevantes para tus metas profesionales y tus intereses.

Mantente al día de las últimas novedades y aprende a aplicarlas a tus proyectos actuales. Sigue practicando, busca nuevos retos y oportunidades, y acepta la idea de cometer errores como una forma de aprender.

Recapitulemos los pasos que podemos seguir para elaborar un plan de aprendizaje de PySpark satisfactorio:

Un ejemplo de plan de aprendizaje de PySpark

Aunque cada persona tiene su propia forma de aprender, siempre es buena idea contar con un plan o una guía que seguir para aprender a utilizar una nueva herramienta. Hemos creado un posible plan de aprendizaje en el que se describe dónde debes centrar tu tiempo y tus esfuerzos si acabas de empezar con PySpark.

Mes 1: Fundamentos de PySpark

- Conceptos básicos. Instala PySpark y explora su sintaxis. Comprender los conceptos básicos de Apache Spark, su arquitectura y cómo permite el procesamiento distribuido de datos.

- Conceptos básicos de PySpark. Aprende a configurar tu entorno PySpark, crear SparkContexts y SparkSessions, y explorar estructuras de datos básicas como RDD y DataFrame.

- Manipulación de datos. Domina las operaciones esenciales de PySpark para la manipulación de datos, incluyendo el filtrado, la clasificación, la agrupación, la agregación y la unión de conjuntos de datos. Puedes completar las proyecto Cleaning Orders with PySpark.

Mes 2: PySpark para el análisis de datos y SQL

- Trabajar con diferentes formatos de datos: Aprende a leer y escribir datos en varios formatos, incluidos CSV, JSON, Parquet y Avro, utilizando PySpark.

- Spark SQL. Aprende a usar Spark SQL para consultar y analizar datos con la sintaxis SQL que ya conoces. Explora conceptos como DataFrame, conjuntos de datos y funciones SQL.

- Visualización de datos e ingeniería de características: Explora las técnicas de visualización de datos en PySpark utilizando bibliotecas como Matplotlib y Seaborn para obtener información valiosa a partir de tus datos. Aprende a manejar datos y realizar ingeniería de características con el curso curso Ingeniería de características con PySpark.

Mes 3-4: PySpark para machine learning y temas avanzados

- Introducción a MLlib: Empieza a utilizar la biblioteca MLlib de PySpark para machine learning. Explora los algoritmos básicos para la clasificación, la regresión y la agrupación. Puedes utilizar el curso machine learning con PySpark.

- Creación de canalizaciones de ML. Aprende a crear e implementar canalizaciones de machine learning en PySpark para entrenar y evaluar modelos de forma eficiente.

- Desarrolla un proyecto. Trabajar en el desarrollo de un modelo de previsión de la demanda.

- Conceptos avanzados. Explora técnicas para optimizar aplicaciones PySpark, incluyendo partición de datos, almacenamiento en caché y ajuste del rendimiento.

Cinco consejos para aprender PySpark

Imagino que a estas alturas ya estás listo para lanzarte a aprender PySpark y poner en práctica tus nuevos conocimientos con un gran conjunto de datos. Pero antes de hacerlo, permíteme destacar estos consejos que te ayudarán a recorrer el camino hacia el dominio de PySpark.

1. Reduce tu ámbito de búsqueda

PySpark es una herramienta que puede tener muchas aplicaciones diferentes. Para mantener la concentración y alcanzar tu objetivo, debes identificar tu área de interés. ¿Quieres centrarte en el análisis de datos, la ingeniería de datos o machine learning? Adoptar un enfoque específico puede ayudarte a adquirir los aspectos y conocimientos más relevantes de PySpark para la trayectoria que hayas elegido.

2. Practica con frecuencia y constancia.

La constancia es clave para dominar cualquier habilidad nueva. Debes reservar tiempo específico para practicar con PySpark. Solo necesitas dedicarle un poco de tiempo cada día. No es necesario que abordes conceptos complejos todos los días. Puedes repasar lo que has aprendido o volver a realizar un ejercicio sencillo para refactorizarlo. La práctica regular reforzará tu comprensión de los conceptos y aumentará tu confianza a la hora de aplicarlos.

3. Trabaja en proyectos reales

Este es uno de los consejos clave, y lo leerás varias veces en esta guía. Practicar ejercicios es ideal para ganar confianza. Sin embargo, aplicar tus habilidades en PySpark a proyectos del mundo real es lo que te hará destacar en este campo. Busca conjuntos de datos que te interesen y utiliza PySpark para analizarlos, extraer información y resolver problemas.

Empieza con proyectos y preguntas sencillos y ve pasando gradualmente a otros más complejos. Esto puede ser tan sencillo como leer y limpiar un conjunto de datos reales y escribir una consulta compleja para realizar agregaciones y predecir el precio de una casa.

4. Participa en una comunidad

El aprendizaje suele ser más eficaz cuando se realiza de forma colaborativa. Compartir tus experiencias y aprender de los demás puede acelerar tu progreso y proporcionarte información valiosa.

Para intercambiar conocimientos, ideas y preguntas, puedes unirte a algunos grupos relacionados con PySpark y asistir a reuniones y conferencias. La comunidad Databricks, la empresa fundada por los creadores de Spark, cuenta con un foro comunitario muy activo en el que puedes participar en debates y plantear preguntas sobre PySpark. Además, la Spark Summit, organizada por Databricks, es la mayor conferencia sobre Spark.

5. Cometer errores

Al igual que con cualquier otra tecnología, aprender PySpark es un proceso iterativo. Y aprender de tus errores es una parte esencial del proceso de aprendizaje. No tengas miedo de experimentar, prueba diferentes enfoques y aprende de tus errores. Prueba diferentes funciones y alternativas para agregar los datos, realiza subconsultas o consultas anidadas y observa la rápida respuesta que ofrece PySpark.

Las mejores formas de aprender PySpark

Veamos algunos métodos eficaces para aprender PySpark.

Realizar cursos en línea

Los cursos en línea ofrecen una excelente manera de aprender PySpark a tu propio ritmo. DataCamp ofrece cursos de PySpark para todos los niveles, que en conjunto conforman el Big Data con PySpark programa Los cursos abarcan conceptos introductorios sobre temas relacionados con machine learning y están diseñados con ejercicios prácticos.

Estos son algunos de los cursos relacionados con PySpark que se imparten en DataCamp:

- Ingeniería de características con PySpark

- Machine learning con PySpark

- Creación de motores de recomendación con PySpark

- Fundamentos del Big Data con PySpark

Sigue los tutoriales en línea.

Los tutoriales son otra forma estupenda de aprender PySpark, especialmente si eres nuevo en esta tecnología. Contienen instrucciones paso a paso sobre cómo realizar tareas específicas o comprender determinados conceptos. Para empezar, ten en cuenta estos tutoriales:

Echa un vistazo a las hojas de referencia de PySpark.

Las hojas de referencia son útiles cuando necesitas una guía rápida sobre temas relacionados con PySpark. Aquí hay dos hojas de referencia útiles:

- Hoja de referencia de PySpark: Spark en Python

- Hoja de referencia de PySpark: Spark DataFrames in Python

Proyectos completos de PySpark

Para aprender PySpark es necesario practicar. Enfrentar retos mientras completas proyectos que te permitirán aplicar todas las habilidades que has aprendido. A medida que empieces a asumir tareas más complejas, necesitarás encontrar soluciones e investigar nuevas alternativas para obtener los resultados que deseas, lo que te permitirá mejorar tus conocimientos sobre PySpark.

Busca proyectos PySpark en los que trabajar en DataCamp. Esto te permite aplicar tus habilidades de manipulación de datos y creación de modelos de machine learning aprovechando PySpark:

- Limpieza de un conjunto de datos de pedidos con PySpark

- Creación de un modelo de previsión de la demanda

Descubre PySpark a través de libros

Los libros son un recurso excelente para aprender PySpark. Ofrecen conocimientos profundos y opiniones de expertos, junto con fragmentos de código y explicaciones. Estos son algunos de los libros más populares sobre PySpark:

- Aprender PySpark, 2.ª edición, Jules S. Damji

- Libro de recetas de PySpark, Denny Lee

- La chispa para programadores de Python

Empleos en PySpark

La demanda de habilidades en PySpark ha aumentado en varios puestos relacionados con los datos, desde analistas de datos hasta ingenieros de big data. Si te estás preparando para una entrevista, ten en cuenta estas preguntas de entrevista sobre PySpark para

Ingeniero de big data

Como ingeniero de big data, eres el arquitecto de soluciones de big data, responsable de diseñar, construir y mantener la infraestructura que gestiona grandes conjuntos de datos. Utilizarás PySpark para crear canalizaciones de datos escalables, lo que garantizará una ingesta, un procesamiento y un almacenamiento de datos eficientes.

Se requiere un profundo conocimiento de la informática distribuida y las plataformas de nube, así como experiencia en almacenamiento de datos y procesos ETL.

- Habilidades clave:

- Dominio de Python y PySpark, Java y Scala.

- Comprensión de estructuras de datos y algoritmos.

- Dominio tanto de SQL como de nosql.

- Experiencia en procesos ETL y creación de canales de datos.

- Comprensión de los sistemas distribuidos

- Herramientas clave utilizadas:

- Apache Spark, ecosistema Hadoop

- Herramientas de almacenamiento de datos (por ejemplo, Snowflake, Redshift o BigQuery)

- Plataformas en la nube (por ejemplo, AWS, GCP, Databricks)

- Herramientas de coordinación de flujos de trabajo (por ejemplo, Apache Airflow, Apache Kafka)

Certifícate en el puesto de Ingeniero de Datos de tus sueños

Nuestros programas de certificación te ayudan a destacar y a demostrar que tus aptitudes están preparadas para el trabajo a posibles empleadores.

Científico de datos

Como científico de datos, utilizarás las capacidades de PySpark para realizar el procesamiento y la manipulación de datos, así como para desarrollar e implementar modelos de machine learning. Tus conocimientos estadísticos y habilidades de programación te ayudarán a desarrollar modelos que contribuyan al proceso de toma de decisiones.

- Habilidades clave:

- Sólidos conocimientos de Python, PySpark y SQL.

- Comprensión de los conceptos de machine learning e inteligencia artificial.

- Competencia en análisis estadístico, análisis cuantitativo y modelización predictiva

- Técnicas de visualización de datos y elaboración de informes

- Habilidades de comunicación y presentación eficaces

- Herramientas clave utilizadas:

- Herramientas de análisis de datos (por ejemplo, pandas, NumPy)

- Bibliotecas de aprendizaje automático (por ejemplo, Scikit-learn)

- Herramientas de visualización de datos (por ejemplo, Matplotlib, Tableau)

- Marcos de Big Data (por ejemplo, Airflow, Spark)

- Herramientas de línea de comandos (por ejemplo, Git, Bash)

Ingeniero de aprendizaje automático

Como ingeniero de machine learning, utilizarás PySpark para preparar datos, crear modelos de machine learning, y entrenarlos e implementarlos.

- Habilidades clave:

- Dominio de Python, PySpark y SQL.

- Profundo conocimiento de los algoritmos de machine learning.

- Conocimiento de marcos de aprendizaje profundo.

- Comprensión de estructuras de datos, modelado de datos y arquitectura de software

- Herramientas clave utilizadas:

- Bibliotecas y algoritmos de aprendizaje automático (por ejemplo, Scikit-learn, TensorFlow)

- Bibliotecas de ciencia de datos (por ejemplo, Pandas, NumPy)

- Plataformas en la nube (por ejemplo, AWS, Google Cloud Platform)

- Sistemas de control de versiones (por ejemplo, Git)

- Marcos de aprendizaje profundo (por ejemplo, TensorFlow, Keras, PyTorch)

Analista de datos

Como analista de datos, utilizarás PySpark para explorar y analizar grandes conjuntos de datos, identificar tendencias y comunicar tus conclusiones a través de informes y visualizaciones.

- Habilidades clave:

- Dominio de Python, PySpark y SQL.

- Sólidos conocimientos de análisis estadístico.

- Experiencia con herramientas de inteligencia empresarial (por ejemplo, Tableau, Power BI).

- Comprensión de las técnicas de recopilación y limpieza de datos.

- Herramientas clave utilizadas:

- Herramientas de análisis de datos (por ejemplo, pandas, NumPy)

- Herramientas de datos de inteligencia empresarial (por ejemplo, Tableau, Power BI)

- Bases de datos SQL (por ejemplo, MySQL, PostgreSQL)

|

Función |

Lo que haces |

Tus habilidades clave |

Herramientas que utilizas |

|

Ingeniero de Big Data |

Diseña, construye y mantiene la infraestructura para manejar grandes conjuntos de datos. |

Python, PySpark, Java y Scala, estructuras de datos, SQL y nosql, ETL, sistemas distribuidos. |

Apache Spark, Hadoop, herramientas de almacenamiento de datos, plataformas de nube, herramientas de coordinación de flujos de trabajo. |

|

Científico de datos |

Descubre patrones ocultos y extrae información valiosa de los datos. Aplica conocimientos estadísticos y habilidades de programación para crear modelos que ayudan en la toma de decisiones. |

Python, PySpark, SQL, machine learning, conceptos de IA, análisis estadístico, modelado predictivo, visualización de datos, comunicación eficaz. |

Pandas, NumPy, Scikit-learn, Keras, Matplotlib, plotly, Airflow, Spark, Git |

|

Ingeniero de Aprendizaje Automático |

Diseña, desarrolla e implementa sistemas de machine learning para realizar predicciones utilizando datos de la empresa. |

Python, PySpark y SQL, machine learning algoritmalar, aprendizaje profundo, estructuras de datos, modelado de datos y arquitectura de software. |

Scikit-learn, TensorFlow, Keras, PyTorch, Pandas, NumPy, AWS, Google Cloud Platform, Git |

|

Analista de datos |

Acorta la distancia entre los datos brutos y la información empresarial útil. Comunicar los resultados mediante informes y visualizaciones. |

Python, PySpark y SQL, análisis estadístico, visualización de datos, técnicas de recopilación y limpieza de datos. |

Pandas, NumPy, Tableau, PowerBI, MySQL, PostgreSQL. |

Cómo encontrar un trabajo que utilice PySpark o en PySpark

Un título universitario puede ser una gran ventaja a la hora de iniciar una carrera profesional en la que se utilice PySpark, pero no es la única vía posible. Hoy en día, cada vez más profesionales están empezando a trabajar en puestos relacionados con los datos a través de vías alternativas, incluida la transición desde otros campos. Con dedicación, aprendizaje constante y un enfoque proactivo, puedes conseguir el trabajo de tus sueños utilizando PySpark.

Sigue aprendiendo sobre el campo

Mantente al día de las últimas novedades de PySpark. Sigue en las redes sociales a profesionales influyentes relacionados con PySpark, lee blogs sobre PySpark y escucha podcasts relacionados con PySpark.

PySpark fue desarrollado por Matei Zaharia, que también es director técnico de Databricks, una plataforma creada sobre Apache Spark. Obtendrás información sobre temas de actualidad, tecnologías emergentes y la dirección futura de PySpark.

También deberías echar un vistazo a los eventos del sector, ya sean los seminarios web de DataCamp, conferencias sobre ciencia de datos e inteligencia artificialo eventos de networking.

Desarrollar una cartera

Tienes que destacar entre los demás candidatos. Una buena manera de hacerlo es crear una sólida portafolio que muestre tus habilidades y los proyectos que has completado. Puedes causar una buena impresión a los responsables de contratación si abordas retos del mundo real.

Tu portafolio debe contener proyectos diversos que reflejen tu experiencia en PySpark y sus diversas aplicaciones. Consulta esta guía sobre cómo crear un impresionante portafolio de ciencia de datos.

Elaborar un currículum eficaz

En los últimos años, ha habido un aumento en el número de personas que se pasan a la ciencia de datos y a puestos relacionados con los datos. Los responsables de contratación tienen que revisar cientos de currículos y distinguir a los mejores candidatos. Además, en muchas ocasiones, tu currículum pasa por los sistemas de seguimiento de candidatos (ATS), unos programas informáticos automatizados que utilizan muchas empresas para revisar los currículums y descartar aquellos que no cumplen unos criterios específicos. Por lo tanto, debes crear un currículum excelente para impresionar tanto al ATS como a tus reclutadores.

Prepárate para la entrevista.

Si llamas la atención del responsable de contratación o tu currículum eficaz supera el proceso de selección, lo siguiente que debes hacer es prepararte para una entrevista técnica. Para estar preparado, puedes consultar este artículo sobre las preguntas más frecuentes en las entrevistas sobre PySpark.

Conclusión

Aprender PySpark puede abrirte las puertas a mejores oportunidades y resultados profesionales. El camino para aprender PySpark es gratificante, pero requiere constancia y práctica. Experimentar y resolver retos utilizando esta herramienta puede acelerar tu proceso de aprendizaje y proporcionarte ejemplos reales que podrás mostrar cuando busques trabajo.

Preguntas frecuentes

¿Cuáles son las principales características de PySpark?

PySpark proporciona una API de Python fácil de usar para aprovechar Spark, lo que permite velocidad, escalabilidad y compatibilidad con SQL, machine learning y procesamiento de flujos para grandes conjuntos de datos.

¿Por qué está creciendo la demanda de habilidades en PySpark?

La facilidad de uso, la escalabilidad y la versatilidad de PySpark para el procesamiento de big data y machine learning están impulsando la creciente demanda de estas habilidades.

¿Cuáles son los puntos clave a tener en cuenta para aprender PySpark?

Céntrate en los fundamentos de Python, los conceptos básicos de Spark y las técnicas de manipulación de datos, y explora temas avanzados como Spark SQL y MLlib.

¿Cuáles son algunas formas de aprender PySpark?

Realiza cursos en línea y sigue tutoriales, trabaja con conjuntos de datos reales, utiliza hojas de referencia y descubre PySpark a través de libros.

¿Cuáles son algunas de las funciones que utilizan PySpark?

Algunas de las funciones que utilizan PySpark son: ingeniero de big data, ingeniero de machine learning, científico de datos y analista de datos.