Cursus

J'ai récemment conclu un contrat avec une entreprise spécialisée dans l'intelligence artificielle. Entre autres, ils assistent les chercheurs dans le post-entraînement des LLM. En tant que docteur en mathématiques, j'ai élaboré des problèmes mathématiques qui ont posé des difficultés aux modèles d'IA de pointe. Les astuces ne comptaient pas ; les questions devaient mettre en évidence les erreurs de raisonnement.

Au cours de ce travail, j'ai entendu à plusieurs reprises des références au « dernier examen de l'humanité ». J'ai appris qu'il s'agissait d'un test de référence en matière d'intelligence artificielle conçu pour évaluer le raisonnement dans de nombreux domaines universitaires. Ma curiosité m'a incité à approfondir mes recherches sur ce qu'est le HLE et ce qu'il nous apprend sur les limites actuelles du raisonnement de l'IA.

Si vous débutez dans le domaine de l'IA et du benchmarking, je vous recommande de suivre le cursus de compétences « Principes fondamentaux de l'IA ».

Qu'est-ce que « le dernier examen de l'humanité » ?

À mesure que les LLM ont évolué, les chercheurs se sont appuyés sur des collections de questions d'évaluation, appelées benchmarks, pour comparer les performances et suivre le cursus. Le dernier examen de l'humanité (HLE) est un test de référence conçu pour mesurer les capacités d' sraisonnement d'un LLM , et pas seulement sa capacité à reconnaître des modèles. Il vise à évaluer la capacité d'un modèle à traiter des problèmes de niveau expert dans de nombreux domaines académiques.

Pourquoi avons-nous besoin d'un « dernier examen » ?

Étant donné le nombre important de benchmarks déjà disponibles, pourquoi en créer un nouveau ? Les benchmarks qui représentaient autrefois un défi pour les LLM, tels que le MMLU, sont désormais saturés, les modèles obtenant souvent des scores supérieurs à 90 %. À ce stade, ces tests de performance cessent de mesurer des différences significatives entre les modèles.

HLE est un test de référence de nouvelle génération qui augmente le niveau de difficulté en rassemblant des questions élaborées par des experts qui nécessitent un raisonnement en plusieurs étapes, et non pas simplement la mémorisation de correspondances superficielles.

Comment HLE a-t-il été développé ?

À la fin de l'année 2024, le Centre for AI Safety, une organisation à but non lucratif dédiée à la sécurité de l'IA, s'est associé à Scale AI, une entreprise spécialisée dans les données, afin de développer un benchmark plus exigeant pour l'IA. Monsieur Dan Hendrycks a dirigé le projet.

L'équipe a recueilli des questions de niveau universitaire dans plusieurs disciplines académiques et a offert des prix importants : les 50 meilleurs contributeurs ont chacun gagné 5 000 dollars, et les 500 suivants ont reçu 500 dollars.

Le résultat a été un vaste ensemble de questions de niveau expert couvrant de nombreux sujets, tels que les mathématiques, l'informatique, la littérature, l'analyse musicale et l'histoire.

Quels sont les éléments inclus dans le dernier examen de l'humanité ?

Le document HLE décrit le benchmark comme « ...le benchmark définitif et fermé pour les compétences académiques générales ». Ses questions nécessitent un raisonnement en plusieurs étapes, ce qui empêche les modèles de deviner ou de mémoriser les réponses.

HLE comprend 2 500 questions publiques et environ 500 questions supplémentaires dans un ensemble privé.

Chaque question doit être originale, avoir une seule réponse correcte et ne pas pouvoir être trouvée facilement par une simple recherche sur Internet ou dans une base de données. Environ 76 % des questions utilisent le format de réponse à correspondance exacte et les 24 % restants utilisent le format à choix multiples. Environ 14 % des questions sont multimodales, impliquant à la fois du texte et des images.

L'équipe HLE a appliqué un processus de vérification rigoureux pour les questions.

- Pour être acceptées, les questions devaient poser un défi à un LLM de premier plan. Environ soixante-dix mille questions répondaient à ce critère.

- Des pairs experts ont affiné et filtré le total pour aboutir à treize mille questions.

- Les organisateurs et les experts ont approuvé manuellement six mille de ces questions.

- Les chercheurs ont divisé cet ensemble de questions en deux groupes : un ensemble public de 2 500 questions et un ensemble réservé d'environ 500 questions.

Critiques de l'examen final de l'humanité

Les premiers résultats ont montré que les modèles pionniers ont initialement obtenu de faibles scores aux questions, tout en exprimant un niveau de confiance élevé. Cet écart indique la présence d'hallucinations.

Des groupes indépendants ont également exprimé leurs préoccupations. Future House, un laboratoire de recherche à but non lucratif, a publié un article de blog intitulé « Environ 30 % des réponses aux examens finaux de chimie/biologie de l'humanité sont probablement erronées ».

Leur analyse s'est concentrée sur le protocole d'examen. Les auteurs des questions ont affirmé que les réponses étaient correctes, mais les évaluateurs ont reçu pour instruction de ne consacrer que cinq minutes à la vérification de l'exactitude des réponses. Ils affirment que ce processus permet à des réponses trop complexes, artificielles ou ambiguës de passer entre les mailles du filet, ce qui est souvent en contradiction avec la littérature scientifique.

Les responsables de HLE ont répondu à cette publication en commandant une expertise menée par trois experts sur le sous-ensemble litigieux. Le 16 septembre 2025, ils prévoyaient d'annoncer un processus de révision continue à HLE.

Le paysage des benchmarks en matière d'intelligence artificielle

HLE s'inscrit dans un écosystème plus large de benchmarks qui évaluent différents aspects des capacités des LLM.

Connaissances et raisonnement

Ces critères d'évaluation évaluent les connaissances académiques et le raisonnement.

- Compréhension linguistique multitâche à grande échelle (MMLU). MMLU évalue les performances en mode zero-shot sur cinquante-sept sujets différents.

- MMLU-Pro/MMLU Pro+. Complexité accrue des questions et accent mis sur le raisonnement de haut niveau.

- Questions-réponses Google Proof (GPQA) Un test de référence en sciences, technologie, ingénierie et mathématiques (STEM) de niveau universitaire, comprenant 448 questions à choix multiples.

- Le dernier examen de l'humanité (HLE). HLE utilise des problèmes sélectionnés par des experts qui mettent l'accent sur le raisonnement plutôt que sur la mémorisation.

Compréhension multimodale

Ces critères évaluent le raisonnement impliquant à la fois du texte et des images.

- La Massive Multi-discipline Multimodal Understanding and Reasoning (MMMU). Environ 1 500 questions multimodales et multidisciplinaires provenant d'examens, de questionnaires et de manuels scolaires.

- Le MMMU-Pro supprime les questions pouvant être résolues par des modèles textuels, ajoute des options de réponse plus robustes et introduit un paramètre exclusivement visuel dans lequel l'intégralité de l'invite est intégrée à une image.

Ingénierie logicielle et utilisation d'outils

D'autres critères se concentrent spécifiquement sur l'ingénierie logicielle et l'utilisation d'outils.

- SWE-bench. Conçu à partir de problèmes GitHub réels provenant de douze référentiels Python. Le modèle analyse le code source, interprète la description du problème et propose un correctif.

- SWE-bench vérifié. Une version améliorée de SWE-bench qui corrige les tests trop spécifiques, clarifie les descriptions de problèmes vagues et stabilise la configuration de l'environnement.

- SWE-bench-Live. Une version évolutive et continuellement mise à jour comprenant 1 319 tâches réparties dans 93 référentiels.

Cadres d'évaluation holistiques et multimétriques

Le Centre de recherche sur les modèles fondamentaux (CRFM) de Stanford a développé une évaluation holistique des modèles linguistiques. Évaluation holistique des modèles linguistiques (HELM) afin de favoriser une évaluation responsable de l'IA.

HELM évalue les modèles à l'aide d'une série de scénarios standardisés, tels que la réponse à des questions, la synthèse, les requêtes critiques en matière de sécurité et le contenu social/éthique. Ces scénarios sont évalués selon plusieurs critères, non seulement la précision, mais également l'étalonnage, la robustesse et la toxicité.

HELM s'est développé pour devenir une famille de cadres connexes.

- Capacités HEML. Un classement général pour l'évaluation des modèles linguistiques.

- Audio. Évaluations pour les tâches liées à l'audio et à la parole.

- HELM Lite. Un sous-ensemble plus petit et plus rapide pour des comparaisons rapides.

- HELM Finance. HELM adapté aux tâches financières.

- MedHELM. Évaluations relatives au raisonnement et à la sécurité dans le domaine des soins de santé.

Évaluations de la sécurité et des risques potentiels

Les cadres de sécurité évaluent le risque plutôt que les compétences intellectuelles.

- Évaluation des modèles et recherche sur les menaces (METR) est un organisme de recherche à but non lucratif qui évalue les capacités potentiellement dangereuses, telles que les cyberattaques, les tentatives d'éviter les arrêts de service ou la capacité à automatiser la recherche et le développement en matière d'intelligence artificielle. Sa mission consiste à détecter rapidement les risques catastrophiques.

- Cadre de sécurité Frontier de Google DeepMind. Définit les niveaux de capacité critiques (NCC), surveille si les modèles de pointe s'en approchent et met en œuvre des plans d'atténuation lorsque c'est le cas.

Où se situent les modèles d'IA actuels dans les benchmarks d'IA ?

De nombreux classements publics évaluent les performances des LLM à l'aide de divers indicateurs.

- Classement LLM. Comprend des classements pour le comportement proactif, la sécurité et les performances de pointe selon des critères standardisés.

- Statistiques LLM. Couvre la génération d'images, la génération de vidéos, la synthèse vocale, la reconnaissance vocale et les intégrations.

- Vellum LLM Leaderboard. Se concentre sur le raisonnement et le codage.

- Artificial Analysis.AI LM Leaderboard. Classe les modèles en fonction de leur intelligence, de leur prix, de leur vitesse et de leur latence.

- Classement Hugging Face Open LLM. Comprend les résultats détaillés pour divers modèles.

Classements

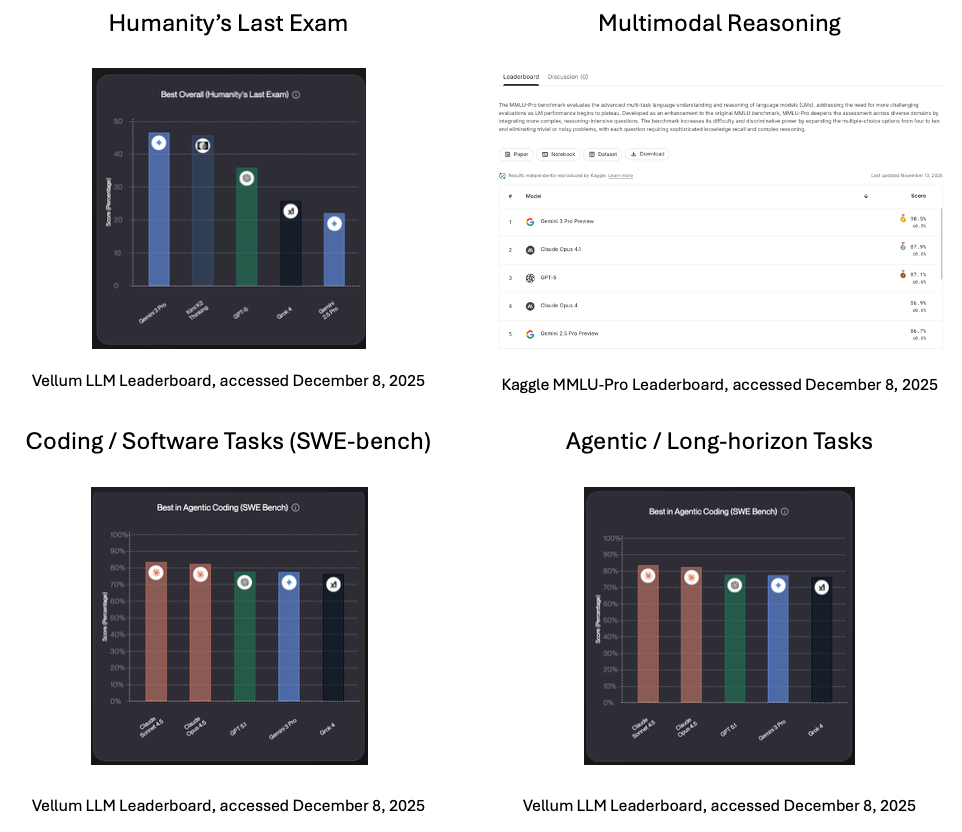

Voici quelques résultats au moment de la rédaction de cet article, en décembre 2025.

- Le dernier examen de l'humanité. Selon le classement Vellum, le leader actuel (au moment de la rédaction de cet article) est Gemini 3 Pro, le modèle d'IA multimodal génératif phare de Google.

- s de raisonnement multimodal. Gemini 3 Pro, conçu pour unifier les modalités en un seul système, est en tête du classement Kaggle MMLU-Pro en matière de raisonnement multimodal.

- Tâches de codage / logiciels (SWE-bench). Selon le classement Vellum, Claude Sonnet 4.5 d'Anthopic , qui privilégie un raisonnement rigoureux, occupe la première place dans les tâches de codage et de développement logiciel dans le monde réel.

- Tâches agentives / à long terme. Claude Sonnet 4.5 est également en tête dans les tâches agentives et à long terme, selon le classement Vellum.

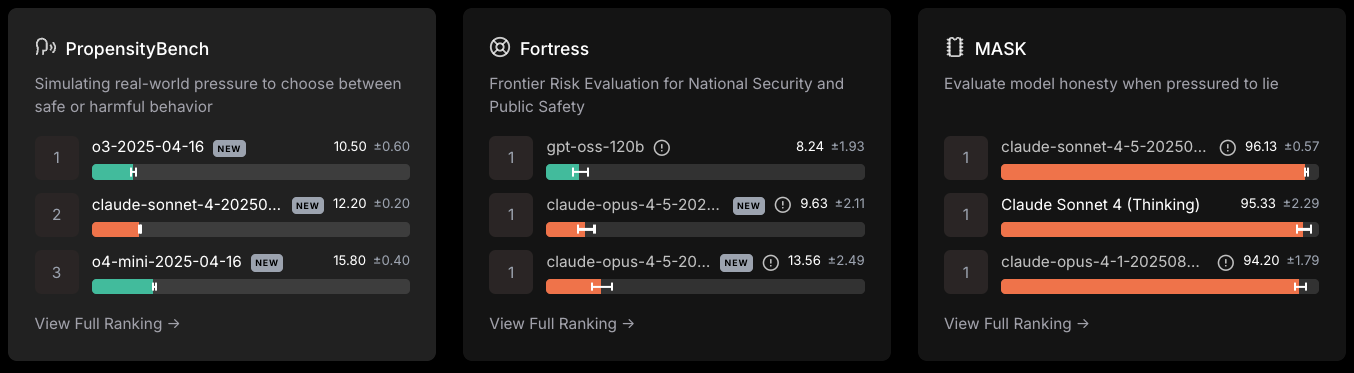

Sécurité/risques potentiels

Classement des leaders en matière de sécurité LLM, consulté le 8 décembre 2025

- Open AI a publié le 18 avril 2024 a mené le PropensityBench, qui mesure le choix entre un comportement sûr ou dangereux.

- Le GPT-oss-120b a dirigé dans l'évaluation des risques frontaliers pour la sécurité nationale et la sécurité publique.

- Sonnet de Caude-4 .5 a résisté à la pression de mentir.

Comment est utilisé le dernier examen de l'humanité

Jusqu'à présent, j'ai présenté ce qu'est le HLE et comment il a été développé. Examinons maintenant comment le test est utilisé dans la pratique.

Pour les équipes de recherche

HLE fournit une méthode d'évaluation standardisée dans tous les domaines. Il met en évidence les points forts et les points faibles d'un modèle. Il met en évidence l'écart entre ses performances et celles d'un expert humain. Les équipes peuvent utiliser ces modèles pour orienter le développement de modèles et cibler la formation post-formation.

À l'intention des décideurs politiques

HLE fournit un indicateur public et mondial des progrès réalisés en matière de raisonnement artificiel. Il établit un point de référence commun à tous les pays et organismes de réglementation et permet d'ancrer les discussions sur les seuils, la surveillance et la gouvernance dans la réalité, et non dans le battage médiatique.

Conclusion

Les critères de référence en matière d'IA déterminent la manière dont nous évaluons les progrès réalisés dans ce domaine. Les benchmarks précédents ayant atteint leur limite, le besoin d'un nouveau benchmark, axé sur le raisonnement et non plus uniquement sur la mémorisation ou la reconnaissance de formes, est devenu évident.

Humanity's Last Exam tente de combler cette lacune en recueillant des questions de niveau universitaire auprès d'experts du monde entier afin de mettre en évidence les limites des modèles linguistiques à grande échelle (LLM). Ce n'est pas le dernier mot, mais cela clarifie la position actuelle de l'IA par rapport au raisonnement des experts humains.

Pour plus d'informations sur les LLM et leur fonctionnement, je vous recommande les ressources suivantes :

FAQ sur le dernier examen de l'humanité

Qu'est-ce que le dernier examen de l'humanité (HLE) ?

Il s'agit d'un test de référence conçu pour évaluer la capacité d'un LLM à raisonner à l'aide de questions académiques fermées de niveau expert dans de nombreuses disciplines.

Pourquoi les chercheurs ont-ils créé le HLE ?

Les benchmarks antérieurs sont devenus trop faciles pour les modèles de pointe. HLE augmente la difficulté afin que les chercheurs puissent mesurer les progrès réalisés en matière de raisonnement.

Quels types de questions trouve-t-on dans le HLE ?

Le HLE comprend des questions issues d'un large éventail de disciplines, notamment les mathématiques, l'informatique, l'histoire et l'analyse musicale.

Qui a créé HLE ?

Dan Hendrycks, du Centre pour la sécurité de l'IA, a dirigé l'équipe. Ils ont établi un partenariat avec Scale AI.

Comment les chercheurs utilisent-ils le HLE ?

Ils comparent les modèles, suivent les améliorations au fil du temps, identifient les domaines faibles et mesurent l'écart entre l'IA et l'expertise humaine.

Mark Pedigo, PhD, est un éminent scientifique des données, spécialisé dans la science des données de santé, la programmation et l'éducation. Titulaire d'un doctorat en mathématiques, d'une licence en informatique et d'un certificat professionnel en intelligence artificielle, Mark allie connaissances techniques et résolution de problèmes pratiques. Au cours de sa carrière, il a joué un rôle dans la détection des fraudes, la prédiction de la mortalité infantile et les prévisions financières, et a contribué au logiciel d'estimation des coûts de la NASA. En tant qu'éducateur, il a enseigné à DataCamp et à l'université Washington de St. Louis et a encadré des programmeurs juniors. Pendant son temps libre, Mark profite de la nature du Minnesota avec sa femme Mandy et son chien Harley, et joue du piano jazz.