Programa

Acabei de fechar um contrato com uma empresa de inteligência artificial. Entre outras coisas, eles ajudam os pesquisadores a treinar LLMs. Como doutor em matemática, criei problemas matemáticos que deixaram os modelos de IA mais avançados sem saber o que fazer. As dicas não valiam; as dicas tinham que mostrar os erros de raciocínio.

Durante esse trabalho, ouvi várias referências ao “Último Exame da Humanidade”. Descobri que era um benchmark de IA feito pra testar o raciocínio em várias áreas acadêmicas. Minha curiosidade me levou a pesquisar mais sobre o que é HLE e o que isso nos diz sobre os limites atuais do raciocínio da IA.

Se você é novo no mundo da IA e do benchmarking, recomendo fazer o programa de habilidades Fundamentos de IA.

O que é a “Última Prova da Humanidade”?

Com o avanço dos LLMs, os pesquisadores usam conjuntos de perguntas de avaliação, conhecidos como benchmarks, para comparar o desempenho e acompanhar o progresso. O Último Exame da Humanidade (HLE ) é um benchmark feito pra medir as habilidades de raciocínio e de correspondência de padrões de um LLM , não só a capacidade dele de fazer a correspondência de padrões. O objetivo é ver como um modelo lida com problemas de nível avançado em várias áreas acadêmicas.

Por que precisamos de uma “última prova”?

Com tantos benchmarks já existentes, por que criar mais um? Os benchmarks que antes desafiavam os LLMs, como o MMLU, agora estão saturados, com modelos frequentemente obtendo pontuações acima de 90%. Nesse ponto, esses benchmarks deixam de medir diferenças significativas entre os modelos.

O HLE é um padrão de referência de última geração que aumenta o nível de dificuldade ao reunir perguntas elaboradas por especialistas que exigem raciocínio em várias etapas, e não apenas a memorização de padrões superficiais.

Como o HLE foi desenvolvido?

No final de 2024, o Centro para a Segurança da IA, uma organização sem fins lucrativos dedicada à segurança da IA, fez uma parceria com a Scale AI, uma empresa de dados, para desenvolver um benchmark de IA mais difícil. Dan Hendrycks comandou o projeto.

A equipe fez um crowdsourcing de perguntas de nível de pós-graduação de várias disciplinas acadêmicas e ofereceu prêmios bem legais: os 50 melhores colaboradores ganharam US$ 5.000 cada, e os 500 seguintes ganharam US$ 500.

O resultado foi um grande conjunto de perguntas de nível especializado em várias disciplinas, como matemática, ciência da computação, literatura, análise musical e história.

O que está incluído no último exame da humanidade?

O documento da HLE descreve o benchmark como "... o benchmark final fechado para habilidades acadêmicas gerais." As perguntas exigem um raciocínio em várias etapas, o que impede que os modelos adivinhem ou memorizem as respostas.

O HLE tem 2.500 perguntas públicas e mais ou menos 500 perguntas adicionais num conjunto privado.

Cada pergunta precisa ser original, ter só uma resposta certa e não ser fácil de achar numa busca rápida na internet ou num banco de dados. Cerca de 76% das perguntas usam o formato de resposta de correspondência exata e os 24% restantes usam múltipla escolha. Mais ou menos 14% das perguntas são multimodais, envolvendo tanto texto quanto imagens.

A equipe da HLE tinha um processo de verificação bem rigoroso para as perguntas.

- Pra ser aceita, as perguntas tinham que ser difíceis pra um LLM pioneiro. Cerca de setenta mil perguntas preencheram esse critério.

- Os revisores especializados refinaram e filtraram o total para treze mil perguntas.

- Os organizadores e revisores especialistas aprovaram manualmente seis mil dessas perguntas.

- Os pesquisadores dividiram esse conjunto de perguntas em um conjunto público de 2.500 perguntas e um conjunto reservado de aproximadamente 500 perguntas.

Críticas ao último exame da humanidade

Os primeiros resultados mostraram que os modelos pioneiros inicialmente tiveram notas baixas nas perguntas, mas mostraram muita confiança. Essa diferença indica alucinações.

Grupos independentes também mostraram preocupação. A Future House, um laboratório de pesquisa sem fins lucrativos, publicou um blog intitulado “Cerca de 30% das respostas da última prova de química/biologia da humanidade provavelmente estão erradas”.

A análise deles focou no protocolo de revisão. Os autores das perguntas afirmaram que as respostas estavam corretas, mas os revisores foram instruídos a dedicar apenas cinco minutos à revisão da correção das respostas. Eles dizem que esse processo deixa passar respostas muito complicadas, forçadas ou confusas, que muitas vezes não batem com o que a literatura científica diz.

Os responsáveis pela manutenção do HLE responderam à publicação encomendando uma revisão por três especialistas do subconjunto em disputa. A partir de 16 de setembro de 2025, eles planejaram anunciar um processo de revisão contínua para a HLE.

O panorama dos benchmarks de IA

O HLE faz parte de um ecossistema mais amplo de benchmarks que testam diferentes aspectos da capacidade do LLM.

Conhecimento e raciocínio

Esses padrões de referência avaliam o conhecimento acadêmico e o raciocínio.

- Compreensão de linguagem multitarefa massiva (MMLU). O MMLU testa o desempenho zero-shot em cinquenta e sete assuntos diferentes.

- MMLU-Pro/MMLU Pro+. Maior complexidade das questões e foco no raciocínio de nível superior.

- Perguntas e respostas à prova do Google (GPQA) Um teste de referência em STEM, à prova do Google, com 448 perguntas de múltipla escolha.

- Último Exame da Humanidade (HLE). O HLE usa problemas selecionados por especialistas que dão mais ênfase ao raciocínio do que à memorização.

Compreensão multimodal

Esses benchmarks medem o raciocínio que envolve tanto texto quanto imagens.

- A Compreensão e Raciocínio Multidisciplinar e Multimodal em Massa (MMMU). Cerca de 1.500 perguntas multimodais e multidisciplinares tiradas de exames, questionários e livros didáticos.

- O MMMU-Pro remove perguntas que podem ser resolvidas só com modelos de texto, adiciona opções de resposta mais robustas e traz uma configuração só de visão, onde toda a solicitação é colocada dentro de uma imagem.

Engenharia de software e uso de ferramentas

Outros benchmarks ainda se concentram especificamente em engenharia de software e uso de ferramentas.

- Banco SWE. Feito com base em problemas reais do GitHub de doze repositórios Python. O modelo lê o código-fonte, entende o problema e sugere um patch.

- Verificado pelo SWE-bench. Uma versão melhorada do SWE-bench que corrige testes excessivamente específicos, esclarece descrições vagas de problemas e estabiliza a configuração do ambiente.

- SWE-bench-Live. Uma versão escalável e sempre atualizada com 1319 tarefas em 93 repositórios.

Estruturas de avaliação holísticas e multimétricas

O Centro de Pesquisa em Modelos Fundamentais (CRFM) da Universidade de Stanford desenvolveu Avaliação Holística de Modelos de Linguagem (HELM) para apoiar a avaliação responsável da IA.

O HELM avalia modelos em uma série de cenários padronizados, como resposta a perguntas, resumos, consultas críticas à segurança e conteúdo social/ético. Esses cenários são avaliados em várias dimensões, não só na precisão, mas também na calibração, robustez e toxicidade.

O HELM virou uma família de frameworks relacionados.

- Recursos do HEML. Um quadro de líderes geral para avaliar os LMs.

- Áudio. Avaliações para tarefas relacionadas com áudio e fala.

- HELM Lite. Um subconjunto menor e mais rápido para comparações rápidas.

- HELM Finance. HELM feito sob medida para tarefas financeiras.

- MedHELM. Avaliações para raciocínio e segurança relacionados à saúde.

Avaliações de segurança e capacidade de perigo

As estruturas de segurança medem o risco, e não a competência intelectual.

- Avaliação de Modelos e Pesquisa de Ameaças (METR) é uma organização de pesquisa sem fins lucrativos que avalia recursos potencialmente perigosos, como ataques cibernéticos, tentativas de evitar o desligamento ou a capacidade de automatizar a pesquisa e o desenvolvimento de IA. A missão deles é detectar riscos catastróficos logo de cara.

- Estrutura de segurança de ponta do Google DeepMind. Define os níveis críticos de capacidade (CCLs), fica de olho se os modelos de fronteira estão chegando perto deles e, quando isso acontece, coloca em prática planos de mitigação.

Como os modelos atuais de IA se saem nos benchmarks de IA?

Muitos programas públicos acompanham o desempenho do LLM em várias métricas.

- Classificação LLM. Inclui tabelas de classificação para comportamento proativo, segurança e desempenho de ponta em referências padronizadas.

- Estatísticas do LLM. Aborda geração de imagens, geração de vídeos, conversão de texto em fala, conversão de fala em texto e incorporações.

- Classificação do Vellum LLM. Foca em raciocínio e programação.

- Artificial Análise.AI Classificação LM. Classifica os modelos com base na inteligência, preço, velocidade e latência.

- Classificação Hugging Face Open LLM. Inclui resultados detalhados para vários modelos.

Tabelas de classificação

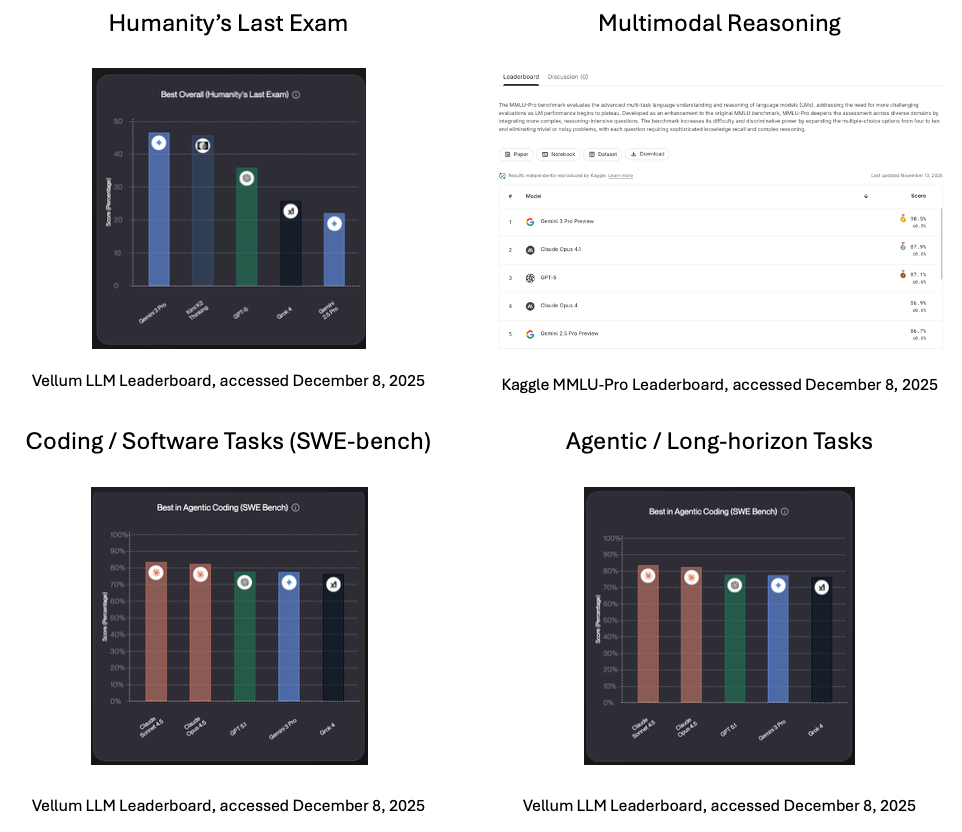

Aqui estão algumas pontuações até o momento em que este artigo foi escrito, em dezembro de 2025.

- O Último Exame da Humanidade. De acordo com o ranking do Vellum, o líder atual (no momento em que este artigo foi escrito) é o Gemini 3 Pro, o principal modelo de IA multimodal generativa do Google.

- Raciocínio multimodal. O Gemini 3 Pro, feito pra juntar várias modalidades num único sistema, tá na frente em raciocínio multimodal, de acordo com o ranking Kaggle MMLU-Pro.

- Tarefas de codificação/software (SWE-bench). O Claude Sonnet 4.5 da Anthopic , que prioriza o raciocínio cuidadoso, ocupa o primeiro lugar em tarefas de codificação e software do mundo real, de acordo com o ranking da Vellum.

- Tarefas de longo prazo/agentes. O Claude Sonnet 4.5 também lidera em tarefas de agência e de longo prazo, de acordo com o ranking da Vellum.

Segurança/capacidades perigosas

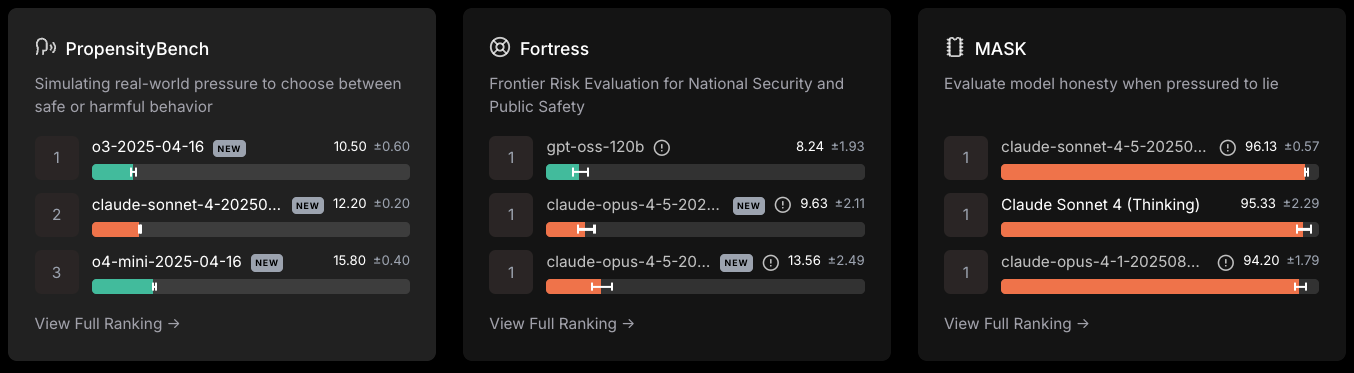

Ranking de segurança da Scale LLM, acessado em 8 de dezembro de 2025

- O o3-2024-04-18 da Open AI liderou o PropensityBench, que mede a escolha entre comportamentos seguros ou prejudiciais.

- O GPT-oss-120b liderou na Avaliação de Riscos de Fronteira para Segurança Nacional e Segurança Pública.

- Soneto Caude-4 .5 mais resistiu à pressão para mentir.

Como o Último Exame da Humanidade é usado

Até agora, eu expliquei o que é HLE e como foi desenvolvido. Vamos agora ver como o teste é usado na prática.

Para equipes de pesquisa

A HLE oferece um método de avaliação padronizado para todos os domínios. Ele mostra os pontos fortes e fracos de um modelo. Isso mostra a diferença entre ele e o desempenho de um especialista humano. As equipes podem usar esses padrões para orientar o desenvolvimento de modelos e o pós-treinamento focado.

Para os responsáveis políticos

A HLE oferece uma métrica pública e global do progresso do raciocínio da IA. Isso cria um ponto de referência comum entre países e órgãos reguladores e pode fundamentar discussões sobre limites, supervisão e governança na realidade, sem exageros.

Conclusão

Os benchmarks de IA moldam a forma como medimos o progresso da IA. Como os benchmarks anteriores ficaram saturados, ficou claro que precisávamos de um novo benchmark, focado no raciocínio, e não só na memorização ou na correspondência de padrões.

O Humanity's Last Exam tenta preencher essa lacuna com perguntas de nível de pós-graduação feitas por especialistas de todo o mundo para mostrar as limitações dos LLMs. Não é a palavra final, mas deixa claro onde a IA está hoje em relação ao raciocínio dos especialistas humanos.

Pra saber mais sobre LLMs e como funcionam, recomendo os seguintes recursos:

Perguntas frequentes sobre o Último Exame da Humanidade

O que é o Último Exame da Humanidade (HLE)?

É um teste feito pra ver se um LLM consegue raciocinar usando perguntas acadêmicas fechadas, tipo de especialista, em várias áreas.

Por que os pesquisadores criaram o HLE?

Os benchmarks anteriores ficaram muito fáceis para os modelos de fronteira. O HLE aumenta a dificuldade para que os pesquisadores possam medir as melhorias no raciocínio.

Que tipo de perguntas tem no HLE?

O HLE inclui questões de várias disciplinas, como matemática, ciência da computação, história e análise musical.

Quem criou o HLE?

Dan Hendrycks, do Centro para a Segurança da IA, liderou a equipe. Eles fizeram uma parceria com a Scale AI.

Como os pesquisadores usam o HLE?

Eles comparam modelos, programam melhorias ao longo do tempo, identificam pontos fracos e medem a diferença entre a inteligência artificial e a experiência humana.

Mark Pedigo, PhD, é um ilustre cientista de dados com experiência em ciência de dados de saúde, programação e educação. Com doutorado em matemática, bacharelado em ciência da computação e certificado profissional em IA, Mark combina conhecimento técnico com solução prática de problemas. Sua carreira inclui funções em detecção de fraudes, previsão de mortalidade infantil e previsão financeira, além de contribuições para o software de estimativa de custos da NASA. Como educador, ele lecionou no DataCamp e na Washington University em St. Louis e foi mentor de programadores juniores. Em seu tempo livre, Mark curte o ar livre de Minnesota com sua esposa Mandy e seu cachorro Harley e toca piano jazz.