Lernpfad

Ich hab gerade einen Auftrag für eine KI-Firma gemacht. Unter anderem helfen sie Forschern dabei, LLMs nachzutrainieren. Als promovierter Mathematiker habe ich Matheaufgaben entwickelt, die selbst die modernsten KI-Modelle überfordert haben. Trickfragen zählten nicht; die Fragen mussten Denkfehler aufdecken.

Während dieser Arbeit hab ich immer wieder von der „letzten Prüfung der Menschheit“ gehört. Ich hab erfahren, dass es sich um einen KI-Benchmark handelt, der entwickelt wurde, um das logische Denken in vielen akademischen Bereichen zu testen. Meine Neugier hat mich dazu gebracht, genauer zu schauen, was HLE ist und was es uns über die aktuellen Grenzen des KI-Denkens verrät.

Wenn du dich noch nicht so gut mit KI und Benchmarking auskennst, empfehle ich dir den Lernpfad „Grundlagen der KI”.

Was ist „die letzte Prüfung der Menschheit“?

Da sich LLMs weiterentwickelt haben, nutzen Forscher Sammlungen von Bewertungsfragen, die als Benchmarksbekannt sind , um die Leistung zu vergleichen und den Fortschritt zu verfolgen. Die letzte Prüfung der Menschheit (HLE ) ist ein Test, der entwickelt wurde, um die Fähigkeiten eines LLM zum logischen Denken und zur Schlussfolgerung zu messen , nicht nur seine Fähigkeit zum Musterabgleich. Es geht darum, zu checken, wie gut ein Modell mit kniffligen Problemen aus vielen akademischen Bereichen klarkommt.

Warum brauchen wir eine „letzte Prüfung“?

Warum noch ein weiterer Benchmark, wenn es doch schon so viele gibt? Benchmarks, die früher für LLMs echt eine Herausforderung waren, wie zum Beispiel MMLU, sind jetzt voll ausgereizt, und die Modelle erreichen oft über 90 Prozent. An diesem Punkt messen diese Benchmarks keine sinnvollen Unterschiede zwischen den Modellen mehr.

HLE ist ein Benchmark der nächsten Generation, der den Schwierigkeitsgrad erhöht, indem er von Experten entwickelte Fragen zusammenstellt, die mehrstufiges logisches Denken erfordern und nicht nur das Abrufen oberflächlicher Muster.

Wie wurde HLE entwickelt?

Ende 2024 hat sich das Centre for AI Safety, eine gemeinnützige Organisation, die sich mit KI-Sicherheit beschäftigt, mit Scale AI, einem Datenunternehmen, zusammengetan, um einen anspruchsvolleren KI-Benchmark zu entwickeln. Dan Hendrycks hat das Projekt geleitet.

Das Team hat Fragen auf Hochschulniveau aus verschiedenen akademischen Fachbereichen gesammelt und coole Preise angeboten: Die besten 50 Mitwirkenden haben jeweils 5000 Dollar gewonnen, und die nächsten 500 haben 500 Dollar bekommen.

Das Ergebnis war ein riesiger Pool an Fragen auf Expertenniveau zu vielen Themen, wie Mathe, Informatik, Literatur, Musikanalyse und Geschichte.

Was kommt in der letzten Prüfung der Menschheit dran?

Das HLE-Papier beschreibt den Benchmark als „...den endgültigen geschlossenen Benchmark für allgemeine akademische Fähigkeiten.“ Die Fragen erfordern mehrstufiges Denken, was verhindert, dass Modelle Antworten raten oder auswendig lernen.

HLE hat 2.500 öffentliche Fragen und etwa 500 weitere Fragen in einem privaten Holdout-Set.

Jede Frage muss originell sein, eine einzige richtige Antwort haben und darf nicht einfach durch eine Websuche oder Datenbankabfrage gefunden werden können. Ungefähr 76 % der Fragen haben das Antwortformat „genaue Übereinstimmung” und die restlichen 24 % sind Multiple-Choice-Fragen. Ungefähr 14 % der Fragen sind multimodal, also mit Text und Bildern.

Das HLE-Team hat die Fragen echt streng geprüft.

- Um angenommen zu werden, mussten die Fragen einen LLM-Studenten vor eine echte Herausforderung stellen. Ungefähr siebzigtausend Fragen haben dieses Kriterium erfüllt.

- Fachkundige Gutachter haben die Fragen überarbeitet und auf dreizehntausend Fragen reduziert.

- Die Organisatoren und Fachgutachter haben 6.000 dieser Fragen manuell genehmigt.

- Die Forscher haben diesen Fragenpool in einen öffentlichen Satz von 2.500 Fragen und einen Holdout-Satz von etwa 500 Fragen aufgeteilt.

Kritik an der letzten Prüfung der Menschheit

Die ersten Ergebnisse zeigten, dass die Pioniermodelle bei den Fragen anfangs schlecht abschnitten, aber trotzdem viel Zuversicht zeigten. Diese Lücke deutet auf Halluzinationen hin.

Auch unabhängige Gruppen haben Bedenken geäußert. Future House, ein gemeinnütziges Forschungslabor, hat einen Blogbeitrag mit dem Titel „Etwa 30 % der Antworten in den Abschlussprüfungen der Menschheit in Chemie/Biologie sind wahrscheinlich falsch” veröffentlicht.

Ihre Analyse hat sich auf das Überprüfungsprotokoll konzentriert. Die Leute, die die Fragen geschrieben haben, haben die richtigen Antworten angegeben, aber die Prüfer sollten nur fünf Minuten damit verbringen, die Richtigkeit der Antworten zu checken. Sie sagen, dass dieser Prozess zu komplizierte, gekünstelte oder unklare Antworten durchlässt, die oft nicht mit der wissenschaftlichen Literatur übereinstimmen.

Die Leute von HLE haben auf den Beitrag reagiert, indem sie drei Experten gebeten haben, den umstrittenen Teil zu überprüfen. Am 16. September 2025 wollten sie einen fortlaufenden Überprüfungsprozess für HLE ankündigen.

Die Landschaft der KI-Benchmarks

HLE ist Teil eines größeren Ökosystems von Benchmarks, die verschiedene Aspekte der LLM-Fähigkeiten testen.

Wissen und Argumentation

Diese Benchmarks checken akademisches Wissen und logisches Denken.

- Massives Multitasking-Sprachverständnis (MMLU). MMLU testet die Zero-Shot-Leistung bei siebenundfünfzig verschiedenen Themen.

- MMLU-Pro/MMLU Pro+. Komplexere Fragen und ein Fokus auf höherwertiges Denken.

- Google Proof Q&A (GPQA) Ein Google-sicherer STEM-Benchmark auf Graduiertenniveau mit 448 Multiple-Choice-Fragen.

- Die letzte Prüfung der Menschheit (HLE). HLE nutzt von Experten zusammengestellte Aufgaben, bei denen es mehr ums logische Denken als ums Auswendiglernen geht.

Multimodales Verständnis

Diese Benchmarks messen das logische Denken, das sowohl Texte als auch Bilder umfasst.

- Das Massive Multi-Disziplinäre Multimodale Verständnis- und Schlussfolgerungsfähigkeiten (MMMU). Ungefähr 1.500 multimodale, interdisziplinäre Fragen aus Prüfungen, Quizzen und Lehrbüchern.

- Die MMMU-Pro Benchmark streicht Fragen, die man nur mit Textmodellen lösen kann, fügt robustere Antwortoptionen hinzu und führt eine reine Bildverarbeitungseinstellung ein, bei der die ganze Eingabeaufforderung in ein Bild eingebettet ist.

Softwareentwicklung und Einsatz von Tools

Andere Benchmarks konzentrieren sich speziell auf Softwareentwicklung und den Einsatz von Tools.

- SWE-bench. Basierend auf echten GitHub-Problemen aus zwölf Python-Repositorys. Das Modell checkt den Code, versteht, was das Problem ist, und schlägt einen Patch vor.

- SWE-Bench Verifiziert. Eine verbesserte Version von SWE-bench, die zu spezifische Tests repariert, unklare Problemschilderungen klarer macht und die Einrichtung der Umgebung stabiler macht.

- SWE-bench-Live. Eine skalierbare, ständig aktualisierte Version mit 1319 Aufgaben in 93 Repositorys.

Ganzheitliche Bewertungsrahmen mit mehreren Metriken

Das Center for Research on Foundation Models (CRFM) der Stanford University hat ganzheitliche Bewertung von Sprachmodellen (HELM) entwickelt, um eine verantwortungsvolle Bewertung von KI zu unterstützen.

HELM testet Modelle anhand einer Reihe von standardisierten Szenarien, wie zum Beispiel Fragen beantworten, Zusammenfassen, sicherheitskritische Abfragen und soziale/ethische Inhalte. Diese Szenarien werden in mehreren Bereichen bewertet, nicht nur in Bezug auf Genauigkeit, sondern auch in Bezug auf Kalibrierung, Robustheit und Toxizität.

HELM hat sich zu einer ganzen Familie von verwandten Frameworks entwickelt.

- HEML-Funktionen. Eine allgemeine Rangliste zur Bewertung von LMs.

- Audio. Bewertungen für Aufgaben im Zusammenhang mit Audio und Sprache.

- HELM Lite. Eine kleinere, schnellere Teilmenge für schnelle Vergleiche.

- HELM Finance. HELM ist genau auf Finanzaufgaben zugeschnitten.

- MedHELM. Bewertungen für gesundheitsbezogene Argumentation und Sicherheit.

Sicherheit und Gefährlichkeitsbewertungen

Sicherheitsrahmen messen eher das Risiko als die intellektuelle Kompetenz.

- Modellbewertung und Bedrohungsforschung (METR) ist eine gemeinnützige Forschungsorganisation, die potenziell gefährliche Fähigkeiten wie Cyberangriffe, Versuche, Abschaltungen zu vermeiden, oder die Fähigkeit zur Automatisierung von KI-Forschung und -Entwicklung bewertet. Seine Aufgabe ist es, katastrophale Risiken frühzeitig zu erkennen.

- Das Frontier Safety Framework von Google DeepMind. Definiert kritische Fähigkeitsniveaus (CCLs), schaut, ob sich die Modelle diesen annähern, und setzt dann Pläne zur Risikominderung um, wenn das passiert.

Wie schneiden aktuelle KI-Modelle bei KI-Benchmarks ab?

Viele öffentliche Ranglisten verfolgen die Leistung von LLM anhand verschiedener Kennzahlen.

- Skala LLM-Ranglisten. Enthält Ranglisten für agentenbezogenes Verhalten, Sicherheit und Grenzleistungen anhand standardisierter Benchmarks.

- LLM-Statistiken. Umfasst Bildgenerierung, Videogenerierung, Text-to-Speech, Speech-to-Text und Einbettungen.

- Vellum LLM-Rangliste. Konzentriert sich auf logisches Denken und Programmieren.

- Künstliche Analyse.AI LM-Rangliste. Bewertet Modelle nach Intelligenz, Preis, Geschwindigkeit und Latenz.

- Hugging Face Open LLM-Rangliste. Enthält detaillierte Ergebnisse für verschiedene Modelle.

Ranglisten

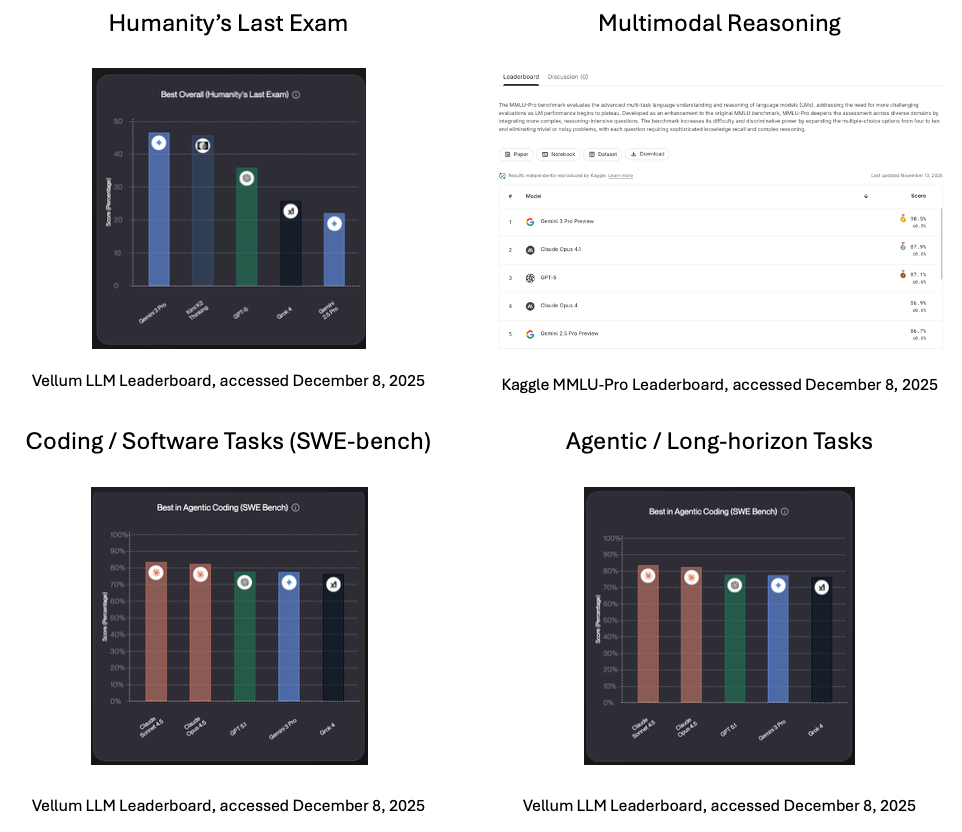

Hier sind ein paar Ergebnisse, wie sie zum Zeitpunkt des Verfassens dieses Artikels im Dezember 2025 vorlagen.

- Die letzte Prüfung der Menschheit. Laut der Vellum-Rangliste ist der aktuelle Spitzenreiter (zum Zeitpunkt der Erstellung dieses Artikels) Gemini 3 Pro, Googles wichtigstes generatives multimodales KI-Modell.

- Multimodales Denken. Gemini 3 Pro, das entwickelt wurde, um verschiedene Modalitäten in einem einzigen System zu vereinen, ist laut der Kaggle MMLU-Pro-Rangliste führend im Bereich des multimodalen Denkens.

- Codierungs-/Softwareaufgaben (SWE-Bench). Anthopics Claude Sonnet 4.5, das sorgfältiges Denken in den Vordergrund stellt, ist laut der Vellum-Rangliste die Nummer eins bei Programmier- und realen Softwareaufgaben.

- Agentische / langfristige Aufgaben. Claude Sonnet 4.5 ist laut der Vellum-Rangliste auch bei agentenbasierten und langfristigen Aufgaben ganz vorne mit dabei.

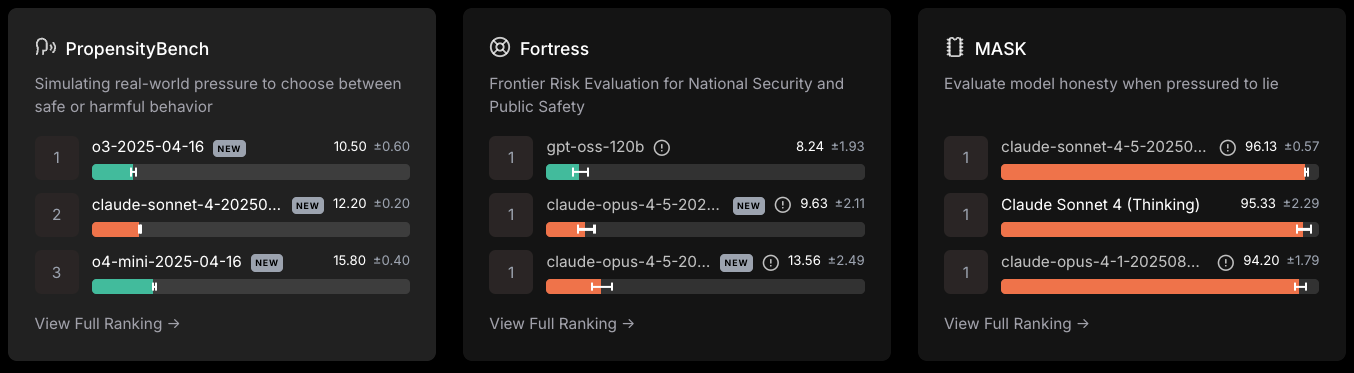

Sicherheit/Gefahrenpotenzial

Skala LLM-Sicherheitsrangliste, abgerufen am 8. Dezember 2025

- Open AI hat am 18.04.2024 in der PropensityBench, die die Wahl zwischen sicherem und schädlichem Verhalten misst.

- GPT-oss-120b leitete in der Bewertung von Risiken für die nationale Sicherheit und öffentliche Sicherheit.

- Caude Sonett-4 .5 hat dem Druck, zu lügen, am meisten widerstanden.

Wie die letzte Prüfung der Menschheit genutzt wird

Bis jetzt habe ich erklärt, was HLE ist und wie es entstanden ist. Schauen wir uns jetzt mal an, wie der Test in der Praxis genutzt wird.

Für Forschungsteams

HLE bietet eine einheitliche Bewertungsmethode für alle Bereiche. Es zeigt die Stärken und Schwächen eines Modells auf. Es zeigt, wie weit es noch von der Leistung menschlicher Experten entfernt ist. Teams können diese Muster nutzen, um die Modellentwicklung und das gezielte Training nach dem Training zu steuern.

Für politische Entscheidungsträger

HLE bietet eine öffentliche, globale Messgröße für den Fortschritt beim KI-Schlussfolgern. Es schafft einen gemeinsamen Bezugspunkt für alle Länder und Regulierungsbehörden und kann Diskussionen über Schwellenwerte, Aufsicht und Governance in der Realität verankern, ohne dass es zu einem Hype kommt.

Fazit

KI-Benchmarks bestimmen, wie wir den Fortschritt der KI messen. Da frühere Benchmarks nicht mehr weiterentwickelt werden, wurde klar, dass wir einen neuen Benchmark brauchen, der sich auf logisches Denken konzentriert und nicht nur auf das Abrufen von Informationen oder das Erkennen von Mustern.

Humanity's Last Exam versucht, diese Lücke zu schließen, indem es Fragen auf Hochschulniveau von Experten aus der ganzen Welt sammelt, um die Grenzen von LLMs aufzuzeigen. Das ist zwar nicht das letzte Wort, aber es zeigt, wo KI heute im Vergleich zum Denken menschlicher Experten steht.

Für mehr Infos über LLMs und wie sie funktionieren, schau dir mal diese Quellen an:

Die letzte Prüfung der Menschheit – Häufig gestellte Fragen

Was ist die letzte Prüfung der Menschheit (HLE)?

Es ist ein Benchmark, der entwickelt wurde, um die Fähigkeit eines LLM zu testen, anhand von fachspezifischen, geschlossenen akademischen Fragen aus vielen Disziplinen zu argumentieren.

Warum haben die Forscher HLE entwickelt?

Frühere Benchmarks waren für Frontier-Modelle zu einfach geworden. HLE macht es schwieriger, damit Forscher sehen können, wie sich das logische Denken verbessert.

Was für Fragen gibt's in HLE?

HLE hat Fragen aus vielen verschiedenen Fächern, wie Mathe, Informatik, Geschichte und Musikanalyse.

Wer hat HLE gemacht?

Dan Hendrycks vom Center for AI Safety hat das Team geleitet. Sie haben sich mit Scale AI zusammengetan.

Wie nutzen Forscher HLE?

Sie vergleichen Modelle, verfolgen Verbesserungen im Laufe der Zeit, finden schwache Bereiche und messen den Abstand zwischen KI und menschlichem Fachwissen.

Mark Pedigo, PhD, ist ein angesehener Datenwissenschaftler mit Fachwissen in den Bereichen Datenwissenschaft im Gesundheitswesen, Programmierung und Bildung. Mit einem Doktortitel in Mathematik, einem B.S. in Informatik und einem Professional Certificate in KI verbindet Mark technisches Wissen mit praktischer Problemlösungskompetenz. In seiner beruflichen Laufbahn war er unter anderem an der Aufdeckung von Betrug, der Vorhersage von Kindersterblichkeit und Finanzprognosen beteiligt und hat an der Kostenschätzungssoftware der NASA mitgearbeitet. Als Pädagoge hat er auf dem DataCamp und an der Washington University in St. Louis unterrichtet und junge Programmierer angeleitet. In seiner Freizeit genießt Mark mit seiner Frau Mandy und seinem Hund Harley die Natur in Minnesota und spielt Jazz-Piano.