Cursus

À mesure que les systèmes d'IA s'intègrent davantage dans les applications critiques, j'ai observé les défis auxquels les organisations sont confrontées pour garantir la sécurité et la fiabilité des modèles. Un chatbot de service client divulguant des informations confidentielles, une intelligence artificielle dans le domaine de la santé fournissant des conseils médicaux inappropriés ou un assistant financier générant des recommandations biaisées. Il ne s'agit pas de scénarios hypothétiques. Il existe des risques réels qui peuvent nuire à la confiance, enfreindre les réglementations et porter préjudice aux utilisateurs.

L'adoption rapide des grands modèles linguistiques (LLM) a exacerbé ces préoccupations. Bien que ces systèmes performants soient capables de générer des textes semblables à ceux rédigés par des humains et de résoudre des problèmes complexes, ils peuvent également produire des contenus préjudiciables, divulguer des informations sensibles ou générer des informations convaincantes mais fausses. Sans mesures de protection adéquates, les organisations s'exposent à des risques juridiques, éthiques et réputationnels importants.

Dans ce tutoriel, je vais vous expliquer ce que sont les garde-fous de l'IA, pourquoi ils sont importants et comment les mettre en œuvre efficacement. Que vous développiez votre premier chatbot ou déployiez des applications à l'échelle de l'entreprise, il est essentiel de comprendre les garde-fous pour créer des systèmes auxquels les utilisateurs peuvent faire confiance.

Si vous débutez dans le domaine de la sécurité et du développement de l'IA, je vous recommande plusieurs de nos cours, notamment Sécurité et gestion des risques liés à l'IA, Comprendre la loi européenne sur l'IAet Ingénieur IA associé pour les développeurs.

Que sont les garde-fous de l'IA ?

Les garde-fous de l'IA sont des mécanismes de sécurité qui surveillent, valident et contrôlent le comportement des systèmes d'IA tout au long de leur cycle de vie.

Je les considère comme l'équivalent des dispositifs de sécurité dans une voiture : les ceintures de sécurité, les airbags et les freins antiblocage ne vous empêchent pas de conduire, mais ils vous protègent en cas de problème.

À la base, les garde-fous de l'IA ont trois objectifs principaux :

- Empêcher les résultats préjudiciables avant qu'ils n'atteignent les utilisateurs

- Garantir le respect des normes éthiques et des réglementations

- Maintenir un comportement cohérent du système, même dans les cas extrêmes

Contrairement aux filtres de contenu simples qui se contentent de bloquer certains mots, les garde-fous fonctionnent à plusieurs niveaux, depuis la validation des données d'entrée jusqu'à la surveillance des résultats des modèles et l'application des règles métier.

Il est important de distinguer les garde-fous de l'IA des concepts connexes.

Les outils de modération de contenu se concentrent généralement sur le filtrage après la génération, tandis que les garde-fous fonctionnent de manière proactive tout au long du processus d'IA.

De même, l'ingénierie rapide guide le comportement des modèles à l'aide d'instructions, mais les garde-fous fournissent des contraintes applicables que le système ne peut pas contourner.

Maintenant que nous comprenons ce que sont les garde-fous, examinons pourquoi ils sont devenus essentiels pour le déploiement de l'IA moderne.

Pourquoi les garde-fous de l'IA sont-ils importants ?

La mise en œuvre de l'IA sans mesures de protection comporte des risques importants tant pour les utilisateurs que pour les organisations.

Pour les entreprises

Pour les entreprises, les amendes réglementaires pour non-conformité des systèmes, l'atteinte à la réputation due à des résultats biaisés et les violations de données lorsque les modèles divulguent involontairement des données d'entraînement constituent autant de problèmes potentiels pour de nombreuses sociétés.

Cette importance est encore renforcée par des cadres réglementaires tels que la loi européenne sur l'IA et les exigences spécifiques à certains secteurs, telles que la loi HIPAA dans le domaine de la santé ou le RGPD pour la protection des données, car elles créent des obligations légales.

Au-delà de la conformité, il existe un impératif éthique pour les organisations de déployer l'IA de manière responsable, en veillant à ce que les systèmes ne perpétuent pas les préjugés ou ne génèrent pas de contenu préjudiciable.

Pour les utilisateurs

Pour les utilisateurs finaux, les risques sont potentiellement encore plus importants. Une intelligence artificielle non sécurisée dans le secteur de la santé pourrait littéralement mettre des vies en danger en fournissant des informations médicales inexactes.

Les garde-fous de l'IA renforcent la confiance. Les utilisateurs adoptent les systèmes d'IA lorsqu'ils savent que des mesures de protection sont en place pour prévenir les erreurs et protéger leurs intérêts. Pour les organisations, cela se traduit par la fidélisation des utilisateurs, la réputation de la marque et l'adoption durable de l'IA. Sans garde-fous, un seul échec retentissant peut compromettre des années d'efforts de développement.

Les principes fondamentaux des garde-fous de l'IA en action

Les garde-fous de l'IA fonctionnent en limitant le comportement de l'IA grâce à des contrôles programmatiques, des règles de validation et des systèmes de surveillance qui fonctionnent parallèlement aux modèles d'IA.

L'évolution des garde-fous reflète le développement de l'IA. Les premiers systèmes basés sur des règles reposaient sur le filtrage par mots-clés. À mesure que les modèles gagnaient en sophistication, les garde-fous évoluaient également. L'émergence de grands modèles linguistiques a accéléré le développement de garde-fous, introduisant de nouveaux risques liés aux hallucinations et à l'injection de prompts.

Les garde-fous actuels combinent des règles déterministes et l'apprentissage automatique, créant ainsi des systèmes de protection multicouches.

Cela a donné lieu à une classification détaillée des types de garde-fous, chacun traitant d'aspects spécifiques de la sécurité de l'IA. Examinons ces catégories en détail.

Types de garde-fous pour l'IA

Comprendre les différents types de garde-corps vous aide, vous ou votre organisation, à mettre en place une protection complète.

Les garde-fous IA peuvent être classés en fonction de leur emplacement dans l'architecture du système et des risques spécifiques auxquels ils s'adressent. Certains se concentrent sur la protection de la confidentialité des données, d'autres veillent au bon fonctionnement des modèles, tandis que d'autres encore s'occupent des questions de déploiement et de conformité.

Le tableau suivant présente les principales catégories de garde-fous, chacune ayant des objectifs distincts mais complémentaires dans la création de systèmes d'IA sécurisés :

|

Caractéristique |

Focus |

Fonctionnement |

Exemple |

|

Barrières de protection des données |

Veuillez protéger les informations sensibles. |

Détecter et expurger les informations personnelles identifiables |

Masquer les numéros de carte de crédit |

|

Modèle de garde-corps |

Génération de modèles de contrôle |

Les filtres anti-toxicité bloquent les contenus inappropriés. |

Les vérifications factuelles permettent de confirmer les affirmations. |

|

Barrières de sécurité pour les applications |

Gérer les interactions des utilisateurs |

Gérer le déroulement de la conversation |

Empêcher les commentaires non autorisés |

|

Barrières de sécurité pour les infrastructures |

Garantir un déploiement sécurisé |

Surveiller les ressources système |

Mettre en œuvre le contrôle d'accès |

|

Barrières de sécurité appropriées |

Respecter les normes professionnelles |

Filtrer les sujets inappropriés |

Veuillez adapter le contenu en fonction de l'âge. |

|

Barrières de sécurité contre les hallucinations |

Veuillez vous assurer de l'exactitude des faits. |

Contenu généré par référence croisée |

Signaler les affirmations non vérifiables |

|

Barrières de conformité réglementaire |

Respecter les exigences légales |

Mettre en place des contrôles automatisés |

Documenter les processus décisionnels |

|

Barrières de sécurité d'alignement |

Répondre aux attentes de l'utilisateur |

Appliquer les directives éthiques |

Veuillez vous assurer de la conformité avec les politiques de l'entreprise. |

|

Barrières de validation |

Vérifier l'exactitude des résultats |

Vérifier la qualité des données |

Veuillez vous assurer que la sortie est au format JSON. |

Comparaison des types de barrières de sécurité IA

Ces types de garde-fous fonctionnent conjointement pour offrir une protection complète aux systèmes d'IA. Les garde-fous relatifs aux données, aux modèles et aux applications constituent la première ligne de défense. Ils interviennent à différentes étapes du processus d'IA afin de détecter les problèmes avant qu'ils n'atteignent les utilisateurs.

Les garde-fous liés à l'infrastructure et à la pertinence garantissent le fonctionnement sûr et professionnel du système à grande échelle, tandis que les garde-fous liés aux hallucinations et à la validation se concentrent sur la précision et la fiabilité.

Les dernières catégories, conformité réglementaire et garde-fous d'alignement, répondent à des besoins organisationnels plus généraux. Ils veillent à ce que les systèmes d'IA fonctionnent correctement, mais aussi qu'ils respectent les limites légales et soient conformes aux valeurs de l'entreprise.

Dans la pratique, la plupart des systèmes d'IA de production mettent en œuvre simultanément plusieurs types de garde-fous, créant ainsi une protection à plusieurs niveaux qui répond aux préoccupations techniques, éthiques et juridiques.

Il est important de comprendre ces types, mais pour mettre en œuvre efficacement les garde-fous, nous devons examiner les éléments techniques qui les rendent possibles.

Architecture technique des garde-fous de l'IA

L'architecture de la glissière de sécurité comprend généralement quatre composants clés qui fonctionnent ensemble pour offrir une protection complète.

Le vérificateur

Le vérificateur examine les entrées ou les sorties par rapport à des critères définis : un classificateur de toxicité, un détecteur de fuite de données ou un vérificateur de véracité. Les vérificateurs peuvent être des systèmes déterministes basés sur des règles ou des modèles d'apprentissage automatique formés pour identifier des risques spécifiques.

Le correcteur

Lorsqu'un vérificateur identifie un problème, le correcteur détermine la manière de le traiter. Les correcteurs peuvent masquer les données sensibles, reformuler les contenus problématiques ou rejeter le résultat et demander une nouvelle génération. Les correcteurs simples remplacent les informations personnelles identifiables détectées par des espaces réservés, tandis que les correcteurs avancés utilisent des modèles linguistiques pour réécrire le contenu tout en préservant son sens.

Le rail

L' e ferroviaire définit les contraintes et les politiques que les contrôleurs doivent respecter. Les rails sont spécifiés dans des formats structurés tels que YAML, JSON ou des langages spécifiques à un domaine, ce qui les rend faciles à maintenir par des parties prenantes non techniques. Une directive peut préciser que les publications doivent comporter moins de 500 mots, ne doivent pas mentionner les concurrents et doivent conserver un ton professionnel.

Le gardien

Enfin, le garde orchestre le processus, en déterminant quand appliquer quels vérificateurs, en gérant le flux de travail de correction et en enregistrant toutes les actions à des fins d'audit.

Barrières de sécurité déterministes et modèles probabilistes

Il existe une distinction essentielle entre les garde-fous déterministes et les modèles probabilistes. Les garde-fous déterministes offrent un comportement prévisible : une expression régulière pour la détection des e-mails produit toujours le même résultat.

Les modèles probabilistes offrent une détection nuancée, mais avec une part d'incertitude. Les systèmes modernes combinent les deux approches pour une protection optimale.

Une fois ces composants architecturaux en place, examinons comment ils fonctionnent ensemble dans la pratique lors du traitement de requêtes réelles.

Comment fonctionnent les garde-fous de l'IA ?

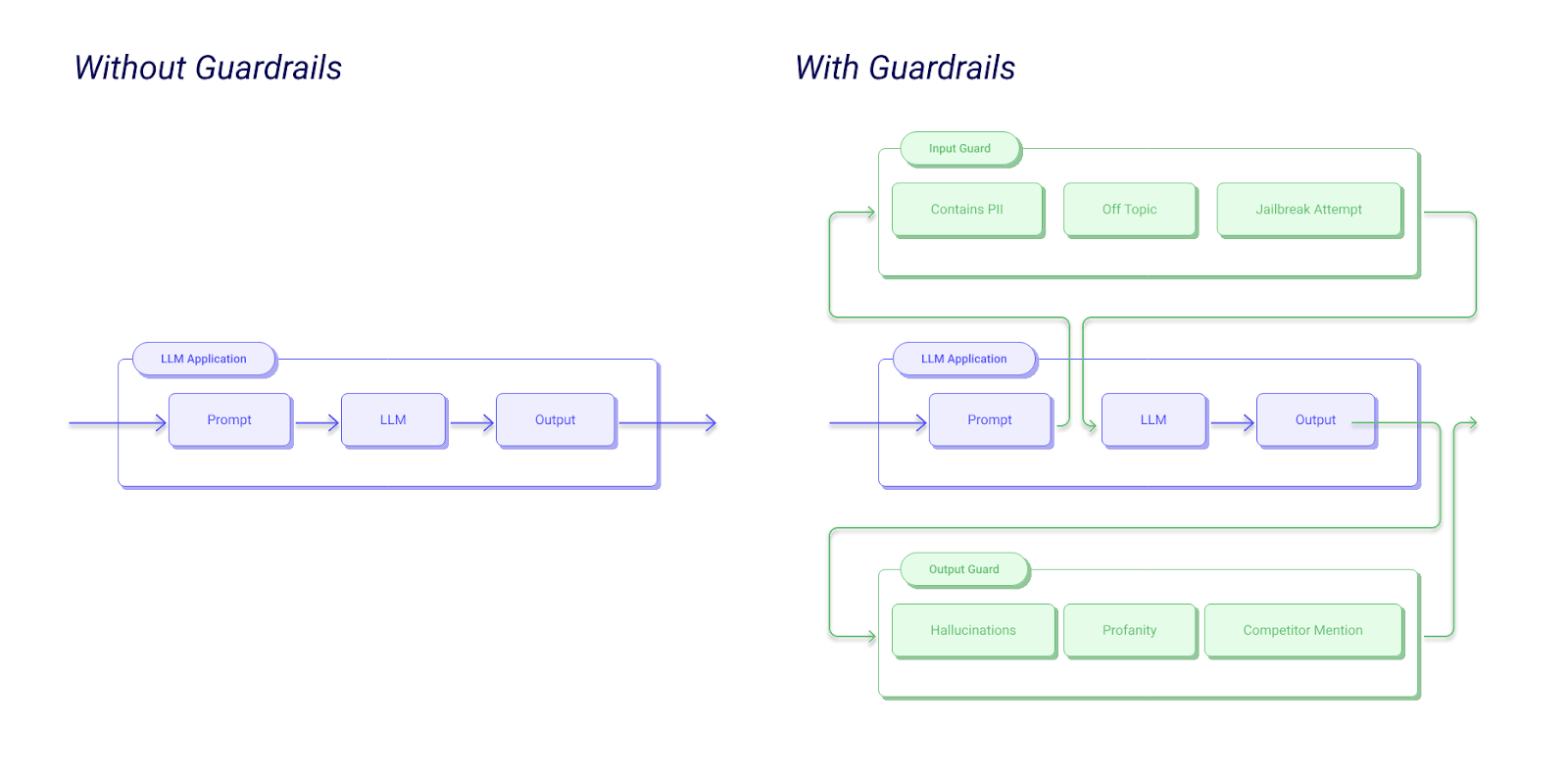

La compréhension du processus de garde-fou permet de clarifier le fonctionnement de ces composants dans la pratique. Lorsqu'un utilisateur soumet une entrée à votre application d'IA, la requête passe d'abord parles garde-fous d'entrée d' , qui valident la invite afin de détecter les attaques par injection, les contenus inappropriés ou les violations de politique.

Le modèle génère une réponse, mais avant qu'elle ne parvienne à l'utilisateur, les garde-fous de sortie l'examinent. Plusieurs vérificateurs fonctionnent en parallèle : l'un valide les affirmations factuelles, un autre vérifie l'absence de fuite de données sensibles et un troisième s'assure que le ton utilisé est approprié.

Si un vérificateur signale un problème, le correcteur tente d'y remédier, par exemple en masquant les informations personnelles identifiables ou en régénérant le contenu avec des contraintes plus strictes.

Exemple de flux de travail avec l'IA Guardrails

Après correction, la réponse est soumise à une validation finale. Si elle est approuvée, elle est transmise à l'utilisateur avec les métadonnées relatives aux mesures de protection appliquées. Toutes les étapes sont consignées à des fins de surveillance et de conformité. Si la validation échoue après plusieurs tentatives, le système renvoie uneréponse de repli sécurisée .

Cette approche en plusieurs étapes garantit une protection complète tout en maintenant une latence acceptable. En parallélisant les vérifications et en optimisant les modèles, les systèmes de garde-fou modernes n'ajoutent que 50 à 200 millisecondes au temps de réponse.

Approches de mise en œuvre des garde-fous IA

Il existe trois approches principales pour mettre en œuvre des garde-fous, chacune présentant des avantages et des limites distincts :

- Les systèmes basés sur des règles utilisent des modèles prédéfinis, des expressions régulières et une logique déterministe. Ils sont hautement interprétables. Vous comprenez parfaitement pourquoi le contenu a été signalé. Ils sont également rapides et économiques à utiliser. Cependant, ils rencontrent des difficultés avec les nuances et nécessitent une mise à jour constante à mesure que la langue évolue.

- Les classificateurs d'apprentissage automatique offrent une détection sophistiquée en apprenant des modèles à partir de données d'entraînement. Un classificateur de toxicité basé sur un transformateur est capable de comprendre le contexte et de détecter les contenus subtilement préjudiciables que les règles ne parviennent pas à identifier. L'inconvénient est une interprétabilité réduite et la possibilité de faux positifs. Les classificateurs ML nécessitent également davantage de ressources informatiques.

- Les approches hybrides combinent les atouts des deux méthodes. Vous pouvez utiliser des règles pour les cas clairs, tels que la détection des informations personnelles identifiables, et des modèles d'apprentissage automatique pour les jugements nuancés, tels que la pertinence ou la véracité. C'est ce que je recommande généralement pour les systèmes de production.

Au-delà des approches techniques, une mise en œuvre réussie nécessite la constitution d'équipes multidisciplinaires comprenant des experts du domaine, des éthiciens, des conseillers juridiques et des ingénieurs.

Avantages des garde-fous de l'IA

J'espère avoir clairement expliqué pourquoi les garde-fous de l'IA sont importants, mais récapitulons.

Confidentialité et sécurité

Les garde-corps offrent bien plus qu'une simple prévention des problèmes. Ils renforcent la confidentialité et la sécurité des utilisateurs en empêchant les fuites de données avant qu'elles ne se produisent, en détectant lorsque les modèles sont susceptibles de reproduire les données d'entraînement et en détectant les tentatives d'extraction d'informations sensibles par injection de prompt.

Pour les organisations qui traitent des informations personnelles relatives à la santé ou des données financières, ces mesures de protection sont indispensables.

Conformité

La conformité réglementaire devient gérable grâce à des garde-fous. Les systèmes appliquent automatiquement le droit à l'explication prévu par le RGPD en enregistrant les motifs des décisions.

Les applications conformes à la loi HIPAA utilisent des garde-fous pour garantir que les informations médicales protégées n'apparaissent jamais dans les résultats. Les exigences de la loi européenne sur l'IA relatives aux systèmes d'IA à haut risque prévoient explicitement des mesures techniques visant à atténuer les risques identifiés.

Confiance dans l'IA

Plus important encore, les garde-fous renforcent la confiance des utilisateurs. Lorsque les utilisateurs savent que les systèmes sont dotés de mesures de sécurité, ils sont plus enclins à s'engager de manière authentique. La confiance se traduit par des taux d'adoption plus élevés, des commentaires plus précieux et une croissance durable.

Principales plateformes et outils de protection par IA

Plusieurs plateformes ont été développées afin de simplifier la mise en œuvre des garde-corps. Comprendre les différentes options disponibles vous aide à choisir les outils adaptés à vos besoins spécifiques et à votre environnement technique.

Barrières de sécurité IA

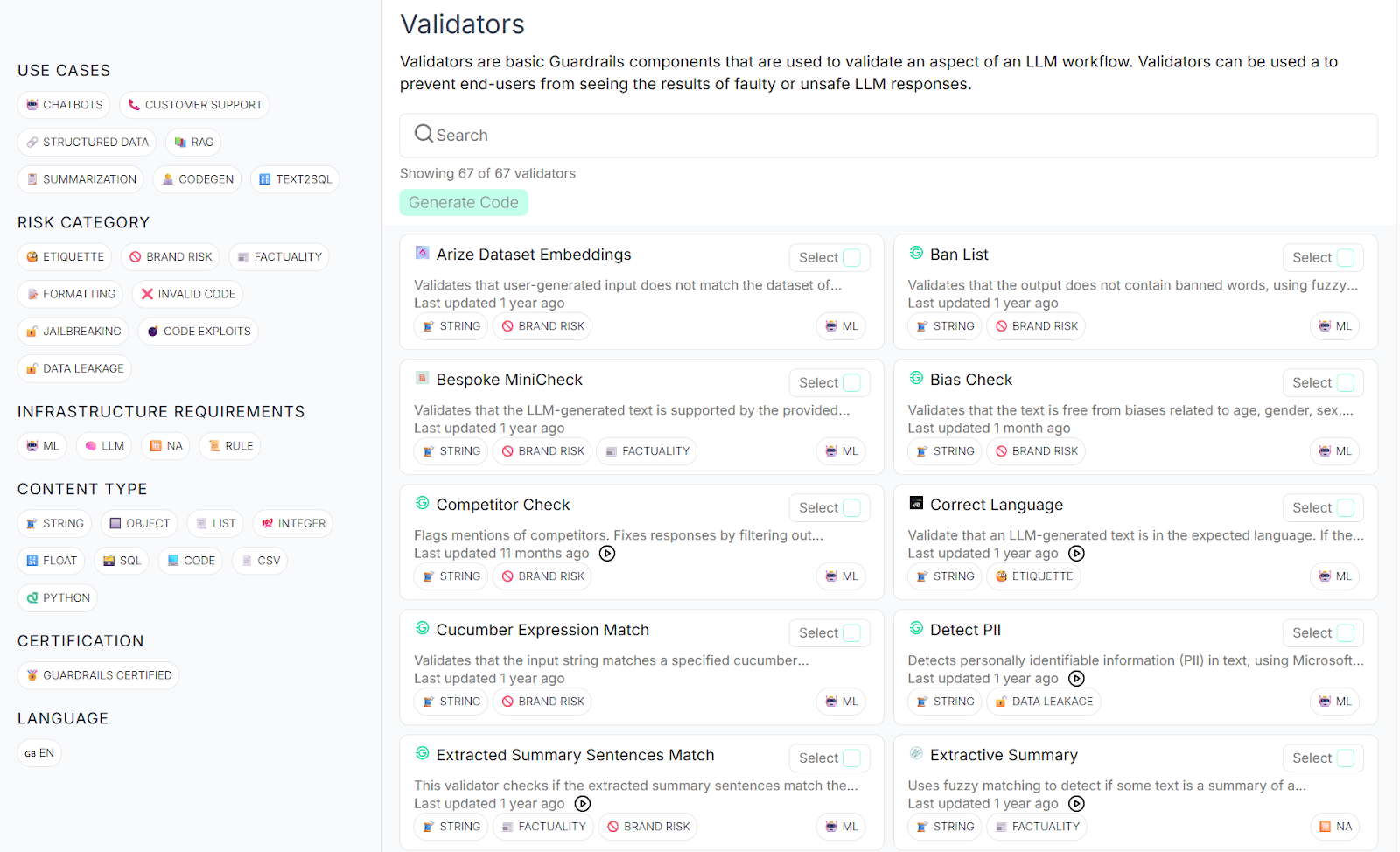

Guardrails AI est un framework open source qui a suscité un intérêt considérable au sein de la communauté des développeurs. Je pense que cela s'explique en grande partie par le fait qu'il fournit une vaste bibliothèque de validateurs pré-intégrés couvrant les risques courants tels que la détection des informations personnelles identifiables, le filtrage de la toxicité et la prévention des hallucinations.

Le cadre utilise un langage de spécification appelé RAIL (Reliable AI Markup Language) qui vous permet de définir des garde-fous personnalisés de manière déclarative.

Ce qui rend Guardrails AI particulièrement intéressant à mes yeux, c'est sa flexibilité et son extensibilité.

Vous pouvez utiliser l'un des nombreux validateurs disponibles sur leur Guardrails Hub, les intégrer à des fournisseurs LLM populaires tels que OpenAI, Anthropic et Cohere, et les déployer partout où vos applications fonctionnent.

La nature open source vous permet d'examiner le code, d'apporter des améliorations et d'éviter la dépendance vis-à-vis d'un fournisseur. La communauté active ajoute continuellement de nouveaux validateurs et partage des modèles de mise en œuvre pour des cas d'utilisation courants.

Centre d'intelligence artificielle Guardrails

Barrières de sécurité Amazon Bedrock

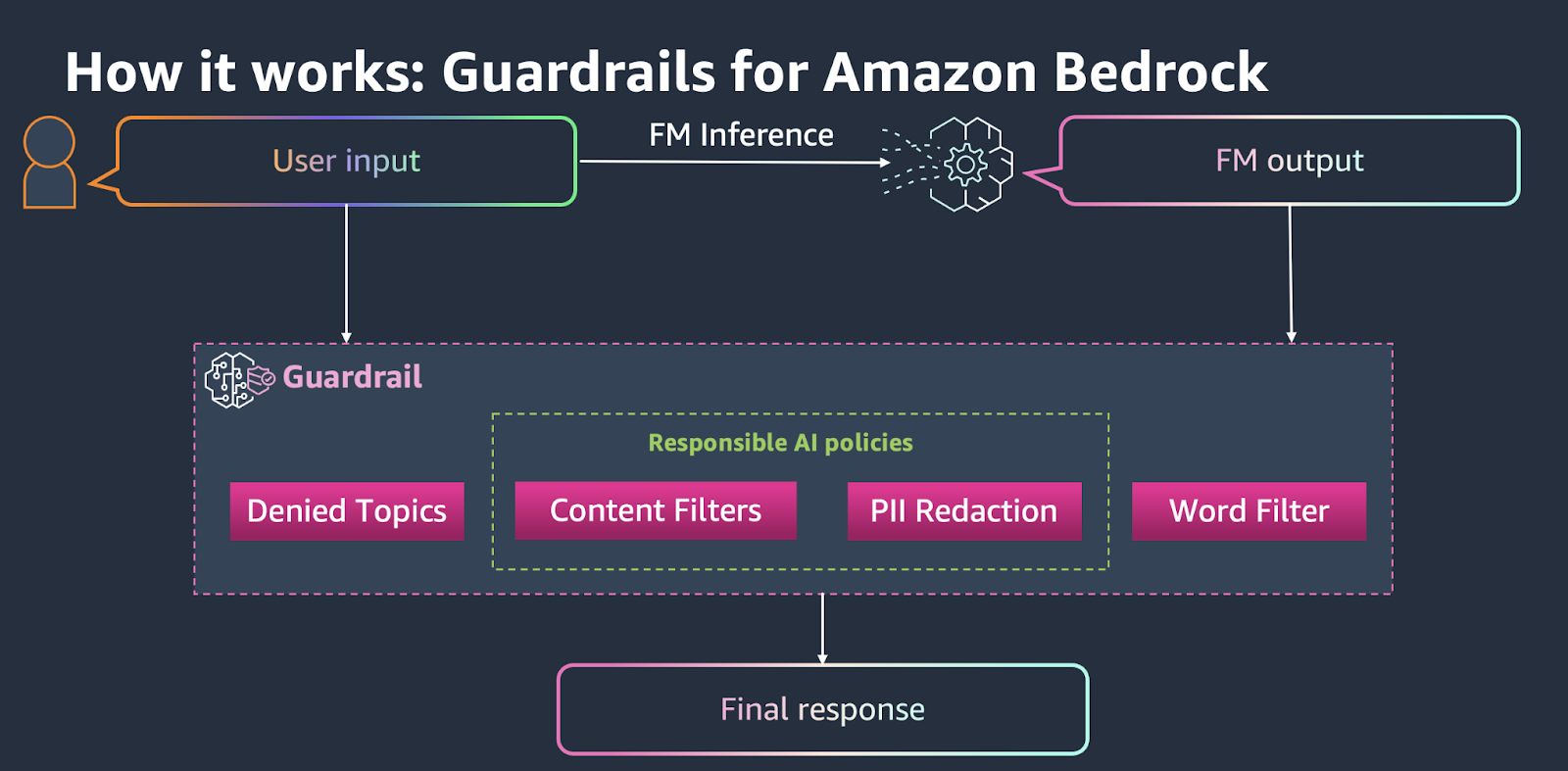

Amazon Bedrock Guardrails adopte une approche gérée et native du cloud qui s'intègre parfaitement aux services AWS. adopte une approche gérée et native du cloud qui s'intègre parfaitement aux services AWS. Il propose des politiques préconfigurées pour le filtrage de contenu, la détection des informations personnelles identifiables, les sujets interdits et les filtres de mots, entre autres.

La plateforme gère la complexité de l'infrastructure et adapte automatiquement les garde-fous en fonction de vos modèles de trafic.

Barrières de sécurité Amazon Bedrock

Pour les équipes déjà investies dans l'écosystème AWS, Bedrock Guardrails pourrait constituer la solution la plus simple pour passer à la production. Vous pouvez configurer des garde-fous via la console AWS ou l'API, les appliquer à n'importe quel modèle de base sur Bedrock et surveiller leurs performances via CloudWatch.

Le compromis réside dans une personnalisation réduite par rapport aux alternatives open source, mais la facilité de déploiement et le support aux entreprises le rendent attrayant pour les organisations qui privilégient la rapidité de mise sur le marché.

Barrières de sécurité NVIDIA NeMo

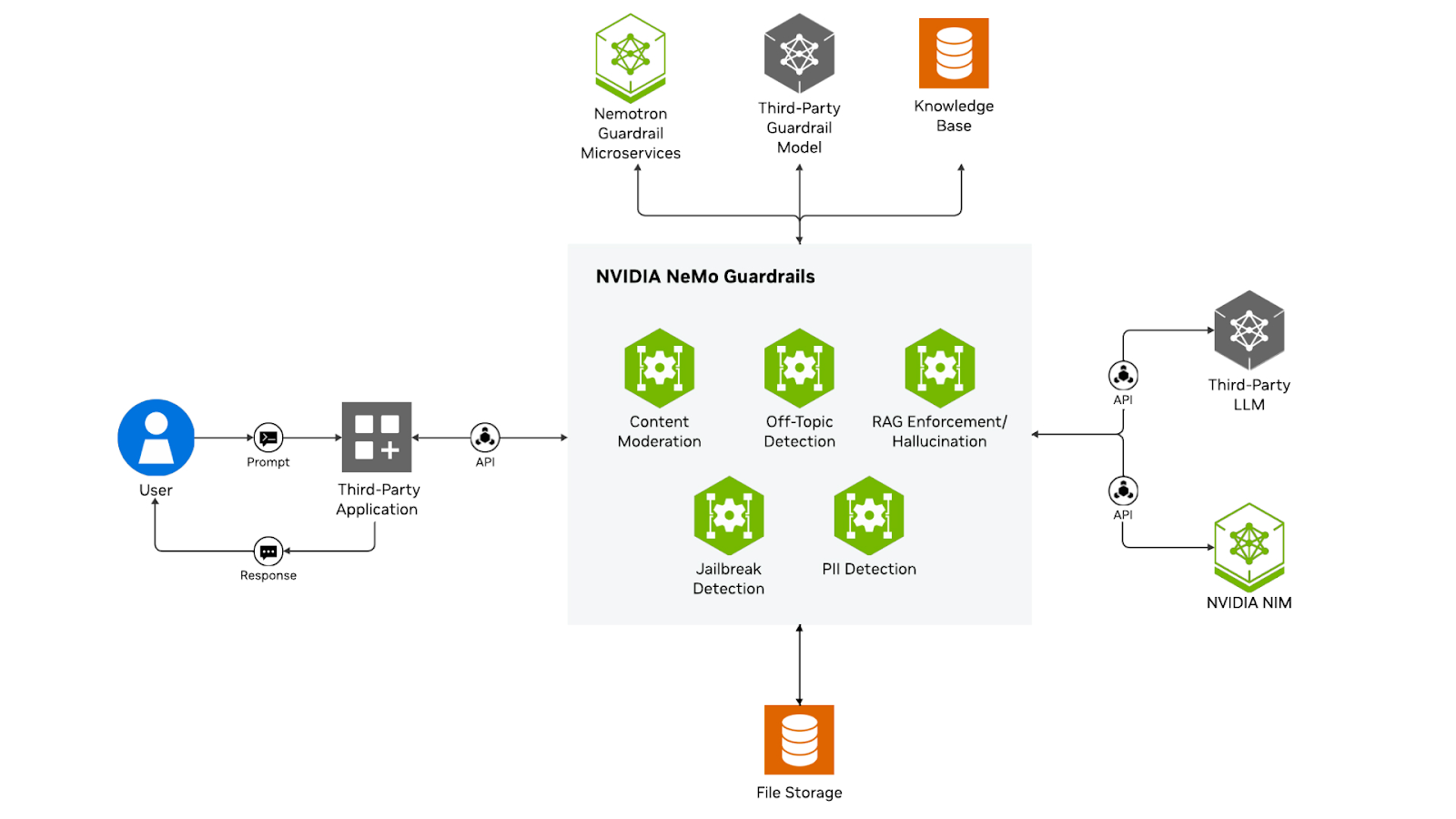

NVIDIA NeMo Guardrails adopte une approche unique en se concentrant spécifiquement sur l'IA conversationnelle grâce à un modèle de machine à états centré sur le dialogue. Au lieu de simplement filtrer les entrées et les sorties, NeMo gère l'ensemble des flux de conversation, garantissant que les interactions multi-tours suivent des chemins et des contraintes définis.

Barrières de sécurité NVIDIA NeMo

La plateforme utilise Colang, un langage de modélisation spécialement conçu pour contrôler le comportement des dialogues. Cela vous permet de définir des rails de conversation qui guident les interactions, gèrent le contexte d'un tour à l'autre et appliquent la logique métier tout au long des conversations prolongées.

L'approche de NeMo est particulièrement efficace pour les chatbots, les assistants virtuels et les applications de service client, où il est plus important de maintenir des conversations cohérentes et conformes aux politiques que d'effectuer un filtrage en un seul tour.

Sécurité du contenu Microsoft Azure AI

La solution Azure AI Content Safety de Microsoft offre une modération de contenu de niveau professionnel spécialement adaptée au texte, aux images et au contenu multimodal. La plateforme propose des seuils de gravité personnalisables dans différentes catégories telles que les discours haineux, la violence, les contenus à caractère sexuel et l'automutilation. Il comprend des fonctionnalités spécialisées pour détecter les tentatives de jailbreak et protéger contre les attaques par injection rapide.

Azure AI Content Safety s'intègre naturellement à Azure OpenAI Service et aux autres offres Azure AI, ce qui en fait un choix idéal pour les organisations utilisant la plateforme cloud de Microsoft. Ce service fournit des scores de risque détaillés plutôt que des décisions binaires, ce qui vous permet de mettre en œuvre des politiques de modération nuancées en fonction de votre tolérance au risque.

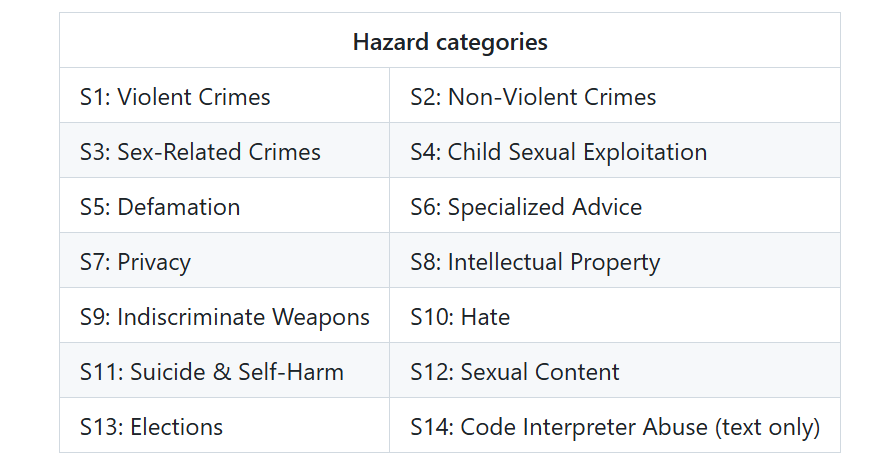

LlamaGuard

LlamaGuard, développé par Meta, représente une nouvelle génération de modèles de sécurité open source. Il s'agit d'un modèle LLaMA perfectionné, spécialement conçu pour classer les contenus générés par l'IA en fonction des risques pour la sécurité. LlamaGuard fournit des résultats sûrs/non sûrs pour ses évaluations de sécurité, ainsi que les catégories qu'il enfreint.

Étiquettes de sécurité LlamaGuard 4

Grâce à ces plateformes, examinons comment des organisations issues de différents secteurs mettent en œuvre des garde-fous dans des scénarios concrets.

Applications concrètes et cas d'utilisation des garde-fous de l'IA

L'observation des garde-fous en action dans divers secteurs illustre leur valeur pratique.

Service à la clientèle

Dans le domaine du service client, les garde-fous garantissent que les agents IA maintiennent un ton professionnel, ne prennent jamais d'engagements non autorisés et escaladent de manière appropriée lorsqu'ils sont confrontés à des problèmes complexes. Une entreprise de télécommunications a mis en place des garde-fous qui identifient les clients mécontents et transfèrent automatiquement les conversations à des agents humains.

Soins de santé

Les applications dans le domaine de la santé sont soumises à des exigences particulièrement strictes. Les garde-fous intégrés aux systèmes d'IA médicale empêchent les diagnostics provenant de systèmes non agréés, vérifient que les traitements recommandés sont conformes aux directives fondées sur des preuves et garantissent la confidentialité des données des patients. Un système de mise en correspondance des essais cliniques utilise des garde-fous pour s'assurer que les informations relatives aux patients ne sont jamais divulguées dans les explications.

Recherche

Dans le domaine de la recherche universitaire, les garde-fous permettent d'équilibrer la sécurité et la liberté académique. Les assistants de recherche doivent éviter le plagiat, citer correctement leurs sources et adopter un ton académique sans être trop restrictif.

Sécurité informatique

En matière de cybersécurité et de flux de travail d'entreprise, les garde-fous protègent contre les attaques par injection rapide, empêchent l'exécution de code non sécurisé et conservent des pistes d'audit à des fins de conformité. Une société de services financiers utilise des garde-fous pour garantir que les assistants IA ne divulguent jamais de stratégies de trading exclusives tout en fournissant des analyses utiles.

Conformité réglementaire et gouvernance

Comprendre le contexte réglementaire vous aide à concevoir des garde-fous qui répondent aux exigences légales. La loi européenne sur l'IA classe les systèmes d'IA par niveau de risque et impose des garanties techniques pour les applications à haut risque dans les domaines de l'emploi, de l'éducation, de l'application de la loi ou des infrastructures critiques. La loi exige spécifiquement des mesures d'atténuation des risques, des capacités de surveillance humaine et des mécanismes de transparence.

Les réglementations relatives à la protection des données, telles que le RGPD et l'HIPAA, établissent des exigences spécifiques en matière de protection. Le principe de minimisation des données du RGPD exige la mise en place de garde-fous afin d'empêcher la collecte et le traitement inutiles de données. La règle de sécurité HIPAA exige la mise en place de mesures de protection pour les informations de santé électroniques protégées.

Les nouveaux cadres de gouvernance mettent l'accent sur la surveillance et l'adaptation continues. Le cadre de gestion des risques liés à l'IA du NIST encourage les organisations à mettre en œuvre des contrôles techniques dans le cadre d'une stratégie de gouvernance plus large.

Conclusion

Comme j'ai tenté de le démontrer, les garde-fous de l'IA constituent un élément essentiel d'un déploiement responsable de l'IA. Ils transforment l'IA, qui était auparavant un système imprévisible, en un outil fiable auquel les organisations et les utilisateurs peuvent se fier. Tout au long de ce tutoriel, j'ai examiné ce que sont les garde-fous, leur importance et la manière de les mettre en œuvre efficacement.

Le point essentiel à retenir est que les garde-fous ne visent pas à limiter les capacités de l'IA. Il s'agit de canaliser ces capacités de manière sûre et productive. Lorsque vous développez des systèmes d'IA, je vous encourage à considérer les garde-fous comme une priorité dès le début. Commencez par établir des politiques claires, mettez en place des protections modulaires et affinez-les continuellement en fonction des commentaires issus du monde réel.

Le domaine continue d'évoluer, avec l'apparition régulière de nouveaux outils, techniques et meilleures pratiques. Restez en contact avec la communauté, essayez différentes approches et partagez vos connaissances. Ensemble, nous pouvons développer des systèmes d'IA qui sont non seulement puissants, mais également sûrs, fiables et dignes de confiance.

Pour continuer à approfondir vos connaissances, je vous recommande les ressources suivantes :

FAQ sur les garde-fous de l'IA

Que sont les garde-fous de l'IA ?

Les garde-fous de l'IA sont des mécanismes de sécurité qui surveillent, valident et contrôlent le comportement des systèmes d'IA tout au long de leur cycle de vie, empêchant ainsi les résultats préjudiciables et garantissant le respect des normes éthiques.

Quels types de garde-fous existent en matière d'IA ?

Les principaux types comprennent les garde-fous de données (protection des informations sensibles), les garde-fous de modèles (contrôle de la génération), les garde-fous d'applications (gestion des interactions), les garde-fous d'infrastructure (garantie d'un déploiement sécurisé) et les garde-fous de conformité réglementaire (prise en charge des exigences légales).

Quelles plateformes proposent des solutions de protection basées sur l'intelligence artificielle ?

Les principales plateformes comprennent Guardrails AI (open source), Amazon Bedrock Guardrails (cloud native), NVIDIA NeMo Guardrails (axée sur le dialogue), Microsoft Azure AI Content Safety et LlamaGuard.

Quel est l'impact des garde-fous sur les performances des systèmes d'IA ?

Les garde-fous ajoutent 50 à 200 millisecondes de latence et augmentent les coûts de calcul, mais la mise en cache intelligente, la validation asynchrone et la vérification par niveaux minimisent l'impact sur les performances tout en maintenant la protection.

Les garde-fous liés à l'IA sont-ils requis par la loi ?

Oui, dans de nombreux cas. La loi européenne sur l'IA impose des garde-fous pour les systèmes d'IA à haut risque, tandis que des réglementations telles que le RGPD et l'HIPAA exigent des mesures de protection spécifiques pour la protection des données et le respect de la vie privée.

En tant que fondateur de Martin Data Solutions et Data Scientist freelance, ingénieur ML et AI, j'apporte un portefeuille diversifié en régression, classification, NLP, LLM, RAG, réseaux neuronaux, méthodes d'ensemble et vision par ordinateur.

- A développé avec succès plusieurs projets de ML de bout en bout, y compris le nettoyage des données, l'analyse, la modélisation et le déploiement sur AWS et GCP, en fournissant des solutions impactantes et évolutives.

- Création d'applications web interactives et évolutives à l'aide de Streamlit et Gradio pour divers cas d'utilisation dans l'industrie.

- Enseigne et encadre des étudiants en science des données et en analyse, en favorisant leur développement professionnel par le biais d'approches d'apprentissage personnalisées.

- Conception du contenu des cours pour les applications de génération augmentée par récupération (RAG) adaptées aux exigences de l'entreprise.

- Rédaction de blogs techniques à fort impact sur l'IA et le ML, couvrant des sujets tels que les MLOps, les bases de données vectorielles et les LLM, avec un engagement significatif.

Dans chaque projet que je prends en charge, je m'assure d'appliquer des pratiques actualisées en matière d'ingénierie logicielle et de DevOps, comme le CI/CD, le linting de code, le formatage, la surveillance des modèles, le suivi des expériences et la gestion robuste des erreurs. Je m'engage à fournir des solutions complètes, en transformant les connaissances sur les données en stratégies pratiques qui aident les entreprises à se développer et à tirer le meilleur parti de la science des données, de l'apprentissage automatique et de l'IA.