Programa

À medida que os sistemas de IA se tornam mais integrados em aplicações críticas, tenho observado os desafios que as organizações enfrentam para garantir que os modelos funcionem de forma segura e confiável. Um chatbot de atendimento ao cliente que vaza informações privadas, uma IA de saúde que dá conselhos médicos perigosos ou um assistente financeiro que gera recomendações tendenciosas. Esses não são cenários hipotéticos. Existem riscos reais que podem prejudicar a confiança, violar regulamentos e prejudicar os usuários.

A rápida adoção de grandes modelos de linguagem (LLMs) intensificou essas preocupações. Embora esses sistemas poderosos possam criar textos parecidos com os humanos e resolver problemas complicados, eles também podem produzir conteúdo prejudicial, vazar informações confidenciais ou criar informações falsas, mas que parecem verdadeiras. Sem as proteções certas, as organizações ficam expostas a riscos legais, éticos e de reputação bem sérios.

Neste tutorial, vou te mostrar o que são as proteções de IA, por que elas são importantes e como implementá-las de forma eficaz. Seja pra criar seu primeiro chatbot ou implementar aplicativos em escala empresarial, entender as proteções é essencial pra criar sistemas nos quais os usuários possam confiar.

Se você é novo no mundo da segurança e desenvolvimento de IA, posso recomendar vários dos nossos cursos, incluindo Segurança e Gestão de Riscos em IA, Entendendo a Lei de IA da UEe Engenheiro Associado de IA para Desenvolvedores.

O que são barreiras de proteção de IA?

As barreiras de segurança da IA são mecanismos que monitoram, validam e controlam o comportamento dos sistemas de IA durante todo o seu ciclo de vida.

Gosto de pensar neles como o equivalente aos recursos de segurança de um carro: cintos de segurança, airbags e freios antibloqueio não impedem você de dirigir, mas protegem você quando algo dá errado.

No fundo, as proteções de IA têm três objetivos principais:

- Evitar resultados prejudiciais antes que eles cheguem aos usuários

- Garantindo que a gente siga as regras e normas éticas

- Manter o comportamento consistente do sistema mesmo em casos extremos

Diferente dos filtros de conteúdo simples que só bloqueiam certas palavras, as proteções funcionam em vários níveis, desde validar os dados de entrada até monitorar os resultados do modelo e fazer valer as regras de negócios.

É importante diferenciar as proteções de IA de outros conceitos parecidos.

As ferramentas de moderação de conteúdo geralmente se concentram na filtragem pós-geração, enquanto as proteções funcionam de forma proativa em todo o pipeline de IA.

Da mesma forma, a engenharia imediata orienta o comportamento do modelo por meio de instruções, mas as proteções fornecem restrições aplicáveis que o sistema não pode ignorar.

Com essa compreensão do que são guard-rails, vamos explorar por que eles se tornaram essenciais para a implantação moderna da IA.

Por que as proteções de IA são importantes?

Implementar IA sem proteções traz riscos significativos tanto para os usuários quanto para as organizações.

Para empresas

Para as empresas, multas regulatórias por sistemas que não estão em conformidade, danos à reputação por resultados distorcidos e violações de dados quando os modelos divulgam acidentalmente dados de treinamento são todos problemas potenciais para muitas empresas.

Essa importância é reforçada por estruturas regulatórias, como a Lei de IA da UE e requisitos específicos do setor, como a HIPAA na área da saúde ou o GDPR para proteção de dados, uma vez que criam obrigações legais.

Além da conformidade, existe uma obrigação ética para as organizações usarem a IA de forma responsável, garantindo que os sistemas não perpetuem preconceitos nem criem conteúdo prejudicial.

Para os usuários

Para os usuários finais, os riscos são potencialmente ainda maiores. Uma IA desprotegida no setor de saúde pode literalmente colocar vidas em risco ao fornecer informações médicas imprecisas.

As proteções da IA criam confiança. Os usuários adotam sistemas de IA quando sabem que existem medidas de segurança para evitar erros e proteger seus interesses. Para as organizações, isso significa manter os usuários, a reputação da marca e a adoção sustentável da IA. Sem proteções, um único fracasso de grande visibilidade pode comprometer anos de esforços de desenvolvimento.

O básico das proteções de IA em ação

As barreiras de proteção da IA funcionam restringindo o comportamento da IA por meio de verificações programáticas, regras de validação e sistemas de monitoramento que operam em conjunto com os modelos de IA.

A evolução das barreiras de proteção reflete o próprio desenvolvimento da IA. Os primeiros sistemas baseados em regras dependiam da filtragem por palavras-chave. À medida que os modelos ficaram mais sofisticados, o mesmo aconteceu com as proteções. O surgimento de grandes modelos de linguagem acelerou o desenvolvimento de barreiras de proteção, trazendo novos riscos relacionados a alucinações e injeção de prompts.

As proteções de hoje juntam regras determinísticas com machine learning, criando sistemas de proteção em várias camadas.

Isso levou a uma rica taxonomia de tipos de barreiras de proteção, cada uma abordando aspectos específicos da segurança da IA. Vamos ver essas categorias com mais detalhes.

Tipos de proteções de IA

Entender os diferentes tipos de proteções ajuda você ou sua organização a criar uma proteção completa.

As proteções de IA podem ser categorizadas com base em onde operam na arquitetura do sistema e quais riscos específicos elas abordam. Alguns se concentram em proteger a privacidade dos dados, outros garantem um comportamento adequado do modelo, enquanto outros lidam com questões de implantação e conformidade.

A tabela a seguir mostra as principais categorias de barreiras de proteção, cada uma com um propósito diferente, mas que se complementam na criação de sistemas de IA seguros:

|

Característica |

Foco |

Operação |

Exemplo |

|

Proteção de dados |

Proteja as informações confidenciais |

Detectar e ocultar informações pessoais identificáveis |

Ocultar números de cartão de crédito |

|

Guarda-corpos modelo |

Geração do modelo de controle |

Os filtros de toxicidade bloqueiam conteúdos prejudiciais |

As verificações de fatos confirmam as alegações |

|

Proteções para aplicativos |

Gerenciar interações do usuário |

Gerenciar o fluxo da conversa |

Evite comentários não autorizados |

|

Barreiras de proteção de infraestrutura |

Garanta uma implantação segura |

Monitorar os recursos do sistema |

Implementar controle de acesso |

|

Barreiras de adequação |

Manter os padrões profissionais |

Filtrar assuntos inapropriados |

Ajustar o conteúdo com base na idade |

|

Barreiras de proteção contra alucinações |

Garanta a precisão dos fatos |

Conteúdo gerado por referência cruzada |

Sinalizar alegações não verificáveis |

|

Barreiras de conformidade regulatória |

Atender aos requisitos legais |

Implementar verificações automáticas |

Documentar os processos de tomada de decisão |

|

Guia de alinhamento |

Corresponder à intenção do usuário |

Aplique as diretrizes éticas |

Garanta a consistência com as políticas da empresa. |

|

Barreiras de validação |

Verifique se a saída está correta |

Validar a qualidade dos dados |

Garanta que a saída esteja no formato JSON |

Comparação dos tipos de barreiras de proteção com IA

Esses tipos de barreiras de proteção funcionam juntos para criar uma proteção abrangente para os sistemas de IA. Os controles de dados, modelos e aplicativos são a primeira linha de defesa, funcionando em diferentes etapas do pipeline de IA para detectar problemas antes que eles cheguem aos usuários.

As proteções de infraestrutura e adequação garantem que o sistema funcione de forma segura e profissional em grande escala, enquanto as proteções de alucinação e validação se concentram na precisão e confiabilidade.

As categorias finais, conformidade regulatória e diretrizes de alinhamento, tratam de necessidades organizacionais mais amplas. Eles garantem que os sistemas de IA não só funcionem corretamente, mas também operem dentro dos limites legais e estejam alinhados com os valores da empresa.

Na prática, a maioria dos sistemas de IA de produção implementa vários tipos de proteções ao mesmo tempo, criando uma proteção em camadas que lida com questões técnicas, éticas e legais.

Entender esses tipos é importante, mas, pra realmente implementar as proteções de forma eficaz, precisamos examinar os componentes técnicos que as tornam possíveis.

Arquitetura técnica das proteções de IA

A arquitetura da barreira de proteção geralmente tem quatro partes principais que funcionam juntas para dar uma proteção completa.

O verificador

O verificador analisa entradas ou saídas em relação a critérios definidos: um classificador de toxicidade, um detector de vazamento de dados ou um verificador de factualidade. Os verificadores podem ser sistemas baseados em regras determinísticos ou modelos de machine learning treinados para identificar riscos específicos.

O corretor

Quando um verificador encontra um problema, o corretor decide como resolver isso. Os corretores podem ocultar dados confidenciais, reformular conteúdos problemáticos ou rejeitar o resultado e solicitar uma nova geração. Os corretores simples trocam as informações pessoais identificáveis detectadas por espaços reservados, enquanto os avançados usam modelos de linguagem para reescrever o conteúdo, mantendo o significado.

O trilho

O e eferroviário define as restrições e políticas que os verificadores aplicam. Os rails são especificados em formatos estruturados, como YAML, JSON ou linguagens específicas do domínio, tornando-os fáceis de manter por pessoas que não são da área técnica. Uma diretriz pode dizer que as respostas têm que ter menos de 500 palavras, não podem falar dos concorrentes e precisam manter um tom profissional.

O guarda

Por fim, o guarda coordena o processo, decidindo quando usar quais verificadores, gerenciando o fluxo de trabalho de correção e registrando todas as ações para auditoria.

Barreiras determinísticas e modelos probabilísticos

Tem uma diferença importante entre barreiras determinísticas e modelos probabilísticos. As proteções determinísticas oferecem um comportamento previsível: uma expressão regular para detecção de e-mail sempre dá o mesmo resultado.

Os modelos probabilísticos oferecem uma detecção mais detalhada, mas com incerteza. Os sistemas modernos juntam as duas abordagens para uma proteção ideal.

Com esses componentes arquitetônicos em funcionamento, vamos ver como eles funcionam juntos na prática ao processar solicitações reais.

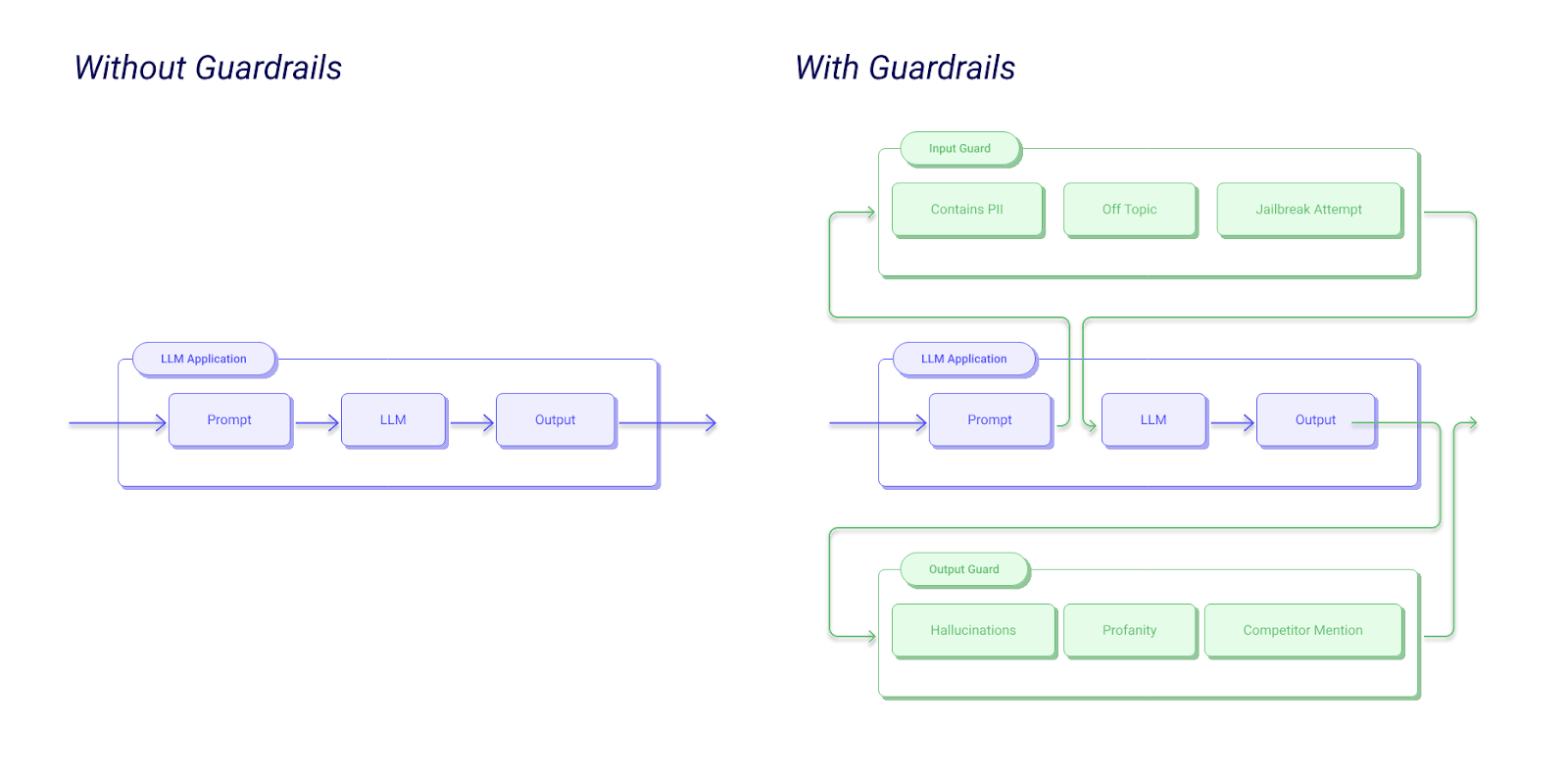

Como funcionam as proteções de IA?

Entender o fluxo de trabalho do guardrail deixa claro como esses componentes funcionam na prática. Quando um usuário manda uma entrada pro seu aplicativo de IA, a solicitação primeiro passa porumas proteções de entrada d , que verificam se tem algum ataque de injeção, conteúdo impróprio ou violação de política.

O modelo gera uma resposta, mas antes de chegar ao usuário, os controles de saída dão uma olhada nela. Vários verificadores funcionam ao mesmo tempo: um valida as afirmações factuais, outro verifica se há vazamento de dados confidenciais e um terceiro garante que o tom seja adequado.

Se algum revisor sinalizar um problema, o corretor tenta corrigir, talvez ocultando informações de identificação pessoal (PII) ou regenerando com restrições mais rigorosas.

Exemplo de fluxo de trabalho da IA Guardrails

Depois da correção, a resposta passa por uma validação final. Se for aprovado, é entregue ao usuário com metadados sobre as proteções aplicadas. Todas as etapas são registradas para monitoramento e conformidade. Se a validação falhar depois de várias tentativas, o sistema vai devolver umaresposta de fallback segura .

Essa abordagem em várias etapas garante proteção abrangente, mantendo uma latência aceitável. Ao paralelizar as verificações e otimizar os modelos, os sistemas de proteção modernos adicionam apenas 50 a 200 milissegundos aos tempos de resposta.

Abordagens para a implementação da barreira de proteção de IA

Existem três abordagens principais para implementar barreiras de proteção, cada uma com vantagens e limitações distintas:

- Os sistemas baseados em regras usam padrões pré-definidos, expressões regulares e lógica determinística. Eles são super interpretáveis. Você sabe exatamente por que o conteúdo foi sinalizado. Eles também são rápidos e baratos de operar. Mas, eles têm dificuldade com as nuances e precisam de manutenção constante, já que a linguagem está sempre mudando.

- Os classificadores de machine learning oferecem detecção sofisticada, aprendendo padrões a partir de dados de treinamento. Um classificador de toxicidade baseado em transformador pode entender o contexto e detectar conteúdos prejudiciais sutis que as regras não detectam. A desvantagem é que fica mais difícil de entender e pode ter falsos positivos. Os classificadores ML também precisam de mais recursos computacionais.

- As abordagens híbridas juntam o que há de melhor dos dois métodos. Você pode usar regras para casos claros, como detecção de PII, e modelos de ML para julgamentos mais sutis, como adequação ou factualidade. É o que eu geralmente recomendo para sistemas de produção.

Além das abordagens técnicas, uma implementação bem-sucedida precisa de equipes multidisciplinares, incluindo especialistas na área, especialistas em ética, consultores jurídicos e engenheiros.

Benefícios das proteções de IA

A essa altura, espero ter deixado claro por que as proteções de IA são importantes, mas vamos recapitular.

Privacidade e segurança

As proteções oferecem mais do que só evitar problemas. Eles aumentam a privacidade e a segurança do usuário, evitando vazamentos de dados antes que eles aconteçam, detectando quando os modelos podem reproduzir dados de treinamento e pegando tentativas de extrair informações confidenciais por meio de injeção de prompt.

Para organizações que lidam com informações pessoais de saúde ou dados financeiros, essas proteções são essenciais.

Conformidade

A conformidade regulatória fica mais fácil de gerenciar com as proteções. Os sistemas garantem automaticamente o direito à explicação previsto no RGPD, registrando as razões por trás das decisões.

Os aplicativos que seguem a HIPAA usam proteções para garantir que as informações de saúde protegidas nunca apareçam nas saídas. Os requisitos da Lei da UE sobre IA para sistemas de IA de alto risco pedem explicitamente medidas técnicas para reduzir os riscos identificados.

Confiança na IA

O mais importante é que as proteções aumentam a confiança dos usuários. Quando os usuários sabem que os sistemas têm proteções, eles ficam mais dispostos a se envolver de verdade. A confiança leva a taxas de adoção mais altas, feedback mais valioso e crescimento sustentável.

Principais plataformas e ferramentas de proteção de IA

Várias plataformas surgiram para simplificar a implementação de guard-rails. Entender suas opções ajuda você a escolher as ferramentas certas para suas necessidades específicas e ambiente técnico.

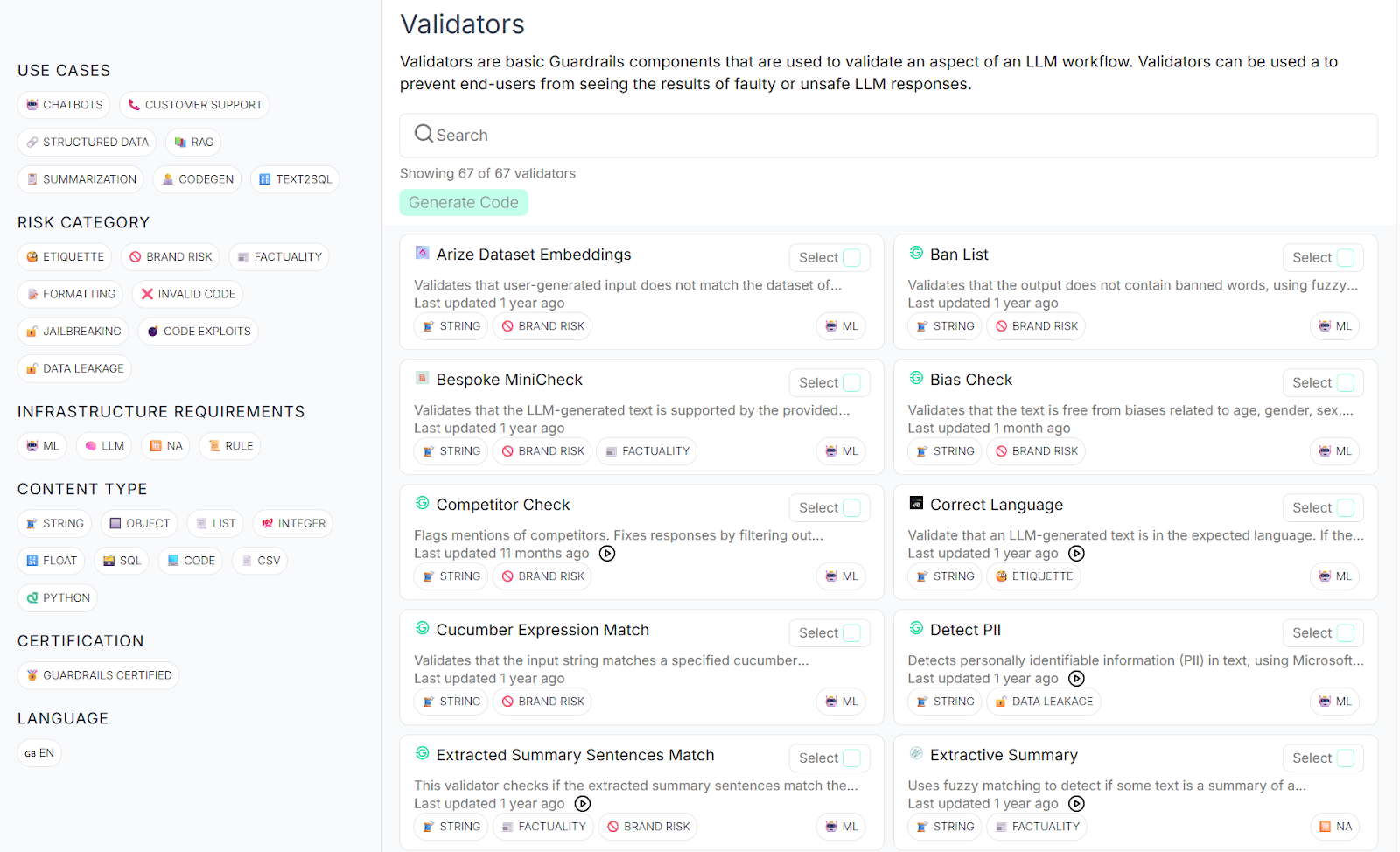

Barreiras de proteção AI

Guardrails AI é uma estrutura de código aberto que chamou bastante a atenção da galera que desenvolve. Acho que isso se deve, em grande parte, ao fato de ele oferecer uma biblioteca extensa de validadores pré-construídos que cobrem riscos comuns, como detecção de PII, filtragem de toxicidade e prevenção de alucinações.

A estrutura usa uma linguagem de especificação chamada RAIL (Reliable AI Markup Language) que permite definir proteções personalizadas de forma declarativa.

O que torna o Guardrails AI especialmente interessante pra mim é a flexibilidade e a capacidade de expansão dele.

Você pode usar um dos vários validadores do Guardrails Hub, integrá-los com provedores populares de LLM, como OpenAI, Anthropic e Cohere, e implementá-los em qualquer lugar onde seus aplicativos funcionem.

A natureza de código aberto significa que você pode dar uma olhada no código, ajudar com melhorias e evitar ficar preso a um único fornecedor. A galera ativa sempre adiciona novos validadores e compartilha padrões de implementação para casos de uso comuns.

Centro de IA Guardrails

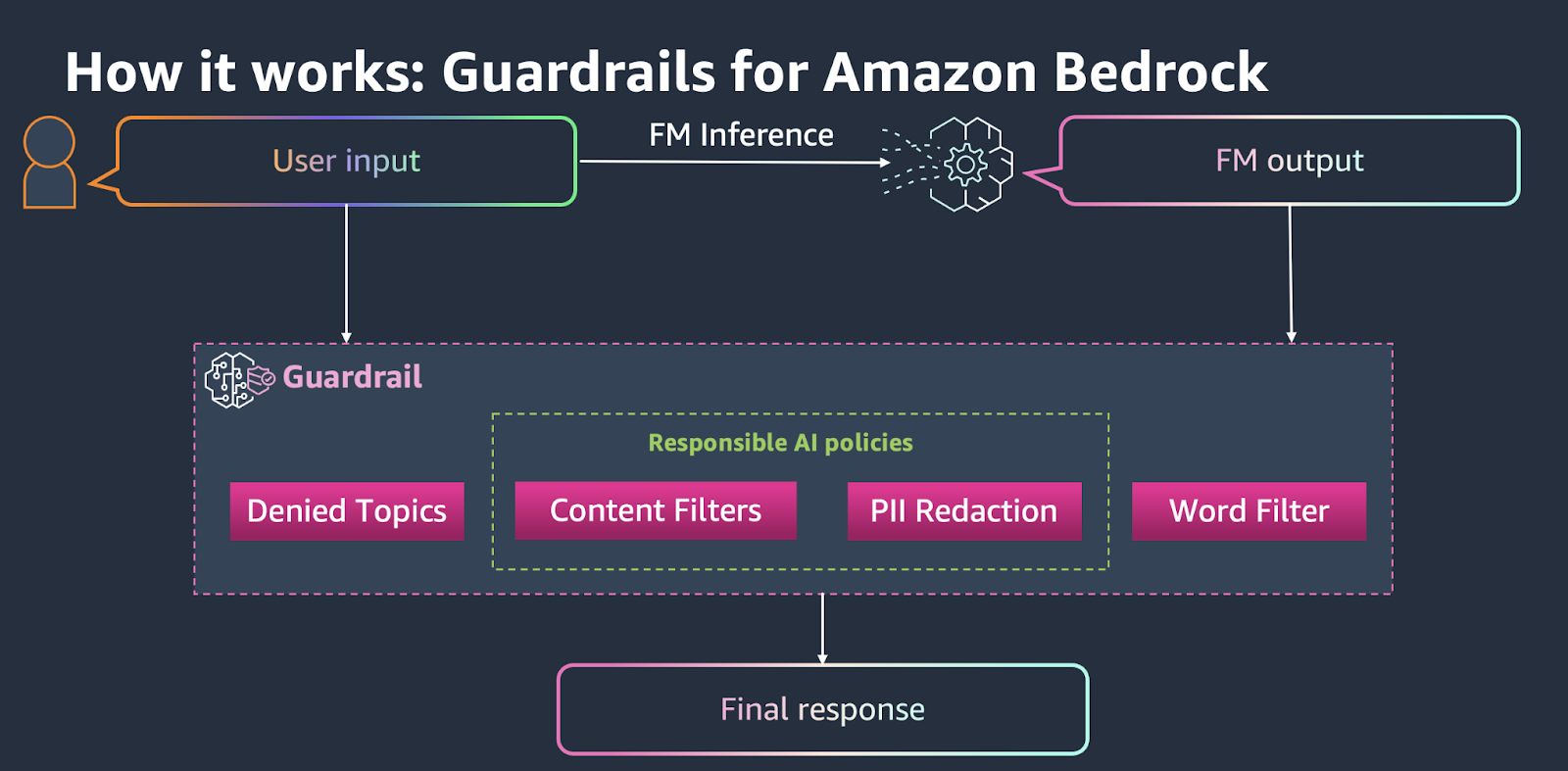

Guia de Proteção Amazon Bedrock

Amazon Bedrock Guardrails adota uma abordagem gerenciada e nativa da nuvem que se integra perfeitamente aos serviços da AWS. Ele oferece políticas pré-configuradas para filtragem de conteúdo, detecção de PII, tópicos negados e filtros de palavras, entre outros.

A plataforma cuida da complexidade da infraestrutura, ajustando automaticamente as proteções com base nos seus padrões de tráfego.

Guia de Proteção Amazon Bedrock

Para equipes que já investiram no ecossistema AWS, você pode descobrir que o Bedrock Guardrails oferece o caminho mais fácil para a produção. Você pode configurar guardrails pelo console ou API da AWS, aplicá-los a qualquer modelo básico no Bedrock e monitorar o desempenho deles pelo CloudWatch.

A desvantagem é que tem menos personalização do que as alternativas de código aberto, mas a facilidade de implantação e o suporte empresarial fazem com que seja uma opção atraente para organizações que priorizam o tempo de lançamento no mercado.

Barreiras de proteção NVIDIA NeMo

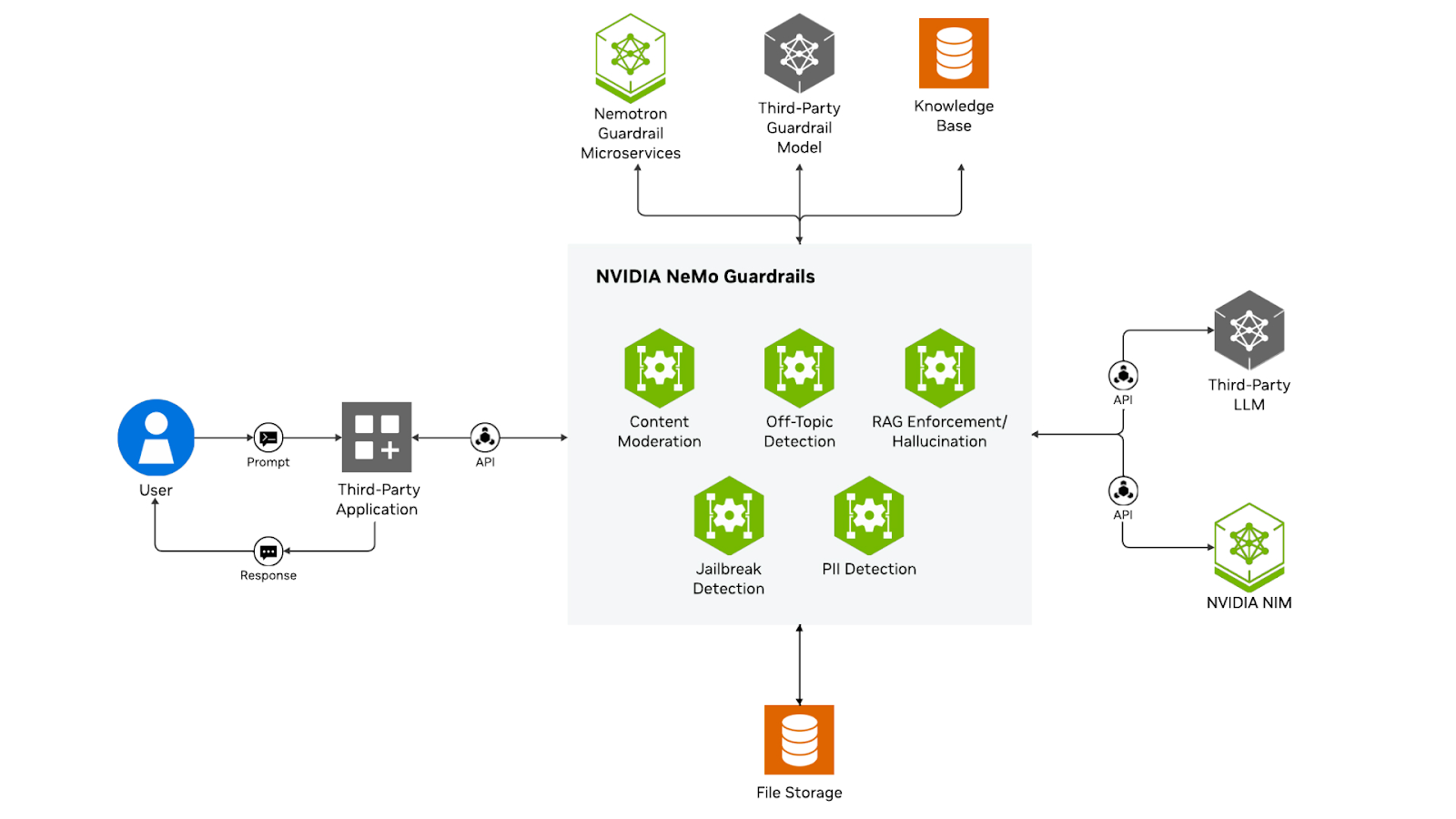

O NVIDIA NeMo Guardrails tem uma abordagem única, focando especificamente na IA conversacional por meio de um modelo de máquina de estados centrado no diálogo. Em vez de só filtrar entradas e saídas, o NeMo gerencia fluxos de conversação inteiros, garantindo que interações com várias respostas sigam caminhos e restrições definidos.

Barreiras de proteção NVIDIA NeMo

A plataforma usa Colang, uma linguagem de modelagem criada especialmente para controlar o comportamento do diálogo. Isso permite que você defina trilhos de conversa que orientam as interações, lidam com o contexto ao longo das rodadas e aplicam a lógica de negócios em conversas prolongadas.

A abordagem da NeMo é especialmente boa para chatbots, assistentes virtuais e aplicativos de atendimento ao cliente, onde manter conversas coerentes e em conformidade com as políticas é mais importante do que a filtragem de uma única resposta.

Segurança de conteúdo do Microsoft Azure AI

O Azure AI Content Safety da Microsoft oferece moderação de conteúdo de nível empresarial, especialmente ajustada para texto, imagens e conteúdo multimodal. A plataforma oferece limites de gravidade personalizáveis em categorias como discurso de ódio, violência, conteúdo sexual e automutilação. Inclui recursos especializados para detectar tentativas de jailbreak e proteger contra ataques de injeção imediata.

O Azure AI Content Safety se integra naturalmente ao Azure OpenAI Service e a outras ofertas do Azure AI, tornando-o uma ótima opção para organizações que usam a nuvem da Microsoft. O serviço fornece pontuações de risco detalhadas em vez de decisões binárias, permitindo que você implemente políticas de moderação diferenciadas com base na sua tolerância ao risco.

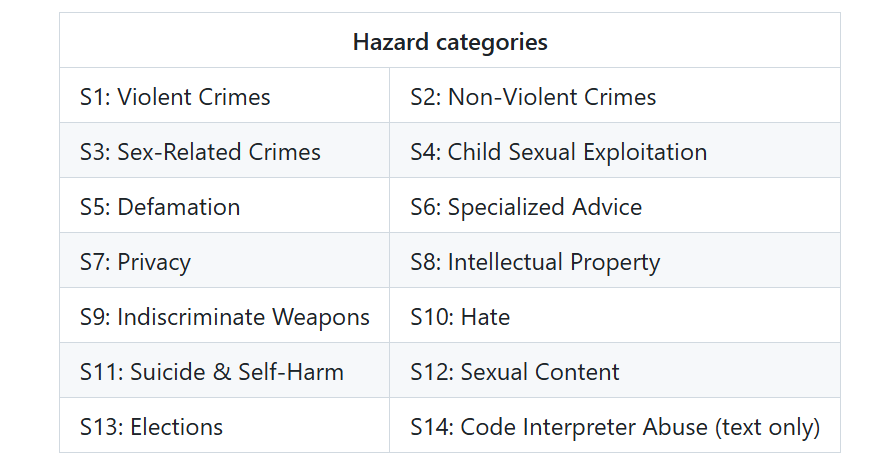

LlamaGuard

O LlamaGuard, desenvolvido pela Meta, representa uma nova geração de modelos de segurança de código aberto. É um modelo LLaMA bem ajustado, treinado especialmente para classificar conteúdos gerados por IA quanto a riscos de segurança. O LlamaGuard fornece resultados seguros/inseguros para suas avaliações de segurança, juntamente com as categorias que violam.

Etiquetas de segurança LlamaGuard 4

Com essas plataformas disponíveis, vamos ver como as organizações de diferentes setores estão usando as proteções em situações reais.

Aplicações reais e casos de uso de barreiras de proteção de IA

Ver as barreiras de proteção em ação em todos os setores mostra o quanto elas são úteis.

Atendimento ao cliente

No atendimento ao cliente, as proteções garantem que os agentes de IA mantenham um tom profissional, nunca façam compromissos não autorizados e escalem adequadamente quando enfrentarem questões complexas. Uma empresa de telecomunicações criou um sistema que detecta clientes irritados e encaminha automaticamente as conversas para atendentes humanos.

Saúde

Os aplicativos de saúde têm que seguir regras bem rígidas. As proteções nos sistemas de IA médica evitam diagnósticos de sistemas sem licença, garantem que os tratamentos recomendados sigam as diretrizes baseadas em evidências e protegem a privacidade dos dados dos pacientes. Um sistema de correspondência de ensaios clínicos usa proteções para garantir que as informações dos pacientes nunca vazem nas explicações.

Pesquisa

Na pesquisa acadêmica, as proteções equilibram a segurança com a liberdade acadêmica. Os assistentes de pesquisa devem evitar o plágio, citar corretamente as fontes e manter um tom acadêmico sem serem excessivamente restritivos.

Segurança cibernética

Para a segurança cibernética e os fluxos de trabalho corporativos, as proteções protegem contra ataques de injeção imediata, impedem a execução de códigos não seguros e mantêm trilhas de auditoria para conformidade. Uma empresa de serviços financeiros usa proteções para garantir que os assistentes de IA nunca revelem estratégias de negociação exclusivas, mas ainda assim forneçam análises úteis.

Conformidade regulatória e governança

Entender o cenário regulatório ajuda você a criar proteções que cumprem os requisitos legais. A Lei da IA da UE classifica os sistemas de IA por nível de risco e exige medidas técnicas de proteção para aplicações de alto risco nas áreas de emprego, educação, aplicação da lei ou infraestruturas críticas. A lei exige especificamente medidas de mitigação de riscos, recursos de supervisão humana e mecanismos de transparência.

Regulamentos de proteção de dados como o GDPR e o HIPAA criam requisitos específicos de proteção. O princípio de minimização de dados do GDPR exige medidas de proteção que evitem a coleta e o processamento desnecessários de dados. A regra de segurança da HIPAA exige proteções para informações eletrônicas de saúde protegidas.

As novas estruturas de governança dão ênfase ao monitoramento e à adaptação contínuos. A NIST AI Risk Management Framework incentiva as organizações a implementar controles técnicos como parte de uma estratégia de governança mais ampla.

Conclusão

Como tentei mostrar, as barreiras de segurança da IA são uma parte essencial da implementação responsável da IA. Eles transformam a IA de sistemas imprevisíveis em ferramentas confiáveis nas quais as organizações e os usuários podem confiar. Ao longo deste tutorial, eu explorei o que são guardrails, por que eles são importantes e como implementá-los de forma eficaz.

A principal lição é que as proteções não servem para limitar as capacidades da IA. Trata-se de canalizar essas capacidades de forma segura e produtiva. Ao criar sistemas de IA, recomendo que você considere as proteções como uma prioridade desde o início. Comece com políticas claras, implemente proteções modulares e refine continuamente com base no feedback do mundo real.

O campo continua evoluindo, com novas ferramentas, técnicas e melhores práticas surgindo regularmente. Mantenha-se envolvido com a comunidade, experimente diferentes abordagens e compartilhe seus aprendizados. Juntos, podemos criar sistemas de IA que não só são poderosos, mas também seguros, confiáveis e dignos de confiança.

Para continuar aprendendo, recomendo os seguintes recursos:

Perguntas frequentes sobre as proteções de IA

O que são barreiras de proteção de IA?

As barreiras de segurança da IA são mecanismos que monitoram, validam e controlam o comportamento dos sistemas de IA durante todo o seu ciclo de vida, evitando resultados prejudiciais e garantindo a conformidade com os padrões éticos.

Que tipos de barreiras de proteção para IA existem?

Os principais tipos incluem proteções de dados (protegendo informações confidenciais), proteções de modelos (controlando a geração), proteções de aplicativos (gerenciando interações), proteções de infraestrutura (garantindo uma implantação segura) e proteções de conformidade regulatória (suportando requisitos legais).

Quais plataformas oferecem soluções de proteção com IA?

As principais plataformas incluem Guardrails AI (código aberto), Amazon Bedrock Guardrails (nativa da nuvem), NVIDIA NeMo Guardrails (focada em diálogo), Microsoft Azure AI Content Safety e LlamaGuard.

Como as barreiras de proteção afetam o desempenho do sistema de IA?

As proteções adicionam 50 a 200 milissegundos de latência e aumentam os custos computacionais, mas o cache inteligente, a validação assíncrona e a verificação em camadas minimizam o impacto no desempenho, mantendo a proteção.

As barreiras de proteção de IA são exigidas por lei?

Sim, em muitos casos. A Lei de IA da UE exige medidas de proteção para sistemas de IA de alto risco, enquanto regulamentos como o GDPR e o HIPAA exigem salvaguardas específicas para a proteção de dados e conformidade com a privacidade.

Como fundador da Martin Data Solutions e cientista de dados freelancer, engenheiro de ML e IA, tenho um portfólio diversificado em regressão, classificação, PNL, LLM, RAG, redes neurais, métodos de conjunto e visão computacional.

- Desenvolveu com sucesso vários projetos de ML de ponta a ponta, incluindo limpeza de dados, análise, modelagem e implantação no AWS e no GCP, fornecendo soluções impactantes e dimensionáveis.

- Criou aplicativos da Web interativos e dimensionáveis usando Streamlit e Gradio para diversos casos de uso do setor.

- Ensinou e orientou alunos em ciência e análise de dados, promovendo seu crescimento profissional por meio de abordagens de aprendizagem personalizadas.

- Projetou o conteúdo do curso para aplicativos RAG (retrieval-augmented generation) adaptados aos requisitos da empresa.

- Criou blogs técnicos de IA e ML de alto impacto, abordando tópicos como MLOps, bancos de dados vetoriais e LLMs, obtendo um envolvimento significativo.

Em cada projeto que assumo, certifico-me de aplicar práticas atualizadas em engenharia de software e DevOps, como CI/CD, code linting, formatação, monitoramento de modelos, rastreamento de experimentos e tratamento robusto de erros. Tenho o compromisso de fornecer soluções completas, transformando insights de dados em estratégias práticas que ajudam as empresas a crescer e tirar o máximo proveito da ciência de dados, do machine learning e da IA.