Lernpfad

Da KI-Systeme immer mehr in wichtige Anwendungen eingebaut werden, habe ich gesehen, welche Probleme Unternehmen haben, um sicherzustellen, dass die Modelle sicher und zuverlässig funktionieren. Ein Kundenservice-Chatbot, der private Infos weitergibt, eine KI im Gesundheitswesen, die gefährliche medizinische Ratschläge gibt, oder ein Finanzassistent, der voreingenommene Empfehlungen macht. Das sind keine hypothetischen Szenarien. Es gibt echte Risiken, die das Vertrauen zerstören, gegen Vorschriften verstoßen und den Nutzern schaden.

Die schnelle Verbreitung von großen Sprachmodellen (LLMs) hat diese Bedenken noch verstärkt. Diese leistungsstarken Systeme können zwar menschenähnliche Texte erstellen und komplizierte Probleme lösen, aber sie können auch schädliche Inhalte produzieren, vertrauliche Infos weitergeben oder überzeugende, aber falsche Infos generieren. Ohne die richtigen Sicherheitsmaßnahmen setzen sich Unternehmen großen rechtlichen, ethischen und Reputationsrisiken aus.

In diesem Tutorial erkläre ich dir, was KI-Leitplanken sind, warum sie wichtig sind und wie man sie effektiv einsetzt. Egal, ob du deinen ersten Chatbot entwickelst oder Anwendungen für Unternehmen einsetzt – du musst die Sicherheitsvorkehrungen verstehen, um Systeme zu erstellen, denen die Nutzer vertrauen können.

Wenn du dich noch nicht so gut mit KI-Sicherheit und -Entwicklung auskennst, kann ich dir ein paar unserer Kurse empfehlen, darunter KI-Sicherheit und Risikomanagement, Das EU-KI-Gesetz verstehenund Associate AI Engineer für Entwickler.

Was sind KI-Leitplanken?

KI-Sicherheitsvorkehrungen sind Mechanismen, die das Verhalten von KI-Systemen während ihres ganzen Lebenszyklus überwachen, überprüfen und steuern.

Ich sehe sie als so was wie die Sicherheitsfeatures in einem Auto: Sicherheitsgurte, Airbags und Antiblockiersysteme halten dich nicht vom Fahren ab, aber sie schützen dich, wenn was schiefgeht.

Im Grunde haben KI-Sicherheitsvorkehrungen drei Hauptzwecke:

- Verhindern, dass schädliche Inhalte die Nutzer erreichen

- Sicherstellen, dass ethische Standards und Vorschriften eingehalten werden

- Auch in Ausnahmesituationen ein gleichbleibendes Systemverhalten sicherstellen

Im Gegensatz zu einfachen Inhaltsfiltern, die nur bestimmte Wörter blockieren, funktionieren Guardrails auf mehreren Ebenen, von der Validierung von Eingabedaten bis zur Überwachung von Modellausgaben und der Durchsetzung von Geschäftsregeln.

Es ist wichtig, KI-Leitplanken von ähnlichen Konzepten zu unterscheiden.

Tools zur Inhaltsmoderation kümmern sich meistens um die Filterung nach der Erstellung, während Schutzvorrichtungen schon vorher in der KI-Pipeline aktiv werden.

Genauso wie Prompt Engineering das Verhalten von Modellen durch Anweisungen steuert, setzen Guardrails durchsetzbare Einschränkungen, die das System nicht umgehen kann.

Nachdem wir jetzt wissen, was Leitplanken sind, schauen wir mal, warum sie für den Einsatz moderner KI so wichtig geworden sind.

Warum sind KI-Sicherheitsvorkehrungen wichtig?

KI ohne Sicherheitsvorkehrungen einzusetzen, ist für Nutzer und Unternehmen ziemlich riskant.

Für Unternehmen

Für Unternehmen sind Bußgelder wegen nicht konformer Systeme, Reputationsschäden durch verzerrte Ergebnisse und Datenverstöße, wenn Modelle versehentlich Trainingsdaten freigeben, potenzielle Probleme für viele Firmen.

Diese Bedeutung wird durch Regulierungsrahmen wie das EU-KI-Gesetz und branchenspezifische Anforderungen wie HIPAA im Gesundheitswesen oder die DSGVO für den Datenschutz, die rechtliche Verpflichtungen schaffen.

Über die Einhaltung von Vorschriften hinaus gibt es für Unternehmen eine ethische Verpflichtung, KI verantwortungsbewusst einzusetzen und sicherzustellen, dass die Systeme keine Vorurteile weitergeben oder schädliche Inhalte erzeugen.

Für Nutzer

Für Endnutzer sind die Risiken möglicherweise sogar noch größer. Eine ungeschützte KI im Gesundheitswesen könnte durch die Bereitstellung ungenauer medizinischer Informationen buchstäblich Leben gefährden.

KI-Leitplanken schaffen Vertrauen. Leute nutzen KI-Systeme, wenn sie wissen, dass es Sicherheitsmaßnahmen gibt, die Fehler verhindern und ihre Interessen schützen. Für Unternehmen heißt das: Kundenbindung, guter Ruf der Marke und nachhaltige Einführung von KI. Ohne Leitplanken kann ein einziger öffentlichkeitswirksamer Misserfolg jahrelange Entwicklungsarbeit zunichte machen.

Die Grundlagen von KI-Sicherheitsvorkehrungen in der Praxis

KI-Sicherheitsvorkehrungen funktionieren, indem sie das KI-Verhalten durch programmierte Überprüfungen, Validierungsregeln und Überwachungssysteme einschränken, die zusammen mit KI-Modellen laufen.

Die Entwicklung von Leitplanken spiegelt die Entwicklung der KI wider. Frühe regelbasierte Systeme haben sich auf die Filterung von Schlüsselwörtern verlassen. Mit der zunehmenden Komplexität der Modelle wurden auch die Sicherheitsvorkehrungen immer ausgefeilter. Das Aufkommen großer Sprachmodelle hat die Entwicklung von Schutzmaßnahmen beschleunigt, was neue Risiken in Bezug auf Halluzinationen und Prompt-Injektionen mit sich gebracht hat.

Die heutigen Schutzvorrichtungen kombinieren feste Regeln mit maschinellem Lernen und bilden so mehrschichtige Schutzsysteme.

Das hat zu einer umfangreichen Klassifizierung von Schutzmaßnahmen geführt, die sich jeweils mit bestimmten Aspekten der KI-Sicherheit befassen. Schauen wir uns diese Kategorien mal genauer an.

Arten von KI-Sicherheitsvorkehrungen

Wenn du die verschiedenen Arten von Schutzvorrichtungen verstehst, kannst du oder deine Organisation einen umfassenden Schutz aufbauen.

KI-Sicherheitsvorkehrungen kann man danach einteilen, wo sie in der Systemarchitektur eingesetzt werden und welche spezifischen Risiken sie abdecken. Einige kümmern sich um den Datenschutz, andere sorgen dafür, dass die Modelle richtig funktionieren, und wieder andere kümmern sich um die Bereitstellung und die Einhaltung von Vorschriften.

Die folgende Tabelle zeigt die wichtigsten Kategorien von Schutzmaßnahmen, die alle unterschiedliche, aber sich ergänzende Zwecke bei der Entwicklung sicherer KI-Systeme erfüllen:

|

Charakteristisch |

Fokus |

Betrieb |

Beispiel |

|

Datenschutzrichtlinien |

Schütze sensible Infos |

Persönliche Daten erkennen und schwärzen |

Kreditkartennummern maskieren |

|

Modellgeländer |

Steuerungsmodellgenerierung |

Toxizitätsfilter halten schädliche Inhalte fern |

Faktenchecks überprüfen Behauptungen |

|

Anwendungsrichtlinien |

Benutzerinteraktionen verwalten |

Den Gesprächsfluss steuern |

Verhindere unerwünschte Kommentare |

|

Infrastruktur-Leitplanken |

Sicheres Deployment sicherstellen |

Systemressourcen überwachen |

Zugangskontrolle einrichten |

|

Angemessenheitssicherheitsvorkehrungen |

Halt dich an die professionellen Standards |

Unangemessene Themen filtern |

Inhalt je nach Alter anpassen |

|

Halluzinationen-Leitplanken |

Stell sicher, dass alles richtig ist |

Querverweis generierter Inhalt |

Nicht überprüfbare Behauptungen melden |

|

Regulatorische Compliance-Leitplanken |

Unterstützung gesetzlicher Anforderungen |

Automatische Kontrollen einführen |

Entscheidungsprozesse dokumentieren |

|

Ausrichtung von Leitplanken |

Nutzerabsicht abgleichen |

Ethische Richtlinien durchsetzen |

Sicherstellen, dass alles mit den Unternehmensrichtlinien übereinstimmt |

|

Validierungsleitplanken |

Überprüfe, ob die Ausgabe richtig ist. |

Datenqualität überprüfen |

Stell sicher, dass die Ausgabe im JSON-Format ist. |

Vergleich der AI-Leitplankentypen

Diese Arten von Leitplanken sorgen zusammen für einen umfassenden Schutz von KI-Systemen. Daten-, Modell- und Anwendungssicherheitsvorkehrungen sind die erste Verteidigungslinie. Sie greifen an verschiedenen Stellen der KI-Pipeline ein, um Probleme zu erkennen, bevor sie die Nutzer erreichen.

Infrastruktur und Angemessenheits-Sicherheitsvorkehrungen sorgen dafür, dass das System sicher und professionell in großem Maßstab läuft, während Halluzinations- und Validierungs-Sicherheitsvorkehrungen sich auf Genauigkeit und Zuverlässigkeit konzentrieren.

Die letzten Kategorien, die Einhaltung von Vorschriften und die Ausrichtung von Leitplanken, kümmern sich um die größeren organisatorischen Bedürfnisse. Sie sorgen dafür, dass KI-Systeme nicht nur richtig funktionieren, sondern auch innerhalb der gesetzlichen Grenzen bleiben und mit den Unternehmenswerten übereinstimmen.

In der Praxis setzen die meisten KI-Systeme in der Produktion mehrere Arten von Schutzvorrichtungen gleichzeitig ein, um einen mehrschichtigen Schutz zu schaffen, der technische, ethische und rechtliche Bedenken berücksichtigt.

Es ist wichtig, diese Typen zu verstehen, aber um Schutzvorrichtungen wirklich effektiv einzusetzen, müssen wir uns die technischen Bausteine anschauen, die sie möglich machen.

Technische Architektur von KI-Sicherheitsvorkehrungen

Die Leitplankenarchitektur besteht normalerweise aus vier Hauptkomponenten, die zusammenarbeiten, um umfassenden Schutz zu bieten.

Der Prüfer

Der Checker checkt Eingaben oder Ausgaben anhand von festgelegten Kriterien: einem Toxizitätsklassifizierer, einem Datenleckdetektor oder einem Faktenprüfer. Checker können entweder auf festen Regeln basieren oder es sind Modelle, die mit maschinellem Lernen trainiert wurden, um bestimmte Risiken zu erkennen.

Der Korrektor

Wenn ein Prüfer ein Problem findet, entscheidet der Korrektur, wie damit umgegangen wird. Korrektoren können sensible Daten verdecken, problematische Inhalte umformulieren oder die Ausgabe ablehnen und eine Neugenerierung verlangen. Einfache Korrekturprogramme ersetzen gefundene personenbezogene Daten durch Platzhalter, während die fortgeschrittenen Sprachmodelle nutzen, um Inhalte umzuschreiben, ohne dass die Bedeutung verloren geht.

Die Schiene

Der Rail- -Framework legt die Einschränkungen und Richtlinien fest, die von den Checkern durchgesetzt werden. Rails werden in strukturierten Formaten wie YAML, JSON oder domänenspezifischen Sprachen festgelegt, sodass auch Leute ohne technischen Hintergrund damit umgehen können. Eine Vorgabe könnte lauten, dass Beiträge weniger als 500 Wörter haben müssen, keine Konkurrenten erwähnen dürfen und einen professionellen Ton beibehalten müssen.

Der Wachmann

Schließlich ist die Wächter den Prozess, entscheidet, wann welche Prüfer eingesetzt werden, kümmert sich um den Korrektur-Workflow und protokolliert alle Aktionen für die Prüfung.

Deterministische Leitplanken und Wahrscheinlichkeitsmodelle

Es gibt einen wichtigen Unterschied zwischen festen Regeln und Modellen, die auf Wahrscheinlichkeiten basieren. Deterministische Leitplanken sorgen für vorhersehbares Verhalten: Ein regulärer Ausdruck zur E-Mail-Erkennung liefert immer das gleiche Ergebnis.

Probabilistische Modelle bieten eine differenzierte Erkennung, aber mit Unsicherheit. Moderne Systeme bringen beide Ansätze zusammen, um optimalen Schutz zu bieten.

Nachdem wir jetzt diese Architekturkomponenten haben, schauen wir mal, wie sie in der Praxis zusammenarbeiten, wenn sie echte Anfragen bearbeiten.

Wie funktionieren KI-Sicherheitsvorkehrungen?

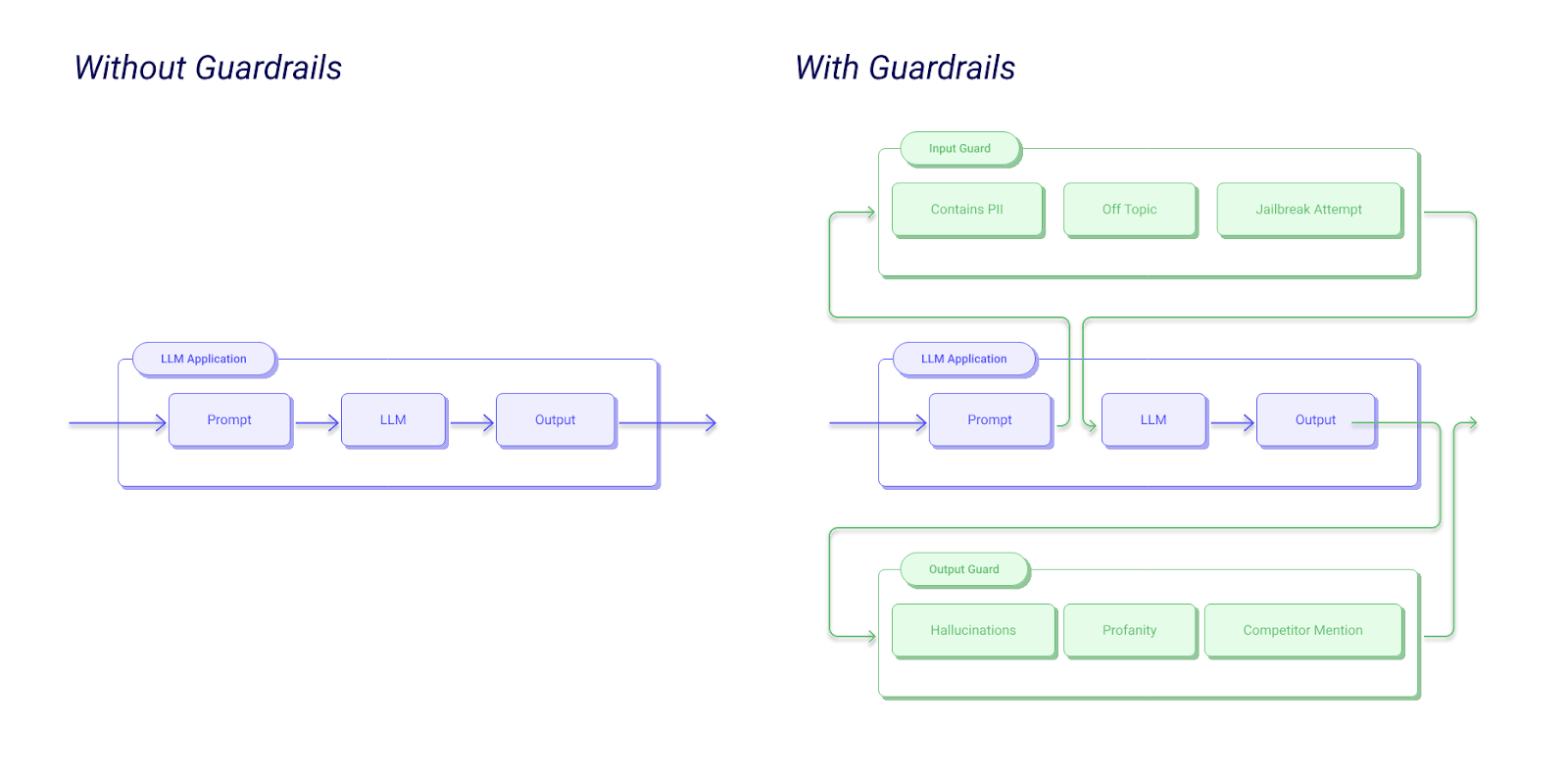

Wenn man den Guardrail-Workflow versteht, wird klar, wie diese Teile in der Praxis funktionieren. Wenn jemand was in deine KI-App eingibt, wird die Anfrage erst mal durchdie Eingabeschutzmechanismen von geschleust, die die Eingabe auf Injektionsangriffe, unpassende Inhalte oder Verstöße gegen Richtlinien checken.

Das Modell macht eine Antwort, aber bevor sie beim Nutzer ankommt, checktdas Output Guardrails-, ob alles okay ist. Mehrere Prüfer arbeiten gleichzeitig: Einer checkt, ob die Fakten stimmen, ein anderer schaut nach, ob sensible Daten durchs Netz gehen, und ein dritter passt auf, dass alles in einem angemessenen Ton gesagt wird.

Wenn ein Prüfer ein Problem meldet, versucht der Korrektor versucht, das Problem zu beheben, indem er beispielsweise personenbezogene Daten maskiert oder unter strengeren Auflagen neu generiert.

Beispiel-Workflow für Guardrails AI

Nach der Korrektur wird die Antwort noch mal überprüft, . Wenn es durchkommt, wird es dem Nutzer mit Infos zu den eingesetzten Schutzmaßnahmen zugestellt. Alle Schritte werden für die Überwachung und Einhaltung der Vorschriften protokolliert. Wenn die Validierung nach mehreren Versuchen nicht klappt, gibt das System einesichere Fallback-Antwort „ “ zurück.

Dieser mehrstufige Ansatz sorgt für umfassenden Schutz und hält gleichzeitig die Latenz in Grenzen. Durch die Parallelisierung von Prüfungen und die Optimierung von Modellen verlängern moderne Guardrail-Systeme die Reaktionszeiten nur um 50 bis 200 Millisekunden.

Ansätze zur Umsetzung von KI-Leitplanken

Es gibt drei Hauptansätze für die Umsetzung von Leitplanken, die alle ihre eigenen Vorteile und Einschränkungen haben:

- Regelbasierte Systeme nutzen vordefinierte Muster, reguläre Ausdrücke und deterministische Logik. Die sind echt gut zu verstehen. Du weißt genau, warum der Inhalt gemeldet wurde. Außerdem sind sie schnell und günstig im Betrieb. Allerdings haben sie Probleme mit Nuancen und müssen ständig aktualisiert werden, weil sich Sprachen weiterentwickeln.

- Maschinelle Lernklassifikatoren bieten eine ausgeklügelte Erkennung, indem sie Muster aus Trainingsdaten lernen. Ein Transformator-basierter Toxizitätsklassifikator kann den Kontext verstehen und subtile schädliche Inhalte erkennen, die von Regeln übersehen werden. Der Nachteil ist, dass es schwerer zu verstehen ist und man falsche positive Ergebnisse kriegen kann. ML-Klassifikatoren brauchen auch mehr Rechenleistung.

- Hybride Ansätze bringen die Vorteile beider Methoden zusammen. Du kannst Regeln für eindeutige Fälle wie die Erkennung personenbezogener Daten und ML-Modelle für differenzierte Beurteilungen wie Angemessenheit oder Sachlichkeit verwenden. Das empfehle ich normalerweise für Produktionssysteme.

Neben den technischen Sachen braucht man für eine erfolgreiche Umsetzung auch Teams aus verschiedenen Bereichen, wie Experten, Ethiker, Juristen und Ingenieure.

Vorteile von KI-Sicherheitsvorkehrungen

Ich hoffe, ich habe inzwischen deutlich gemacht, warum KI-Sicherheitsvorkehrungen wichtig sind, aber lass uns noch mal zusammenfassen.

Datenschutz und Sicherheit

Geländer sind mehr als nur eine Möglichkeit, Probleme zu vermeiden. Sie machen die Privatsphäre und Sicherheit der Nutzer besser, indem sie Datenlecks verhindern, bevor sie passieren, erkennen, wenn Modelle Trainingsdaten reproduzieren könnten, und Versuche abfangen, sensible Infos durch Prompt-Injection zu extrahieren.

Für Unternehmen, die mit persönlichen Gesundheitsdaten oder Finanzdaten arbeiten, sind diese Schutzmaßnahmen echt wichtig.

Compliance

Mit Leitplanken wird die Einhaltung von Vorschriften einfacher. Die Systeme setzen das Recht auf Erklärung der DSGVO automatisch durch, indem sie die Gründe für Entscheidungen protokollieren.

HIPAA-konforme Anwendungen nutzen Schutzmaßnahmen, um sicherzustellen, dass geschützte Gesundheitsdaten nie in den Ausgaben auftauchen. Die EU-KI-Gesetzesvorschriften für risikoreiche KI-Systeme verlangen ausdrücklich technische Maßnahmen, um die erkannten Risiken zu verringern.

Vertrauen in KI

Vor allem aber stärken Leitplanken das Vertrauen der Nutzer. Wenn Leute wissen, dass Systeme sicher sind, sind sie eher bereit, sich echt einzubringen. Vertrauen führt zu höheren Akzeptanzraten, wertvollerem Feedback und nachhaltigem Wachstum.

Führende KI-Guardrail-Plattformen und -Tools

Es gibt jetzt mehrere Plattformen, die die Umsetzung von Leitplanken einfacher machen. Wenn du deine Optionen kennst, kannst du die richtigen Tools für deine speziellen Anforderungen und deine technische Umgebung auswählen.

Geländer KI

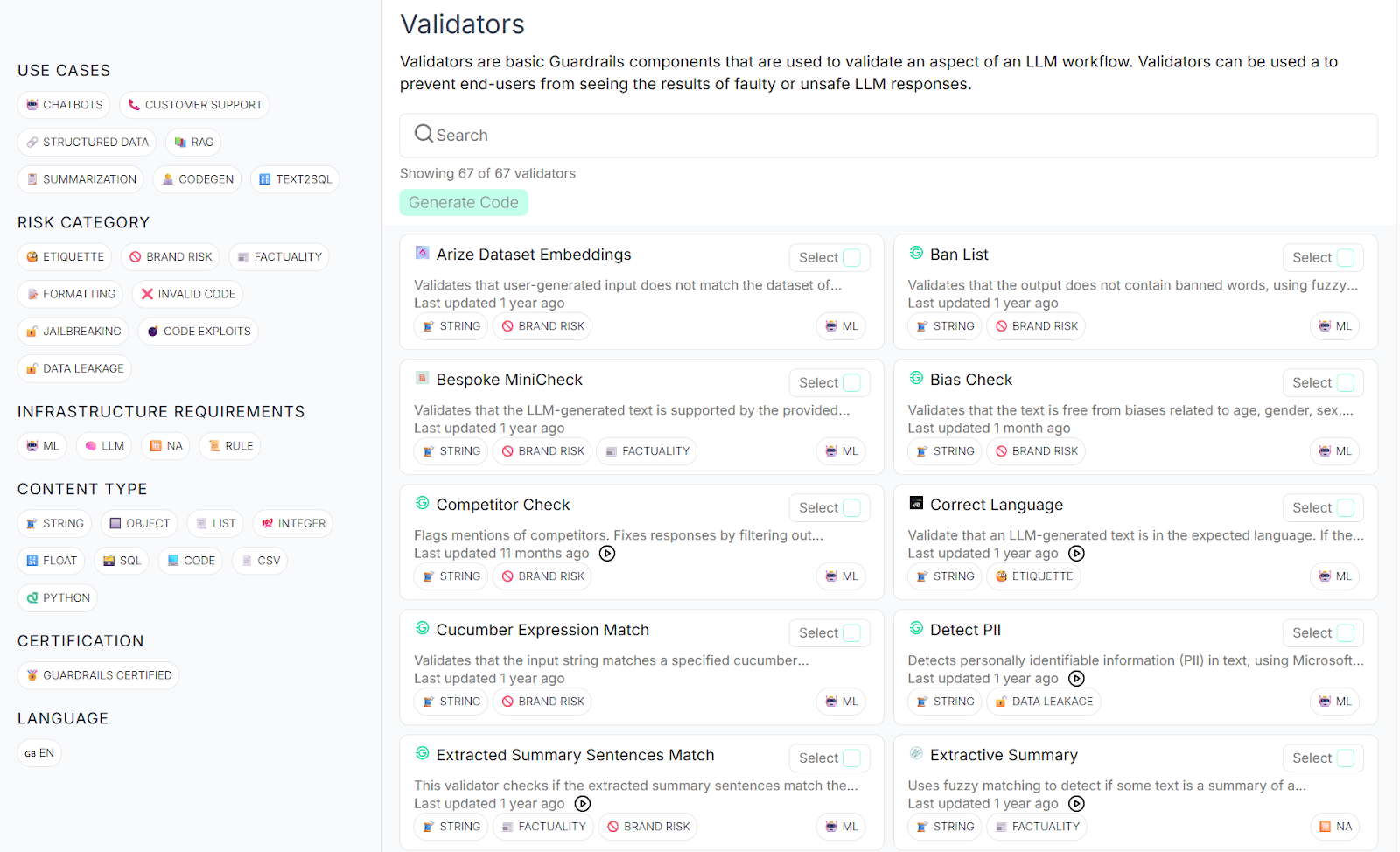

Guardrails AI ist ein Open-Source-Framework, das in der Entwickler-Community ziemlich viel Aufmerksamkeit bekommen hat. Ich denke, das liegt vor allem daran, dass es eine umfangreiche Bibliothek mit vorgefertigten Validatoren bietet, die gängige Risiken wie die Erkennung personenbezogener Daten, die Filterung toxischer Inhalte und die Verhinderung von Halluzinationen abdecken.

Das Framework nutzt eine Spezifikationssprache namens RAIL (Reliable AI Markup Language) und lässt dich damit benutzerdefinierte Schutzvorrichtungen auf deklarative Weise festlegen.

Was Guardrails AI für mich besonders cool macht, ist seine Flexibilität und Erweiterbarkeit.

Du kannst einen der vielen Validatoren von ihrem Guardrails Hubverwenden, sie mit beliebten LLM-Anbietern wie OpenAI, Anthropic und Cohere integrieren und überall dort einsetzen, wo deine Anwendungen laufen.

Da es sich um Open Source handelt, kannst du den Code anschauen, Verbesserungen vorschlagen und dich nicht an einen bestimmten Anbieter binden. Die aktive Community holt immer wieder neue Validatoren dazu und tauscht sich über Implementierungsmuster für gängige Anwendungsfälle aus.

Guardrails KI-Hub

Amazon Bedrock-Sicherheitsvorkehrungen

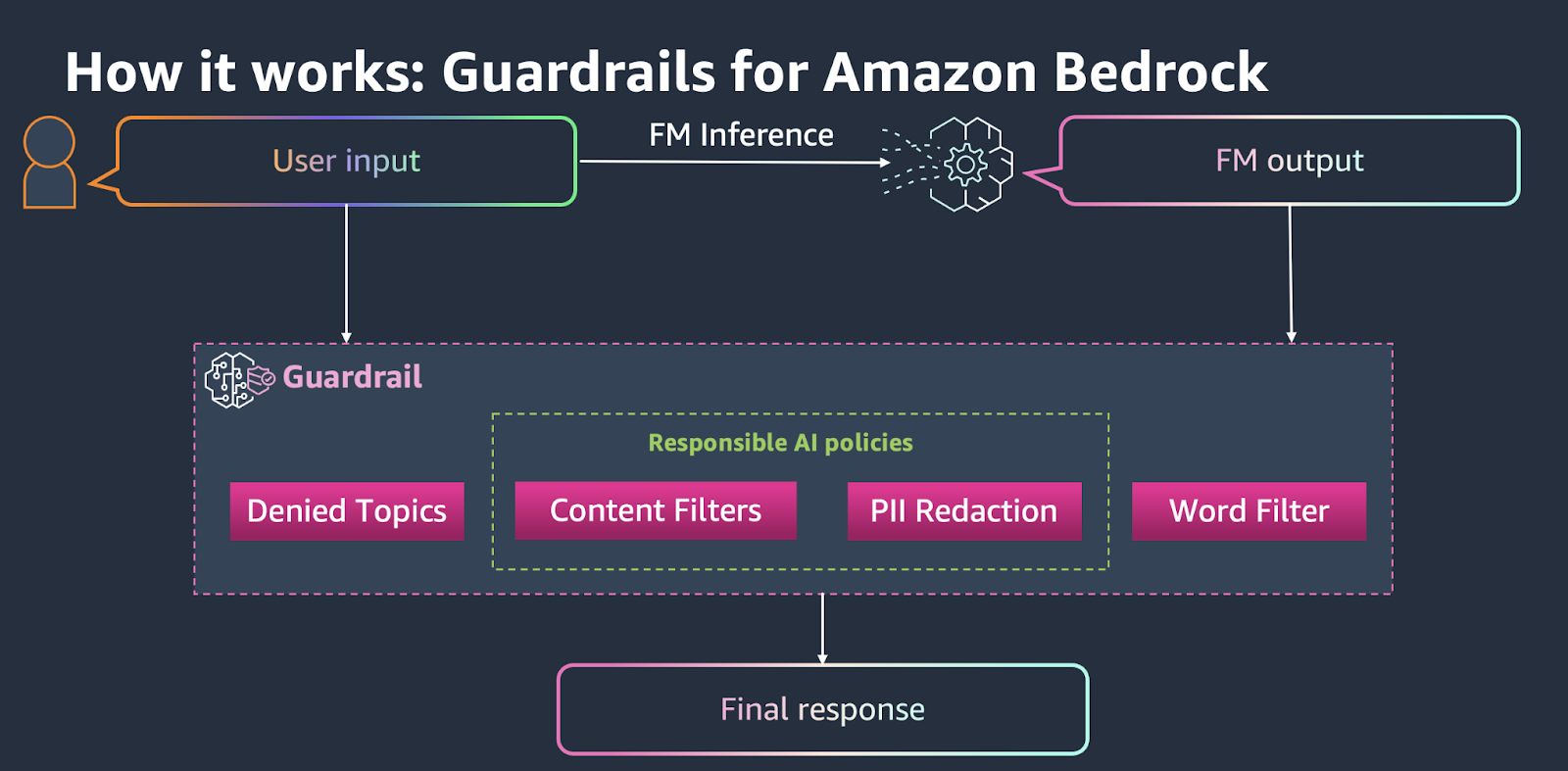

Amazon Bedrock Guardrails nutzt einen verwalteten, cloud-nativen Ansatz, der sich nahtlos in AWS-Dienste einfügt. Es gibt vorgefertigte Richtlinien für Sachen wie Inhaltsfilterung, Erkennung von personenbezogenen Daten, verbotene Themen und Wortfilter.

Die Plattform kümmert sich um die ganze Infrastruktur und passt die Sicherheitsmaßnahmen automatisch an deine Traffic-Muster an.

Amazon Bedrock-Sicherheitsvorkehrungen

Für Teams, die schon im AWS-Ökosystem investiert haben, könnte Bedrock Guardrails der reibungsloseste Weg zur Produktion sein. Du kannst Guardrails über die AWS-Konsole oder API einrichten, sie auf jedes Foundation-Modell auf Bedrock anwenden und ihre Leistung über CloudWatch im Auge behalten.

Der Nachteil ist, dass man im Vergleich zu Open-Source-Alternativen weniger Anpassungsmöglichkeiten hat, aber die einfache Bereitstellung und der Support für Unternehmen machen es attraktiv für Firmen, die Wert auf eine schnelle Markteinführung legen.

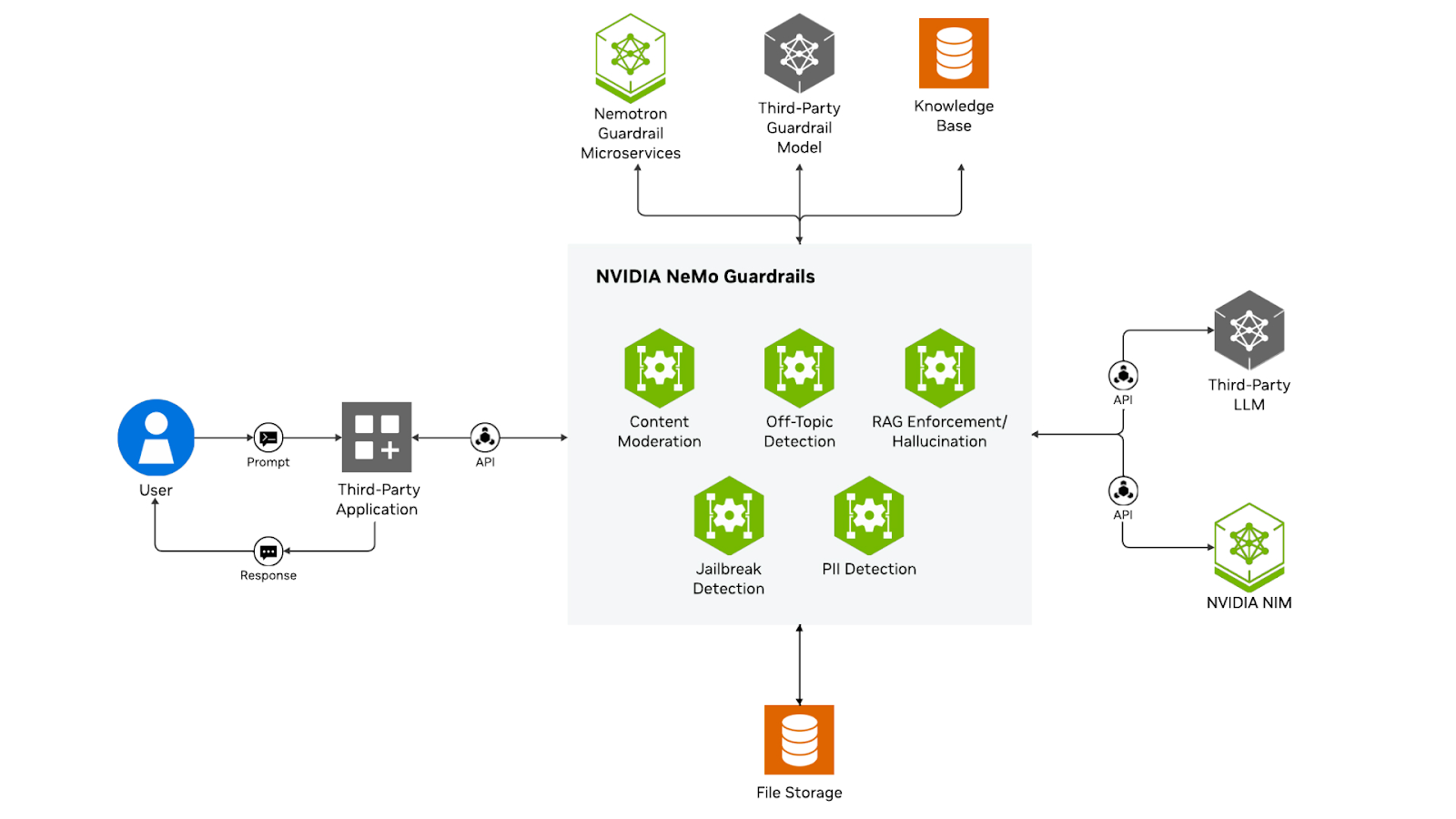

NVIDIA NeMo Guardrails

NVIDIA NeMo Guardrails hat einen coolen Ansatz, indem es sich mit einem dialogorientierten Zustandsmaschinenmodell voll auf die dialogbasierte KI konzentriert. Anstatt nur Eingaben und Ausgaben zu filtern, verwaltet NeMo ganze Gesprächsabläufe und sorgt dafür, dass Interaktionen mit mehreren Gesprächsrunden festgelegten Pfaden und Einschränkungen folgen.

Die Plattform nutzt Colang, eine Programmiersprache, die extra für die Steuerung von Dialogverhalten entwickelt wurde. Damit kannst du Gesprächsablaufpläne festlegen, die die Interaktionen steuern, den Kontext über mehrere Gesprächsrunden hinweg verwalten und die Geschäftslogik in längeren Gesprächen durchsetzen.

Der Ansatz von NeMo ist besonders gut für Chatbots, virtuelle Assistenten und Kundenservice-Anwendungen, wo es wichtiger ist, zusammenhängende, richtlinienkonforme Gespräche zu führen, als nur einzelne Antworten zu filtern.

Microsoft Azure KI-Inhaltssicherheit

Microsofts Azure AI Content Safety bietet Content-Moderation auf Unternehmensniveau, die speziell auf Text, Bilder und multimodale Inhalte abgestimmt ist. Die Plattform hat anpassbare Schwellenwerte für verschiedene Kategorien wie Hassrede, Gewalt, sexuelle Inhalte und Selbstverletzung. Es hat spezielle Funktionen, um Jailbreak-Versuche zu erkennen und vor Prompt-Injection-Angriffen zu schützen.

Azure AI Content Safety lässt sich super mit Azure OpenAI Service und anderen Azure AI-Angeboten verbinden, was es zu einer guten Wahl für Unternehmen macht, die die Cloud-Plattform von Microsoft nutzen. Der Service liefert detaillierte Risikobewertungen statt nur Ja-Nein-Entscheidungen, sodass du je nach deiner Risikobereitschaft differenzierte Moderationsrichtlinien umsetzen kannst.

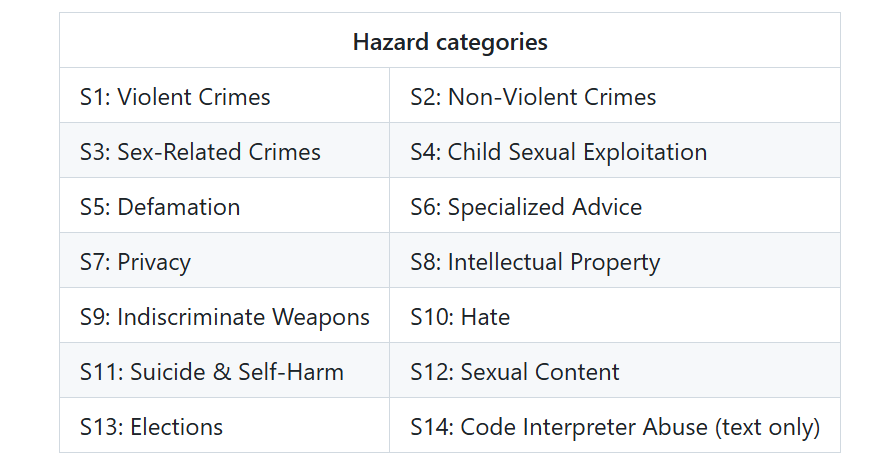

LlamaGuard

LlamaGuard, entwickelt von Meta, ist eine neue Generation von Open-Source-Sicherheitsmodellen. Es ist ein fein abgestimmtes LLaMA-Modell, das speziell darauf trainiert wurde, KI-generierte Inhalte auf Sicherheitsrisiken zu überprüfen. LlamaGuard gibt bei seinen Sicherheitsbewertungen an, ob etwas sicher oder unsicher ist, und zeigt auch, welche Kategorien nicht eingehalten werden.

LlamaGuard 4 Sicherheitsetiketten

Schauen wir mal, wie Unternehmen aus verschiedenen Branchen diese Plattformen nutzen, um in echten Situationen Schutzmaßnahmen einzusetzen.

Praktische Anwendungen und Anwendungsfälle von KI-Sicherheitsvorkehrungen

Wenn man sieht, wie Leitplanken in verschiedenen Branchen funktionieren, wird klar, wie nützlich sie sind.

Kundenservice

Im Kundenservice sorgen Leitplanken dafür, dass KI-Agenten einen professionellen Ton beibehalten, niemals unberechtigte Zusagen machen und bei komplexen Problemen angemessen eskalieren. Ein Telekommunikationsunternehmen hat ein System eingeführt, das verärgerte Kunden erkennt und die Gespräche automatisch an menschliche Mitarbeiter weiterleitet.

Gesundheitswesen

Anwendungen im Gesundheitswesen müssen besonders strenge Anforderungen erfüllen. Sicherheitsvorkehrungen in medizinischen KI-Systemen verhindern Diagnosen von nicht zugelassenen Systemen, stellen sicher, dass empfohlene Behandlungen mit evidenzbasierten Richtlinien übereinstimmen, und schützen die Privatsphäre der Patientendaten. Ein System zum Abgleich klinischer Studien nutzt Sicherheitsvorkehrungen, um sicherzustellen, dass Patientendaten niemals in Erklärungen durchsickern.

Forschung

In der akademischen Forschung sorgen Leitplanken für ein Gleichgewicht zwischen Sicherheit und akademischer Freiheit. Wissenschaftliche Mitarbeiter sollten Plagiate vermeiden, Quellen ordentlich zitieren und einen wissenschaftlichen Ton beibehalten, ohne dabei zu streng zu sein.

Cybersicherheit

Bei Cybersicherheit und Unternehmensabläufen schützen Leitplanken vor Prompt-Injection-Angriffen, verhindern die Ausführung von unsicherem Code und sorgen für Prüfpfade zur Einhaltung von Vorschriften. Ein Finanzdienstleister setzt Schutzmaßnahmen ein, um sicherzustellen, dass KI-Assistenten niemals proprietäre Handelsstrategien preisgeben und trotzdem nützliche Analysen liefern.

Einhaltung von Vorschriften und Unternehmensführung

Wenn du die Regulierungslandschaft verstehst, kannst du Leitplanken entwickeln, die den gesetzlichen Anforderungen entsprechen. Das EU-KI-Gesetz teilt KI-Systeme nach Risikostufen ein und schreibt technische Schutzmaßnahmen für risikoreiche Anwendungen in den Bereichen Beschäftigung, Bildung, Strafverfolgung oder kritische Infrastruktur vor. Das Gesetz verlangt ausdrücklich Maßnahmen zur Risikominderung, menschliche Kontrollmöglichkeiten und Transparenzmechanismen.

Datenschutzregeln wie die DSGVO und HIPAA haben bestimmte Anforderungen. Der Grundsatz der Datenminimierung der DSGVO braucht Regeln, die unnötige Datenerfassung und -verarbeitung verhindern. Die Sicherheitsvorschriften von HIPAA verlangen Schutzmaßnahmen für elektronisch gespeicherte Gesundheitsdaten.

Neue Governance-Rahmenbedingungen setzen auf ständige Überwachung und Anpassung. Das NIST-Rahmenwerk für das Risikomanagement im Bereich der künstlichen Intelligenz ermutigt Unternehmen, technische Kontrollen als Teil einer umfassenderen Governance-Strategie einzuführen.

Fazit

Wie ich zu zeigen versucht habe, sind KI-Sicherheitsvorkehrungen ein wichtiger Teil eines verantwortungsvollen Einsatzes von KI. Sie machen KI von unberechenbaren Systemen zu zuverlässigen Tools, auf die sich Unternehmen und Nutzer verlassen können. In diesem Tutorial habe ich erklärt, was Leitplanken sind, warum sie wichtig sind und wie man sie effektiv einsetzt.

Das Wichtigste ist, dass es bei Leitplanken nicht darum geht, die Möglichkeiten der KI einzuschränken. Es geht darum, diese Fähigkeiten sicher und produktiv zu nutzen. Wenn du KI-Systeme entwickelst, solltest du von Anfang an auf Sicherheitsvorkehrungen achten. Fang mit klaren Richtlinien an, setz modulare Schutzmaßnahmen um und verbesser sie immer weiter anhand von Feedback aus der Praxis.

Das Feld entwickelt sich ständig weiter, und es kommen regelmäßig neue Tools, Techniken und Best Practices dazu. Bleib mit der Community in Kontakt, probier verschiedene Ansätze aus und teil deine Erfahrungen mit anderen. Gemeinsam können wir KI-Systeme entwickeln, die nicht nur leistungsstark, sondern auch sicher, zuverlässig und vertrauenswürdig sind.

Um weiterzulernen, kann ich dir die folgenden Ressourcen empfehlen:

Häufig gestellte Fragen zu KI-Sicherheitsvorkehrungen

Was sind KI-Leitplanken?

KI-Sicherheitsvorkehrungen sind Mechanismen, die das Verhalten von KI-Systemen während ihres gesamten Lebenszyklus überwachen, validieren und kontrollieren, um schädliche Ergebnisse zu verhindern und die Einhaltung ethischer Standards sicherzustellen.

Welche Arten von KI-Sicherheitsvorkehrungen gibt es?

Die wichtigsten Arten sind Daten-Guards (zum Schutz sensibler Informationen), Modell-Guards (zur Steuerung der Generierung), Anwendungs-Guards (zur Verwaltung von Interaktionen), Infrastruktur-Guards (zur Gewährleistung einer sicheren Bereitstellung) und Compliance-Guards (zur Unterstützung gesetzlicher Anforderungen).

Welche Plattformen bieten KI-Sicherheitslösungen an?

Zu den führenden Plattformen gehören Guardrails AI (Open Source), Amazon Bedrock Guardrails (Cloud-nativ), NVIDIA NeMo Guardrails (dialogorientiert), Microsoft Azure AI Content Safety und LlamaGuard.

Wie beeinflussen Leitplanken die Leistung von KI-Systemen?

Guardrails sorgen für eine zusätzliche Latenz von 50 bis 200 Millisekunden und erhöhen die Rechenkosten, aber durch intelligentes Caching, asynchrone Validierung und mehrstufige Überprüfungen werden die Auswirkungen auf die Leistung minimiert, während der Schutz erhalten bleibt.

Sind KI-Sicherheitsvorkehrungen gesetzlich vorgeschrieben?

Ja, in vielen Fällen. Das EU-KI-Gesetz schreibt Schutzmaßnahmen für risikoreiche KI-Systeme vor, während Vorschriften wie die DSGVO und HIPAA bestimmte Schutzmaßnahmen für den Datenschutz und die Einhaltung der Datenschutzbestimmungen verlangen.

Als Gründer von Martin Data Solutions und freiberuflicher Datenwissenschaftler, ML- und KI-Ingenieur bringe ich ein vielfältiges Portfolio in den Bereichen Regression, Klassifizierung, NLP, LLM, RAG, Neuronale Netze, Ensemble-Methoden und Computer Vision mit.

- Er hat erfolgreich mehrere End-to-End-ML-Projekte entwickelt, einschließlich Datenbereinigung, Analyse, Modellierung und Bereitstellung auf AWS und GCP, und dabei wirkungsvolle und skalierbare Lösungen geliefert.

- Du hast mit Streamlit und Gradio interaktive und skalierbare Webanwendungen für verschiedene Branchen entwickelt.

- Er unterrichtete und betreute Studierende in den Bereichen Datenwissenschaft und Analytik und förderte ihre berufliche Entwicklung durch personalisierte Lernansätze.

- Entwickelte Kursinhalte für Retrieval-Augmented-Generating (RAG)-Anwendungen, die auf die Anforderungen von Unternehmen zugeschnitten sind.

- Er hat hochwirksame technische Blogs zu Themen wie MLOps, Vektordatenbanken und LLMs verfasst und damit ein hohes Maß an Engagement erzielt.

Bei jedem Projekt, das ich übernehme, achte ich darauf, dass ich die neuesten Praktiken des Software-Engineerings und der DevOps anwende, wie CI/CD, Code Linting, Formatierung, Modellüberwachung, Experiment-Tracking und robuste Fehlerbehandlung. Ich biete Komplettlösungen an und verwandle Datenerkenntnisse in praktische Strategien, die Unternehmen dabei helfen, zu wachsen und das Beste aus Data Science, maschinellem Lernen und KI herauszuholen.