Cours

GLM 4.7 Flash est en train de devenir rapidement un choix populaire pour le codage agentique local. De nombreux développeurs l'utilisent avec des outils tels que llama.cpp et LM Studio. Cependant, de nombreuses personnes rencontrent encore des difficultés lors de la configuration, pour faire fonctionner correctement le modèle et s'assurer que l'appel des outils fonctionne comme prévu.

Ce tutoriel se concentre sur la méthode la plus simple et la plus fiable pour exécuter GLM 4.7 Flash localement à l'aide de Claude Code avec Ollama. L'objectif est d'éliminer les frictions et de vous aider à obtenir une configuration fonctionnelle sans complexité inutile.

Ce guide est applicable à tous les systèmes d'exploitation. Peu importe que vous utilisiez Linux, Windows ou macOS. À la fin, vous disposerez de GLM 4.7 Flash fonctionnant localement et correctement intégré à Claude Code via Ollama.

Conditions préalables

Avant de commencer, veuillez vous assurer que votre système répond aux exigences matérielles et logicielles minimales indiquées ci-dessous.

Matériel :

- Carte graphique NVIDIA avec au moins 16 Go de mémoire vidéo

- 24 Go de VRAM sont recommandés pour une inférence plus fluide avec des contextes de plus grande taille.

- 16 à 32 Go de mémoire vive (RAM)

- Au moins 25 Go d'espace disque disponible

Si vous ne disposez pas d'un GPU, le modèle peut fonctionner sur un CPU, mais les performances seront considérablement ralenties et une mémoire RAM importante sera nécessaire.

Logiciel :

- Il est recommandé d'utiliser Linux ou macOS. Utilisateurs Windows : veuillez utiliser WSL2 avec le passthrough GPU activé.

- Un pilote GPU NVIDIA doit être installé et compatible avec votre version CUDA.

- Veuillez installer CUDA Toolkit 13.1.

- Si CUDA/le pilote est manquant ou incompatible, Ollama se rabattra généralement sur le CPU, qui est beaucoup plus lent.

Si le kit d'outils CUDA ou les pilotes NVIDIA sont manquants ou incompatibles, Ollama passera en mode CPU, qui est beaucoup plus lent.

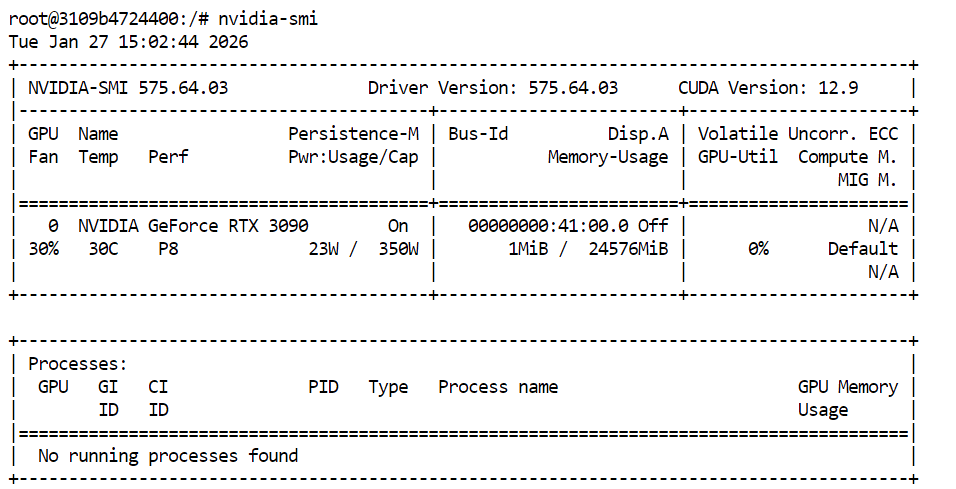

Pour vérifier que vos pilotes GPU et CUDA sont correctement installés, veuillez exécuter la commande suivante dans votre terminal :

nvidia-smiSi tout est correctement configuré, vous devriez voir votre GPU répertorié avec la VRAM disponible et la version CUDA.

1. Veuillez installer Ollama.

Ollama est le moteur d'exécution que nous utiliserons pour exécuter GLM 4.7 Flash localement et l'exposer de manière à ce que Claude Code puisse interagir de manière fiable. L'installation est simple sur toutes les plateformes prises en charge.

Sous Linux, vous pouvez installer Ollama à l'aide d'une seule commande :

curl -fsSL https://ollama.com/install.sh | shPour macOS et Windows, veuillez télécharger le programme d'installation directement depuis le site site web d'Ollama et suivez les instructions à l'écran.

Source : Ollama

Ollama fonctionne en tant que service en arrière-plan et vérifie automatiquement les mises à jour. Lorsqu'une mise à jour est disponible, vous pouvez l'appliquer en sélectionnant « Redémarrer pour mettre à jour » dans le menu Ollama.

Après l'installation, veuillez ouvrir un terminal et vérifier que Ollama est correctement installé :

ollama -vVous devriez obtenir un résultat similaire à celui-ci :

ollama version is 0.15.2Si vous rencontrez une erreur lors de l'exécution de ollama -v, cela signifie généralement que le service Ollama n'est pas encore opérationnel. Veuillez démarrer le serveur Ollama manuellement :

ollama serveVeuillez laisser cela en cours d'exécution, ouvrez une nouvelle fenêtre de terminal, puis exécutez :

ollama -vUne fois que la commande version fonctionne, Ollama est prêt à être utilisé dans les étapes suivantes du tutoriel.

2. Tirer et courir GLM-4.7-Flash

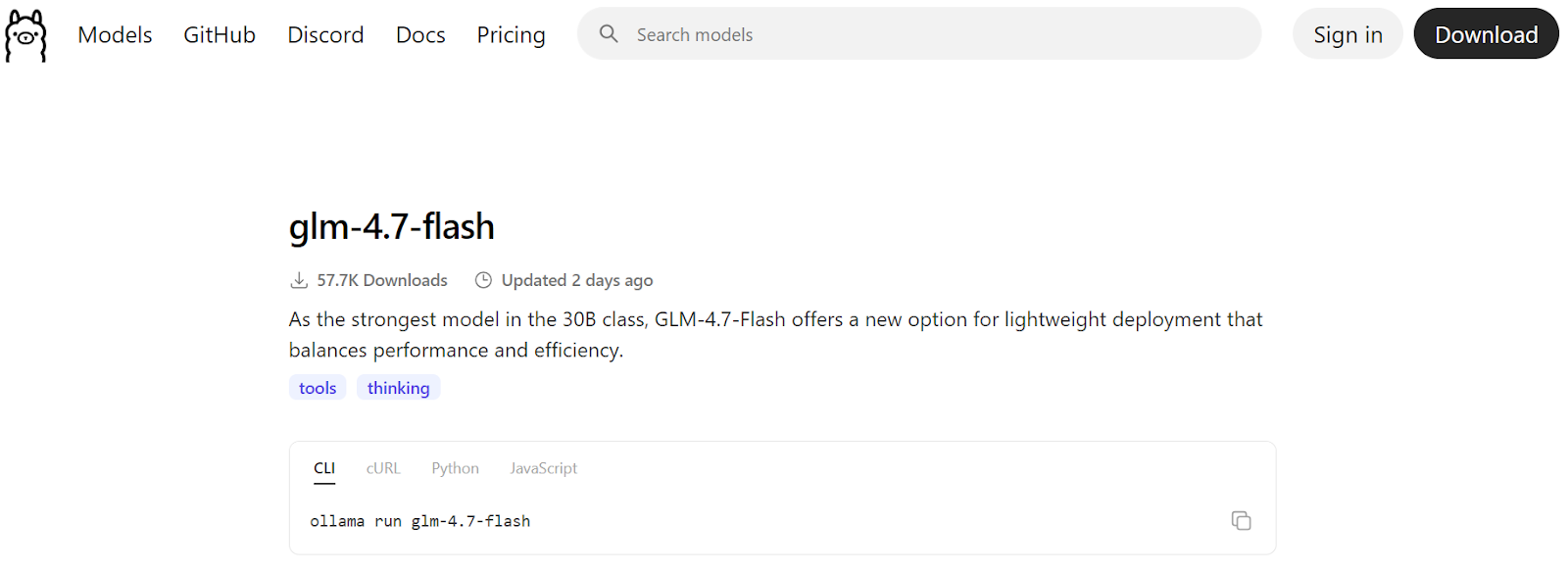

Une fois Ollama installé et opérationnel, l'étape suivante consiste à télécharger le modèle Flash GLM 4.7 et à vérifier qu'il fonctionne correctement. Cette étape garantit que le modèle fonctionne localement avant de l'intégrer à Claude Code.

Source : glm-4.7-flash

Veuillez commencer par télécharger le modèle à partir du registre Ollama :

ollama pull glm-4.7-flashCela permettra de télécharger les fichiers du modèle et de les enregistrer localement. En fonction de votre débit Internet, cela peut prendre quelques minutes.

![]()

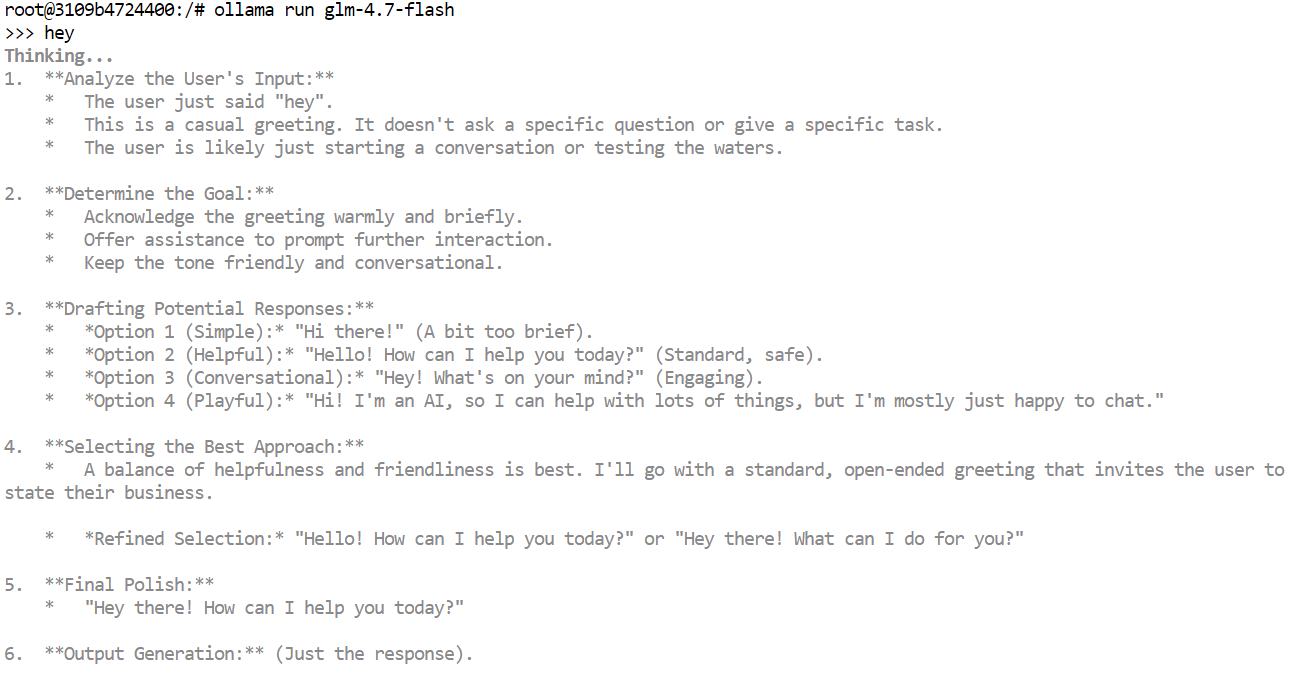

Une fois le téléchargement terminé, veuillez exécuter le modèle en mode de discussion interactive afin de procéder à une vérification rapide :

ollama run glm-4.7-flashVeuillez saisir une invite simple, telle qu'une salutation, puis appuyez sur Entrée. Dans quelques instants, vous devriez recevoir une réponse.

Si vous utilisez un GPU, vous constaterez que les réponses sont très rapides et que le résultat peut inclure des jetons de réflexion internes ou des traces de raisonnement, selon la configuration du modèle.

Vous pouvez également tester le modèle via l'API HTTP locale d'Ollama. Ceci est utile pour vérifier que les outils externes peuvent communiquer avec le modèle.

Veuillez exécuter la commande suivante :

curl http://localhost:11434/api/chat -d '{

"model": "glm-4.7-flash",

"messages": [{"role":"user","content":"Hello!"}]

}'3. Définir la longueur du contexte

Claude Code et la plupart des outils de codage agentique fonctionnent mieux avec des fenêtres contextuelles de grande taille, pouvant souvent atteindre 64 000 tokens. Cependant, avec GLM 4.7 Flash, il est essentiel de choisir la bonne longueur de contexte pour garantir à la fois performances et stabilité.

L'utilisation de contextes de très grande taille peut considérablement ralentir la vitesse de génération. En pratique, le débit des jetons peut passer de plus de 100 jetons par seconde à seulement 2 jetons par seconde. Dans certains cas, le modèle peut également se retrouver bloqué dans de longues boucles de réflexion si la fenêtre contextuelle est réglée à une valeur trop élevée.

Nous avons évalué plusieurs tailles de contexte et avons constaté qu'un contexte de 10 000 mots n'était pas suffisant pour les flux de travail Claude Code. Un contexte de 20 000 mots a permis d'atteindre un bon équilibre. Il était suffisamment spacieux pour les tâches de codage tout en conservant des temps de réponse rapides et en réduisant les boucles de réflexion inutiles.

Tout d'abord, veuillez arrêter le serveur Ollama en cours d'exécution. Vous pouvez procéder en saisissant la commande « Ctrl + C » dans le terminal ou en arrêtant le processus.

Ensuite, veuillez redémarrer Ollama avec une longueur de contexte personnalisée en définissant la variable d'environnement avant de lancer le serveur :

OLLAMA_CONTEXT_LENGTH=20000 ollama serveCela indique à Ollama de charger des modèles avec une fenêtre contextuelle maximale de 20 000 jetons.

Dans une nouvelle fenêtre de terminal, veuillez exécuter :

ollama psCela confirme que GLM 4.7 Flash fonctionne sur le GPU et que la longueur du contexte a été correctement définie. À ce stade, le modèle est configuré pour une utilisation stable et rapide avec Claude Code.

NAME ID SIZE PROCESSOR CONTEXT UNTIL

glm-4.7-flash:latest d1a8a26252f1 21 GB 100% GPU 20000 About a minute from now 4. Veuillez installer Claude Code.

Claude Code est l'agent de codage basé sur terminal d'Anthropic qui vous assiste dans la rédaction, la modification, la refactorisation et la compréhension du code à l'aide du langage naturel. Il est conçu pour les flux de travail agentique et peut gérer des tâches de codage en plusieurs étapes directement à partir de votre ligne de commande.

Lorsqu'il est associé à Ollama, Claude Code peut être facilement utilisé avec des modèles locaux tels que GLM 4.7 Flash, ce qui vous permet d'exécuter toutes les opérations localement et de conserver votre code sur votre machine.

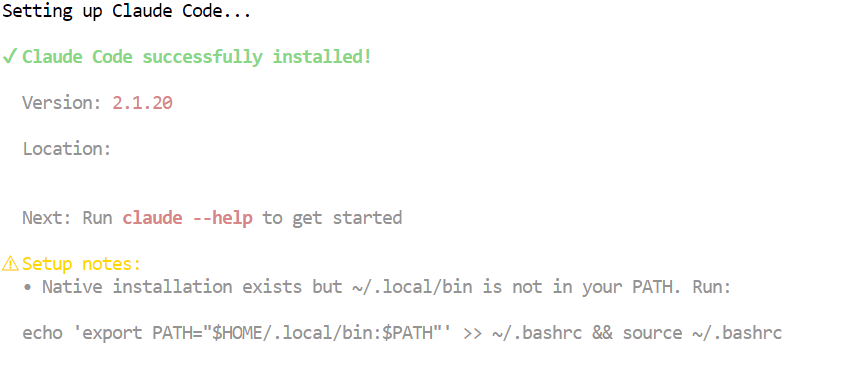

Sur macOS, Linux ou Windows utilisant WSL, veuillez installer Claude Code à l'aide du script d'installation officiel :

curl -fsSL https://claude.ai/install.sh | bashCette commande télécharge et installe Claude Code ainsi que les dépendances requises. Une fois l'installation terminée, la commande claude sera disponible dans votre terminal.

5. Veuillez connecter Claude Code à Ollama.

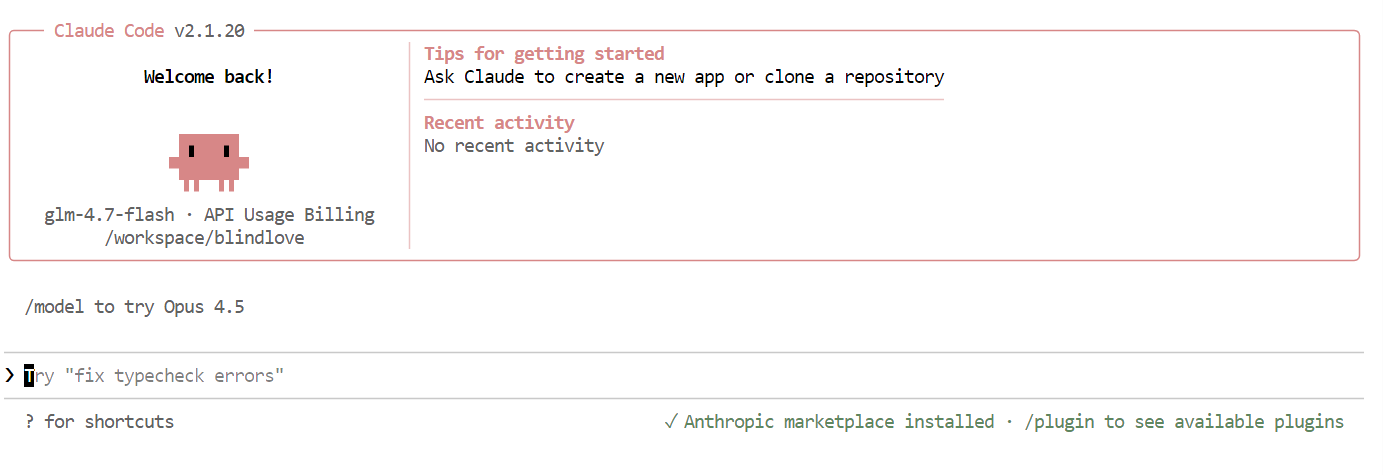

Maintenant que Ollama et Claude Code sont installés, l'étape suivante consiste à connecter Claude Code à votre serveur Ollama local et à le configurer pour utiliser le modèle GLM 4.7 Flash.

Commencez par créer un répertoire de travail pour votre projet. C'est ici que Claude Code fonctionnera et gérera les fichiers :

mkdir <project-name>

cd <project-name>Ollama propose désormais une fonctionnalité intégrée permettant de lancer Claude Code, qui se configure automatiquement pour communiquer avec le runtime Ollama local. Il s'agit de l'approche recommandée et la plus fiable.

Pour lancer Claude Code de manière interactive à l'aide d'Ollama :

ollama launch claudePour démarrer directement Claude Code à l'aide du modèle GLM 4.7 Flash, veuillez exécuter :

ollama launch claude --model glm-4.7-flashCela garantit que Claude Code utilise votre modèle Flash GLM 4.7 local au lieu d'un modèle distant ou par défaut.

Une fois que tout est configuré, l'interface Claude Code s'affichera directement dans votre terminal.

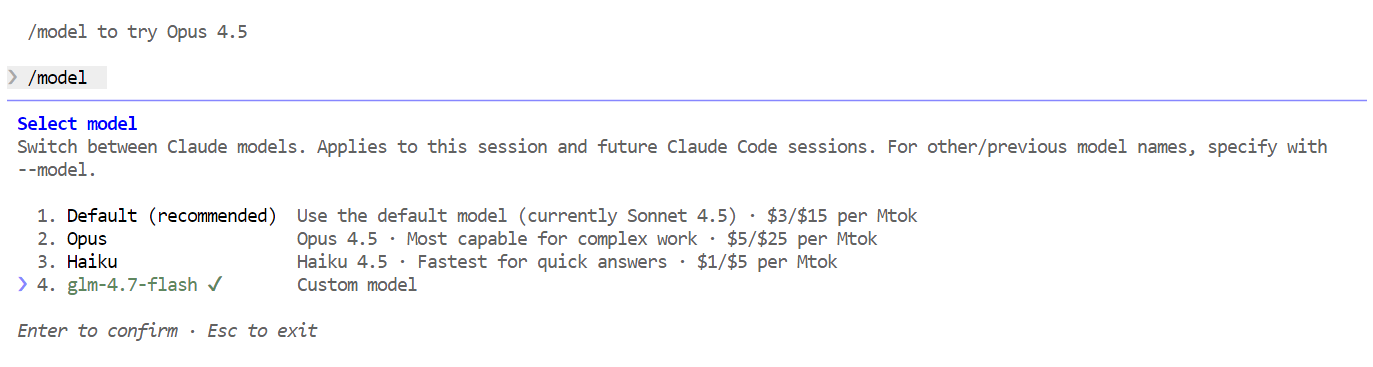

Dans Claude Code, veuillez utiliser la commande suivante pour vérifier que le modèle local est bien utilisé :

/modelSi le résultat affiche « glm-4.7-flash », votre configuration est terminée et Claude Code fonctionne correctement sur votre modèle Ollama local.

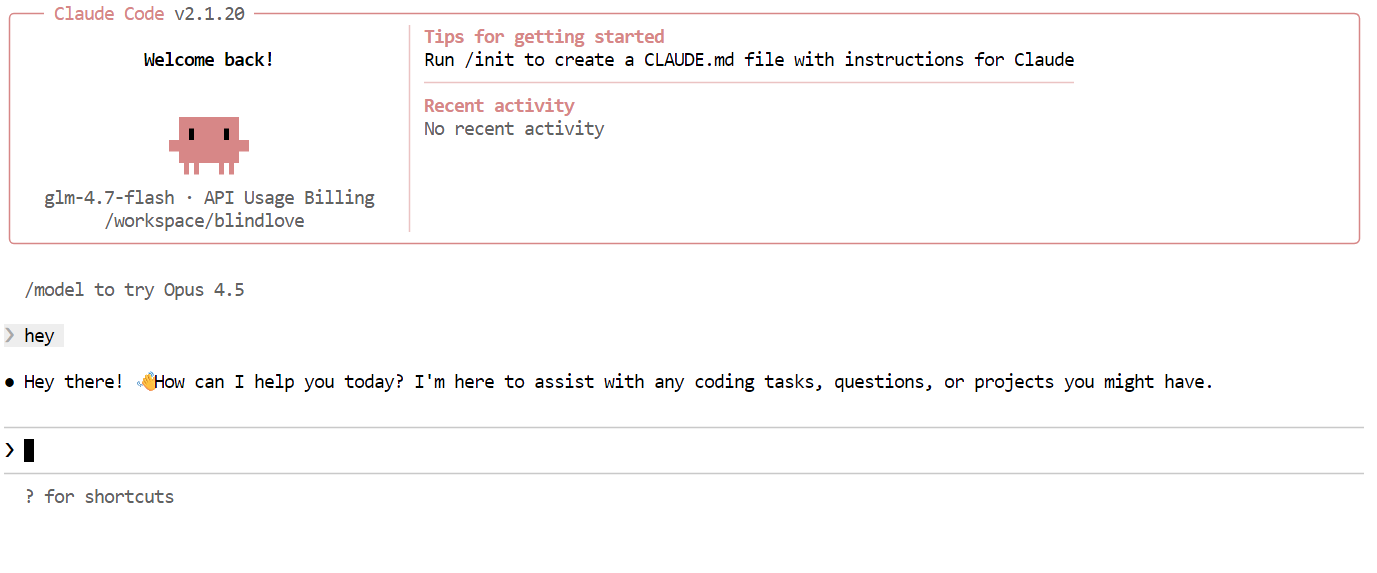

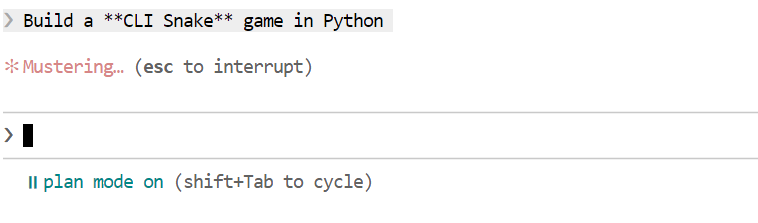

7. Utilisation de Claude Code avec Ollama

Une fois tout configuré, vous pouvez désormais commencer à utiliser Claude Code, optimisé par votre modèle Flash GLM 4.7 local. La première chose à essayer est une simple salutation. En l'espace d'une ou deux secondes, vous devriez recevoir une réponse. La vitesse est remarquablement rapide, en particulier lors de l'exécution sur un GPU.

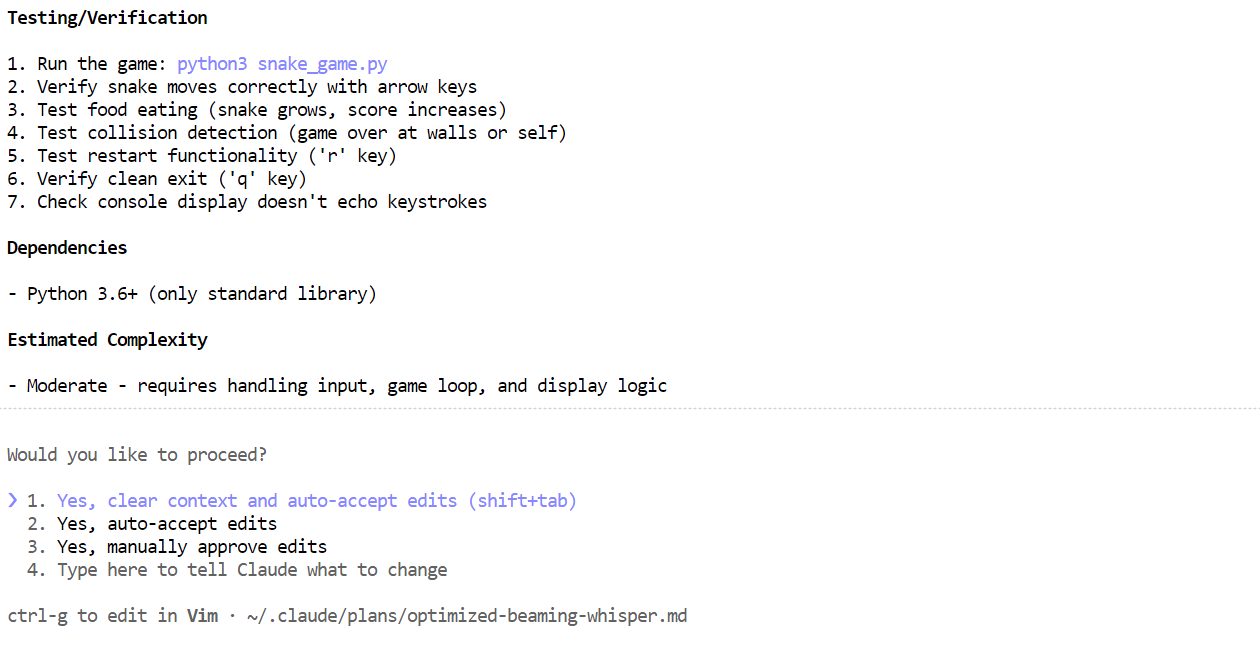

Ensuite, essayez une tâche de codage plus réaliste. Veuillez demander à Claude Code de développer un jeu Snake en Python avec une interface CLI. Avant de générer le code, veuillez passer en mode planification afin que le modèle définisse d'abord son approche. Vous pouvez activer ou désactiver le mode planification en appuyant deux fois sur les touchesShift + Tab de votre claviers .

Une fois le plan généré, veuillez le vérifier. Si l'approche semble appropriée, veuillez informer Claude Code de mettre le plan à exécution.

Une fois le plan généré, veuillez le vérifier. Si l'approche semble appropriée, veuillez informer Claude Code de mettre le plan à exécution.

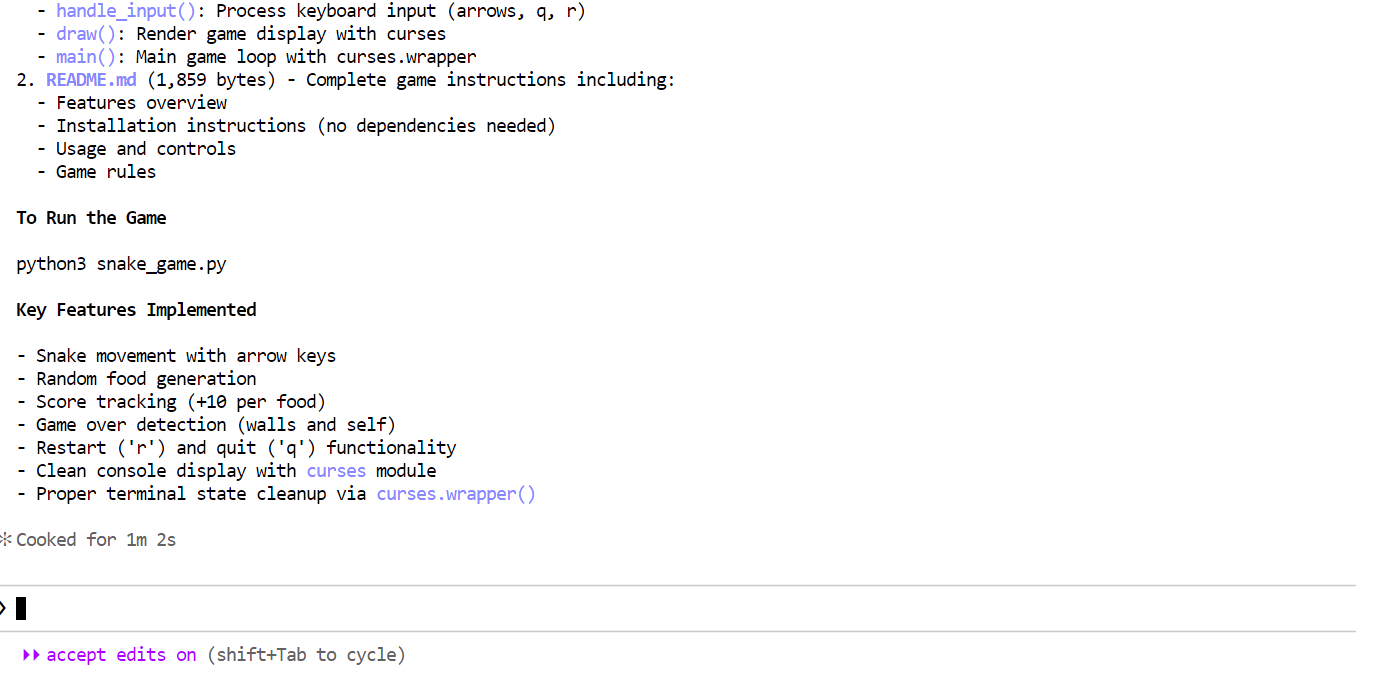

En quelques minutes, il a créé les fichiers requis, expliqué le fonctionnement du jeu Snake et fourni des instructions claires sur la manière de l'exécuter.

En quelques minutes, il a créé les fichiers requis, expliqué le fonctionnement du jeu Snake et fourni des instructions claires sur la manière de l'exécuter.

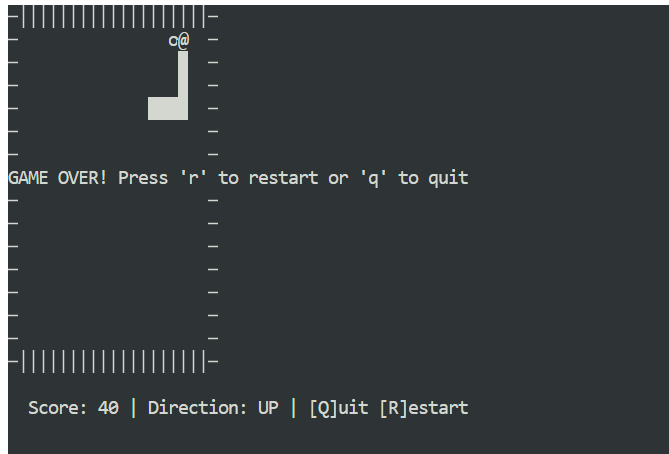

Veuillez ouvrir une nouvelle fenêtre de terminal et vous assurer que vous vous trouvez dans le même répertoire de projet. Veuillez ensuite démarrer le jeu avec :

Veuillez ouvrir une nouvelle fenêtre de terminal et vous assurer que vous vous trouvez dans le même répertoire de projet. Veuillez ensuite démarrer le jeu avec :

python3 snake_game.pyLe jeu est prêt à l'emploi, aucune configuration supplémentaire n'est nécessaire. Il s'agit d'un jeu Snake simple, basé sur un terminal, très similaire à la version classique du Nokia 3310. Malgré sa simplicité, il s'agit d'un excellent exemple de la rapidité et de l'efficacité du codage agentique local avec Claude Code et Ollama.

Conclusions finales

L'exécution de Claude Code avec GLM 4.7 Flash sur Ollama démontre les progrès réalisés en matière de codage agentique local. Vous bénéficiez de réponses rapides, d'une génération de code performante et d'un contrôle total sur vos données, sans dépendre de modèles hébergés dans le cloud.

Une fois configuré, le flux de travail est fluide et fiable, même pour les tâches de codage en plusieurs étapes.

Il est important de retenir que des fenêtres contextuelles plus grandes et des configurations plus complexes ne sont pas toujours préférables. Avec des paramètres par défaut raisonnables, la configuration complète prend environ cinq minutes, hors temps de téléchargement du modèle, qui dépend de votre connexion Internet.

Si vous avez déjà téléchargé le fichier GGUF pour le modèle, l'installation sera encore plus rapide. Dans ce cas, vous pouvez ignorer complètement le téléchargement du modèle et simplement enregistrer le fichier GGUF existant dans Ollama en créant unfichier modèle .

Cela vous permet de définir les paramètres de génération une seule fois et de réutiliser le modèle de manière cohérente entre les exécutions et les outils.

Veuillez créer un fichier nommé Modelfile dans le même répertoire que votre fichier GGUF :

FROM ./glm-4.7-flash.gguf

PARAMETER temperature 0.8

PARAMETER top_p 0.95

PARAMETER repeat_penalty 1.0Vous pouvez ajuster les paramètres selon vos besoins :

- Température : 0,7 à 1,0

- Top-p : 0,95 à 1,0

- Pénalité de répétition : désactivée ou réglée sur 1,0

Veuillez enregistrer le modèle auprès d'Ollama :

ollama create glm-4.7-flash-local -f ModelfileUne fois le modèle créé, vous pouvez l'exécuter directement en mode chat :

ollama run glm-4.7-flash-localLe modèle peut désormais être utilisé comme n'importe quel autre modèle Ollama et s'intègre parfaitement à Claude Code.

J'ai pris beaucoup de plaisir à créer des applications et des jeux à l'aide de GLM 4.7 Flash dans Claude Code. Il est véritablement valorisant de travailler dans un endroit isolé, sans connexion Internet ou avec une connexion instable. Tout fonctionne localement, rien ne se casse, et vous disposez toujours d'un puissant agent de codage à portée de main. Ce sentiment de contrôle et d'indépendance est difficile à égaler.

Si vous souhaitez en savoir plus sur les outils présentés dans cet article, je vous recommande les ressources suivantes :

- Claude Code : Un guide avec des exemples concrets

- Claude Code 2.1 : Un guide avec des exemples concrets

- Tutoriel Claude Cowork : Comment utiliser l'agent de bureau IA d'Anthropic

- Comment exécuter GLM 4.7 Flash localement

- Comment exécuter GLM-4.7 localement avec llama.cpp : Un guide de haute performance

Questions fréquentes

Quels modèles locaux fonctionnent le mieux pour le codage agentique ?

L'exécution de Claude Code avec Ollama constitue l'une des configurations de « vibe-coding » les plus performantes pour 2026. Il vous permet d'utiliser l'agent terminal avancé d'Anthropic tout en conservant la confidentialité totale de votre code source et en évitant les frais d'API élevés.

Depuis la version 0.14 d'Ollama, il est nativement compatible avec l'API Anthropic Messages, ce qui signifie que vous pouvez remplacer le backend cloud par un backend local à l'aide de quelques variables d'environnement.

5 Questions fréquentes générales concernant Claude Code + Ollama

1. Comment puis-je diriger Claude Code vers mon serveur Ollama local ?

Claude Code recherche par défaut l'API Anthropic. Pour le rediriger vers Ollama, il est nécessaire de définir ces trois variables d'environnement dans votre terminal avant d'exécuter la commande d'claude:

- Linux/macOS :

Bash

export ANTHROPIC_BASE_URL="http://localhost:11434" export ANTHROPIC_AUTH_TOKEN="ollama" export ANTHROPIC_API_KEY="" - Windows (PowerShell) :

PowerShell

$env:ANTHROPIC_BASE_URL = "http://localhost:11434" $env:ANTHROPIC_AUTH_TOKEN = "ollama" $env:ANTHROPIC_API_KEY = ""

Conseil : Si vous utilisez la dernière version d'Ollama, il vous suffit d'exécuter

ollama launch claudepour que ces variables soient automatiquement configurées pour vous.

2. Quels modèles locaux fonctionnent le mieux pour le codage agentique ?

Tous les modèles locaux ne sont pas en mesure de gérer les instructions « agentives » complexes (appel d'outils, lecture de fichiers et planification en plusieurs étapes) requises par Claude Code. Au début de l'année 2026, les favoris de la communauté sont les suivants :

- GLM 4.7 Flash : Optimisé pour la vitesse et les fenêtres contextuelles de grande taille (128k).

- Codeur Qwen 2.5 (32 bits ou 7 bits) : Actuellement, la référence en matière de raisonnement de codage open source.

- Codestral : Idéal pour Python et les logiques complexes, bien que plus exigeant en termes de matériel.

Quelles sont les exigences matérielles minimales requises ?

Étant donné que Claude Code envoie une requête système volumineuse (~16 000 jetons) pour définir son comportement, le matériel constitue le principal goulot d'étranglement :

- Recommandé : Carte graphique NVIDIA avec 16 à 24 Go de mémoire vidéo (par exemple, RTX 3090/4090) ou Mac Apple série M avec 32 Go de RAM ou plus.

- Minimum : 16 Go de mémoire vive totale. Si vous ne disposez pas d'un GPU, vous pouvez exécuter des modèles plus petits (tels que Qwen 7B) sur votre CPU, mais veuillez noter que le « mode planification » peut prendre plusieurs minutes par étape.

Pourquoi Claude Code continue-t-il à tenter de se connecter à Internet ?

Même avec un modèle local, Claude Code peut tenter d'envoyer du trafic « non essentiel » tel que des données télémétriques ou des vérifications de mises à jour. Si vous vous trouvez dans un environnement strictement hors ligne ou si vous souhaitez bénéficier d'une confidentialité maximale, veuillez définir cette variable supplémentaire :

export CLAUDE_CODE_DISABLE_NONESSENTIAL_TRAFFIC=1

Cela garantit que l'agent ne communique pas avec l'extérieur et reste confiné à votre réseau local.

Puis-je utiliser le « mode planification » avec des modèles locaux ?

Oui. Les modèles locaux qui prennent en charge l'utilisation d'outils (tels que GLM 4.7 Flash ou Qwen 2.5 Coder) sont compatibles avec le mode de planification de Claude Code. Cependant, si le modèle n'est pas suffisamment puissant, il risque de se retrouver dans une « boucle de réflexion » où il répète la même étape.

- Correction : Si cela se produit, veuillez essayer une quantification plus importante (par exemple, en passant d'une version du modèle

q4à une versionq8oufp16) ou augmentez votre fenêtre contextuelle (num_ctx) dans votre fichier Ollama Modelfile à au moins 32 000.

En tant que data scientist certifié, je suis passionné par l'utilisation des technologies de pointe pour créer des applications innovantes d'apprentissage automatique. Avec une solide expérience en reconnaissance vocale, en analyse de données et en reporting, en MLOps, en IA conversationnelle et en NLP, j'ai affiné mes compétences dans le développement de systèmes intelligents qui peuvent avoir un impact réel. En plus de mon expertise technique, je suis également un communicateur compétent, doué pour distiller des concepts complexes dans un langage clair et concis. En conséquence, je suis devenu un blogueur recherché dans le domaine de la science des données, partageant mes idées et mes expériences avec une communauté grandissante de professionnels des données. Actuellement, je me concentre sur la création et l'édition de contenu, en travaillant avec de grands modèles linguistiques pour développer un contenu puissant et attrayant qui peut aider les entreprises et les particuliers à tirer le meilleur parti de leurs données.