Curso

O GLM 4.7 Flash está rapidamente se tornando uma escolha popular para codificação de agentes locais. Muitos desenvolvedores estão usando isso com ferramentas como llama.cpp e LM Studio. Mas, muita gente ainda tem problemas na hora de configurar, fazer o modelo funcionar direito e garantir que a chamada da ferramenta funcione como esperado.

Este tutorial mostra a maneira mais simples e segura de rodar o GLM 4.7 Flash localmente usando o Claude Code com o Ollama. O objetivo é eliminar o atrito e ajudar você a obter uma configuração funcional sem complexidade desnecessária.

Este guia funciona em todos os sistemas operacionais. Não importa se você está usando Linux, Windows ou macOS. No final, você vai ter o GLM 4.7 Flash rodando localmente e integrado corretamente com o Claude Code através do Ollama.

Pré-requisitos

Antes de começar, certifique-se de que seu sistema atenda aos requisitos mínimos de hardware e software abaixo.

Hardware:

- GPU NVIDIA com no mínimo 16 GB de VRAM

- Recomenda-se 24 GB de VRAM para uma inferência mais suave em tamanhos de contexto maiores.

- 16–32 GB de memória RAM do sistema

- Pelo menos 25 GB de espaço livre em disco

Se você não tiver uma GPU, o modelo pode rodar em uma CPU, mas o desempenho vai ser bem mais lento e vai precisar de muita RAM.

Software:

- Recomenda-se o uso do Linux ou macOS. Usuários do Windows: usem o WSL2 com o GPU passthrough ativado.

- É preciso ter um driver de GPU NVIDIA instalado e compatível com a sua versão do CUDA.

- Instale o CUDA Toolkit 13.1

- Se o CUDA/driver estiver faltando ou for incompatível, o Ollama normalmente vai usar a CPU, que é bem mais lenta.

Se o kit de ferramentas CUDA ou os drivers NVIDIA estiverem faltando ou forem incompatíveis, o Ollama vai voltar pro modo CPU, que é bem mais lento.

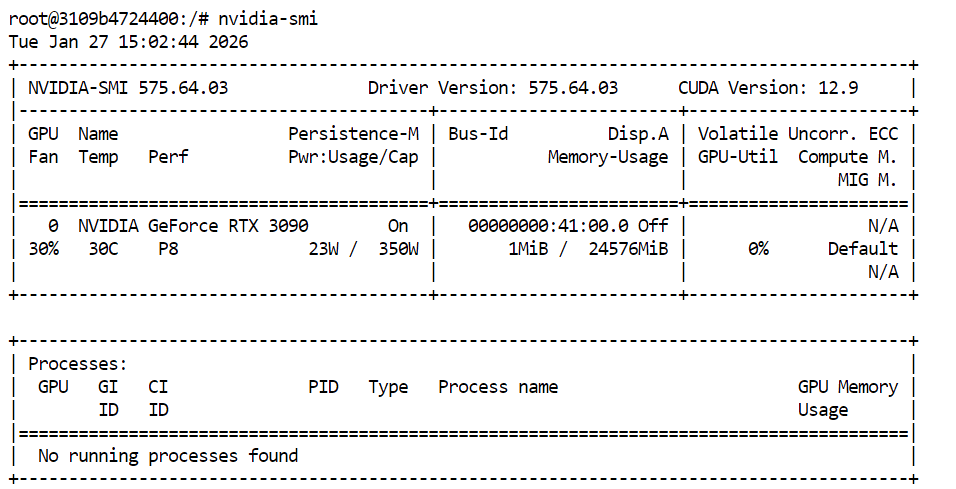

Pra conferir se os drivers da sua GPU e CUDA estão instalados direitinho, dá uma olhada no seguinte comando no seu terminal:

nvidia-smiSe tudo estiver configurado corretamente, você deverá ver sua GPU listada junto com a VRAM disponível e a versão CUDA.

1. Instalar o Ollama

O Ollama é o ambiente de execução que vamos usar pra rodar o GLM 4.7 Flash localmente e expô-lo de forma que o Claude Code possa interagir com ele de maneira confiável. A instalação é bem simples em todas as plataformas compatíveis.

No Linux, dá pra instalar o Ollama com um comando só:

curl -fsSL https://ollama.com/install.sh | shPara macOS e Windows, baixa o instalador direto do site da Ollama e siga as instruções na tela.

Fonte: Ollama

O Ollama funciona como um serviço em segundo plano e vai procurar atualizações automaticamente. Quando uma atualização estiver disponível, você pode aplicá-la selecionando “Reiniciar para atualizar” no menu do Ollama.

Depois de instalar, abra um terminal e veja se o Ollama tá instalado direitinho:

ollama -vVocê deve ver um resultado parecido com este:

ollama version is 0.15.2Se você vir um erro ao rodar ollama -v, geralmente quer dizer que o serviço Ollama ainda não está funcionando. Inicie o servidor Ollama manualmente:

ollama serveDeixe isso rodando, abra uma nova janela do terminal e execute:

ollama -vAssim que o comando version funcionar, o Ollama estará pronto para ser usado nas próximas etapas do tutorial.

2. Puxe e execute GLM-4.7-Flash

Depois que o Ollama estiver instalado e funcionando, o próximo passo é baixar o modelo GLM 4.7 Flash e ver se ele tá funcionando direitinho. Essa etapa garante que o modelo funcione localmente antes de integrá-lo ao Claude Code.

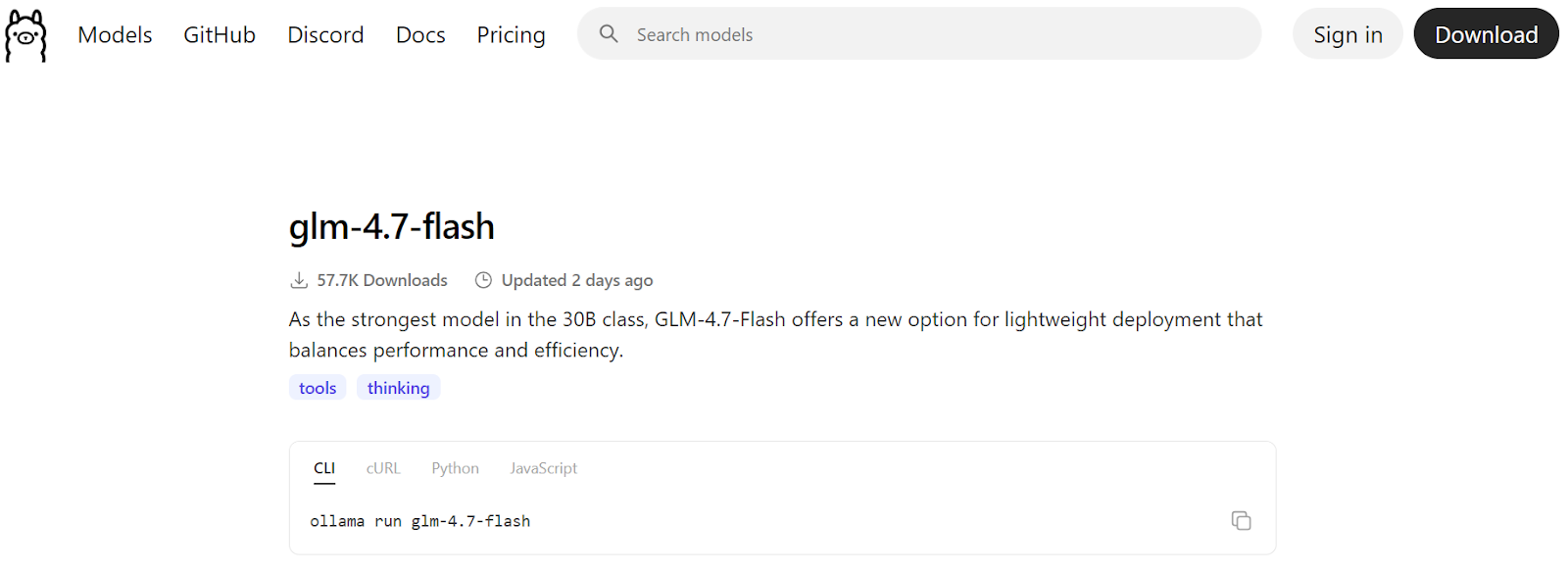

Fonte: glm-4.7-flash

Comece baixando o modelo do registro da Ollama:

ollama pull glm-4.7-flashIsso vai baixar os arquivos do modelo e guardá-los no seu computador. Dependendo da velocidade da sua internet, isso pode demorar alguns minutos.

![]()

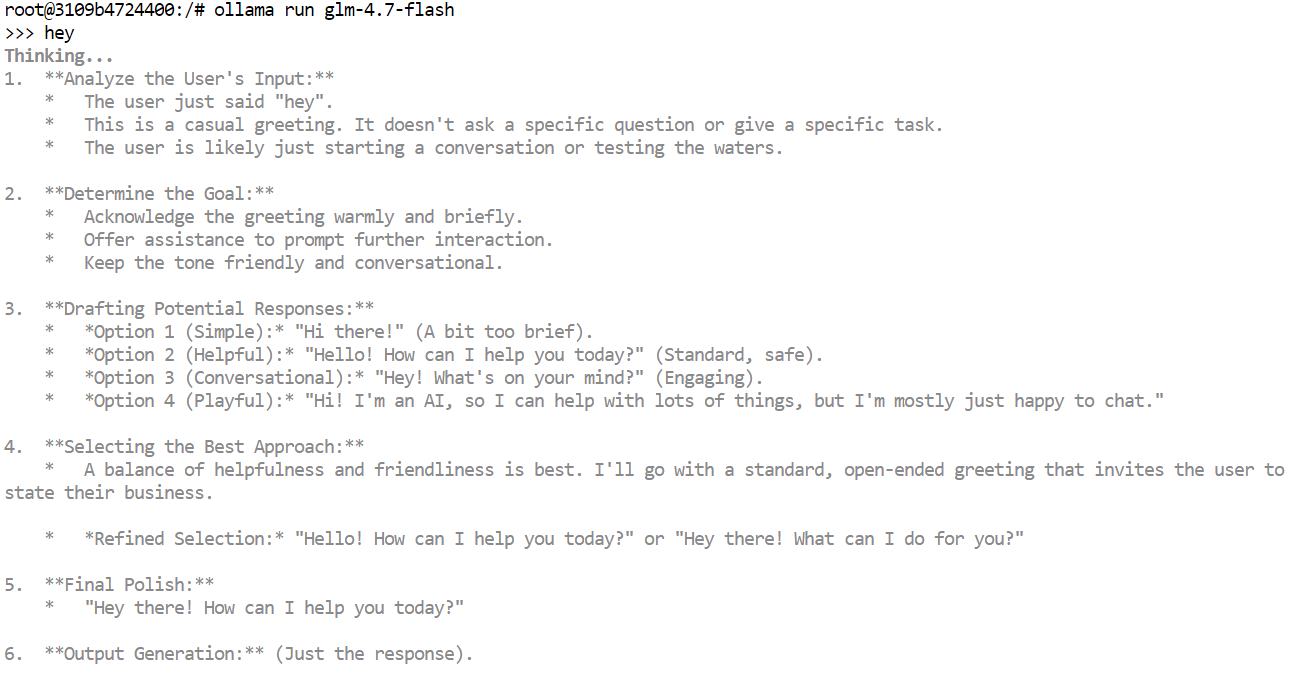

Depois que o download terminar, execute o modelo no modo de bate-papo interativo como uma rápida verificação de sanidade:

ollama run glm-4.7-flashDigite um comando simples, tipo uma saudação, e aperte Enter. Em alguns segundos, você deve receber uma resposta.

Se você estiver usando uma GPU, vai notar que as respostas são bem rápidas, e a saída pode incluir tokens de raciocínio interno ou traços de raciocínio, dependendo da configuração do modelo.

Você também pode testar o modelo através da API HTTP local do Ollama. Isso é útil para confirmar que as ferramentas externas podem se comunicar com o modelo.

Execute o seguinte comando:

curl http://localhost:11434/api/chat -d '{

"model": "glm-4.7-flash",

"messages": [{"role":"user","content":"Hello!"}]

}'3. Definir comprimento do contexto

O Claude Code e a maioria das ferramentas de codificação agentica funcionam melhor com janelas de contexto grandes, muitas vezes com até 64 mil tokens. Mas, com o GLM 4.7 Flash, escolher o comprimento de contexto certo é importante tanto para o desempenho quanto para a estabilidade.

Usar tamanhos de contexto muito grandes pode diminuir bastante a velocidade de geração. Na prática, a taxa de transferência de tokens pode cair de mais de 100 tokens por segundo para apenas 2 tokens por segundo. Às vezes, o modelo pode ficar preso em longos ciclos de reflexão se a janela de contexto estiver muito alta.

Testamos vários tamanhos de contexto e descobrimos que um contexto de 10k não era suficiente para os fluxos de trabalho do Claude Code. Um contexto de 20k proporcionou um bom equilíbrio. Era grande o suficiente para tarefas de codificação, mantendo tempos de resposta rápidos e reduzindo loops de pensamento desnecessários.

Primeiro, desligue o servidor Ollama. Você pode fazer isso pressionando “ Ctrl + C ” no terminal ou encerrando o processo.

Depois, reinicie o Ollama com um comprimento de contexto personalizado, definindo a variável de ambiente antes de iniciar o servidor:

OLLAMA_CONTEXT_LENGTH=20000 ollama serveIsso diz ao Ollama para carregar modelos com uma janela de contexto máxima de 20.000 tokens.

Em uma nova janela do terminal, execute:

ollama psIsso confirma que o GLM 4.7 Flash está rodando na GPU e que o comprimento do contexto foi definido corretamente. Neste momento, o modelo está configurado para uso estável e rápido com o Claude Code.

NAME ID SIZE PROCESSOR CONTEXT UNTIL

glm-4.7-flash:latest d1a8a26252f1 21 GB 100% GPU 20000 About a minute from now 4. Instalar o Claude Code

Claude Code é o agente de codificação baseado em terminal da Anthropic que ajuda você a escrever, editar, refatorar e entender código usando linguagem natural. Ele foi feito pra fluxos de trabalho de agentes e dá pra lidar com tarefas de codificação de várias etapas direto da sua linha de comando.

Quando combinado com o Ollama, o Claude Code pode ser facilmente usado com modelos locais, como o GLM 4.7 Flash, permitindo que você execute tudo localmente e mantenha seu código em sua máquina.

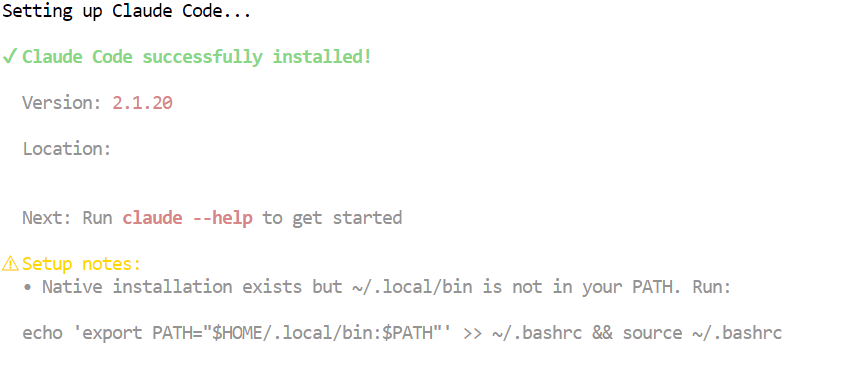

No macOS, Linux ou Windows usando WSL, instale o Claude Code usando o script instalador oficial:

curl -fsSL https://claude.ai/install.sh | bashEsse comando baixa e instala o Claude Code junto com as dependências necessárias. Quando a instalação terminar, o comando ` claude ` vai estar disponível no seu terminal.

5. Conecte o Claude Code ao Ollama

Agora que o Ollama e o Claude Code estão instalados, o próximo passo é conectar o Claude Code ao seu servidor Ollama local e configurá-lo para usar o modelo GLM 4.7 Flash.

Comece criando um diretório de trabalho para o seu projeto. É aqui que o Claude Code vai operar e gerenciar os arquivos:

mkdir <project-name>

cd <project-name>O Ollama agora tem uma maneira integrada de abrir o Claude Code, que se configura automaticamente para se comunicar com o tempo de execução local do Ollama. Essa é a abordagem recomendada e mais confiável.

Para abrir o Claude Code de forma interativa usando o Ollama:

ollama launch claudePara iniciar diretamente o Claude Code usando o modelo GLM 4.7 Flash, execute:

ollama launch claude --model glm-4.7-flashIsso garante que o Claude Code use seu modelo GLM 4.7 Flash local em vez de um modelo remoto ou padrão.

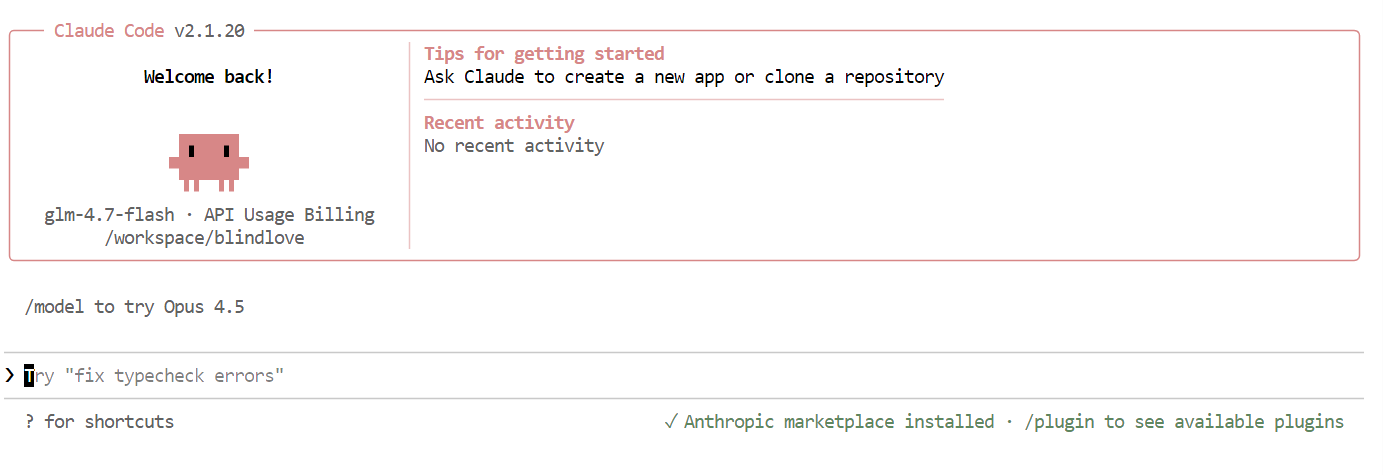

Depois que tudo estiver configurado, você vai ver a interface do Claude Code direitinho no seu terminal.

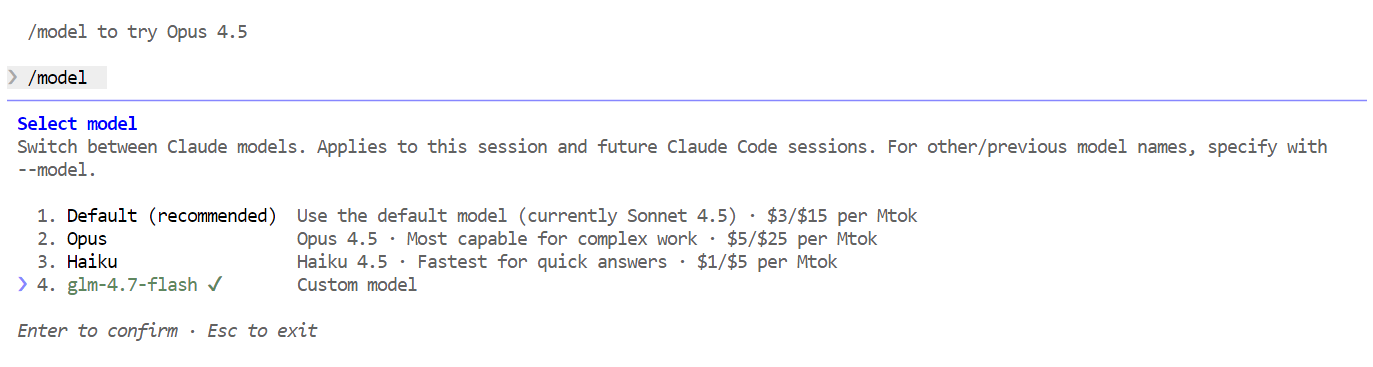

Dentro do Claude Code, use o seguinte comando para confirmar que ele está usando seu modelo local:

/modelSe a saída mostrar “ glm-4.7-flash ”, sua configuração está completa e o Claude Code está funcionando direitinho no seu modelo Ollama local.

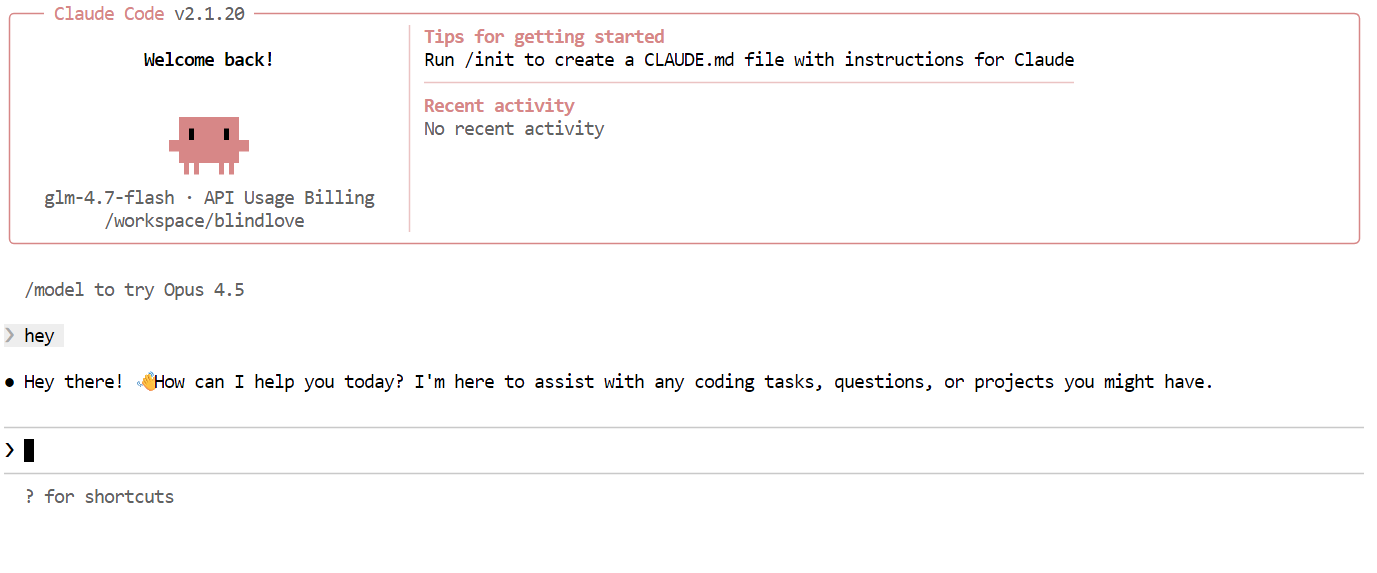

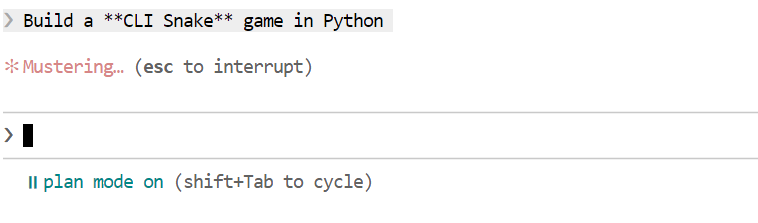

7. Usando o Claude Code com o Ollama

Com tudo configurado, agora você pode começar a usar o Claude Code com o seu modelo GLM 4.7 Flash local. A primeira coisa a tentar é uma saudação simples. Em um ou dois segundos, você deve receber uma resposta. A velocidade é bem rápida, principalmente quando tá rodando numa GPU.

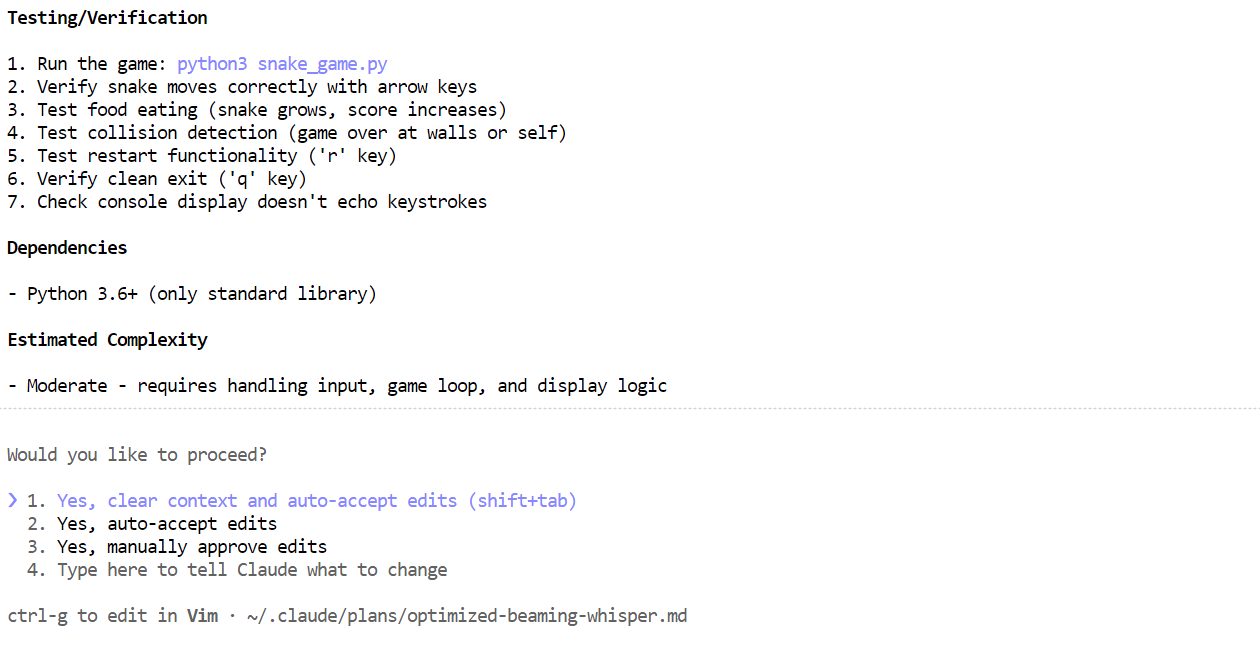

Depois, tente uma tarefa de programação mais realista. Peça ao Claude Code para criar um jogo Snake CLI em Python. Antes de gerar o código, mude para o modo de planejamento para que o modelo esboce sua abordagem primeiro. Você pode alternar o modo de planejamento pressionandoShift + Tab duas vezes.

Depois que o plano estiver pronto, dá uma olhada nele. Se a abordagem parecer boa, diga ao Claude Code para colocar o plano em ação.

Depois que o plano estiver pronto, dá uma olhada nele. Se a abordagem parecer boa, diga ao Claude Code para colocar o plano em ação.

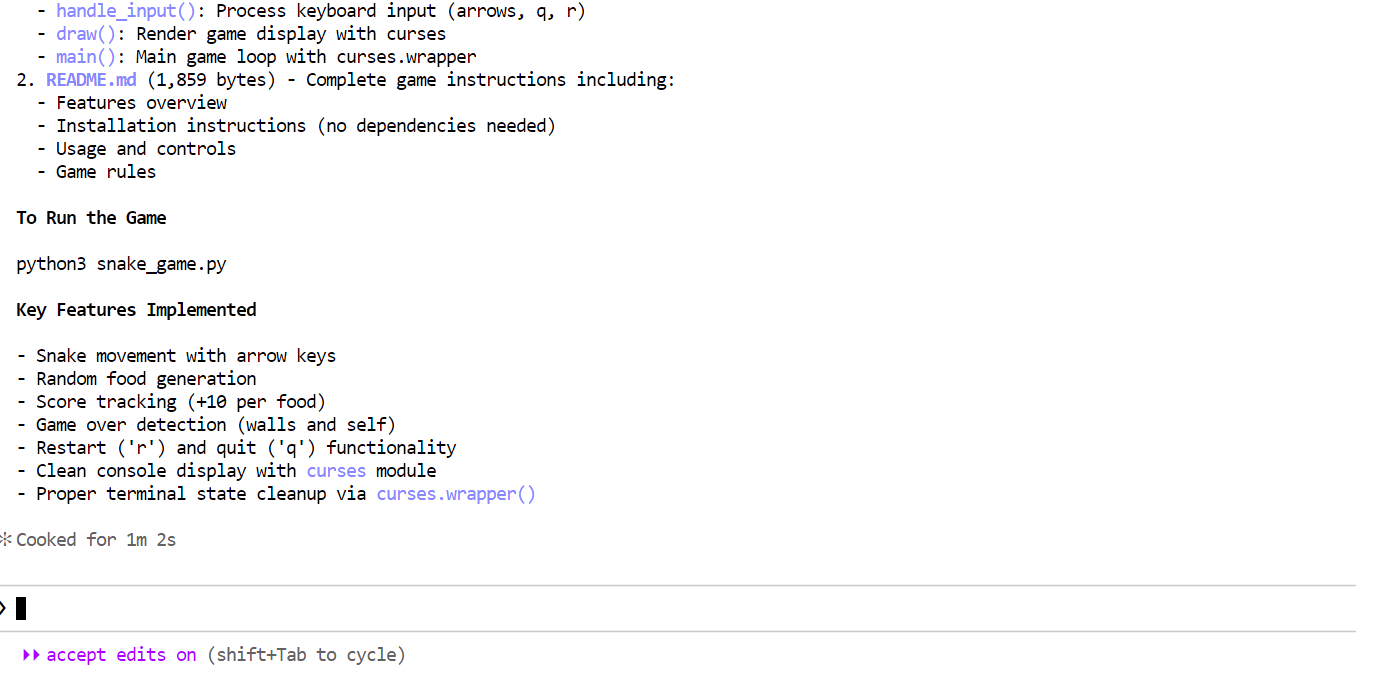

Em poucos minutos, ele criou os arquivos necessários, explicou o que o jogo Snake faz e forneceu instruções claras sobre como executá-lo.

Em poucos minutos, ele criou os arquivos necessários, explicou o que o jogo Snake faz e forneceu instruções claras sobre como executá-lo.

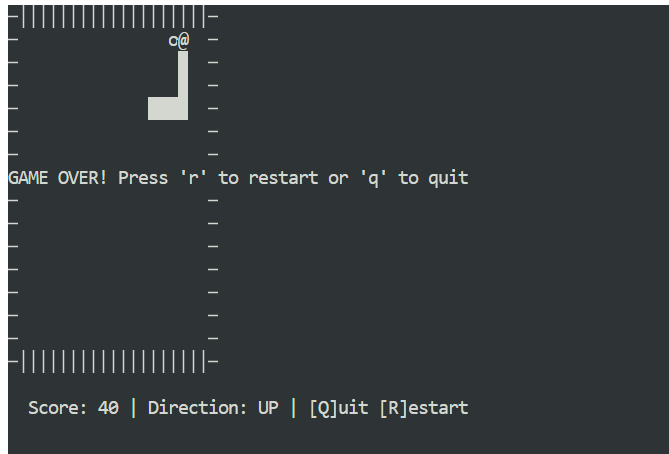

Abra uma nova janela terminal e certifique-se de que você está no mesmo diretório do projeto. Então comece o jogo com:

Abra uma nova janela terminal e certifique-se de que você está no mesmo diretório do projeto. Então comece o jogo com:

python3 snake_game.pyO jogo funciona direto da caixa, sem precisar de nenhuma configuração extra. É um jogo Snake simples, tipo terminal, bem parecido com a versão clássica do Nokia 3310. Apesar de ser simples, é um ótimo exemplo de como a codificação local pode ser rápida e eficaz com o Claude Code e o Ollama.

Considerações finais

Executar o Claude Code com GLM 4.7 Flash no Ollama mostra o quanto a codificação local de agentes evoluiu. Você obtém respostas rápidas, geração de código robusta e controle total sobre seus dados, tudo isso sem depender de modelos hospedados na nuvem.

Depois de configurado, o fluxo de trabalho parece tranquilo e confiável, mesmo para tarefas de codificação com várias etapas.

Uma lição importante é que janelas de contexto maiores e configurações mais complexas nem sempre são melhores. Com as configurações padrão, a instalação toda leva uns cinco minutos, sem contar o tempo de download do modelo, que depende da sua conexão com a internet.

Se você já baixou o arquivo GGUF do modelo, a instalação vai ser ainda mais rápida. Nesse caso, você pode pular totalmente o download do modelo e só registrar o arquivo GGUF que já existe no Ollama, criando umarquivo de modelo .

Isso permite que você defina os parâmetros de geração uma vez e reutilize o modelo de forma consistente em todas as execuções e ferramentas.

Crie um arquivo chamado Modelfile no mesmo diretório do seu arquivo GGUF:

FROM ./glm-4.7-flash.gguf

PARAMETER temperature 0.8

PARAMETER top_p 0.95

PARAMETER repeat_penalty 1.0Você pode ajustar os parâmetros conforme necessário:

- Temperatura: 0,7 a 1,0

- Top-p: 0,95 a 1,0

- Penalidade de repetição: desativada ou definida como 1,0

Cadastre o modelo no Ollama:

ollama create glm-4.7-flash-local -f ModelfileDepois que o modelo estiver pronto, você pode rodá-lo direto no modo de bate-papo:

ollama run glm-4.7-flash-localAgora, o modelo pode ser usado como qualquer outro modelo Ollama e integrado perfeitamente ao Claude Code.

Eu me diverti muito criando aplicativos e jogos usando o GLM 4.7 Flash dentro do Claude Code. É realmente empoderador trabalhar em um lugar remoto, sem internet ou com conexão instável. Tudo funciona localmente, nada dá errado e você ainda tem um poderoso agente de codificação ao seu alcance. É difícil superar essa sensação de controle e independência.

Se você quiser saber mais sobre as ferramentas que falamos neste artigo, recomendo os seguintes recursos:

Perguntas frequentes

Quais modelos locais funcionam melhor para a codificação agênica?

Executar o Claude Code com o Ollama é uma das configurações mais poderosas de “vibe-coding” para 2026. Isso permite que você use o agente de terminal avançado da Anthropic, mantendo seu código-fonte totalmente privado e evitando taxas caras de API.

Desde o Ollama v0.14, ele tem compatibilidade nativa com a API Anthropic Messages, o que significa que você pode trocar o backend na nuvem por um local com algumas variáveis de ambiente.

5 Perguntas frequentes gerais sobre Claude Code + Ollama

1. Como faço para apontar o Claude Code para o meu servidor Ollama local?

O Claude Code procura a API Anthropic por padrão. Para redirecioná-lo para o Ollama, você precisa definir essas três variáveis de ambiente no seu terminal antes de rodar o comando ` claude `:

- Linux/macOS:

Bash

export ANTHROPIC_BASE_URL="http://localhost:11434" export ANTHROPIC_AUTH_TOKEN="ollama" export ANTHROPIC_API_KEY="" - Windows (PowerShell):

PowerShell

$env:ANTHROPIC_BASE_URL = "http://localhost:11434" $env:ANTHROPIC_AUTH_TOKEN = "ollama" $env:ANTHROPIC_API_KEY = ""

Dica: Se você estiver usando a versão mais recente do Ollama, basta executar

ollama launch claudepara que essas variáveis sejam configuradas automaticamente para você.

2. Quais modelos locais funcionam melhor para a codificação agênica?

Nem todo modelo local consegue lidar com as instruções “agentes” complexas (chamada de ferramentas, leitura de arquivos e planejamento em várias etapas) que o Claude Code precisa. No começo de 2026, os favoritos da galera são:

- GLM 4.7 Flash: Altamente otimizado para velocidade e janelas de contexto grandes (128k).

- Codificador Qwen 2.5 (32B ou 7B): Atualmente, é o padrão ouro para raciocínio de codificação de código aberto.

- Codestral: Ótimo para Python e lógica complexa, mas mais pesado no hardware.

Quais são os requisitos mínimos de hardware?

Como o Claude Code manda um monte de comandos para o sistema (~16 mil tokens) para definir como ele funciona, o hardware é o principal problema:

- Recomendado: GPU NVIDIA com 16 GB-24 GB de VRAM (por exemplo, RTX 3090/4090) ou um Mac da série M da Apple com 32 GB+ de RAM.

- Mínimo: 16 GB de RAM no total. Se você não tiver uma GPU, pode rodar modelos menores (como o Qwen 7B) na sua CPU, mas espere que o “Modo de Planejamento” demore vários minutos por etapa.

Por que o Claude Code fica tentando se conectar à internet?

Mesmo com um modelo local, o Claude Code pode tentar enviar tráfego “não essencial”, como telemetria ou verificações de atualização. Se você estiver em um ambiente totalmente offline ou quiser o máximo de privacidade, defina essa variável extra:

export CLAUDE_CODE_DISABLE_NONESSENTIAL_TRAFFIC=1

Isso garante que o agente não “ligue para casa” e fique só na sua rede local.

Posso usar o “Modo de Planejamento” com modelos locais?

Sim. Modelos locais que suportam o uso de ferramentas (como GLM 4.7 Flash ou Qwen 2.5 Coder) podem lidar com o modo de planejamento do Claude Code. Mas, se o modelo não for potente o suficiente, ele pode ficar preso num “loop de pensamento”, repetindo sempre a mesma etapa.

- Fix: Se isso acontecer, tente uma quantização maior (por exemplo, passando de uma versão

q4para uma versãoq8oufp16do modelo) ou aumente seunum_ctx(janela de contexto) no seu arquivo Ollama Modelfile para pelo menos 32.000.

Sou um cientista de dados certificado que gosta de criar aplicativos de aprendizado de máquina e escrever blogs sobre ciência de dados. No momento, estou me concentrando na criação e edição de conteúdo e no trabalho com modelos de linguagem de grande porte.