Programa

O Change Data Capture (CDC) ajuda a manter os pipelines de dados eficientes, capturando apenas inserções, atualizações e exclusões, em vez de recarregar conjuntos de dados inteiros. Isso reduz o tempo de processamento e a carga do sistema.

O CDC também é essencial no streaming de dados em tempo real, integrando-se a plataformas como o Apache Kafka para permitir arquiteturas orientadas por eventos.

Vamos nos aprofundar no CDC e em como ele pode melhorar seus projetos de dados!

O que é Change Data Capture (CDC)?

O Change Data Capture é uma abordagem que detecta, captura e encaminha apenas os dados modificados de um sistema de origem para sistemas downstream, como data warehouses, dashboards ou aplicativos de streaming.

Em vez de reprocessar conjuntos de dados inteiros, o CDC se concentra apenas em mudanças incrementais, garantindo que os sistemas-alvo sempre tenham acesso aos dados mais atuais disponíveis.

Em um projeto de análise em tempo real, enfrentei atrasos significativos nos relatórios devido às atualizações em lote. Ao mudar para uma solução de CDC baseada em log, reduzi drasticamente o atraso na atualização dos dados de horas para segundos, tornando o painel de análise realmente em tempo real.

Com essa experiência pessoal ressaltando o valor prático do CDC, vamos agora falar sobre os diferentes métodos usados para implementar o CDC.

Métodos para implementar a captura de dados de alteração

Antes de se aprofundar em técnicas específicas, é importante reconhecer que não há uma abordagem única para todos os cenários. Abaixo estão quatro métodos comuns de CDC, cada um com suas próprias vantagens e desvantagens.

CDC baseado em registro

O CDC baseado em logs lê os logs de transação de um banco de dados (geralmente chamados de Write-Ahead Logs, ou WAL) para identificar as alterações instantaneamente à medida que elas ocorrem. Esse método é altamente eficiente porque opera em um nível baixo, capturando alterações com o mínimo de interrupção no sistema de produção.

- Vantagens: A baixa sobrecarga do sistema e o desempenho quase em tempo real o tornam ideal para ambientes de alto volume.

- Desvantagens: Requer acesso privilegiado aos logs de transações e depende de configurações adequadas de retenção de logs.

Por exemplo, no PostgreSQL, você pode configurar a replicação lógica para capturar alterações do WAL:

-- Enable logical replication

ALTER SYSTEM SET wal_level = logical;

-- Create a logical replication slot to capture changes

SELECT pg_create_logical_replication_slot('cdc_slot', 'pgoutput');

-- Fetch recent changes from the WAL

SELECT * FROM pg_logical_slot_get_changes('cdc_slot', NULL, NULL);Essa abordagem permite que uma ferramenta CDC (como o Debezium ou o AWS DMS, que exploraremos mais adiante) transmita continuamente as alterações do banco de dados para um sistema downstream sem depender de consultas programadas.

CDC baseado em gatilho

O CDC baseado em gatilhos usa gatilhos de banco de dados anexados a eventos da tabela de origem (inserções, atualizações ou exclusões) para registrar automaticamente as alterações assim que elas ocorrem. Esse método é simples para bancos de dados que suportam acionadores e fornece captura imediata de alterações; no entanto, ele pode adicionar carga extra ao banco de dados e complicar as alterações de esquema se não for gerenciado com cuidado.

- Vantagens: Fácil de implementar em bancos de dados que suportam acionadores e garante a captura imediata de alterações.

- Desvantagens: Isso pode adicionar carga extra ao banco de dados e complicar as alterações de esquema se não for gerenciado com cuidado.

O CDC baseado em gatilho oferece imediatismo, mas com o custo potencial da sobrecarga adicional, por isso é mais adequado em ambientes com volumes de transação moderados.

No PostgreSQL, você pode criar um acionador para registrar as alterações de uma tabela customers em uma tabela customers_audit separada:

-- Create an audit table to store changes

CREATE TABLE customers_audit (

audit_id SERIAL PRIMARY KEY,

operation_type TEXT,

customer_id INT,

customer_name TEXT,

modified_at TIMESTAMP DEFAULT now()

);

-- Create a function to insert change records

CREATE OR REPLACE FUNCTION capture_customer_changes()

RETURNS TRIGGER AS $

BEGIN

IF TG_OP = 'INSERT' THEN

INSERT INTO customers_audit (operation_type, customer_id, customer_name)

VALUES ('INSERT', NEW.id, NEW.name);

ELSIF TG_OP = 'UPDATE' THEN

INSERT INTO customers_audit (operation_type, customer_id, customer_name)

VALUES ('UPDATE', NEW.id, NEW.name);

ELSIF TG_OP = 'DELETE' THEN

INSERT INTO customers_audit (operation_type, customer_id, customer_name)

VALUES ('DELETE', OLD.id, OLD.name);

END IF;

RETURN NULL; -- No need to modify original table data

END;

$ LANGUAGE plpgsql;

-- Attach the trigger to the customers table

CREATE TRIGGER customer_changes_trigger

AFTER INSERT OR UPDATE OR DELETE ON customers

FOR EACH ROW EXECUTE FUNCTION capture_customer_changes();Esse acionador garante que cada INSERT, UPDATE ou DELETE na tabela customers seja registrado em customers_audit em tempo real.

CDC baseado em pesquisas de opinião

O CDC baseado em sondagem consulta periodicamente o banco de dados de origem para verificar se há alterações com base em uma coluna de carimbo de data/hora ou versão. Embora esse método evite a necessidade de acesso direto a logs de transações ou acionadores, ele pode introduzir latência porque as alterações são detectadas somente em intervalos fixos.

- Vantagens: Simples de implementar quando o acesso ao registro ou os acionadores não estão disponíveis.

- Desvantagens: Isso pode atrasar a captura de alterações e aumentar a carga se a sondagem for muito frequente.

Essa abordagem funciona bem em circunstâncias em que o acesso em tempo real aos logs não está disponível, embora a desvantagem seja um pequeno atraso na detecção de alterações.

Imagine uma tabela products com uma coluna version_number que aumenta a cada atualização:

SELECT *

FROM products

WHERE version_number > 1050

ORDER BY version_number ASC;Aqui, 1050 é o último número de versão processado do ciclo de pesquisa anterior. Isso garante que apenas as novas alterações sejam obtidas sem depender de carimbos de data/hora, tornando-o mais robusto quando os relógios do sistema não são confiáveis.

CDC baseado em carimbo de data/hora

O CDC baseado em carimbo de data/hora depende de uma coluna dedicada que registra a hora da última modificação de cada registro. Ao comparar esses carimbos de data e hora, o sistema identifica os registros que foram alterados desde a verificação anterior.

Esse método é semelhante ao CDC baseado em sondagem, mas é mais estruturado, pois exige um mecanismo explícito para rastrear as alterações:

- O CDC baseado em sondagem é uma abordagem mais ampla que consulta periodicamente as alterações usando qualquer padrão identificável (registros de data e hora, números de versão ou outros indicadores).

- O CDC baseado em carimbo de data/hora depende de uma coluna de carimbo de data/hora que deve ser mantida com precisão no banco de dados de origem.

Embora seja fácil de implementar quando o banco de dados atualiza automaticamente os carimbos de data/hora, isso depende da consistência dos relógios do sistema e da confiabilidade das atualizações dos carimbos de data/hora.

- Vantagens: Abordagem simples quando os sistemas atualizam automaticamente os registros de data e hora.

- Desvantagens: A precisão depende da sincronização consistente do relógio e de atualizações confiáveis do carimbo de data/hora.

Suponha que você tenha uma tabela orders com uma coluna last_modified que é atualizada sempre que uma linha é inserida ou modificada. A consulta SQL a seguir obtém todas as alterações desde a última verificação:

SELECT *

FROM orders

WHERE last_modified > '2025-02-25 12:00:00'

ORDER BY last_modified ASC;Esse método funciona bem quando o banco de dados atualiza automaticamente o carimbo de data/hora após a modificação, como o uso de acionadores ou mecanismos integrados, como o DEFAULT now() do PostgreSQL ou o ON UPDATE CURRENT_TIMESTAMP do MySQL.

Tabela de comparação de métodos CDC

Aqui está uma tabela de comparação que destaca as principais diferenças entre os quatro métodos de Change Data Capture (CDC):

|

Recurso |

CDC baseado em registro |

CDC baseado em gatilho |

CDC baseado em pesquisas de opinião |

CDC baseado em carimbo de data/hora |

|

Como funciona |

Lê os logs de transação do banco de dados (WAL, binlog, etc.) para capturar alterações em tempo real. |

Usa acionadores de banco de dados para registrar alterações em uma tabela de auditoria. |

Consulta periodicamente as alterações usando um número de versão ou outros critérios. |

Compara os registros de data e hora em uma coluna para detectar alterações. |

|

Latência |

Quase em tempo real (baixa latência). |

Imediato (os acionadores são executados instantaneamente). |

Intervalos programados (podem introduzir atrasos). |

Depende da frequência de sondagem (latência baixa a moderada). |

|

Custos indiretos do sistema |

Baixa (não requer consulta a tabelas). |

Alta (acionadores são executados a cada alteração). |

Moderado (depende da frequência da pesquisa). |

Baixo a moderado (depende de registros de data e hora). |

|

Complexidade da implementação |

Alta (requer acesso a registros de transações e retenção adequada). |

Médio-alto (requer a criação de acionadores e a manutenção de uma tabela de auditoria). |

Baixo (depende de consultas SQL simples). |

Baixo (simples se os registros de data e hora forem gerenciados automaticamente). |

|

Requisitos de acesso |

Acesso privilegiado a registros de transações. |

Requer acesso DDL para criar acionadores. |

Você não precisa de acesso especial (SQL padrão). |

Você não precisa de acesso especial (SQL padrão). |

|

Você tem suporte para exclusões? |

Sim (capturado dos registros). |

Sim (se estiver registrado na tabela de auditoria). |

Precisa de rastreamento adicional (por exemplo, uma tabela de exclusão separada). |

Somente se forem usadas exclusões flexíveis (deleted_at). |

|

Melhor caso de uso |

Replicação em tempo real de alto volume, em que a carga mínima do banco de dados é crucial. |

Cargas de trabalho pequenas e médias que precisam de captura instantânea de alterações. |

Quando o CDC e os acionadores baseados em log não estão disponíveis, mas atualizações periódicas são aceitáveis. |

Quando os registros de data e hora são atualizados automaticamente e é possível fazer pesquisas frequentes. |

|

Ferramentas comuns |

Debezium, AWS DMS, StreamSets, Striim, HVR |

Acionadores nativos de banco de dados (PostgreSQL, MySQL, SQL Server, Oracle) |

Apache Airflow, scripts ETL (Python, SQL) |

Trabalhos de ETL, pipelines de dados em lote |

Casos de uso para captura de dados de alteração

Compreender os métodos é apenas a metade da história; ver como o CDC oferece valor tangível em cenários do mundo real é igualmente importante.

Armazenamento de dados em tempo real

O CDC permite atualizações contínuas e incrementais nos data warehouses, propagando apenas as alterações em vez de recarregar conjuntos de dados completos. Essa abordagem garante que as ferramentas e os painéis de business intelligence exibam os dados mais atuais.

Por exemplo, uma empresa de varejo pode atualizar seu painel de vendas quase em tempo real para revelar rapidamente tendências e percepções emergentes.

Replicação de dados

O CDC replica dados entre sistemas, garantindo que qualquer alteração feita no sistema de origem seja imediatamente espelhada nos bancos de dados de destino. Isso é especialmente útil durante projetos de migração de dados ou ao manter backups e réplicas em ambientes híbridos.

Por exemplo, a replicação de dados de sistemas locais para bancos de dados na nuvem, como o AWS RDS ou o Snowflake, garante a consistência entre as plataformas.

Sincronização de dados

Em sistemas distribuídos, como os que envolvem microsserviços ou vários aplicativos, o CDC garante que cada componente opere com os dados mais atualizados, sincronizando as alterações em tempo real.

Por exemplo, a sincronização das informações do cliente em várias plataformas mantém uma experiência de usuário consistente em todas elas.

Auditoria e monitoramento de dados

Por fim, o CDC fornece registros detalhados de alterações que são essenciais para fins de auditoria. Ao rastrear quem fez as alterações e quando elas ocorreram, as equipes podem atender aos requisitos regulamentares, solucionar problemas e realizar análises forenses detalhadas.

As instituições financeiras, por exemplo, dependem de registros abrangentes de CDC para auditar as modificações nos dados dos clientes e garantir a conformidade com políticas rigorosas de governança de dados.

Ferramentas para implementar a captura de dados de mudança

Depois de explorar os métodos e os casos de uso, vamos examinar algumas ferramentas populares que facilitam as implementações do CDC. A escolha certa depende do seu caso de uso -se você precisa de streaming em tempo real, migração para a nuvem ou soluções ETL empresariais.

Serviço de migração de banco de dados do AWS (DMS)

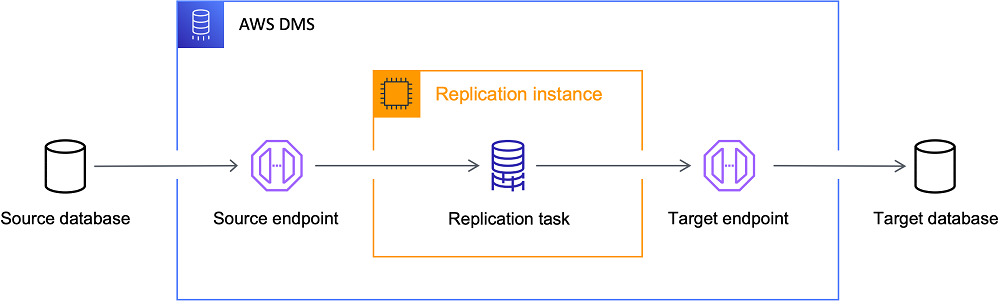

O AWS DMS usa CDC baseado em log para replicar continuamente os dados dos sistemas locais para a nuvem do AWS com o mínimo de tempo de inatividade, o que o torna uma excelente opção para migrações. O AWS DMS é uma solução robusta se o seu objetivo for mover dados para a nuvem com tempo de atividade confiável.

Melhor para: Migrações para a nuvem e arquiteturas baseadas em AWS.

A arquitetura do AWS DMS. Fonte da imagem: AWS

Debezium

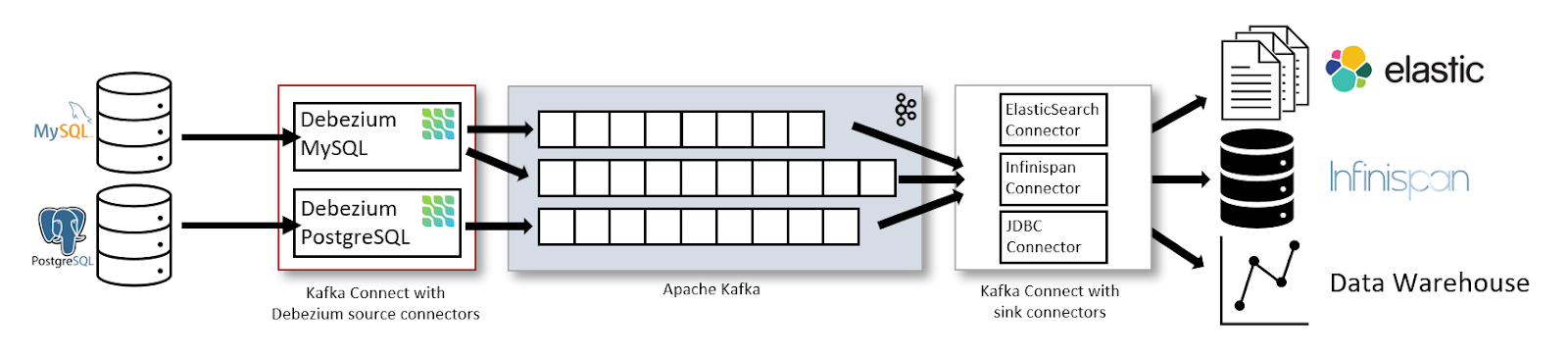

O Debezium é uma plataforma CDC de código aberto que captura e transmite as alterações do banco de dados para sistemas como o Apache Kafka.

Pessoalmente, achei o Debezium extremamente útil para transmitir alterações de banco de dados para o Kafka, especialmente em ambientes distribuídos em que vários serviços dependem de atualizações em tempo real. Seus recursos de escalabilidade e integração fazem dele uma opção de destaque.

Melhor para: Fluxo de dados em tempo real e arquiteturas orientadas por eventos.

A arquitetura de streaming de dados com o Kafka Connect e o Debezium. Fonte da imagem: Debezium

Apache Kafka

O Apache Kafka não é uma ferramenta de CDC propriamente dita, mas serve como espinha dorsal para o processamento de eventos de CDC quando combinado com ferramentas como o Debezium. O Kafka permite pipelines confiáveis orientados por eventos, análises em tempo real e sincronização de dados entre vários consumidores.

Melhor para: Transmissão de dados de CDC para arquiteturas orientadas por eventos.

Para ilustrar como os eventos CDC podem ser enviados para o Kafka, considere o seguinte trecho de Python. O código inicializa um produtor do Kafka e envia um evento CDC (representando uma operação de atualização em uma tabela orders ) para um tópico do Kafka chamado cdc-topic:

from kafka import KafkaProducer

import json

# Initialize the Kafka producer with bootstrap servers and a JSON serializer for values.

producer = KafkaProducer(

bootstrap_servers='localhost:9092',

value_serializer=lambda v: json.dumps(v).encode('utf-8')

)

# Define a CDC event that includes details of the operation.

cdc_event = {

"table": "orders",

"operation": "update",

"data": {"order_id": 123, "status": "shipped"}

}

# Send the CDC event to the 'cdc-topic' and flush to ensure transmission.

producer.send('cdc-topic', cdc_event)

producer.flush()

print("CDC event sent successfully!")Talend e Informatica

A Talend e a Informatica são plataformas ETL abrangentes que oferecem a funcionalidade CDC integrada para capturar e processar alterações de dados, reduzindo as configurações manuais. Eles são especialmente vantajosos em cenários complexos de transformação de dados, nos quais as soluções integradas podem simplificar as operações.

Melhor para: Soluções ETL de nível empresarial com CDC integrado.

Soluções CDC nativas de banco de dados

Vários bancos de dados relacionais oferecem recursos nativos de CDC, reduzindo a necessidade de ferramentas externas:

- Replicação lógica do PostgreSQL: Captura alterações no WAL e as transmite aos assinantes.

- Captura de dados de alteração (CDC) do SQL Server: Usa logs de transações para rastrear alterações automaticamente.

- Replicação do registro binário do MySQL (binlog): Registra as alterações para fins de replicação.

Melhor para: Minimizar as dependências de ferramentas externas de CDC.

Google Datastream e Azure Data Factory

Os provedores de nuvem também oferecem soluções de CDC para seus ecossistemas:

- Google Datastream: Um serviço de CDC e replicação totalmente gerenciado para usuários do Google Cloud.

- CDC do Azure Data Factory: Permite o rastreamento de alterações e a replicação para o Azure SQL, o CosmosDB e o Synapse Analytics.

Melhor para: CDC em ambientes do Google Cloud ou do Microsoft Azure.

Desafios e limitações do CDC

Embora o CDC ofereça benefícios significativos, ele também traz desafios que devem ser gerenciados para uma implementação confiável.

Lidar com problemas de integridade de dados

Manter a integridade dos dados pode ser um desafio ao lidar com interrupções na rede, transações atrasadas ou falhas no sistema. Protocolos robustos de tratamento de erros e reconciliações regulares são essenciais para evitar discrepâncias entre os sistemas de origem e de destino. A solução antecipada desses problemas ajuda a manter um pipeline de dados confiável.

Sobrecarga de desempenho

Certos métodos CDC, especialmente os que dependem de acionadores ou de sondagens frequentes, podem introduzir carga adicional nos bancos de dados de origem. Equilibrar a necessidade de atualizações quase em tempo real com as restrições de desempenho dos seus sistemas de produção é fundamental para uma operação tranquila.

Gerenciar transformações de dados complexas

Embora o CDC capture com eficiência as alterações brutas, pode ser necessário um processamento posterior adicional, como limpeza ou transformação de dados. A integração da lógica de transformação sem atrasar as entregas ou introduzir erros aumenta a complexidade da implementação do CDC, portanto, é necessário um planejamento cuidadoso.

Práticas recomendadas para a implementação do CDC

Para colocar a teoria em prática, você precisa aderir às práticas recomendadas. Aqui estão dicas práticas de minha experiência que me ajudaram a criar pipelines de CDC robustos.

Escolha o método de implementação correto

Selecione uma abordagem de CDC que se alinhe ao seu volume de dados, aos requisitos de latência e à arquitetura do sistema. O CDC baseado em registro geralmente é ideal para ambientes com muitas transações, enquanto os métodos baseados em acionamento ou sondagem podem ser mais adequados para aplicativos menores. Avaliar suas necessidades específicas antecipadamente pode economizar tempo e recursos posteriormente.

Monitorar trabalhos

Implemente um monitoramento abrangente usando painéis de controle em tempo real e alertas automatizados. Revisões regulares de registros e verificações de integridade são essenciais para garantir que todas as alterações sejam capturadas com precisão e que todos os problemas sejam resolvidos imediatamente.

Uma pequena configuração incorreta de CDC baseada em log em um projeto passou despercebida por dias, levando a uma perda silenciosa de dados em análises downstream. A implementação dos alertas do Grafana ajudou a detectar instantaneamente as atualizações ausentes, evitando erros dispendiosos.

Garantir a qualidade dos dados

Integrar pontos de verificação de validação de dados no pipeline do CDC para garantir que somente alterações precisas e consistentes sejam propagadas.

Pela minha experiência, a configuração de verificações de validação automatizadas no pipeline do CDC me poupou de horas de depuração de problemas de propagação de dados incorretos. Ferramentas como o dbt e o Apache Airflow têm sido fundamentais para garantir a consistência em vários sistemas downstream.

Teste as implementações antes da implantação

Antes de transferir sua solução CDC para a produção, teste-a completamente em um ambiente de preparação. Simule cargas de trabalho e cenários de falha do mundo real e valide recursos como reversão e viagem no tempo para garantir que o sistema se comporte conforme o esperado em todas as condições. Esse teste rigoroso é importante para que a implementação da produção ocorra sem problemas.

Lidar com a evolução do esquema de forma estratégica

Seu sistema CDC deve se adaptar às alterações de esquema sem interrupções à medida que seus conjuntos de dados evoluem. Use ferramentas que suportem a evolução automática do esquema e mantenha um controle de versão adequado para que os novos campos sejam integrados sem problemas. Essa abordagem estratégica evita erros inesperados e tempo de inatividade quando as estruturas de dados são alteradas.

Conclusão

Ao capturar com precisão apenas os dados modificados, o CDC minimiza a carga do sistema e permite que a análise em tempo real e os aplicativos de streaming funcionem adequadamente. Independentemente de você estar implementando a replicação, a sincronização ou o registro de auditoria de dados, selecionar o método de CDC adequado e seguir as práticas recomendadas é fundamental para criar um pipeline de dados confiável e eficiente.

Para aqueles que desejam aprofundar seus conhecimentos, incentivo você a explorar os seguintes cursos do DataCamp:

- Introdução à engenharia de dados - Aprenda técnicas básicas para criar pipelines de dados robustos e integrar várias fontes de dados.

- Fundamentos de Big Data com PySpark - Obtenha experiência prática com o Apache Spark e o PySpark para processar e analisar grandes conjuntos de dados.

- Engenheiro de dados em Python - Crie pipelines de dados de ponta a ponta usando Python, com exposição prática a ferramentas como o Apache Kafka para integração de dados de streaming.

Boa codificação - e um brinde à criação de sistemas de dados resilientes e em tempo real!

Torne-se um engenheiro de dados

Perguntas frequentes

Como o CDC aprimora a análise em tempo real em arquiteturas de dados modernas?

O CDC minimiza a necessidade de trabalhos de ETL em massa, capturando apenas alterações incrementais dos bancos de dados de origem. Isso garante que os painéis analíticos e os aplicativos de streaming sempre tenham acesso aos dados mais recentes, reduzindo a latência e a carga do sistema.

Quais são as etapas práticas para testar a implementação do CDC antes da implantação completa?

Configure um ambiente de preparação para simular cargas de produção; monitore a integridade dos dados, a latência e o tratamento de erros; e realize testes de reversão usando recursos de viagem no tempo, se disponíveis, para validar os procedimentos de recuperação.

Como posso lidar com a evolução do esquema ao usar o CDC?

Incorporar o controle de versão do esquema e as etapas de validação automatizadas no pipeline do CDC. Teste as alterações de esquema em um ambiente controlado para garantir a compatibilidade com versões anteriores e aproveite as ferramentas CDC que oferecem suporte à evolução automática do esquema.

Quais ferramentas ou práticas de monitoramento você recomenda para os pipelines de CDC?

Integre painéis (usando ferramentas como Grafana) e sistemas de alerta para acompanhar as métricas de execução do CDC. Análises regulares de logs e verificações de integridade automatizadas podem ajudar a detectar gargalos de desempenho ou problemas de qualidade de dados com antecedência.

Qual método CDC deve ser escolhido para um ambiente de alto volume e baixa latência?

O CDC baseado em log geralmente é a melhor opção para esses ambientes, pois lê diretamente dos logs de transações do banco de dados (WAL) e minimiza o impacto sobre as cargas de trabalho de produção, fornecendo atualizações quase em tempo real.