Cursus

La capture des données de changement (CDC) permet de maintenir l'efficacité des pipelines de données en capturant uniquement les insertions, les mises à jour et les suppressions au lieu de recharger des ensembles de données entiers. Cela permet de réduire le temps de traitement et la charge du système.

CDC joue également un rôle essentiel dans la diffusion de données en temps réel, en s'intégrant à des plateformes telles qu'Apache Kafka pour permettre la mise en place d'architectures axées sur les événements.

Voyons ensemble comment le CDC peut améliorer vos projets de données !

Qu'est-ce que le Change Data Capture (CDC) ?

La capture des données modifiées est une approche qui détecte, capture et transmet uniquement les données modifiées d'un système source vers des systèmes en avaltels que des entrepôts de données, des tableaux de bord ou des applications en continu.

Plutôt que de retraiter des ensembles entiers de données, le CDC se concentre uniquement sur les changements progressifs, garantissant ainsi que les systèmes cibles ont toujours accès aux données les plus récentes disponibles.

Dans le cadre d'un projet d'analyse en temps réel, j'ai été confronté à des retards importants dans la production de rapports en raison des mises à jour par lots. En passant à une solution CDC basée sur les journaux, j'ai considérablement réduit le délai de rafraîchissement des données, qui est passé de quelques heures à quelques secondes, ce qui a permis au tableau de bord analytique d'être véritablement en temps réel.

Cette expérience personnelle soulignant la valeur pratique du CDC, passons maintenant aux différentes méthodes utilisées pour mettre en œuvre le CDC.

Méthodes de mise en œuvre de la saisie des données de changement

Avant d'aborder les techniques spécifiques, il est important de reconnaître qu'il n'existe pas d'approche unique adaptée à tous les cas de figure. Vous trouverez ci-dessous quatre méthodes courantes de CDC, chacune ayant ses propres avantages et inconvénients.

CDC basé sur un journal

Le CDC basé sur les journaux lit les journaux de transactions d'une base de données (communément appelés Write-Ahead Logs, ou WAL) afin d'identifier les changements dès qu'ils se produisent. Cette méthode est très efficace parce qu'elle opère à un niveau bas, capturant les changements avec une perturbation minimale du système de production.

- Avantages: La faible surcharge du système et les performances en temps quasi réel en font un outil idéal pour les environnements à fort volume.

- Inconvénients: Elle nécessite un accès privilégié aux journaux de transactions et dépend des paramètres de conservation des journaux.

Par exemple, dans PostgreSQL, vous pouvez mettre en place une réplication logique pour capturer les modifications du WAL :

-- Enable logical replication

ALTER SYSTEM SET wal_level = logical;

-- Create a logical replication slot to capture changes

SELECT pg_create_logical_replication_slot('cdc_slot', 'pgoutput');

-- Fetch recent changes from the WAL

SELECT * FROM pg_logical_slot_get_changes('cdc_slot', NULL, NULL);Cette approche permet à un outil CDC (tel que Debezium ou AWS DMS, que nous étudierons plus loin) de transmettre en continu les modifications apportées à la base de données à un système en aval, sans avoir recours à des requêtes programmées.

CDC basé sur des déclencheurs

Le CDC basé sur des déclencheurs utilise des déclencheurs de base de données liés aux événements des tableaux sources (insertions, mises à jour ou suppressions) pour enregistrer automatiquement les modifications dès qu'elles se produisent. Cette méthode est simple pour les bases de données qui prennent en charge les déclencheurs et permet de capturer immédiatement les modifications ; toutefois, elle peut ajouter une charge supplémentaire à la base de données et compliquer les modifications de schéma si elle n'est pas gérée avec soin.

- Avantages : Il est facile à mettre en œuvre sur les bases de données qui prennent en charge les déclencheurs et garantit une capture immédiate des changements.

- Inconvénients : Il peut ajouter une charge supplémentaire à la base de données et compliquer les changements de schéma s'il n'est pas géré avec soin.

Le CDC basé sur des déclencheurs offre l'immédiateté, mais au prix potentiel d'un surcroît de travail. Il convient donc mieux aux environnements dont les volumes de transactions sont modérés.

Dans PostgreSQL, vous pouvez créer un déclencheur pour enregistrer les modifications d'un tableau customers dans un tableau customers_audit distinct :

-- Create an audit table to store changes

CREATE TABLE customers_audit (

audit_id SERIAL PRIMARY KEY,

operation_type TEXT,

customer_id INT,

customer_name TEXT,

modified_at TIMESTAMP DEFAULT now()

);

-- Create a function to insert change records

CREATE OR REPLACE FUNCTION capture_customer_changes()

RETURNS TRIGGER AS $

BEGIN

IF TG_OP = 'INSERT' THEN

INSERT INTO customers_audit (operation_type, customer_id, customer_name)

VALUES ('INSERT', NEW.id, NEW.name);

ELSIF TG_OP = 'UPDATE' THEN

INSERT INTO customers_audit (operation_type, customer_id, customer_name)

VALUES ('UPDATE', NEW.id, NEW.name);

ELSIF TG_OP = 'DELETE' THEN

INSERT INTO customers_audit (operation_type, customer_id, customer_name)

VALUES ('DELETE', OLD.id, OLD.name);

END IF;

RETURN NULL; -- No need to modify original table data

END;

$ LANGUAGE plpgsql;

-- Attach the trigger to the customers table

CREATE TRIGGER customer_changes_trigger

AFTER INSERT OR UPDATE OR DELETE ON customers

FOR EACH ROW EXECUTE FUNCTION capture_customer_changes();Ce déclencheur garantit que chaque INSERT, UPDATE ou DELETE du tableau customers est connecté à customers_audit en temps réel.

CDC par sondage

Le CDC par interrogation interroge périodiquement la base de données source pour vérifier les modifications en fonction d'un horodatage ou d'une colonne de version. Si cette méthode permet d'éviter l'accès direct aux journaux de transactions ou aux déclencheurs, elle peut toutefois introduire un temps de latence car les changements ne sont détectés qu'à intervalles fixes.

- Avantages : Simple à mettre en œuvre lorsque l'accès au journal ou les déclencheurs ne sont pas disponibles.

- Inconvénients : Cela peut retarder la saisie des modifications et augmenter la charge si les interrogations sont trop fréquentes.

Cette approche fonctionne bien dans les cas où l'accès en temps réel aux journaux n'est pas disponible, bien que la contrepartie soit un léger retard dans la détection des changements.

Imaginez un tableau products avec une colonne version_number qui s'incrémente à chaque mise à jour :

SELECT *

FROM products

WHERE version_number > 1050

ORDER BY version_number ASC;Ici, 1050 est le dernier numéro de version traité lors du cycle d'interrogation précédent. Cela permet de s'assurer que seules les nouvelles modifications sont récupérées sans s'appuyer sur les horodatages, ce qui rend le système plus robuste lorsque les horloges du système ne sont pas fiables.

CDC basé sur l'horodatage

Le CDC basé sur l'horodatage s'appuie sur une colonne dédiée qui enregistre l'heure de la dernière modification de chaque enregistrement. En comparant ces horodatages, le système identifie les enregistrements qui ont été modifiés depuis le contrôle précédent.

Cette méthode est similaire au CDC basé sur les sondages, mais elle est plus structurée, car elle nécessite un mécanisme explicite de suivi des modifications :

- Le CDC basé sur l'interrogation est une approche plus large qui interroge périodiquement les changements en utilisant un modèle identifiable (horodatage, numéro de version ou autres indicateurs).

- Le CDC basé sur l'horodatage dépend d'une colonne d'horodatage qui doit être maintenue avec précision dans la base de données source.

Bien qu'elle soit facile à mettre en œuvre lorsque la base de données met automatiquement à jour les horodatages, elle dépend de la cohérence des horloges du système et de la fiabilité des mises à jour des horodatages.

- Avantages : Approche simple lorsque les systèmes mettent automatiquement à jour les horodatages.

- Inconvénients : La précision dépend de la cohérence de la synchronisation de l'horloge et de la fiabilité des mises à jour de l'horodatage.

Supposons que nous ayons un tableau orders avec une colonne last_modified qui se met à jour chaque fois qu'une ligne est insérée ou modifiée. La requête SQL suivante permet de récupérer toutes les modifications intervenues depuis le dernier contrôle :

SELECT *

FROM orders

WHERE last_modified > '2025-02-25 12:00:00'

ORDER BY last_modified ASC;Cette méthode fonctionne bien lorsque la base de données met automatiquement à jour l'horodatage en cas de modification, par exemple à l'aide de déclencheurs ou de mécanismes intégrés tels que DEFAULT now() de PostgreSQL ou ON UPDATE CURRENT_TIMESTAMP de MySQL.

Tableau comparatif des méthodes du CDC

Voici un tableau comparatif mettant en évidence les principales différences entre les quatre méthodes de capture des données de changement (CDC) :

|

Fonctionnalité |

CDC basé sur un journal |

CDC basé sur des déclencheurs |

CDC par sondage |

CDC basé sur l'horodatage |

|

Comment cela fonctionne-t-il ? |

Lit les journaux de transactions de la base de données (WAL, binlog, etc.) pour capturer les changements en temps réel. |

Utilise des déclencheurs de base de données pour enregistrer les modifications dans un tableau d'audit. |

Recherche périodiquement les modifications à l'aide d'un numéro de version ou d'autres critères. |

Compare les horodatages d'une colonne pour détecter les changements. |

|

Temps de latence |

Presque en temps réel (faible latence). |

Immédiat (les déclencheurs s'exécutent instantanément). |

Intervalles programmés (peuvent entraîner des retards). |

Dépend de la fréquence d'interrogation (latence faible à modérée). |

|

Frais généraux du système |

Faible (ne nécessite pas d'interroger les tableaux). |

Élevé (les déclencheurs sont exécutés à chaque changement). |

Modéré (en fonction de la fréquence des sondages). |

Faible à modéré (repose sur les horodatages). |

|

Complexité de la mise en œuvre |

Élevé (nécessite l'accès aux journaux des transactions et une conservation adéquate). |

Moyenne-élevée (nécessite la création de déclencheurs et la mise à jour d'un tableau d'audit). |

Faible (repose sur des requêtes SQL simples). |

Faible (simple si les horodatages sont gérés automatiquement). |

|

Conditions d'accès |

Accès privilégié aux journaux de transactions. |

Nécessite un accès DDL pour créer des déclencheurs. |

Aucun accès particulier n'est nécessaire (SQL standard). |

Aucun accès particulier n'est nécessaire (SQL standard). |

|

Prend en charge les suppressions ? |

Oui (capturé à partir des journaux). |

Oui (si elle est enregistrée dans le tableau d'audit). |

Nécessite un cursus supplémentaire (par exemple, un tableau de suppression distinct). |

Seulement si des suppressions douces (deleted_at) sont utilisées. |

|

Meilleur cas d'utilisation |

Réplication en temps réel de gros volumes où une charge minimale de la base de données est cruciale. |

Charges de travail petites à moyennes nécessitant une capture instantanée des changements. |

Lorsque les CDC et les déclencheurs basés sur les journaux ne sont pas disponibles, mais que des mises à jour périodiques sont acceptables. |

Lorsque les horodatages sont automatiquement mis à jour et qu'il est possible d'effectuer des sondages fréquents. |

|

Outils communs |

Debezium, AWS DMS, StreamSets, Striim, HVR |

Déclencheurs natifs des bases de données (PostgreSQL, MySQL, SQL Server, Oracle) |

Apache Airflow, scripts ETL (Python, SQL) |

Travaux ETL, pipelines de données par lots |

Cas d'utilisation pour la saisie des données de changement

Comprendre les méthodes n'est qu'une partie de l'histoire ; il est tout aussi important de voir comment le CDC apporte une valeur tangible dans des scénarios réels.

Entreposage de données en temps réel

CDC permet des mises à jour continues et incrémentales des entrepôts de données en ne propageant que les changements au lieu de recharger des ensembles de données complets. Cette approche garantit que les outils de veille stratégique et les tableaux de bord affichent les données les plus récentes.

Par exemple, une entreprise de vente au détail peut mettre à jour son tableau de bord des ventes en temps quasi réel pour révéler rapidement les tendances et les informations émergentes.

Réplication des données

CDC réplique les données entre les systèmes en veillant à ce que toute modification apportée au système source soit immédiatement répercutée dans les bases de données cibles. Ceci est particulièrement utile lors de projets de migration de données ou lors de la gestion de sauvegardes et de répliques dans des environnements hybrides.

Par exemple, la réplication des données des systèmes sur site vers des bases de données dans le cloud, telles que AWS RDS ou Snowflake, garantit la cohérence entre les plateformes.

Synchronisation des données

Dans les systèmes distribués, tels que ceux qui impliquent des microservices ou des applications multiples, la CCD garantit que chaque composant fonctionne sur les données les plus récentes en synchronisant les changements en temps réel.

Par exemple, la synchronisation des informations sur les clients entre les différentes plateformes permet de maintenir une expérience utilisateur cohérente.

Audit et contrôle des données

Enfin, CDC fournit des journaux de modifications détaillés qui sont essentiels à des fins d'audit. Grâce au cursus permettant de savoir qui a effectué les modifications et quand elles ont eu lieu, les équipes peuvent répondre aux exigences réglementaires, résoudre les problèmes et effectuer des analyses médico-légales approfondies.

Les institutions financières, par exemple, s'appuient sur des journaux CDC complets pour contrôler les modifications apportées aux données des clients et garantir le respect de politiques strictes en matière de gouvernance des données.

Outils pour la mise en œuvre de la saisie des données de changement

Après avoir exploré les méthodes et les cas d'utilisation, examinons quelques outils populaires qui facilitent la mise en œuvre des CDC. Le bon choix dépend de votre cas d'utilisation -si vous avez besoin de streaming en temps réel, de migration vers le cloud ou de solutions ETL d'entreprise.

Service de migration des bases de données AWS (DMS)

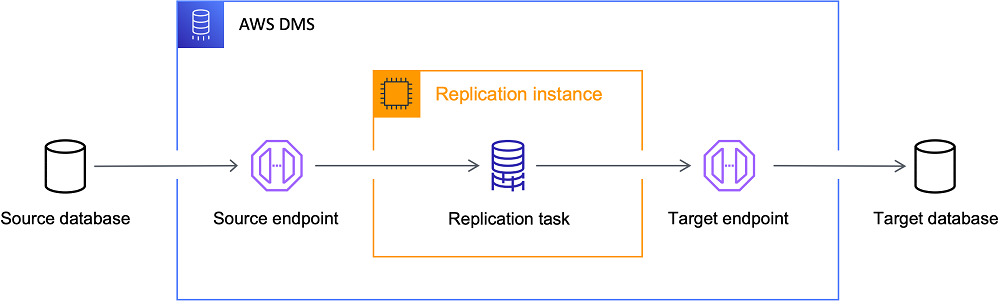

AWS DMS utilise un CDC basé sur des journaux pour répliquer en continu les données des systèmes sur site vers le cloud AWS avec un temps d'arrêt minimal, ce qui en fait un excellent choix pour les migrations. AWS DMS est une solution robuste si votre objectif est de déplacer des données vers le cloud avec un temps de disponibilité fiable.

Meilleur pour: Les migrations vers le cloud et les architectures basées sur AWS.

L'architecture DMS d'AWS. Source de l'image : AWS

Debezium

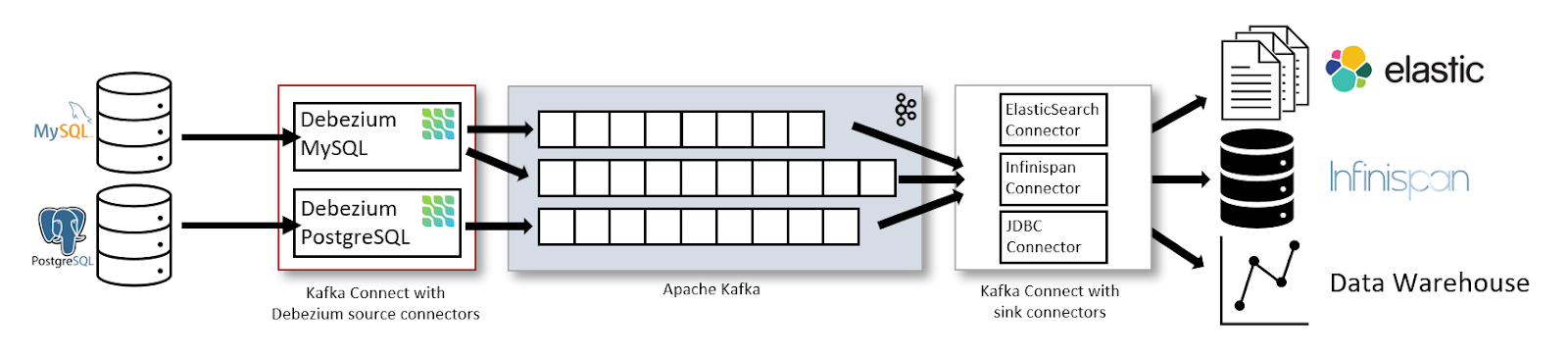

Debezium est une plateforme CDC open-source qui capture et diffuse les modifications apportées aux bases de données dans des systèmes tels qu'Apache Kafka.

Personnellement, j'ai trouvé Debezium extrêmement utile pour diffuser en continu les modifications de la base de données dans Kafka, en particulier dans les environnements distribués où plusieurs services dépendent de mises à jour en temps réel. Son évolutivité et ses capacités d'intégration en font une option de choix.

Meilleur pour: Flux de données en temps réel et architectures pilotées par les événements.

L'architecture de flux de données avec Kafka Connect et Debezium. Source de l'image : Debezium

Apache Kafka

Apache Kafka n'est pas un outil CDC en soi, mais sert d'épine dorsale pour le traitement des événements CDC lorsqu'il est associé à des outils tels que Debezium. Kafka permet de créer des pipelines fiables basés sur des événements, des analyses en temps réel et la synchronisation des données entre plusieurs consommateurs.

Meilleur pour: Flux de données CDC vers des architectures pilotées par les événements.

Pour illustrer la manière dont les événements CDC peuvent être envoyés à Kafka, considérez l'extrait Python suivant. Le code initialise un producteur Kafka et envoie un événement CDC (représentant une opération de mise à jour sur un tableau orders ) à un sujet Kafka nommé cdc-topic:

from kafka import KafkaProducer

import json

# Initialize the Kafka producer with bootstrap servers and a JSON serializer for values.

producer = KafkaProducer(

bootstrap_servers='localhost:9092',

value_serializer=lambda v: json.dumps(v).encode('utf-8')

)

# Define a CDC event that includes details of the operation.

cdc_event = {

"table": "orders",

"operation": "update",

"data": {"order_id": 123, "status": "shipped"}

}

# Send the CDC event to the 'cdc-topic' and flush to ensure transmission.

producer.send('cdc-topic', cdc_event)

producer.flush()

print("CDC event sent successfully!")Talend et Informatica

Talend et Informatica sont des plateformes ETL complètes qui offrent des fonctionnalités CDC intégrées pour capturer et traiter les changements de données, réduisant ainsi les configurations manuelles. Elles sont particulièrement avantageuses dans les scénarios de transformation de données complexes, où des solutions intégrées peuvent simplifier les opérations.

Meilleur pour: Solutions ETL d'entreprise avec CDC intégré.

Solutions CDC basées sur des bases de données

Plusieurs bases de données relationnelles offrent des fonctions CDC natives, ce qui réduit la nécessité de recourir à des outils externes :

- Réplication logique de PostgreSQL : Capture les changements dans le WAL et les transmet aux abonnés.

- SQL Server change data capture (CDC) : Utilise les journaux de transactions pour suivre automatiquement les modifications.

- Réplication du journal binaire (binlog) de MySQL : Enregistre les modifications à des fins de réplication.

Meilleur pour: Réduire au minimum les dépendances à l'égard d'outils CDC externes.

Google Datastream et Azure Data Factory

Les fournisseurs de cloud proposent également des solutions CDC pour leurs écosystèmes :

- Google Datastream: Un service de CDC et de réplication entièrement géré pour les utilisateurs de Google Cloud.

- Azure Data Factory CDC : Permet le suivi des modifications et la réplication pour Azure SQL, CosmosDB et Synapse Analytics.

Meilleur pour: CDC au sein des environnements Google Cloud ou Microsoft Azure.

Défis et limites du CDC

Si le CDC offre des avantages considérables, il s'accompagne également de défis qu'il convient de relever pour une mise en œuvre fiable.

Traitement des problèmes d'intégrité des données

Le maintien de l'intégrité des données peut s'avérer difficile en cas d'interruption du réseau, de retard dans les transactions ou de défaillance du système. Des protocoles robustes de traitement des erreurs et des rapprochements réguliers sont essentiels pour prévenir les divergences entre les systèmes source et cible. Le fait de traiter ces problèmes à un stade précoce permet de maintenir un pipeline de données fiable.

Frais généraux de performance

Certaines méthodes CDC - en particulier celles qui reposent sur des déclencheurs ou des interrogations fréquentes - peuvent entraîner une charge supplémentaire sur les bases de données sources. L'équilibre entre le besoin de mises à jour en temps quasi réel et les contraintes de performance de vos systèmes de production est la clé d'une opération sans heurts.

Gérer des transformations de données complexes

Bien que le CDC capture efficacement les changements bruts, un traitement supplémentaire en aval, tel que le nettoyage ou la transformation des données, peut être nécessaire. L'intégration de la logique de transformation sans retarder les livraisons ou introduire des erreurs ajoute de la complexité à la mise en œuvre du CDC, d'où la nécessité d'une planification minutieuse.

Bonnes pratiques pour la mise en œuvre du CDC

La mise en pratique de la théorie exige le respect des meilleures pratiques. Voici des conseils pratiques tirés de mon expérience qui m'ont aidé à construire des pipelines CDC solides.

Choisissez la bonne méthode de mise en œuvre

Sélectionnez une approche CDC adaptée à votre volume de données, à vos exigences en matière de latence et à l'architecture de votre système. Le CDC basé sur les journaux est généralement optimal pour les environnements à transactions élevées, tandis que les méthodes basées sur les déclencheurs ou les sondages peuvent être plus appropriées pour les applications plus petites. L'évaluation de vos besoins spécifiques dès le départ peut vous faire gagner du temps et des ressources par la suite.

Emplois de moniteur

Mettez en place une surveillance complète à l'aide de tableaux de bord en temps réel et d'alertes automatisées. Il est essentiel de procéder à des révisions régulières des journaux et à des bilans de santé pour s'assurer que chaque changement est enregistré avec précision et que tout problème est rapidement résolu.

Dans un projet, une erreur mineure de configuration du CDC, basée sur les journaux, est passée inaperçue pendant des jours, entraînant une perte de données silencieuse dans les analyses en aval. La mise en place d'alertes Grafana a permis de détecter instantanément les mises à jour manquantes, évitant ainsi des erreurs coûteuses.

Assurer la qualité des données

Intégrer des points de contrôle de la validation des données dans le pipeline CDC afin de s'assurer que seuls les changements exacts et cohérents sont propagés.

D'après mon expérience, la mise en place de contrôles de validation automatisés dans le pipeline CDC m'a épargné des heures de débogage sur des problèmes de propagation de données incorrectes. Des outils tels que dbt et Apache Airflow ont permis de renforcer la cohérence entre plusieurs systèmes en aval.

Tester les implémentations avant le déploiement

Avant de mettre votre solution CDC en production, testez-la minutieusement dans un environnement d'essai. Simulez des charges de travail et des scénarios de défaillance réels et validez des fonctions telles que le retour en arrière et le déplacement dans le temps pour vous assurer que le système se comporte comme prévu dans toutes les conditions. Ces tests rigoureux sont importants pour une mise en production sans heurts.

Gérer l'évolution des schémas de manière stratégique

Votre système CDC doit s'adapter aux changements de schémas sans interruption au fur et à mesure que vos ensembles de données évoluent. Utilisez des outils qui prennent en charge l'évolution automatique des schémas et maintenez un contrôle de version adéquat afin que les nouveaux champs soient intégrés sans heurts. Cette approche stratégique permet d'éviter les erreurs inattendues et les temps d'arrêt lorsque les structures de données changent.

Conclusion

En ne capturant avec précision que les données modifiées, CDC minimise la charge du système et permet aux applications d'analyse en temps réel et de diffusion en continu de fonctionner correctement. Que vous mettiez en œuvre la réplication des données, la synchronisation ou l'enregistrement des audits, le choix de la méthode CDC appropriée et le respect des meilleures pratiques sont essentiels à la mise en place d'un pipeline de données fiable et efficace.

Pour ceux qui souhaitent approfondir leur compréhension, je vous encourage à explorer les cours DataCamp suivants :

- Introduction à l'ingénierie des données - Apprenez les techniques de base pour construire des pipelines de données robustes et intégrer diverses sources de données.

- Principes fondamentaux du Big Data avec PySpark - Acquérir une expérience pratique avec Apache Spark et PySpark pour traiter et analyser de grands ensembles de données.

- Data Engineer en Python - Construisez des pipelines de données de bout en bout en utilisant Python, avec une exposition pratique à des outils comme Apache Kafka pour l'intégration de données en streaming.

Bon codage et à vous de construire des systèmes de données résilients et en temps réel !

Devenez ingénieur en données

FAQ

Comment le CDC améliore-t-il l'analyse en temps réel dans les architectures de données modernes ?

CDC minimise le besoin de travaux ETL en masse en ne capturant que les changements incrémentaux des bases de données sources. Ainsi, les tableaux de bord analytiques et les applications en continu ont toujours accès aux données les plus récentes, ce qui réduit la latence et la charge du système.

Quelles sont les étapes pratiques pour tester la mise en œuvre d'un CDC avant son déploiement complet ?

Mettez en place un environnement de transition pour simuler les charges de production ; contrôlez l'intégrité des données, la latence et le traitement des erreurs ; et effectuez des tests de retour en arrière à l'aide de fonctions de déplacement dans le temps, si elles sont disponibles, pour valider les procédures de récupération.

Comment gérer l'évolution des schémas lors de l'utilisation du CDC ?

Incorporer des versions de schémas et des étapes de validation automatisées dans le pipeline CDC. Testez les changements de schéma dans un environnement contrôlé pour garantir la compatibilité ascendante, et tirez parti des outils CDC qui prennent en charge l'évolution automatique des schémas.

Quels outils ou pratiques de surveillance recommandez-vous pour les pipelines CDC ?

Intégrez des tableaux de bord (à l'aide d'outils comme Grafana) et des systèmes d'alerte pour suivre les métriques d'exécution du CDC. Des examens réguliers des journaux et des contrôles de santé automatisés peuvent aider à détecter rapidement les goulets d'étranglement en matière de performances ou les problèmes de qualité des données.

Quelle méthode CDC doit être choisie pour un environnement à haut volume et à faible latence ?

Le CDC basé sur les journaux est généralement la meilleure option pour ces environnements, car il lit directement les journaux de transactions de la base de données (WAL) et minimise l'impact sur les charges de travail de production, en fournissant des mises à jour en temps quasi réel.