Lernpfad

Change Data Capture (CDC) hilft dabei, die Datenpipelines effizient zu halten, indem nur Einfügungen, Aktualisierungen und Löschungen erfasst werden, anstatt ganze Datensätze neu zu laden. Das reduziert die Bearbeitungszeit und die Systembelastung.

CDC ist auch für das Streaming von Echtzeitdaten unverzichtbar und lässt sich mit Plattformen wie Apache Kafka integrieren, um ereignisgesteuerte Architekturen zu ermöglichen.

Lass uns in die CDC eintauchen und herausfinden, wie sie deine Datenprojekte verbessern kann!

Was ist Change Data Capture (CDC)?

Change Data Capture ist ein Ansatz, der nur die geänderten Daten aus einem Quellsystem erkennt, erfasst und an nachgelagerte Systemewie Data Warehouses, Dashboards oder Streaming-Anwendungenweiterleitet.

Anstatt ganze Datensätze neu zu verarbeiten, konzentriert sich CDC ausschließlich auf inkrementelle Änderungen und stellt so sicher, dass die Zielsysteme immer auf die aktuellsten Daten zugreifen können.

Bei einem Echtzeit-Analyseprojekt kam es aufgrund von Batch-Updates zu erheblichen Verzögerungen bei der Berichterstattung. Durch die Umstellung auf eine logbasierte CDC-Lösung konnte ich die Verzögerung bei der Datenaktualität von Stunden auf Sekunden reduzieren und das Analyse-Dashboard wirklich in Echtzeit erstellen.

Da diese persönliche Erfahrung den praktischen Wert von CDC unterstreicht, wollen wir uns nun den verschiedenen Methoden zuwenden, mit denen CDC umgesetzt wird.

Methoden zur Implementierung der Änderungsdatenerfassung

Bevor du dich mit einzelnen Techniken beschäftigst, ist es wichtig zu wissen, dass es nicht nur einen Ansatz gibt, der für jedes Szenario passt. Im Folgenden werden vier gängige CDC-Methoden vorgestellt, die jeweils ihre eigenen Vorteile und Nachteile haben.

Log-basierte CDC

Log-basiertes CDC liest die Transaktionsprotokolle einer Datenbank (auch Write-Ahead Logs oder WAL genannt), um Änderungen sofort zu erkennen, wenn sie auftreten. Diese Methode ist sehr effizient, weil sie auf einer niedrigen Ebene arbeitet und Änderungen mit minimaler Unterbrechung des Produktionssystems erfasst.

- Vorteile: Geringer System-Overhead und nahezu Echtzeit-Performance machen es ideal für Umgebungen mit hohem Datenaufkommen.

- Nachteile: Sie erfordert einen privilegierten Zugriff auf die Transaktionsprotokolle und hängt von den richtigen Einstellungen für die Protokollaufbewahrung ab.

In PostgreSQL kannst du zum Beispiel eine logische Replikation einrichten, um Änderungen aus dem WAL zu erfassen:

-- Enable logical replication

ALTER SYSTEM SET wal_level = logical;

-- Create a logical replication slot to capture changes

SELECT pg_create_logical_replication_slot('cdc_slot', 'pgoutput');

-- Fetch recent changes from the WAL

SELECT * FROM pg_logical_slot_get_changes('cdc_slot', NULL, NULL);Mit diesem Ansatz kann ein CDC-Tool (wie z.B. Debezium oder AWS DMS, auf das wir später noch eingehen werden) kontinuierlich Datenbankänderungen an ein nachgelagertes System weiterleiten, ohne auf geplante Abfragen angewiesen zu sein.

Trigger-basierte CDC

Trigger-basiertes CDC verwendet Datenbank-Trigger, die an Ereignisse in der Quelltabelle (Einfügen, Aktualisieren oder Löschen) angehängt sind, um Änderungen automatisch aufzuzeichnen, sobald sie auftreten. Diese Methode ist für Datenbanken, die Trigger unterstützen, einfach und ermöglicht die sofortige Erfassung von Änderungen. Allerdings kann sie die Datenbank zusätzlich belasten und Schemaänderungen erschweren, wenn sie nicht sorgfältig durchgeführt wird.

- Vorteile: Einfache Implementierung in Datenbanken, die Trigger unterstützen, und sofortige Erfassung von Änderungen.

- Nachteile: Sie kann die Datenbank zusätzlich belasten und Schemaänderungen erschweren, wenn sie nicht sorgfältig verwaltet wird.

Trigger-basiertes CDC bietet Unmittelbarkeit, allerdings auf Kosten von zusätzlichem Overhead, weshalb es sich am besten für Umgebungen mit mäßigem Transaktionsvolumen eignet.

In PostgreSQL kannst du einen Trigger erstellen, um Änderungen aus einer Tabelle customers in einer separaten Tabelle customers_audit zu protokollieren:

-- Create an audit table to store changes

CREATE TABLE customers_audit (

audit_id SERIAL PRIMARY KEY,

operation_type TEXT,

customer_id INT,

customer_name TEXT,

modified_at TIMESTAMP DEFAULT now()

);

-- Create a function to insert change records

CREATE OR REPLACE FUNCTION capture_customer_changes()

RETURNS TRIGGER AS $

BEGIN

IF TG_OP = 'INSERT' THEN

INSERT INTO customers_audit (operation_type, customer_id, customer_name)

VALUES ('INSERT', NEW.id, NEW.name);

ELSIF TG_OP = 'UPDATE' THEN

INSERT INTO customers_audit (operation_type, customer_id, customer_name)

VALUES ('UPDATE', NEW.id, NEW.name);

ELSIF TG_OP = 'DELETE' THEN

INSERT INTO customers_audit (operation_type, customer_id, customer_name)

VALUES ('DELETE', OLD.id, OLD.name);

END IF;

RETURN NULL; -- No need to modify original table data

END;

$ LANGUAGE plpgsql;

-- Attach the trigger to the customers table

CREATE TRIGGER customer_changes_trigger

AFTER INSERT OR UPDATE OR DELETE ON customers

FOR EACH ROW EXECUTE FUNCTION capture_customer_changes();Dieser Trigger sorgt dafür, dass jeder INSERT, UPDATE oder DELETE in der Tabelle customers in Echtzeit in customers_audit protokolliert wird.

CDC auf Basis von Umfragen

Polling-basiertes CDC fragt regelmäßig die Quelldatenbank ab, um anhand eines Zeitstempels oder einer Versionsspalte nach Änderungen zu suchen. Bei dieser Methode ist zwar kein direkter Zugriff auf Transaktionsprotokolle oder Trigger erforderlich, aber es kann zu Latenzzeiten kommen, da Änderungen nur in festen Intervallen erkannt werden.

- Vorteile: Einfach zu implementieren, wenn kein Log-Zugang oder keine Trigger verfügbar sind.

- Nachteile: Es kann die Erfassung von Änderungen verzögern und die Belastung erhöhen, wenn die Abfrage zu häufig erfolgt.

Dieser Ansatz funktioniert gut, wenn kein Echtzeit-Zugang zu den Protokollen möglich ist, auch wenn der Nachteil darin besteht, dass Änderungen mit einer leichten Verzögerung erkannt werden.

Stell dir eine Tabelle products mit einer Spalte version_number vor, die bei jeder Aktualisierung inkrementiert wird:

SELECT *

FROM products

WHERE version_number > 1050

ORDER BY version_number ASC;Hier ist 1050 die zuletzt verarbeitete Versionsnummer aus dem vorherigen Abfragezyklus. Dadurch wird sichergestellt, dass nur neue Änderungen abgerufen werden, ohne sich auf Zeitstempel zu verlassen, was es robuster macht, wenn die Systemuhren unzuverlässig sind.

Zeitstempel-basierte CDC

Die zeitstempelbasierte CDC basiert auf einer speziellen Spalte, die den Zeitpunkt der letzten Änderung für jeden Datensatz aufzeichnet. Durch den Vergleich dieser Zeitstempel identifiziert das System Datensätze, die sich seit der letzten Prüfung geändert haben.

Diese Methode ähnelt dem polling-basierten CDC, ist aber strukturierter, da sie einen expliziten Mechanismus zur Verfolgung von Änderungen erfordert:

- Polling-basierte CDC ist ein breiterer Ansatz, bei dem regelmäßig nach Änderungen anhand eines identifizierbaren Musters (Zeitstempel, Versionsnummern oder andere Indikatoren) gefragt wird.

- Die zeitstempelbasierte CDC hängt von einer Zeitstempelspalte ab, die in der Quelldatenbank genau gepflegt werden muss.

Es ist zwar einfach zu implementieren, wenn die Datenbank Zeitstempel automatisch aktualisiert, aber es hängt von der Konsistenz der Systemuhren und der Zuverlässigkeit der Zeitstempelaktualisierungen ab.

- Vorteile: Einfacher Ansatz, wenn Systeme Zeitstempel automatisch aktualisieren.

- Nachteile: Die Genauigkeit hängt von einer konsistenten Uhrensynchronisation und einer zuverlässigen Aktualisierung der Zeitstempel ab.

Angenommen, wir haben eine Tabelle orders mit einer Spalte last_modified, die immer dann aktualisiert wird, wenn eine Zeile eingefügt oder geändert wird. Die folgende SQL-Abfrage holt alle Änderungen seit der letzten Prüfung ab:

SELECT *

FROM orders

WHERE last_modified > '2025-02-25 12:00:00'

ORDER BY last_modified ASC;Diese Methode funktioniert gut, wenn die Datenbank den Zeitstempel bei Änderungen automatisch aktualisiert, z.B. mit Triggern oder eingebauten Mechanismen wie DEFAULT now() von PostgreSQL oder ON UPDATE CURRENT_TIMESTAMP von MySQL.

Tabelle zum Vergleich der CDC-Methoden

Hier ist eine Vergleichstabelle, die die wichtigsten Unterschiede zwischen den vier Methoden der Änderungsdatenerfassung (CDC) aufzeigt:

|

Feature |

Log-basierte CDC |

Trigger-basierte CDC |

CDC auf Basis von Umfragen |

Zeitstempel-basierte CDC |

|

Wie es funktioniert |

Liest Datenbanktransaktionsprotokolle (WAL, binlog, etc.), um Änderungen in Echtzeit zu erfassen. |

Verwendet Datenbank-Trigger, um Änderungen in einer Tabelle zu protokollieren. |

Fragt regelmäßig nach Änderungen anhand einer Versionsnummer oder anderer Kriterien. |

Vergleicht Zeitstempel in einer Spalte, um Änderungen zu erkennen. |

|

Latenz |

Nahezu in Echtzeit (geringe Latenzzeit). |

Unmittelbar (Auslöser werden sofort ausgeführt). |

Geplante Intervalle (können zu Verzögerungen führen). |

Hängt von der Abfragefrequenz ab (niedrige bis mittlere Latenz). |

|

System-Overhead |

Niedrig (erfordert keine Abfrage von Tabellen). |

Hoch (Auslöser laufen bei jeder Änderung). |

Mäßig (abhängig von der Abfragefrequenz). |

Gering bis mäßig (verlässt sich auf Zeitstempel). |

|

Komplexität der Implementierung |

Hoch (erfordert Zugang zu Transaktionsprotokollen und eine ordnungsgemäße Aufbewahrung). |

Mittel-Hoch (erfordert die Erstellung von Triggern und die Pflege einer Tabelle). |

Gering (beruht auf einfachen SQL-Abfragen). |

Niedrig (einfach, wenn die Zeitstempel automatisch verwaltet werden). |

|

Zugangsvoraussetzungen |

Privilegierter Zugriff auf Transaktionsprotokolle. |

Erfordert DDL-Zugriff zum Erstellen von Triggern. |

Kein besonderer Zugang erforderlich (Standard-SQL). |

Kein besonderer Zugang erforderlich (Standard-SQL). |

|

Unterstützt er Löschungen? |

Ja (aus den Protokollen erfasst). |

Ja (wenn in der Tabelle für die Betriebsprüfung protokolliert). |

Benötigt zusätzliche Lernpfade (z. B. eine separate Tabelle zum Löschen). |

Nur wenn weiche Löschungen (deleted_at) verwendet werden. |

|

Bester Anwendungsfall |

Replikation in Echtzeit bei hohem Volumen, wo minimale Datenbankbelastung entscheidend ist. |

Kleine bis mittlere Workloads, die sofortige Erfassung von Änderungen benötigen. |

Wenn logbasierte CDC und Trigger nicht verfügbar sind, aber regelmäßige Updates akzeptabel sind. |

Wenn die Zeitstempel automatisch aktualisiert werden und eine häufige Abfrage möglich ist. |

|

Gemeinsame Werkzeuge |

Debezium, AWS DMS, StreamSets, Striim, HVR |

Datenbank-native Trigger (PostgreSQL, MySQL, SQL Server, Oracle) |

Apache Airflow, ETL-Skripte (Python, SQL) |

ETL-Jobs, Batch-Datenpipelines |

Anwendungsfälle für die Erfassung von Änderungsdaten

Die Methoden zu verstehen ist nur die halbe Miete. Genauso wichtig ist es, zu sehen, wie CDC in realen Szenarien einen greifbaren Wert schafft.

Data Warehousing in Echtzeit

CDC ermöglicht kontinuierliche, inkrementelle Aktualisierungen von Data Warehouses, indem nur die Änderungen weitergegeben werden, anstatt komplette Datensätze neu zu laden. Dieser Ansatz stellt sicher, dass die Business Intelligence-Tools und Dashboards die aktuellsten Daten anzeigen.

Ein Einzelhandelsunternehmen kann zum Beispiel sein Verkaufs-Dashboard fast in Echtzeit aktualisieren, um neue Trends und Erkenntnisse schnell zu erkennen.

Datenreplikation

CDC repliziert Daten zwischen Systemen, indem es sicherstellt, dass jede Änderung im Quellsystem sofort in den Zieldatenbanken gespiegelt wird. Dies ist besonders nützlich bei Datenmigrationsprojekten oder bei der Verwaltung von Backups und Repliken in hybriden Umgebungen.

Die Replikation von Daten aus lokalen Systemen in Cloud-Datenbanken wie AWS RDS oder Snowflake garantiert die Konsistenz über alle Plattformen hinweg.

Daten-Synchronisation

In verteilten Systemen - wie z.B. solchen mit Microservices oder mehreren Anwendungen - stellt CDC sicher, dass jede Komponente mit den aktuellsten Daten arbeitet, indem Änderungen in Echtzeit synchronisiert werden.

Die Synchronisierung von Kundeninformationen über verschiedene Plattformen hinweg sorgt zum Beispiel für ein einheitliches Nutzererlebnis auf allen Ebenen.

Prüfung und Überwachung von Daten

Schließlich liefert CDC detaillierte Änderungsprotokolle, die für Auditing-Zwecke unerlässlich sind. Indem sie nachverfolgen, wer wann Änderungen vorgenommen hat, können die Teams die gesetzlichen Anforderungen erfüllen, Probleme beheben und eingehende forensische Analysen durchführen.

Finanzinstitute zum Beispiel verlassen sich auf umfassende CDC-Protokolle, um Änderungen an Kundendaten zu überprüfen und die Einhaltung strenger Data-Governance-Richtlinien sicherzustellen.

Tools für die Implementierung der Änderungsdatenerfassung

Nachdem wir die Methoden und Anwendungsfälle erkundet haben, wollen wir uns einige beliebte Tools ansehen, die die Umsetzung von CDC erleichtern. Die richtige Wahl hängt von deinem Anwendungsfall ab -ob du Echtzeit-Streaming, Cloud-Migration oder ETL-Lösungen für Unternehmen brauchst.

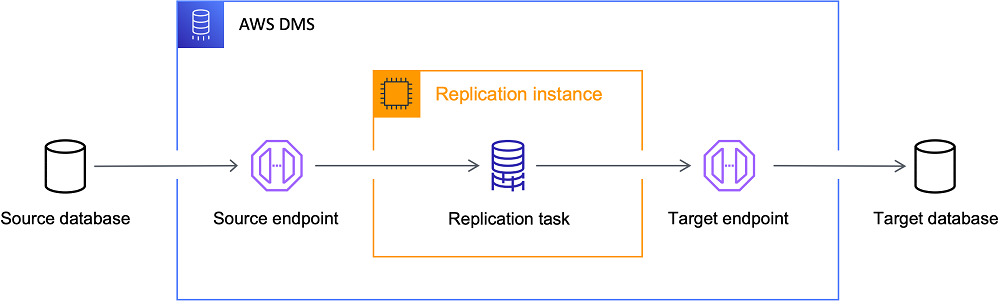

AWS Datenbank-Migrationsdienst (DMS)

AWS DMS nutzt logbasierte CDC, um Daten kontinuierlich und mit minimaler Ausfallzeit von lokalen Systemen in die AWS-Cloud zu replizieren, was es zu einer hervorragenden Wahl für Migrationen macht. AWS DMS ist eine robuste Lösung, wenn dein Ziel darin besteht, Daten mit zuverlässiger Betriebszeit in die Cloud zu verlagern.

Am besten für: Cloud-Migrationen und AWS-basierte Architekturen.

Die AWS DMS-Architektur. Bildquelle: AWS

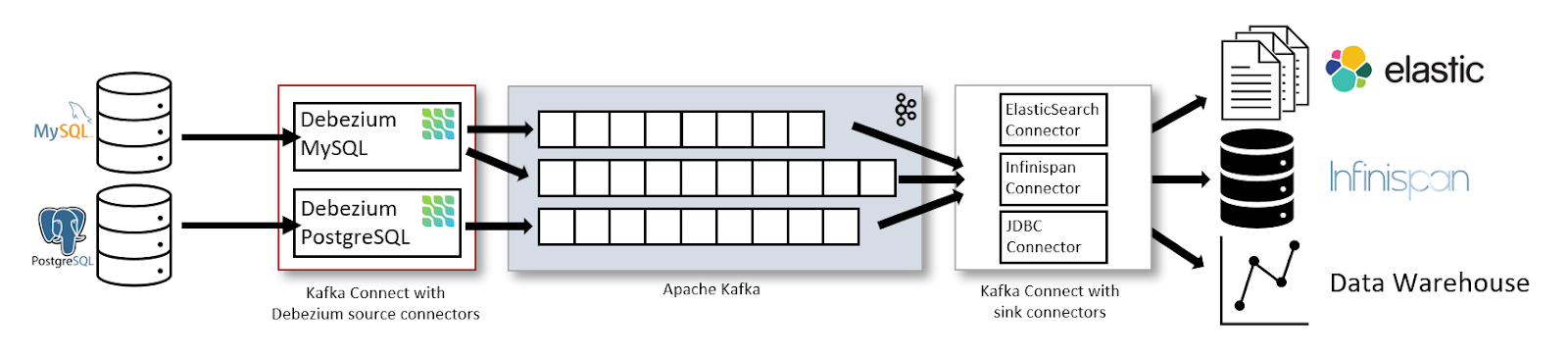

Debezium

Debezium ist eine Open-Source-CDC-Plattform, die Datenbankänderungen erfasst und in Systeme wie Apache Kafka streamt.

Ich persönlich finde Debezium sehr nützlich für das Streaming von Datenbankänderungen in Kafka, vor allem in verteilten Umgebungen, in denen mehrere Dienste auf Echtzeit-Updates angewiesen sind. Seine Skalierbarkeit und Integrationsmöglichkeiten machen es zu einer herausragenden Option.

Am besten für: Echtzeit-Daten-Streaming und ereignisgesteuerte Architekturen.

Die Daten-Streaming-Architektur mit Kafka Connect und Debezium. Bildquelle: Debezium

Apache Kafka

Apache Kafka ist kein eigenes CDC-Tool, sondern dient in Verbindung mit Tools wie Debezium als Rückgrat für die Verarbeitung von CDC-Ereignissen. Kafka ermöglicht zuverlässige ereignisgesteuerte Pipelines, Echtzeit-Analysen und die Synchronisierung von Daten über mehrere Verbraucher hinweg.

Am besten für: Streaming von CDC-Daten in ereignisgesteuerten Architekturen.

Um zu veranschaulichen, wie CDC-Ereignisse an Kafka gesendet werden können, schau dir das folgende Python-Snippet an. Der Code initialisiert einen Kafka-Producer und sendet ein CDC-Ereignis (das eine Update-Operation für eine Tabelle orders darstellt) an ein Kafka-Topic namens cdc-topic:

from kafka import KafkaProducer

import json

# Initialize the Kafka producer with bootstrap servers and a JSON serializer for values.

producer = KafkaProducer(

bootstrap_servers='localhost:9092',

value_serializer=lambda v: json.dumps(v).encode('utf-8')

)

# Define a CDC event that includes details of the operation.

cdc_event = {

"table": "orders",

"operation": "update",

"data": {"order_id": 123, "status": "shipped"}

}

# Send the CDC event to the 'cdc-topic' and flush to ensure transmission.

producer.send('cdc-topic', cdc_event)

producer.flush()

print("CDC event sent successfully!")Talend und Informatica

Talend und Informatica sind umfassende ETL-Plattformen mit eingebauter CDC-Funktionalität, um Datenänderungen zu erfassen und zu verarbeiten und so manuelle Konfigurationen zu reduzieren. Sie sind besonders vorteilhaft in komplexen Datenumwandlungsszenarien, in denen integrierte Lösungen den Betrieb vereinfachen können.

Am besten für: ETL-Lösungen für Unternehmen mit integriertem CDC.

Datenbank-native CDC-Lösungen

Einige relationale Datenbanken bieten native CDC-Funktionen, sodass weniger externe Tools benötigt werden:

- PostgreSQL logische Replikation: Erfasst Änderungen in WAL und streamt sie an die Abonnenten.

- SQL Server Änderungsdatenerfassung (CDC): Verwendet Transaktionsprotokolle, um Änderungen automatisch zu verfolgen.

- MySQL binary log (binlog) Replikation: Protokolliert Änderungen für Replikationszwecke.

Am besten für: Minimierung der Abhängigkeiten von externen CDC-Tools.

Google Datastream und Azure Data Factory

Cloud-Anbieter bieten auch CDC-Lösungen für ihre Ökosysteme an:

- Google Datastream: Ein vollständig verwalteter CDC- und Replikationsdienst für Google Cloud-Nutzer.

- Azure Data Factory CDC: Ermöglicht die Nachverfolgung von Änderungen und die Replikation für Azure SQL, CosmosDB und Synapse Analytics.

Am besten für: CDC in Google Cloud- oder Microsoft Azure-Umgebungen.

Herausforderungen und Beschränkungen der CDC

CDC bietet zwar erhebliche Vorteile, bringt aber auch Herausforderungen mit sich, die für eine zuverlässige Umsetzung gemeistert werden müssen.

Umgang mit Problemen der Datenintegrität

Die Aufrechterhaltung der Datenintegrität kann eine Herausforderung sein, wenn es zu Netzwerkunterbrechungen, verzögerten Transaktionen oder Systemproblemen kommt. Robuste Fehlerbehandlungsprotokolle und regelmäßige Abstimmungen sind unerlässlich, um Diskrepanzen zwischen dem Quell- und dem Zielsystem zu vermeiden. Die frühzeitige Behebung dieser Probleme trägt dazu bei, dass die Datenpipeline zuverlässig funktioniert.

Performance Overhead

Bestimmte CDC-Methoden - insbesondere solche, die auf Triggern oder häufigen Abfragen basieren - können die Quelldatenbanken zusätzlich belasten. Der Schlüssel zu einem reibungslosen Betrieb liegt darin, den Bedarf an zeitnahen Aktualisierungen mit den Leistungsbeschränkungen deiner Produktionssysteme in Einklang zu bringen.

Komplexe Datentransformationen verwalten

Auch wenn CDC rohe Änderungen effizient erfasst, kann eine zusätzliche nachgelagerte Verarbeitung, wie z. B. eine Datenbereinigung oder -umwandlung, erforderlich sein. Die Integration der Transformationslogik ohne Lieferverzögerungen oder Fehler erhöht die Komplexität der CDC-Implementierung, daher ist eine sorgfältige Planung erforderlich.

Best Practices für die Umsetzung der CDC

Um die Theorie in die Praxis umzusetzen, muss man sich an die besten Praktiken halten. Hier sind Tipps aus meiner Erfahrung, die mir geholfen haben, robuste CDC-Pipelines aufzubauen.

Wähle die richtige Umsetzungsmethode

Wähle einen CDC-Ansatz, der zu deinem Datenvolumen, deinen Latenzanforderungen und deiner Systemarchitektur passt. Log-basiertes CDC ist in der Regel optimal für Umgebungen mit vielen Transaktionen, während trigger- oder polling-basierte Methoden für kleinere Anwendungen besser geeignet sind. Wenn du deine spezifischen Bedürfnisse im Voraus abschätzt, kannst du später Zeit und Ressourcen sparen.

Jobs überwachen

Implementiere eine umfassende Überwachung mit Echtzeit-Dashboards und automatischen Warnmeldungen. Regelmäßige Überprüfungen des Protokolls und Gesundheitschecks sind wichtig, um sicherzustellen, dass jede Änderung korrekt erfasst wird und dass alle Probleme umgehend behoben werden.

Eine geringfügige logbasierte CDC-Fehlkonfiguration in einem Projekt blieb tagelang unbemerkt und führte zu einem stillen Datenverlust bei nachgelagerten Analysen. Die Implementierung von Grafana-Warnungen half, fehlende Aktualisierungen sofort zu erkennen und kostspielige Fehler zu vermeiden.

Sicherstellung der Datenqualität

Integriere Prüfpunkte zur Datenvalidierung in die CDC-Pipeline, um sicherzustellen, dass nur korrekte und konsistente Änderungen weitergegeben werden.

Ich habe die Erfahrung gemacht, dass die Einrichtung automatischer Validierungsprüfungen in der CDC-Pipeline mich vor stundenlanger Fehlersuche bei der Datenübermittlung bewahrt hat. Tools wie dbt und Apache Airflow haben dazu beigetragen, die Konsistenz zwischen mehreren nachgelagerten Systemen zu gewährleisten.

Implementierungen vor dem Einsatz testen

Bevor du deine CDC-Lösung in die Produktion überführst, solltest du sie gründlich in einer Staging-Umgebung testen. Simuliere reale Arbeitsbelastungen und Ausfallszenarien und validiere Funktionen wie Rollback und Zeitreisen, um sicherzustellen, dass sich das System unter allen Bedingungen wie erwartet verhält. Diese strengen Tests sind wichtig für eine reibungslose Produktionseinführung.

Strategischer Umgang mit der Schemaentwicklung

Dein CDC-System muss sich ohne Unterbrechung an Schemaänderungen anpassen, wenn sich deine Datensätze weiterentwickeln. Verwende Tools, die eine automatische Schemaentwicklung unterstützen, und sorge für eine angemessene Versionskontrolle, damit neue Felder reibungslos integriert werden können. Dieser strategische Ansatz verhindert unerwartete Fehler und Ausfallzeiten, wenn sich Datenstrukturen ändern.

Fazit

Indem CDC nur die geänderten Daten präzise erfasst, minimiert es die Systembelastung und sorgt dafür, dass Echtzeit-Analysen und Streaming-Anwendungen ordnungsgemäß funktionieren. Ganz gleich, ob du Datenreplikation, Synchronisierung oder Audit-Logging implementierst, die Auswahl der geeigneten CDC-Methode und die Einhaltung von Best Practices sind der Schlüssel zum Aufbau einer zuverlässigen und effizienten Datenpipeline.

Wenn du dein Wissen vertiefen möchtest, empfehle ich dir, die folgenden DataCamp-Kurse zu besuchen:

- Einführung in das Data Engineering - Erlerne grundlegende Techniken zum Aufbau robuster Datenpipelines und zur Integration verschiedener Datenquellen.

- Big Data Fundamentals with PySpark - Sammle praktische Erfahrungen mit Apache Spark und PySpark, um große Datensätze zu verarbeiten und zu analysieren.

- Data Engineer in Python - Baue End-to-End-Datenpipelines mit Python auf, mit praktischer Erfahrung in Tools wie Apache Kafka für die Integration von Streaming-Daten.

Viel Spaß beim Programmieren - und auf den Aufbau stabiler Echtzeit-Datensysteme!

Werde Dateningenieur

FAQs

Wie verbessert CDC Echtzeit-Analysen in modernen Datenarchitekturen?

CDC minimiert den Bedarf an Massen-ETL-Jobs, indem es nur inkrementelle Änderungen aus den Quelldatenbanken erfasst. So wird sichergestellt, dass analytische Dashboards und Streaming-Anwendungen immer auf die aktuellsten Daten zugreifen können, was die Latenzzeit und die Systembelastung reduziert.

Was sind praktische Schritte, um eine CDC-Implementierung vor der vollständigen Einführung zu testen?

Richte eine Staging-Umgebung ein, um die Produktionslasten zu simulieren; überprüfe die Datenintegrität, die Latenz und die Fehlerbehandlung und führe Rollback-Tests mit Zeitreisefunktionen durch, falls verfügbar, um die Wiederherstellungsverfahren zu validieren.

Wie kann ich die Schemaentwicklung bei der Verwendung von CDC handhaben?

Integriere die Schema-Versionierung und automatische Validierungsschritte in die CDC-Pipeline. Teste Schemaänderungen in einer kontrollierten Umgebung, um Abwärtskompatibilität zu gewährleisten, und nutze CDC-Tools, die eine automatische Schemaentwicklung unterstützen.

Welche Überwachungswerkzeuge oder -praktiken empfehlen Sie für CDC-Pipelines?

Integriere Dashboards (mit Tools wie Grafana) und Warnsysteme, um die CDC-Ausführungsmetriken zu verfolgen. Regelmäßige Protokollüberprüfungen und automatische Gesundheitschecks können helfen, Leistungsengpässe oder Datenqualitätsprobleme frühzeitig zu erkennen.

Welche CDC-Methode sollte für eine Umgebung mit hohem Datenaufkommen und niedriger Latenz gewählt werden?

Log-basiertes CDC ist in der Regel die beste Option für solche Umgebungen, da es direkt aus den Datenbank-Transaktionsprotokollen (WAL) liest und die Auswirkungen auf die Produktionsauslastung minimiert, indem es Aktualisierungen nahezu in Echtzeit liefert.